概率论与随机过程

一、概率与分布

1.1 条件概率与独立事件

- 条件概率:已知 事件发生的条件下 发生的概率,记作 ,它等于事件 的概率相对于事件 的概率,即: 。其中必须有 。

条件概率分布的链式法则:对于 个随机变量 ,有:

两个随机变量 相互独立的数学描述: 。记作: 。

两个随机变量 关于随机变量 条件独立的数学描述: 。

记作: 。

1.2 联合概率分布

定义 和 的联合分布为: 。

的分布可以从联合分布中得到:

的分布可以从联合分布中得到:

当 和 都是离散随机变量时, 定义 和 的联合概率质量函数为:

则 和 的概率质量函数分布为:

当 和 联合地连续时,即存在函数 ,使得对于所有的实数集合 和 满足:

则函数 称为 和 的概率密度函数。

联合分布为: 。

和 的分布函数以及概率密度函数分别为:

.

二、期望和方差

2.1 期望

期望描述了随机变量的平均情况,衡量了随机变量 的均值。它是概率分布的泛函(函数的函数)。

离散型随机变量 的期望: 。

若右侧级数不收敛,则期望不存在。

连续性随机变量 的期望: 。

若右侧极限不收敛,则期望不存在。

定理:对于随机变量 ,设 也为随机变量, 是连续函数。

若 为离散型随机变量,若 的期望存在,则: 。

也记做: 。

若 为连续型随机变量,若 的期望存在,则 : 。

也记做: 。

该定理的意义在于:当求 时,不必计算出 的分布,只需要利用 的分布即可。

该定理可以推广至两个或两个以上随机变量的情况。对于随机变量,假设 也是随机变量, 为连续函数,则有: 。也记做: 。

期望性质:

常数的期望就是常数本身。

对常数 有 : 。

对两个随机变量 ,有: 。

该结论可以推广到任意有限个随机变量之和的情况。

对两个相互独立的随机变量,有: 。

该结论可以推广到任意有限个相互独立的随机变量之积的情况。

2.2 方差

对随机变量 ,若 存在,则称它为 的方差,记作 。

的标准差为方差的开平方。即:

方差度量了随机变量 与期望值偏离的程度,衡量了 取值分散程度的一个尺度。

由于绝对值 带有绝对值,不方便运算,因此采用平方来计算。

又因为 是一个随机变量,因此对它取期望,即得 与期望值偏离的均值。

根据定义可知:

对于一个期望为 , 方差为 的随机变量 ,随机变量 的数学期望为0,方差为1。 称 为 的标准化变量。

方差的性质:

常数的方差恒为 0 。

对常数 ,有 。

对两个随机变量 ,有:

当 和 相互独立时,有 。这可以推广至任意有限多个相互独立的随机变量之和的情况。

的充要条件是 以概率1取常数。

2.3 协方差与相关系数

对于二维随机变量 ,可以讨论描述 与 之间相互关系的数字特征。

- 定义 为随机变量 与 的协方差,记作 。

- 定义 为随机变量 与的相关系数,它是协方差的归一化。

由定义可知:

协方差的性质:

- , 为常数。

协方差的物理意义:

协方差的绝对值越大,说明两个随机变量都远离它们的均值。

协方差如果为正,则说明两个随机变量同时趋向于取较大的值或者同时趋向于取较小的值;如果为负,则说明一个随变量趋向于取较大的值,另一个随机变量趋向于取较小的值。

两个随机变量的独立性可以导出协方差为零。但是两个随机变量的协方差为零无法导出独立性。

因为独立性也包括:没有非线性关系。有可能两个随机变量是非独立的,但是协方差为零。如:假设随机变量 。定义随机变量 的概率分布函数为:

定义随机变量 ,则随机变量 是非独立的,但是有: 。

相关系数的物理意义:考虑以随机变量 的线性函数 来近似表示 。以均方误差

来衡量以 近似表达 的好坏程度。 越小表示近似程度越高。

为求得最好的近似,则对 分别取偏导数,得到:

因此有以下定理:

- ( 是绝对值)。

- 的充要条件是:存在常数 使得 。

当 较大时, 较小,意味着随机变量 和 联系较紧密。于是 是一个表征 、 之间线性关系紧密程度的量。

当 时,称 和 不相关。

- 不相关是就线性关系来讲的,而相互独立是一般关系而言的。

- 相互独立一定不相关;不相关则未必独立。

2.4 协方差矩阵

设 和 是随机变量。

- 若 存在,则称它为 的 阶原点矩,简称 阶矩。

- 若 存在,则称它为 的 阶中心矩。

- 若 存在,则称它为 和 的 阶混合矩。

- 若 存在,则称它为 和 的 阶混合中心矩。

因此:期望是一阶原点矩,方差是二阶中心矩,协方差是二阶混合中心矩。

协方差矩阵:

二维随机变量 有四个二阶中心矩(假设他们都存在),记作:

称矩阵

为随机变量 的协方差矩阵。

设 维随机变量 的二阶混合中心矩 都存在,则称矩阵

为 维随机变量 的协方差矩阵。

由于 因此协方差矩阵是个对称阵。

通常 维随机变量的分布是不知道的,或者太复杂以致数学上不容易处理。因此实际中协方差矩阵非常重要。

三、大数定律及中心极限定理

3.1 切比雪夫不等式

切比雪夫不等式:假设随机变量 具有期望 , 方差 ,则对于任意正数 ,下面的不等式成立:

其意义是:对于距离 足够远的地方 (距离大于等于 ),事件出现的概率是小于等于 。即事件出现在区间 的概率大于 。

该不等式给出了随机变量 在分布未知的情况下, 事件 的下限估计。如: 。

证明:

切比雪夫不等式的特殊情况:设随机变量 相互独立,且具有相同的数学期望和方差: 。 作前 个随机变量的算术平均: , 则对于任意正数 有:

证明:根据期望和方差的性质有:, 。根据切比雪夫不等式有:

则有 ,因此有: 。

3.2 大数定理

依概率收敛:设 是一个随机变量序列, 是一个常数。

若对于任意正数 有 : ,则称序列 依概率收敛于 。记作:

依概率收敛的两个含义:

- 收敛:表明这是一个随机变量序列,而不是某个随机变量;且序列是无限长,而不是有限长。

- 依概率:表明序列无穷远处的随机变量 的分布规律为:绝大部分分布于点 ,极少数位于 之外。且分布于 之外的事件发生的概率之和为0。

大数定理一: 设随机变量 相互独立,且具有相同的数学期望和方差: 。 则序列: 依概率收敛于 , 即 。

注意:这里并没有要求随机变量 同分布。

伯努利大数定理: 设 为 次独立重复实验中事件 发生的次数, 是事件 在每次试验中发生的概率。则对于任意正数 有:

即:当独立重复实验执行非常大的次数时,事件 发生的频率逼近于它的概率。

辛钦定理:设随机变量 相互独立,服从同一分布,且具有相同的数学期望: 。 则对于任意正数 有:

- 注意:这里并没有要求随机变量 的方差存在。

- 伯努利大数定理是亲钦定理的特殊情况。

3.3 中心极限定理

独立同分布的中心极限定理:设随机变量 独立同分布,且具有数学期望和方差: , 则随机变量之和 的标准变化量:

的概率分布函数 对于任意 满足:

其物理意义为:均值方差为 的独立同分布的随机变量 之和 的标准变化量 ,当 充分大时,其分布近似于标准正态分布。

即: 在 充分大时,其分布近似于 。

一般情况下,很难求出 个随机变量之和的分布函数。因此当 充分大时,可以通过正态分布来做理论上的分析或者计算。

Liapunov定理:设随机变量 相互独立,具有数学期望和方差: 。记:。 若存在正数 ,使得当 时, 。则随机变量之和 的标准变化量:的概率分布函数 对于任意 满足:

- 其物理意义为:相互独立的随机变量 之和 的衍生随机变量序列,当 充分大时,其分布近似与标准正态分布。

- 这里并不要求 同分布。

Demoiver-Laplace定理:设随机变量序列 服从参数为 的二项分布,其中 。则对于任意 , 有:该定理表明,正态分布是二项分布的极限分布。当 充分大时,可以利用正态分布来计算二项分布的概率。

五、常见概率分布

5.1 均匀分布

离散随机变量的均匀分布:假设 有 个取值: ,则均匀分布的概率密度函数(

probability mass function:PMF)为:连续随机变量的均匀分布: 假设 在

[a,b]上均匀分布,则其概率密度函数(probability density function:PDF)为:.

5.2 伯努利分布

伯努利分布:参数为 。随机变量 。

- 概率分布函数为: 。

- 期望: 。方差: 。

categorical分布:它是二项分布的推广,也称作multinoulli分布。假设随机变量 ,其概率分布函数为:其中 为参数,它满足 ,且 。

5.3 二项分布

假设试验只有两种结果:成功的概率为 ,失败的概率为 。 则二项分布描述了:独立重复地进行 次试验中,成功 次的概率。

概率质量函数:

期望: 。 方差: 。

5.4 高斯分布

正态分布是很多应用中的合理选择。如果某个随机变量取值范围是实数,且对它的概率分布一无所知,通常会假设它服从正态分布。有两个原因支持这一选择:

- 建模的任务的真实分布通常都确实接近正态分布。中心极限定理表明,多个独立随机变量的和近似正态分布。

- 在具有相同方差的所有可能的概率分布中,正态分布的熵最大(即不确定性最大)。

5.4.1 一维正态分布

正态分布的概率密度函数为 :

其中 为常数。

- 若随机变量 的概率密度函数如上所述,则称 服从参数为 的正态分布或者高斯分布,记作 。

- 特别的,当 时,称为标准正态分布,其概率密度函数记作 ,分布函数记作 。

- 为了计算方便,有时也记作: ,其中 。

正态分布的概率密度函数性质:

- 曲线关于 对称。

- 曲线在 时取最大值。

- 曲线在 处有拐点。

- 参数 决定曲线的位置; 决定图形的胖瘦。

若 则:

- 期望: 。方差: 。

有限个相互独立的正态随机变量的线性组合仍然服从正态分布:若随机变量 且它们相互独立,则它们的线性组合: 仍然服从正态分布(其中 不全是为 0 的常数),且: 。

5.4.2 多维正态分布

二维正态随机变量 的概率密度为:

根据定义,可以计算出:

引入矩阵:

为 的协方差矩阵。其行列式为 ,其逆矩阵为:

于是 的概率密度函数可以写作 表示矩阵的转置:

其中:

均值 决定了曲面的位置(本例中均值都为0)。

标准差 决定了曲面的陡峭程度(本例中方差都为1)。

决定了协方差矩阵的形状,从而决定了曲面的形状。

时,协方差矩阵对角线非零,其他位置均为零。此时表示随机变量之间不相关。

此时的联合分布概率函数形状如下图所示,曲面在 平面的截面是个圆形:

时,协方差矩阵对角线非零,其他位置非零。此时表示随机变量之间相关。

此时的联合分布概率函数形状如下图所示,曲面在 平面的截面是个椭圆,相当于圆形沿着直线 方向压缩 :

时,协方差矩阵对角线非零,其他位置非零。

此时表示随机变量之间完全相关。此时的联合分布概率函数形状为:曲面在 平面的截面是直线 ,相当于圆形沿着直线 方向压缩成一条直线 。

由于 会导致除数为 0,因此这里给出 :

多维正态随机变量 ,引入列矩阵:

为 的协方差矩阵。则:

记做 : 。

维正态变量具有下列四条性质:

维正态变量的每一个分量都是正态变量;反之,若 都是正态变量,且相互独立,则 是 维正态变量。

维随机变量 服从 维正态分布的充要条件是: 的任意线性组合: 服从一维正态分布,其中 不全为 0 。

若 服从 维正态分布,设 是 的线性函数,则 也服从多维正态分布。

这一性质称为正态变量的线性变换不变性。

设 服从 维正态分布,则 相互独立 两两不相关。

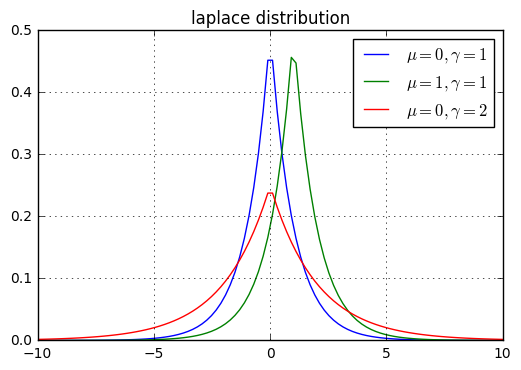

5.5 拉普拉斯分布

拉普拉斯分布:

- 概率密度函数: 。

- 期望: 。方差: 。

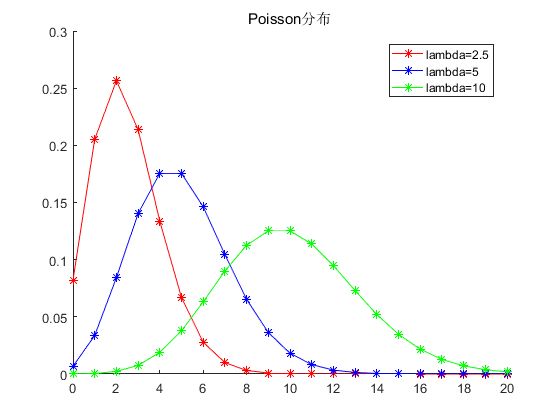

5.6 泊松分布

假设已知事件在单位时间(或者单位面积)内发生的平均次数为 ,则泊松分布描述了:事件在单位时间(或者单位面积)内发生的具体次数为 的概率。

- 概率质量函数: 。

- 期望: 。 方差: 。

用均匀分布模拟泊松分布:

xxxxxxxxxxdef make_poisson(lmd,tm):'''用均匀分布模拟泊松分布。 lmd为 lambda 参数; tm 为时间'''t=np.random.uniform(0,tm,size=lmd*tm) # 获取 lmd*tm 个事件发生的时刻count,tm_edges=np.histogram(t,bins=tm,range=(0,tm))#获取每个单位时间内,事件发生的次数max_k= lmd *2 # 要统计的最大次数dist,count_edges=np.histogram(count,bins=max_k,range=(0,max_k),density=True)x=count_edges[:-1]return x,dist,stats.poisson.pmf(x,lmd)该函数:

- 首先随机性给出了

lmd*tm个事件发生的时间(时间位于区间[0,tm])内。 - 然后统计每个单位时间区间内,事件发生的次数。

- 然后统计这些次数出现的频率。

- 最后将这个频率与理论上的泊松分布的概率质量函数比较。

- 首先随机性给出了

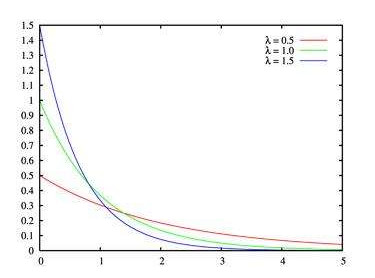

5.7 指数分布

若事件服从泊松分布,则该事件前后两次发生的时间间隔服从指数分布。由于时间间隔是个浮点数,因此指数分布是连续分布。

概率密度函数:( 为时间间隔)

期望: 。方差: 。

用均匀分布模拟指数分布:

xxxxxxxxxxdef make_expon(lmd,tm):'''用均匀分布模拟指数分布。 lmd为 lambda 参数; tm 为时间'''t=np.random.uniform(0,tm,size=lmd*tm) # 获取 lmd*tm 个事件发生的时刻sorted_t=np.sort(t) #时刻升序排列delt_t=sorted_t[1:]-sorted_t[:-1] #间隔序列dist,edges=np.histogram(delt_t,bins="auto",density=True)x=edges[:-1]return x,dist,stats.expon.pdf(x,loc=0,scale=1/lmd) #scale 为 1/lambda

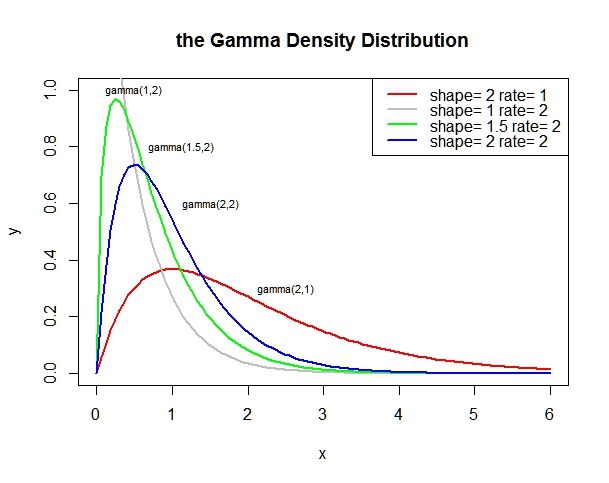

5.8 伽马分布

若事件服从泊松分布,则事件第 次发生和第 次发生的时间间隔为伽玛分布。由于时间间隔是个浮点数,因此指数分布是连续分布。

- 概率密度函数:, 为时间间隔 。

- 期望: 。方差: 。

上面的定义中 必须是整数。事实上,若随机变量 服从伽马分布,则其概率密度函数为:

记做 。其中 称作形状参数, 称作尺度参数。

- 期望 ,方差 。

- 当 时, 为递减函数。

- 当 时, 为单峰函数。

性质:

- 当 时, 为

Erlang分布。 - 当 时,就是参数为 的指数分布。

- 当 时,就是常用的卡方分布。

- 当 时, 为

伽马分布的可加性:设随机变量 相互独立并且都服从伽马分布: ,则:

用均匀分布模拟伽玛分布:

xxxxxxxxxxdef make_gamma(lmd,tm,k):'''用均匀分布模拟伽玛分布。 lmd为 lambda 参数; tm 为时间;k 为 k 参数'''t=np.random.uniform(0,tm,size=lmd*tm) # 获取 lmd*tm 个事件发生的时刻sorted_t=np.sort(t) #时刻升序排列delt_t=sorted_t[k:]-sorted_t[:-k] #间隔序列dist,edges=np.histogram(delt_t,bins="auto",density=True)x=edges[:-1]return x,dist,stats.gamma.pdf(x,loc=0,scale=1/lmd,a=k) #scale 为 1/lambda,a 为 k

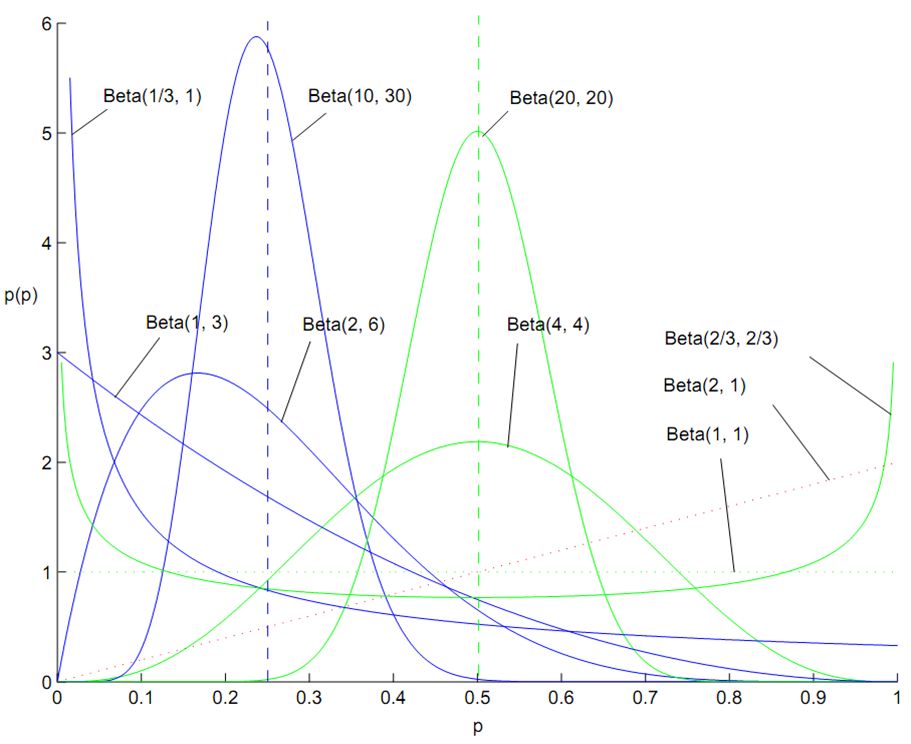

5.9 贝塔分布

贝塔分布是定义在 之间的连续概率分布。

如果随机变量 服从贝塔分布,则其概率密度函数为:

记做 。

- 众数为: 。

- 期望为: ,方差为: 。

5.10 狄拉克分布

狄拉克分布:假设所有的概率都集中在一点 上,则对应的概率密度函数为: 。

其中 为狄拉克函数,其性质为:

狄拉克分布的一个典型用途就是定义连续型随机变量的经验分布函数。假设数据集中有样本 ,则定义经验分布函数:

它就是对每个样本赋予了一个概率质量 。

对于离散型随机变量的经验分布,则经验分布函数就是

multinoulli分布,它简单地等于训练集中的经验频率。经验分布的两个作用:

- 通过查看训练集样本的经验分布,从而指定该训练集的样本采样的分布(保证采样之后的分布不失真)。

- 经验分布就是使得训练数据的可能性最大化的概率密度函数。

5.11 多项式分布与狄里克雷分布

多项式分布的质量密度函数:

它是 的多项式展开的形式。

狄利克雷分布的概率密度函数:

可以看到,多项式分布与狄里克雷分布的概率密度函数非常相似,区别仅仅在于前面的归一化项:

- 多项式分布是针对离散型随机变量,通过求和获取概率。

- 狄里克雷分布时针对连续型随机变量,通过求积分来获取概率。

5.12 混合概率分布

混合概率分布:它组合了其他几个分量的分布来组成。

在每次生成样本中,首先通过

multinoulli分布来决定选用哪个分量,然后由该分量的分布函数来生成样本。其概率分布函数为:

其中 为一个

multinoulli分布, 的取值范围就是各分量的编号。

前面介绍的连续型随机变量的经验分布函数就是一个混合概率分布的例子,此时 。

混合概率分布可以通过简单的概率分布创建更复杂的概率分布。一个常见的例子是混合高斯模型,其中 为高斯模型。每个分量都有对应的参数 。

- 有些混合高斯模型有更强的约束,如 ,更进一步还可以要求 为一个对角矩阵。

- 混合高斯模型是一个通用的概率密度函数逼近工具。任何平滑的概率密度函数都可以通过足够多分量的混合高斯模型来逼近。

六、先验分布与后验分布

在贝叶斯学派中,

先验分布+数据(似然)= 后验分布。例如:假设需要识别一大箱苹果中的好苹果、坏苹果的概率。

根据你对苹果好、坏的认知,给出先验分布为:50个好苹果和50个坏苹果。

现在你拿出10个苹果,发现有:8个好苹果,2个坏苹果。

根据数据,你得到后验分布为:58个好苹果,52个坏苹果

再拿出10个苹果,发现有:9个好苹果,1个坏苹果。

根据数据,你得到后验分布为:67个好苹果,53个坏苹果

这样不断重复下去,不断更新后验分布。当一箱苹果清点完毕,则得到了最终的后验分布。

在这里:

- 如果不使用先验分布,仅仅清点这箱苹果中的好坏,则得到的分布只能代表这一箱苹果。

- 采用了先验分布之后得到的分布,可以认为是所有箱子里的苹果的分布。

- 当采用先验分布时:给出的好、坏苹果的个数(也就是频数)越大,则先验分布越占主导地位。

假设好苹果的概率为 ,则抽取 个苹果中,好苹果个数为 个的概率为一个二项分布:

其中 为组合数。

现在的问题是:好苹果的概率 不再固定,而是服从一个分布。

假设好苹果的概率 的先验分布为贝塔分布: 。

则后验概率为:

归一化之后,得到后验概率为:

好苹果概率 的先验分布的期望为: 。好苹果概率 的后验分布的期望为: 。

根据上述例子所述:

- 好苹果的先验概率的期望为

- 进行第一轮数据校验之后,好苹果的后验概率的期望为

如果将 视为先验的好苹果数量, 视为先验的坏苹果数量, 表示箱子中苹果的数量, 表示箱子中的好苹果数量(相应的, 就是箱子中坏苹果的数量)。则:好苹果的先验概率分布的期望、后验概率分布的期望符合人们的生活经验。

这里使用先验分布和后验分布的期望,因为 是一个随机变量。若想通过一个数值来刻画好苹果的可能性,则用期望较好。

更一般的,如果苹果不仅仅分为好、坏两种,而是分作

尺寸1、尺寸2、...尺寸K等。则 个苹果中,有 个尺寸1的苹果、 个尺寸2的苹果.... 个尺寸 的苹果的概率服从多项式分布:其中苹果为尺寸1的概率为 , 尺寸2的概率为 ,... 尺寸 的概率为 ,

假设苹果尺寸的先验概率分布为狄利克雷分布: 。

苹果尺寸的先验概率分布的期望为: 。

则苹果尺寸的后验概率分布也为狄里克雷分布: 。

苹果尺寸的后验概率分布的期望为: 。

七、信息论

信息论背后的原理是:从不太可能发生的事件中能学到更多的有用信息。

- 发生可能性较大的事件包含较少的信息。

- 发生可能性较小的事件包含较多的信息。

- 独立事件包含额外的信息 。

对于事件 ,定义自信息

self-information为: 。自信息仅仅处理单个输出,但是如果计算自信息的期望,它就是熵:

记作 。

熵刻画了按照真实分布 来识别一个样本所需要的编码长度的期望(即平均编码长度)。

如:含有4个字母

(A,B,C,D)的样本集中,真实分布 ,则只需要1位编码即可识别样本。对于离散型随机变量 ,假设其取值集合大小为 ,则可以证明: 。

对于随机变量 和 ,条件熵 表示:已知随机变量 的条件下,随机变量 的不确定性。

它定义为: 给定条件下 的条件概率分布的熵对 的期望:

对于离散型随机变量,有:

对于连续型随机变量,有:

根据定义可以证明: 。

即:描述 和 所需要的信息是:描述 所需要的信息加上给定 条件下描述 所需的额外信息。

KL散度(也称作相对熵):对于给定的随机变量 ,它的两个概率分布函数 和 的区别可以用KL散度来度量:KL散度非负:当它为 0 时,当且仅当P和Q是同一个分布(对于离散型随机变量),或者两个分布几乎处处相等(对于连续型随机变量)。KL散度不对称: 。直观上看对于 ,当 较大的地方, 也应该较大,这样才能使得 较小。

对于 较小的地方, 就没有什么限制就能够使得 较小。这就是

KL散度不满足对称性的原因。

交叉熵

cross-entropy:。- 交叉熵刻画了使用错误分布 来表示真实分布 中的样本的平均编码长度。

- 刻画了错误分布 编码真实分布 带来的平均编码长度的增量。

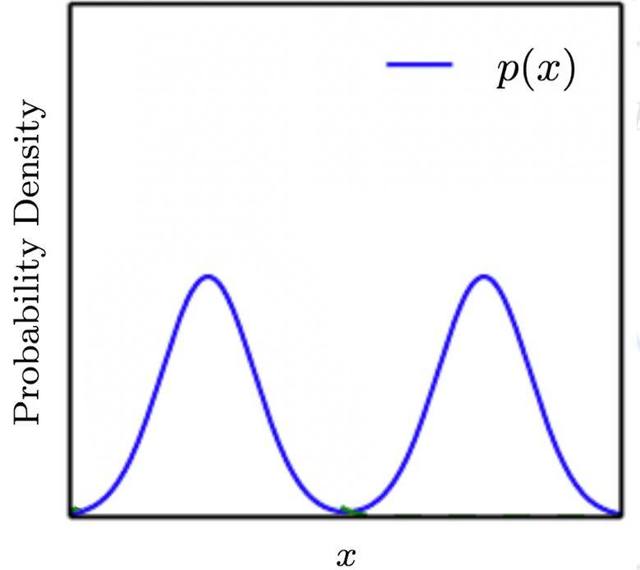

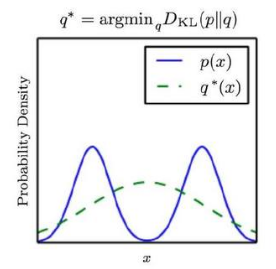

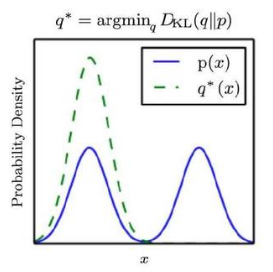

示例:假设真实分布 为混合高斯分布,它由两个高斯分布的分量组成。如果希望用普通的高斯分布 来近似 ,则有两种方案:

如果选择 ,则:

- 当 较大的时候 也必须较大 。如果 较大时 较小,则 较大。

- 当 较小的时候 可以较大,也可以较小。

因此 会贴近 的峰值。由于 的峰值有两个,因此 无法偏向任意一个峰值,最终结果就是 的峰值在 的两个峰值之间。

如果选择 ,则:

- 当 较小的时候, 必须较小。如果 较小的时 较大,则 较大。

- 当 较大的时候, 可以较大,也可以较小。

因此 会贴近 的谷值。最终结果就是 会贴合 峰值的任何一个。

绝大多数场合使用 ,原因是:当用分布 拟合 时我们希望对于常见的事件,二者概率相差不大。

八、其它

假设随机变量 满足 ,且函数 满足:处处连续、可导、且存在反函数。 则有:

或者等价地(其中 为反函数):

如果扩展到高维空间,则有:

并不是 ,这是因为 引起了空间扭曲,从而导致 。

根据 ,求解该方程,即得到上述解。

机器学习中不确定性有三个来源:

模型本身固有的随机性。如:量子力学中的粒子动力学方程。

不完全的观测。即使是确定性系统,当无法观测所有驱动变量时,结果也是随机的。

不完全建模。有时必须放弃一些观测信息。

如机器人建模中:虽然可以精确观察机器人周围每个对象的位置,但在预测这些对象将来的位置时,对空间进行了离散化。则位置预测将带有不确定性。