十一、Pinterest Recommender System[2017]

虽然已经有很多关于高级推荐系统及其实际应用的论文发表,但是通常不可能直接构建

state-of-the-art的推荐系统。最初的产品initial product必须用一个小的工程团队、有限的计算资源、以及缺乏训练数据来构建,直到推荐系统被启用bootstrapped。工业级的推荐系统通常处理包含数十亿个item的Web-scale数据。由于内容是通过用户隐式反馈implicit user feedback收集的,因此内容通常标记不佳并且有很大噪音noisy。因此,很多从业者在构建初始系统时选择使用临时的启发式方法heuristics来trade-off。但是,系统的进一步增长grow会使得系统迅速复杂化,从而难以应对接下来的变化。在论文

《Related Pins at Pinterest: The Evolution of a Real-World Recommender System》中,作者给出了在Related Pins背景下以独特的机会在三年的时间范围内观察这些问题。Related Pins的初始版本是在2013年推出的,是Pinterest首次进入推荐系统的尝试之一。尽管在改善内容发现content discovery取得了成功,但是Related Pins最初在工程上受到的关注很少。2014年,Pinterest上大约10%的pins saved是通过Related Pins发现discovered的。2015年,一个小团队开始迭代并进一步开发Related Pins。现在,Related Pins通过多个产品界面product surfaces推动了超过40%的保存save和曝光impression,并且是Pinterest上的主要发现机制primary discovery mechanisms之一。论文通过对Related Pins的纵向研究,探索了现实世界中推荐系统的挑战。在描述Pinterest系统的逐步演变时,作者提出了应对这些挑战的解决方案、trade-off的理由、以及学到的关键洞察key insights。现实世界的推荐系统已经作为音乐推荐

music suggestion、图像搜索image search、视频发现video discovery、电影发现movie discovery。其中很多论文描述了final system,然而并没有描述如何逐步增量地incrementally构建系统。《Hidden technical debt in machine learning systems》描述了现实世界推荐系统面临的很多挑战,我们提供了在Related Pins中这些挑战的具体例子,并提出了独特的解决方案。- 对于

Related Pins,我们首先考虑最简单、性价比最高highest-leverage的产品,从而达到增量式的里程碑incremental milestones并证明可行性viability。我们最初的推荐算法由一个简单的候选生成器candidate generator以及很多启发式规则heuristic rules组成。尽管它仅在三周内建成,但是它利用了user-curated boards中的强烈信号strong signal。我们继续添加更多的候选源candidate sources,因为我们发现了覆盖率coverage和召回率recall之间的gap。 - 随着时间的推移,我们引入了

memorization layer来提高热门的结果popular results。Memboost在工程复杂度和计算强度方面都是轻量级的,但是它能显著地利用大量的用户反馈user feedback。我们不得不考虑位置偏差position bias,并以反馈回路feedback loops的形式处理复杂性complexity,但是发现付出的代价是值得的。 - 接下来我们添加了一个机器学习的

ranking组件,因为我们认为它具有最大的影响潜力。我们从只有九个特征的基础线性模型开始。当我们发现模型和训练方法的缺点时,我们开始尝试使用更高级的方法。

每个组件最初都是在工程和计算资源上有很多限制的情况下构建的,因此我们优先考虑了最简单和最高效的解决方案。我们展示了有机增长

organic growth如何导致一个复杂的系统,以及我们如何管理这种复杂性。- 对于

11.1 系统介绍

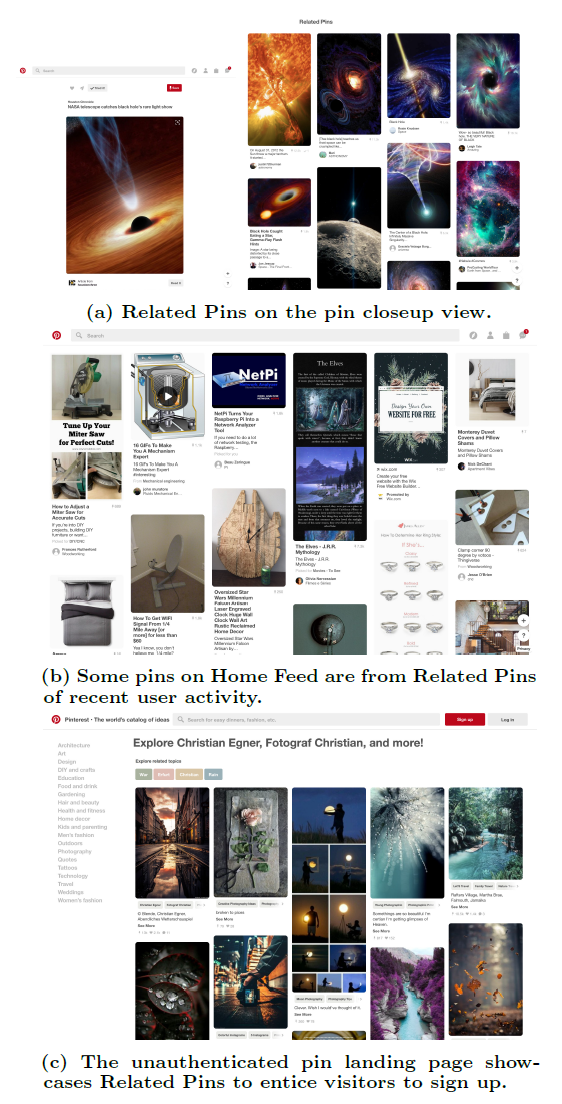

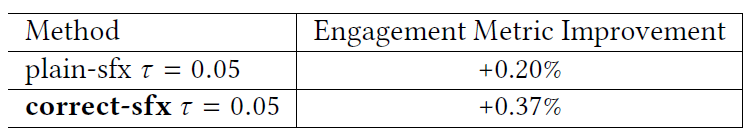

Pinterest是用于保存saving和发现discovering内容content的可视化发现工具visual discovery tool。用户将他们在Web上找到的内容另存为pins,并在boards上创建这些pins的集合。Related Pins利用这些人类收藏的human-curated内容基于给定的query pin来提供个性化的pin推荐。下图给出了pin特写视图pin closeup view。Pinterest其它几个部分也包含Related Pins推荐,包括主页feed流home feed、访客(身份未验证的访问者)的pin page、相关想法related ideas的instant ideas按钮、电子邮件email、通知notification、搜索结果search result、浏览选项卡Explore tab。

Pinterest上的用户互动user engagement通过以下操作来定义:- 用户通过点击来查看有关

pin的更多详细信息从而特写closeup这个pin。 - 然后,用户可以点击从而访问关联的

Web链接。如果用户长时间off-site,那么被视为长按long click。 - 最后,用户可以将

pin保存到自己的board上。

我们对推动相关

pin的保存倾向Related Pins Save Propensity很感兴趣,它的定义是:保存Related Pins推荐的pin的数量除以用户看到的Related Pins推荐的pin的数量。- 用户通过点击来查看有关

在

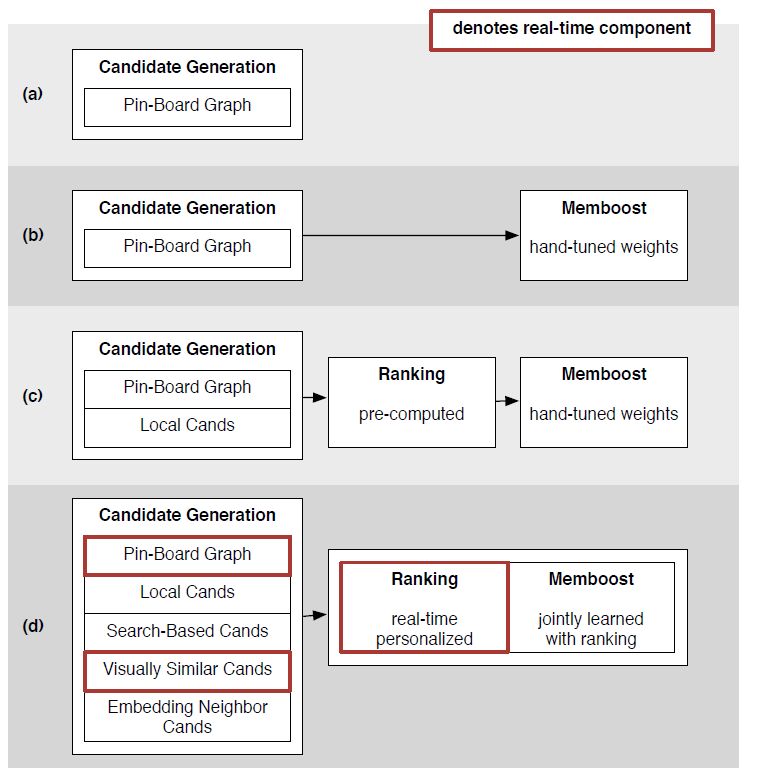

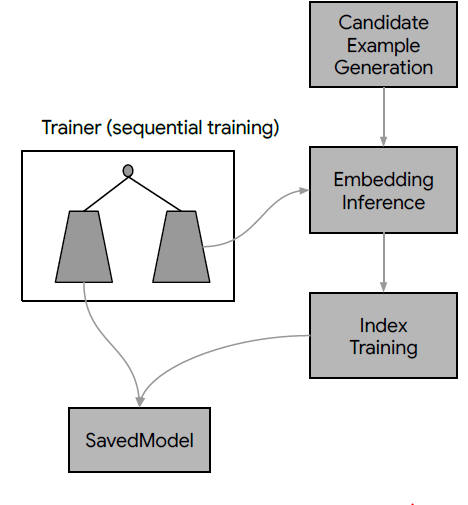

Pinterest数据模型data model中,每个pin都是一个带链接link和描述文本description的图像实例image instance,其中图像是通过一个图像签名signature来唯一标识的。尽管每个pin位于单个board上,但是同一个图像可以用于不同board上的很多pin:当pin保持到一个新的board上时,会创建该pin的拷贝。pin信息通常在image signature level上进行汇总,从而提供了比单个pin实例相比更丰富的元数据meta-data(比如pin粒度的点击量、保存量)。为方便起见,将来对query pin和result pin的引用实际上指的是pin的集合,该集合中的pin具有相同image signature。Related Pins系统包含以下三个主要组件components。随着时间的推移,这些组件已经被陆续引入到系统中,并且每个组件以各自的方式发生了巨大的演变 。下图给出了我们体系结构的各种快照snapshots,说明了整个系统以及三个组件的演变evolution。本文后续部分将更详细地探讨它们的发展。Candidate Generation组件:我们首先将候选集合candidate set(符合Related Pin推荐的pin集合)的范围从数十亿缩小到大约1000个可能和query pin相关related的pin。我们已经开发并迭代了几种不同的候选生成器

candidate generators来做到这一点。Memboost组件:我们系统的一部分会记住历史上特定query和result的pair对上的互动。我们描述了在使用历史数据时,如何通过使用点击除以期望点击的方式来解决位置偏见position bias问题。引入记忆会增加带有反馈回路

feedback loops系统的复杂性,但是会显著提高互动engagement。Ranking组件:我们应用一个机器学习的ranking model到pin上,对这些pin排序从而最大化我们的Save Propensity的目标互动指标target engagement metric。该模型结合了query特征、candidate pins特征、用户画像特征、session上下文特征、Memboost信号等特征的组合。我们采用了

learning-to-rank技术,采用历史用户互动user engagement来训练系统。

11.2 Candidate Generation 的演变

最初的

Related Pins系统仅包含一种形式的候选生成candidate generation:通过抽取经常共现co-occurring的pins来利用pin-board graph。这些候选pins作为推荐直接显示给用户(上图的(a))。后来我们引入了

Memboost和machine-learned ranking时,候选生成的问题从precision转移到了recall:生成和query pin相关的各种各样diverse的pins集合。由于我们发现了覆盖率coverage和召回率recall方面的差距,这导致我们添加了新的候选源candidate sources(上图的(d))。

11.2.1 Board 共现

我们主要的候选生成器

candidate generator是基于用户收藏的user-curatedboards和pins的graph,但是随着时间的推移我们改变了这个方法从而产生更相关relevant的结果并覆盖更多的query pins。启发式候选

Heuristic Candidates:原始的Related pins是在离线Hadoop Map/Reduce作业中计算的。我们输入boards的集合,输出在同一个board上共现的pin pair对。由于有太多的pin pair对,因此对于每个pin query我们随机采样这些pair对从而为每个pin query产生大致相同数量的候选。随机采样时,共现次数越高的

pin pair对被采样到的可能性越高,因此相当于选择top共现次数的pin pair。但是基于采样的方法避免了对pin pair的共现计数、以及对计数结果的排序。我们还基于粗略

rough的文本和类目category匹配来添加启发式的相关性得分heuristic relevance score。这个相关性得分是通过检查示例结果example results来手动调优hand-tuned的。我们选择该方法是因为它很简单。由于工程资源有限,该方法是由两名工程师在短短三周内实现的。另外,由于人类收藏

human-curatedboard graph已经是非常强烈的信号,因此该方法被证明是一种相当有效的方法。在线随机游走

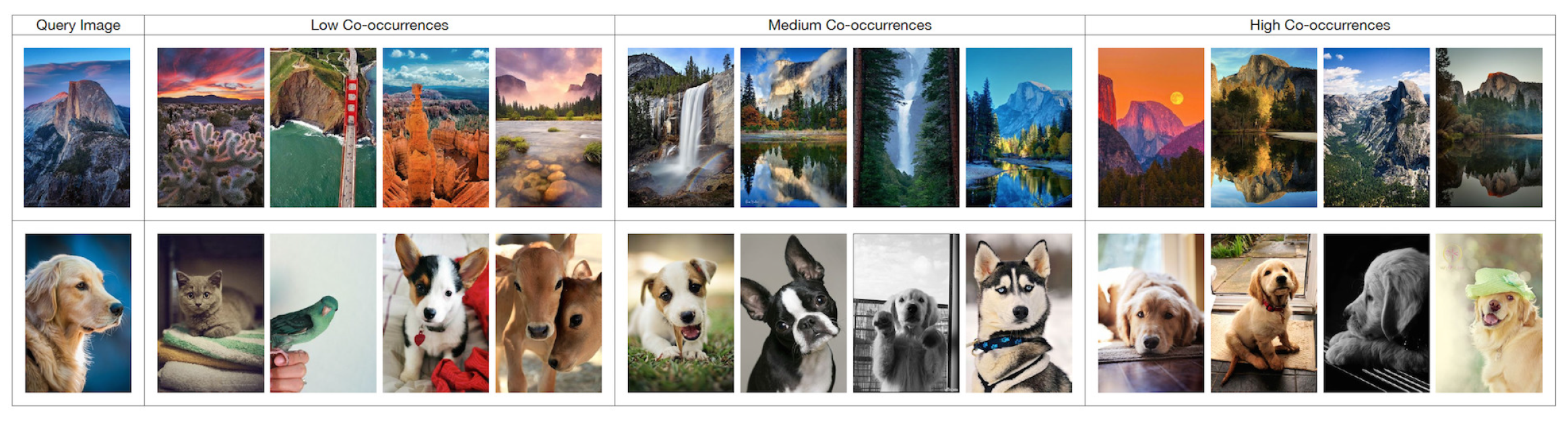

Online Random Walk:我们发现:board共现co-occurrence越高候选item质量越好,如下图所示。然而,原始的方法主要是基于启发式得分

heuristic score,它并没有试图最大化board共现。我们还注意到,罕见

rare的pin(仅出现在少量board上)没有太多的候选item。

为了解决这些局限性,我们通过在线遍历

board-to-pin graph,在serving time生成候选item。现在我们使用一个叫做

Pixie的随机游走服务random walk service来生成候选item。Pixie完整的描述不在本文讨论范围之内,但是从广义上讲,Pixie将pins & boards二部图bipartite graph加载到一台具有大存储容量的机器上。二部图的边代表一个board关联了一个pin。我们根据一些启发式规则heuristic rules裁剪该二部图,从而在board上删除high-degree节点和low-relevance节点。Pixie从query pin开始在二部图上进行多次随机游走(大约100,000步),并在游走的每一步都有reset概率,最终汇总pin的访问次数。这样可以有效地计算出二部图上query pin的Personalized PageRank。该系统可以更有效地利用

board的共现,因为高度相关联highly connected的pins更可能被随机游走访问到。它还可以增加罕见pins的候选覆盖率candidate coverage,因为它可以检索距离query pin好几个hops的候选item。pins的共现代表了pin-board-pin的二阶邻近性,而随机游走方法可以检索pin-board-pin-board-pin这类的高阶邻近性从而提高罕见pins的候选覆盖率。

11.2.2 Session 共现

board共现在生成候选集时提供了良好的召回recall,但是死板rigid的、基于board的分组具有固有的缺陷inherent disadvantages。boards通常过于宽松broad,因此board上的任何pin pair对可能仅仅是很微弱地相关。对于生命周期很长的boards而言尤其如此,因为board的主题topic会随着用户的兴趣而漂移drift。boards也可能过于狭窄narrow。例如,威士忌和用威士忌调制的鸡尾酒可能被安排在不同的、但是相邻的boards上。

这两个缺点可以通过结合用户行为的时间维度

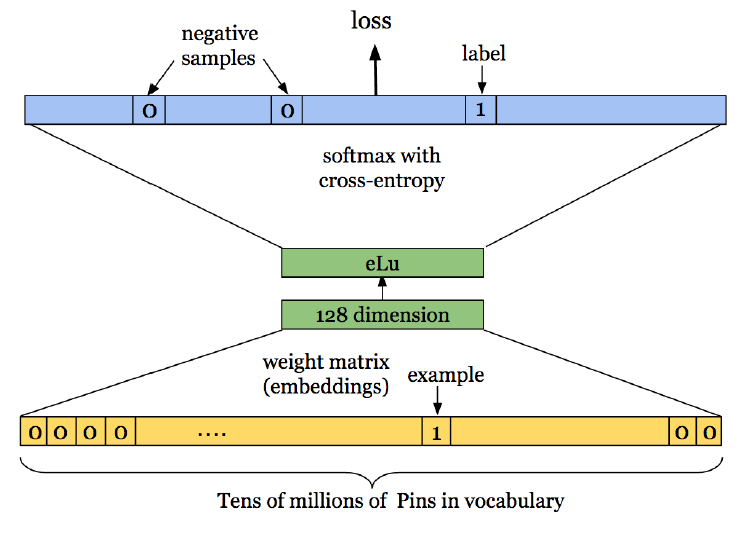

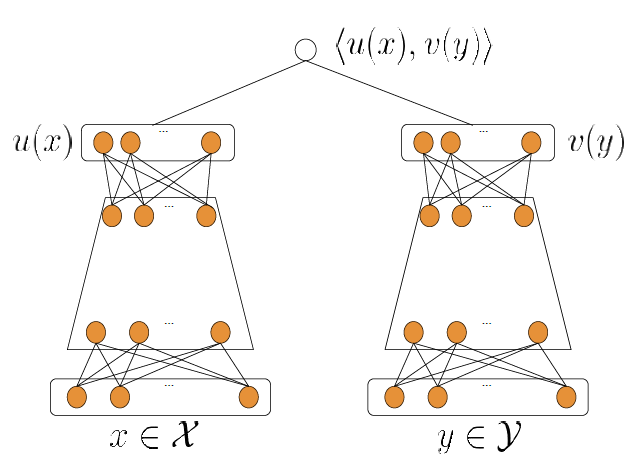

temporal dimension来解决:在同一个会话session期间保存的pins通常以某种方式关联。我们建立了一个名为Pin2Vec的额外侯选源candidate source,从而利用这些session共现co-occurrence信号。Pin2Vec是在d维空间中嵌入N个最热门的pins的一种学习方法,目标是将同一个session中保存的pins之间的距离最小化。Pin2Vec神经网络的架构类似于Word2Vec。学习问题learning problem被表述为N路分类问题,其中输入和输出均为N个pins之一,如下图所示。

为了产生训练数据,我们认为同一个用户在特定时间窗口内保存的

pins是相关的。每个训练样本都是这样的一对pins。给定

pin pair对的其中一个pin作为输入,一个embedding matrix将pin ID映射到d维向量,然后一个softmax layer将embedding向量映射回预测的输出pin ID。这个pair对的另一个pin作为预期的输出,然后我们通过最小化网络的交叉熵损失来训练embedding。我们还使用负样本采样从而使得训练过程更简单。- 模型是通过

TensorFlow来构建和训练的,结果得到了N个pins中每个pin的d维embedding。 - 在

serving时,当用户query了N个pins中的某个时,我们通过在embedding空间中查找query pin最近的邻居来生成候选集。 - 我们发现,

session-based候选集和board-based候选集结合起来会大大提高相关性relevance。从概念上讲,session-based方法以紧凑compact的向量representation捕获了大量用户行为。

- 模型是通过

11.2.3 补充的候选

在取得上述进展的同时,出于两个原因,我们开始开发新的候选生成技术:

- 首先,我们想解决冷启动问题:罕见

pins没有很多候选,因为它们没有出现在很多boards上。 - 其次,在添加了

Ranking模块之后,我们希望在结果的多样性diversity带来更多互动engagement的情况下扩大我们的候选集。

出于这些原因,我们开始利用其它的

Pinterest discovery技术。- 首先,我们想解决冷启动问题:罕见

基于搜索的候选

search-based candidates:我们利用Pinterest的text-based search来生成候选,其中使用query pin的注释annotations(来自于web link或者描述descriptioin的单词)作为query tokens。每个热门的search query都有Pinterest Search提供的预计算的pin集合来支持。这些基于搜索的候选相对于基于

board共现的候选而言相关性较低,但是从探索exploration的角度来看,这是一个不错的折衷trade-off方案:基于搜索的候选产生了更多样化diverse的pin集合,而且这些pin集合仍然和query pin具有相关性。视觉相似的候选

visually similar candidates:我们有两个视觉候选源。- 如果某个

image和query image是几乎重复near-duplicate的,那么我们将该image添加到Related Pins推荐结果中。 - 如果没有和

query image几乎重复的image,那么我们使用Visual Search后端基于query image embedding向量的最近邻查找lookup来返回视觉相似的image。

- 如果某个

11.2.4 分区的候选

最后我们要解决内容激活问题

content activation problem:罕见的pins不会作为候选pins出现,因为它们不会出现在很多board上。当

Pinterest开始专注于国际化时,我们希望向国际用户展示更多的以他们自己语言的结果。大部分内容是来自美国的英语。尽管确实存在本地化内容local content,但是这些内容不是很热门,也没有链接到热门的pins,因此不会被其它侯选源来生成。为了解决这个问题,我们为上述许多生成技术生成了按本地化分区

segmented by locale的附加additional候选集。例如,对于board共现,我们将board-pin graph的输入集合过滤为仅包含本地化locale的pins。这种方法也可以扩展到存在内容激活问题的其它维度,例如特定于性别

gender-speci fic的内容或者新鲜fresh的内容。

11.3 Memboost 的演变

最初的

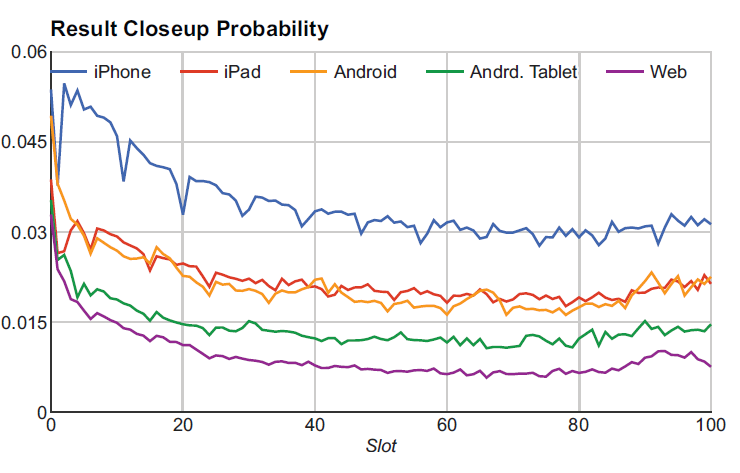

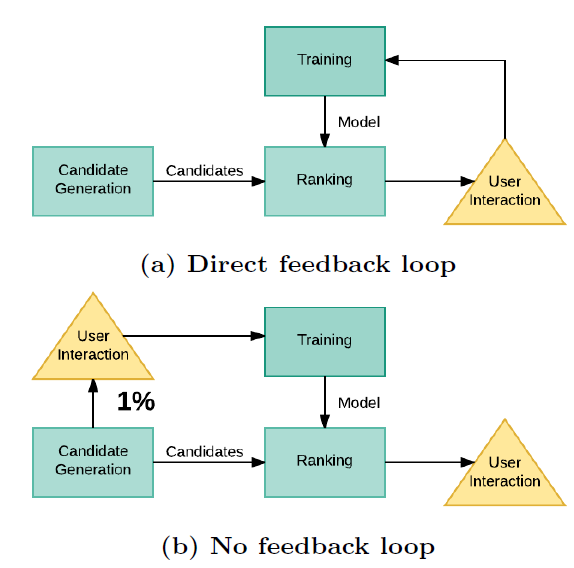

Related Pins版本已经获得了大量的互动engagement。作为从大量互动日志中学习的第一步,我们构建了Memboost来记住每个query的最佳pins结果。我们选择在尝试全面学习之前实现Memboost,因为它更轻量级lightweight,并且我们直觉上相信它会有效。我们最初只是想简单地合并每个结果的历史点击率

historical click-through rate。但是,日志数据容易受到位置偏见position bias的影响:显示在更前面位置的item更容易被点击。下图说明了每个平台platform上不同rank的全局点击率的bias(排名越小则显示越靠前)。为解决这个问题,我们选择了计算clicks over expected clicks: COEC。

COEC:令 为result pin r在query pin q上获得的总点击量。令 为平台 、rank上result pin r在query pin q上获得的总曝光量。每个曝光贡献了一定比例的期望点击expected clicks。result pin r在query pin q上的期望点击量为:其中 为平台 、

rank的全局先验global prior的点击率。这里面的 是根据统计数据计算而来。上面公式的物理意义为:点击 = 曝光 x

ctr,但是对platform和rank求积分。我们将这些定义扩展到其它互动行为(不仅仅是点击),将这些互动行为的权重设为 :

现在 为对所有互动行为泛化的

COEC。Memboost score:为了获得一个zero-centered score,其中正值和负值分别表示结果比期望多互动多少和少互动多少,我们使用COEC的对数。另外我们还引入平滑来处理低互动或低曝光的

item。因此,总体的Memboost score为:Memboost score用于调整现有的pin score,并根据调整后的score来排序得到最终结果:历史上,

Memboost权重 通过A/B test来人工调优hand-tuned,从而最大化互动engagement。然而,这种做法会给评分函数带来不良的耦合影响:尝试使用新的ranker或者改变评分函数可能会产生更大或更小的初始得分initial scores,从而无意中改变了Memboost权重的相对大小。人工调优的权重对于新的条件condition(系统改变、不同的时间段等等)不再是最优的。每次改变 时,都需要重新调优

Memboost的超参数。为了消除这种耦合,我们现在在改变模型时共同训练

Memboost参数。我们将Memboost作为特征,Memboost的临时变量取值(clicks、Eclicks等等)作为特征馈入到基于机器学习的ranker中。Memboost Insertion:有时,已知某些item是好的(基于它们的Memboost scores),但是由于候选生成器和ranking sytem等上游的变化,这些item不再出现在候选结果中。为了处理这些情况,我们设计了一个

Memboost insertion算法。该算法将Memboost score最高的top-n item插入到候选结果中,如果这些item并未出现在候选结果中。将

Memboost结果作为一路召回。Memboost本质上就是记忆性memorization,它会记住历史上表现好的(query pin q, result pin r)。由于模型通常综合考虑了memorization和generization,因此一些历史表现好的pair可能会被稀释掉。Memboost作为一个整体,通过在系统中添加反馈回路feedback loops,显著增加了系统的复杂性。从理论上讲,它可以破坏corrupting或者稀释diluting实验结果:例如,实验中的正样本可能被挑选出来并泄漏到控制组和对照组(因为控制组和对照组都收到了反馈回流的Memboost数据)。重新评估历史的实验(例如添加了新的模型特征)变得更加困难,因为这些实验的结果可能已经被记住了。这些问题存在于任何基于记忆

memorization-based的系统中,但是Memboost具有显著的正向效果,因此我们也就接受了这些潜在的不足。我们目前正在实验替代

Memboost insertion的方法。Memboost insertion会减缓开发速度development velocity,因为有害harm结果的实验可能不再显示为负向的A/B test结果。而且新的ranking方法的试验效果可能被稀释,因为top结果可能被Memboost insertion所主导。Memboost insertion也可以无限期地维持候选items,即使候选生成器不再生成这批候选items(这批候选items由Memboost insertion产生,并始终在线上生效)。一种常见的替代

memorization方法是将item id作为ranking特征。但是,这需要一个大的模型(模型规模和被记忆的item数量呈线性关系),因此需要大量的训练数据来学习这些参数。这样的大型模型通常需要分布式训练技术。取而代之的是,Memboost预先聚合了每个result的互动统计量engagement statistics,这使得我们能够在单台机器上训练主力ranking模型。

11.4 Ranking 的演变

在引入

Ranking之前,Candidate Generation和Memboost已经工作了相当长的一段时间。我们假设下一个最大的潜在提升potential improvement将来自于我们在系统中添加一个ranking组件,并应用learning-to-rank技术。第一个

learning-to-rank模型大幅度提升了Related Pins的互动engagement,使得用户保存save和点击click结果提升了30%以上。在我们的

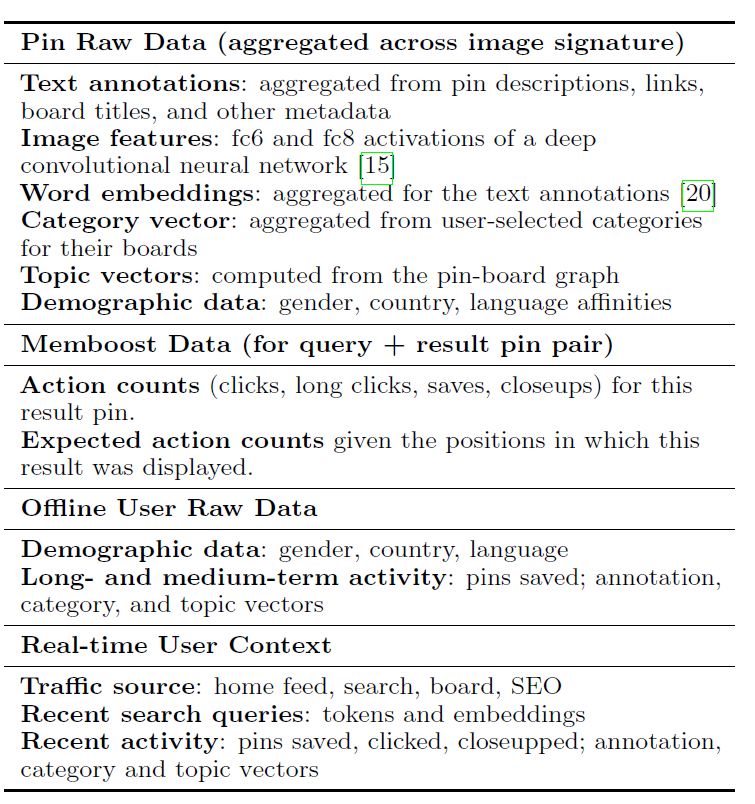

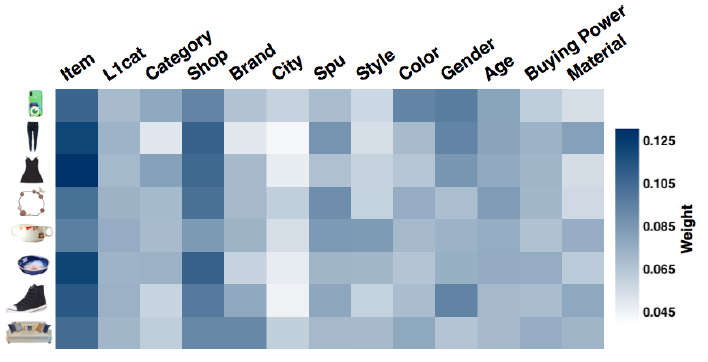

application中,ranker在特定query的上下文中对候选pins进行重新排序re-order。其中query包括query pin、浏览的用户、以及用户上下文user context。这些query部分和候选pin各自贡献了一些异质heterogeneous的、结构化structured的原始数据,例如注释annotations、类目categories、或者最近的用户活动user activity。如下表所示,给出了ranking feature extractor中样本可用的原始数据。我们定义了很多特征抽取器

feature extractors,这些特征抽取器输入原始数据并生成单个特征向量 。- 某些特征抽取器直接将原始数据拷贝到特征向量中,例如

topic向量和category向量。 - 另一些特征抽取器则计算原始数据的变换,如

Memboost数据的归一化normalized或者re-scaled的版本。 - 一些特征抽取器将

one-hot encoding应用于离散字段categorical fields,例如性别、国家。 - 最后,一些特征抽取器计算匹配分

match scores,例如query pin和candidate pin之间的类目向量category vector的余弦相似度,或者query image和candidate image之间的embedding距离。

ranking模型 输入特征向量并产生最终的ranking score。这个ranking模型是从训练数据中学习的,其中训练数据在后文中描述。

- 某些特征抽取器直接将原始数据拷贝到特征向量中,例如

我们的第一个

ranking系统仅使用pin原始数据。随着我们获得了额外的工程能力来构建必要的基础架构,我们将更多数据(如Memboost数据和用户数据)引入到ranking系统。我们还引入了从用户最近活动recent activities中抽取的个性化特征,如用户最近的search query。

11.4.1 选择

在构建

ranking系统时,我们面临三个重大largely的正交orthogonal的决策:- 训练数据集收集方法

training data collection method。 - 学习目标函数

learning objective。 - 模型类型

model type。

正交指的是决策之间互不影响。

- 训练数据集收集方法

训练数据集收集:我们探索了训练数据的两个主要数据源:

Memboost scores作为训练数据。从概念上讲,在没有足够日志数据来进行可靠的Memboost估计estimate的情况下,ranker可以学习预测query-result pair对的Memboost scores。即,对于无法从日志数据计算

Memboost scores的query-result pair对,可以通过模型来预测。单个

Related Pins session: 会话session定义为单个用户以单个query pin和Related Pins进行交互的结果。我们可以将这些交互直接作为训练数据的样本。

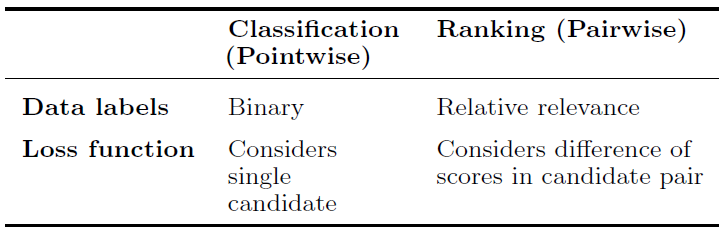

模型目标函数:在

《Learning to rank for information retrieval》中,learning-to-rank方法大致可以分为point-wise方法、pair-wise方法、list-wise方法。这些方法之间的主要区别在于:损失函数是一次考虑一个候选item、两个候选item、还是多个候选item。在我们的工作中,我们探索了

point-wise方法和pair-wise方法,如下表所示。

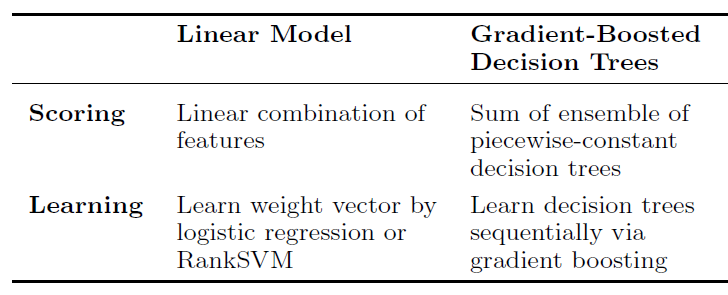

模型形式

formulation:模型的精确precise形式form决定了模型来描述特征和score之间复杂关系的能力。下表比较了我们使用的两种模型类型model types。

11.4.2 决策演变

下表给出了我们在

Related Pins Ranking中探索的训练数据、目标函数以及模型的各种组合。

第一版

V1:Memboost训练数据、相关性pair标签relevance pair labels、pair-wise损失函数、线性RankSVM模型。在我们的第一版中,我们选择使用

Memboost数据,因为我们发现Memboost数据是高质量的信号:它是在很长一段时间内数百万用户行为的聚合。我们为每个

query显式采样pair对 ,其中:- 是针对

query pin的Memboost scores最高pin。 - 是针对

query pin的Memboost scores最低pin。 - 是从

Pinterest随机采样的一个热门的pin,用于稳定排名(如论文《Optimizing search engines using clickthrough data》所示)。

我们认为,由于候选生成器提供了一定程度的相关性

relevance,因此具有较低Memboost scores的pin仍然比随机pin更相关relevant。当我们从

Memboost数据中人工检查pair对时,我们发现大约70%的时间可以猜测哪个pin的Memboost score更高。这表明训练数据是相当干净clean的 。相比之下,从每个user session中采样的pair对的噪声很大,我们无法确定用户保存了两个pin中的哪一个。因此,我们可以使用一个小得多的语料库,并且在几分钟之内在单台机器上训练一个模型。

- 是针对

第二版

V2:转向单个individual的Related Pins sessions。我们希望使用用户特征和上下文特征,但是使用

Memboost数据固有地inherently会排除个性化,因为Memboost数据是在很多用户上聚合的,从而失去了与单个用户以及session上下文的关联。此外,我们发现只有热门的内容才具有足够的交互,从而提供可靠的Memboost数据。这些局限性促使我们转向单个Related Pins sessions。每个记录

logged的session均由query pin、浏览的用户、最近的动作上下文action context、result pins列表a list of result pins来组成。每个result pin还具有一个对应的互动标签engagement label(可以为以下之一:仅仅曝光impression、特写closeup、点击click、长点击long click、保存save)。出于训练的目的,我们裁剪记录

logged的pin集合,按照rank order取每个互动的pin以及紧紧排在它前面的两个前序的pins。我们假设用户可能看到了紧紧排在互动pin之间的前序pins。在

V2版中,我们继续使用pair-wise损失,但是pin relevance pairs由动作的相对顺序来定义:save > long click > click > closeup > impression only。第三版

V3:转向一个RankNet GBDT模型。我们发现,简单的线性模型能够从

ranking中获得大部分的互动增益engagement gain。但是,线性模型有几个缺点:首先,它迫使

score和每个特征的依赖关系为线性的。为了让模型表达更复杂的关系,工程师必须人工添加这些特征的转换(分桶bucketizing、分区间percentile、数学转换mathematical transformations、归一化normalization)。其次,线性模型无法添加仅依赖于

query pin而不依赖于候选pin的特征。例如,假设特征 代表一个类似于query category = Art的特征,每个候选pin将具有相同的特征(因为query是同一个),所以对于ranking结果毫无影响。query-specific特征必须和候选pin的特征进行手动交叉,例如添加一个特征来表示query pin category + candidate pin category。设计这些交叉特征费时费力。

为避免这些缺点,我们转向梯度提升决策树

gradient-boosted decision trees: GBDT。除了允许对单个特征进行非线性响应外,决策树还固有地考虑了特征之间的交互,这对应于树的深度。例如,可以对推理

reasoning进行编码,如 “如果query pin category为Art,那么视觉相似性应该是更强的相关性信号relevance signal” 。通过自动学习特征交互feature interactions,我们消除了执行人工特征交叉的需要manual feature crosses,加快了开发速度。第四版

V4:转向point-wise分类损失、二元标签binary label、逻辑回归GBDT模型。尽管我们最初选择了

pair-wise learning,但是我们也已经在point-wise learning中取得了良好的结果。由于我们在线实验的主要目标指标target metric是用户保存result pin的倾向propensity,因此使用包含closeups和clicks的训练样本似乎会适得其反,因为这些动作可能不会影响保存倾向save propensity。我们发现给样本提供简单的

binary标签(saved或者not saved),并且重新加权reweighting正样本来对抗类别不平衡,这在增加保存倾向方面被证明是有效的。将来,我们仍然可以使用不同的pair采样策略来实验pair-wise ranking loss。

11.4.3 Previous-Model Bias

在我们努力改进

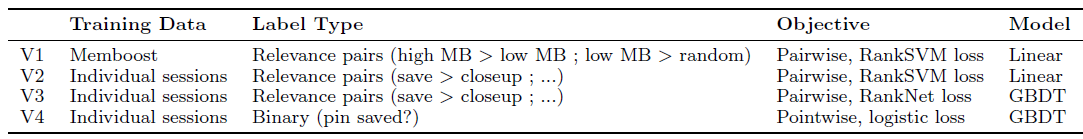

ranking的过程中,我们遇到了一个重大的挑战。因为互动日志engagement logs用于训练,所以我们引入了直接反馈环direct feedback loop,如论文《Hidden technical debt in machine learning systems》所述:当前部署currently deployed的模型极大地影响了为将来模型future models生成的训练样本。我们直接观察到了这个反馈环的负面影响

negative impact。当我们训练第一个ranking model时,日志反映了用户对仅由候选生成器排序的结果的互动。所学的模型被用于对这批候选进行排序。在接下来的几个月里,训练数据只反映了现有模型中排序较高的pins的互动(如下图(a)所示)。当我们尝试使用相同的特征和最近的互动数据来训练一个模型时,我们无法击败已经部署的模型。我们认为反馈环带来了一个问题,即训练时

pin分布和serving时的pin分布不再匹配。训练时的

pin分布:由老模型产生;serving时的pin分布:由新模型产生(由新模型排序并截断)。

为了缓解训练数据中的

previous-model bias,我们为unbiased data collection分配了一小部分流量:对于这些请求,我们显示了来自所有候选来源的随机样本,并且没有ranking而随机排序。这将训练数据和之前的模型隔离开来(如上图(b)所示)。虽然未排序

unranked的result质量较低,但是它们为训练新的ranking model提供了有价值的数据。为了避免过多降低任何特定用户的体验,每个用户只在一小部分随机query中获取未排序的pins。尽管训练数据的数量被限制在总流量的这一小部分,但是最终得到的模型要比用有偏的数据biased data训练的模型表现得更好。仅用这

1%的随机流量来训练模型,会不会因为数据量太低而降低模型效果?一种方法是:将这1%流量的样本加权(比如加权10倍),然后和剩余99%流量的样本一起训练。

11.4.4 衡量指标

能够探索这些不同选项的一个重要

step是能够快速迭代。测试变更效果的金标准gold standard是在线A/B test实验,其中我们主要根据save propensity来评估ranking。所有的变更都要经过在线实验,但是在线

A/B test通常需要几天或者几周的时间来收集数据。我们认为,通过离线评估来马上测试变更效果从而近似approximate不同模型的性能是有帮助的。在这个过程中,我们重复使用了很多训练数据生成器来采样每个Related Pins sessions(即,生成训练集),但是选择了一个紧跟着训练日期的不同日期范围、以及一个和训练采样策略稍微不同的采样策略(即,生成测试集)。对于每个session,我们使用被测模型对用户实际看到的pins(即,label)进行重新打分rescore(即,预测),然后评估预测的score和记录的用户行为之间的一致性。我们已经尝试了多种度量方法,包括

normalized discounted cumulative gain: NDCG、PR AUC。为了确定这些离线指标在多大程度上预测了在线

A/B test影响,我们检查了我们过去几次ranking model变更的结果。我们检查了通过离线评估预测差异(即新模型和baseline模型在测试集评估指标上的差异)的方向和大小,并将其与实际实验结果进行比较。我们发现:PR AUC指标对于A/B test实验中的closeups和click-throughs具有极强的预测性,但是我们很难用离线评估来预测save行为。目前,我们将离线指标用作健全性检查

sanity check和潜在影响potential impact的粗略估计rough estimation。

11.4.5 Serving 架构

Related Pins在峰值负载下每秒可以处理数万个query。为了处理这种规模,我们利用了几个现有的Pinterest系统。我们的第一版

pin ranking是在离线的Map-Reduce作业中预计算pre-computed的,并由Terrapin提供服务(这是一个不可变的key-value的lookup service)。这需要大量的Map-Reduce作业来为每个query和candidate来join原始数据、计算特征、并对item进行打分。由于集群的限制,我们一次只能对几百万个

query进行rank,从而覆盖了50%的用户query。我们通过一次在不同的segments上运行reranking作业并合并结果来scale up,但是这种方法本质上inherently无法在合理reasonable的时间内提供完全覆盖。离线排序也显著降低了开发速度:每个变更模型的实验(特征开发、训练数据变更)都需要离线重新排序

reranking所有的query,这是一个耗时的过程。为此,我们转向在线

ranking serving system。pin的原始数据存储在叫做RealPin的分片sharded的key-value store中,通过image signature作为key。为了执行

ranking,我们将一个请求request和计算特征和score所需的候选pins列表、其它原始数据组装assemble在一起:query pin原始数据(从RealPin检索到)、离线的用户原始数据(从Terrapin而来)、最近的用户活动(从一个叫做UserContextService的service而来)。RealPin root server将请求复制到RealPin leaves server,将合适的候选子集路由到每个leaf server。leaf server在本地检索pin原始数据,并调用我们自定义的特征抽取器custom feature extractor和scorer。注意:

leaf server存储了pin的原始数据。leaf server发送top候选以及相应的score给root server,然后由root server收集并返回全局的top候选集。

我们选择了这种

serving架构来提高数据局部性data locality。基于Hadoop的系统在每次query时都需要传输大量的pin原始数据。我们还看到,由于pin原始数据的传输,其它的online pin scoring系统受到网络的限制。通过将计算下推到存储候选pin原始数据的节点,可以避免大量的数据传输。

11.5 挑战

Changing Anything Changes Everything:根据《Hidden technical debt in machine learning systems》,机器学习系统固有地会纠缠信号tangle signals。输入从来都不是真正独立的,这就产生了Changing Anything Changes Everything: CACE原则:系统的一个组件可以针对系统的现有状态进行高度优化。改进另一个组件可能会导致整体性能下降。这是一个system-level的局部最优点local optimum,可能会使得进一步的进展变得困难。我们的通用解决方案是为每个实验联合train/automate尽可能多的系统。我们提供了一些例子,这些例子说明了在我们的简单推荐系统中出现的这一特殊挑战,以及我们的缓解措施。

例子一:在我们的推荐系统

pipeline的各个阶段中使用了很多超参数。回想一下,我们使用手动调优hand-tuned的权重对Memboost进行调优,并通过耗时耗力的A/B test来进行优化。随着系统其它部分的改变,这些很快就过时了。联合训练Memboost权重避免了这个问题。同样地,ranking learner也有需要调优的超参数。为了避免导致超参数变得次优

sub-optimal的其它变更,我们实现了一个用于自动调参automated hyperparameter tuning的并行系统。因此,我们现在可以在每次变更模型时调优超参数。例子二:对原始数据的 “改进” 可能会损害我们的结果,因为我们的下游模型是基于旧的特征定义进行训练的。即使修复了一个

bug(例如在计算pin的类目向量时),我们现有的模型将依赖于有缺陷的特征定义,因此这个fix可能会对我们的系统产生负面影响。如果变更来自于另一个团队,这尤其会成为问题。在《Hidden technical debt in machine learning systems》中,这被称作不稳定的数据依赖unstable data dependency。目前,我们必须使用更新后的原始数据手动重新训练我们的模型,同时将新模型和更新后的原始数据部署到生产环境中(因为在线部署时需要获取样本特征,所以要将原始数据部署到线上)。除了耗时之外,这个解决方案也不太理想,因为它需要我们了解上游的变化。理想情况下,我们将自动对我们的模型进行连续的再训练

continual retraining,从而将上游数据upstream data的任何变化考虑进来。例子三:最后,我们经历了

candidate generation和ranking之间复杂的相互依赖关系。模型变得和训练数据的特点相协调。例如,变更或引入一个candidate generator会导致ranker的恶化,因为训练数据的分布不再和serving时的ranking数据的分布相匹配。这是我们在训练数据收集中看到的一个问题。如果引入一个

candidate generator无法提高性能,那么如何确定这是由于candidate generator性能较差、还是由于ranker并没有针对这个candidate generator的候选上训练过?我们目前的解决方案是:在用新训练的模型运行实验之前,将

candidate generator得到的候选插入训练集一段时间。这种方案一次改变一个变量:先固定

ranking模型,仅改变candidate generator;然后固定candidate generator,重新训练ranking模型。这个问题强调了尽可能简化系统的必要性,因为可能的非预期交互

unintended interactions的数量随着系统组件的数量而迅速增加。

内容激活:有大量的内容没有互动量,但是这些内容可能是潜在相关

potentially relevant的和高质量high quality的。每天都有数百万张新图像上传到Pinterest。此外还有大量的dark内容,这些dark内容是高质量的,但是很少出现。平衡

fresh or dark内容和完善的、高质量的内容,这代表了经典的探索和利用问题explore vs exploit problem。这是Pinterest的一个开放问题。我们深入探讨了如何针对本地化localization的情况解决内容激活content activation问题。由于

Pinterest是一种日益国际化的产品,因此我们特别努力确保国际用户能够看到他们自己语言的内容。出于两个主要原因,使得Related Pins本地化很困难:- 首先,一开始就没有多少本地化的候选,因为这些本地化内容并没有出现在很多

board上。 - 其次,本地化内容的历史互动要少得多,这导致我们的模型对本地化内容的排名更低,即使我们确实有本地化的候选。(即数据稀疏导致的冷启动问题)

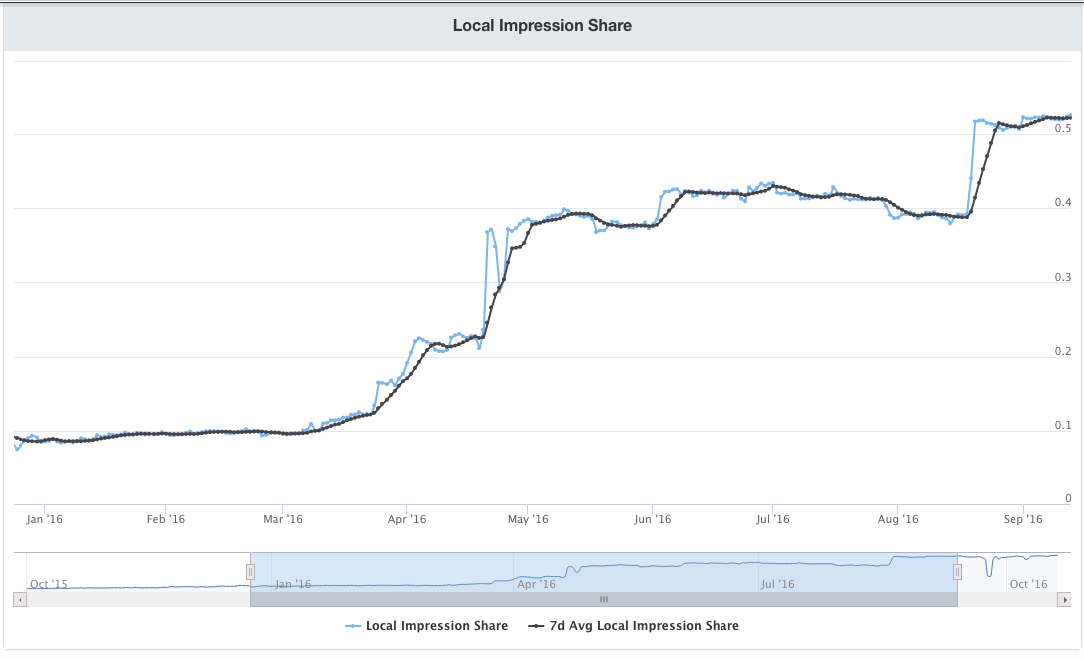

我们尝试了几种方法来解决这些问题,最终能够将本地化

result的占比从9%增加到54%,如下图所示。Local pin swap:对于我们生成的每个相关related的pin,我们检查是否存在具有相同图像的本地化替代local alternative。如果存在,那么我们将result pin换本地化替代的pin。结果,我们增加了本地化的

pin曝光、以及本地化的pin save,而不会改变结果的相关性。Local pin boost:当返回的候选集中存在和浏览者相同语言的pin(即本地化的pin)时,我们试图人为地将本地化的pin的排名提升到result set中更高的位置。事实上证明这并不是特别有效,因为此时的候选集并没有包含很多本地化的

pin,因此该解决方案的覆盖率coverage较低。Localizing candidate sets:我们修改了board-based的候选生成方法,从而在pin采样之前对语言进行过滤,并生成针对每种语言的segmented corpus。此外,为了增加对这些本地化的

pin的曝光,我们选择以不同的比例将本地化的候选混合到result中。

这些手段都是基于业务策略的方法,而不是基于模型的方法。基于模型的方法是后验的、数据驱动的,基于策略的方法是先验的、规则驱动的。当冷启动或其它数据稀疏场景时,策略方法要优于模型方法。

- 首先,一开始就没有多少本地化的候选,因为这些本地化内容并没有出现在很多

十二、DLRM[2019]

个性化

personalization和推荐系统recommendation systems目前已经被部署在大型互联网公司的各种任务中,包括广告点击率预估CTR prediction和排序ranking。尽管这些方法已经有很长的历史,但是直到最近这些方法才包含神经网络。有两个基本观点primary perspectives有助于个性化和推荐的深度学习模型的架构设计architectural design。第一种观点来自推荐系统。这些系统最初采用内容过滤

content filtering,其中一群专家将产品划分为不同的类目categories,用户选择他们喜欢的类目,而系统根据用户的偏好进行匹配。该领域随后发展为使用协同过滤

collaborative filtering,其中推荐是基于用户历史的行为,例如对item的历史评分。邻域

neighborhood方法通过将用户和item一起进行分组grouping从而提供推荐。潜在因子

latent factor方法通过矩阵分解技术从而使用某些潜在因子来刻画用户和item。这些方法后来都取得了成功。

第二种观点来自预测分析

predictive analytics,它依靠统计模型根据给定的数据对事件的概率进行分类classify或预测predict。预测模型从简单模型(例如线性模型和逻辑回归)转变为包含深度网络的模型。为了处理离散数据

categorical data,这些模型采用了embedding技术从而将one-hot向量和multi-hot向量转换为抽象空间abstract space中的稠密表示dense representation。这个抽象空间可以解释为推荐系统发现的潜在因子空间space of the latent factors。

在论文

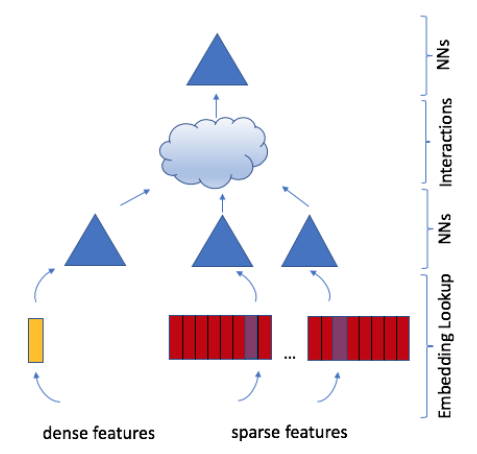

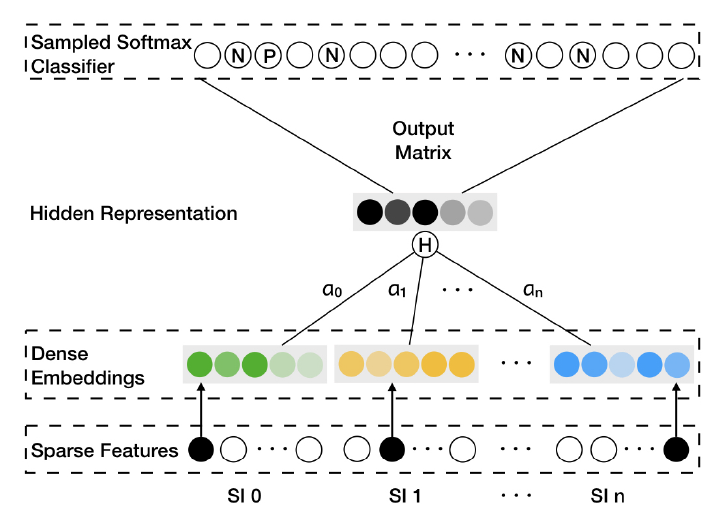

《Deep Learning Recommendation Model for Personalization and Recommendation Systems》中,论文介绍了一个由上述两种观点结合而成的个性化模型。该模型使用embedding来处理代表离散数据的稀疏特征sparse features、使用多层感知机multilayer perceptron: MLP来处理稠密特征dense features,然后使用《Factorization machines》中提出的统计技术显式的交互interacts这些特征。最后,模型通过另一个MLP对交互作用进行后处理post-processing从而找到事件的概率。作者将这个模型称作深度学习推荐模型

deep learning recommendation model: DLRM,如下图所示。该模型的PyTorch和Caffe2的实现已经发布。此外,作者还设计了一种特殊的并行化方案,该方案利用

embedding tables上的模型并行性model parallelism来缓解内存限制memory constraints,同时利用数据并行性data parallelism从全连接层扩展scale-out计算。作者将DLRM与现有的推荐模型进行了比较,并在Big Basin AI平台上实验了DLRM的性能,证明了它作为未来算法实验algorithmic experimentation、以及系统协同设计system co-design的benchmark的有效性。

12.1 模型设计和架构

这里我们将描述

DLRM的设计。我们将从网络的高级组件high level components开始,并说明如何以及为什么将它们以特定方式组装assembled在一起,以及对未来的模型设计产生的影响。然后我们描述组成模型的低级算子

low level operators和原语primitives,以及对未来的硬件和系统设计产生的影响。

12.1.1 DLRM 组件

通过回顾早期模型,我们可以更容易理解

DLRM的高级组件。我们避免全面的科学文献综述,而将重点几种在早期模型中使用的四种技术上,这些技术可以被解释为DLRM的重要高级组件。Embedding:为了处理离散数据,embedding将每个类目category映射到抽象空间abstract space中的稠密表示dense representation。具体而言,每个

embedding lookup可以被解释为使用一个one-hot向量 (第 位为1、其它位为0,索引 代表了第 个类目 )来获得embedding table中的相应行向量row vector:其中 为类目总数, 为抽象空间的维度。

在更复杂的场景中,

embedding也可以表示多个item的加权组合,其中包含一个multi-hot向量的权重:其中 : 代表对应的

item; 代表这些item的权重。包含 个

embedding lookup的mini-batch可以写作:其中 为一个稀疏矩阵。

DLRM利用embedding tables将离散特征映射到稠密表示。然而,即使设计了这些有意义的embedding之后,如何利用它们来生成准确的预测?为了回答这个问题,我们回到潜在因子方法latent factor methods。矩阵分解

Matrix Factorization:回忆一下,在推荐问题的典型公式中,我们得到了对某些item进行评分的某些用户的集合 。其中,集合 由元组 索引组成,表示第 个用户在第 个item上已经评分。我们用向量 来表示represent第 个item、用向量 来表示第 个用户,从而找到所有评分ratings。矩阵分解方法通过最小化以下公式来求解这个问题:

其中 为第 个用户在第 个

item上的评分。令 、 ,我们可以将完整的评级矩阵 近似为矩阵乘积:

其中 为总的

item数量, 为总的用户数量。注意: 和 可以解释为两个

embedding tables,其中每一行代表潜在因子空间latent factor space中的user/item。这些embedding向量的内积可以得出对评级有意义的后续预测,这是因子分解机factorization machines和DLRM设计的关键观察。因子分解机

Factorization Machine:在分类问题中,我们要定义一个从输入数据点 到target label的预测函数 。例如,我们可以通过定义 来预测点击率click-through rate: CTR,其中+1表示点击label、-1表示未点击label。因子分解机

Factorization machines: FM通过以下定义形式的模型,将二阶交互second-order interactions融合到带有离散数据的线性模型中:其中:

- 为模型参数,且 。

upper(.)函数严格选择矩阵的上三角部分。

FM和多项式核polynomial kernel的支持向量机SVM显著不同,因为FM像矩阵分解一样将二阶交互矩阵分解为潜在因子latent factor(或embedding向量),从而更有效地处理稀疏数据。通过仅捕获不同

embedding向量pair对之间的交互,FM显著降低了二阶交互的复杂度,从而产生线性计算复杂度。根据原始公式,

FM的算法复杂度为 ,但是经过数学转换之后,计算复杂度降低到 。多层感知机

Multilayer Perceptrons:最近机器学习的成功很大程度上归功于深度学习的兴起。其中,最基本的模型是多层感知机multilayer perceptron: MLP,它是一个由全连接层fully connected layers: FC和激活函数 交替组成的预测函数prediction function:其中权重矩阵 ,

bias向量 , 。这些方法被用来捕获更复杂的交互

interactions。例如,已经表明:给定足够的参数、具有足够深度depth和宽度width的MLP能够以任何精度precistion拟合数据。这些方法的变体已经广泛应用于各种

application,包括计算机视觉和NLP。一个具体的例子是神经协同过滤Neural Collaborative Filtering: NCF被用作MLPerf benchmark的一部分,它使用MLP而不是内积来计算矩阵分解中embedding之间的交互。

12.1.2 DLRM 架构

目前为止,我们已经描述了推荐系统和预测分析中使用的不同模型。现在,让我们结合它们的直觉

intuitions来构建state-of-the-art的个性化模型。令用户和

item使用很多连续continuous的、离散categorical的特征来描述。- 为了处理离散特征,每个离散特征将由相同维度的

embedding向量来表示,从而推广了矩阵分解中潜在因子的概念。 - 为了处理连续特征,所有的连续特征整体上将被一个

MLP转换(这个MLP我们称之为bottom MLP或者dense MLP),这将产生和embedding向量相同维度的dense representation。

注意:每个离散特征会得到一个

embedding,而所有连续特征整体才能得到一个embedding。我们将根据

FM处理稀疏数据的直觉,通过MLP来显式计算不同特征的二阶交互。这是通过获取所有representation向量(包括每个离散特征的embedding向量、连续特征整体的representation向量)之间的pair对的内积来实现的。这些内积和连续特征

representation(即经过原始连续特征经过bottom MLP之后得到的)拼接起来,馈入另一个MLP(我们称之为top MLP或者output MLP)。最终这个MLP的输出馈入到一个sigmoid函数从而得到概率。我们将这个模型称作

DLRM。top MLP的特征有:显式二阶交互特征、连续representation特征。这里并没有馈入一阶embedding特征。- 为了处理离散特征,每个离散特征将由相同维度的

和早期模型的比较:许多基于深度学习的推荐模型使用类似的基本思想来生成高阶项

term从而处理稀疏特征。例如:Wide and Deep、Deep and Cross、DeepFM、xDeepFM网络等等,它们设计了专用网络specialized networks来系统地构建高阶交互higher-order interactions。然后,这些网络将它们专用网络和MLP的结果相加,并通过线性层和sigmoid激活函数产生最终的概率。DLRM特别地模仿因子分解机,以结构化方式与embedding交互,从而在最终MLP中仅考虑embedding pair对之间的内积所产生的的交叉term,从而显著降低了模型的维度。我们认为,在其他网络中发现的、超过二阶的更高阶交互可能不一定值得额外的计算代价和内存代价。DLRM和其它网络之间的主要区别在于:网络如何处理embedding特征向量及其交叉项cross-term。具体而言:DLRM(以及xDeepFM)将每个embedding向量解释为表示单个类目category的单元unit,交叉项仅在类目之间产生。像

Deep and Cross这样的网络将embedding向量中的每个元素视为单元,交叉项在元素之间产生。因此,

Deep and Cross不仅会像DLRM那样通过内积在不同embedding向量的元素之间产生交叉项,而且会在同一个embedding向量内的元素之间产生交叉项,从而导致更高的维度。

12.2 并行性

现代的个性化和推荐系统需要大型复杂的模型来利用大量的数据。

DLRM尤其包含大量参数,比其它常见的深度学习模型(例如CNN、RNN、GAN)多几个数量级。这导致训练时间长达数周或者更长。因此,更重要的是有效地并行化这些模型,以便在实际数据规模上解决这些问题。如前所述,

DLRM以耦合的方式coupled manner处理离散特征(通过embedding)和连续特征(通过bottom MLP)。embedding贡献了大部分参数,每个lookup table都需要超过几个GB的内存,使得DLRM的内存容量和带宽bandwidth代价昂贵。- 由于

embedding太大,因此无法使用数据并行data parallelism,因为数据并行需要在每个设备上拷贝超大的embedding。在很多情况下,这种内存限制需要将模型分布在多个设备上,从而满足内存容量要求。 - 另一方面,

MLP参数在内存中较小,但是却有相当可观的计算量。因此,对于MLP而言,数据并行是首选的,因为这样可以在不同的设备上同时处理样本,并且仅在累计更新accumulating updates时才需要通信。

我们的并行化

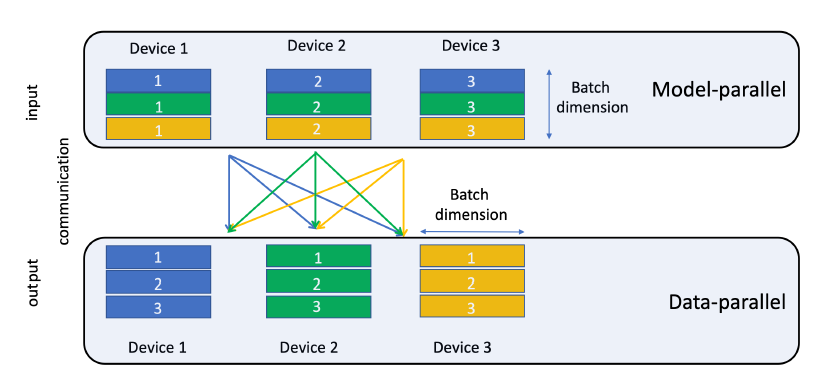

DLRM联合使用模型并行model parallelism和数据并行data parallelism:针对embedding使用模型并行、针对MLP使用数据并行,从而缓解embedding产生的内存瓶颈memory bottleneck,同时并行化MLP上的前向传播和反向传播计算。由于

DLRM的体系结构和较大的模型尺寸,因此将模型并行和数据并行相结合是DLRM的独特要求。Caffe2或PyTorch(以及其它流行的深度学习框架)均不支持这种组合并行性,因此我们设计了一个自定义的实现。我们计划在未来的工作中提供其详细的性能研究。- 由于

在我们的设置

setup中,top MLP和交互算子interaction operator要求从bottom MLP和所有embedding中访问部分mini-batch。由于模型并行已用于在设备之间分布embedding,因此这需要个性化的all-to-all通信。在

embedding lookup的最后,每个设备都针对mibi-batch中的所有样本,将对应的embedding table中的embedding向量驻留在这些设备上。需要驻留的embedding向量需要沿着mibi-batch维度分割,并传送到适当的设备,如下图所示(如黄色embedding向量都传送到Device 3)。PyTorch和Caffe2都不提供对模型并行的原生支持,因此我们通过将embedding算子显式映射到不同的设备来实现它。然后使用butterfly shuffle算子实现个性化的all-to-all通信,该算子将生成的embedding向量适当的分片slice,并将其传输到目标设备target device。在当前版本中,这些传输是显式拷贝,但是我们打算使用可用的通信原语(如all-gather和send-recv)进一步优化这一点。下图为用于

all-to-all通信的butterfly shuffle。注意,目前

pytorch.distributed package已经支持模型并行、数据并行,也支持个性化的all-to-all通信。

我们注意到,对于数据并行

MLP,反向传播中的参数更新以allreduce进行积累accumulated,并以同步synchronous的方式应用于每个设备上的拷贝参数replicated parameters,从而确保每个设备上的更新参数updated parameters在每次迭代之前都是一致consistent的。- 在

PyTorch中,通过nn.DistributedDataParallel和nn.DataParallel模块启用数据并行,这些模块在每个设备上拷贝模型并插入allreduce以及必要的依赖。 - 在

Caffe2中,我们在梯度更新之前人工插入allreduce。

- 在

1.3 实验

为了衡量模型的准确性

accuracy、测试模型的整体性能、并描述各个算子operator的特征,我们需要为DLRM创建或获取一个数据集。我们提供了三种类型的数据集:随机数据集

random dataset、人工合成数据集synthetic dataset、公共数据集public dataset。从系统的角度来看,前两个数据集可用于试验模型。具体而言,它允许我们通过动态生成的数据来试验不同的硬件属性和瓶颈,同时消除对数据存储系统的依赖。后者允许我们对真实数据集进行实验,并度量模型的的准确性accuracy。随机数据集:回忆一下,

DLRM接受连续continuous特征和离散categorical特征作为输入。对于连续特征,可以通过使用

numpy.random package的rand或者randn调用具有默认参数的均匀分布或正态分布(高斯分布)生成随机向量来建模。 然后可以通过生成一个矩阵来获得一个mini-batch的输入,其中矩阵的每一行代表mini-batch中的一个样本。对于离散特征,我们需要确定给定的的

multi-hot向量中有多少个非零元素。benchmark允许非零元素数量是固定的、或者是1~k范围内的一个随机数。然后,我们生成相应数量的整数索引,数量范围在

1~m范围内,其中m为embedding矩阵 的行数。最后,为了创建一个

mini-batch的lookup,我们拼接上述索引,并用lengths(Caffe中的SparseLengthsSum)、或者offsets(PyTorch中的nn.EmbeddingBag)来描述每个单独的lookup。

人工合成数据集:有很多理由支持对应于离散特征的索引的自定义生成。例如,如果我们的

application使用一个特定的数据集,但出于隐私的目的我们不愿意共享它,那么我们可以选择通过索引分布来表达离散特征。这可能会替代联邦学习federated learning等应用于application中的隐私保护技术。此外,如果我们想要测试系统组件system components,例如研究内存行为memory behavior,我们可能希望在合成的trace中捕获原始trace访问的基本局部性fundamental locality。让我们说明如何使用合成数据集。假设我们有索引的

trace,这些索引对应于某个离散特征的所有embedding lookup轨迹。我们可以在这个trace中记录去重访问unique accesses和重复访问repeated accesses之间的距离频次,然后生成合成trace。具体生成算法参考原始论文。公共数据集:

Criteo AI Labs Ad Kaggle和Criteo AI Labs Ad Terabyte数据集是公开的数据集,由用于广告点击率预测的点击日志组成。每个数据集包含

13个连续特征和26个离散特征。通常,连续特征使用简单的对数变换log(1+x)进行预处理。离散特征映射到相应的embedding index,而未标记的离散特征映射到0或者NULL。Criteo Ad Kaggle数据集包含7天内的4500万个样本,每天的样本量大致相等。在实验中,通常将第7天拆分为验证集和测试集,而前面6天用作训练集。Criteo Ad Terabyte数据集包含24天的样本,其中第24天分为验证集和测试集,前面23天用作训练集。每天的样本量大致相等。

模型配置:

DLRM模型在PyTorch和Caffe2框架中实现,可以在Github上获得。模型分别使用fp32浮点数作为模型参数,以及int32(Caffe2)/int64(PyTorch)作为模型索引。实验是在BigBasin平台进行的,该平台具有双路Intel Xeon 6138 CPU @ 2.00GHz以及8个Nvidia Tesla V100 16GB GPUs。我们在

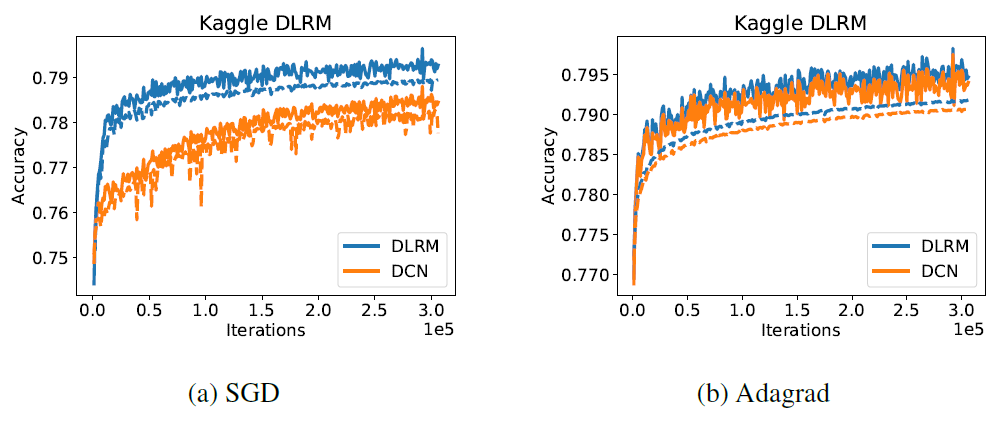

Criteo Ad Kaggle数据集上评估了模型的准确性accuracy,并将DLRM和Deep and Cross network: DCN的性能进行了比较,后者没有进行额外的调优。我们和DCN进行比较,因为它是在相同数据集上具有综合结果comprehensive results的少数模型之一。DLRM既包含用于处理连续特征的bottom MLP(该bottom MLP分别由具有512/256/64个节点的三个隐层组成),又包括top MLP(该top MLP分别由具有512/256个节点的两个隐层组成)。DCN由六个cross layer和一个具有512/256个节点的深度网络组成。embedding的维度为16。

这样产生的

DLRM和DCN两者都具有大约540M的参数。我们使用

SGD和Adagrad优化器绘制了两个模型在完整的单个epoch内的训练准确率(实线)、验证准确率(虚线)。我们没有使用正则化。可以看到:

DLRM获得了稍高的训练准确率和验证准确率,如下图所示。我们强调,这没有对模型的超参数进行大量的调优。DLRM和DCN都没有经过超参数调优,因此实验结果的对比没有任何意义。

为了分析我们模型在单设备上的性能,我们考虑了一个具有

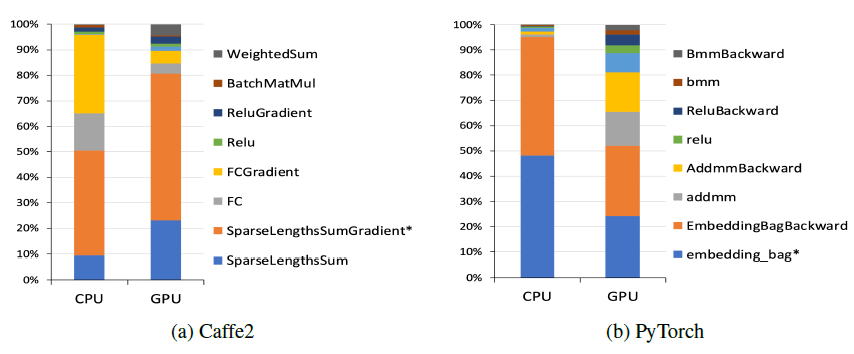

8个离散特征、512个连续特征的模型。每个离散特征都通过一个包含1M个向量的embedding table(即类目总数有1M)进行处理,向量维度为64。而连续特征被组装assembled为一个512维的向量。bottom MLP有两层,而top MLP有四层。我们让具有2048K个随机生成样本的数据集上分析了该模型,其中mini-batch的batch size = 1K。Caffe2中的这个模型实现在CPU上运行大约256秒,在GPU上运行大约62秒,每个算子的分析如下图所示。正如预期所示:大部分时间都花在了执行embedding lookup和全连接层上。在CPU上,全连接层占了很大一部分计算,而GPU上全连接层的计算几乎可以忽略不计。

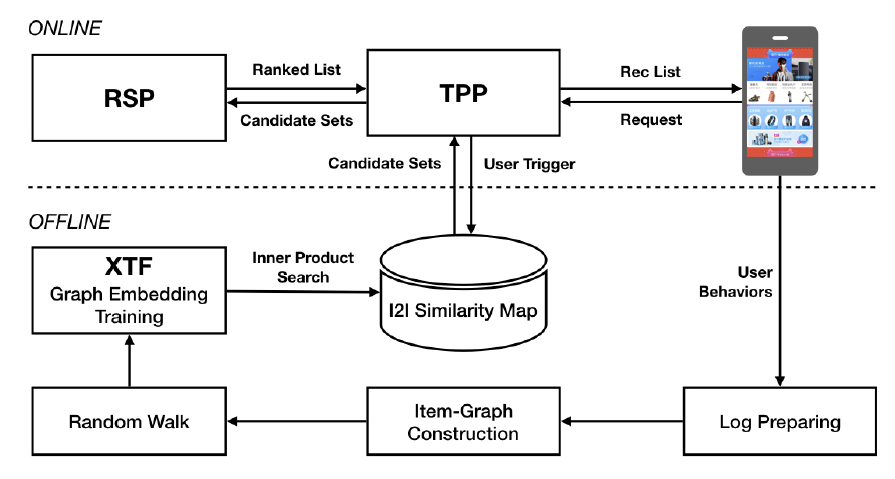

十三、Applying Deep Learning To Airbnb Search[2018]

Airbnb的home sharing platform是一个双边市场,其中房东host可以出租他们的空间(称作listings),以供来自世界各地的潜在租客guest预订。典型的预订开始于租客在airbnb.com上搜索特定地理位置的房屋。search ranking任务是从库存中的成千上万个listing中挑选一个有序的listing列表来响应租客。search ranking的第一个实现是手动制作的评分函数scoring function。用梯度提升决策树gradient boosted decision tree: GBDT模型代替手动评分函数是Airbnb历史上房屋预订量方面最大的改进之一,随后还有多次成功的迭代。在线预订量的收益最终饱和,其中很长一段时间的实验都是中性的(即没有提升)。这为尝试对系统进行全面改造提供了时机。从这一背景出发,论文

《Applying Deep Learning To Airbnb Search》讨论了作者将互联网上的一个大规模搜索引擎之一切换为深度学习的经验。本文针对是拥有机器学习系统、并开始考虑神经网络的团队。论文的目的并不是推进前沿的、新的建模技术,而是讲述了如何将神经网络应用于现实产品。- 首先,论文对模型体系结构随着时间的演变进行了总结。

- 然后,论文给出了特征工程

feature engineering和系统工程system engineering的注意事项。 - 最后,论文描述了一些工具和超参数探索。

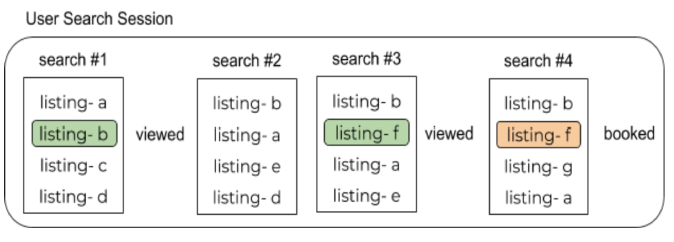

Airbnb的search ranking模型是模型生态系统的一部分,所有这些模型都有助于决定向租客展示哪些listing。这些模型包括:预测房东接受租客预订请求可能性的模型、预测租客将旅行体验评为五星好评5-star的概率的模型等等。论文目前的讨论集中在这个生态系统中的一个特定模型上,并且被认为是排序难题ranking puzzle中最复杂的一块。这个模型负责根据租客预订的可能性来对可用的listing进行排序。典型的租客搜索会话

search session如下图所示。- 租客通常会进行多次搜索,点击一些

listing从而查看它们的详情页。 - 成功的

session以租客预订一个listing而结束。

租客的搜索以及他们和产品的交互被作为日志而记录下来。在训练期间,新模型可以访问交互日志,也可以访问产品中之前使用的模型。新模型被训练从而学习一个评分函数,该函数将曝光日志中预订

listing分配到尽可能高的排名。然后,新模型在

A/B test框架中进行在线测试,从而查看新模型和当前模型的对比,看看新模型是否可以实现统计意义上显著的预订量提升。

- 租客通常会进行多次搜索,点击一些

13.1 模型演变

我们向深度学习的转变不是原子

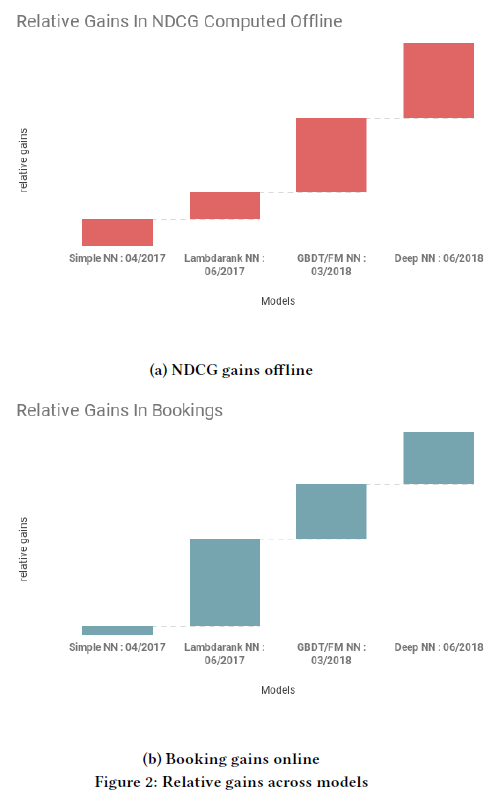

atomic操作的结果,而是一系列迭代改进的最终结果。- 下图

(a)显示了我们的主要离线指标normalized discounted cumulative gain: NDCG的相对提升,其中预订listing的曝光impression被分配为相关性1.0、其它listing的曝光被分配为相关性0.0。X轴描述了模型及其投入生产的时间。 - 下图

(b)显示了模型在线预订量的相对增长。

总体而言,这代表了

Airbnb上最有影响力的机器学习应用之一。以下各节简要描述了每个模型。

- 下图

Simple NN:Andrej Karpathy对模型架构有一些建议:不要成为英雄don’t be a hero。在 “我们为什么不能成为英雄?” 的驱动下,我们从一些复杂的自定义架构开始,结果却被它们的复杂性淹没,最终浪费了很多时间。我们最终想方设法上线的第一个体系架构是具有

ReLU激活的、简单的单隐层(32个神经元)神经网络NN。事实证明该神经网络和GBDT相比,预订量指标是中性neutral的(即效果既不正向、也不负向)。NN和GBDT模型具有相同的特征,其训练目标也和GBDT保持不变:最小化L2回归损失regression loss,其中预订listing的效用utility分配为1.0、未预订listing的效用分配为0.0。整个练习

exercise的价值在于,它验证了整个NN pipeline已经准备就绪,并且能够为实时流量提供服务。稍后在特征工程和系统工程部分讨论该pipeline的具体细节。Lambdarank NN:不是英雄not being a hero让我们有了一个开始,但没有走很远。最终我们及时的将Karpathy的建议调整为:在开始的时候不要成为英雄don’t be a hero, in the beginning。我们的第一个突破是将

Simple NN和Lambdarank思想相结合。在离线时,我们使用NDCG作为主要指标。Lambdarank为我们提供了一种直接针对NDCG优化NN的方法。这涉及为Simple NN的regression based公式的两个关键改进:转向

pairwise偏好公式,其中预订者看到的listing被用于构建pairwise的{booked listing, not-booked listing},从而作为训练样本。在训练期间,我们将预订listing和未预订listing之间得分差异的交叉熵损失最小化。即:预订

listing和未预订listing之间差异尽可能大。通过交换组成该

pair对的两个listing的位置position而导致的NDCG差异,从而加权每个pairwise损失。这使得预订listing的排名优化rank optimization朝向搜索结果列表的头部,而不是底部。例如,把预订listing的排名从位置2提升到1,将优于把预订listing的排名从位置10提升到9。即:预订

listing位置尽可能靠前。

下面给出了

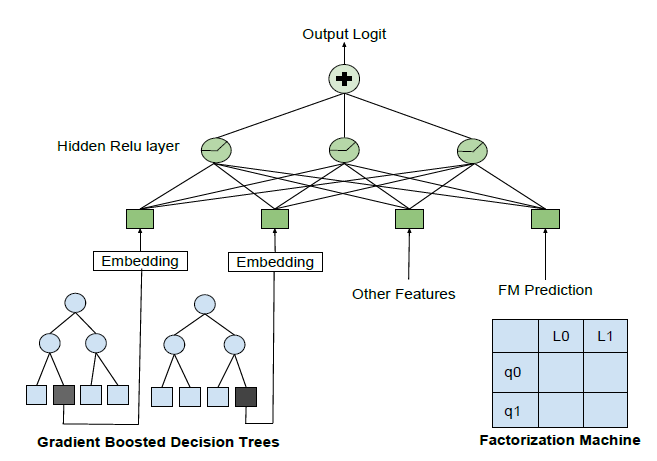

TensorFlow中的部分实现,尤其是如何对paiwise loss进行加权:x1def apply_discount(x):2'''3计算位置折扣曲线 positional discount curve4'''5return np.log(2.0)/np.log(2.0 + x)6def compute_weights(logit_op, session):7'''8根据 ndcg 的差异来计算损失的加权系数.9logit_op 是一个形状为 [BATCH_SIZE, NUM_SAMPLES] 的张量,对应于网络的输出层。每一行代表一个搜索,每一列代表搜索结果中的一个 listing。列 0 表示预订的 listing,剩余的 NUM_SAMPLES-1 列表示未预订的 listing。10'''11logit_vals = session.run(logit_op)12ranks = NUM_SAMPLES - 1 - logit_vals.argsort(axis=1).argsort(axis=1)13discounted_non_booking = apply_discount(ranks[:, 1:])14discounted_booking = apply_discount(np.expand_dims(ranks[:, 0], axis=1))15discounted_weights = np.abs(discounted_booking - discounted_non_booking)16return discounted_weight1718# 计算 pairwise loss19pairwise_loss = tf.nn.sigmoid_cross_entropy_with_logits(20targets=tf.ones_like(logit_op[:, 0]),21logits=logit_op[:, 0] - logit_op[:, i:] )22# 计算基于 ndcg 加权的 lambdarank 权重23weights = compute_weights(logit_op, session)24# 计算 lambdarank 权重加权的 pairwise loss25loss = tf.reduce_mean(tf.multiply(pairwise_loss, weights))Decision Tree/Factorization Machine NN:虽然目前服务于生产流量的主力排序模型是神经网络,但是我们仍然在研究其它模型。值得一提的模型有:GBDT模型,其中使用使用替代方法对搜索进行采样从而来构建训练数据。- 因子分解机

factorization machine:FM模型,它通过将listing和query都映射到一个32维的空间,从而预测一个listing在给定query的情况下被预订的概率。

这些研究

search ranking问题的新方法揭露了一些有趣的东西:尽管这些模型在测试数据上的性能和神经网络相当,但是它们排名靠前upranked的listing却大不相同。受到

《Deep & Cross Network for Ad Click Predictions》这样的神经网络体系架构的启发,新模型试图结合所有三种模型(GBDT模型、FM模型、NN模型)的优势:- 对于

FM模型,我们将最终预测作为特征纳入NN模型。 - 对于

GBDT模型,我们将每棵树激活的叶节点的索引作为离散特征纳入NN模型。

下图给出了一个概览。

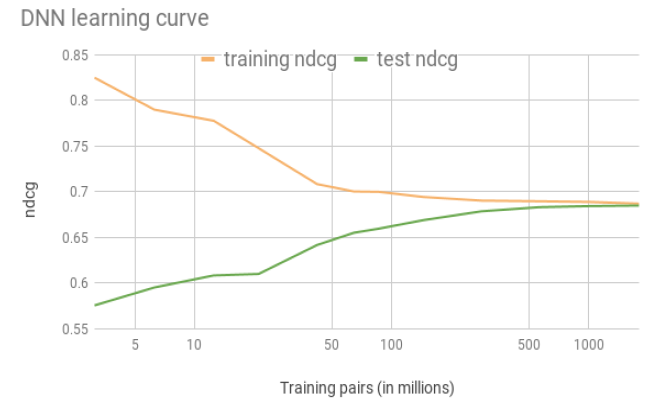

Deep NN:Deep NN模型的复杂性是惊人的,而且《Hidden Technical Debt in Machine Learning Systems》中提到的一些问题开始出现。在我们的最后一次飞跃中,我们能够通过简单地将训练数据扩展10倍,并切换到具有两层隐层的DNN来消除所有这些复杂性。Deep NN网络的典型配置:- 一个输入层

input layer。其中,在将离散特征扩展到embedding之后,输入一共有195个特征。 - 第一个隐层

hidden layer。其中,该层具有127个全连接的ReLU激活的神经元。 - 第二个隐层

hidden layer。其中,该层具有83个全连接的ReLU激活的神经元。

馈入

DNN的特征大部分是简单的listing属性,诸如价格、设施amenities、历史预订量等等。这些特征通过最少的特征工程来提供。除此之外,还包括从其它模型输出的特征:- 启用了智能定价

Smart Pricing功能的listing价格,该特征由专门的模型提供。 - 候选

listing和用户历史查看listing的相似度similarity,这是基于co-view embedding来计算得到。

这些模型利用了不直接隶属于

search ranking训练样本的数据,为DNN提供了额外的信息。为了更深入地了解

DNN,我们在下图中绘制了它的学习曲线learning curve。我们在训练集和测试集上对比了NDCG,其中训练集有17亿的pair对。可以看到:我们能够弥合

close训练集和测试集之间的泛化距离generalization gap。

- 一个输入层

我们能否跳过演变

evolution的所有阶段直接启用DNN?我们试图在追溯部分中回答这一问题。顺便说一句,虽然

DNN在某些图像应用上取得了人类水平的性能,但我们很难判断我们在类似的比较中处于什么位置。问题的部分原因是,目前尚不清楚在search ranking问题中如何定义人类水平的性能。通过浏览日志信息,我们很难准确地判断哪些listing将会被预订。我们在日志中找不到客观的事实,只能根据租客的预算budget和口味tastes进行tradeoff,而租客的口味大多数情况下还是看不到的。一些学者指出,即使是对于熟悉的shopping items,也很难进行人工评估。对于我们的application,由于库存的新颖性novelty,这些困难将进一步加剧。说到困难,接下来我们讨论一些鲜为人知的事情:失败的尝试。

13.2 失败的模型

上一节中介绍的一个成功的

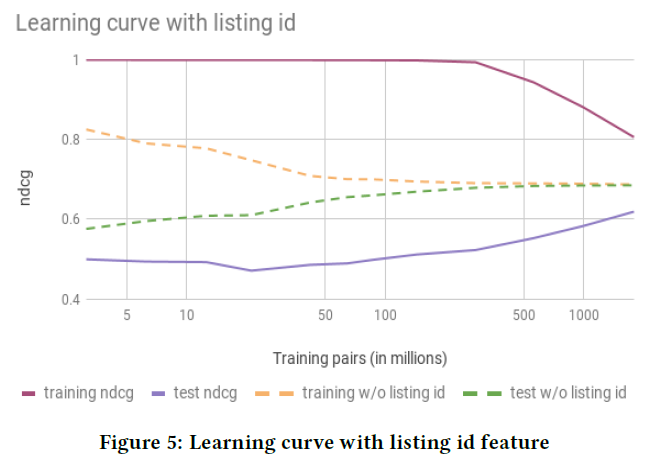

launch后又接着另一个成功的launch的叙述并没有讲出完整的故事。现实中失败的尝试比成功的尝试更多。复述每一次失败的尝试比较耗时,所以我们选择了两个特别有趣的失败来讲述。这些模型很有趣,因为它们说明了一些外部非常有效和受欢迎的技术,但是内部使用时可能会失效。Listing ID:Airbnb上的每个listing都有相应的唯一ID。NN提供的一个令人兴奋的新能力是使用这些listing id作为特征。想法是使用listing id作为embedding的索引index,这使得我们能够学习每个listing的向量representation,从而编码listing独有的属性property。我们之所以兴奋,是因为其它

application已成功地将如此高基数cardinality的离散特征映射到embedding,例如在NLP application中学习word embedding、在推荐系统中学习video id embedding和user id embedding。但是,在我们尝试的不同变体中,

listing id大多数会导致过拟合。下图绘制了一次这类尝试的学习曲线,我们看到NDCG在训练集上有显著提升,但是在测试集上却没有任何改善。这种成熟的技术在

Airbnb上失败的原因是由于底层市场underlying marketplace的某些独特属性property。embedding需要每个item有大量数据才能收敛到合理的值。- 当

item可以无限地重复时,例如在线视频或语言中的单词,那么item拥有的用户交互数量也没有限制。为item兴趣获取大量的数据相对容易。 - 另一方面,

listing受到物理世界的限制。即使是最受欢迎的listing,一年最多也就可以预订365次。平均每个listing的预订量要少得多。这一基础限制fundamental limitation生成的数据在listing-level非常稀疏。过拟合就是这种限制的直接后果。

如果

item id频次太少,则很难学到有意义的embedding。

- 当

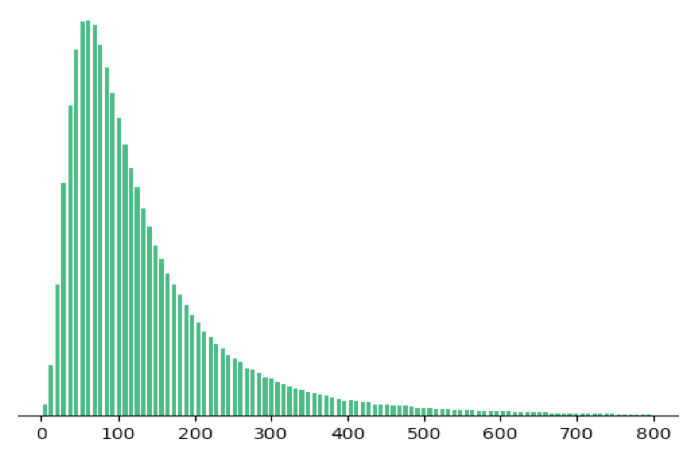

多任务学习

Multi-task Learning:虽然预订有物理限制,但是用户对listing详情页的查看并没有物理限制。下图显示了listing的详情页查看量和预订量的比例的分布,预订量通常比查看量稀疏了几个数量级(横轴为查看量和预订量之比,纵轴为listing数量)。更进一步,我们发现,不出所料,对listing详情页的长时间观看long view和预订相关。

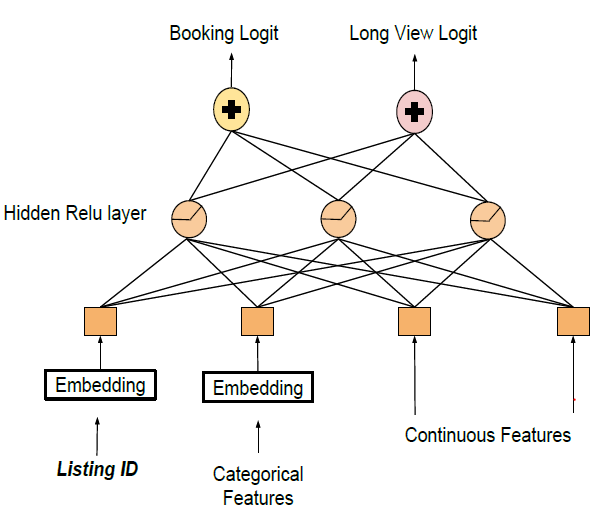

为了解决

listing id过拟合的问题,我们建立了一个多任务学习模型。该模型使用两个独立的输出层同时预测预订概率和long view的概率:- 一个以预订

listing作为正样本来优化损失,从而预测预订概率。 - 另一个以

long view listing作为正样本来优化损失,从而预测long view概率。

两个输出层共享一个公共的隐层,如下图所示。更重要的是,

listing id embedding是共享的。背后的想法是,模型能够将long view中学到的知识迁移到预订任务中,从而避免过拟合。

由于

long view标签的数量比预订标签的数量多几个数量级,因此对预订损失施加了较高的补偿权重,从而保持对预订目标的关注。如

《Beyond Clicks: Dwell Time for Personalization》所建议的,每个long view标签的损失进一步由log(view_duration)进行缩放。最终在线

listing评分时,我们仅使用预订预测booking prediction。但是当在线测试时,该模型大幅增加了

long view,而预订量保持不变。人工检查了具有较高long view的listing,我们发现了可能导致这种gap的几种原因:- 这种

long view可能是由于高端的、但价格昂贵的listing所驱动(所以用户会停留一段时间来慎重考虑)。 listing的描述太长,且难以阅读。- 极其独特、且有时很幽默的

listing。 - 还有一些其它原因。

同样,正是

Airbnb市场的独特性,使得long view和预订相关,但是也有很大的正交部分(即不相关的部分),这使得基于long view来预测预订具有挑战性。更好地理解listing view仍然是我们研究的主题。注:笔者在

ctr和cvr多任务建模过程中也发现类似的规律。即希望丰富的点击样本能够有助于迁移学习到转化预估任务。但是结果发现,ctr预估任务效果很好,但是cvr预估任务效果持平或略有下降。- 一个以预订

13.3 特征工程

我们开始的

baseline GBDT pipeline具有广泛的特征工程。典型的变换包括计算比率ratio、窗口平均等等。这些特征工程技巧是经过多年实验积累的。然而,目前还不清楚这些特征是否是最好的,或者是否随着市场动态变化而更新。NN的一大吸引力在于引入了特征自动化feature automation:馈入原始数据并让特征工程在以数据驱动的NN的隐单元中自动进行。然而,本节内容是专门针对特征工程的,因为我们发现让

NN有效工作不仅仅是提供原始数据,也需要特征工程。这种特征工程不同于传统的特征工程:在将特征输入到模型之前,无需人工对特征执行数学计算,而是将重点转移到确保特征符合某些属性properties,以便神经网络可以自己有效地进行数学计算。特征归一化

Feature Normalization:在我们第一次训练NN的尝试中,我们简单地将所有用于训练GBDT模型的特征输入到神经网络中。这种情况非常糟糕,损失函数在训练过程中达到饱和,后续的step没有任何效果。我们将问题追溯到以下事实:特征未能正确地归一化。- 对于决策树,只要特征的相对顺序有意义,那么特征的确切数值几乎无关紧要。

- 神经网络对于特征的数值非常敏感。超出正常特征范围的馈入值可能会导致较大梯度的反向传播。由于梯度消失,这可以使得

ReLU这类激活函数永久死亡。

为了避免这种情况,我们确保将所有特征限制在较小的取值范围内,并且大部分分布在

[-1,1]区间、均值映射到0。总的来说,这涉及检查特征,并应用以下两种转换中的任何一种:如果特征分布类似于正态分布,我们将其变换为:

其中 为特征均值, 为特征标准差。

如果特征分布类似于幂律分布

power law distribution,我们将其变换为:其中

median为特征的中位数。

另一种简单的选择是采用

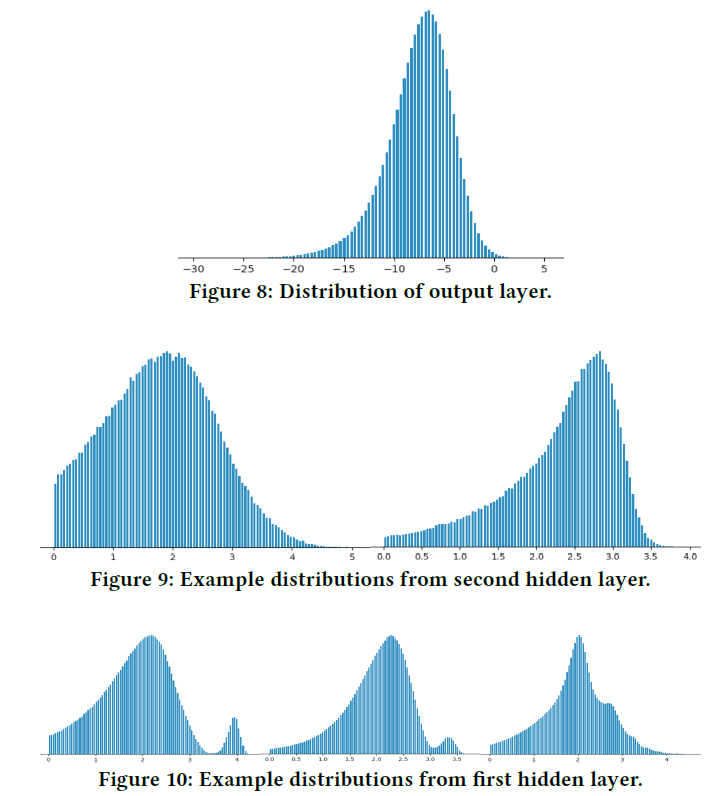

BN Layer。特征分布

Feature Distribution:除了将特征映射到有限的数值范围,我们还确保大多数特征都具有平滑的分布。为什么要纠结于分布的平滑性smoothness?以下是我们的一些理由。发现错误

spotting bugs:在处理上亿个特征样本时,如何验证其中一小部分没有bug?范围检查很有用,但是很有限。我们发现分布的平滑性是发现错误的宝贵工具,因为错误的分布通常和典型的分布形成鲜明对比。举个例子,我们在某些地区记录的价格中发现了

bug。对于超过28天的区间,记录的价格是每月价格、而不是每日价格。这些错误在原始分布图上显示为尖峰。促进泛化

facilitating generalization:确切回答为什么DNN善于泛化是研究前沿的一个复杂课题。同时,我们的工作知识working knowledge是基于以下观察:在为我们的application构建的DNN中,各层的输出在其分布方面变得越来越平滑。下图显示了来自一些样本的最终输出层分布、以及隐层分布。为了绘制隐层的分布,零值被省略,并且应用了log(1 + relu_output)转换。

这些图激发了我们的直觉:为什么

DNN可以很好地泛化到我们的application中。当建立一个基于数百个特征的模型时,所有特征取值的组合空间非常庞大,并且在训练过程中常常会覆盖一定比例特征组合。来自较低层的平滑分布确保了较高层可以正确地对未看过unseen的值进行插值。将这种直觉一直扩展到输入层,我们尽力确保输入特征具有平滑的分布。这里有个平滑性假设:假设相似的特征带来相似的

label。我们如何测试模型是否在样本上良好地泛化?真正的测试当然是模型的在线性能,但是我们发现以下技术可以作为完整性检查

sanity check:将测试集中给定特征上所有的值都缩放(例如将price特征缩放为2倍或者3倍或者4倍),然后观察NDCG的变化。我们发现,在这些从未见过的price取值上,该模型的性能是非常稳定的。对特征的取值缩放可能会破坏样本的完整性。例如:对于郊区的、单个房间的

listing,如果price缩放4倍会导致一个奇怪的listing,看起来应该很便宜的listing但是标价很高。在调试

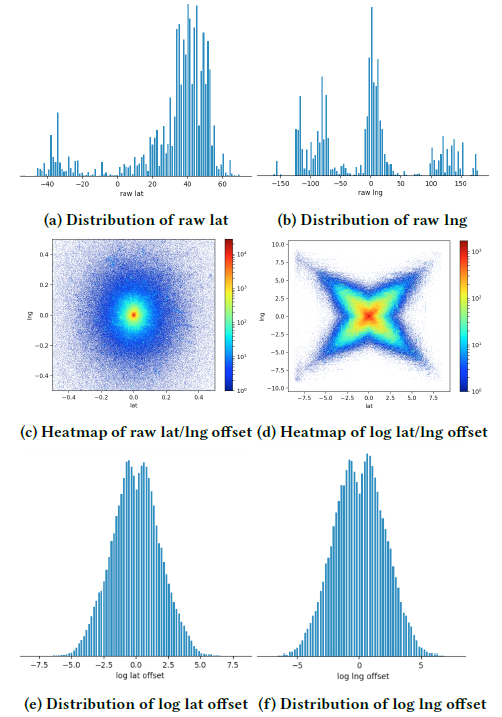

debugged并应用适当的归一化之后,大多数特征都获得了平滑分布。但是,有少数几个特征,我们不得不进行专门的特征工程。一个例子是listing的地理位置geo-location,以经度和纬度来表示。下图(a)和(b)显示了原始经纬度的分布。为了使得分布更加平滑,我们计算的是距展示给用户的地图的中心点的偏移量。如下图(c)所示,质量似乎集中在中心,因为地图的尾部被zoomed out了很多。因此,我们使用经度/纬度偏移量的log(),从而得到了下图(d)的分布。这使得我们能够构造两个平滑分布的特征,如下图(e)和(f)所示。

需要明确的是,原始经度/纬度到地图中心的距离变换是有损的多对一函数

many-to-one function。因为它可以将多个经度/纬度转换为相同的偏移量。这使得模型可以基于距离属性而不是特定的地理位置属性来学习全局属性。要学习特定于局部地理位置的属性,我们使用了稍后描述的高基数high cardinali离散特征。检查特征完整性

checking feature completeness:在某些情况下,调查某些特征缺乏平滑性会导致发现模型缺失missing的特征。例如,我们有一个

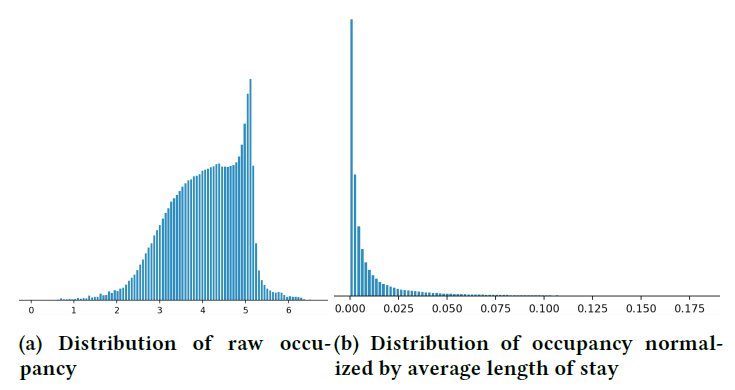

listing未来已预订天数占available days的比例作为一个特征(即占用率occupancy),这个特征是listing质量的信号。背后的直觉是:高质量的listing会提前售罄。但是,由于缺乏平滑性,占用率的分布却令人困惑,如下图(a)所示。经过调查,我们发现了另一个影响占用率的因素:

listing有不同的最低住宿时间minimum required stay要求,有的会要求最低住宿几个月。因此这些listing得到了不同的占用率。但是,我们没有在模型中添加最低住宿时间作为特征,因为它取决于日历并且被认为过于复杂。但是在查看了占用率分布之后,我们增加了listing的平均住宿时间作为一个特征。在占用率通过平均住宿时间归一化之后,我们可以看到下图

(b)中的分布。在一个维度中缺乏平滑性的特征可能在较高维度上变得平滑。这有助于我们思考这些维度是否可以应用在我们的模型中。

高基数离散特征

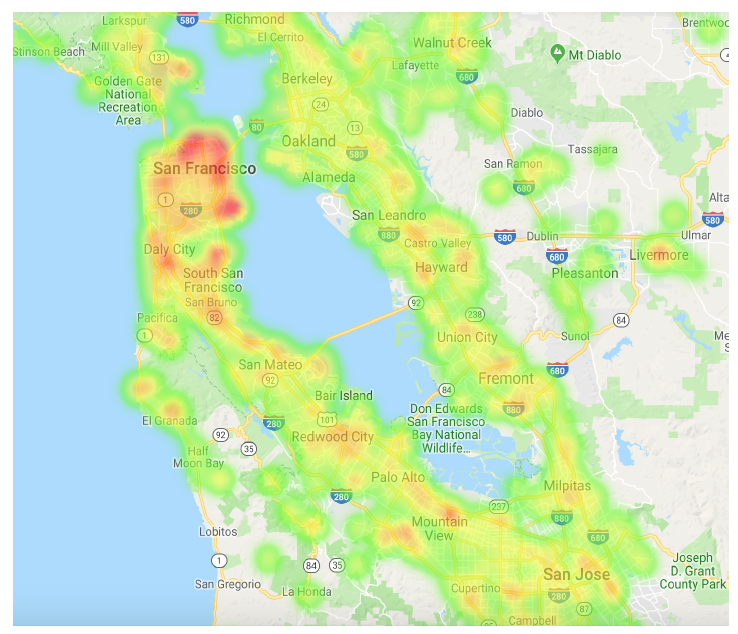

High Cardinality Categorical Features:过拟合的listing id并不是我们尝试的唯一高基数离散特征。还有其它尝试,如NN的承诺所言,我们用很少的特征工程就取得了很高的回报。一个具体的例子最能说明这一点。租客对于城市各个街区

neighborhoods的偏好是一个重要的位置信号location signal。对于GBDT模型,该信息是由一个精心设计的pipeline提供的,该pipeline跟踪了各个街区和城市的层级分布hierarchical distribution。建立和维护该pipeline的工作量很大,而且它也没有考虑诸如预订listing价格之类的关键因素。在

NN的世界中,处理这类信息本身就是简单的。我们基于query中指定的城市、以及对应于listing的level 12 S2 cell创建的一个新的离散特征,然后使用哈希函数将这二者整体映射到一个整数。例如,给定query“旧金山” 以及位于Embarcadero附近的listing,我们选择listing所在的S2 cell(539058204),然后将将{"San Francisco", 539058204}哈希映射到71829521从而建立我们的离散特征。然后该离散特征被映射到一个embedding,接着馈入NN。在训练期间,该模型通过反向传播来学习embedding,该embedding编码了在给定城市query的情况下由S2 cell代表的街区的位置偏好location preference。即将地域划分为一个个的网格,然后学习每个网格的

grid id embedding。下图可视化了为

query“旧金山” 学到的各街区的embedding(通过t-SNE)。这符合我们对该地区的直觉理解:embedding值不仅突出了该城市的主要points of interest: poi,它还表明了人们更喜欢位于西湾west bay以南一点的位置,而不是靠近主要交通拥堵桥梁的位置。

13.4 系统工程

这部分是关于加速训练

training和加速打分scoring。我们pipeline的一个quick summary:- 来自租客的搜索

query命中了一个进行检索retrieval和评分scoring的Java server。 - 这个

server还生成日志,这些日志存储为序列化的Thrift实例。 - 日志使用

Spark pipeline来处理从而创建训练数据。 - 使用

TensorFlow来训练模型。 - 使用

Scala和Java编写的各种工具用于评估模型和计算离线指标。 - 模型上传到执行检索和评分的

Java server。

所有这些组件都在

AWS实例上运行。- 来自租客的搜索

Protobufs and Datasets:GBDT模型是以CSV格式来提供训练数据的,并且我们重复使用这个pipeline的大部分,从而使用feed dict馈入TensorFlow模型。乍一看,这似乎不是一个机器学习的问题,并且在我们的优先级清单中是相当低的。但是当我们发现

GPU利用率接近25%时,我们马上警醒了。大部分训练时间都花在解析CSV和通过feed dict拷贝数据上。我们实际上是在用骡子拖着一辆法拉利。重构

pipeline以产生Protobufs训练数据,并使用Dataset可以将训练速度提高17倍,并将GPU利用率提高到大约90%。这最终允许我们将训练数据从几周扩展到几个月。重构静态特征

refactoring static features:我们的很多特征都是很少变化的listing属性。例如,地理位置location、卧室数量、便利设施amenities、租客规则guest fules等等。将所有这些特征作为训练样本的一部分将产生输入瓶颈input bottleneck。为了消除这种磁盘流量,我们仅使用

listing id作为离散特征。所有静态特征都被打包为由listing id索引的、不可训练non-trainable的embedding。对于在训练期间发生突变的特征,这需要在少量噪声和训练速度之间进行trade-off。注意:这个

embedding就是这些静态特征拼接而成的,因此是不可训练的。是否对这些属性进行embedding训练会更好?论文并未讨论这一点。这个

embedding常驻在GPU内存,消除了每个训练样本数千KB的数据,这些数据通常是通过CPU从磁盘加载的。这种效率使得探索全新类型的模型成为可能,该模型考虑了用户历史交互的数十个listing的详细信息。Java NN library:在2017年初,当我们开始将Tensorflow模型投入生产时,我们发现没有有效的解决方案可以在Java stack中对模型进行评分scoring。 通常需要在Java和另一种语言之间来回转换数据,这个过程中引入的延迟latency对我们而言是一个障碍。为了满足严格的搜索延迟要求,我们在

Java中创建了一个自定义的神经网络评分库。虽然到目前为止这对我们很有帮助,但是我们希望重新讨论这个问题,看看有没有最新的替代方案。

13.5 超参数

尽管在

GBDT世界中有一些超参数,如树的数量、正则化等,但是NN却将超参数的规模提升到一个新的高度。在最初的迭代中,我们花了大量时间探索超参数世界。调研所有选项和试验组合上的努力并没有给我们带来任何有意义的改进。但是,这个练习exercise确实让我们对我们的选择有了一些信息,我们将在下面描述。dropout:我们最初的印象是,dropout和神经网络的正则化相对应,因此必不可少。然而对于我们的application,我们尝试了不同的dropout形式,所有这些都会导致离线指标略有下降。为了理解

dropout和我们的失败,我们目前对dropout的解释更接近于一种数据增强技术。当随机性的引入模拟了有效的场景时,这种技术是有效的。对于我们的情况,随机性只能产生无效的场景。作为替代方案,我们在考虑特定特征的分布的情况下,添加了人工制作的噪声,从而使得离线

NDCG降低了大约1%。但是我们在在线性能方面没有取得任何统计意思上的显著提升。初始化

initialization:出于纯粹的习惯,我们通过将所有权重和embedding初始化为零来开始我们的第一个模型,结果发现这是开始训练神经网络的最差的方法。在研究了不同的技术之后,我们目前的选择是对网络权重使用Xavier初始化,对embedding使用{-1 ~ +1}范围内的均匀随机初始化。学习率

learning rate:这里面临着各种各样的策略,但是对于我们的application,我们发现很难使用默认的设置来改善Adam的性能。当前,我们使用了LazyAdamOptimizer变体,我们发现使用large embedding训练时该变体会更快。batch size:batch size的变化对于训练速度有着显著影响,但是对于模型本身的确切影响却难以把握。我们发现最有用的指南是《Don’t Decay the Learning Rate, Increase the Batch Size》。但是我们并没有完全遵守该论文的建议。在LazyAdamOptimizer解决了学习率问题之后,我们选择了200的固定batch size,这似乎对当前模型有效。

13.6 特征重要性

一般来说,特征重要性的估计和模型的可解释性

interpretability是神经网络不擅长的一个领域。评估特征的重要性对于确定工程工作的优先级和指导模型迭代是至关重要的。NN的优势在于找到特征之间的非线性相互作用。当理解特定特征扮演了什么角色时,这也是一个弱点,因为非线性相互作用使得很难孤立地研究任何特征。接下来,我们讲述解释神经网络的一些尝试。分数分解

Score Decomposition:在NN的世界中,试图了解单个特征的重要性只会导致混乱。我们第一个朴素的尝试是获取网络产生的最终得分,然后尝试将其分解为来自每个输入节点input node的贡献。在查看了结果之后,我们意识到这个想法存在概念上的错误:没有一种干净

clean的方法来区分一个特定的输入节点对像ReLU这样的非线性激活的影响。消融测试

Ablation Test:这是对这个问题的又一次简单的尝试。这里的想法是一次移除一个特征,重新训练模型并观察性能的差异。然后,我们可以将这些特征的重要性与移除它们所导致的性能下降成正比。然而这里的困难在于,通过移除一个特征获得的任何性能差异都类似于在重新训练模型时观察到的离线指标中的典型噪声。这可能是因为我们的特征集合中存在大量的冗余,模型似乎能够从剩余的特征中弥补一个缺失的特征。

这导致了忒休斯之船悖论

Ship-of-Theseus paradox:你能一次从模型中删除一个特征,声称该模型没有显著的性能下降吗?忒修斯悖论:如果忒修斯的船上的木头被逐渐替换,直到所有的木头都不是原来的木头,那这艘船还是原来的那艘船吗?

即:假定某物体的构成要素被置换后,但它依旧是原来的物体吗?

排列测试

Permutation Test:在接下来的尝试中,我们从针对随机森林提出的排列特征重要性permutation feature importance中得到启发。我们在测试中随机排列了特征在各个样本中的取值之后,在测试集上观察了模型的性能。我们的期望是,特征越重要,扰动它导致的模型退化degradation就越大。但是,该操作会导致有些荒谬的结果。原因是在一次排列

permuting一个特征时,我们假设不同特征之间彼此独立,这是错误的。例如,预测预订概率的最重要特征之一就是listing中的房间数。而房间数量和价格、住宿人数、便利设施等特征息息相关。对特征进行独立排列会创建在现实生活中从未发生过的样本,并且特征在无效空间invalid space中的重要性使我们误入歧途。但是,该测试在确定没有发挥作用的特征方面有些用处。如果随机排列特征完全不影响模型性能,则可以很好地表明模型可能不依赖于该特征。

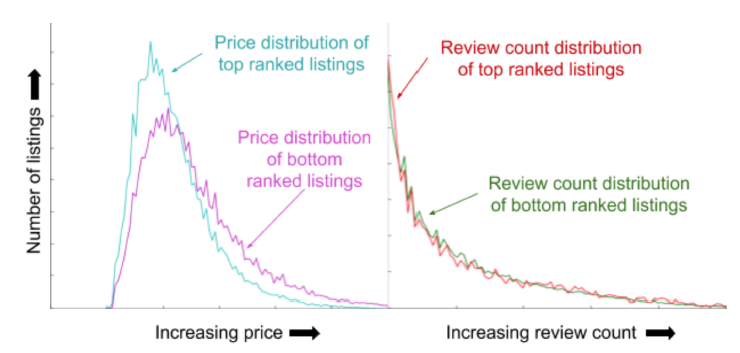

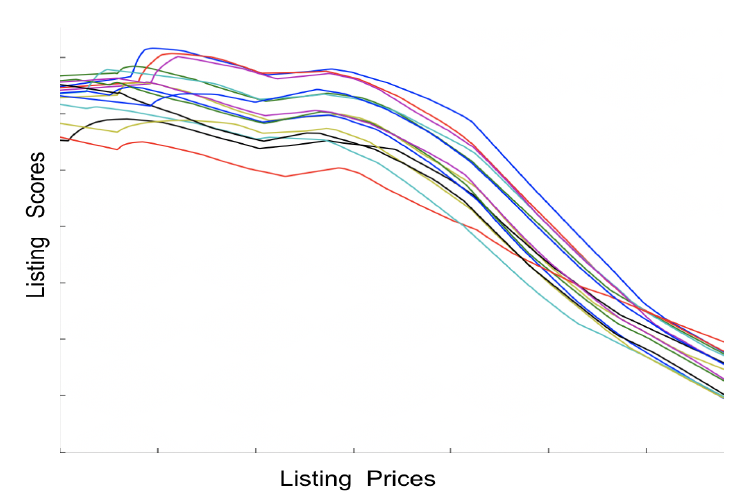

TopBot Analysis:有一个自主开发的工具旨在解释这些特征,并且不会以任何方式干扰它们。这个工具叫做TopBot,它提供了一些有趣的洞察insight。TopBot是自上而下分析器top-bottom analyzer的缩写,它将一个测试集作为输入,并使用模型对每个测试query的listing进行排序。然后它为每个query从排名在top的listing生成特征取值的分布图,并将该分布图和排名在bottom的listing生成特征取值的分布图进行比较。这个比较comparison表明了模型是如何利用不同取值范围内的特征。下图显示了一个例子。排名最高的

listing的价格分布偏向于较低的值,这表明模型对于价格的敏感性sensitivity。但是,当比较排名top和排名bottom的listing的评论数量的分布时,这两个分布看起来非常相似,表明这个版本的模型未按预期使用评论,从而为下一步研究提供了方向。还可以细化下:针对不同的细分市场(或者不同类型的

listing)来可视化。

13.7 回顾

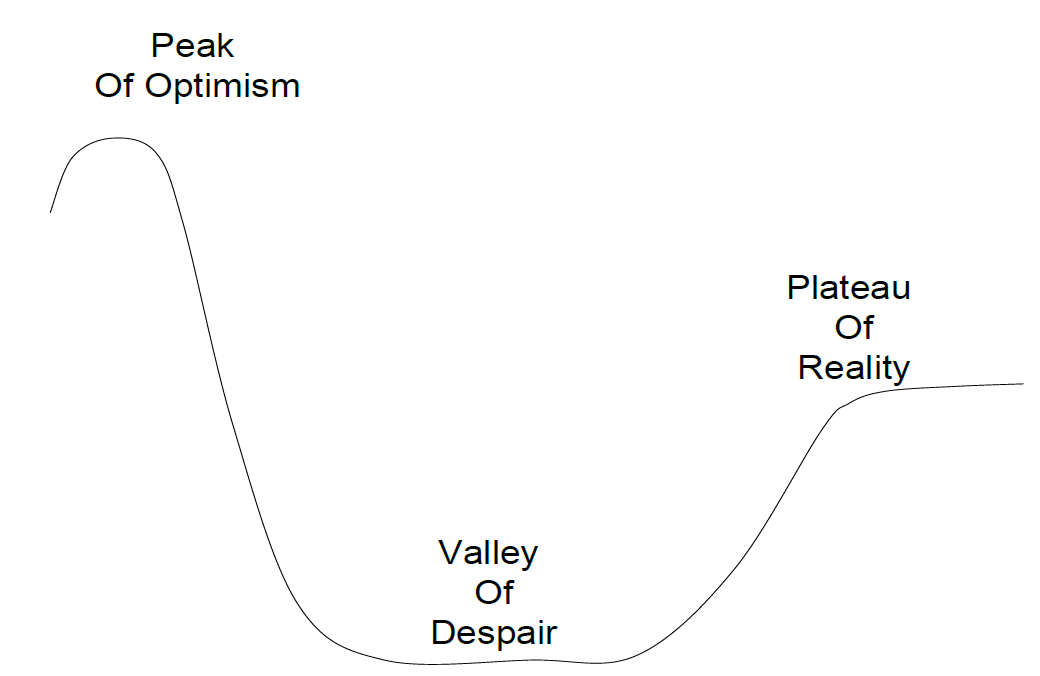

下图总结了目前为止的深度学习之旅。

- 根据无处不在的深度学习成功案例,我们从乐观主义的顶峰开始,认为深度学习将取代

GBDT模型,并为我们带来惊人的收益。 - 许多最初的讨论集中在保持其他一切不变,用神经网络替代当前的模型,看看我们能够得到什么收益。当最初没有实现这些收益时,这让我们陷入了绝望的深渊。

- 随着时间的推移,我们意识到转向深度学习根本不是一个简单的模型替代,更确切的说这是关于系统扩展

sytem scaling。因此,它需要重新思考围绕模型的整个系统。

如果仅局限于较小的规模,像

GBDT这样的模型在性能上可以说是同等水平并且更易于处理,我们继续使用GBDT来解决中等规模的问题。那么,我们会向其他人推荐深度学习吗?答案是Yes。这不仅是因为深度学习模型的在线性能大幅提升。还有部分原因是与深度学习如何改变了我们未来的roadmap有关。早期机器学习的重点主要放在特征工程上,但是在转向深度学习之后,试图手动特征工程已经失去了前景。这让我们可以在更高的层次上研究问题。比如,如何改进我们的优化目标?我们是否准确地代表了所有的用户?在迈出将神经网络应用于search ranking第一步的两年之后,我们觉得我们才刚刚开始。- 根据无处不在的深度学习成功案例,我们从乐观主义的顶峰开始,认为深度学习将取代

十四、Improving Deep Learning For Airbnb Search[2020]

Airbnb是一个双边市场,汇集了拥有出租房屋的房东hosts、以及来自世界各地的潜在租客guests。Airbnb的search ranking问题是对住宿地点(称为listing)进行排名,从而响应用户的query。这些query通常包括位置location、客人数量、入住/退房日期checkin/checkout dates。过度到深度学习是

Airbnb search ranking发展过程中的一个重要里程碑。我们在《Applying Deep Learning to Airbnb Search》对旅程(指的是超越之旅journey beyond)的描述让我们和许多行业从业人员进行了交谈,使得我们能够交换见解insights和批评critiques。此类对话中经常出现的一个问题是:下一步是什么?我们试图在论文《Improving Deep Learning For Airbnb Search》中回答这个问题。用于

ranking的深度学习的推出引起了很多庆祝,不仅因为它带来的预订量增益,还因为它给我们未来的路线图roadmap带来了变化。最初的看法是,在深度学习上的Airbnb ranking使我们能够接触到这个巨大的机器学习思想宝库,这个宝库似乎每天都在增长。我们可以简单地从文献综述中挑选出最好的想法,一个接一个地推出,从此过上幸福的生活。但是事实证明,这是乐观情绪的山峰

the peak of optimism。熟悉的、陷入绝望之谷valley of despair的模式很快就出现了:在其他地方取得了令人印象深刻的、成功的技术在我们自己的application中证明是非常中性neutral的。这导致了我们在第一次launch之后对如何迭代深度学习的策略进行了全面修订。在论文

《Improving Deep Learning For Airbnb Search》中,我们描述了在《Applying Deep Learning to Airbnb Search》推出之后的主要改进。除了深入研究核心机器学习技术本身,我们还关注导致突破的过程process和缘由reasoning。现在从更大的角度来看,我们更重视在如何迭代DNN方面的经验教训,而不是任何单独的技术。我们希望那些专注于在工业环境中应用深度学习的人会发现我们的经验很有价值。我们通过回顾我们为改进

DNN架构所作的努力来展开讨论。- 对于架构,我们描述了一个新的

ranking神经网络,重点关注于将我们现有的DNN发展到两层全连接网络之外的过程。 - 在处理

ranking中的位置偏差positional bias时,我们描述了一种新颖的方法,该方法在处理库存inventory方面取得了显著的提升。 - 为了解决冷启动问题,我们描述了我们对问题的看法,以及我们为改善平台上新

listing的处理所做的改变。

- 对于架构,我们描述了一个新的

14.1 架构优化

什么是深度学习?嗯,添加更多的

layer。至少,在回顾了引领当前深度学习时代的一系列进展之后,这是我们朴素的解读。但是,当我们试图复制《Revisiting Unreasonable Effectiveness of Data in Deep Learning Era》中总结的scaling数据和添加更多layer的好处时,我们遇到的只是中性的测试结果。为了解释为什么增加

layer没有显示任何收益,我们从文献中借用了更多的想法,例如应用残差学习residual learning、batch normalization等等。尽管如此,NDCG在离线测试中仍然没有提升。我们从这些练习

exercise中得出的结论是:增加layer是convolutional neural networks: CNN卷积神经网络中的有效技术,但是不一定适用于所有DNN。对于像我们这样的全连接网络fully connected networks: FCN,两个隐层就足够了,模型容量不是我们的问题。如果更深的网络不适合我们的架构,那么我么假设:更专业的网络可能适合我们的架构。因此,我们尝试了可以显式处理

query和listing之间交互的架构,例如Deep and Wide,其中query-listing的特征交叉添加到wide部分。接下来是《Attention is All you Need》中基于attention的网络变体。这样做的目的是使得从query特征派生的隐层将注意力集中在从listing特征派生的隐层的某些部分上。这些努力的简短总结是,它们也未能改变现状。在尝试将成功的深度学习架构引入

product application时,在翻译任务translation中经常忽略的是:一个体系架构的成功和它的应用上下文application context有着错综复杂的联系。人们报告的架构性能提升来自于解决与它进行比较的baseline的某些缺点。由于深度学习普遍缺乏可解释性explainability,因此很难准确推断出新架构正在解决什么缺点、以及如何解决这些缺点。因此,确定这些缺点是否也同样困扰着自家产品,就变成了一种猜测。为了提高我们成功的几率,我们放弃了 “下载论文 --> 实现 -->

A/B test” 的循环。相反,我们决定基于一个非常简单的原则来推动这个过程:用户主导、模型跟随users lead, model follows。问题驱动,而不是模型驱动。

用户主导、模型跟随

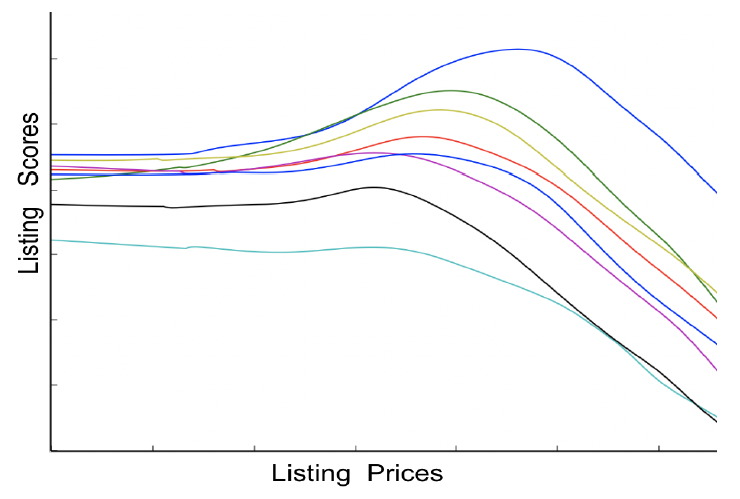

Users Lead, Model Follows:这里的想法是:首先量化一个用户问题user problem,随后调整模型以响应用户问题。沿着这些思路,我们观察到

《Applying Deep Learning to Airbnb Search》中描述的一系列成功的ranking模型不仅与预订量的增加有关,而且还与搜索结果的平均listing价格降低有关。这表明模型迭代越来越接近租客的价格偏好price preference,其中每轮迭代时平均价格低于前面模型的平均价格。我们怀疑,即使在连续降价之后,模型的价格选择和租客的价格偏好之间也可能存在

gap。为了量化这种gap,我们观察了每个租客看到的搜索结果的价格中位数、以及该租客预订listing的价格之间的gap的分布。由于价格服从对数正态分布log-normal distribution,因此在对价格取对数之后计算差异。下图给出了差异的分布情况。X轴显示了预订价格和搜索结果中间价median price的对数偏移,Y轴是这个对数偏移对应的用户数。

我们预期的是:预订价格将围绕着搜索结果的中间价对称分布,并且类似于以零点为中心的正态分布。实际上相反,这个分布在负向侧

negative side更大,表明租客更偏好较低的价格。这给了我们一个具体的用户问题来调查:是否需要将更接近租客价格偏好的低价listing排名更高。假设有两个普通的

listing,它们除了价格在其它方面都相同,我们的直觉理解是租客更喜欢更便宜的listing。我们的ranking模型是否真正理解了cheaper is better的原则?我们并不完全确定。cheaper is better是一个先验知识,因此希望模型能够学到这一先验知识。Enforcing Cheaper Is Better强迫cheaper is better:我们不清楚模型如何解释listing价格的原因是:模型是一个DNN。一些熟悉的工具,如检查逻辑回归模型中相应权重、或者GBDT模型中的部分依赖图partial dependence graphs,在DNN环境中都不再有效。为了使得价格更可解释

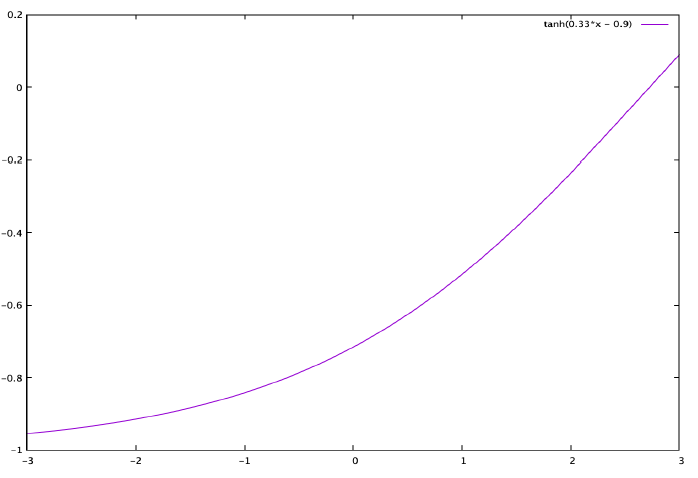

interpretable,我们对模型架构进行了以下更改:从

DNN的输入特征中移除价格。我们将这个修改的DNN模型记作 ,其中 为DNN模型参数, 为用户特征, 为query特征, 为移除了价格的listing特征。模型的最终输出修改为:

其中 为待学习的参数, 定义为:

其中

price为原始的价格特征,而 为根据日志的listing价格的中位数计算得出的常数。

-tanh(.)项允许我们通过相对于价格单调递减的output score来强制执行cheaper is better。易于解释的 和 参数使得我们能够准确描绘出价格的精确影响。通过训练数据我们学习到参数取值为: 。我们在下图中绘制了在

ranking过程中, 遇到的典型取值所对应tanh(.)项的结果。X轴表示归一化的价格( 值),Y轴表示tanh(.)项的结果。

当对

《Applying Deep Learning to Airbnb Search》中的带两个隐层的DNN进行在线A/B test时,搜索结果的平均价格下降了-5.7%,这与离线分析相一致。但是价格的可解释性付出了沉重的代价,因为预订量下降了-1.5%。我们猜想背后的原因是:价格和其它特征密切相关,将价格从模型中分离出来导致欠拟合。

NDCG在训练集和测试集上都下降了,该事实支持这一假设。广义单调性

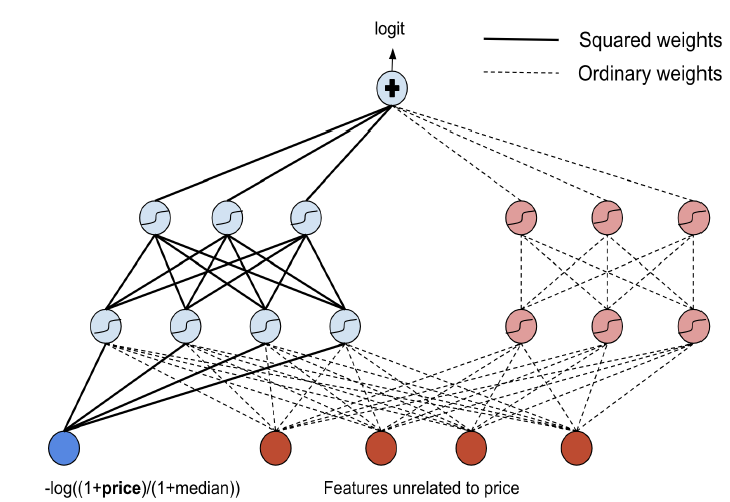

Generalized Monotonicity:为了在模型中保留cheaper is better的直觉,但是允许价格和其它特征相互作用,我们开始研究在某些输入特征方面是单调monotonic的DNN架构。lattice networks为这个问题提供了一个优雅的解决方案。但是,将我们的整个系统切换到lattice networks是一个巨大的挑战,我们寻求一种破坏性较小的机制。因此,我们构建了下图中所示的架构,除Tensorflow中原生节点之外,该架构不依赖于任何专门的计算节点。我们讨论架构的逐步构建,确保从输入价格节点到最终输出的所有路径在价格方面都是单调的:

我们将 作为

DNN的输入,该输入相对于价格单调递减。在

input layer,我们没有将 乘以权重参数,而是将它乘以权重参数的平方。因为在任何 参数(都是实数)的情况下, 都是相对于价格单调递减的。因此第一层隐层的输入对于价格也是单调递减的。对于隐层,我们使用 作为激活函数,该激活函数保持了单调性。

给定相对于 单调递减的两个函数 ,那么 也是相对于 单调递减的。其中 可以为任意实数。

我们在第二个隐层和输出层使用这个属性,所有权重都是平方的。在下图中,这在第二个隐层和输出层用粗实线表示。即:粗实线表示平方权重,虚线表示常规的权重。

添加一个既没有价格作为输入、也没有任何单调性约束的子网

subnet,从而允许其它特征之间的不受约束的交互。

尽管比

Enforcing Cheaper Is Better中描述的架构更加灵活,但是在线测试的结果非常相似:预订量下降了-1.6%。与

Enforcing Cheaper Is Better中描述的架构一样,该架构强制模型在任何情况下的输出都是相对于价格单调递减的。这种架构的失败表明:价格的单调性是一个过于严格的约束。

软单调性

Soft Monotonicity:虽然前面描述的架构揭示了DNN在支持模型约束方面的能力,但是它也教会了我们DNN的另一个特点:它们的行为就像团队中的一位明星工程师star engineer。给定一个问题,让他自己解决,他通常会想出一个合理的解决方案。但是强迫他往某个方向走,灾难很快就会随之而来。所以在我们的下一次迭代中,我们决定通过配置上下文

setting context来管理DNN,而不是通过控制control来管理DNN。我们没有强制要求模型的输出是价格的单调函数,而是添加了一个软提示soft hint:cheaper was better。通常,每个训练样本包含一对

listing,一个是预订的listing、另一个是未预订的listing。将DNN应用于这两个listing的特征并产生对应的logits,并且定义损失函数为:xxxxxxxxxx91# tensorflow 代码定义的 pairwise booking loss2def get_loss_op(positive_logits, negative_logits):3logit_diffs = positive_logits - negative_logits4xentropy = tf.nn.sigmoid_cross_entropy_with_logits(5labels = tf.ones_like(logit_diffs),6logits = logit_diffs7)8loss = tf.reduce_mean(xentropy)9return loss为了添加价格提示

price hint,我们为每个训练样本引入了第二个label,指示两个listing中哪个价格更低、哪个价格更高。然后我们修改损失函数如下:xxxxxxxxxx151# tensorflow 代码定义的 pairwise booking loss2def get_loss_op(positive_logits, negative_logits):3logit_diffs = positive_logits - negative_logits4xentropy = tf.nn.sigmoid_cross_entropy_with_logits(5labels = tf.ones_like(logit_diffs),6logits = logit_diffs7)8loss = tf.reduce_mean(xentropy)9return loss10# booked listing 为正样本、not booked listing 为负样本11booking_loss = get_loss_op(booked_logits, not_booked_logits)12# 低价 listing 为正样本、高价 listing 为负样本13price_loss = get_loss_op(lower_price_logits, higher_price_logits)14# alpha 为超参数15loss = alpha * booking_loss + (1 - alpha) * price_lossalpha超参数提供了一种方法来控制:结果是按照相关性relevance排序还是按照价格price排序。将价格约束作为一种正则化,使得模型倾向于选择低价的

listing。为了测试这个想法,我们将

alpha超参数调整到最小值,这样在离线测试中,我们得到了和baseline模型相同的NDCG。这使得我们能够在不损害相关性的情况下尽可能地推动cheaper is better的直觉,至少在离线指标上是这样的。在在线

A/B test中,我们观察到搜索结果的平均价格下降了-3.3%,但是预订量也下降了-0.67%。离线分析的局限性在于:它仅对日志中可用的、

reranking中的top结果(因为这些日志是reranking模块胜出的流量)进行评估。在在线测试期间,将新训练的模型应用于整个库存inventory空间揭示了将价格损失作为训练目标的一部分的真实代价。离线评估样本分布和在线样本分布不同,因此即使离线

auc相同的情况下,在线a/b test表现也不相同。执行个体条件期望

Putting Some ICE:降价实验带来的灾难让我们处于一种矛盾的状态:搜索结果中的listing价格似乎高于房客偏好价格,但是压低价格却让房客不高兴。为了了解新模型的不足之处,有必要比较

baseline模型是如何利用价格特征的,但是这被全连接DNN缺乏可解释性所掩盖。如前所述,像部分依赖图partial dependence plots这样的概念没有用,因为这种方式依赖于给定的特征对模型的影响独立于其它特征的假设。试图给出价格的部分依赖图会产生平缓倾斜sloping straight的直线,这表明DNN对价格有一些轻微的线性依赖,这与我们所知道的相矛盾。为了取得进展,我们缩小

scaled down了DNN可解释性的问题。我们没有试图对价格如何影响DNN做一般性的陈述statement,而是聚焦于一次解释单个搜索结果。借用《Peeking Inside the Black Box: Visualizing Statistical Learning With Plots of Individual Conditional Expectation》中的个体条件期望individual conditional expectation:ICE图plots的想法,我们从单个搜索结果中获取listing,在保持所有其它特征不变的情况下对价格选取一定的范围,并构建模型得分的plot。下面给出了一个示例。图中

x轴为价格、y轴为模型预估的listing score。每条曲线代表了单次搜索结果中的一个lising(在多个价格上的score)。因为单次搜索返回多个listing结果,所以下图中有多条曲线。该图表明,

《Applying Deep Learning to Airbnb Search》中的两层全连接层DNN已经理解了cheaper was better。对日志中随机选择的搜索集合重复ICE分析进一步加强了这个结论。失败的架构通过试图进一步压低价格从而影响了模型质量。

双塔架构

Two Tower Architecture:回到下图,租客显然是在通过这个plot传递一个信息。但是,那些致力于用相关性relevance换取价格price的架构错误地解释了这个信息。需要对下图进行重新解释,这个解释必须和价格保持一致,也必须和相关性保持一致。即不能用相关性的降低来换取价格的降低,应该在保持相关性的同时降低价格。

当我们计算租客搜索结果的中间价与其预订价格之间的差异,并计算按城市分组的均值时,就出现了上图的替代解释

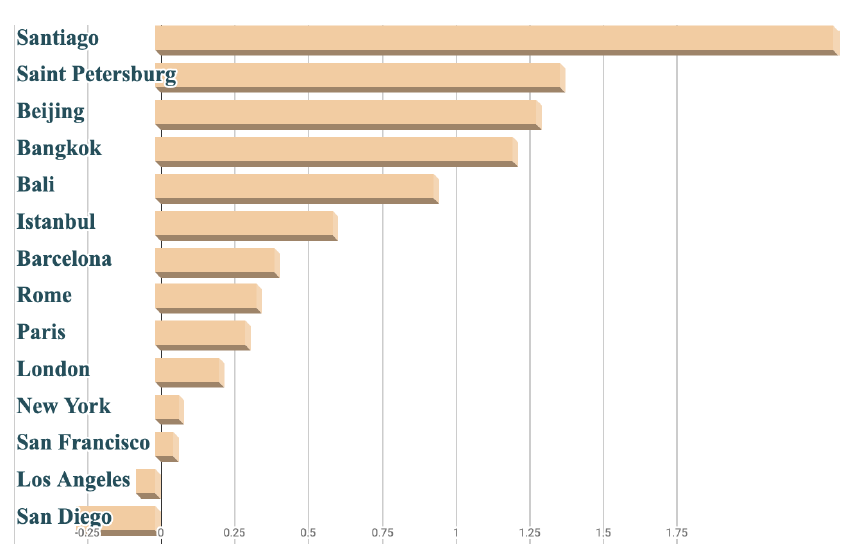

alternate explanation。正如预期的那样,各城市之间存在差异。但是和头部城市相比,尾部城市的差异要大得多。尾部城市也通常位于发展中市场developing markets。下图展示了某些选定城市的搜索结果中间价和预订价格之间的差异的平均值。

这就产生了一个假设,即:搜索结果中间价与其预订价格之间差异

plot背后的DNN正遭受多数暴政tyranny of the majority,它聚焦于针对统治了预订量的热门区域调优的price-quality tradeoff。将这个trade-off推广到长尾的query效果不佳,并且该模型也不适应本地条件(即长尾城市)。该假设与馈入

DNN特征的另一个观察相吻合。鉴于DNN是使用pairwise损失训练的,pair对的两个listing中有差异的特征似乎具有最大影响力。query特征,这对于pair对的两个listing都是公共的,似乎没有什么影响,并且删除query特征对于NDCG的影响非常微小。新的想法是,该模型充分理解了

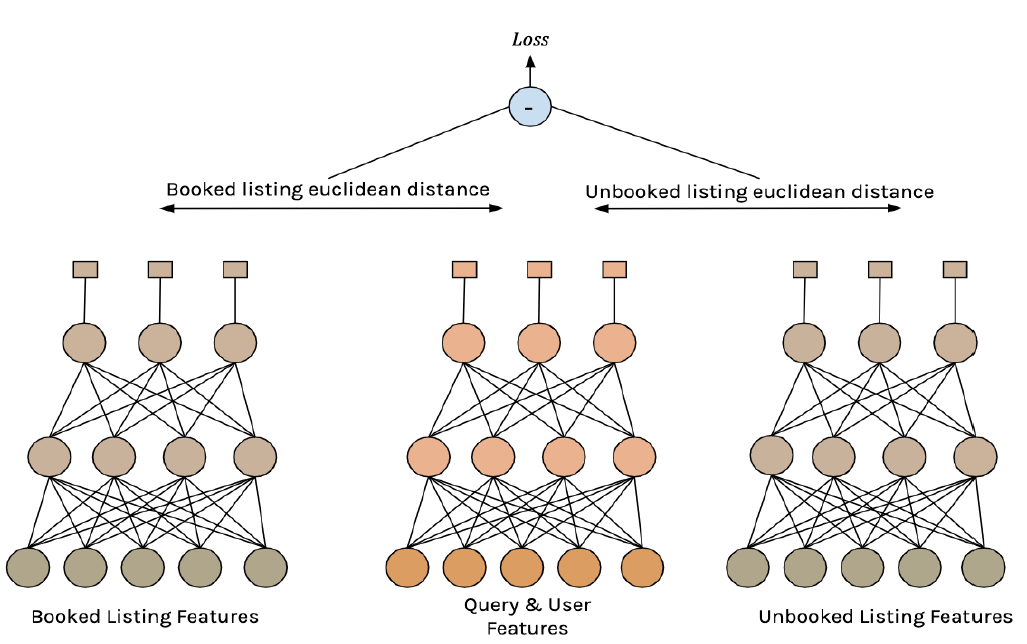

cheaper is better,但它缺少的是合适价格right price的概念。理解这一概念需要密切关注query特征,如位置location,而不是纯粹基于listing特征进行区分。这启发了该架构的下一次修订,新架构由双塔two towers组成。- 第一个塔由

query特征和用户特征馈入,生成了一个100维的向量,该向量从概念上代表了query-user组合的ideal理想listing。 - 第二个塔根据

listing特征构建了一个100维的向量。两个塔输出向量之间的欧氏距离用于衡量给定listing和query-user的理想listing之间的距离。

训练样本由

listing pair对组成:一个已预订listing、一个未预订listing。损失函数的定义是:和已预订

listing相比,未预订listing与理想情况的接近程度。因此,对这个双塔模型进行训练可以使得pair对中的预订listing更接近理想listing、同时将未预订listing远离理想listing。这类似于《A Unified Embedding for Face Recognition and Clustering》中引入的triplet loss。这里的主要区别在于:我们没有在三元组triples上训练,而是只有listing pair,并且三元组中缺失的anchor listing是由query-user塔来自动学习。query和listing的pairwise training如下图所示。

Tensorflow代码如下所示,实际实现可能略有不同从而优化训练速度:xxxxxxxxxx291import tensorflow as tf2def get_tower(features, w0, b0, w1, b1):3# 两层全连接层,用于产生一个 100 维向量4h1 = tf.nn.tanh(tf.matmul(features, w0) + b0)5h2 = tf.nn.tanh(tf.matmul(h1, w1) + b1)6return h27def get_distance_to_ideal(query_vec, listing_vec):8# 计算 listing hidden layer 和 query hidden layer 之间的欧式距离9sqdiff = tf.math.squared_difference(query_vec, listing_vec)10logits = tf.math.reduce_sum(sqdiff, axis=1)11return logits12def pairwise_loss(query_features, booked_listing_features,13not_booked_listing_features ) :14qvec = get_tower(query_features, query_w0,15query_b0, query_w1, query_b1)16booked_vec = get_tower(booked_listing_features, listing_w0,17listing_b0, listing_w1, listing_b1)18not_booked_vec = get_tower(listing_features, listing_w0,19listing_b0, listing_w1, listing_b1)20booked_distance = get_distance_to_ideal(qvec, booked_vec)21not_booked_distance = get_distance_to_ideal(qvec, not_booked_vec)22distance_diff = not_booked_distance - booked_distance23# 通过增加二者之间的相对距离,将未预定 listing 推离理想 listing,24# 将预定 listing 推近理想 listing25xentropy = tf.nn.sigmoid_cross_entropy_with_logits(26labels = tf.ones_like(logit_diffs),27logits = logit_diffs)28loss = tf.reduce_mean(xentropy)29return loss- 第一个塔由

测试结果:当进行线上

A/B test时,其中baseline为《Applying Deep Learning to Airbnb Search》中的两层全连接层的DNN,双塔架构的预订量增加了+0.6%。这一增长是由搜索便利性ease of search的提高所推动的,因为在线NDCG提高了0.7%。尽管这个双塔架构的目标不是直接降低价格,但是我们观察到搜索结果的平均价格降低了-2.3%,这是相关性增加的副作用side effect。预订量的增加抵消了价格下降对于收入的影响,整体收入增加了+0.75%。搜索便利性:搜索结果中,目标

listing排名更靠前因此有利于用户预订。除了提高搜索结果的质量之外,双塔架构还允许我们优化在线

DNN的scoring延迟。对于全连接架构,评估第一个隐层贡献了

scoring延迟的最大部分。评估第一个隐层的计算复杂度可以表示为 ,其中 是和listing无关的query和user特征的数量, 为listing特征的数量, 为第一层的隐单元数量。为了评估包含 个

listing的结果集(该结果集对应于单个query的搜索结果),总的算法复杂为 。在新架构的双塔中,

query塔独立于listing。这允许在整个搜索结果集针对该塔仅评分一次,并且仅评估每个listing的listing dependent tower。第一个隐层的计算复杂度降低到 ,其中 和 为listing塔和query塔的隐层神经元数量。当在线测试时,这导致

99th百分位数的scoring延迟降低了-33%。

架构回顾:就在我们庆祝成功的时候,随着

DNN迭代的启动,疑虑也悄然而至。架构是否按预期工作?或者DNN是否偶然发现了其它意外情况?过去,

DNN的不可解释的性质使得回答此类疑问变得极其困难。但是考虑到双塔架构的直觉是针对用户问题user problem而开发的,我们现在可以使用这些直觉来更好地了解DNN的运作方式。重温价格的

ICE图,我们看到了一个显著的变化。如下图所示,我们看到分数在某些价格附近达到峰值,而不是总是向下倾斜(对应于cheaper is better)。这更接近right price for the trip(旅行的正确价格) 的解释。在这种情况下,一个经常被提出的问题是,低质量的

listing是否可以通过简单地降低价格从而在新模型中提升排名。仔细检查ICE曲线发现,某些价格附近的分数峰值仅发生在高质量listing中,这些listing通常一开始就排名靠前。对于大多数listing,该图仍然保持着与价格相关的单调递减曲线。

正确价格

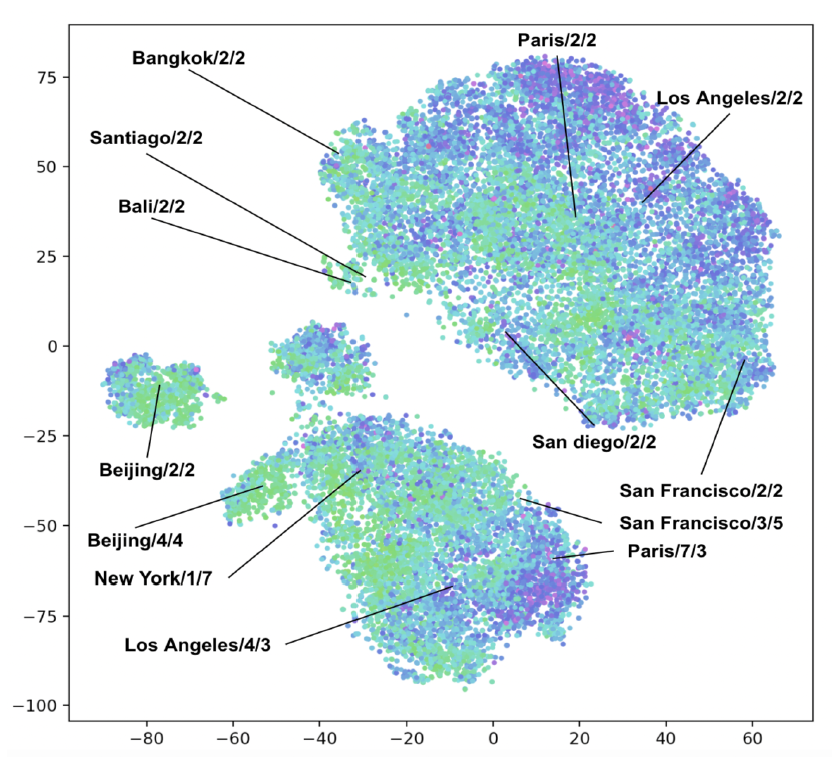

right price、理想listing这些概念的核心是query塔生成的向量,因此自然而然的后续工作是准确地研究这些向量到底是什么样子的。为了进行分析,我们随机采样了一批搜索来运行了双塔DNN,并收集了query塔的输出向量。由于100维向量对于人类是不可解释的,因此我们应用t-SNE将这些向量降维到2维空间,如下图所示。图中标出了部分城市对应的query,每个点代表一个query。某些query标记有city/guest-count/trip-length信息。点的颜色代表query的预订订单价格,越便宜颜色越绿、越贵颜色越蓝。令人欣慰的是,租客数量guest count和行程长度trip length等参数相似的值形成了大的簇clusters。在大的簇内部,直觉上感觉相似的城市(比如都是发达市场或者发展中市场)被放置在彼此相对接近的地方。

值得强调的是,簇不仅仅是价格簇

price clusters。和query对应的预订listing的价格由点的颜色来表示,我们看到簇具有所有范围all range的颜色。虽然莫斯科通常比巴黎更便宜,但是莫斯科的预订价格很容易超过巴黎的预订价格,这取决于租客数量、停留时间duration of stay、离旅游景点的距离、周末vs工作日、以及许多其他因素。价格与所有其它维度有着千丝万缕的联系,掌握旅行的正确价格意味着同时掌握所有其它因素。我们所作的分析都不能作为双塔架构确实发展出这种掌握

grasp的有力证据。但是,针对价格的ICE图、query塔输出的t-SNE可视化、以及对跨城市price movements的额外分析给了我们足够的信息,让我们相信这一机制正在按预期发挥作用。放下一系列的架构操作,接下来我们继续解决

ranking的挑战,该挑战不仅影响房客,也影响Airbnb社区的另一半,即房东。

14.2 冷启动改善

在旅游领域的机器学习

application中,任何时候都有很大一部分用户是新用户,或者在很长一段时间后才使用该产品。此时用户处于连续冷启动状态continuous cold start。处理

user level冷启动是核心排序公式core ranking formulation本身的一部分。所以在提到冷启动问题时,我们把注意力集中在item level冷启动上(即如何处理新item的排名)。和前面改进DNN架构的情况一样,我们探索的起点不是文献综述,而是对用户问题user problem的观察。使用

NDCG来量化预订listing在搜索结果中的位置,这对我们来说是衡量模型性能最可靠的方法。因此,调查用户问题的一个自然的地方是:寻找NDCG低于NDCG整体水平的细分市场。考虑平台上新

listing、老listing中,预定listing的在线NDCG之间的差异,我们观察到了-6%的差距。而模型预估的NDCG和在线预定的NDCG之间的差异只有0.7%。这表明该模型让房客更难发现值得预订的新listing。为了更好地理解这一点,我们从

DNN中移除了所有的、listing上基于房客历史互动生成的输入特征,例如一个listing的历史预订量。删除这些互动特征engagement features导致离线NDCG下降了-4.5%。显然,DNN非常依赖于互动特征。由于新listing没有这些互动特征,因此DNN被迫根据剩余特征做出宽泛broad的判断,从而接近新listing的平均表现。冷启动方法视为

Explore-Exploit:冷启动问题的一个可能的框架是将它视为探索和利用explore-exploit之间的tradeoff。排序策略可以通过利用

exploiting当前库存inventory的知识来短期地专门优化预订量,并且只押注那些有良好记录的listing。但是为了市场的长期成功,它需要支付一些成本来探索explore新的库存。这种

tradeoff可以作为新listing的显式排名提升boost来实现,它为新listing分配更高的排名(相比较于DNN所确定的排名)。这允许新listing以较低的预订代价cost收集租客的反馈。这种通用的方式在电商排序application中很流行,例如在《Re-ranking results in a search》中。这种boost可以通过曝光次数限制、或者引入时间衰减来进一步细化refined。即,给新

listing预估的得分提供一个大于1的权重,该权重可以随着时间衰减到1.0、或者随着新listing曝光次数增加而衰减到1.0。我们的第一次迭代是为了测试这种

boost。通过在线A/B test,与没有boost相比,boost并没有带来新listing的预订量的提升或下降(效果中性),并且为新listing带来了+8.5%的首页曝光次数。但是,

explore-exploit范式带来了严峻的挑战:新

listing的ranking boost被两种相反的力量拉向不同的方向:- 由于搜索结果相关性

relevance降低,短期内用户体验user experience下降。我们可以准确地衡量这一影响(通过点击率或预订量)。 - 由于库存增加,长期来看用户体验有所改善。我们发现这种影响很难量化。

缺乏对最佳

boost值的明确和客观的定义导致了激烈的内部辩论,没有一个解决方案让每个团队都满意。- 由于搜索结果相关性

即使能够确定探索

exploration成本的总体预算,很明显,预算的正确使用取决于特定地域location的供需supply and demand情况。- 当需求量

demand很大时,探索的容忍度就很高。当需求量很少时,探索的容忍度就没那么高。

即流量充裕的时候,适当的探索可以接受;但是流量稀缺的时候,探索代价较大。

在商品供给受到限制的区域,探索和扩大库存的需求很高。当大量优质

listing空置时,几乎没有动力承担探索成本。即供给稀缺的时候,很有必要进行探索;但是供给充裕的时候,没动力进行探索。

供需反过来又受到位置

location、季节性seasonality、租客容量capacity等参数的影响。因此,为了最优地使用全局探索预算,需要数千个局部参数localizing parameters,这是一项无法手动完成的任务。- 当需求量

预估将来的用户互动

User Engagement:为了让系统更易于管理,我们退了一步,开始问:是什么让一个新的listing与众不同?答案当然是缺乏用户产生的互动特征

engagement features,例如预订量、点击量、评论量等等。价格、位置location、遍历设施amenities等其它属性,新listing和其它listing一样。理论上,如果我们有一个预言机可以100%准确预测新listing的互动特征,那么它可以最佳地解决冷启动问题。因此,我们没有将冷启动视为

explore-exploit tradeoff,而是将其重新定义为一个评估新listing互动值engagement values的问题。问题的重新定义揭示了一些重要的东西:它允许我们为问题定义一个客观的理想objective ideal,并不断地朝着它努力。为了解决冷启动问题,我们引入了一个新的组件

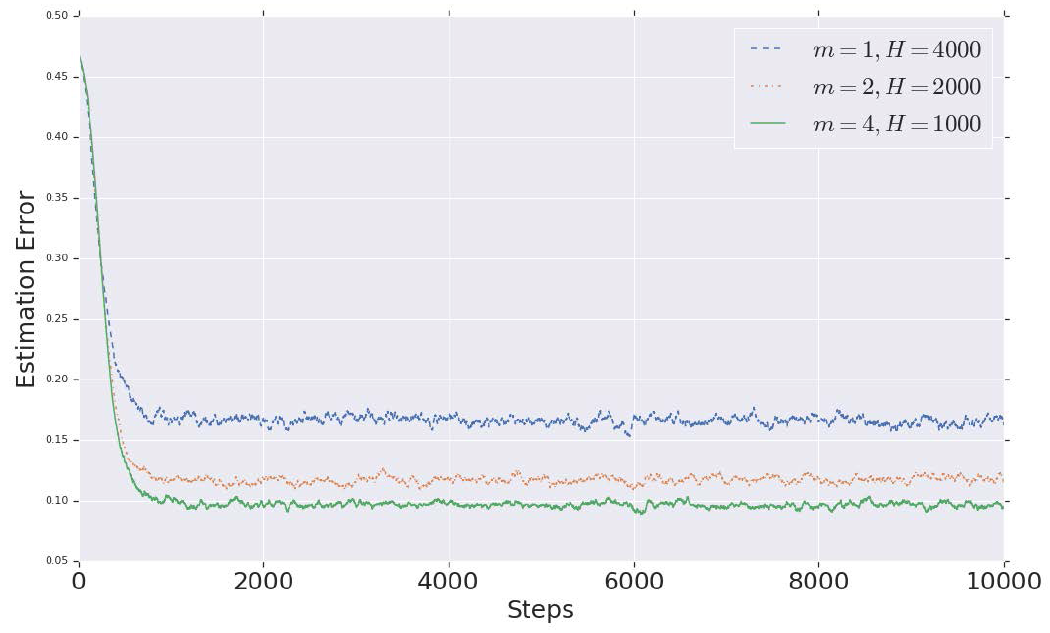

component来为DNN提供数据,该组件在训练和评估时预测新listing的用户互动特征。为了衡量估计器estimator的准确性accuracy,我们采用了以下步骤:从日志中采样 个搜索结果。对于每个搜索结果,从

top 100个位置随机抽取一个listing。这些代表了受到租客充分关注的listing样本,因此它们的互动特征已经充分融合converged。令 表示从日志中获取的抽样

listing的排名。我们将排名表示为real,从而表示listing的互动特征是真实租客互动的结果。从排名中,我们计算real discounted rank为:为什么采用这种形式的

DR指标?论文未给出解释。该指标的性质:真实排名越靠前,指标越大;指标最大值为1.0(当真实排第一名时)、最小值趋近于零。接下来,对于每个抽样的

listing,我们删除所有互动特征,并用被estimator预测的互动特征来代替它们。我们使用预估的互动特征对listing进行评分,在相应的日志搜索结果中找到它的新排名,然后从中计算discounted rank。我们用 来表示。对于每个抽样的

listing,我们计算互动估计中的误差为 。为了获取整体误差,我们对所有抽样的

listing的互动估计误差engagement estimation error进行平均。

理想的互动估计器会产生零误差。要在两个估计器之间取舍,可以选择误差较小的估计器。

为了验证,我们对比了两种估计方法:

baseline是生产中使用的系统,它为缺失的特征分配默认值,包括新listing的互动特征默认值。默认值是通过手动分析相应特征而创建的常量。我们对比了一个

estimator,这个estimator通过新listing地理位置附近的其它listing的互动特征均值来估计了新listing的互动特征。为了提高准确性

accuracy,它只考虑和新listing的房客容量capacity相匹配的相邻listing,并计算滑动时间窗口的均值从而考虑季节性seasonality。这本质上是一种缺失值填充策略:使用相似样本在该特征上取值的均值来进行填充。但是这种方式只能填充单值型的缺失值,难以处理序列型的缺失值。

例如,为了估计一个容纳两人的新

listing的预订量,我们选取了新listing的很小半径内的、容量为两人的所有listing的平均预订量。这在概念上类似于朴素贝叶斯推荐器

Naive Bayes recommender(它使用生成式方法generative method来估计缺失信息)。

测试结果:

- 在离线分析中,与使用默认值相比,上述互动估计器将互动估计误差降低了

-42%。 - 在在线

A/B test中,我们观察到新listing的预订量提高了+14%,同时新listing的首页曝光量增加了+14%。除了对新listing的影响之外,整体预订量增加了+0.38%,表明用户体验的整体改善。

- 在离线分析中,与使用默认值相比,上述互动估计器将互动估计误差降低了

14.3 Positional Bias

我们研究位置偏差

positional bias的出发点是完全不相关unrelated的。与新listing的NDCG较低的观察结果类似,另一个表现低于预期的细分市场是精品酒店boutique hotels和传统住宿加早餐酒店traditional bed and breakfasts。这个细分市场作为库存的一部分正在迅速增长。从观察中得出的一个假设是:由于位置偏差,在训练数据中未充分表达

under-represented的库存没有得到最佳排名。但是和新listing表现与冷启动之间的联系不同,没有充分理由相信位置偏差是这个case的唯一罪魁祸首。还有多个其它假设。虽然我们发现关注用户问题

user problem要比简单地从文献综述中引入想法要好得多,但是用户问题并不是万灵药。在用户问题和模型缺陷之间建立因果关系远远不是简单直接的。在目前的场景中,我们是在黑暗中射击shooting in the dark。但是与此同时,我们决定寻找模型中的最大

gap来解释观察结果。文献综述对于确定我们模型中潜在的主要gap至关重要。相关工作:给定用户 发出的

query,用户从搜索结果中预订listing的概率可以分解为两个因素:listing和用户相关relevant的概率。这个概率可以表示为 ,从而明确它和listing、用户、query的依赖关系。给定

listing在搜索结果中的位置 的条件下,用户检查examined该listing的概率。这可能取决于用户(例如,移动设备上的用户可能对top结果有更高的bias)或query(例如,提前期lead days较短的用户可能不太关注底部结果)。我们将这个概率表示为 ,它独立于

listing。即,用户看到这个

listing的概率,它和设备相关(如,PC端还是手机端,以及手机型号)、和用户紧迫程度有关(如,是今天就想入住,还是三个月之后入住)。

使用

《Click Models for Web Search》中描述的position based模型的简化建设,我们将用户预订listing的概率简单地表示为两个分解概率的乘积:通过直接训练一个模型来预测预订,该模型学会预测了依赖于 的 。这反过来又取决于位置 ,这是先前

previous的ranking模型做出的决定。因此,当前的模型变得依赖于先前的模型(指的是模型的前一个版本)。理想情况下,我们希望模型专注于 ,并仅按照相关性

relevance对listing进行排序。为了实现这一点,《Unbiased Learning-to-Rank with Biased Feedback》描述了一种具有两个关键概念的方法:- 一个预测 的倾向性模型

propensity model。 - 用预测的倾向的倒数来加权每个训练样本。

虽然构建倾向性模型通常涉及扰乱

perturbing搜索结果从而收集反事实counterfactuals的样本,但是《Estimating Position Bias Without Intrusive Interventions》描述了在没有额外干扰的情况下构建倾向模型的方法。位置作为控制变量

Position As Control Variable:我们的解决方案有两个关键亮点。首先,它是非侵入式

non-intrusive的,不需要对搜索结果进行任何随机化。我们依赖

Airbnb搜索结果的一些独特属性,这些属性使得listing即使在排序分不变的情况下也可能出现在不同的位置:listing代表给定日期范围内只能预订一次的物理实体physical entities。随着listing被预订并从搜索结果中消失,这会改变剩余listing的position。在

Airbnb中,每个item的库存只有一个,这和电商(每个item库存很多个)、新闻(每个item库存无限)不同。每个

listing都有自己独特的日历可用性unique calendar availability,因此对于跨日期范围的相似query,不同的listing会出现在不同的position。

其次,我们没有明确建立一个倾向模型。相反,我们在

DNN中引入位置position作为特征,并通过dropout进行正则化。在评分过程中,我们将position特征设置为零。

接下来我们描述为什么这种方法有效的直觉

intuition。我们以前面描述的DNN为基础,将query特征、用户特征、listing特征作为输入。利用符号 (query特征)、 (用户特征)、 (listing特征)、(DNN参数),我们将DNN的输出表示为:这反映了

《Click Models for Web Search》中position based模型所作的假设,其中:- 估计了 ,我们称之为相关性预测

relevance prediction。 - 预估 ,我们称之为位置偏差预测

positional bias prediction。

很明显 缺少

listing的位置 作为输入,而它试图估计的量依赖于 。因此,我们的第一步是将 作为输入特征添加到DNN。因为相关性预测和位置偏差预测都是由DNN的输入馈送fed的,因此向输入中添加 会将我们的DNN变为:假设 独立于

listing,位置偏差预测对 的任何依赖性dependence都可以被视为误差error。我们假设有足够数量的训练数据,待学习的参数 能够最小化该误差。我们将这个假设理解为:其中从 中移除 。

评分时,我们将位置特征 设置为零。在给定的

query中, 和 在DNN评分的listing中是不变的。我们使用 和 来表示给定搜索的query特征和用户特征。因此,位置偏差预测变为 ,它是对给定搜索结果中所有listing不变invariant的,我们将其记作 。那么DNN的评分变为:这使得两个

listing得分的比较独立于位置偏差positional bias,并且仅依赖于listing相关性relevance。本质上,我们在排序模型中添加了position作为控制变量control variable。对于给定的 和 (因此 是固定的),我们需要对所有的

listing进行位置无关的排序。则 的排序等价于 的排序。Position Dropout:在position based模型的假设下,增加position作为控制变量有效地消除了listing排序中的位置偏差预测,但是它引入了一个新的问题:相关性预测现在依赖于位置特征position feature。这使得DNN在训练期间依赖位置特征来预测相关性,但是在评分期间无法利用学到的、位置相关的知识(因为评分期间位置特征总是为零)。将具有位置特征的

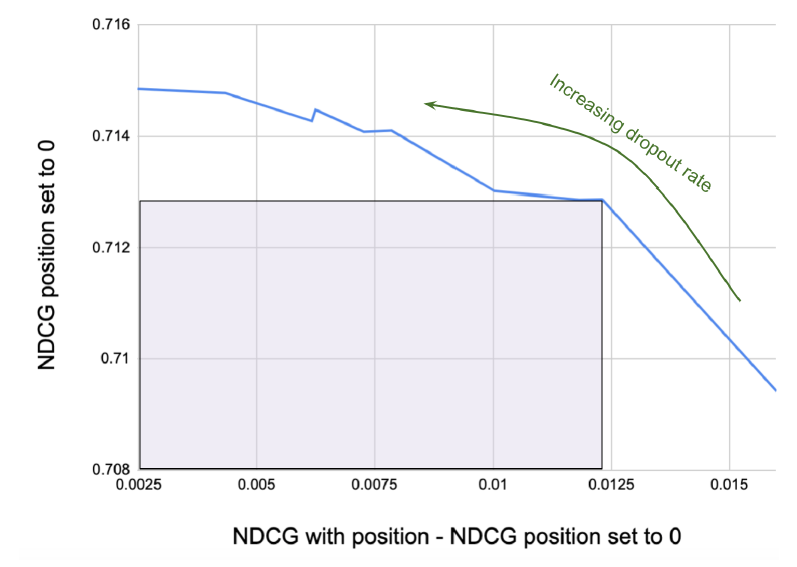

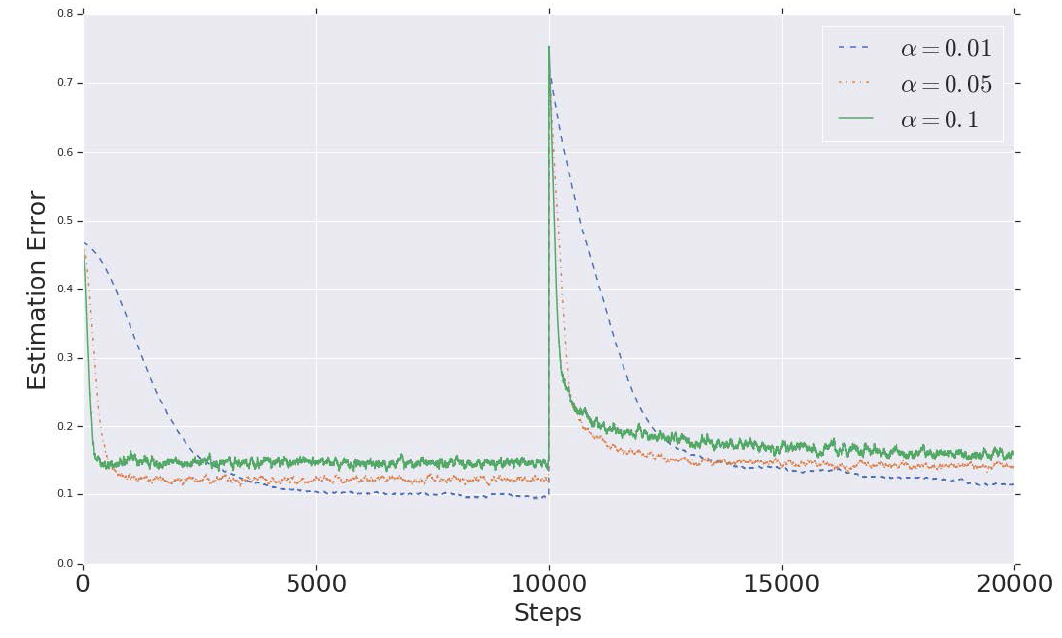

DNN和没有位置特征的baseline进行比较,我们可以看到离线NDCG下降了大约-1.3%。因此,直接将位置作为控制变量引入模型似乎会损害相关性预测。为了减少相关性预测对于位置特征的依赖项,我们使用dropout对其进行正则化。在训练期间,我们随机性地将listing的position设为0,这个概率由dropout rate来控制。dropout rate在无噪声noise-free地访问位置特征从而准确地推断位置偏差vs有噪声noisy地访问位置特征从而远离相关性预测之间进行tradeoff。我们尝试通过以下步骤找到平衡的tradeoff:扫描一个范围内的

dropout rate,并在测试集上计算两种NDCG。- 第一个是在测试期间将

position为零,这衡量了相关性预测并表示为 。 - 第二个通过保留位置特征来衡量相关性和位置偏差组合在一起的预测,记作 。

- 第一个是在测试期间将

从而获得位置偏差预测。这里的直觉是:通过比较有位置输入和没有位置输入的排序质量,我们可以估计位置对于排序的贡献。

我们得到了 针对位置偏差预测的曲线,如下图所示。

Y轴为 ,X轴为位置偏差预测。

为了在相关性预测和位置偏差预测之间取得平衡,我们在曲线上选择一个点,该点在

X轴上的位置偏差预测足够先进advanced,而且不会导致Y轴上的相关性预测下降太多。

通过这个练习

exercise,我们最终选择了0.15的dropout rate。测试结果:我们通过在线

A/B test测试了这个想法,其中:对照组是没有位置偏差的DNN;实验组是相同的DNN,但是使用位置作为特征进行训练,并以0.15的dropout rate进行正则化。在在线测试中,我们观察到预订量增加了0.7%。除了预订量增加之外,收入增长

1.8%也是一个惊喜。收入增长这个副作用说明了位置偏差是如何在模型的多次迭代中累计起来的。对于排序模型来说,了解价格的影响相对容易,因为价格是一个非常清晰的特征,并且数据强烈表明人们更喜欢较低的价格。质量

quality、地域location等平衡力量balancing forces更难学习。因此,最初的简单模型严重依赖较低的价格。经过多次模型迭代,我们提高了对质量和地域的理解,但那时对更便宜的价格的

bias已经在训练数据中根深蒂固。这种黏性使得接下来的模型高估了对较低价格的偏好。消除positional bias使得模型更接近客人的真实偏好,并在价格、质量、地域之间取得更好的平衡。观察到的收入增长是其直接后果。最后,我们观察到精品酒店的预订量增加了

1.1%。

十五、HOP-Rec[2018]

推荐系统在现代无处不在,并且已经广泛应用于推荐音乐、书籍、电影等

item的服务。真实世界的推荐系统包括很多有利于推荐的user-item交互,包括播放时间、喜欢、分享、以及贴标签tag。协同过滤collaborative filtering: CF通常用于利用这种交互数据进行推荐,因为CF在各种推荐策略之间性能表现较好,并且不需要领域知识domain knowledge。有两种主流的

CF模型:潜在因子模型latent factor model和基于图的模型graph-based model。潜在因子模型通过分解

user-item矩阵来发现user-item交互背后的共享潜在因子shared latent factor。矩阵分解matrix factorization: MF是此类方法的典型代表。此外,最近的文献更多地关注从隐式数据优化

item排序,而不是预测显式的item score。大多数此类方法假设用户对未观察到的item不太感兴趣,因此这些方法旨在区分观察到的item(positive)和未观察到的item(negative)。总而言之,潜在因子模型通过分解观察到的用户和

item之间的直接交互来捕获用户偏好。基于图的模型探索了由用户、

item、及其交互构建的简单user-item二部图bipartite graph中固有的inherent、顶点之间的高阶邻近性high-order proximity。在某种程度上,这种基于图的方法放松了基于因子分解的模型所做出的假设(即:假设用户对未观察到的

item不太感兴趣),因为它们显式地对user-item交互二部图中的用户和item之间的高阶邻近性进行建模。总而言之,基于图的模型从由

user-item交互构建的图中捕获用户间接偏好。

在论文

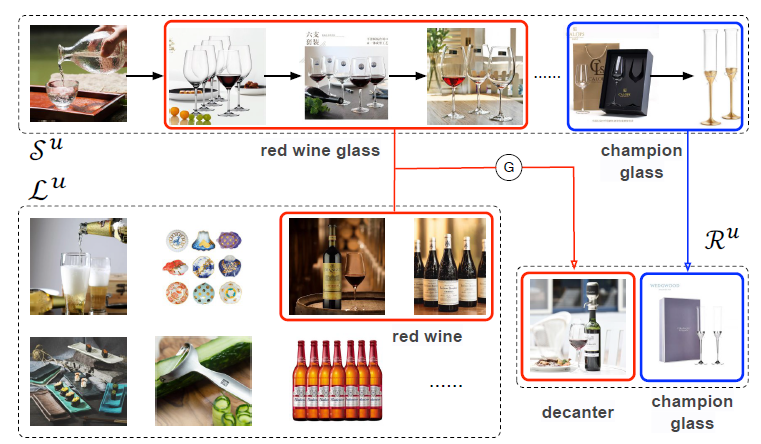

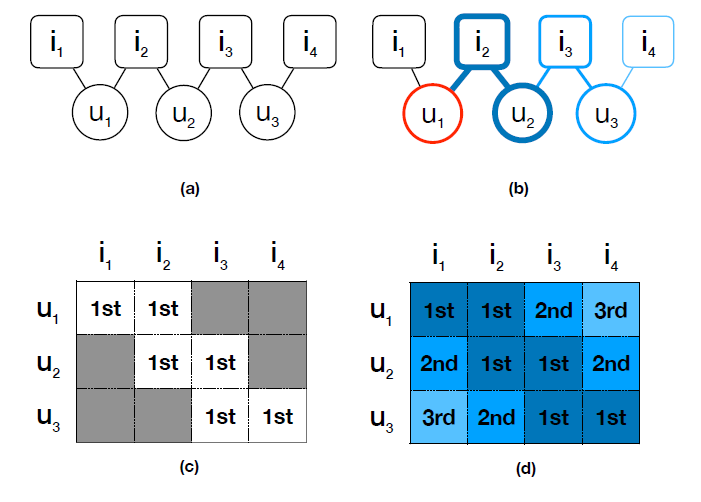

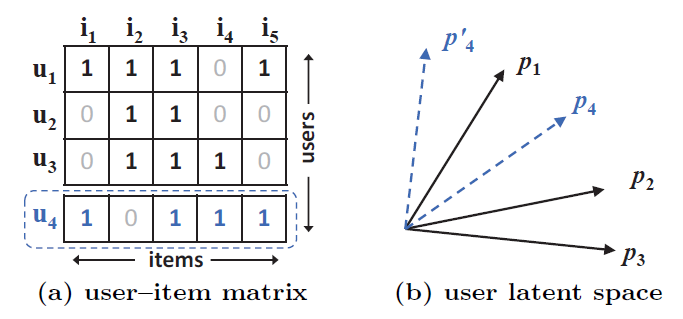

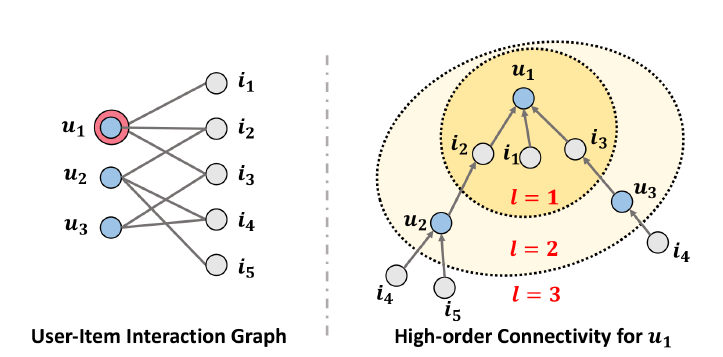

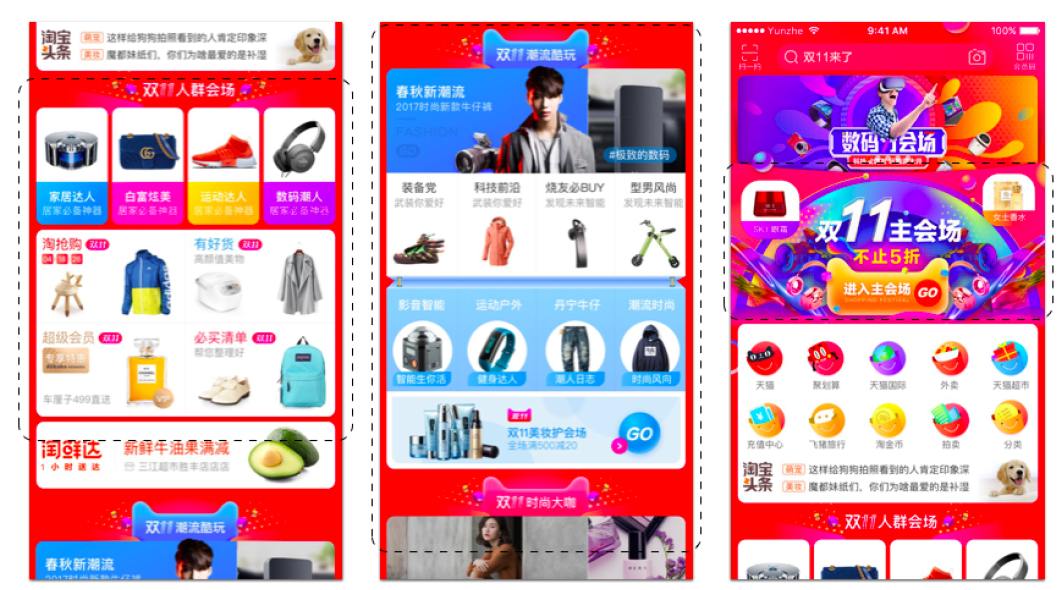

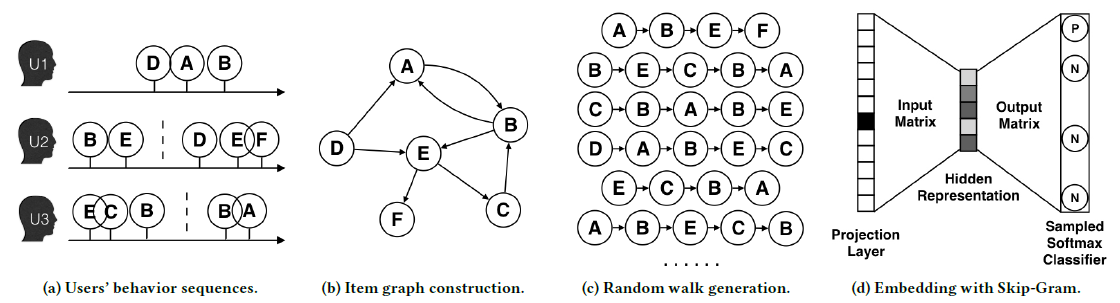

《HOP-Rec: High-Order Proximity for Implicit Recommendation》中,作者提出了高阶临近性增强推荐模型high-order proximity augmented recommendation: HOP-Rec,这是一个结合了这两种隐式推荐方法(潜在因子模型和基于图的模型)的、统一而有效的方法。HOP-Rec通过在user-item二部图上进行随机游走,从而为每个用户发现邻域item的高阶间接信息high-order indirect information。通过对游走路径中不同阶数使用置信参数confidence parameter,HOP-Rec在分解用户偏好的潜在因子时同时考虑item的不同阶数。下图说明了在观察到的交互中对用户和

item之间的高阶邻近性建模的思想。- 图

(a)表示由观察到的user-item交互构建的二部图。 - 图

(b)给出了一条从源顶点 到目标顶点 的路径。 - 图

(c)以矩阵的形式记录了用户和item之间的直接交互(一阶邻近性)。 - 图

(d)以矩阵的形式显示了用户和item之间的高阶关系(高阶邻近性)。

具体而言,用户 的潜在偏好

item按照它们在图(b)中的路径中出现的阶数进行排序。例如,观察到的item和用户 具有一阶关系,未观察到的item和用户 具有二阶关系。HOP-Rec显式地建模这种高阶间接偏好信息high-order indirect preference information。

在真实世界四个大规模数据集上的实验结果表明,

HOP-Rec显著优于几种state-of-the-art的推荐算法,并表明将高阶邻近性和因子分解模型相结合对于一般的top-N隐式推荐问题很有帮助。

15.1 模型

15.1.1 因子分解模型和图模型

交互图

Interaction Graph的定义:user-item交互由一个二元邻接矩阵 来表示,二部交互图bipartite interaction graph基于二元邻接矩阵 来构建。其中:- 为用户集合, 为

item集合, 为顶点集合。 - 表示是否存在交互,边集合 。

- 为用户集合, 为

k阶邻近性k-order Proximity的定义:给定一个交互图 ,顶点 之间的k阶邻近性由它们在图上随机游走生成的序列中的转移概率来定义,其中 。具体而言,令 表示从源顶点 开始的随机游走序列,其中 和 分别表示顶点 的第 个邻居用户和第 个邻居

item。源顶点 与其第 个邻居item之间的k阶邻近性定义为 ,其中:- 表示从 到 的

k阶转移概率。 - 是

k阶衰减因子decay factor。例如 。

如果从 到 不存在可行的路径,则

k阶邻近性为零。- 表示从 到 的

Factorization Model: FM模型:因子分解模型的目标是估计以下两个潜在因子集合:,其中:- 为用户潜在因子集合, 为

item潜在因子集合, 为潜在因子空间的维度。 - 为 的超集,由我们模型中的所有参数组成。

令 表示用户 在 中的行向量, 表示

item在 中的行向量,则MF针对隐式反馈数据集的目标函数为:其中:

- , 为置信度水平

confidence level。通常选择 ,即观察到交互的user-item置信度高于未观察到交互的user-item。 - 为二元变量表示在邻接矩阵 中观察到的用户 和

item是否有交互。 - 正则化参数 是防止观测值过拟合的超参数。

在各种基于因子分解的模型中,基于排序

ranking-based的模型在top-N推荐问题中表现突出。基于排序的模型如BPR和WARP已经从传统的point-wise方法(绝对关系)转变为pairwise方法(相对关系),其中排序损失ranking loss可以定义为:其中:

- 表示用户 观察到的

item(positive), 表示用户 未观察到的item(negative), 。 - 函数 表示

item排序问题的通用目标函数。具体而言,在BPR中, 是由logistic sigmoid函数、对数函数、示性函数组成的排序函数。在WARP中, 由权重近似的排序函数和一个示性函数组成。

基于排序的模型假设用户更喜欢观察到的

item而不是未观察到的item,因此其目标是从每对item pair中区分出偏好的item。- 为用户潜在因子集合, 为

Graph Model模型:除了通常研究的基于因子分解的模型之外,人们还提出了几个基于图的模型,这些模型利用随机游走来对推荐的item进行排序。具体而言,这类模型的主要思想是将user-item交互矩阵 视为交互图,并在图上使用随机游走从而引入间接偏好信息来提供推荐。

15.1.2 HOP-Rec 模型

尽管基于因子分解的模型隐式地推断用户对未观测

item的偏好,但是最近的研究表明显式地建模此类潜在偏好potential preference可以提高推荐系统的性能。受到因子分解模型和图模型的启发,我们提出了HOP-Rec。这是一个统一的框架:HOP-Rec在给定的user-item交互矩阵中捕获高阶偏好信息。HOP-Rec通过在相应的交互图上使用随机游走来扩展scale到大规模的真实世界数据集。

HOP-Rec的目标函数定义为:其中:

- 表示从随机游走序列 中采样

item的k阶概率分布(即前面定义的 )。 - 表示从所有

item的集合中采样item的均匀分布。 - 表示在我们的方法中建模的最大阶数。

上述物理含义是:以概率 随机采样 的

k阶邻居item作为正样本、以均匀随机采样item作为负样本,然后对它们的pairwise loss进行衰减降权(由 指定衰减因子)。注意:每个正样本采样 个负样本, 为超参数。从另一个角度来看,我们通过从

user-item交互中推断高阶邻近性来丰富最初的稀疏图。它的本质是:数据集增强技术。即利用二部图来增强正样本(同时对每个正样本负采样 个负样本),另外对增强的样本赋予一个小于

1的权重。- 表示从随机游走序列 中采样

HOP-Rec方法背后的主要思想是:通过随机游走来近似高阶概率矩阵分解,其中随机游走具有一个置信权重confidence weighting的衰减因子, 。引入置信度加权参数 来区分不同邻近性之间的强度。具体而言,我们选择 作为衰减因子。注意,我们没有通过矩阵运算直接分解转移概率矩阵矩阵,这对于大规模数据集是不可行的。而随机游走近似矩阵分解已经被证明是有效和准确的。

通过这种方式,我们不仅通过引入高阶偏好信息来平滑观察的

item和未观察的item之间的严格边界(“非此即彼”的边界),而且使得我们的方法可以扩展到大规模的现实世界数据集。具体而言,我们首先引入随机游走从而为每个用户 在交互图上探索。给定从 开始的随机游走序列 ,我们采样用户 的

k阶潜在偏好的item(即用户 的k阶邻居item)。此外,在现实世界的数据集中,用户集合 和

item集合 的degree分布通常呈现幂律分布power-law distribution。如果我们使用均匀采样,那么大多数采样路径都是低degree的用户顶点和item顶点。考虑到这一点,我们在随机游走过程中使用了degree采样,即:对于随机游走采样的每一个step,我们分别以正比于deg(u)的概率对用户 采样、以正比于deg(i)的概率对item采样。如何采样正样本很关键,不同的采样方式产生不同的结果。

我们定义 函数为:

其中:

- 为示性函数,当条件

B为真时返回1、为假时返回0。上式中仅当 才考虑损失(即负样本的偏好分更高)。 - 为阶数相关的阈值参数,设置为 。这是因为阶数越高, 和 的偏好分越低,则阈值也需要越小。

注意,

item是从所有item的集合中均匀采样的,因为我们对用户不喜欢的item采用假设的均匀分布 。这个假设是合理的,因为在很多真实场景中,对每个用户来讲,喜欢的item(观察到的item)通常远远少于不喜欢的item(未观察到的item)。- 为示性函数,当条件

HOP-Rec模型的目标函数可以通过异步随机梯度下降asynchronous stochastic gradient descent: ASGD来优化。

15.2 实验

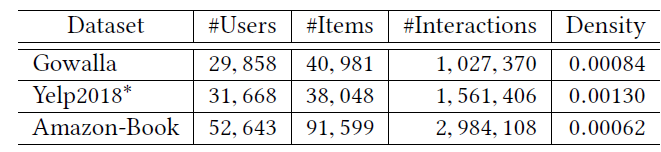

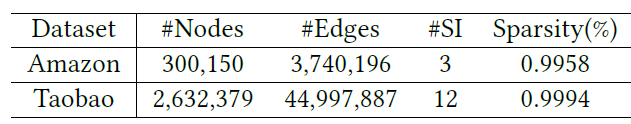

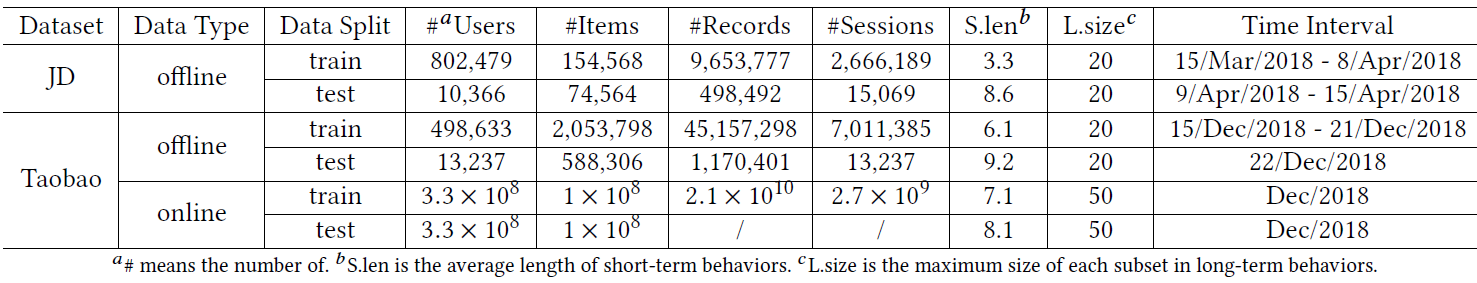

数据集:为了验证

HOP-Rec的能力和可扩展性,我们在四个公共数据集上进行了实验,这些数据集在领域domain、规模、稀疏性方面各不相同,如下表所示。对于每个数据集,我们丢弃那些交互少于

5个的用户和item。此外,我们对每个数据集的交互记录进行预处理,从而模拟用户的隐式二元反馈:- 对于包含显式评分记录的

Amazon-book和MovieLens数据集,我们将所有>=4分的评分记录转换为label = 1、将<4分的评分记录转换为label = 0。 - 对于

CiteUlike数据集,不进行任何转换,因为它本身就是一个二元偏好数据集。

- 对于包含显式评分记录的

baseline方法:矩阵分解

Matrix Factorization: MF:MF是一种成熟且常用的user-item推荐技术。在实验中我们使用implicit library,它用交替最小二乘法alternating least-square: ALS实现了MF。贝叶斯个性化排序

Bayesian Personalized Ranking: BPR:BPR扩展了MF的pointwise方法,并引入pairwise ranking loss来进行个性化推荐。Weighted Approximate-Rank Pairwise: WARP损失:WARP是一种有效估计排序函数的近似方法,其主要思想是根据它们在排序列表中的位置来加权pairwise违规violation。K-Order Statistic: K-OS损失:K-OS通过在优化过程中考虑正样本集合来扩展WARP,其中K表示考虑的正样本数量。注意,当K=1时K-OS退化为WARP。对于

BPR, WARP, K-OS三种方法,我们使用lightfm library进行实验。Popularity-based Re-ranking: RP3(β):该方法作为各种graph-based方法的一个强基线。该方法通过调节热门item的权重重新加权ranking score,这个ranking score是基于随机游走而得到。该方法的评估时用原始作者提供的library进行的。

实验配置:

- 对于

top-N推荐,我们使用了以下三个常见的评估指标:precision@N、recall@N、MAP@N。 - 对于每个数据集,我们将二元交互矩阵随机分为两个部分:

80%作为训练集、20%作为测试集。报告的性能取20次实验的测试集均值。 - 所有基于分解的方法以及提出的

HOP-Rec都使用两个潜在因子的内积作为评分函数。 - 除了

RP3(β)这种以转移概率为排序分的纯图方法之外,其它方法的潜在因子 的维度固定为120。除了 之外,所有其它超参数都是在第一次评估时使用网格搜索和测试集基于MAP来选择。 - 对于

HOP-Rec,我们搜索了从1 ~3的最佳阶数K,以及针对不同规模数据集的采样倍数N(对于CiteUlike/MovieLens- 1M/MovieLens-20M/Amazon-Book数据集,最佳采样倍数分别为90/60/300/800)。 - 对于

HOP-Rec, 都是在 范围内随机均匀初始化,并且 。

- 对于

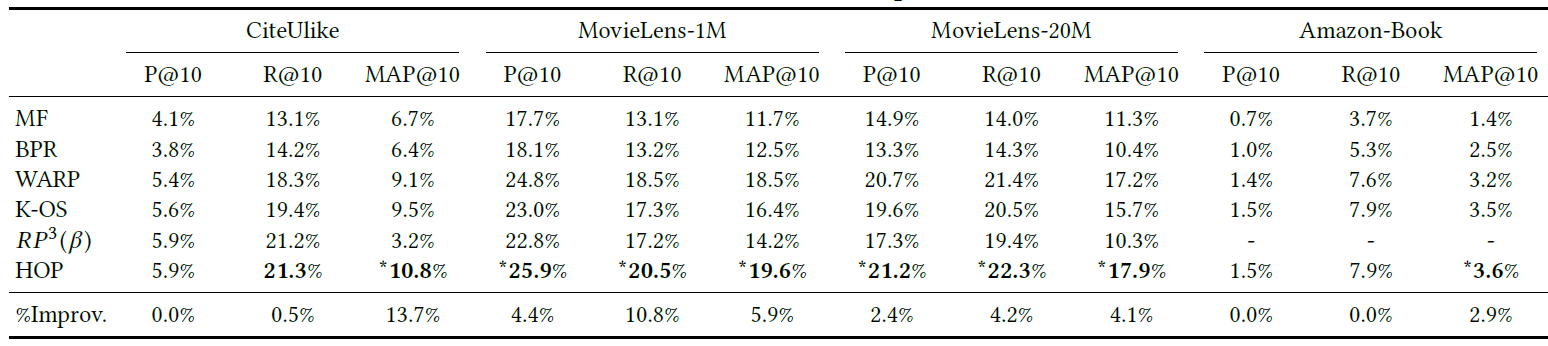

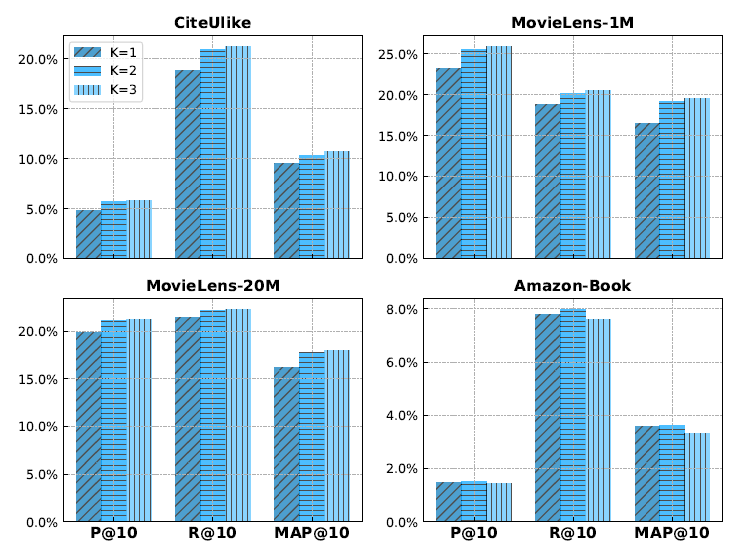

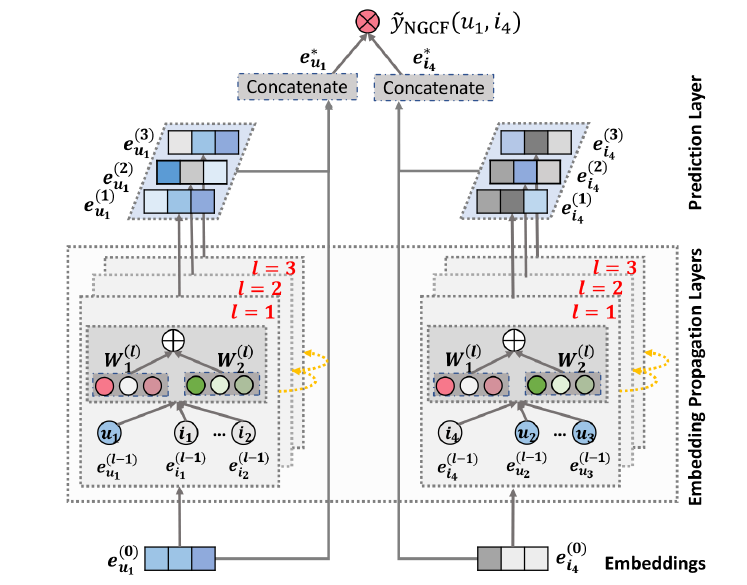

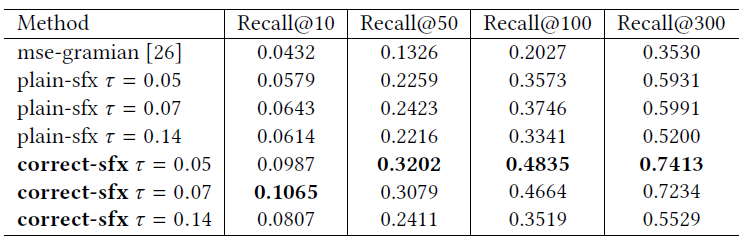

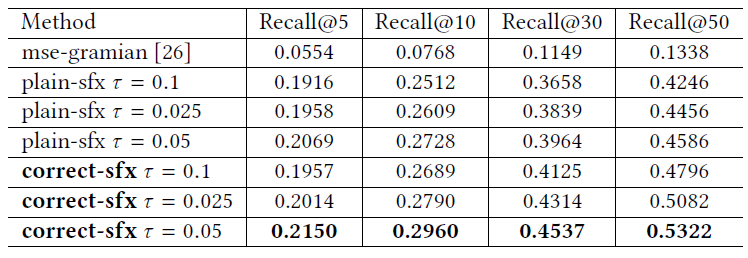

HOP-Rec和其它五种baseline方法的性能比较如下表所示,其中:*表示相对于所有baseline方法在 (成对t检验)时的统计显著性;%Improv表示相对于最佳baseline的性能提升比例。注意,原始library的资源限制阻碍了我们在Amazon-Book上进行PR3(β)实验。可以看到:

WARP,K-OS,PR3(β)是很强的baseline方法,因为它们和其它两种方法MF,BPR之间存在显著的性能差距。HOP-Rec通常产生优于或者相当与五种baseline方法的性能。

为进一步检查

HOP-Rec中建模高阶邻近性的有效性,我们评估了关于参数K的性能,结果如下图所示。可以看到:融合高阶邻近性可以提升HOP-Rec的性能,但是对于最大的数据集Amazon-Book,当K=3时性能下降。

十六、NCF[2017]

在信息爆炸的时代,推荐系统在缓解信息过载

information overload方面发挥着举足轻重的作用,并且已经被许多在线服务广泛采用,包括电商、在线新闻、社交媒体网站。个性化推荐系统的关键在于根据用户历史交互(例如评分、点击)对user-item的偏好进行建模,这就是所谓的协同过滤collaborative filtering。在各种协同过滤技术中,矩阵分解

matrix factorization: MF是最流行的一种,它将用户和item投影到共享的潜在空间latent space中,使用潜在特征向量来表示用户和item。此后,用户对item的交互被建模为它们潜在向量latent vector的内积。通过Netflix Prize的推广,MF已经成为基于潜在因子模型latent factor model-based的推荐的事实上的方法。许多研究工作致力于增强

MF,例如将其与基于邻域的模型neighbor-based model相结合、将其与item内容的主题模型topic model相结合、将其扩展到分解机factorization machine从而进行特征的通用建模。尽管

MF对于协同过滤很有效,但是众所周知,它的性能可能会受到简单选择“内积” 作为交互函数的阻碍。例如,对于基于显式反馈的评分预测任务,众所周知,可以通过将user bias项和item bias项添加到交互函数中从而提高MF模型的性能。虽然这对于内积算子而言似乎只是一个微不足道的调整,但是它指出了设计一个更好的、专用的交互函数来建模用户和item之间潜在特征交互的积极效果。内积算子,它仅仅简单地线性组合多个潜在特征latent feature的乘法,可能不足以捕获用户交互数据的复杂结构。在论文

《Neural Collaborative Filtering》中,作者探讨了使用深度神经网络从数据中学习交互函数,而不是像以前许多工作那样人工设计交互函数。神经网络已经被证明能够逼近任何连续函数,而且最近发现神经网络deep neural networks: DNNs在多个领域都有效 ,从计算机视觉、语音识别到文本处理。然而,与大量关于MF方法的文献相比,使用DNN进行推荐的工作相对较少。尽管最近的一些进展已经将DNN应用于推荐任务并显示出有希望的结果,但是它们主要使用DNN来建模辅助信息auxiliary information,例如item的文本描述、音乐的音频特征、图像的视觉特征。在建模关键的协同过滤效果方面,他们仍然采用MF,使用内积来结合用户潜在特征和item潜在特征。论文通过形式化formalize用于协同过滤的神经网络建模方法来解决上述研究问题(利用神经网络来建模交互函数)。通过采用可以从数据中学习任意函数的神经网络架构代替内积,论文提出了一个名为Neural Network-based Collaborative Filtering: NCF的通用框架。论文聚焦于隐式反馈

implicit feedback,隐式反馈通过视频观看、商品购买、item点击等行为间接反映了用户的偏好。和显式反馈explicit feedback(即显式评分rating和评论review)相比,隐式反馈可以自动跟踪,因此更容易被内容提供商content provider所收集。然而,隐式反馈的使用更具有挑战性,因为无法观察到用户满意度user satisfaction,并且负反馈negative feedback天然的稀疏性。在本文中,作者探讨了如何利用DNN对包含噪音的隐式反馈信号进行建模。论文的主要贡献:

- 论文提出了一个神经网络架构来对用户和

item的潜在特征进行建模,并设计了一个基于神经网络的协同过滤通用框架NCF。 - 论文表明:

MF可以被解释为NCF的特殊情况,并利用多层感知机赋予NCF模型高度的非线性。 - 论文在两个真实数据集上进行了大量的实验,从而证明

NCF方法的有效性,以及深度学习在协同过滤方面的前景。

- 论文提出了一个神经网络架构来对用户和

相关工作:

隐式反馈:虽然关于推荐的早期文献主要集中在显式反馈,但最近人们越来越关注隐式数据。具有隐式反馈的协同过滤

collaborative filtering: CF任务通常被形式化为item推荐问题,其目的是向用户推荐一个简短的item列表。和显式反馈工作广泛解决的评分预测相比,解决item推荐问题更实用但更具有挑战性。一个关键的洞察insight是对缺失数据进行建模,而这些缺失数据总是被显式反馈的工作所忽略。为了使用隐式反馈为

item推荐定制tailor潜在因子模型,早期工作应用了两种均匀加权策略:将所有缺失数据视为负样本,或者从缺失数据中均匀采样负样本。最近,《Fast matrix factorization for online recommendation with implicit feedback》和《Modeling user exposure in recommendation》提出了专门的模型来对缺失数据进行加权。《A generic coordinate descent framework for learning from implicit feedback》为基于特征的分解模型开发了一种隐式坐标下降implicit coordinate descent: iCD解决方案,实现了state-of-the-art的item推荐性能。基于神经网络的推荐:早期先驱工作

《Restricted boltzmann machines for collaborative filtering》提出了一种两层受限玻尔兹曼机Restricted Boltzmann Machine: RBM来建模用户对item的显式评分。《Ordinal boltzmann machines for collaborative filtering》扩展了该工作从而对评分的保序性质ordinal nature进行建模。最近,自编码器已经成为构建推荐系统的流行选择。

《Autorec: Autoencoders meet collaborative filtering》提出了基于用户的AutoRec,其思想是学习隐藏的结构hidden structure,这些结构可以根据用户的历史评分作为输入从而重构用户的评分。在用户个性化方面,该方法与item-item模型(将用户表示为他/她的历史评分item)具有相似的精神。为了避免自编码器学习恒等函数

identity function从而无法泛化到未见unseen的数据,降噪自编码器denoising autoencoder: DAE应用于从故意损坏的输入中学习。最近

《A neural autoregressive approach to collaborative fi ltering》提出了一种用于CF的神经自回归方法。虽然这些工作为神经网络解决

CF的有效性提供了支持,但是其中大多数都专注于显式评分,并仅对观察到的数据进行建模。结果,对于从只有正样本的隐式数据中学习的任务,它们很容易失败。神经网络用于隐式反馈的推荐:最近的一些工作探索了基于隐式反馈的深度学习模型来进行推荐,但是他们主要使用

DNN对辅助信息进行建模,例如item的文本描述、音乐的声学特征、用户的跨域行为、以及知识库中的丰富信息。然后,将DNN学到的特征与用于协同过滤的MF集成。与我们的工作最相关的工作是

《Collaborative denoising auto-encoders for top-n recommender systems》,它为CF提供了一个带有隐式反馈的协同降噪自编码器collaborative denoising autoencoder: CDAE。 和DAE-based CF相比,CDAE额外地将一个用户节点插入到自编码器的输入中从而重建用户的评分。如作者所示,当应用恒等映射作为CDAE的隐层激活函数时,CDAE等效于SVD++模型。这意味着虽然CDAE是一种用于CF的神经网络建模方法,但是它仍然应用线性核linear kernel(即内积)来对user-item交互进行建模。这可以部分解释为什么CDAE使用更深的层不会提高性能。与

CDAE不同,我们的NCF采用双路架构,使用多层前馈神经网络对user-item交互进行建模。这允许NCF从数据中学习任意函数,比固定的内积函数更强大、更具表达能力。其它工作:沿着类似的路线,在知识图谱文献中已经深入研究了学习两个实体之间的关系。已有很多关系型机器学习

relational machine learning method方法被提出。与我们的方法最相似的一个是神经张量网络Neural Tensor Network: NTN,它使用神经网络来学习两个实体的交互并展示层强大的性能。在这里,我们关注协同过滤的不同problem setting。虽然将MF和MLP相结合的NeuMF的思想部分受到NTN的启发,但是在允许MF和MLP学习不同的embedding集合方面,我们的NeuMF比NTN更灵活、更通用。最近,谷歌公布了他们用于

App推荐的Wide & Deep方法。Deep组件同样在特征embedding之上使用MLP,据报道它具有很强的泛化能力。虽然他们的工作重点是结合用户和item的各种特征,但是我们的目标是探索纯协同过滤系统的DNN。我们表明,DNN是对user-item交互建模的一个很有前景的选择。据我们所知,以前从未有工作对此进行研究过。

16.1 模型

16.1.1 基本概念

我们首先将问题形式化并讨论现有的带隐式反馈的协同过滤解决方案。然后我们简短地概括了广泛使用的

MF模型,并强调其内积造成的局限性。从隐式数据中学习

Learning from Implicit Data:令 表示用户数量、 表示item数量。定义从用户隐式反馈implicit feedback得到的user-item交互矩阵 为:注意:

- 表示用户 和

item之间存在交互,然而这并不意味着用户 真的喜欢item。 - 表示用户 和

item之间不存在交互,这也并不意味着用户 真的不喜欢item,可能是因为用户 没注意到item。

这给从隐式数据中学习带来了挑战,因为隐式数据仅提供了关于用户偏好

users' preference的带噪音的信号noisy signals。虽然观察到的item至少反映了用户对item的兴趣,但是未观察到的item可能只是缺失的数据missing data,并且天然natural缺乏负反馈negative feedback。带隐式反馈的推荐问题被表述为估计 中未观察到的

item的得分score的问题,其中这些score用于对item进行排序。model-based方法假设数据可以由底层模型生成(或描述)。形式上, 模型可以抽象为学习:其中:

- 表示对交互 的预估分

predicted score。 - 表示模型参数; 表示将模型参数映射到预估分的函数,我们称之为交互函数

interaction function。

为了估计参数 ,现有方法通常遵循优化目标函数的机器学习范式。文献中最常用的目标函数有两种:

point-wise loss和pair-wise loss。- 作为显式反馈

explicit feedback大量工作的自然延伸,point-wise loss通常定义为最小化 和目标值 之间的平方损失。为了处理negative data的缺失,他们要么将所有未观察到的item视为负样本、要么从未观察到的item中采样负样本。 pair-wise loss的思想是:观察到的item应该比未观察到的item的排名更高。因此,它不是最小化 和目标值 之间的损失,而是pair-wise learning最大化观察到的item和未观察到的item之间的边距margin。

更进一步地,我们的

NCF框架使用神经网络参数化交互函数 从而估计 。因此,NCF自然支持point-wise learning和pair-wise learning。- 表示用户 和

矩阵分解

Matrix Factorization: MF:MF将每个用户、每个item都和潜在特征向量latent feature vector相关联。令 表示用户 的潜在特征向量, 表示用户 的潜在特征向量。MF估计estimate交互 为 和 的内积:其中 为潜在空间

latent space的维度。正如我们所看到的,

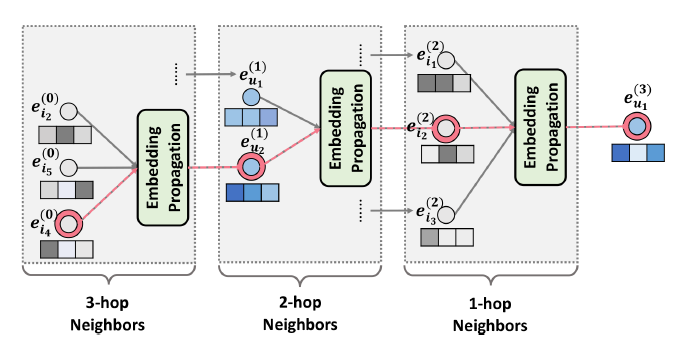

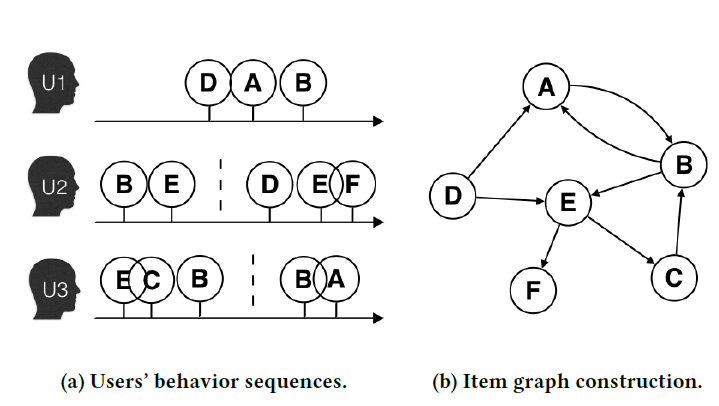

MF对用户潜在因子latent factor和item潜在因子的双向交互two-way interaction进行建模,假设潜在空间的每个维度彼此独立,并以相同的权重线性组合它们。因此,MF可以视为潜在因子的线性模型。下图说明了内积函数如何限制

MF的表达能力。为了更好地理解示例,有两个设置settings需要事先说明。- 首先,因为

MF将用户和item都映射到相同的潜在空间,所以两个用户之间的相似性也可以用内积来衡量(或者它们潜在向量之间的余弦相似度来衡量)。 - 其次,不失一般性,我们使用

Jaccard系数(用户A观察到的item集合与用户B观察到的item集合之间的Jaccard系数)作为MF需要恢复的、两个用户之间的真实相似度ground-truth similarity。

我们首先关注图

(a)中的前三行(用户)。很容易有 。因此, 在潜在空间中的几何关系可以如图(b)所示绘制。现在,让我们考虑一个新的用户 ,其输入如图

(a)中的虚线所示。所以我们有 ,这意味着 最类似于 、其次是 、最后是 。但是,如果MF模型将 放置在最接近 的位置(图(b)中用虚线显示的两个选择),则会导致 更靠近 而不是更靠近 ,而这会导致更大的排序损失ranking loss。这个例子显示了

MF使用简单的、且固定的内积来估计低维潜在空间中复杂的user-item交互的限制。在这个例子中,我们注意到解决该问题的一种方法是使用更大的潜在因子数量 (即更高维的潜在空间)。 然而,这种方法可能会对模型的泛化能力产生不利影响(如,过拟合),尤其是在数据稀疏的环境中。

- 首先,因为

在本文中,我们通过从数据中使用

DNN学习交互函数来解决MF的这个限制。- 我们首先介绍了通用的

NCF框架,详细说明了如何学习NCF的概率模型,该模型强调了隐式数据的二元属性binary property。 - 然后我们证明了

MF可以在NCF下表达和推广。 - 为了探索用于协同过滤的

DNN,我们接着提出NCF的实例化,使用多层感知机multi-layer perceptron: MLP来学习user-item交互函数。 - 最后,我们提出了一个新的神经矩阵分解模型,它在

NCF框架下集成了MF和MLP,从而统一了MF的线性和MLP的优势来建模user-item潜在结构latent structures。

- 我们首先介绍了通用的

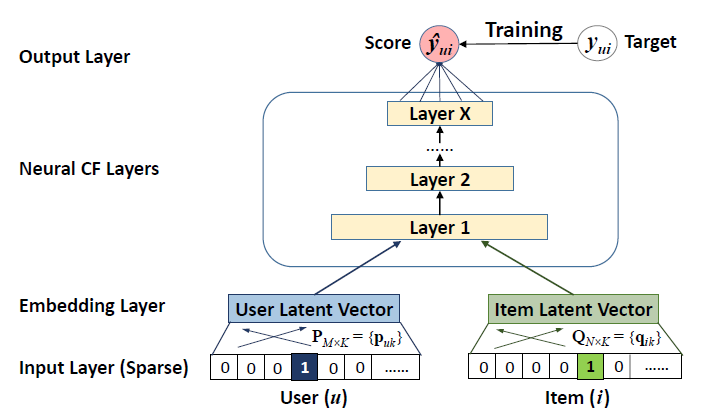

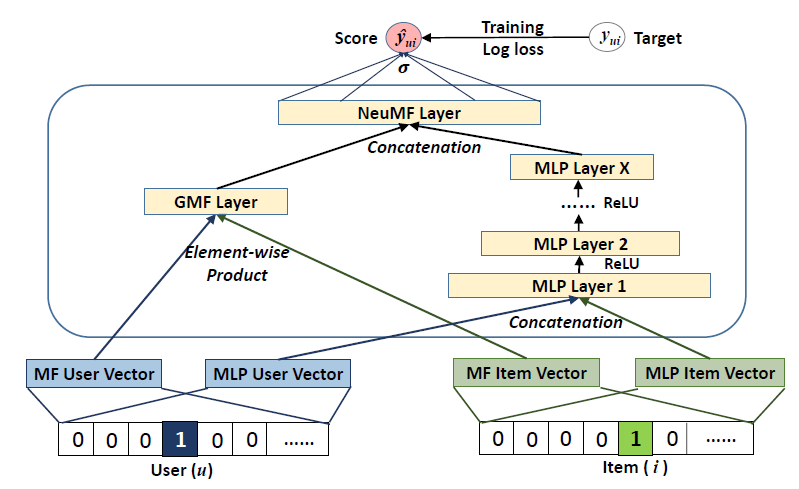

16.1.2 NCF 通用框架

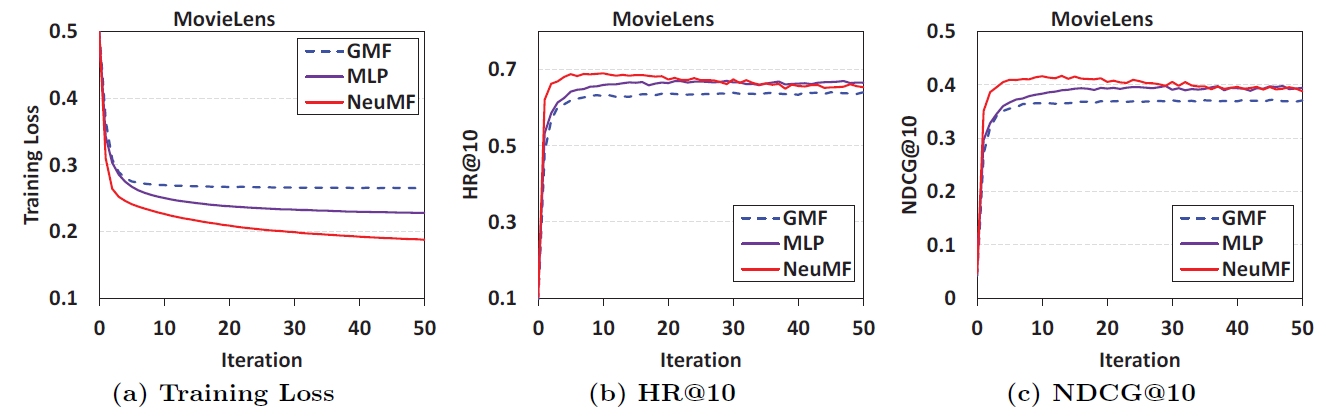

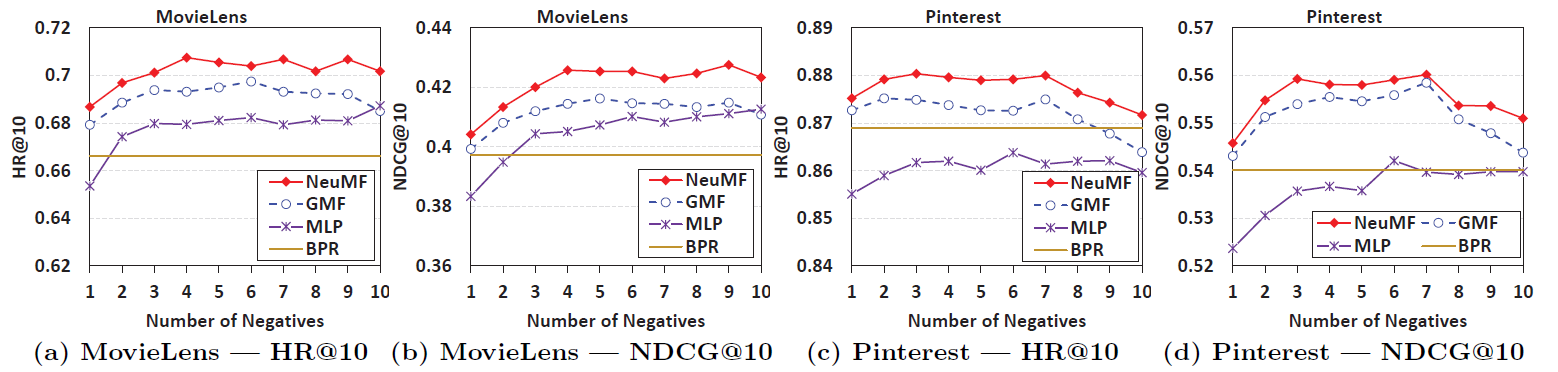

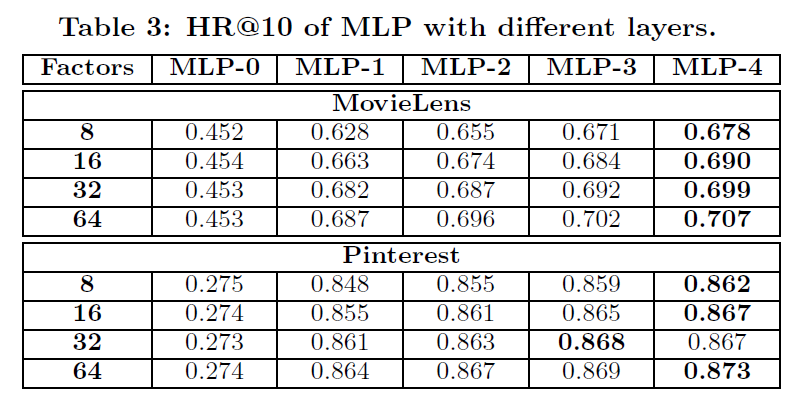

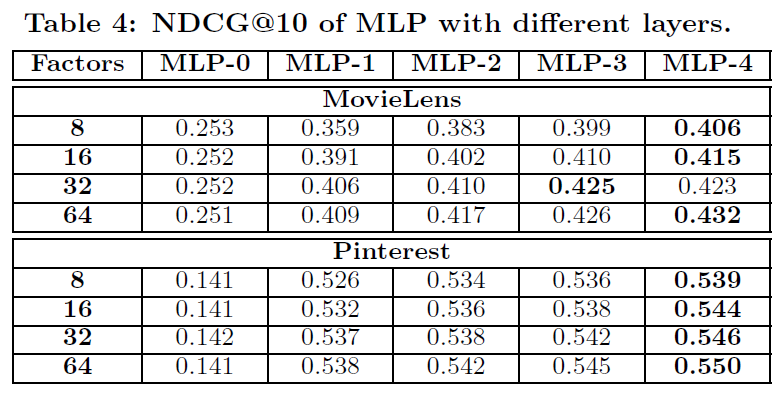

为了允许全