Transformer

一、Transformer[2017]

循环神经网络

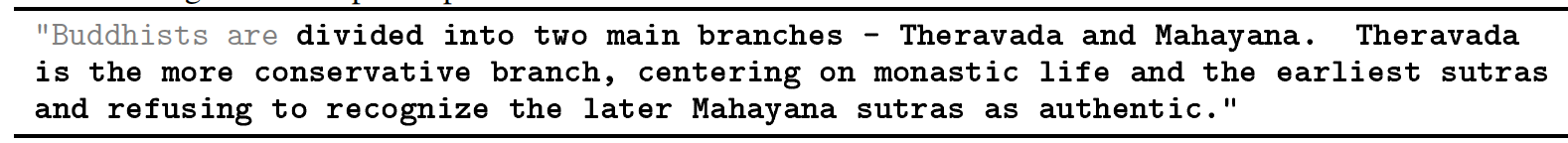

RNN(尤其是LSTM、GRU网络)已经牢牢地被确定为序列建模和转导transduction问题的state-of-the-art方法。此后,许多努力继续推动循环语言模型recurrent language model和encoder-decoder的发展。循环模型通常沿输入序列和输出序列的

symbol position来考虑计算。将position和step在计算期间对齐aligning,这些模型生成一系列hidden statehidden stateinput的函数。这种固有的序列性质sequential nature阻止了训练样本内的并行化,而这种样本内的并行化在更长的序列长度下变得至关重要,因为内存约束限制了样本之间的batching。最近的工作通过分解factorization和条件计算conditional computation显著提高了计算效率,同时在后者的case中(即,条件计算)也提高了模型性能。然而,序列计算sequential computation的基本约束仍然存在。注意力机制已经成为各种任务中引人注目的序列建模和转导模型

sequence modeling and transduction model的组成部分,它允许建模依赖性而无需考虑这些相互依赖的项在input序列或output序列中的距离。然而,除了少数情况之外,这种注意力机制与RNN结合使用。在论文

《Attention Is All You Need》中,作者提出了Transformer,这是一种避免循环recurrence的模型架构。Transformer完全依赖注意力机制来抽取input和output之间的全局依赖关系。Transformer可以实现更高的并行化,并且在八个P100 GPU上经过短短12个小时的训练后就可以在翻译质量方面达到新的state-of-the-art。背景:

减少序列计算这一目标也构成了

Extended Neural GPU、ByteNet、ConvS2S的基础,它们都使用卷积神经网络作为基础构建块basic building block,并行地为所有input position和output position来计算hidden representation。在这些模型中,联系relate来自两个任意input position或output position的信号所需操作的数量,随着position之间的距离而增加:对于ConvS2S呈线性增加,而对于ByteNet则呈对数增加。这使得学习远距离位置之间的依赖性变得更加困难。在

Transformer,这种数量被降低到常数级(effective resolution为代价(由于attention-weighted加权平均 ),但是我们使用多头注意力Multi-Head Attention来抵消这种影响。自注意力

self-attention(有时被称作intra-attention)是一种将单个序列的不同位置关联起来从而计算序列的representation的注意力机制。自注意力已经成功应用于各种任务,包括阅读理解reading comprehension、抽象摘要abstractive summarization、文本蕴含textual entailment、学习任务无关的sentence representation。端到端记忆网络

memory network基于循环注意力机制recurrent attention mechanism而不是序列对齐循环sequence-aligned recurrence,并且已被证明在简单的语言问题和语言建模任务中表现良好。

然而,据我们所知,

Transformer是第一个完全依赖自注意力来计算其input和output的representation而不使用sequence-aligned RNN或卷积的模型。在接下来部分中,我们将描述Transformer、自注意力的启发,并讨论它相对于《Neural GPUs learn algorithms》、《Neural machine translation in linear time》、《Structured attention networks》等模型的优势。

1.1 模型

1.1.1 模型架构

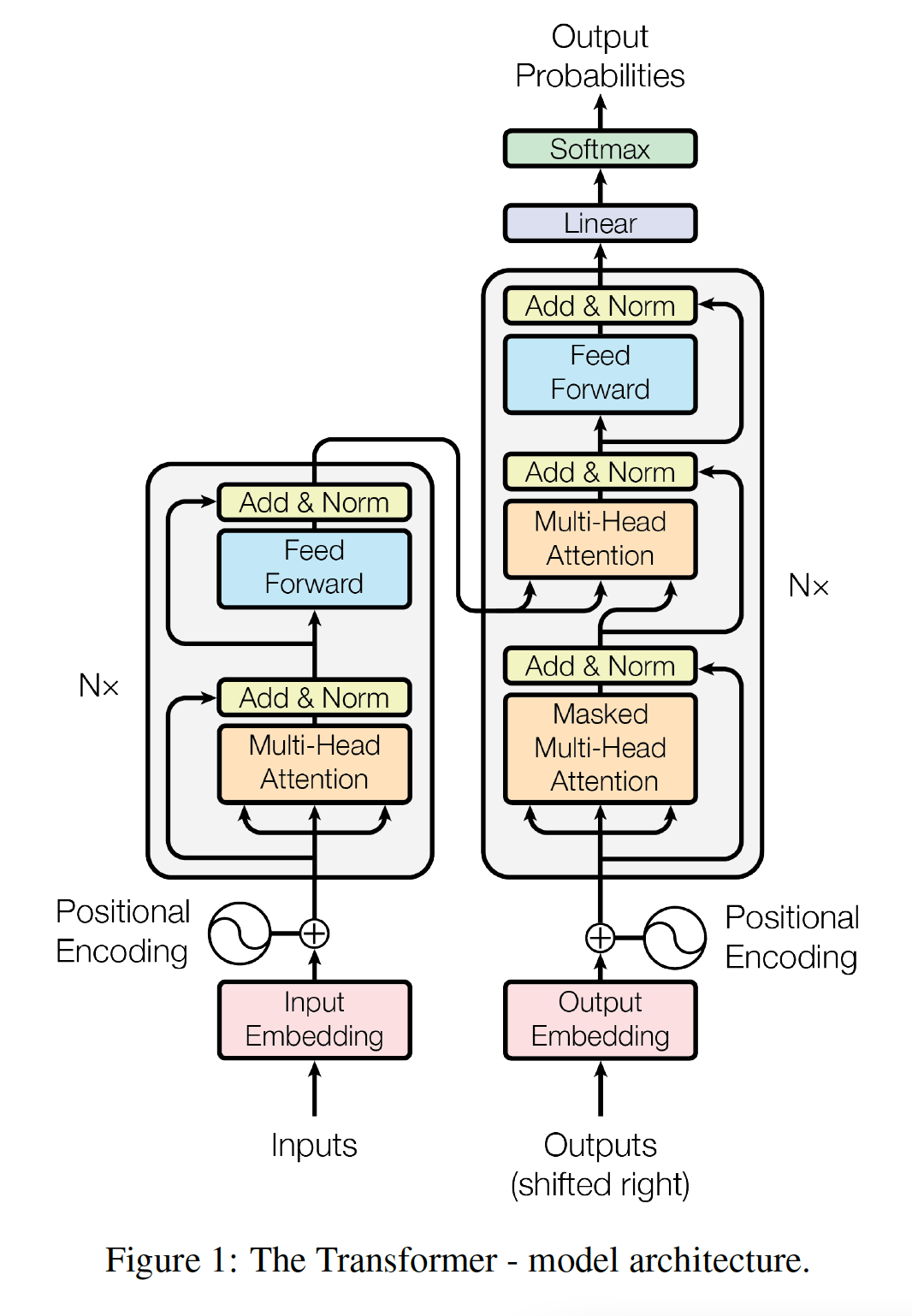

大多数有竞争力的神经序列转导模型

neural sequence transduction model具有encoder-decoder结构。这里,encoder将symbol representation的输入序列continuous representation的序列symbol representation(one-hot向量),hidden representation。 给定decoder然后生成symbol的一个输出序列symbol representation(one-hot向量)。在每个step,模型都是自回归auto-regressive的,在生成下一个输出symbol时使用所有前面生成的symbol作为额外的输入。Transformer遵循这种整体架构,同时为encoder和decoder使用堆叠的self-attention的和point-wise的全连接层,分别如下图的左半部分和有半部分所示。下图中的

attention的三个输入中,最右侧为query而其它两个输入分别为key,value。注意,key的数量和value的数量相等。

Encoder:encoder由multi-head self-attention mechanism, 第二个子层是简单的、position-wise的全连接前馈神经网络。我们在两个子层中的每个子层周围使用残差连接residual connection,然后进行layer normalization。即,每个子层的输出为:其中:

为了有助于这些残差连接,模型中的所有子层以及

embedding layer都会产生维度注意,图中黄色框内的标注是

Add & Norm,即Add在前、Norm在后,也就是LayerNorm作用在残差连接之后。Decoder:decoder也是由decoder的每个层包含三个子层,其中有两个子层与encoder子层相同,而第三个子层对encoder stack的输出执行multi-head attention。与

encoder类似,我们在每个子层周围使用残差连接,然后进行layer normalization。我们还修改了decoder stack中的self-attention子层,从而防止它关注后续的position(即,masked self-attention)。这种masking确保对position

1.1.2 Attention

注意力函数可以描述为:将一个

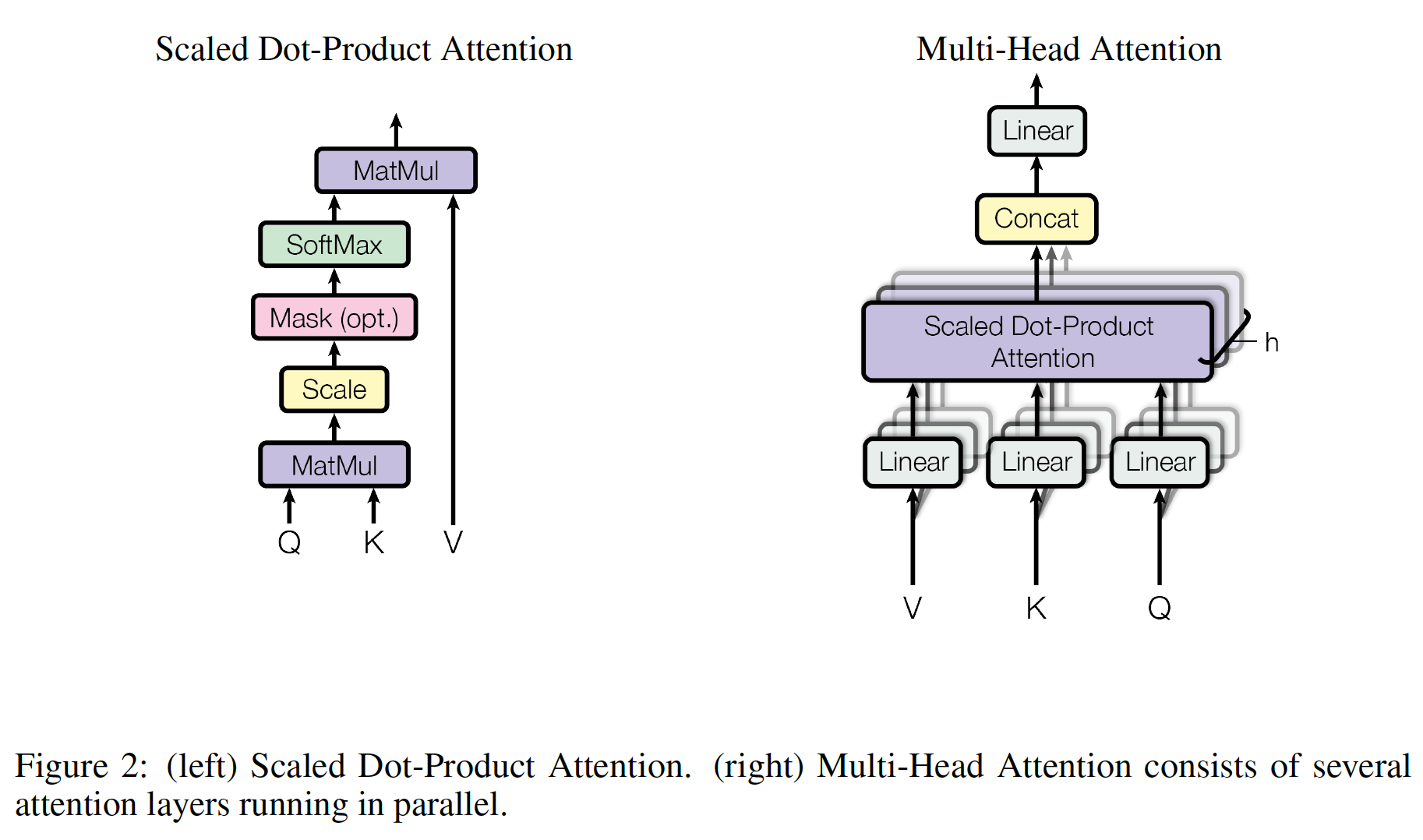

query和一组key-value pair映射到output,其中query, key, value, output都是向量。output被计算为value的加权和,其中每个value的权重是由一个函数来计算(即,注意力函数),该函数以query, key作为输入。Scaled Dot-Product Attention:我们称我们提出的注意力为Scaled Dot-Product Attention,如下图所示。输入由三部分组成:维度为query、维度为key、维度为value。我们将单个query和所有的key计算内积,然后内积的结果除以softmax函数从而获得value的权重。这里要求

query向量的维度和key向量的维度相同,都是在实践中,我们同时计算一组

query的注意力函数,其中将query打包到一个矩阵key和value也被打包到矩阵output矩阵计算为:假设有

query、key、value(要求key的数量和value的数量相同),则:两种最常见的注意力函数为:加性注意力

additive attention、内积注意力dot-product (multiplicative) attention。内积注意力与我们的算法相同,除了我们使用了

因为维度越大,则内积中累加和的项越多,内积结果越大。很大的数值会导致

softmax函数位于饱和区间,梯度几乎为零。加性注意力通过具有单隐层的前馈神经网络来计算注意力函数。

additive attention(也称作Bahdanau Attention) 的原理为:其中:

attention向量,为待学习的参数,query,key,value。query向量映射到公共空间,key向量映射到公共空间,因此query向量和key向量可以为不同的维度。它们都是待学习的权重。query在各个position的注意力权重,position的数量为

虽然这两种注意力在理论上的复杂度相同,但是内积注意力在实践中更快且更节省内存空间,因为它可以使用高度优化的矩阵乘法代码来实现。

Multi-Head Attention:与执行单个注意力函数attention function(具有query, key, value)不同,我们发现将query, key, value线性投影query, key, value分别投影到然后,在每个

query, key, value的投影后的版本上,我们并行执行注意力函数,每个注意力函数产生output。这些output被拼接起来并再次投影,产生final output,如上图右侧所示。多头注意力

multi-head attention允许模型在每个position联合地关注jointly attend来自不同representation子空间的信息。如果只有单个注意力头single attention head,那么平均操作会抑制这一点。其中待学习的投影矩阵为:

在这项工作中,我们使用

attention head。对于其中每个注意力头,我们使用head的维度减小,因此总的计算成本与完整维度的单头注意力single-head attention相近。注意力在

Transformer中的应用:Transformer以三种不同的方式使用多头注意力:- 在

encoder-decoder attention层中,query来自于前一个decoder layer,key和value来自于encoder的输出。这允许decoder中的每个位置关注input序列中的所有位置。这模仿了sequence-to-sequence模型中典型的encoder-decoder attention注意力机制。 encoder包含自注意力层。在自注意力层中,所有的query, key, value都来自于同一个地方(在这个case中,就是encoder中前一层的输出)。encoder中的每个位置都可以关注encoder上一层中的所有位置。- 类似地,

decoder中的自注意力层允许decoder中的每个位置关注decoder中截至到当前为止(包含当前位置)的所有位置。我们需要防止decoder中的信息向左流动,从而保持自回归特性。我们通过在scaled dot-product attention内部屏蔽掉softmax input的某些value来实现这一点(将这些value设置为value对应于无效连接illegal connection。

- 在

1.1.3 Position-wise Feed-Forward Networks

除了注意力子层之外,我们的

encoder和decoder中的每一层还包含一个全连接的前馈神经网络,该网络分别且相同地应用于每个位置。该网络包含两个线性变换,中间有一个ReLU激活函数:虽然线性变换在不同位置上是共享的(即,相同的参数),但是它们在层与层之间使用不同的参数。

该层的另一种描述是:

kernel size = 1的两个卷积,其中input和output的维度为representation维度先增大再减小。

1.1.4 Embeddings and Softmax

与其它序列转导模型类似,我们使用学到的

embedding将input token和output token转换为维度softmax函数将decoder output转换为next-token的预测概率。在我们的模型中,我们在两个

embedding layer(输入层)和pre-softmax线性变换(输出层)之间(共计三个权重矩阵)共享相同的权重矩阵,类似于《Using the output embedding to improve language models》。在embedding层中,我们将这些权重乘以这里有两个输入层,分别来自于

encoder input和decoder input。而输出层来自于decoder。三个

embedding矩阵共享的前提是:input symbol空间和output symbol空间是相同的,例如,输入是中文的文本,输出是中文摘要,那么input symbol和output symbol都是中文单词。否则,encoder的embedding矩阵无法和decoder的 两个embedding矩阵共享。但是无论如何,decoder的两个embedding矩阵之间可以共享。为什么要把

embedding矩阵乘以embedding使得它的量级和positional embedding的量级相同。可以通过实验来验证。

1.1.5 position embedding

由于我们的模型不包含递归和卷积,为了让模型利用序列的次序

order,我们必须注入一些关于序列中token的相对位置或绝对位置的信息。为此,我们在encoder stack和decoder stack底部的input embedding中添加了positional encoding。positional encoding与embedding具有相同的维度positional encoding有很多选择,可以选择固定的也可以选择可学习的。这里我们选择固定的方式,采用不同频率的正弦函数和余弦函数:

其中:

position,positional encoding的每个维度对应于一个正弦曲线,正弦曲线的波长从我们选择这个函数是因为我们假设它可以让模型通过相对位置来轻松地学习关注

attend,因为对于任意固定的偏移量我们还尝试使用可学习的

positional embedding,发现这两个版本产生了几乎相同的结果。我们选择了正弦版本,因为它可以让模型推断出比训练期间遇到的序列长度更长的序列。正弦版本的

positional embedding可以应用到训练期间unseen的位置,而可学习的positional embedding无法实现这一功能。

1.1.6 Why Self-Attention

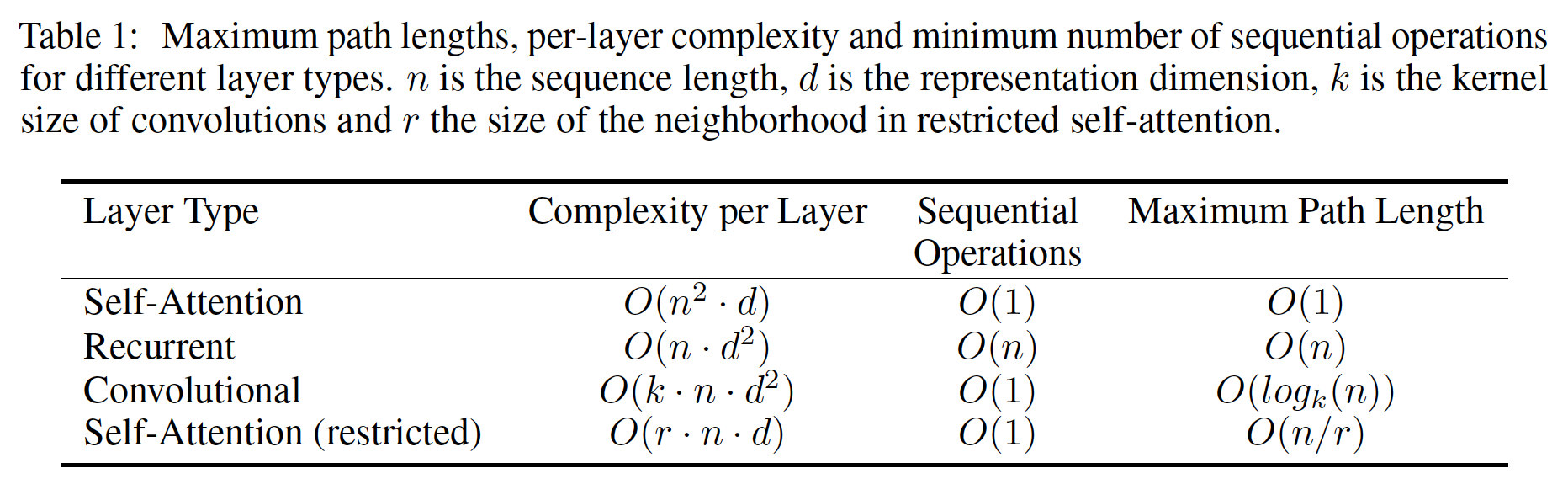

这里我们将自注意力层与循环层、卷积层进行各个方面的比较。这些层通常用于将一个可变长度的

symbol representation序列long-range dependency的路径长度。学习远程依赖是许多序列转导任务中的关键挑战。影响学习这种依赖的能力的一个关键因素是:前向传播信号和反向传播信号必须在网络中传输的路径长度。

input序列和output序列中任意位置组合之间的路径越短,那么就越容易学习远程依赖。因此,我们还比较了由不同类型的层组成的网络中,任意input位置和output位置之间的最大路径长度。如下表所示:

自注意力层在所有位置都关联一个

并行化指的是:为了计算指定位置的输出,模型需要依赖已经产生的多少个输出?

在计算复杂度方面,当序列长度

representation维度state-of-the-art模型常见的case),self-attention层比循环层更快。为了提高涉及非常长序列(即

具有

kernel widthinput position和output position组成的所有的pair。如果希望连接所有的input position和output position,则需要堆叠contiguous kernel) 或dilated convolution),并且增加了网络中任意两个位置之间最长路径的长度。卷积层通常比循环层更昂贵

expensive(贵point-wise feed-forward layer的组合(这就是我们在Transformer模型中采用的方法)。

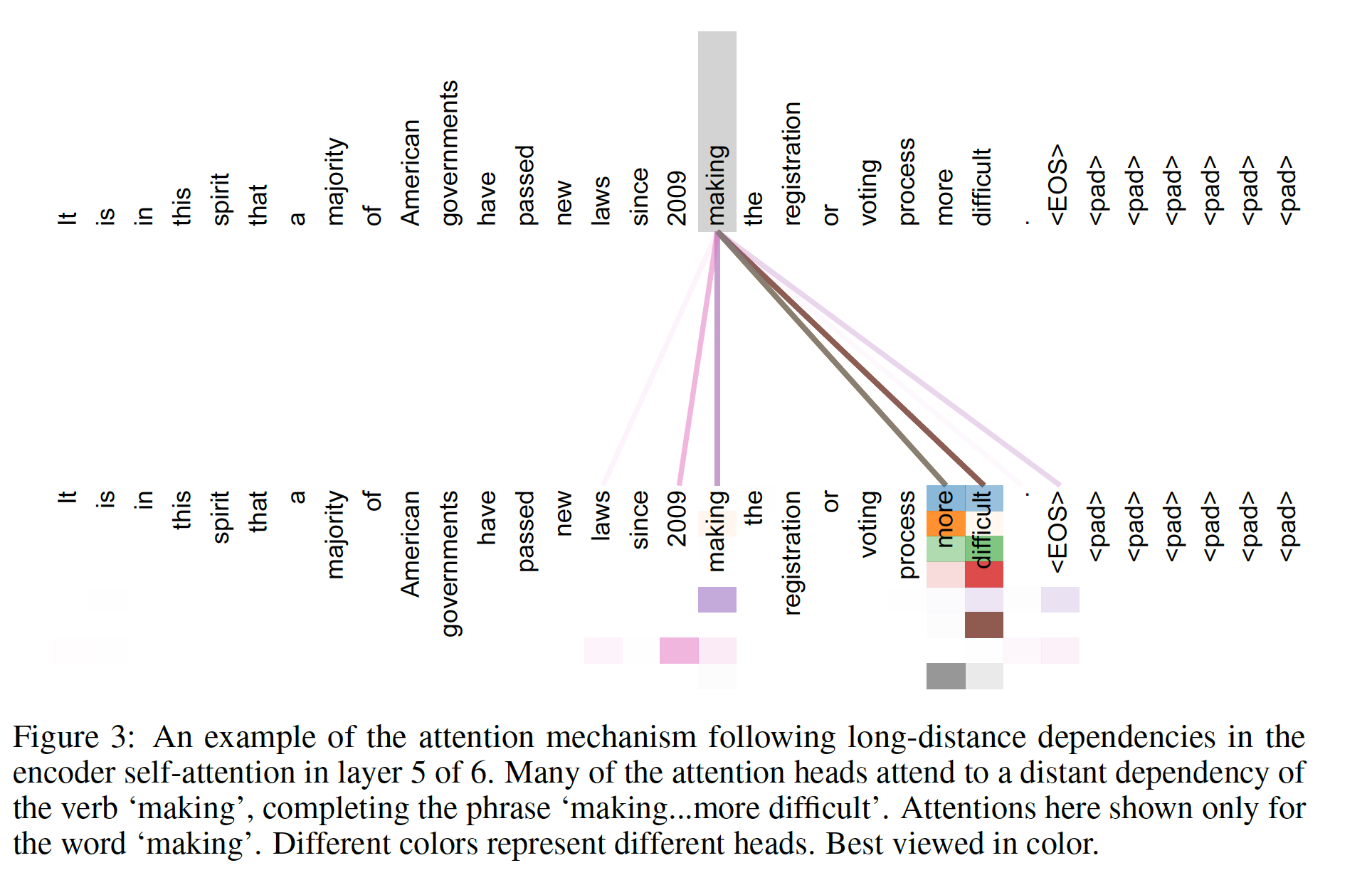

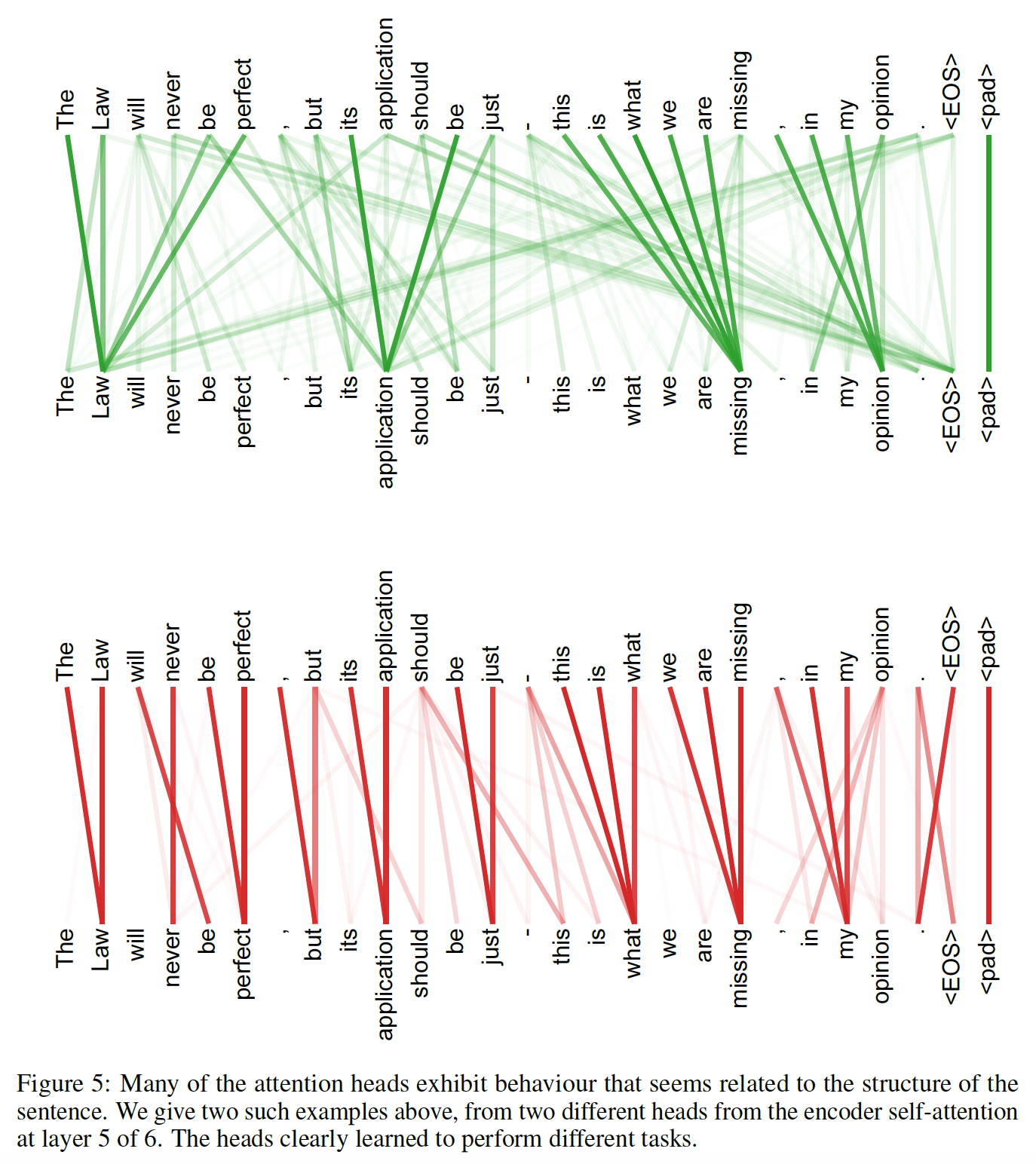

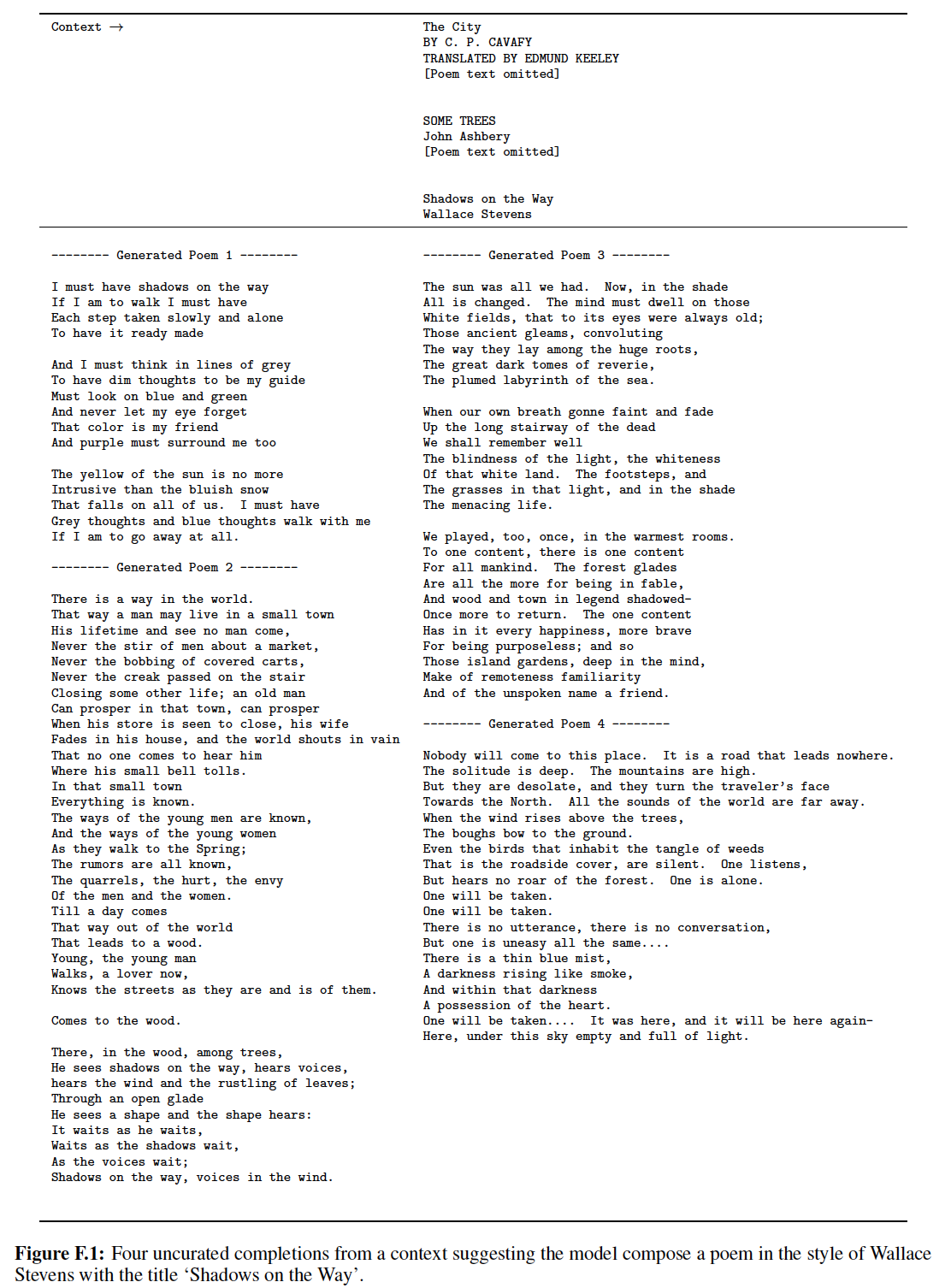

作为附带的好处,自注意力可以产生更可解释的模型。我们从

Transformer模型中检查注意力的分布,并在下图中展示和讨论了示例。不仅单个注意力头清晰地学习执行不同的任务,而且许多注意力头似乎还表现出与句子的句法结构syntactic structure和语义结构semantic structure有关的行为。如下图所示为

encoder六层自注意力层的第五层中,making这个单词的多头自注意力分布(不同的颜色代表不同的头,颜色的深浅代表注意力大小)。making这个单词的自注意力分布似乎倾向于构成短语making ... more difficult。

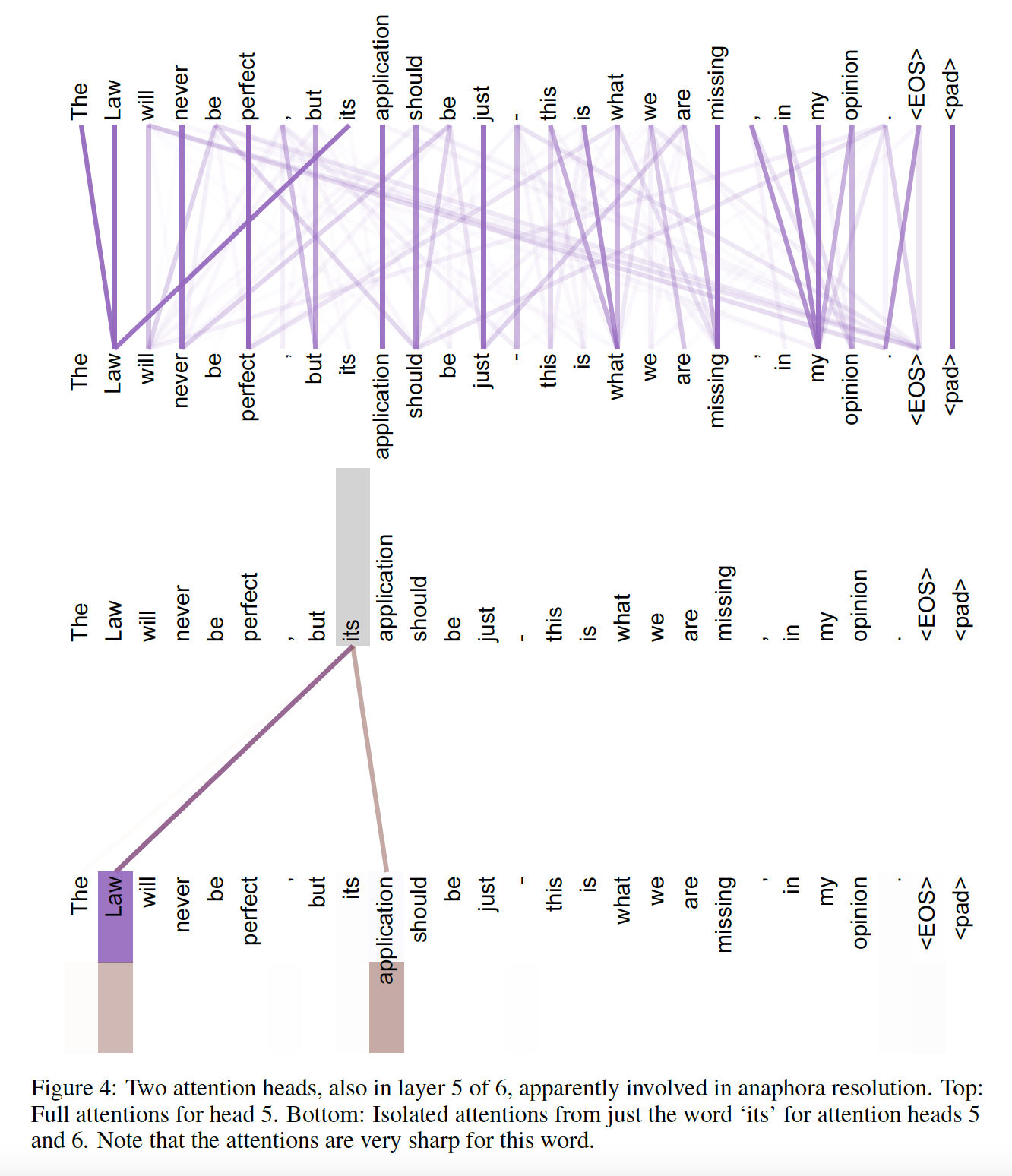

如下图所示为

encoder六层自注意力层的第五层中的两个注意力头。上半部分为head 5的完全的注意力分布(每个单词),下半部分为单词its在head 5和head 6中的注意力分布。

如下图所示为

encoder六层自注意力层的第五层中的两个注意力头。

1.1.7 训练

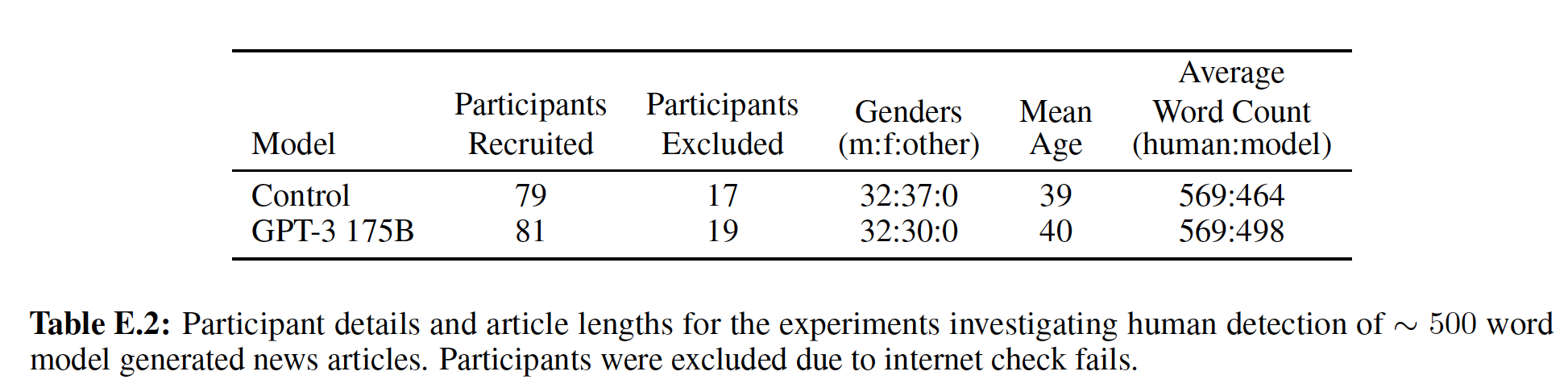

Training Data and Batching:我们在由大约

450万个sentence pair组成的标准WMT 2014 English-German数据集上进行了训练。句子使用byte-pair encoding: BPE(《Massive exploration of neural machine translation architectures》) 进行编码,该编码有一个共享的source-target vocabulary,词典规模大约37000个token。BPE算法:- 语料库中每个单词表示为字符的拼接,其中

</w>表示词尾。 - 将每个单词拆分为字符,并计算字符出现的次数。这些字符添加到词表

vocabulary。 - 寻找出现频次最高的

character pair,合并它们并添加到词表。这些合并的character pair称作word-piece。 - 重复执行上一步(即,“寻找--合并”),直到词表达到指定的规模。

- 语料库中每个单词表示为字符的拼接,其中

对于

English-French,我们使用了更大的WMT 2014 English-French数据集,该数据集由3600万个sentence pair组成。这些句子被拆分为token,并且使用大小为32k的word-piece vocabulary。

sentence pair按照近似的序列长度被batch在一起。每个训练batch包含一组sentence pair,大约共计25k个source token和25k个target token。硬件和

schedule:我们在一台配备8个NVIDIA P100 GPU的机器上训练我们的模型。- 对于我们的

base model(使用我们在整篇论文中描述的超参数),每个training step大约需要0.4秒。我们对base model进行了总共100k步(即12小时)。 - 对于我们的

big model(如下表最后一行所示),每个training step大约需要1.0秒。我们对base model进行了总共300k步(即3.5天)。

- 对于我们的

优化器:我们使用

Adam optimizer优化器,其中即:

- 在开头的

warmup_steps训练step中线性增加学习率。这里我们使用warmup_steps = 4000。 - 然后根据

step number的平方根倒数来按比例降低学习率。

为什么除以

- 在开头的

正则化:在训练期间我们使用三种类型的正则化:

Residual Dropout:我们将

dropout应用于每个子层的output,然后将其和子层的input相加(即残差连接)最后进行layer normalization。即:此外,我们将

dropout同时应用于encoder stack和decoder encoder中的sum embedding,这个sum embedding是embedding和positional encoding相加得到的。

对于

base model,我们使用dropout rate为Label Smoothing:在训练期间,我们采用了label smoothing。这会损害perplexity指标,因为模型会变得更加不确定,但是会提高准确率指标和BLEU得分。语言模型困惑度

perplexity的定义为:其中

1.2 实验

1.2.1 机器翻译

配置(所有超参数是在对验证集进行实验之后再选择的):

base model使用单个模型,该模型是通过平均最后5个checkpoint获得的,其中checkpoint是以10分钟的间隔写入的。big model也是会用单个模型,但是它平均了最后20个checkpoint。checkpoint平均指的是参数值取平均(而不是输出结果取平均)。我们使用

beam size = 4和length penaltybeam search。在解码器的每个位置始终生成

beam size个候选,直到出现结束标记。其中

我们将推断期间的最大输出长度设置为

input length + 50,但是在可能的情况下输出会提前结束。

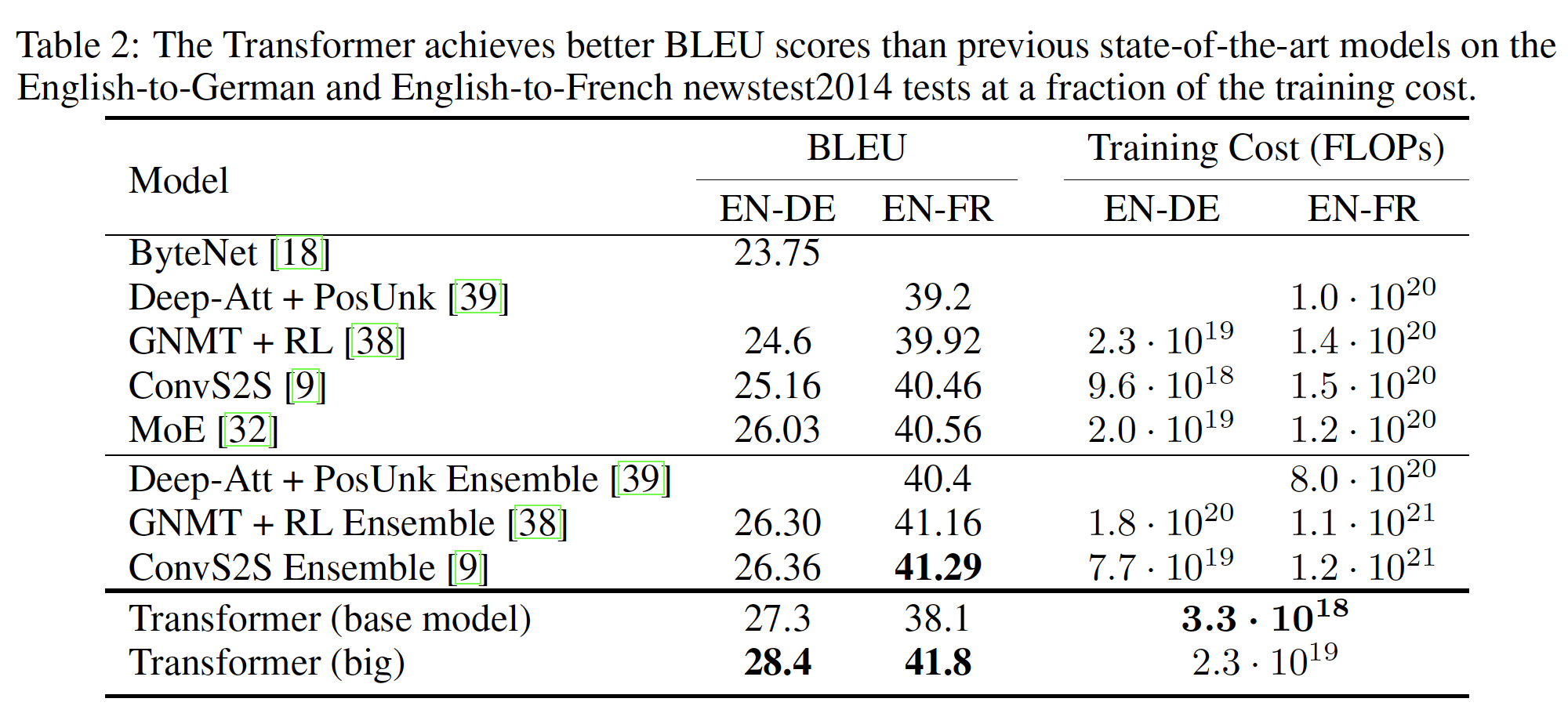

下表总结了我们的结果,并将我们的翻译质量和训练成本,与文献中的其它模型架构进行了比较。我们通过将训练时间、使用的

GPU数量、以及每个GPU的单精度浮点运算能力的估计值相乘,从而估计用于训练模型的浮点运算的数量。对于K80, K40, M40, P100,我们取它们的单精度浮点运算能力分别为2.8, 3.7, 6.0, 9.5 TFLOPS。WMT 2014 English-to-German翻译任务:big transformer model比先前报告的最佳模型(包括ensemble模型)在BLEU指标上高出2.0以上,达到了一个新的state-of-the-art的BLEU得分28.4。big transformer model在8个P100 GPU上训练耗时3.5天。甚至我们的

base model也超越了所有先前发布的模型和ensembles,并且base model的训练成本仅仅是任何其它有竞争力的模型的一小部分。bilingual evaluation understudy: BLEU评估机器翻译质量。其思想是:机器翻译结果越接近专业人工翻译的结果,则越好。其中:

BP为句子简短惩罚Brevity Penalty,迫使机器翻译的长度与参考翻译的长度接近。其中

n-gram匹配最大的n值。通常1-gram匹配结果代表有多少个单词被独立地翻译出来,而2-gram以上的匹配结果代表翻译的流畅度。通常4。n-gram匹配结果的权重,通常选择n-gram匹配结果,即n-gram precision:其中:

n-gram项。n-gram项在所有翻译结果中出现的次数。n-gram项在所有翻译结果中出现的截断次数:而

n-gram项在参考译文中出现的次数。因此这里的“截断”指的是被ground-truth频次所截断。

WMT 2014 English-to-French翻译任务:big transformer model达到了41.0的BLEU得分,优于先前发布的所有单一模型,训练成本小于先前state-of-the-art模型的1/4。注意:为

English-to-French而训练的Transformer big model使用dropout rate为0.3。41.0对不上?从下表结果来看应该是41.8。

1.2.2 模型变体

为了评估

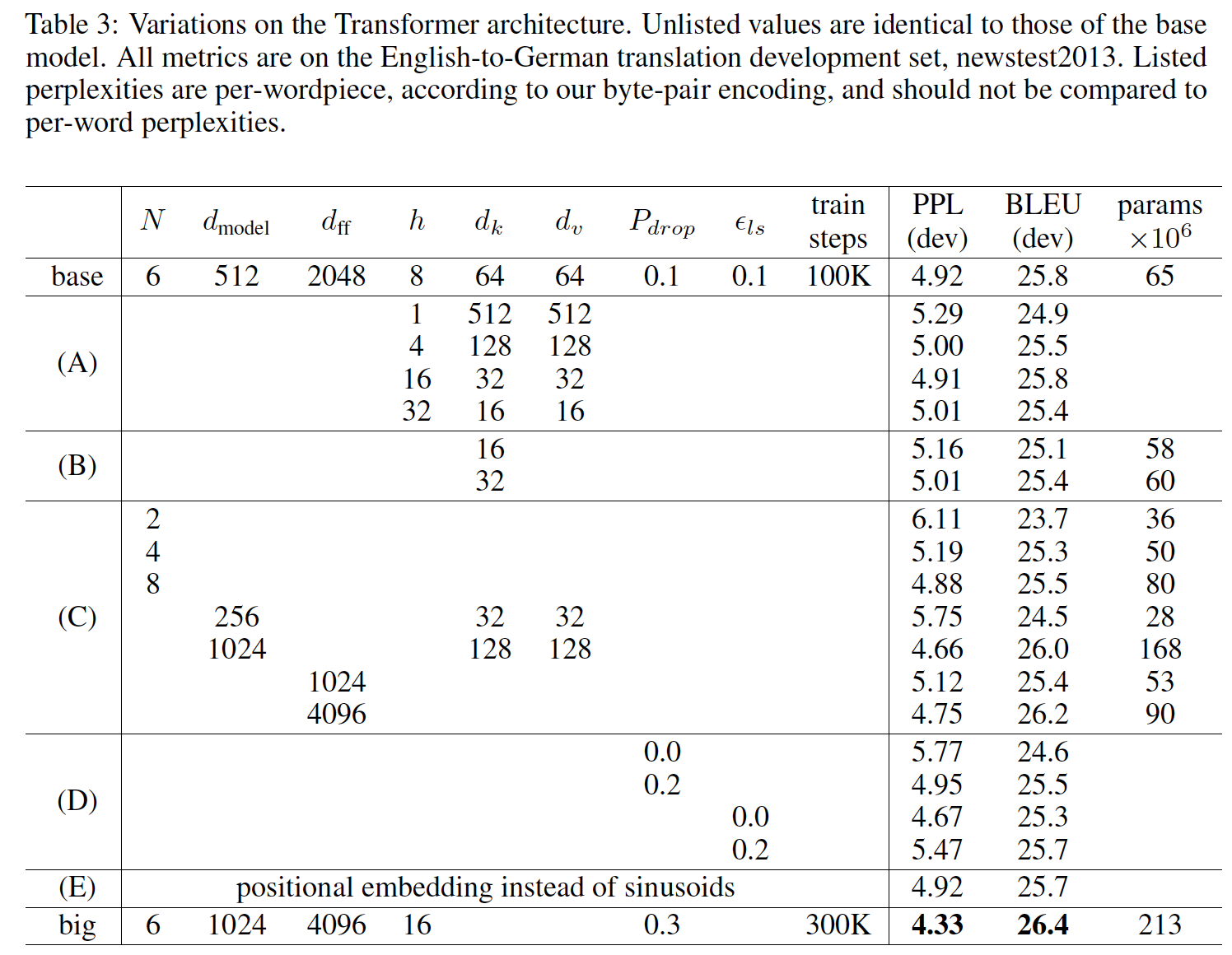

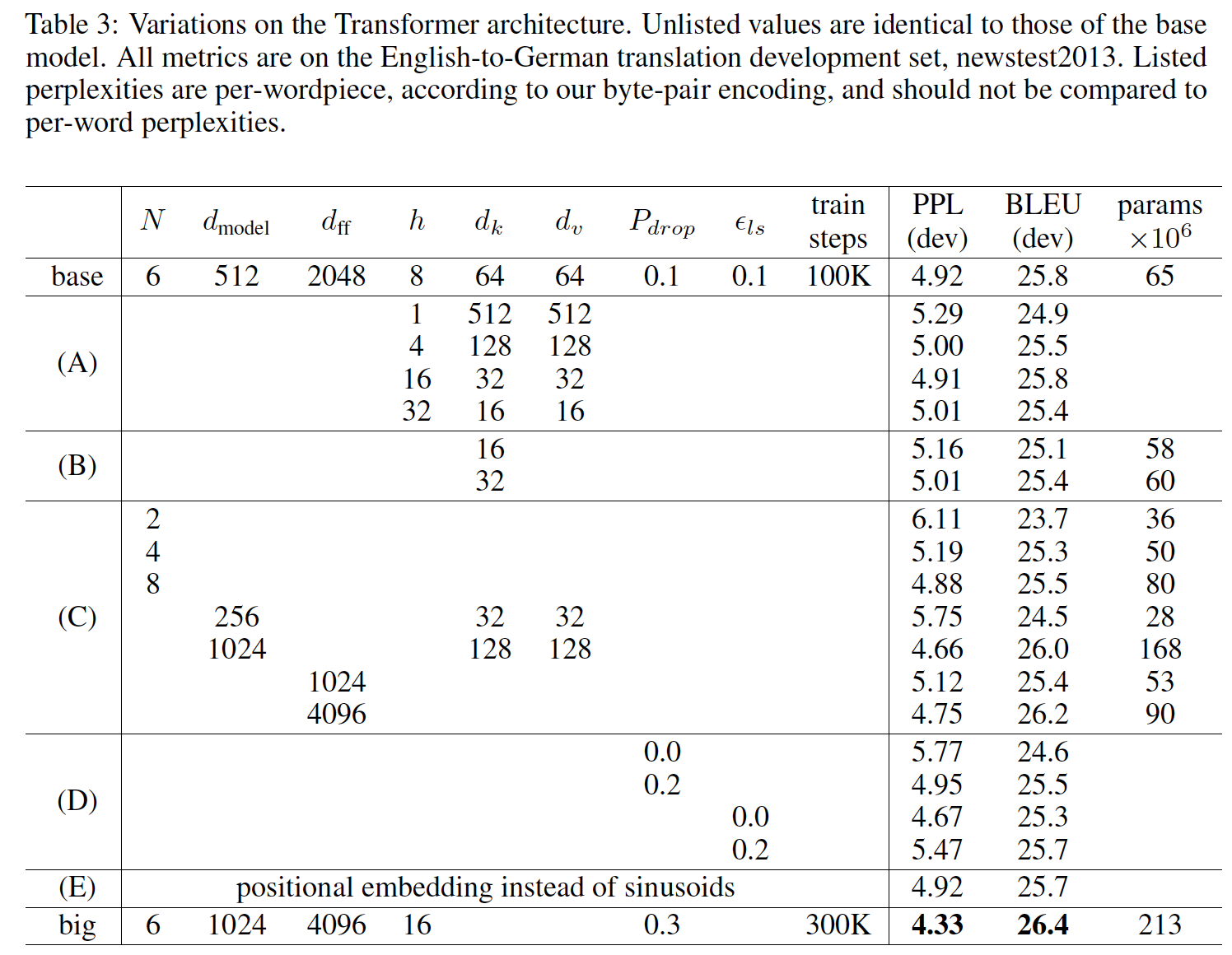

Transformer不同组件的重要性,我们以不同的方式改变了我们的base model,并衡量了验证集(newstest2013)上English-to-German翻译性能的变化。我们使用了上一节中描述的beam search,但是没有使用checkpoint平均。实验结果如下表所示。在

(A)行中,我们改变了注意力头的数量以及注意力key, value的维度,并保持计算量不变。可以看到,虽然单头注意力要比最佳配置差0.9 BLEU,但是如果head数量过多效果也会下降。在

(B)行中,我们观察到降低注意力key的维度compatibility function并不容易确定,采用比内积更复杂的compatibility function可能是有益的。compatibility function就是计算未归一化注意力分的函数此外,降低

65M降低到60M和58M)。在

(C)行中,我们观察到,正如预期的那样,更大的模型更好。在

(D)行中,我们观察到,dropout和label smoothing有助于缓解过拟合,但是需要选取合适的dropout rate和label smoothing rate。在

(E)行中,我们用可学习的positional embedding代替固定的正弦positional encoding,并观察到与base model几乎相同的结果。

1.2.3 English Constituency Parsing

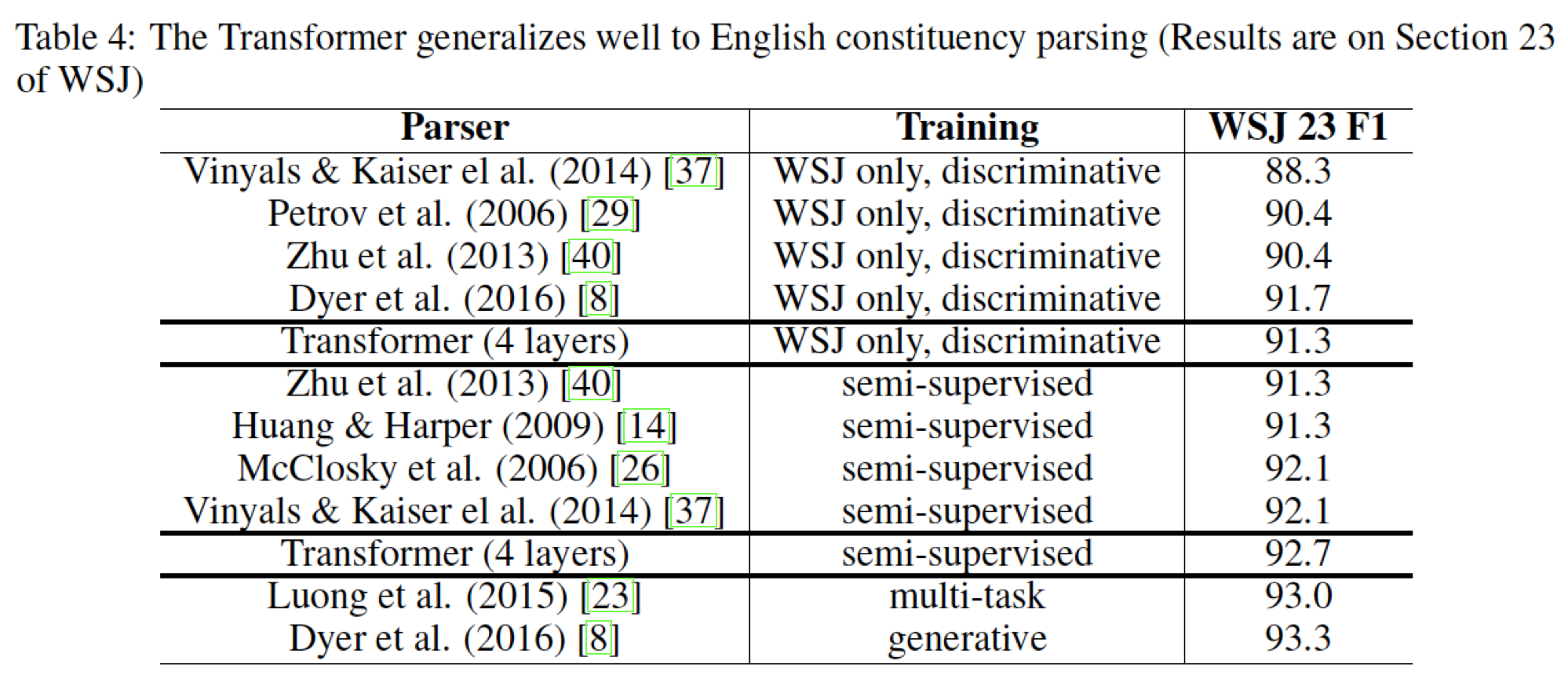

为了评估

Transformer是否可以泛化到其它任务,我们对英语成分分析English constituency parsing任务进行了实验。这项任务提出了特定的挑战:output受到强烈的结构性约束,并且明显比input更长。此外,RNN sequence-to-sequence model无法在小数据领域获得state-of-the-art结果。我们在

Penn Treebank的Wall Street Journal: WSJ部分(大约40k个训练句子)上训练了一个4层transformer。对于该任务,我们使用16k token的词典vocabulary。我们还在半监督环境中训练了相同配置的

transformer,使用来自大约1700万个句子的更大的high-confidence和BerkleyParser的数据集。对于该任务,我们使用32k token的词典。我们仅在

Section 22验证集上进行了少量实验来选择以下超参数:dropout(attention和residual上的dropout)、学习率、beam size。所有其它超参数保持与English-to-German base translation model相同。在推断期间,我们将最大输出长度增加到input length + 300。对于WSJ only和半监督任务,我们都使用beam size = 21和实验结果如下表所示,可以看到:

- 尽管缺乏对特定任务的调优,但是我们的模型表现得非常好,比除了

Recurrent Neural Network Grammar之外的所有先前报告的模型得到了更好的结果。 - 与

RNN sequence-to-sequence model相比,即使仅在具有40k个句子的WSJ训练集上进行训练,Transformer的性能也超越了Berkeley- Parser。

- 尽管缺乏对特定任务的调优,但是我们的模型表现得非常好,比除了

二、Universal Transformer[2018]

像

Transformer这样的parallel-in-time架构解决了RNN的一个重要缺陷:RNN固有的序列计算sequential computation阻止了输入序列中各元素的并行化。同时Transformer也解决了序列较长时梯度消失的问题。Transformer模型完全依靠自注意力机制。这种机制不仅可以直接并行化,而且由于每个symbol的representation也直接访问到所有其他symbol的representation,这导致了整个序列中有效的全局感受野global receptive field。然而,值得注意的是,

Transformer具有固定数量的层,放弃了RNN对学习迭代式转换iterative transformation或递归式转换recursive transformation的归纳偏置inductive bias。我们的实验表明:这种归纳偏置可能对一些算法和语言理解任务至关重要,Transformer不能很好地泛化到训练期间没有遇到的输入长度。在论文

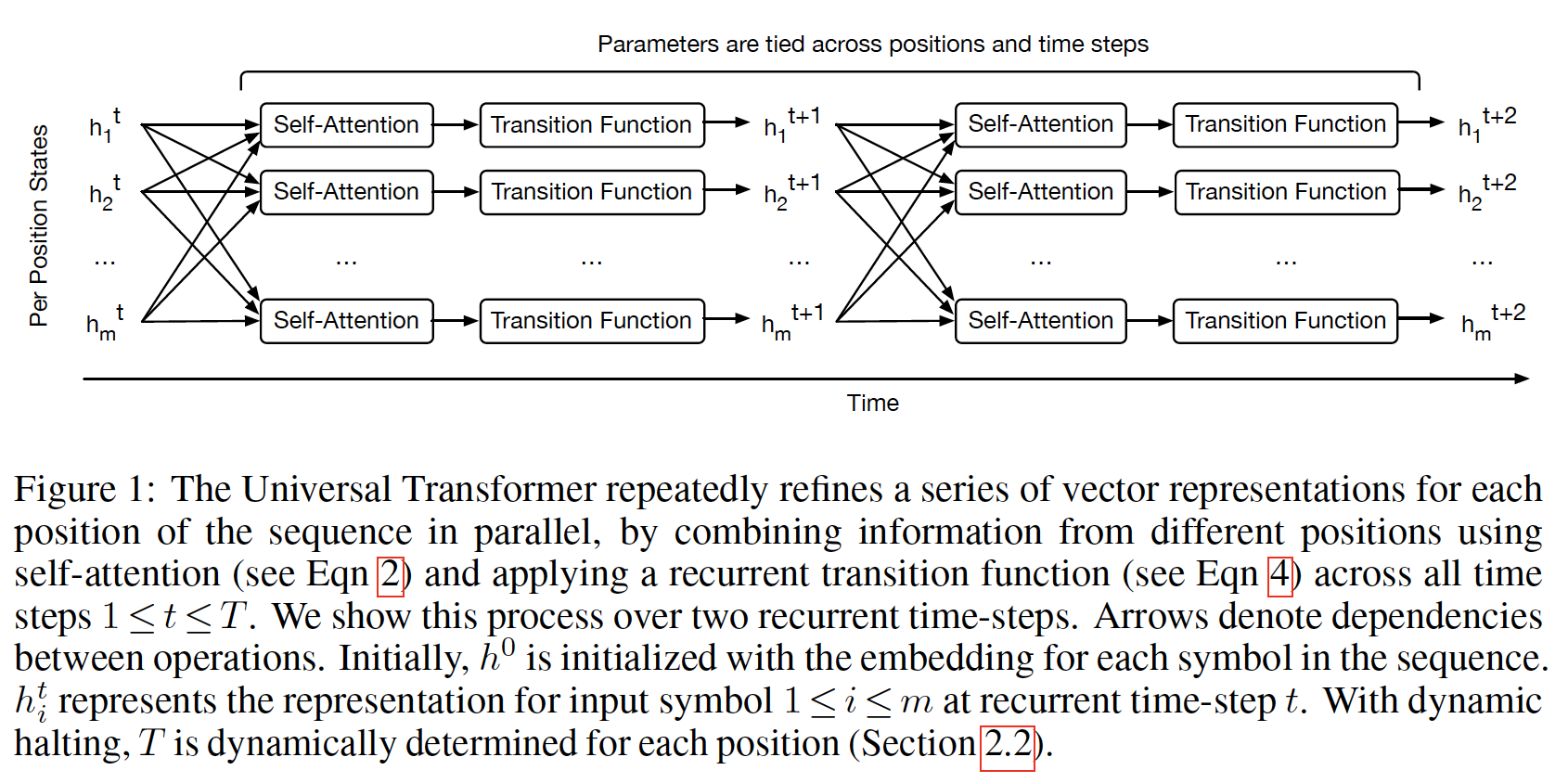

《Universal Transformer》中,作者介绍了Universal Transformer: UT,这是一个parallel-in-time的递归的自注意力序列模型,它可以作为Transformer模型的泛化,在广泛的具有挑战性的sequence-to-sequence任务上产生提升的理论能力和改进的结果。Universal Transformer结合了像Transformer这样的前馈序列模型的并行能力parallelizability和全局感受野、以及RNN的循环归纳偏置,这似乎更适合一系列的算法和自然语言理解的sequence-to-sequence问题。顾名思义,与标准的Transformer相比,在某些假设下,Universal Transformer可以被证明是图灵完备的。在每个

recurrent step中,Universal Transformer使用自注意力机制并行地refine序列中所有symbol的representation,然后跟着一个深度可分离卷积depth-wise separable convolution或position-wise fully-connected layer(在所有position和time-step中共享),如下图所示。作者还添加了一个动态的逐位置停机机制per-position halting mechanism,允许模型动态选择每个symbol所需的refinement step数量,并首次表明这样的条件计算机制conditional computation mechanism事实上可以提高几个较小的结构化的算法和语言推理任务的准确性(尽管它在机器翻译任务上的结果略有下降)。论文强有力的实验结果表明:

Universal Transformer在广泛的任务中的表现优于Transformer和LSTM。

相关工作:

当运行一个

fixed数量的step时,Universal Transformer相当于一个跨所有层共享参数的multi-layer Transformer。这在一定程度上类似于Recursive Transformer,它在不同的深度上共享了self-attention layer的权重。另一种可能更

informative的描述,Universal Transformer的方式是:作为一个并行的RNN block(每个symbol一个RNN block,共享参数)来同时演化每个symbol的hidden state(通过在每个step关注前一个step的hidden state序列来产生)。这样,它与Neural GPU和Neural Turing Machine等架构有关。因此,Universal Transformer保留了原始feed-forward Transformer模型有吸引力的计算效率,但增加了RNN的recurrent inductive bias。此外,利用动态停机机制,Universal Transformer可以根据输入数据自动选择processing step的数量。Universal Transformer和其他序列模型之间的联系从架构上看是显而易见的: 如果我们将recurrent step限制为一个,它将是一个Transformer。但是,考虑

Universal Transformer和RNN以及其他网络之间的关系更为有趣,在这些网络中,递归发生在时间维度上。表面上看,这些模型似乎密切相关,因为它们也是递归的。但有一个关键的区别:- 像

RNN这样的time-recurrent模型不能在递归步骤中访问所有的记忆memory(只能访问最近的一个记忆)。这使得它们在计算上更类似于自动机automata,因为在递归部分唯一可用的记忆是一个固定尺寸的状态向量fixed-size state vector。 - 另一方面,

Universal Transformer可以关注整个previous layer,允许它在recurrent step中访问所有的记忆。

- 像

给定足够的内存,

Universal Transformer在计算上是通用的,即它可以模拟任何图灵机Turing machine,从而解决了标准Transformer模型的一个缺陷。除了在理论上有吸引力外,我们的结果表明:这种增加的表达性也导致了在几个具有挑战性的序列建模任务上的准确性的提高。这缩小了在机器翻译等大规模任务上与

Neural Turing Machine或Neural GPU等模型之间的差距。为了说明这一点,我们可以将

Universal Transformer简化为一个Neural GPU。忽略decoder并将self-attention模块(即带有残差连接的self-attention)简化为恒等映射,并且假设转移函数是卷积。如果我们将循环step的总数Neural GPU。Universal Transformer和Neural Turing Machine之间也存在类似的关系。Neural Turing Machine每个step的single read/write操作可以由Universal Transformer的全局的、并行的representation revision来表达。另一个相关的模型架构是端到端记忆网络

Memory Network。然而,与端到端记忆网络相比,Universal Transformer使用的memory对应于与其输入或输出的individual position对齐的状态。此外,Universal Transformer遵循encoder-decoder的配置,在大规模sequence-to-sequence的任务中实现了有竞争力的性能。

Universal Transformer将以下关键属性结合到一个模型中:Weight sharing:我们用一种简单的权重共享形式来扩展Transformer,从而在inductive bias和模型表达力之间取得了有效的平衡。由于权重共享,所以

Universal Transformer的模型大小要远远小于标准的Transformer。Conditional computation:我们为Universal Transformer配备了动态停机能力。与固定深度的Universal Transformer相比,它显示了更强的结果。

2.1 模型

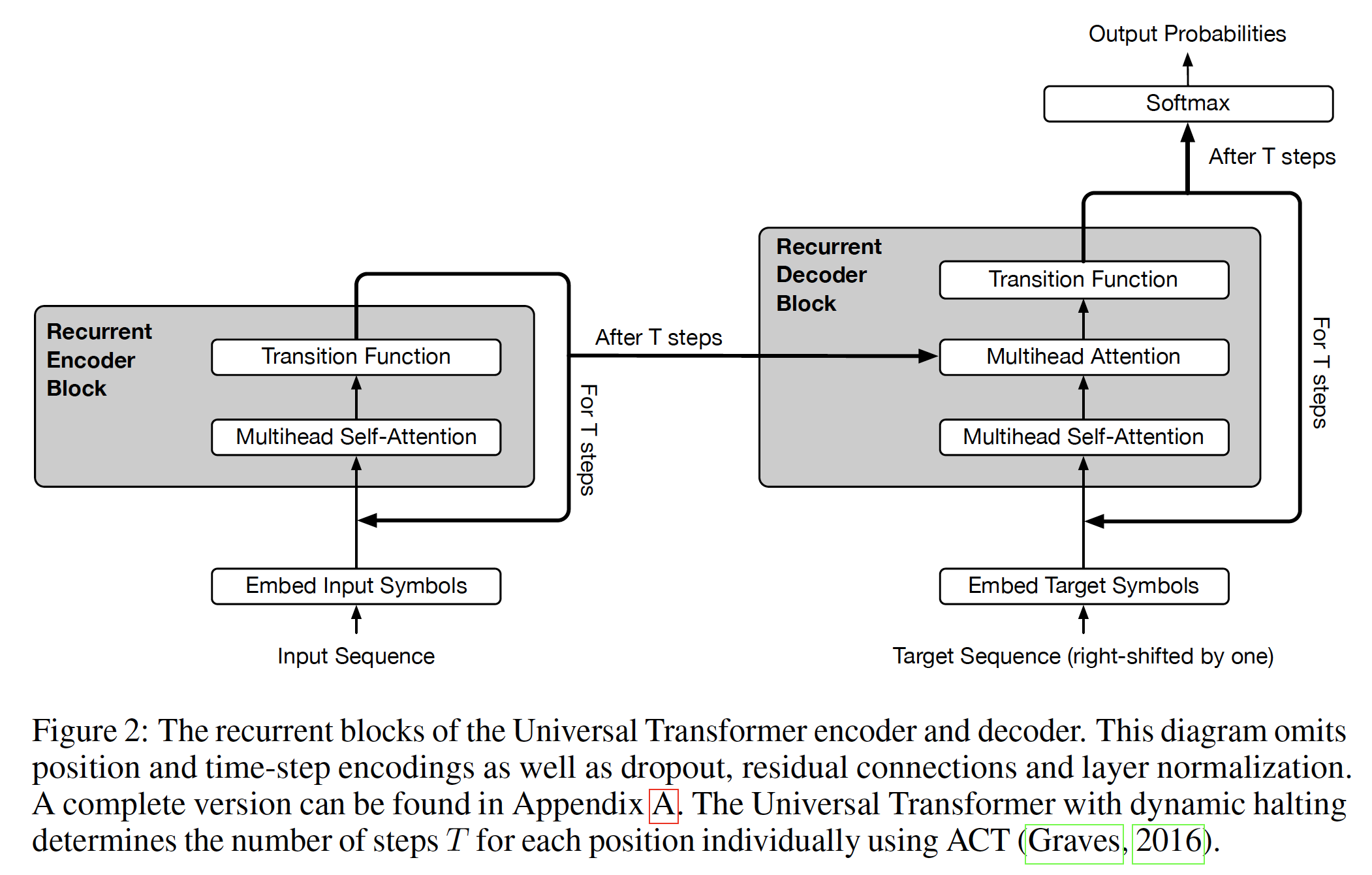

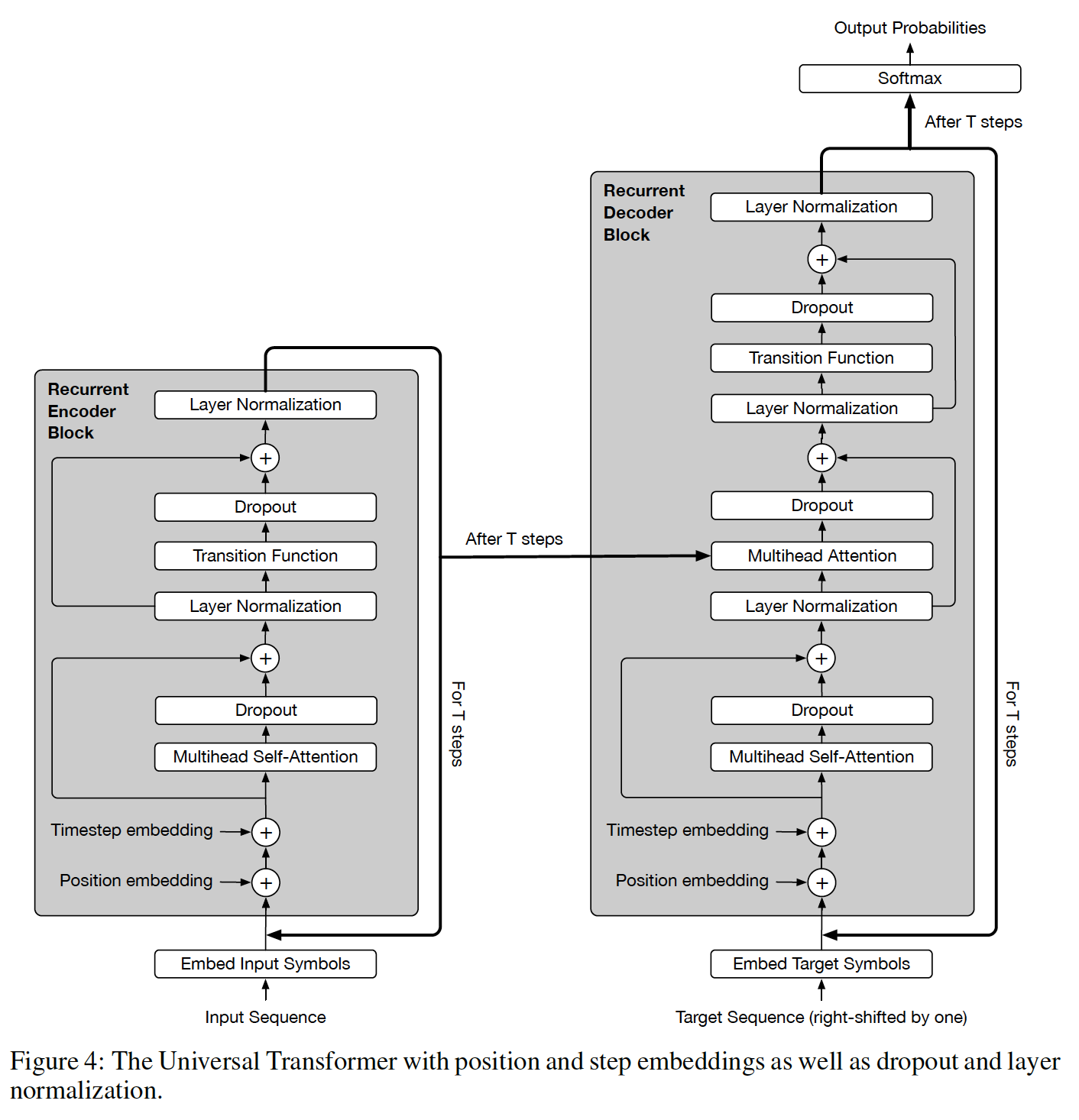

Universal Transformer是基于常用的encoder-decoder架构,它的encoder和decoder都是通过将一个RNN分别应用于输入和输出序列的每个位置的representation来操作的,如下图所示。然而,与常规RNN不同,Universal Transformer不是在序列中的position上递归(沿着宽度方向),而是在每个position的depth上递归(沿着高度方向)。在每个

recurrent time-step,每个位置的representation在两个sub-step中被并行地修改:- 首先,使用自注意力机制在序列中的所有位置上交换信息,从而为每个位置生成一个

vector representation,该representation是由前一个time step的所有其他位置的representation融合而来。 - 然后,在每个位置独立地对自注意力机制的输出应用一个转移函数(跨

position和time共享)。

由于递归可以应用任何次数,这意味着

Universal Transformer可以有可变的深度(per-symbol processing step的数量)。相比之下,Transformer和stacked RNN只有固定的深度。

更完整的架构如下图所示:

- 首先,使用自注意力机制在序列中的所有位置上交换信息,从而为每个位置生成一个

2.1.1 Encoder

给定一个长度为

embedding矩阵,它的第symbol的embedding向量Universal Transformer通过应用Transformer的多头内积自注意力机制multi-headed dot-product self-attention mechanism,在steprepresentationtransition function。我们还在这些功能块function block周围添加了残差连接,并应用了dropout和layer normalization。更具体地说,我们使用缩放的内积注意力:

其中

我们使用有

其中:

在

stepUniversal Transformer然后计算所有representationLayerNorm作用在残差连接之后,而不是之前。其中:

Transition为转移函数。根据任务,我们使用两种不同的转移函数之一:要么是可分离的卷积、要么是前馈神经网络(由两个线性投影以及中间的的单个Relu激活函数组成,逐位置应用)。coordinate embedding,通过计算正弦的position embedding向量获得:

经过

step(每个step并行地更新输入序列的所有位置),Universal Transformer encoder的final output是

2.1.2 Decoder

decoder与encoder的基本递归结构相同。然而,在self-attention函数之后,decoder额外还使用多头内积注意力函数来关注encoder的final representationquerydecoder representation投影得到,而keyvalueencoder final representation投影得到。是否可以对

decoder和encoder应用不同的decoder和encoder迭代相同的次数。像

Transformer模型一样,Universal Transformer是自回归的。- 在生成阶段,

Universal Transformer一次产生一个symbol的输出,其中decoder仅仅依赖已经产生的输出位置。 - 在训练阶段,

decoder的目标输出就是输入左移一个位置。

最后,

per-symbol target distribution是通过应用线性变换final decoder state映射到output vocabularysoftmax进行按行的归一化:其中:

这里我们用

encoder和decoder的最后一层的representation。decoder的输入。- 在生成阶段,

为了从模型中生成:

- 首先,

encoder要对输入序列运行一次前向传播。 - 然后重复运行

decoder从而消耗所有已经生成的symbol,同时为下一个输出位置的symbol生成一个额外的分布。然后,我们通常对最高概率的symbol进行采样从而作为next symbol(用于decoder的下一轮RNN迭代)。

如果是训练期间,那么

decoder每一轮迭代都使用decoder的目标输出右移一位作为decoder input。但是在推断期间,decoder的目标输出不存在,因此需要用到decoder在每一轮的输出。- 首先,

2.1.3 动态停机

在序列处理系统中,某些

symbol通常比其他symbol更ambiguous。因此,将更多的处理资源分配给这些更ambiguous的symbol是合理的。Adaptive Computation Time: ACT是一种机制,用于动态调节标准RNN中处理每个input symbol所需的计算步(称为ponder time),它基于模型在每个step预测的标量停机概率halting probability。受此启发,

Universal Transformer为每个位置(即每个per-symbol self-attentive RNN)添加了一个动态ACT停机机制。一旦某个symbol的recurrent block停机,它的状态就被简单地复制到下一步,直到所有的block都停机,或者我们达到最大的step数量encoder的final output是以这种方式产生的最后一层representation。

2.2 实验

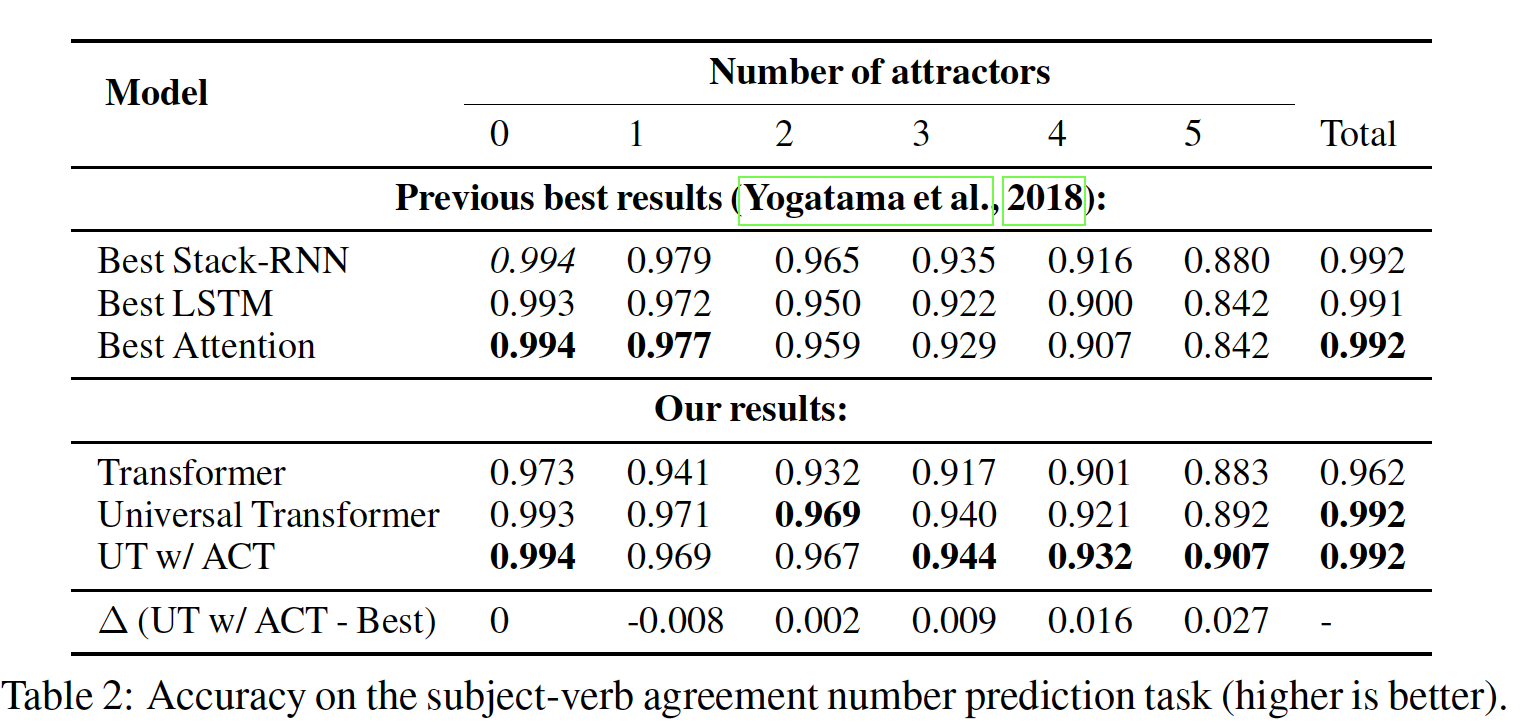

2.2.1 BABI 问答

bAbi question answering数据集:由20个不同的任务组成,其目标是在给定一些英文句子的前提下回答一个问题,这些给定的句子编码了潜在的multiple supporting facts。这么做的目的是:通过要求对每个故事中呈现的语言事实进行某种类型的推理,来衡量各种形式的语言理解

language understanding。为了对输入进行编码,与

《Tracking the world state with recurrent entity networks》类似:首先,我们通过应用一个学到的乘性的

positional mask到每个单词的embedding,并sum聚合所有单词的embedding,从而编码故事中的每个fact。因为每个

fact包含多个单词,所以需要对word embedding进行聚合从而得到fact emebdding。然后,我们以同样的方式嵌入问题,然后用这些

fact embedding和question embedding馈入Universal Transformer。

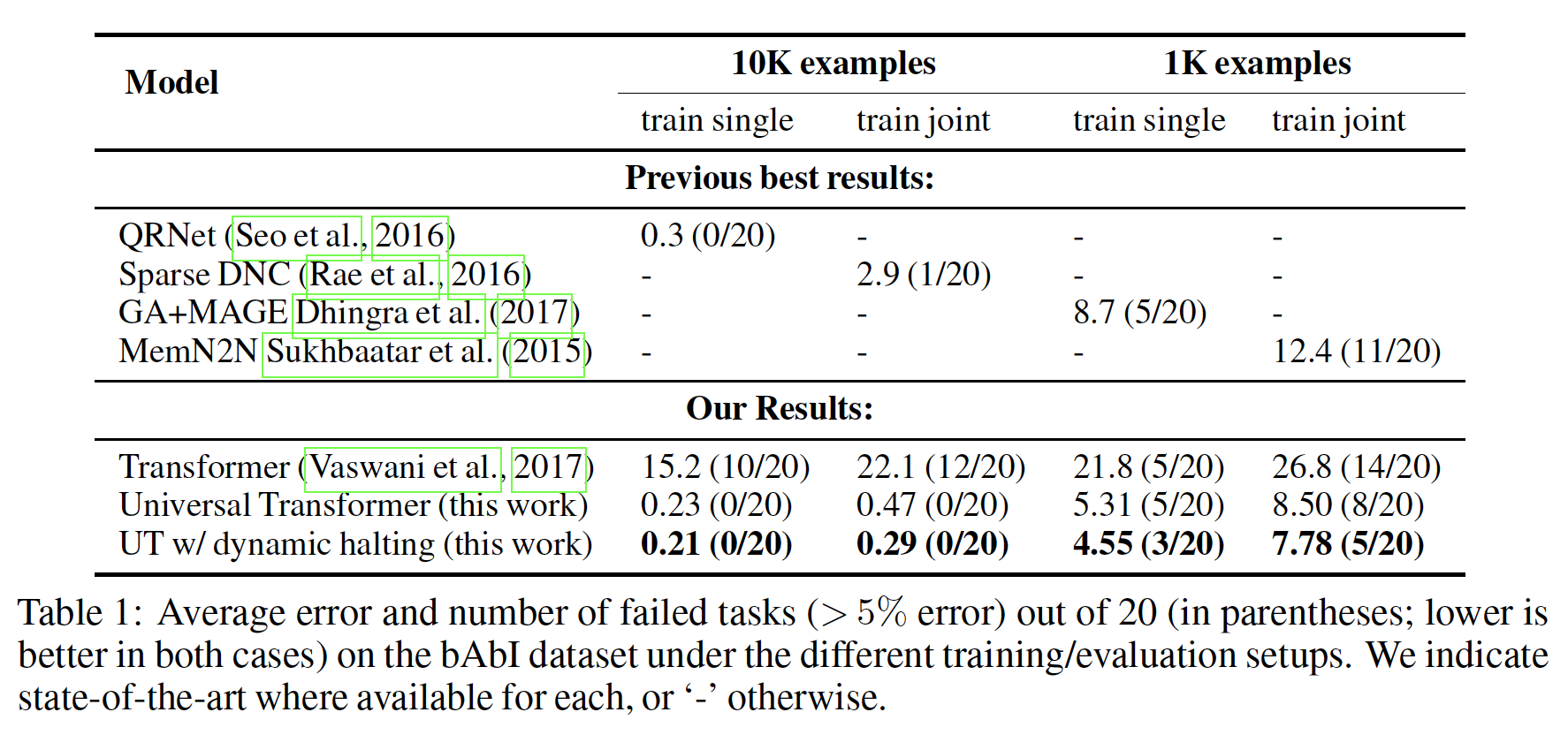

模型可以在每个任务上单独训练(

train single)或在所有任务上联合训练(train joint)。下表总结了我们的结果。我们用不同的初始化运行了10次,并根据验证集上的表现挑选出最佳模型。可以看到:

Universal Transformer和带有动态停机的Universal Transformer在所有任务中的平均误差和失败任务数方面都取得了SOTA的结果。括号中的指标代表失败任务数,如

(10/20)表示在20个任务中失败了10个。任务失败指的是错误率大于5%。

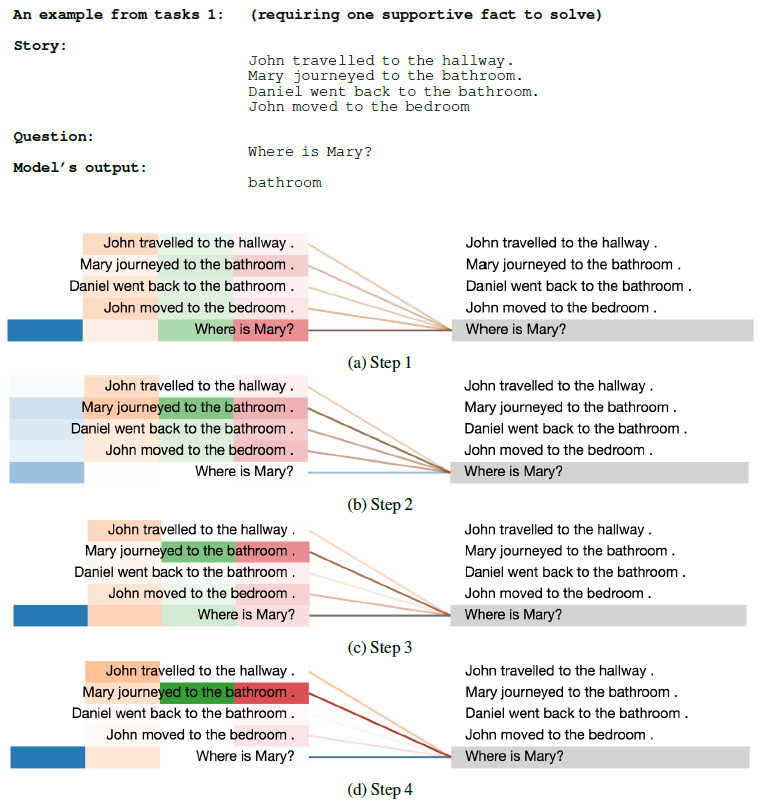

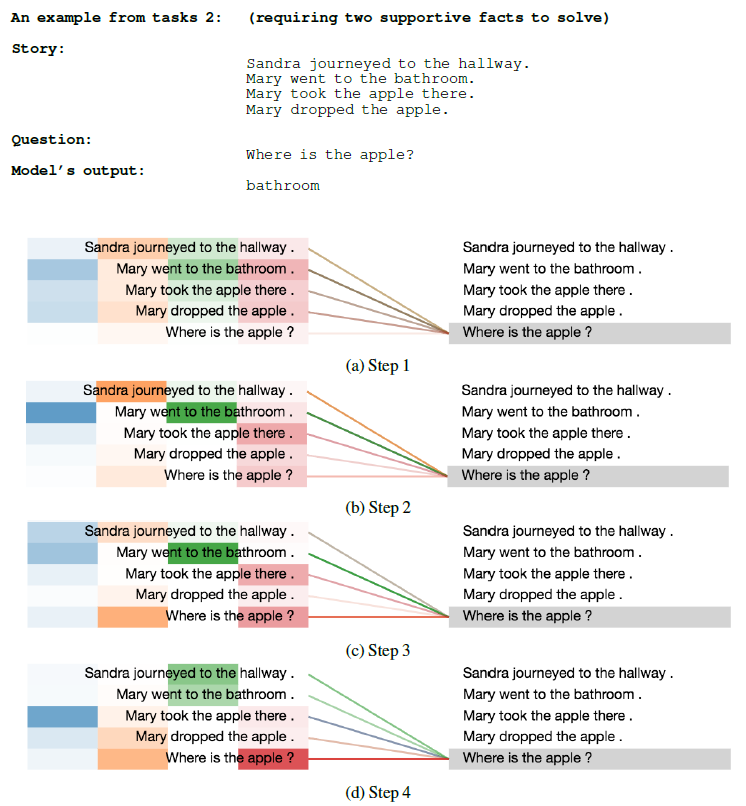

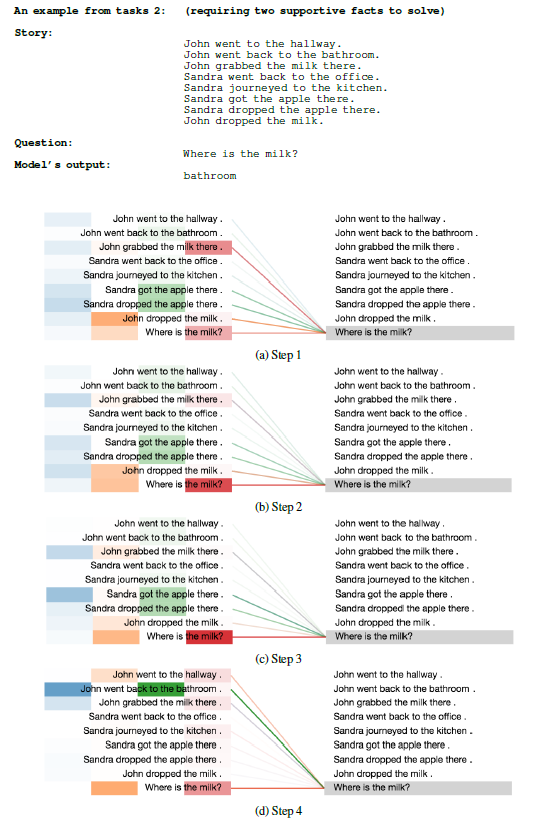

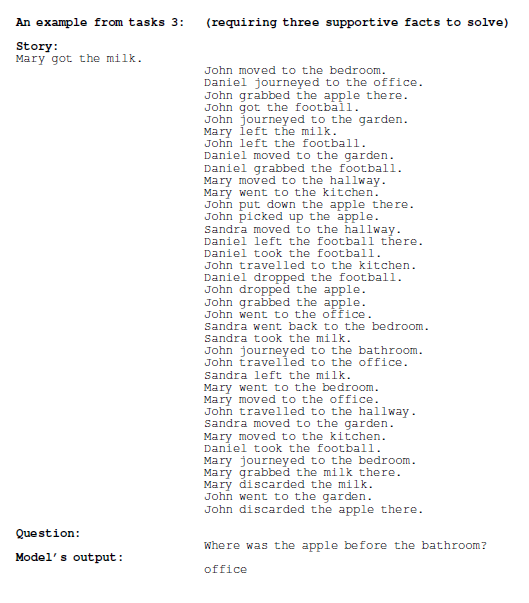

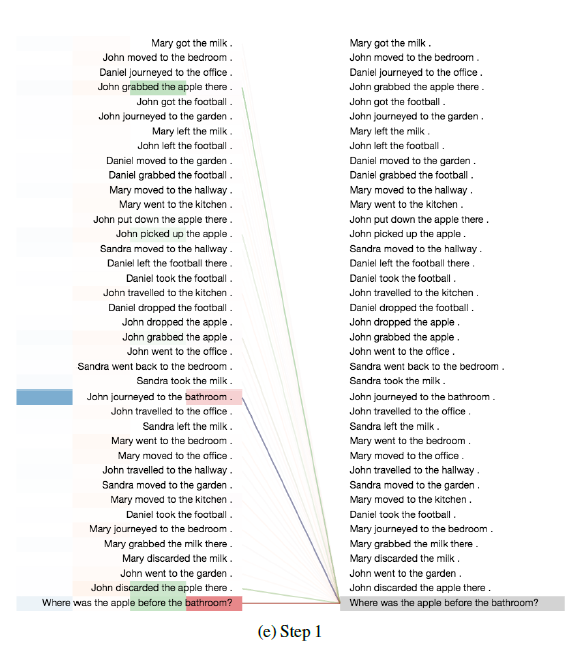

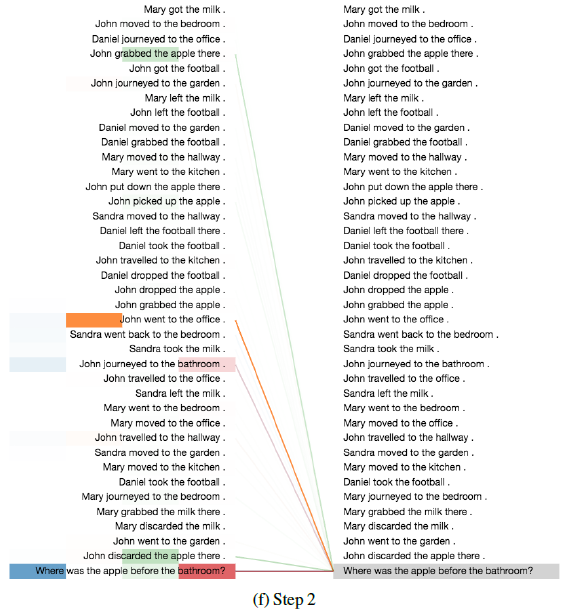

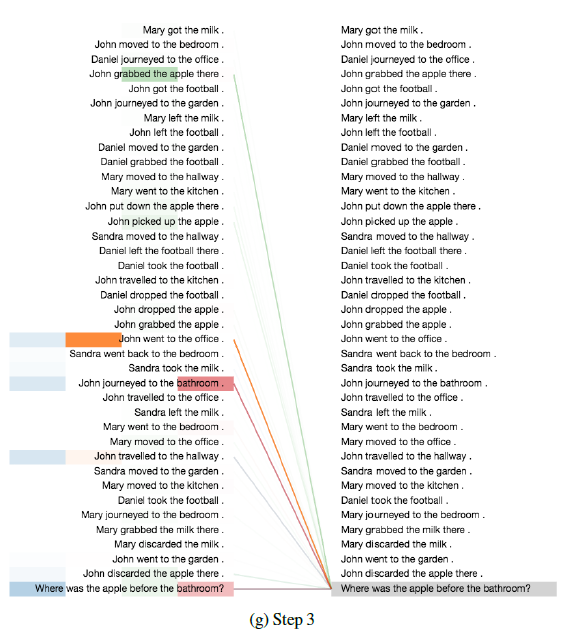

为了更好地理解模型的工作,我们分析了这项任务的注意力分布和平均

ACT ponder time。下图为注意力权重在不同step上的可视化,左侧不同的颜色条表示不同head的注意力权重(一共4个head),即,列代表head、行代表句子。一个

supportive fact的问题:

两个

supportive fact的问题:

三个

supportive fact的问题:

结论:

首先,我们观察到注意力分布开始时非常均匀,但在后面的

step中,围绕着回答每个问题所需的正确的supporting fact,注意力分布逐渐变得尖锐,这确实非常类似于人类如何解决这个任务。其次,通过动态停机我们观察到:需要三个

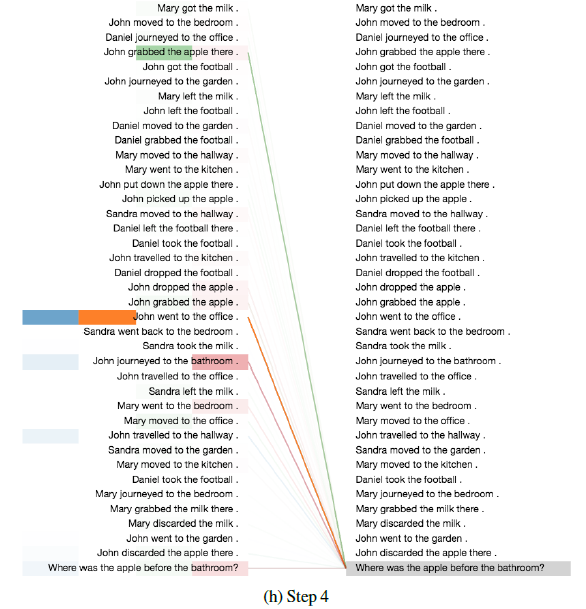

supporting fact的任务的所有位置的平均ponder time(即per-symbol recurrent processing chain的深度(supporting fact的任务(supporting fact的任务(supporting fact的数量来调整processing step的数量。最后,我们观察到:在只需要一个

supporting fact的任务中,不同位置的ponder time直方图与需要两个/三个supporting fact的任务相比更加均匀。同样,在需要两个

supporting fact的任务与需要三个supporting fact的任务也是如此。特别是对于需要三个supporting fact的任务,许多位置已经在第1步或第2步停机了,只有少数位置需要更多的step(如下图所示)。这一点特别有意思,因为在这种情况下,故事的长度确实要高得多,有更多不相关的fact,而模型似乎成功地学会了以这种方式忽略这些fact。

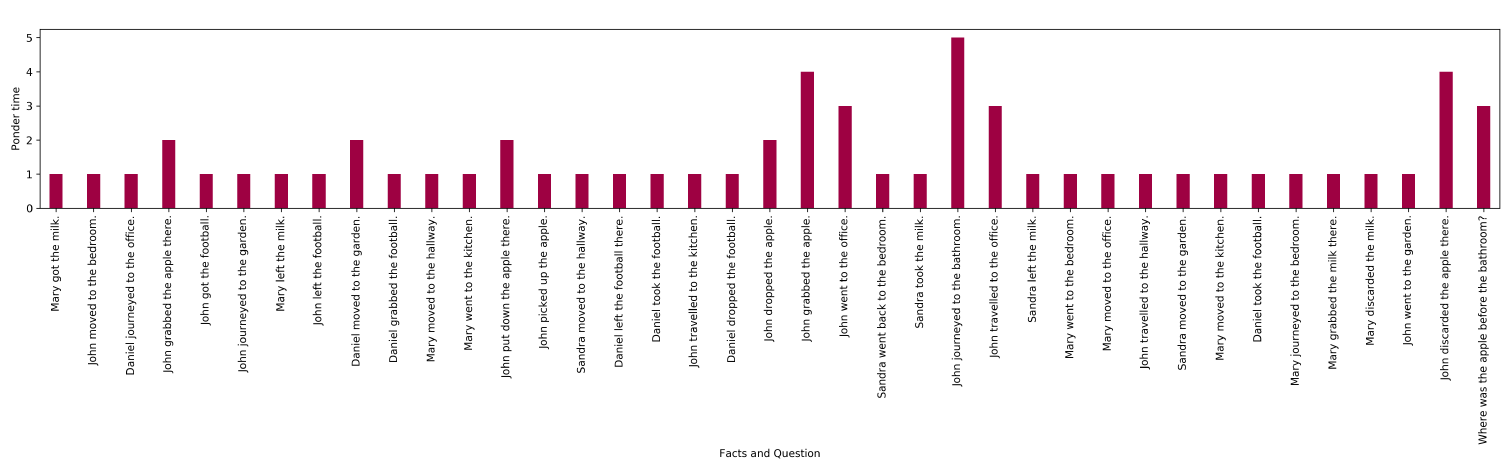

2.2.2 主谓一致

主谓一致

Subject-Verb Aggrement任务:使用语言建模的training setup来解决这个任务,即next word prediction的目标,然后在测试时计算目标动词的ranking accuracy。该任务是衡量模型在自然语言句子中捕捉层级结构hierarchical structure的能力的一个代理。attractors用于增加难度,它表示与主语相反数量opposite number的中间名词intervening noun的个数(旨在混淆模型)。如:给定句子The keys __ to the cabinet,训练期间的目标动词是are,但是测试期间我们要求are的排名比is更高。

2.2.3 LAMBADA 语言建模

LAMBADA任务:是一项语言建模任务,在给定前面4到5个句子的条件下预测一个缺失的目标词。该数据集是专门设计的,当显示完整的上下文时,人类能够准确地预测目标词,但当只显示出现该词的目标句时,则人类无法预测目标词。因此,它超越了语言建模,并测试了模型在预测目标词时纳入更长上下文的能力。

该任务在两种情况下被评估:

语言建模(标准设置,更具挑战性):模型只是在训练数据上进行

next-word prediction的训练,并在测试时对目标词进行评估。和阅读理解:目标句子(减去最后一个词)被用作

query,用于从上下文句子中选择目标词(即,检索式的方法)。请注意,目标词在

81%的时间里出现在上下文中,这使得这种设置更加简单。然而,在其余19%的情况下,这个任务是不可能完成的(因为目标词不存在上下文中)。

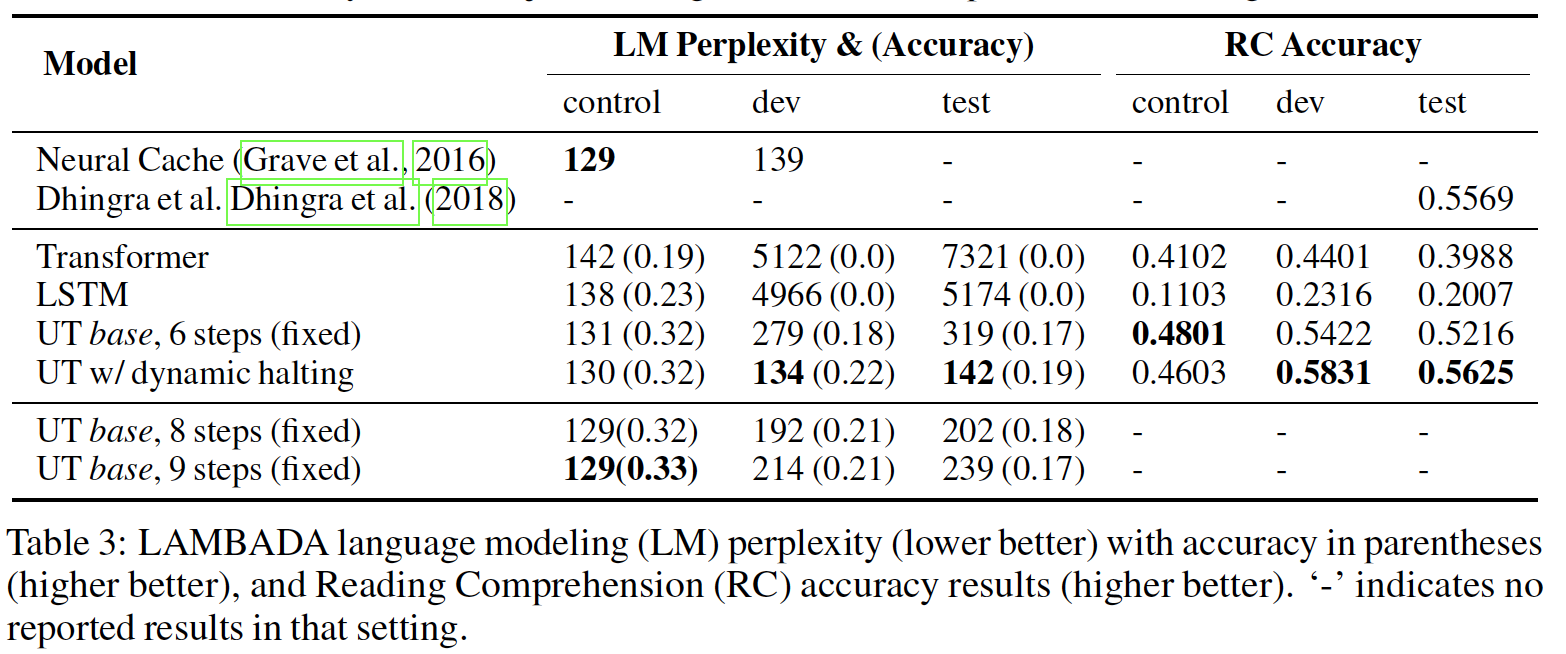

实验结果:

Universal Transformer在语言建模和阅读理解设置中都取得了SOTA结果。我们

fixed Universal Transformer结果使用了6个step(即,Universal Transformer的平均step数为为了看看动态停机是否仅仅因为采取了更多的

step而做得更好,我们训练了两个fixed Universal Transformer,分别用Universal Transformer的表现。这使我们相信:动态停机可以作为模型的一个有用的正则器,通过激励一些

input symbol以较小的step数量,同时允许其他input symbol以更多的计算。

2.2.4 算术任务

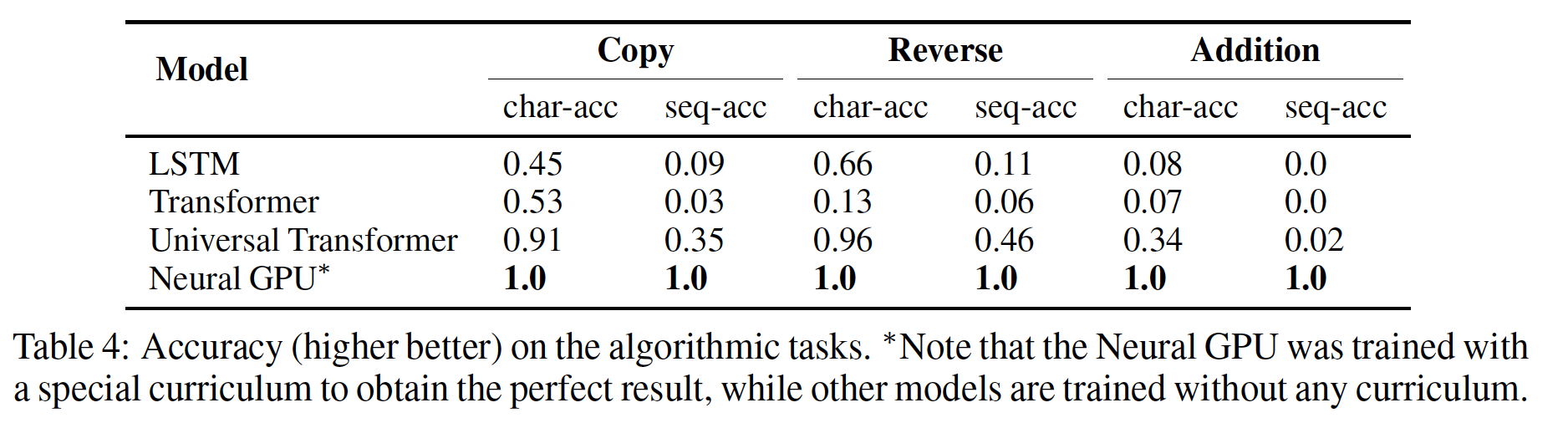

我们在三个算术任务上训练

Universal Transformer,即Copy、Reverse和(整数)加法,都是在由十进制符号(0 ~ 9)组成的字符串上。在所有的实验中,我们在长度为40的序列上训练模型,在长度为400的序列上进行评估。 我们使用从randomized offset开始的位置来训练Universal Transformer(训练样本需要选择从哪里开始切分,因为输入语料库可以视为一个超长的文本),以进一步鼓励模型学习position-relative的转换。结果如下表所示,

Universal Transformer在所有三个任务上的表现都远远超过了LSTM和常规的Transformer。

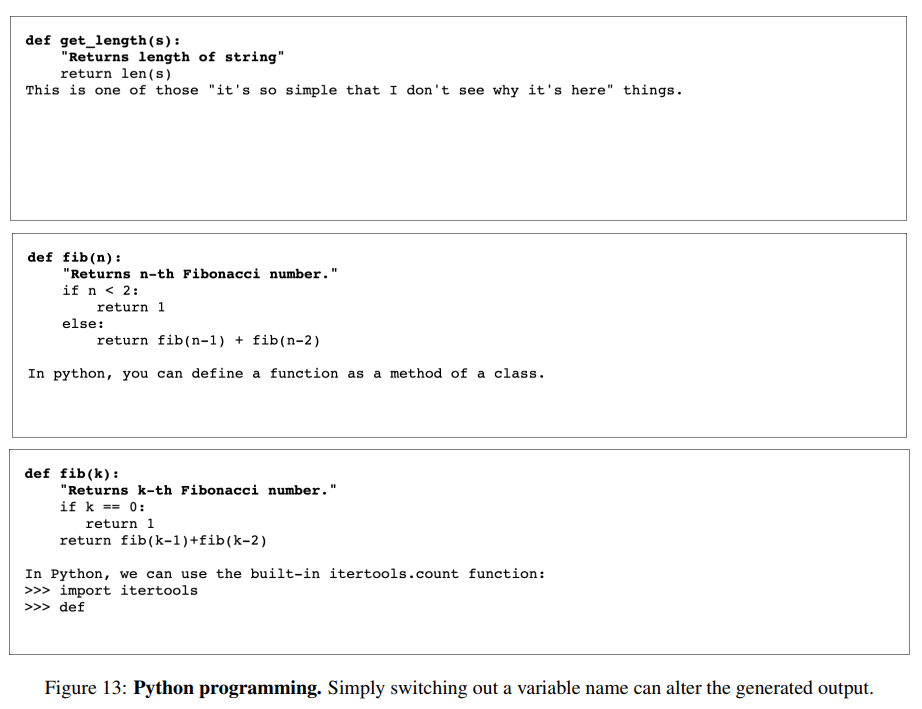

2.2.5 Learnung To Execute: LTE

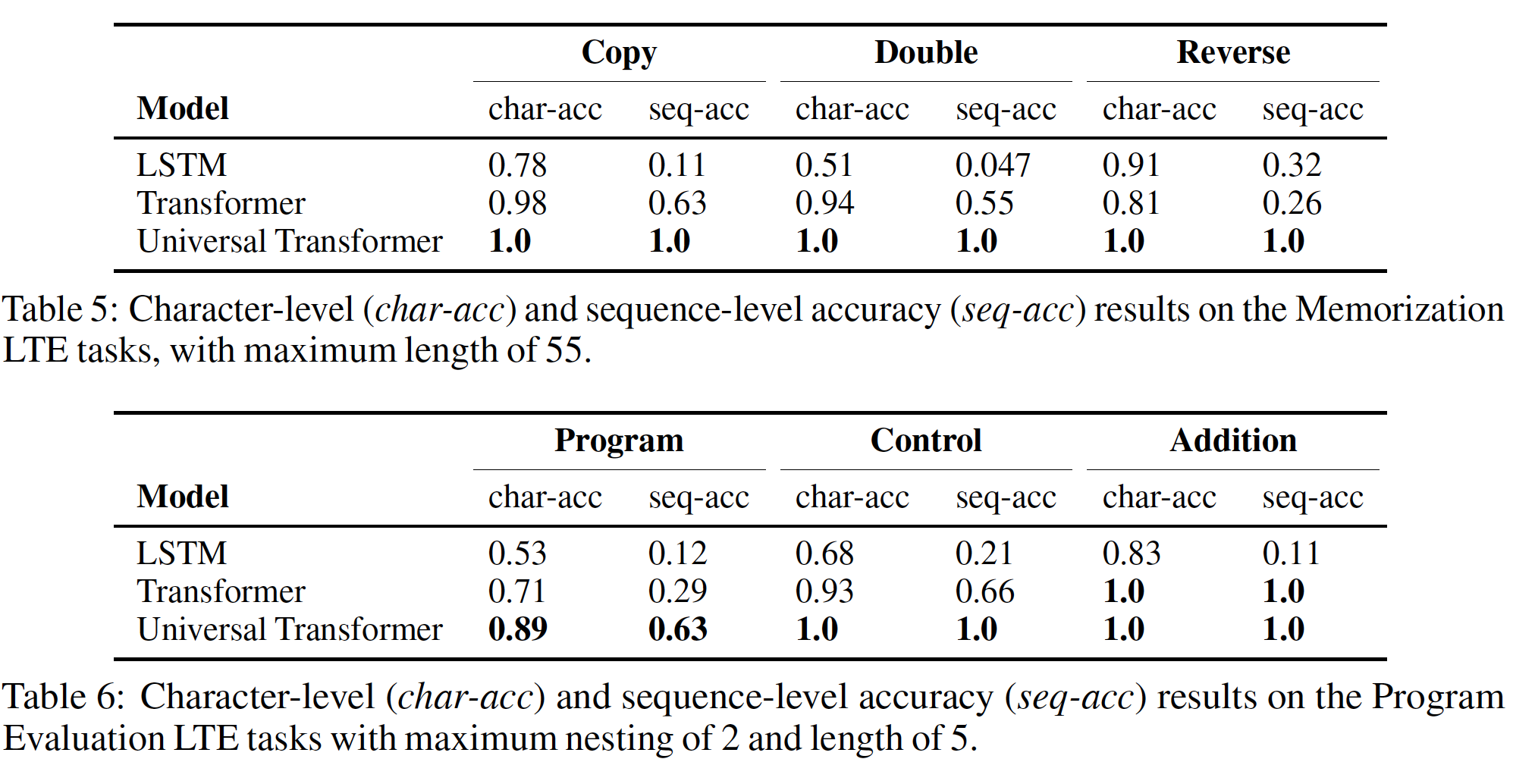

作为另一种

sequence-to-sequence learning问题,我们评估表明模型学习执行计算机程序的能力的任务。这些任务包括程序评估program evaluation任务(编程、控制和加法),以及记忆memorization任务(copy、double和reverse)。结果如下表所示,

Universal Transformer在所有任务上的表现都远远超过了LSTM和常规的Transformer。

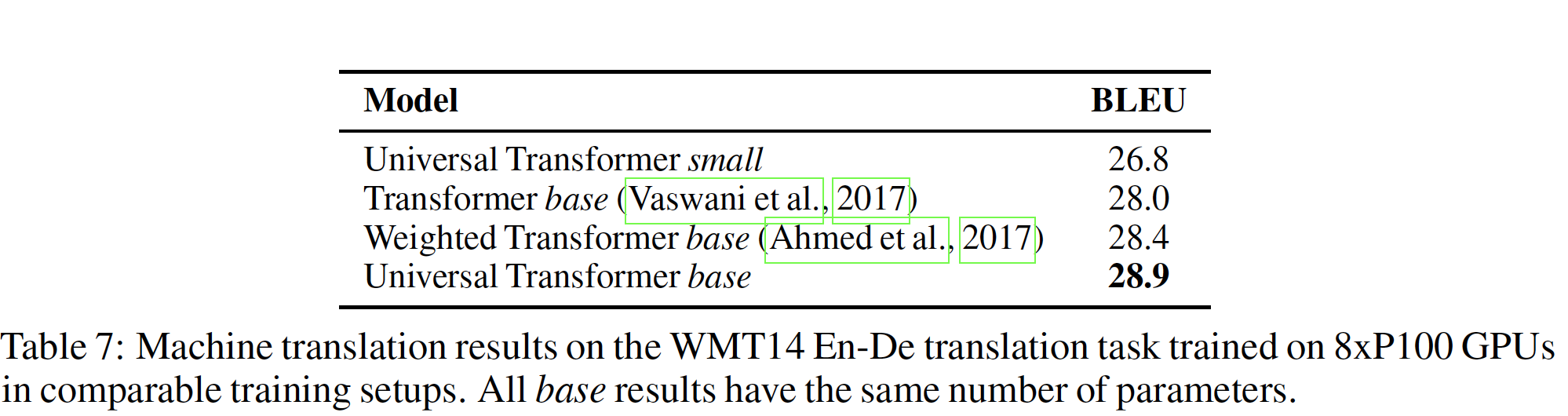

2.2.6 机器翻译

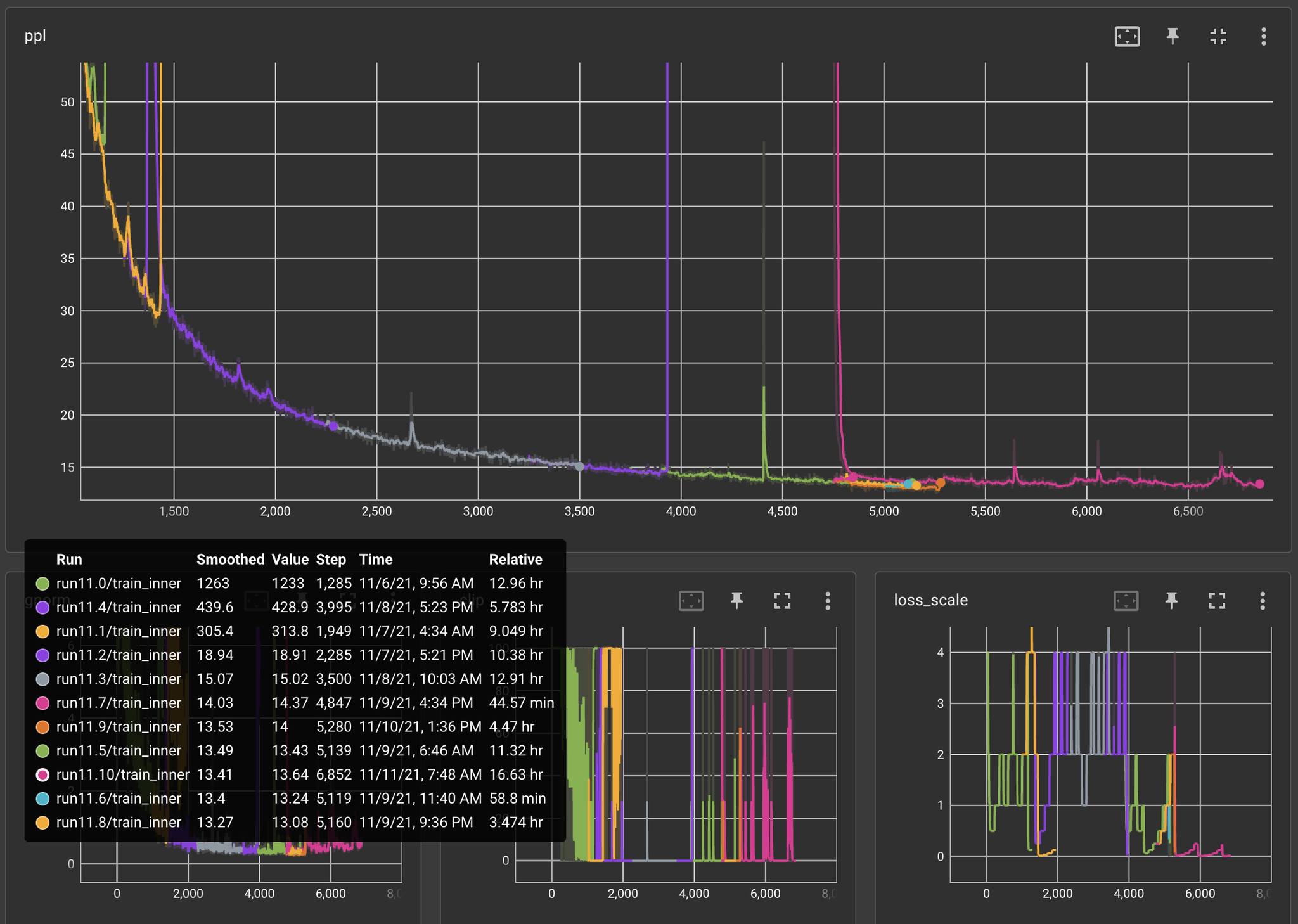

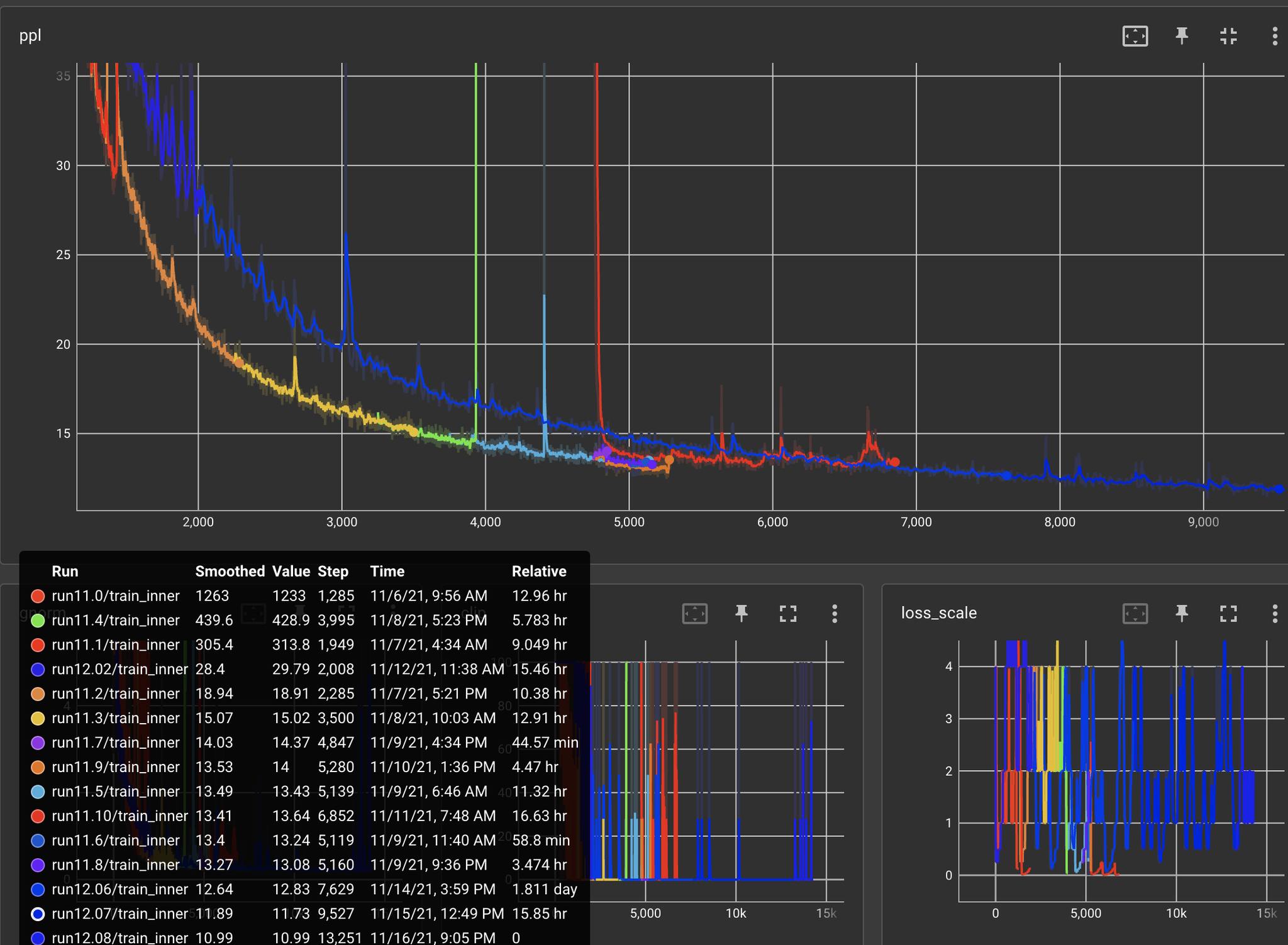

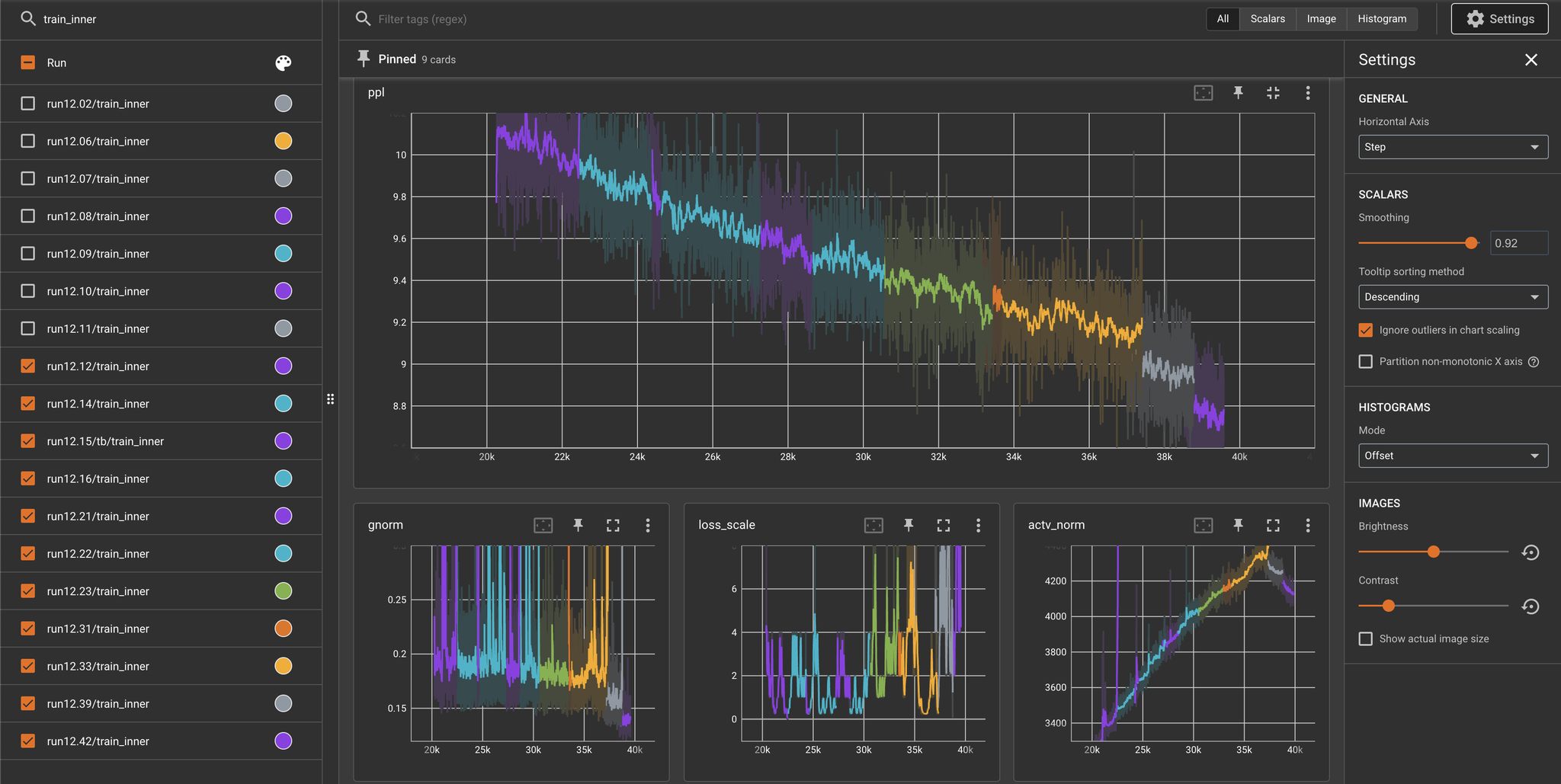

我们使用与

Transformer报告中相同的设置在WMT2014英德翻译任务上训练Universal Transformer,以评估其在大规模sequence-to-sequence任务上的性能。结果总结如下。采用前馈神经网络(而不是可分离卷积)作为转移函数且没有动态停机的Universal Transformer比Transformer提高了0.9 BLEU。根据作者在引言部分的介绍,如果采用动态停机,则会导致

Universal Transformer的效果更差。

三、Transformer-XL[2019]

尽管

RNN适应性很广,但是,由于梯度消失和爆炸导致RNN很难优化。在LSTM中引入门控和梯度裁剪技术可能不足以完全解决这一问题。从经验上看,以前的工作发现:LSTM语言模型平均使用200个context words,表明有进一步改进的空间。另一方面,注意力机制中的长距离

word pairs之间的直接联系可能会有助于优化,并学习长期依赖性。最近《Character-level language modeling with deeper self-attention》设计了一套辅助损失来训练深度Transformer网络从而用于character-level语言建模。该方法存在两个问题:- 尽管取得了成功,但该模型的训练是在几百个字符的分离的固定长度的

segment上进行的,没有跨segment的信息流。 由于固定的上下文长度,该模型无法捕捉到超出预定义上下文长度的任何长期依赖关系。 - 此外,固定长度的

segment是通过选择连续的符号块symbol chunk来创建的,没有考虑句子或任何其他语义边界。因此,该模型缺乏必要的上下文信息从而无法很好地预测前几个symbol,导致低效的优化和较差的性能。我们把这个问题称为上下文碎片化context fragmentation。

为了解决上述固定长度上下文的局限性,论文

《Transformer-XL: Attentive Language Models Beyond a Fixed-Length Context》提出了一个新的架构,叫做Transformer-XL(意为extra long)。论文将递归的概念引入deep self-attention network。具体而言,论文不是为每个新的segment从头开始计算hidden state,而是复用在previous segments中获得的hidden state。复用的hidden state用于current segment的memory,在前后segment之间建立了一个递归连接recurrent connection。因此,建立非常长期的依赖关系的模型成为可能,因为信息可以通过递归连接recurrent connection来传播。同时,从前一个segment传递信息也可以解决上下文碎片化的问题。RNN是在position之间构建递归,Universal Transformer是在depth之间构建递归,Transformer-XL是在segment之间构建递归。通常一个

segment代表一个样本,因此这也是样本之间构建递归。更重要的是,论文展示了使用相对位置编码

relative positional encoding而不是绝对位置编码absolute positional encoding的必要性,以便在不引起时间混乱的情况下实现状态重用state reuse。因此,作为一个额外的技术贡献,论文引入了一个简单但更有效的相对位置编码公式,该公式可以泛化到比训练期间看到的长度更长的序列。Transformer-XL在五个数据集上获得了强有力的结果,这些数据集从word-level语言建模到character-level语言建模。Transformer-XL还能够生成相对连贯的、数千个token的长篇文章。坤文的主要技术贡献包括:

- 在纯粹的自注意力模型

self-attention model中引入递归的概念。 - 推导出一个新颖的位置编码方案。

这两种技术构成了一套完整的解决方案,因为其中任何一个单独的技术都不能解决固定长度上下文的问题。

Transformer-XL是第一个在word-level语言建模到character-level语言建模上取得比RNN更好结果的自注意力模型。- 尽管取得了成功,但该模型的训练是在几百个字符的分离的固定长度的

相关工作:为了捕获语言建模中的长距离上下文,一系列工作直接将更宽上下文的

representation作为additional input输入到网络中。现有的工作有人工定义context representation的,也有依靠从数据中学到的document-level topic。例如,可以把非常长上下文的

sum word embedding作为额外的输入。更广泛地说,在通用序列建模中,如何捕获长期依赖性一直是一个长期研究问题。从这个角度来看,由于

LSTM的普适性,人们在缓解梯度消失问题上做了很多努力来有助于优化,包括更好的初始化、辅助损失、增强的记忆结构memory structure、以及其他的修改RNN内部结构的方法。与他们不同的是,我们的工作是基于Transformer架构的,并表明语言建模作为一个现实世界的任务,受益于学习长期依赖性的能力。

3.1 模型

给定一个

token序列language modeling的任务是估计联合概率其中

在这项工作中,我们坚持采用标准的神经网络方法来建模条件概率。具体而言:

- 一个神经网络将上下文

hidden state中。 - 然后将隐状态(一个向量)与每个单词的

word embedding相乘,从而得到一组logit。 - 将这组

logit馈入softmax函数,从而得到关于next token的离散概率分布。

- 一个神经网络将上下文

3.1.1 普通的 Transformer

为了将

Transformer或self-attention应用于语言建模,核心问题是如何训练Transformer从而将一个任意长的上下文有效地编码为固定尺寸的representation。理想的方法是用一个无条件的

Transformer来处理整个上下文序列,但是由于资源有限,这通常是不可行的。一个可行但粗糙的近似方法是:将整个语料库分割成规模可控的较短的

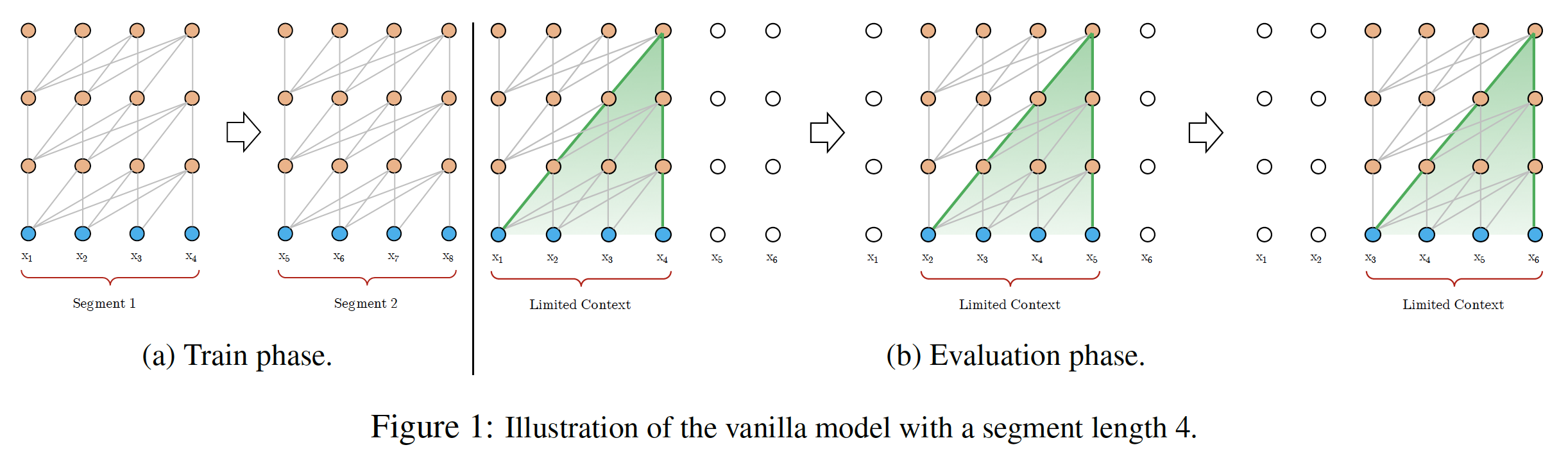

segment,只在每个segment内训练模型,忽略之前segment的所有上下文信息。我们称之为普通的Transformer模型,并在下图(a)中可视化。在这种训练范式下,信息在前向传播和反向传播过程中都不会跨segment流动。使用固定长度的上下文有两个关键限制:

- 首先,最大依赖长度被

segment长度所限。在character-level语言建模中,segment长度为几百。 - 其次,简单地将一个序列分割成固定长度的

segment将导致上下文碎片化问题。

在评估过程的每一步,普通的

Transformer模型也会消耗相同长度的segment(与训练segment长度相同),但仅在segment的最后一个位置做一个预测。然后在下一步,该segment只向右移动了一个位置,而新的segment必须从头开始计算,如图(b)所示。这个过程确保了每个预测都利用了最长的上下文,同时也缓解了训练中遇到的上下文碎片化问题。然而,这种评估过程是非常昂贵的。我们将表明:我们提出的架构能够大幅提高评估速度。注意:训练阶段和评估阶段有两个地方不一致:

segment移动的步长不一致:训练期间右移segment长度),验证期间右移一个位置。- 预测位置不一致:训练期间对

segment的每个位置进行预测,而验证期间仅对segment的最后一个位置进行预测。这是为了和segment移动步长相匹配,使得每个位置仅进行一次预测。

之所以训练期间

segment移动步长更大,个人猜测是为了降低训练样本量。假设segment长度固定为epoch中每个token会出现一次;如果移动步长为1,则每个训练epoch中每个token会出现

- 首先,最大依赖长度被

3.1.2 Segment-Level Recurrence

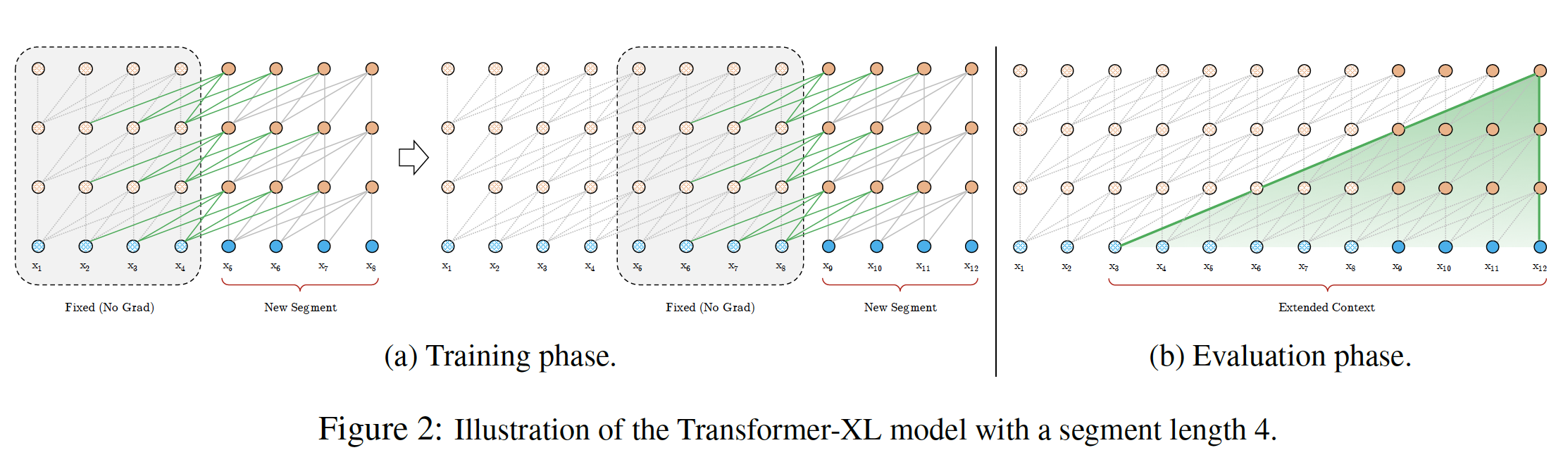

为了解决使用固定长度上下文的局限性,我们建议在

Transformer架构中引入一个递归机制。在训练过程中,固定前一个segment计算好的hidden state序列,并在处理next segment时作为扩展上下文extended context来重用,如下图(a)所示(图中的绿色路径表示扩展上下文)。尽管反向传播仍然保持在一个

segment内,但这个额外的输入(即,前一个segment的hidden state序列 )允许网络利用历史信息,导致了对长期依赖性的建模能力,并避免了上下文碎片化。注意:

- 在训练过程中,前一个

segment的hidden state序列被冻住,不再更新它们的状态(前向传播)以及梯度(反向传播)。 - 对于前一个

segment,需要考虑每一层的hidden state序列(而不仅仅是最后一层)。

- 在训练过程中,前一个

具体而言,假设长度为

segment为:记

hidden state序列为:hidden statehidden state维度。那么hidden state序列的计算过程为:拼接第

stop-gradient,hidden state序列。生成

query, key, value:注意:

query用当前segment的上下文,而key/value用扩展的上下文。这是因为我们只需要计算当前segment的representation,这对应于query的形状。计算第

hidden state序列:

与标准的

Transformer相比,关键的区别在于:keyvaluesegment缓存的。我们通过上图(a)中的绿色路径来强调这一特殊设计。由于这种递归机制应用于语料库的每两个连续的segment,因此它在hidden state中创造了一个segment-level的递归。因此,有效利用的上下文可以远远超过两个segment。这对于

batch的组织是一个挑战,要求前后两个样本之间是连续的,并且不能随机选择样本。请注意,连续两个

segment之间,RNN语言模型中的同层递归不同。因此,最大可能的依赖长度与网络层数、segment长度呈线性增长,即(b)中的阴影区域所示,这里segment长度。对于同层递归,则

segment-Level递归类似于截断的BPTT(用于训练RNN语言模型)。然而,与截断的BPTT不同的是:我们的方法缓存了hidden state的一个序列,而不仅仅是最后一个hidden state,并且应该与相对位置编码技术一起应用。注意,

segment-Level递归对于每一层,都需要缓存hidden state的一个序列。除了实现超长上下文和解决上下文碎片化问题,递归方案带来的另一个好处是评估速度明显加快。具体而言,在评估过程中,先前的

segment的representation可以被重用,而不是像普通Transformer那样从头开始计算。在我们对enwiki8的实验中,Transformer-XL在评估过程中比普通Transformer模型快1800多倍。

最后,请注意,递归方案不仅限于前面一个

segment。理论上,我们可以在GPU内存允许的范围内缓存尽可能多的previous segments,并在处理当前segment时复用所有这些segment作为额外的上下文。因此,我们可以缓存一个长度为old hidden state序列,跨越(可能)多个segment,并将它们称为memory总的上下文长度为

在我们的实验中,我们在训练时将

segment长度segment长度segment,上下文长度这里在训练期间和评估期间采用不同的上下文长度,会不会影响评估效果?毕竟训练数据分布和测试数据分布人为地导致了不一致(总的上下文长度不一致)。

3.1.3 Relative Positional Encoding

为了重用前面

segment的hidden state,有一个关键的技术挑战我们还没有解决:如何保持位置信息的一致性?在标准的

Transformer中,序列顺序的信息是由一组位置编码positional encoding来提供的,表示为segment内第hidden state序列的计算方式为:其中:

segmentword embedding,input。

unseen的序列长度。注意,

为解决这个问题,基本的想法是相对位置编码。从概念上讲,位置编码给了模型一个关于如何收集信息的时间线索或 "

bias",也就是说,关注attend哪个地方。以相对的方式来定义时间bias是更直观和更可泛化的。例如,当一个query向量key向量key向量的绝对位置来识别segment的时间顺序,只要知道每个key向量实际上,人们可以创建一组相对位置编码

attention score,query向量可以很容易地根据不同距离区分出representation,使状态重用机制变得可行。同时,我们不会丢失任何时间信息,因为绝对位置可以从相对距离中递归恢复。此前,相对位置编码的想法已经在机器翻译和音乐生成任务中得到了探索。在这里,我们提供了一种不同的编码形式,它不仅与绝对位置编码有一一对应关系,而且在经验上也具有更好的泛化性。

首先,在标准的

Transformer中,同一个segment中的注意力得分可以分解为:其中:

embedding向量,positional embedding,query的投影矩阵,key的投影矩阵。然后,按照仅依赖于相对位置信息的思路,我们建议重写上述四项为:

一种更简单直接的改写方式为:

第一个改变是用相对位置编码

(b)和(d)中的绝对位置编码实际上,绝对位置在一些任务中也同样重要,例如:句子里的第一个位置和最后一个位置都比较重要,可能包含特殊的语义。

其次,我们引入一个可训练的参数

(c)中的query向量对所有的query position都是相同的,因此这表明无论query position如何,对不同的单词的attentive bias应该保持不变。类似地,我们引入一个可训练的参数

(d)中的query position如何,对不同相对位置的attentive bias应该保持不变。在绝对位置编码中,

query的位置、key的位置都很重要,因此需要两个positional embedding在绝对位置编码中,只有

query和key的相对位置的编码才重要,因此只有一个positional embedding最后,我们特意将两个权重矩阵

content-based和location-based的key向量。content-based和location-based的attentive bias向量。

在相对位置编码中,每一项都有直观的含义:

addressing。positional bias。content bias。positional bias。

相比之下,

《Self-attention with relative position representations》仅考虑了(a), (b)两项,放弃了(c), (d)两个bias项。此外,《Self-attention with relative position representations》将inductive bias。相比之下,我们的relative positional embedding将

segment-level递归与我们提出的relative positional embedding相结合,我们最终得到了Transformer-XL架构。注意,为了计算所有的

pair但是为了计算

3.2 实验

3.2.1 实验结果

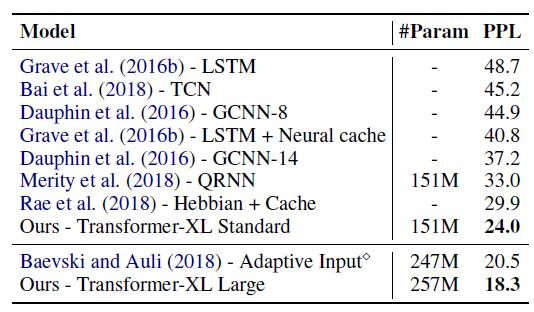

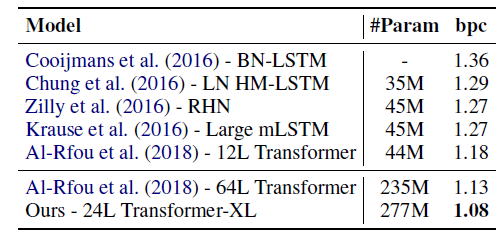

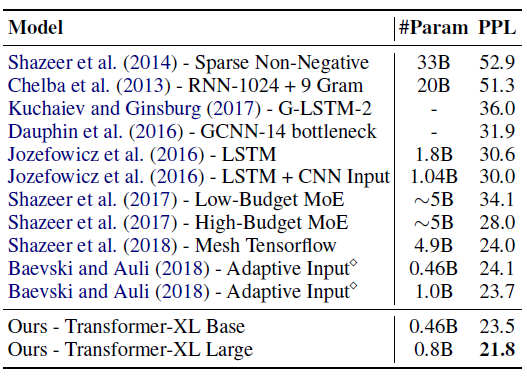

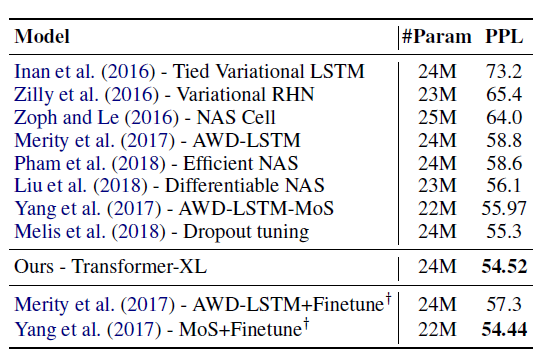

这里比较不同数据集上语言建模的效果,评估指标为困惑度

perplexity: PPL。WikiText-103数据集:现有最大的具有长期依赖性的word-level语言建模benchmark。它包含了来自28K篇文章的1.03亿个训练token,每篇文章的平均长度为3.6K个token,这可以测试建模长期依赖的能力。我们将训练时的注意力长度 (即,

384,评估时设定为1600。如下表所示,Transformer-XL超越了之前的SOTA,将困惑度从20.5降低到18.3。

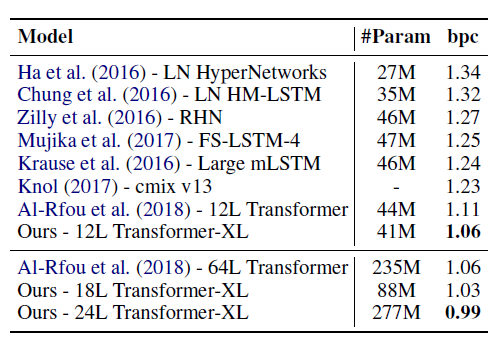

enwik8数据集:包含1亿字节的未处理的维基百科文本。24层的Transformer-XL取得了新的SOTA结果。训练时注意力长度为784,评估时注意力长度为3800。

text8数据集:包含1亿个经过处理的维基百科字符,这些字符是通过转换为小写字母并删除[a ~ z]以及空格以外的任何字符而创建的。同样地,

24层的Transformer-XL(超参数与enwik8中的相同)取得了新的SOTA结果。

One Billion Word数据集:没有保留任何长期的依赖性,因为句子已经被混洗过了。因此,这个数据集主要测试了只对短期依赖关系进行建模的能力。尽管

Transformer-XL主要是为了更好地捕捉长期依赖性,但它极大地提高了单个模型的SOTA。

Penn Treebank数据集:包含1百万token,用于验证模型在小数据集上的表现。我们对

Transformer-XL采用了variational dropout和weight average。通过适当的正则化,Transformer-XL在没有预训练和微调的模型中取得了新的SOTA结果。

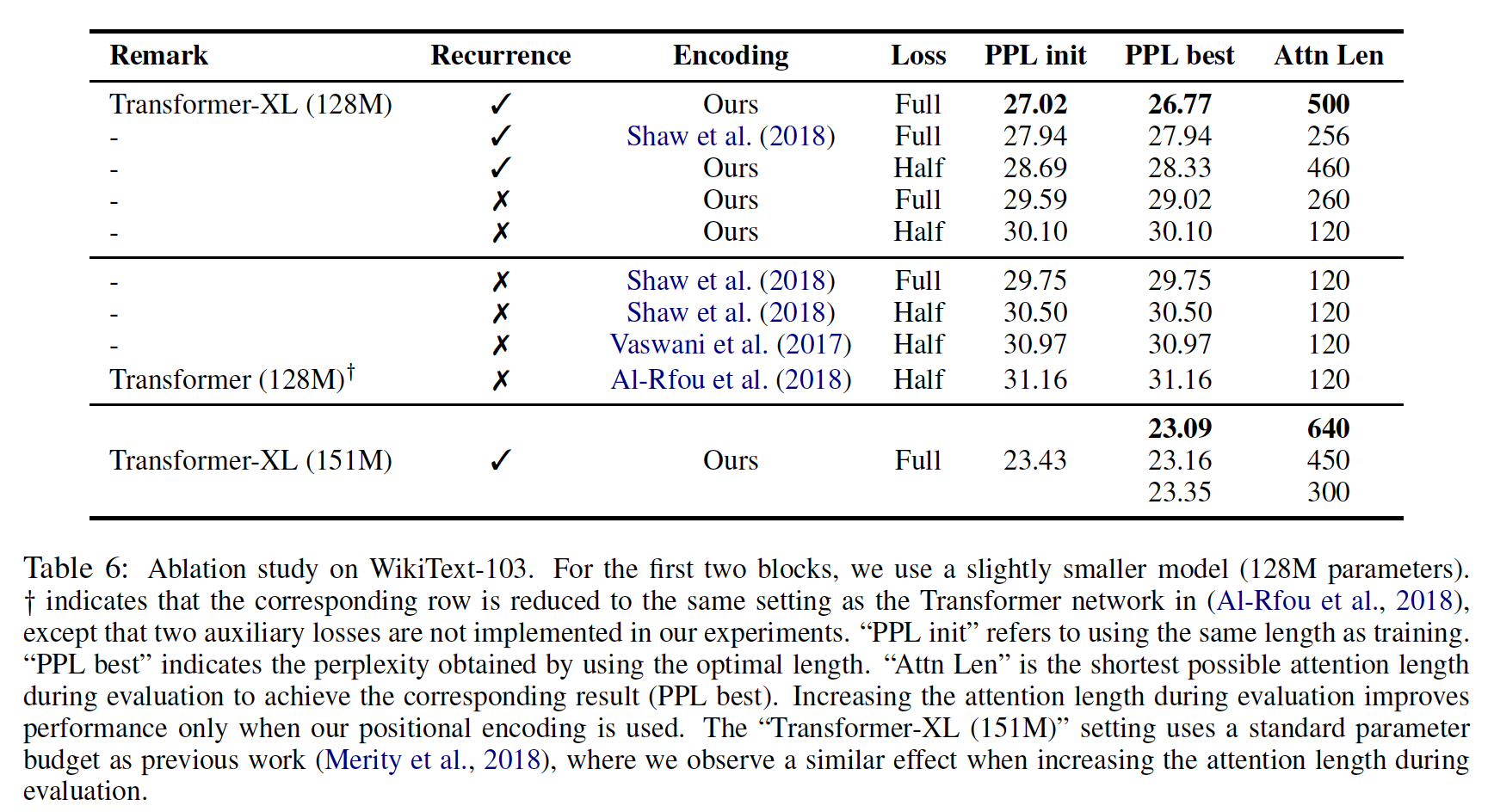

3.2.2 消融研究

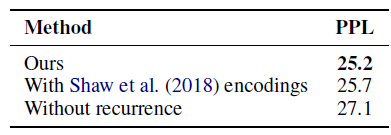

解决长期依赖问题:我们在

WikiText-103上进行研究,这需要建模长期依赖性。结果如下所示。在比较的编码方案中,

Shaw et al. (2018)(《Self-attention with relative position representations》)是相对位置编码,而Vaswani et al. (2017)(《Attention is all you need》)和Al-Rfou et al. (2018)(《Character-level language modeling with deeper self-attention》)是绝对位置编码。Ful/Half损失指的是:对segment中所有位置/最近的一半位置计算交叉熵。我们发现,绝对位置编码只有在Half损失的情况下才能很好地工作,因为Half损失在训练中排除了注意力长度很短的位置,从而获得更好的泛化。PPL init表示评估时使用与训练长度相同的注意力长度;PPL best表示评估时使用最佳注意力长度(由Attn Len列给出)时的结果。结论:

- 递归机制和相对位置编码方案都是实现最佳性能的必要条件。虽然训练期间的反向传播长度只有

128,但通过这两种技术,在测试期间注意力长度可以增加到640。 - 在

151M参数的Transformer-XL中,测试期间,困惑度随着注意力长度的增加而减少。

- 递归机制和相对位置编码方案都是实现最佳性能的必要条件。虽然训练期间的反向传播长度只有

解决上下文碎片化问题:我们特意选择了一个不需要长期依赖的数据集,这样一来,递归机制的任何改进都可以归因于解决了上下文碎片化问题。具体来说,我们在

One Billion Word数据集上进行实验,它只能从消除上下文碎片中受益。结论:

- 即使在不需要长期依赖的情况下,使用

segment-level递归机制也能大幅提高性能。这与我们之前的讨论一致,即递归机制解决了上下文碎片化问题。 - 我们的相对位置编码在短序列上也优于

Shaw et al. (2018)(《Self-attention with relative position representations》)。

- 即使在不需要长期依赖的情况下,使用

3.2.3 其它

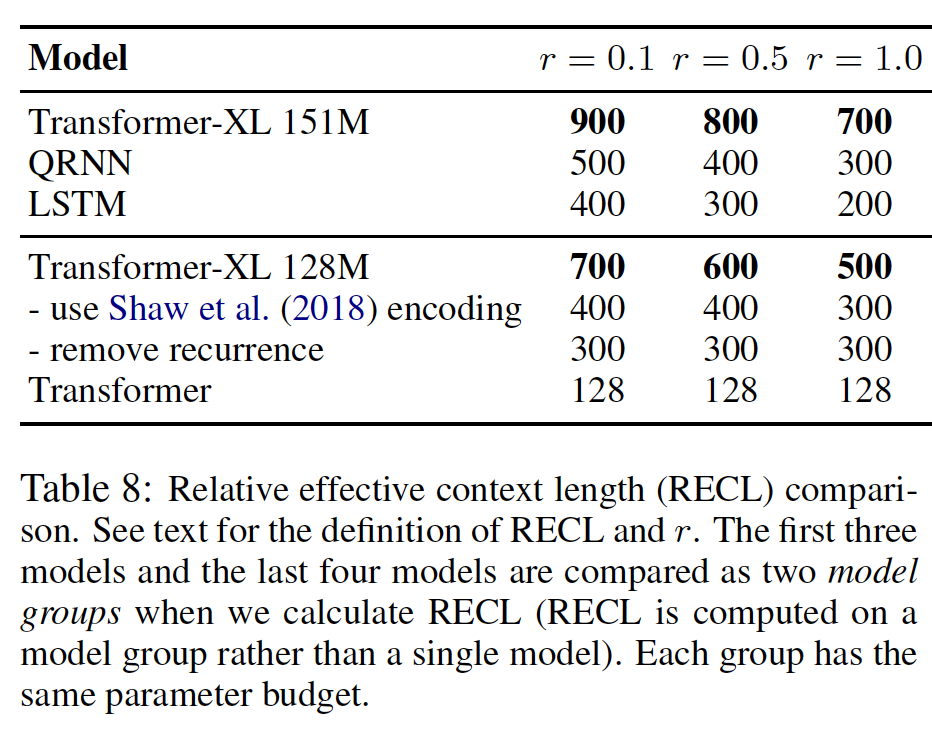

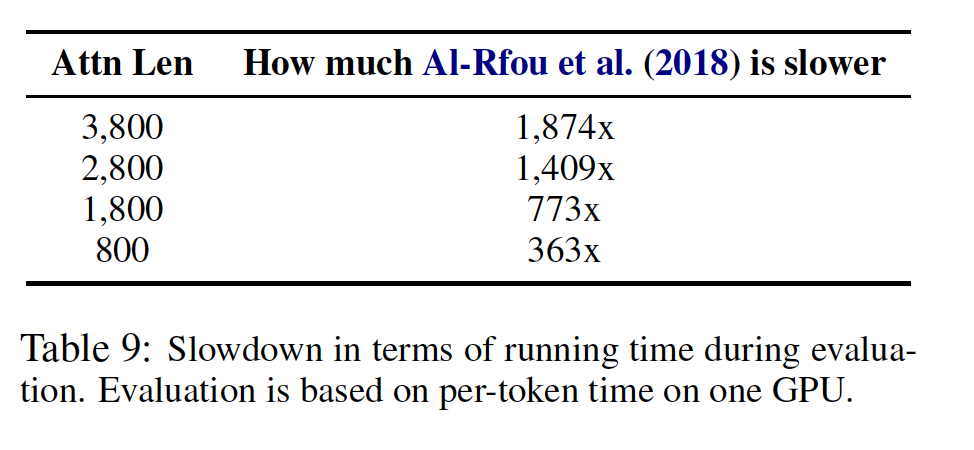

相对有效长度

Relative Effective Context Length:Transformer-XL具有最大的相对有效长度。相对有效长度的定义参考原始论文。

文本生成:在

WikiText-103上训练。参考原始论文的附录。评估速度:由于状态重用,

Transformer-XL在评估时可以达到相比普通Transformer快1874倍的速度。

四、GPT1[2018]

从原始文本中有效学习的能力,可以大大缓解

NLP中对监督学习的依赖。大多数深度学习方法需要大量手动标记的数据,这限制了它们应用于许多缺乏标注资源的领域。在这些情况下,那些可以利用语言信息(这些语言信息来自于未标记数据)的模型,它们提供了一种有价值的替代方法从而免于收集更多标注数据(后者可能既耗时又昂贵)。此外,即使在有大量监督数据可用的情况下,以无监督的方式学习良好的representation也可以显著提高性能。迄今为止,最令人信服的证据是广泛使用预训练的word emebdding来提高一系列NLP任务的性能。然而,利用来自未标记文本的

word-level信息以外的信息具有挑战性,主要有两个原因:首先,尚不清楚哪种类型的优化目标在学习对迁移有用的

text representation方面最有效。最近的研究着眼于各种目标,如语言建模language modeling、机器翻译machine translation、篇章连贯性discourse coherence,每种方法在不同任务上的表现都优于其它方法。即,如何获得

text representation?其次,对于将这些学到的

repersentation迁移到目标任务的最有效方法没有达成共识。现有的技术涉及对模型架构进行task-specific修改、使用复杂的学习方案、添加辅助学习目标等等方法的组合。即,如何迁移

text representation?

这些不确定性使得为语言处理

language processing开发有效的半监督学习方法变得困难。在论文

《Improving Language Understanding by Generative Pre-Training》中,作者为语言理解任务language understanding task探索了一种结合无监督预训练unsupervised pre-training和监督微调supervised fine-tuning的半监督方法,即Generative Pre-Training: GPT。GPT的目标是学习一种通用representation,该representation只需要很少的适配adaption就可以迁移到广泛的任务。作者假设可以访问大量未标记文本的语料库、以及若干个标记数据集(这些数据集包含人工标注的训练样本,即target task)。GPT的setup不要求这些目标任务与未标记语料库位于同一个domain中。GPT采用两阶段的训练过程:- 首先,

GPT对未标记的数据使用语言建模目标language modeling objective来学习神经网络模型的初始参数。 - 然后,

GPT使用相应的监督目标使这些参数适配目标任务。

作者使用

Transformer来作为GPT的模型架构,其中Transformer已被证明在机器翻译machine translation、文档生成document generation、句法解析syntactic parsing等各种任务上表现出色。与RNN等替代方案相比,Transformer为GPT提供了更结构化的内存more structured memory来处理文本中的长期依赖,从而在多样化diverse的任务中实现鲁棒的迁移性能。在迁移过程中,作者利用源自

traversal-style方法的task-specific的输入适配input adaption,将结构化的文本输入处理为token的一个连续序列。正如作者在实验中所证明的那样,这些适配使得GPT能够有效地微调,而只需对预训练模型的架构进行最小的调整。作者在四种类型的语言理解任务上评估了

GPT:自然语言推理natural language inference、问答question answering、语义相似性semantic similarity、文本分类text classification。论文的通用任务无关模型general task-agnostic model超越了那些采用专门为每个任务设计架构的模型,在所研究的12个任务中的9个中显著提高了state-of-the-art。例如:GPT在常识推理commonsense reasoning(Stories Cloze Test数据集)上实现了8.9%的绝对提升。GPT在问答(RACE数据集)上实现了5.7%的绝对提升。GPT在在文本蕴含textual entailment(MultiNLI数据集)上实现了1.5%的绝对提升。GPT在最近引入的GLUE多任务benchmark上实现了5.5%的绝对提升。

作者还分析了预训练模型在四种不同

setting下的zero-shot行为,并证明预训练模型为下游任务获得了有用的语言知识。相关工作:

用于

NLP的半监督学习:我们的工作大致属于自然语言的半监督学习的类别。这种范式引起了人们的极大兴趣,并被应用到序列标记sequence labeling、文本分类等任务。- 最早的方法使用未标记的数据来计算

word-level或phrase-level的统计量,然后将其用作监督模型中的特征(《Semi-supervised learning for natural language》)。 - 在过去的几年中,研究人员已经证明了使用在未标记语料库上训练的

word embedding(《Natural language processing(almost) from scratch》、《Distributed representations of words and phrases and their compositionality》、《Glove: Global vectors for word representation》)来提高各种任务的性能的好处。

然而,这些方法主要是迁移

word-level信息,而我们的目标是捕获更高level的语义。最近的方法已经研究了从未标记的数据中学习和利用不仅限于

word-level语义的信息。可以从未标记的语料库中训练phrase-level或sentence-level,从而用于将文本编码为适合各种目标任务的vector representation,如:《Skip-thought vectors》、《Distributed representations of sentences and documents》、《A simple but tough-to-beat baseline for sentence embeddings》、《An efficient framework for learning sentence representations》、《Discourse-based objectives for fast unsupervised sentence representation learning》、《Supervised learning of universal sentence representations from natural language inference data》、《Learning general purpose distributed sentence representations via large scale multi-task learning》、《Unsupervised machine translation using monolingual corpora only》。- 最早的方法使用未标记的数据来计算

无监督预训练:无监督预训练是半监督学习的一种特殊情况,其目标是找到一个好的初始化点,而不是修改监督学习目标。

早期的工作探索了该技术在图像分类和回归任务中的应用。随后的研究表明(

《Why does unsupervised pre-training help deep learning?》),预训练作为一种正则化方案,可以在深度神经网络中实现更好的泛化。在最近的工作中,该方法已被用于帮助在各种任务上训练神经网络,如图像分类image classification、语音识别speech recognition、实体消岐entity disambiguation、机器翻译machine translation等。与我们最接近的工作包括使用语言建模目标

language modeling objective对神经网络进行预训练pre-training,然后在下游带监督的目标任务上进行微调fine-tuning。《Semi-supervised sequence learning》和《Universal language model fine-tuning for text classification》遵循这种方法来改进文本分类。然而,尽管预训练阶段有助于捕获一些语言信息,但由于它们使用的是LSTM模型,从而使得它们的预测能力限制在一个短的范围short range(因为LSTM的局限性,无法捕获长期依赖)。相比之下,我们选择的

transformer网络使得我们能够捕获更长范围longer range的语言结构,如我们的实验所示。此外,我们还展示了我们的模型在更广泛的任务上的有效性,包括自然语言推理natural language inference、复述检测paraphrase detection(也叫语义相似性)、故事补全story completion。其它一些方法使用来自预训练语言模型或机器翻译模型的

hidden representation作为辅助特征,同时在目标任务上训练监督模型(《Semi-supervised sequence tagging with bidirectional language models》、《Deep contextualized word representations》、《Learned in translation: Contextualized word vectors》)。这涉及到每个单独的目标任务的大量新参数,而我们的方法在迁移过程中只需要对模型架构进行最小化的调整。

辅助训练目标:添加辅助的无监督训练目标是半监督学习的另一种形式。

- 早期工作

《A unified architecture for natural language processing: Deep neural networks with multitask learning》使用各种辅助NLP任务(如词性标注POS tagging、分块chunking、命名实体识别named entity recognition、语言建模language modeling)来改进语义角色标注semantic role labeling。 - 最近,

《Semi-supervised multitask learning for sequence labeling》在其target task objective中添加了辅助语言建模目标,并展示了序列标注任务的性能提升。

我们的实验也使用辅助目标,但正如我们所展示的那样,无监督的预训练已经学习了与目标任务相关的几个

linguistic aspect。- 早期工作

4.1 模型

我们的训练过程分为两个阶段:

- 第一个阶段是在大型文本语料库上学习

high-capacity的语言模型。 - 第二个阶段是在下游监督目标任务上执行微调,其中我们将模型针对带标签的

discriminative task进行适配。

- 第一个阶段是在大型文本语料库上学习

无监督预训练:给定

token集合为likelihood:其中:

context window的大小,条件概率

这是一种自回归模型,只能看到历史信息而无法看到整个序列信息。

在我们的实验中,我们使用

multi-layer Transformer decoder作为语言模型,这是transformer的一种变体。该模型对输入的context tokens应用多头自注意力操作multi-head self-attention operation,然后应用position-wise feed-forward层从而在目标token上生成输出分布:其中:

contect vector,one-hot向量。token embedding矩阵,positional embedding matrix,embedding维度。representation。

监督微调:使用

token的一个序列input经过我们的预训练模型获得final transformer块的激活这为我们提供了以下最大化目标:

我们还发现,将语言建模作为微调的辅助目标来微调有助于学习,因为:该辅助目标提高监督模型的泛化能力,以及该辅助目标加速训练的收敛。这与之前的工作一致(

《Semi-supervised multitask learning for sequence labeling》、《Semi-supervised sequence tagging with bidirectional language models》),他们也观察到使用这种辅助目标可以提高性能。具体而言,我们优化了以下目标:

其中

总体而言,我们在微调期间唯一需要的额外参数是

delimiter token的embedding(delimiter token是一些人工添加的分隔符,如start token、end token等等,参考输入转换部分的内容)。预训练的语言模型一方面作为微调的初始化,另一方面也作为微调的辅助损失函数。

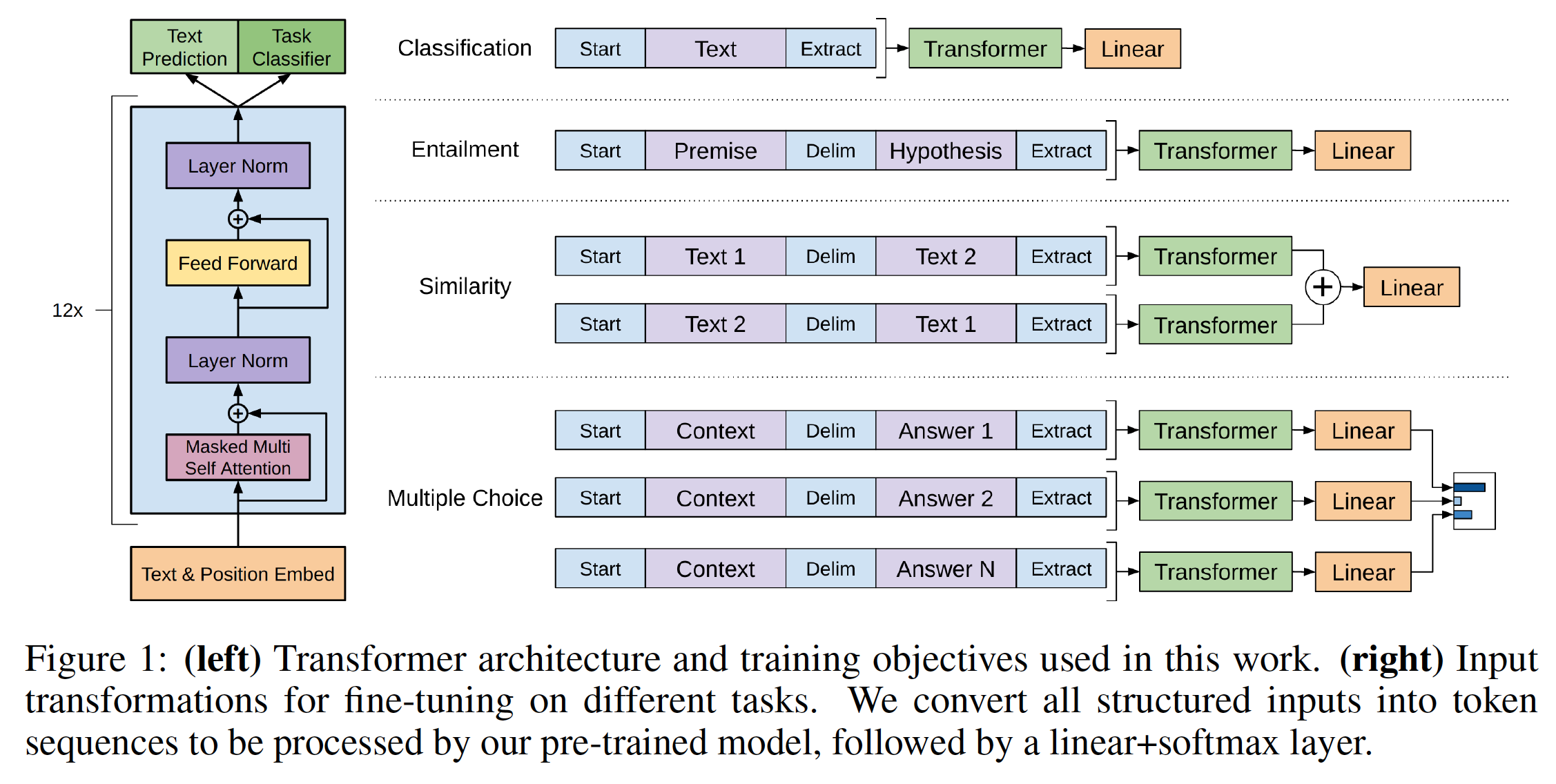

Task-specific输入转换input transformation:对于某些任务(如文本分类),我们可以如上所述直接微调我们的模型。某些其它任务(如问答或文本蕴含)具有结构化输入,例如有序的sentence pair、或者(document, question, answers)三元组。由于我们的预训练模型是针对连续的文本序列进行训练的,因此我们需要进行一些修改才能将预训练模型应用于这些任务。先前的工作提出:将任务特定的架构作用于被迁移学习的

representation之上(ELMo)。这种方法重新引入了大量特定于任务的定制化customization,并且未对这些额外的架构组件使用迁移学习。相反,我们使用traversal-style方法(《Reasoning about entailment with neural attention》),将结构化输入转换为我们的预训练模型可以处理的有序序列。这些输入转换使我们能够避免跨任务对架构进行大量修改。我们在下面提供了这些输入转换的简要描述,下图提供了可视化说明。所有转换都包括添加随机初始化的start tokenend token下图中的

Extract就是end token。文本蕴含

textual entailment:对于文本蕴含任务,我们拼接前提premise(p) 和假设hypothesis(h)的token序列,中间用delimiter token($) 来分隔。相似性

Similarity:对于相似性任务,被比较的两个句子之间没有固有的顺序。为了反映这一点,我们修改输入序列从而同时包含两种可能的句子排序(中间有一个delimiter token),并独立处理每个输入序列从而得到两个sequence representation。然后我们将这两个sequence representation执行逐元素相加,并馈入到线性输出层。sum池化等价于均值池化,这里是否可以选择max池化?可以通过实验来验证。问答和常识推理

Question Answering and Commonsense Reasoning:对于这些任务,我们被给定一个上下文的document(z)、一个问题q、一组可能的回答delimiter token从而得到序列softmax层进行归一化,从而在可能的答案上生成输出分布。注意:这里直接拼接了上下文文档和问题,并没有在它们之间添加

delimiter token。个人猜测这是为了区分问题和答案,而没必要区分问题和文档,因为问题可以作为文档的最后一句话。

4.2 实验

无监督预训练语料库:我们使用

BooksCorpus数据集来训练语言模型。BooksCorpus数据集包含来自各种风格的7k多本unique的未出版书籍,包括Adventure, Fantasy, Romance等风格。至关重要的是,它包含长篇连续的文本,这使得生成模型能够学会以长距离信息long-range information为条件。另一个候选数据集是

1B Word Benchmark,它被一个类似的方法ELMo所使用的,其规模与BooksCorpus大致相同。但是,1B Word Benchmark在sentence level上进行了混洗,这破坏了long-range结构。我们的语言模型在这个语料库上实现了非常差的token level perplexity(即18.4)。模型配置:我们的模型很大程度上遵循了原始的

transformer工作。- 我们训练了一个

12层的ecoder-only transformer,其中带有masked self-attention head(768维的状态state,12个注意力头)。对于position-wise feed-forward网络,我们使用3072维的inner state。 - 我们使用

Adam优化器,最大学习率为2000个step,学习率从零线性地增加到最大学习率,然后使用余弦方案退火到0。 - 我们训练

100个epoch,采用随机采样的mini-batch,batch size = 64,每个样本都是包含512个连续token的一个序列。 - 由于

layernorm在整个模型中被广泛使用,一个简单的正态分布 - 我们使用一个具有

40k merges的byte-pair encoding (BPE) vocabulary。 - 我们为

residual、embedding、attention应用rate = 0.1的dropout从而用于正则化。我们还采用了《Fixing weight decay regularization in adam》中提出的L2正则化的一个修订版,其中在所有non bias or gain weights上使用 - 对于激活函数,我们使用

Gaussian Error Linear Unit: GELU。 - 我们使用可学习的

positional embedding而不是原始工作中提出的正弦版本。 - 我们使用

ftfy library来清理BooksCorpus中的原始文本,规范一些标点符号和空白符,并使用spaCy tokenizer。

- 我们训练了一个

微调配置:除非特别说明,否则我们重用无监督预训练中的超参数配置。

- 我们在

classifier中加入rate = 0.1的dropout。 - 对于大多数任务,我们使用

batch size = 32。 - 我们使用一个线性衰减的学习率调度,

warmup超过0.2%的训练step。 - 我们的模型微调期间收敛很快,

3个epoch的训练对大多数情况而言就足够了。 - 超参数

0.5。

- 我们在

4.2.1 监督微调

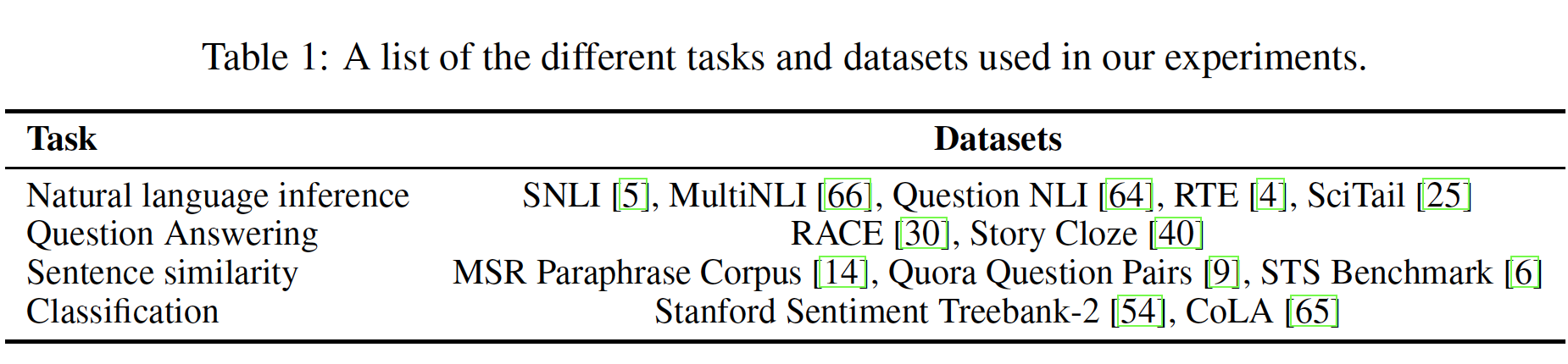

我们对各种监督任务进行了实验,包括自然语言推理、问答、语义相似性、文本分类。其中的一些任务是作为最近发布的

GLUE multi-task benchmark的一部分,我们这里也使用了这个benchmark。实验的任务及其对应的数据集如下表所示。

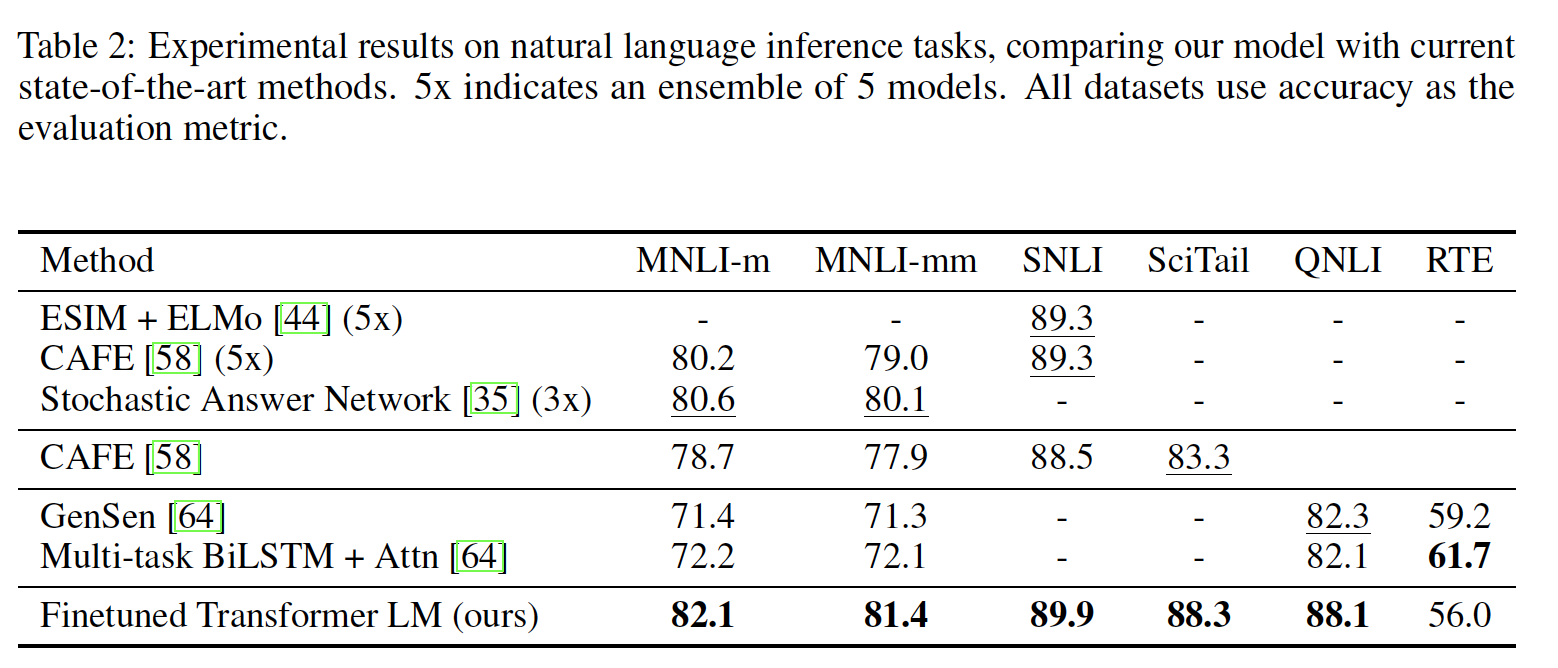

自然语言推理

Natural Language Inference: NLI:该任务也被称作识别文本蕴含,它读取一对句子并判断它们之间的关系是蕴含entailment、冲突contradiction、还是中性neutral。尽管最近有很多学者对此感兴趣,但是由于存在各种各样的现象(如,词法蕴含lexical entailment、共指coreference、词法和句法歧义lexical and syntactic ambiguity),这项任务仍然具有挑战性。我们在五个多样化的数据集上进行评估,包括:

SNLI数据集:包含图像标题image caption。MNLI数据集:包含转录的语音transcribed speech、流行小说popular fiction、和政府报告government report。QNLI数据集:包含维基百科文章Wikipedia article。SciTail数据集:包含科学考试science exam。RTE数据集:新闻文章news article。

下表详细列出了我们的模型和以前

state-of-the-art方法在不同的NLI任务的各种结果。可以看到:- 我们的方法在五个数据集中的四个数据集上的表现显著优于

baseline。与之前的最佳结果相比,在MNLI上取得了高达1.5%的绝对改进,在SciTail上为5%,在QNLI上为5.8%,在SNLI上为0.6%。这证明了我们的模型能够更好地对多个句子进行推理,并处理语言歧义linguistic ambiguity的问题。 - 在

RTE数据集上(我们所评估的较小的数据集,只有2490个样本),我们取得了56%的准确率,这低于多任务biLSTM模型所报告的61.7%。鉴于我们的方法在较大的NLI数据集上的强大性能,我们的模型很可能也会从多任务训练中收益,但是我们目前还没有对此进行探索。

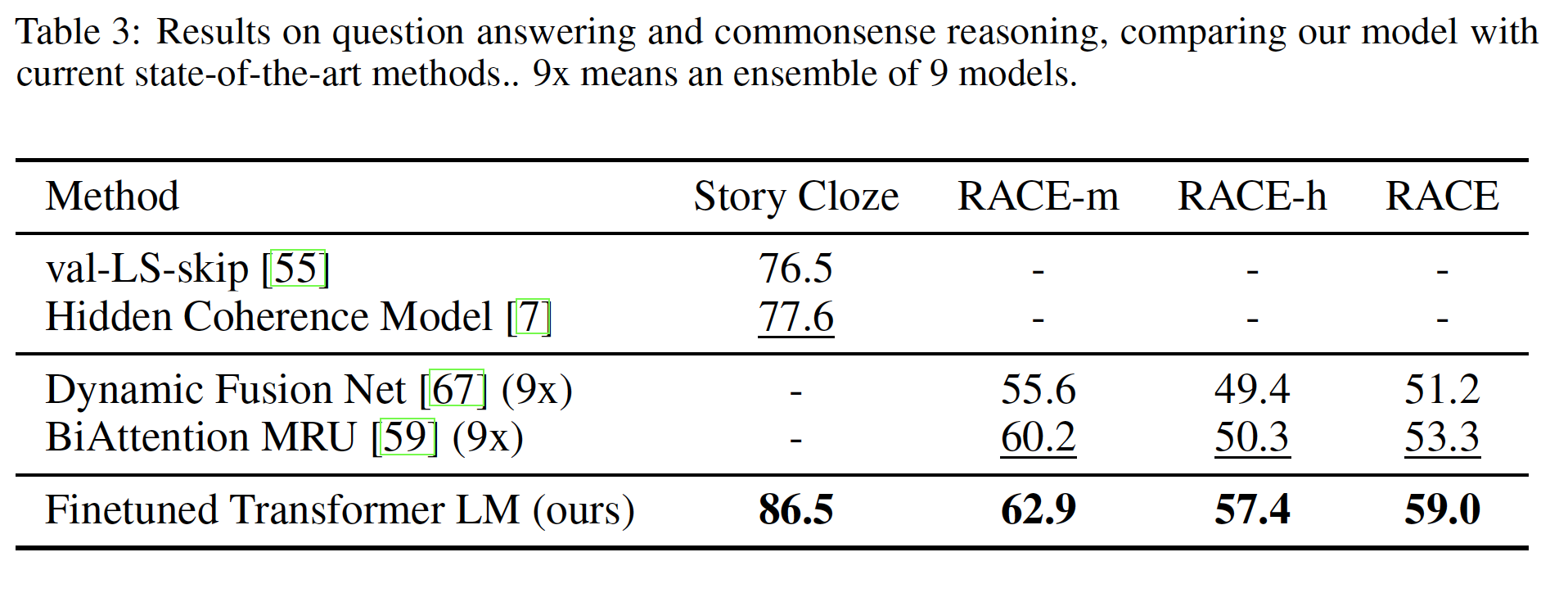

问答和常识推理

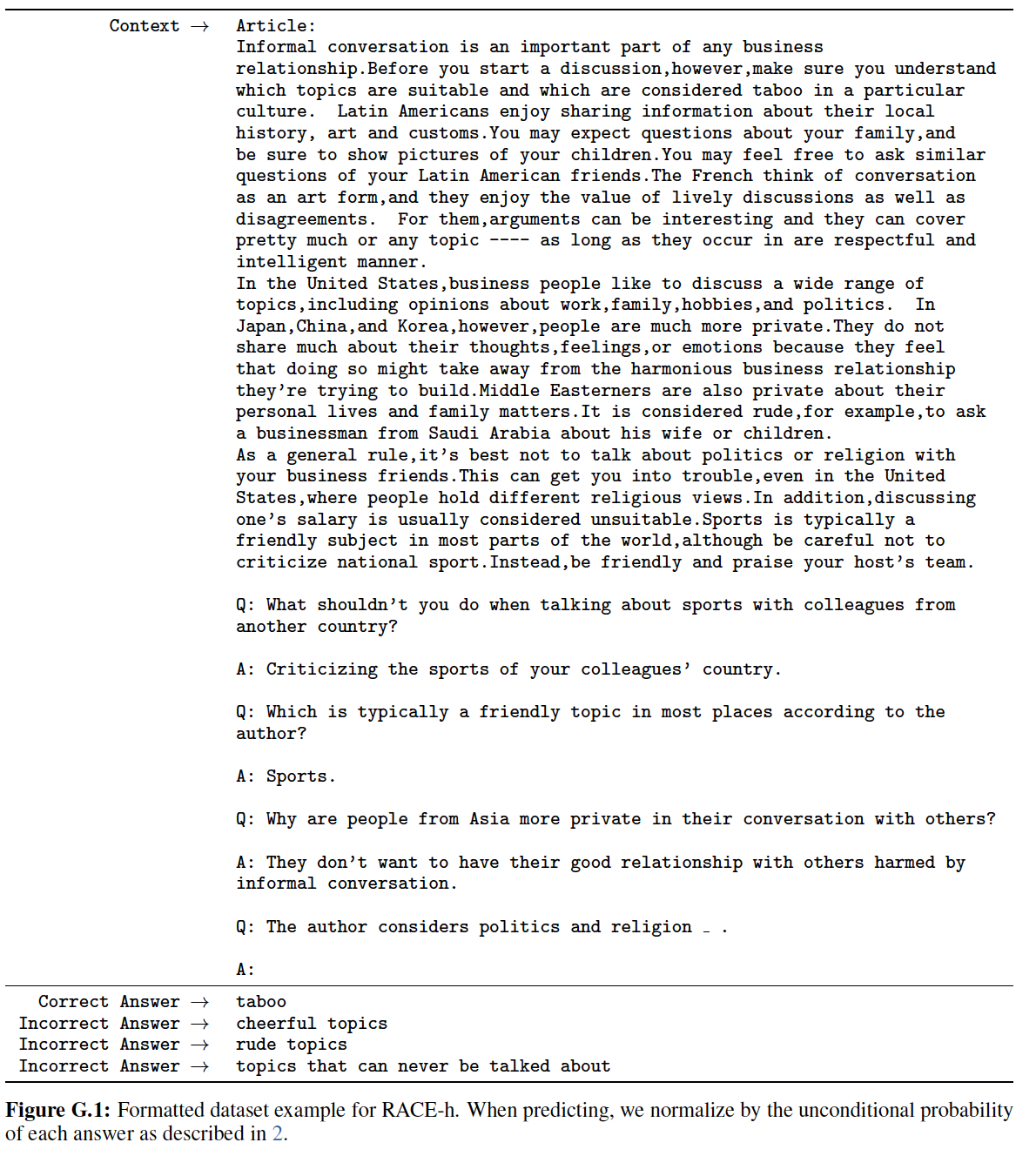

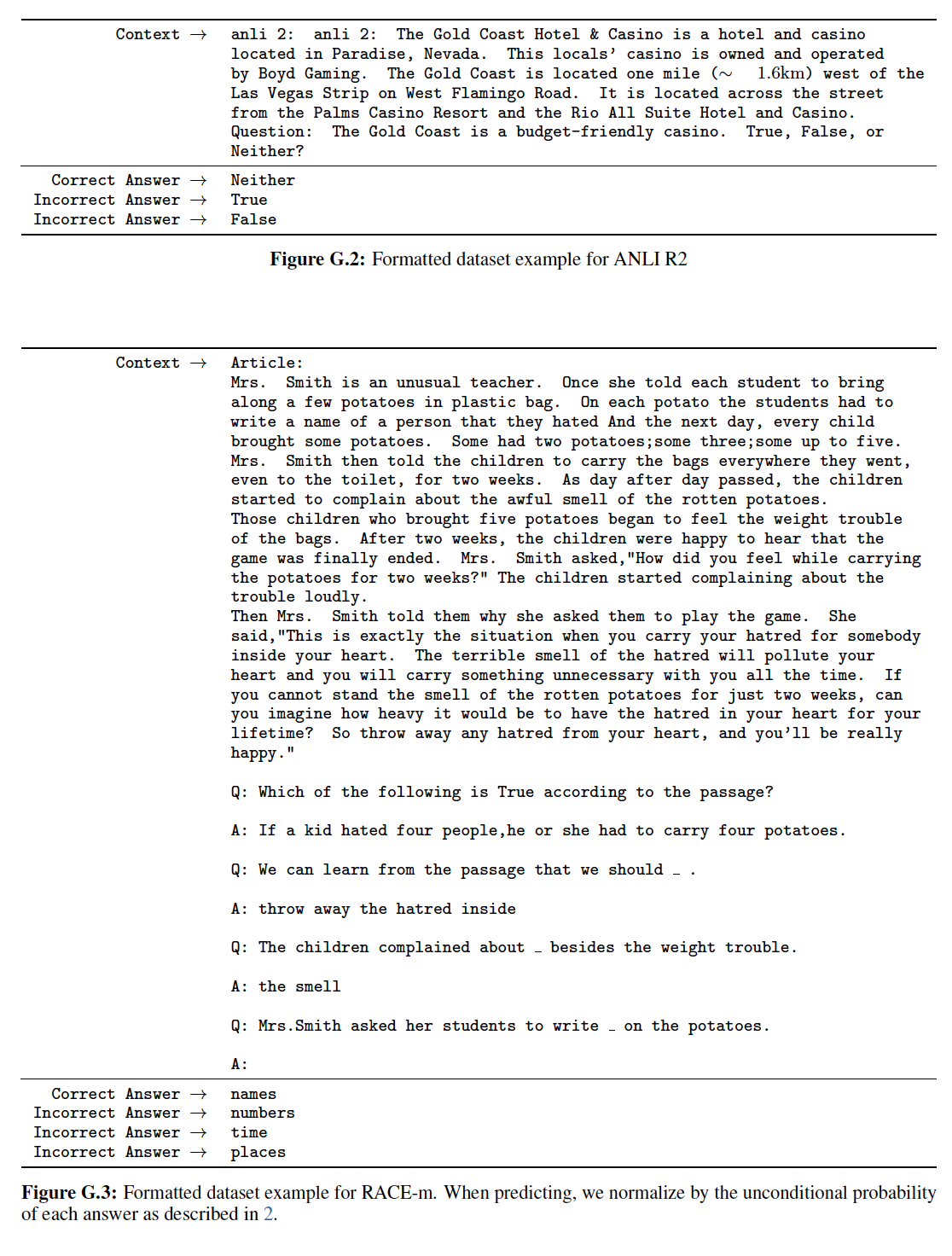

Question Answering and Commonsense Reasoning:另一项需要单句推理和多句推理的任务是问答。我们使用最近发布的RACE数据集,该数据集由初中考试(RACE-m)和高中考试(RACE-h)的英语段落和相关问题组成。这个语料库已被证明包含了比CNN或SQuaD等其它数据集更多的推理类型的问题,为我们的模型提供了完美的评估,其中我们的模型被训练用于处理长程上下文long-range context。此外,我们还在Story Cloze Test数据集上进行评估,该数据集涉及从两个选项中选择多句子故事的正确结局。实验结果如下表所示,在这些任务中,我们的模型再次以显著的优势超越了以前的最佳结果:在

Story Cloze数据集上高达8.9%的绝对改进,在RACE数据集上平均5.7%的绝对改进。这表明我们的模型有能力有效处理长程上下文。

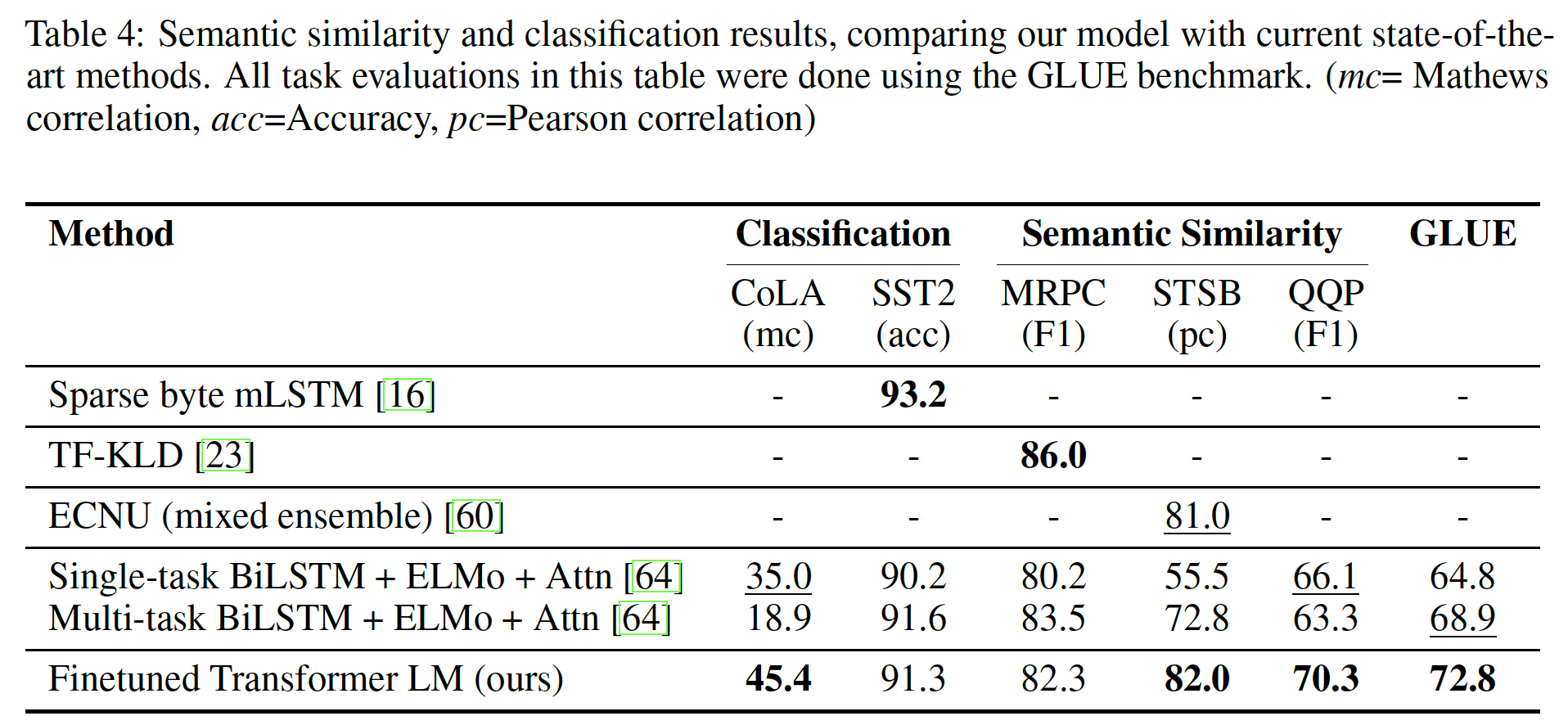

语义相似性

Semantic Similarity:该任务涉及预测两个句子是否在语义上相等。挑战在于识别概念的改写rephrasing、理解否定句negation、以及处理句法歧义syntactic ambiguity。我们使用三个数据集来完成这项任务:Microsoft Paraphrase corpus: MRPC(从新闻来源收集到的)、Quora Question Pairs: QQP、Semantic Textual Similarity benchmark: STS-B。实验结果如下表所示,在这三个语义相似性任务中,我们在其中两个上面获得了

state-of-the-art结果:在STS-B上获得了1%的绝对收益,在QQP上获得显著的4.2%的绝对收益。

分类

Classification:最后,我们还对两个不同的文本分类任务进行了评估。Corpus of Linguistic Acceptability: CoLA包含专家对一个句子是否符合语法的判断,并测试训练好的模型的innate linguistic bias。Stanford Sentiment Treebank: SST-2是一个标准的二元分类任务。实验结果如上表所示,可以看到:

- 我们的模型在

CoLA上获得了45.4分,比之前的最佳结果35.0分有了重大的飞跃,展示了我们的模型学到的innate linguistic bias。 - 在

SST-2数据集上我们的模型也取得了91.3%的准确率,这与state-of-the-art结果相比也是有竞争力的。 - 我们还在

GLUE benchmark上取得了72.8分的总分,这比之前的68.9分的最好成绩要好得多。

- 我们的模型在

总体而言,在我们评估的

12个数据集中,我们的方法在其中的9个数据集上取得了新的state-of-the-art结果,在许多case中超越了ensembles的结果。我们的结果还表明:我们的方法在不同规模的数据集上都运行良好,从较小的数据集(如5.7k个训练样本的STS-B)到最大的数据集(如550k个训练样本的SNLI)。

4.2.2 分析

被迁移的层数的影响

Impact of number of layers transferred:我们观察了从无监督的预训练到监督的目标任务中迁移不同数量的层的影响。下图(左)展示了我们的方法在MultiNLI和RACE数据集上的性能与被迁移的层数的关系。可以看到:

- 仅迁移

embedding层(即,被迁移的层数为1)可以提高性能。 - 每个

transformer layer的迁移都能提供进一步的收益。 - 在

MultiNLI数据集上完全迁移所有层时,效果提升达到9%。

这表明:预训练模型中的每一层都包含了解决目标任务的有用功能

functionality。

- 仅迁移

Zero-shot Behaviors:我们想更好地了解为什么语言模型对transformer的预训练是有效的。一个假设是:底层的生成模型generative model学习执行许多我们所评估的任务,从而提高其语言建模能力。而且与LSTM相比,transformer的更加结构化注意力记忆more structured attentional memory有助于迁移。我们设计了一系列的启发式解决方案,这些解决方案使用底层的生成模型来执行任务而不需要监督微调(即,

zero-shot):- 对于

CoLA(句子是否符合语法),样本的得分为:生成模型分配的token概率的对数均值。然后预测是通过阈值进行的。 - 对于

SST-2(情感分析sentiment analysis),我们在每个样本中添加一个tokenvery,并将语言模型的输出分布限制在单词positive和negative上,并认为概率较高的单词即为预测值。 - 对于

RACE(问答),我们挑选在给定文档和问题的条件下,生成模型赋予最高平均token对数概率的答案。 - 对于

DPRD(winograd schemas),我们用两个可能的指代词referrent替换定语代词definite pronoun,并选择替换后序列的平均token对数概率更高的那一个。

我们在上图(右)中直观地看到了这些启发式解决方案在生成式预训练

generative pre-training过程中的有效性。- 我们观察到这些启发式方案的性能是稳定的,并且随着训练的推进而稳步增加,这表明生成式预训练支持学习各种任务相关的功能。

- 我们还观察到

LSTM的zero-shot性能表现出较高的方差,这表明Transformer架构的归纳偏置inductive bias有助于迁移。

- 对于

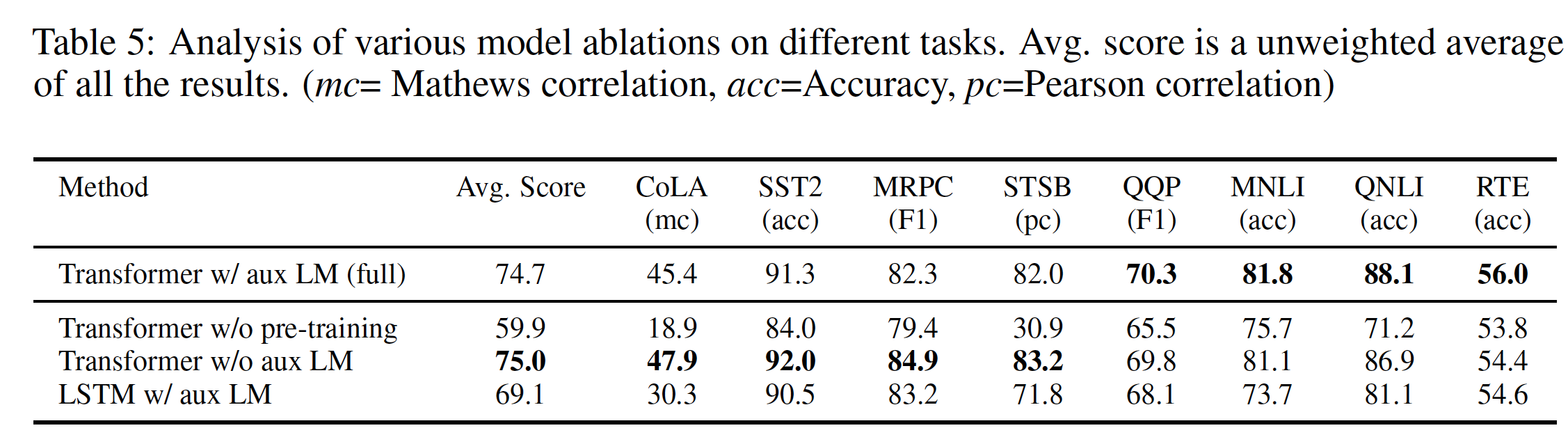

消融研究:我们进行了三种不同的消融研究,如下表所示。

- 首先,我们检查了我们的方法在微调期间没有辅助语言模型目标的性能。我们观察到,辅助目标对

NLI任务和QQP任务有帮助。总体而言,这一趋势表明:较大的数据集从辅助目标中受益,而较小的数据集则没有。 - 其次,我们通过比较

Transformer和使用相同框架的单层2048 unit LSTM来分析其效果。我们观察到,当使用LSTM而不是Transformer时,平均得分下降了5.6。LSTM仅在一个数据集(即,MRPC)上优于Transformer。 - 最后,我们还比较了我们在监督目标任务上直接训练的

transformer架构而没有预训练。我们观察到:缺乏预训练损害了所有任务的性能,导致与我们的完整模型(即,有预训练的模型)相比,性能下降了14.8%。

- 首先,我们检查了我们的方法在微调期间没有辅助语言模型目标的性能。我们观察到,辅助目标对

4.2.3 结论

长期以来,使用无监督训练(或预训练)来提高判别式任务

discriminative task的性能一直是机器学习研究的一个重要目标。我们的工作表明:实现显著的性能提升是可能的,并提示了哪些模型(即Transformer)、哪些数据集(即具有长程依赖的文本)在这种方法下效果最好。我们希望这将有助于对自然语言理解和其它领域的无监督学习进行新的研究,并进一步提高我们对无监督学习如何、以及何时发挥作用的理解。

五、GPT2[2019]

目前,机器学习系统通过使用大数据集、大容量模型、以及监督学习的组合,在它们所训练的任务中表现出色。然而,这些系统很脆弱,对数据分布(

《Do cifar-10 classifiers generalize to cifar-10?》)和任务规范task specification的轻微变化很敏感。目前的系统更多地被描述为狭隘的专家narrow expert而不是称职的通才competent generalist。我们希望迈向更通用的系统,该系统可以执行许多任务,并最终无需为每个任务手动创建和标注一个训练集。建立机器学习系统的主流方法是:

- 收集一个包含训练样本的数据集,这些样本展示所需任务的正确行为。

- 训练一个系统来模仿这些行为。

- 最后在独立同分布

independent and identically distributed: IID的held-out实例上测试其性能。

这对于狭隘专家上的进展起到了很好的作用。但是,

captioning model、阅读理解系统、图片分类器在多样化和多变的、可能的input上经常出现不稳定的行为,突出了这种方法的一些缺点。《Language Models are Unsupervised Multitask Learners》的作者怀疑:单领域数据集上的单任务训练的盛行,是当前系统中观察到的缺乏泛化性的主要原因。要想在当前架构下实现强大的系统,可能需要在广泛的领域和任务上进行训练和度量性能。最近,人们已经提出了几个benchmark(如GLUE和decaNLP)以开始研究这个问题。多任务学习是一个有前途的框架,它可以提高通用的性能

general performance。然而,NLP中的多任务训练仍然处于起步阶段。最近的工作报告了适当modest的性能改进(《Learning and evaluating general linguistic intelligence》),迄今为止两个最雄心勃勃的工作分别在17个(dataset, objective) pair上进行训练(《The natural language decathlon: Multitask learning as question answering》、《Looking for elmo’s friends: Sentence-level pretraining beyond language modeling》) 。从元学习meta-learning的角度来看,每个(dataset, objective) pair都是从数据集和目标的分布中采样到的一个训练实例。目前的机器学习系统需要数百到数千个样本来诱导induce出泛化良好的函数。这表明,多任务训练需要同样多的有效的训练的(dataset, objective) pair,从而实现良好的效果。继续扩大数据集的创建和目标的设计,从而达到所需要的程度将是非常困难的。这就促使我们去探索更多的setup来进行多任务学习。目前在语言任务上表现最好的系统是利用预训练和监督微调的组合。这种方法有很长的历史,其趋势是更灵活的迁移形式。

- 首先,一些方法学习

word vector并用作task-specific architecture的输入(《Distributed representations of words and phrases and their compositionality》、《Natural language processing (almost) from scratch》)。 - 然后,另一些方法迁移

RNN网络的contextual representation(《Semi-supervised sequence learning》、《Deep contextualized word representations》)。 - 最近的工作表明,

task-specific architecture不再是必须的,迁移许多自注意力块就足够了(《Improving language understanding by generative pre-training》、《Bert: Pretraining of deep bidirectional transformers for language understanding》)。

这些方法仍然需要有监督的训练,以便执行任务。当只有极少或者没有监督数据时,另一个方向已经证明了语言模型执行特定任务的前景,如常识推理

common-sense reasoning、情感分析sentiment analysis。在论文

《Language Models are Unsupervised Multitask Learners》中,作者将这两个方向的工作联系起来(预训练和zero-shot),并延续了更通用的迁移方法的趋势。作者证明了语言模型可以在zero-shot中执行下游任务,无需修改任何参数或架构。作者通过强调语言模型在zero-shot setting中执行各种任务的能力,从而证明这种方法的潜力。根据不同的任务,作者取得了有前景的、有竞争力的、和state-of-the-art结果。其中,GPT-2在8个测试的语言建模数据集中的7个上达到了state-of-the-art的性能。相关工作:

这项工作的很大一部分衡量了在更大数据集上训练的更大语言模型的性能。

- 这与

《Exploring the limits of language model》的工作类似,他们在1 Billion Word Benchmark数据集上scale了RNN-based语言模型。 《Embracing data abundance:Booktest dataset for reading comprehension》之前也通过从Project Gutenberg中创建一个更大的训练数据集来补充标准的训练数据集,从而改善了Children’s Book Test的结果。《Deep learning scaling is predictable, empirically》对各种深度学习模型的性能如何随着模型容量和数据集大小而变化进行了深入分析。

我们的实验,虽然在不同的任务中更加

noisy,但表明类似的趋势也存在于子任务中并且持续到1B+的参数规模。- 这与

人们已经记录下来生成模型中有趣的学习功能,如

RNN语言模型中的cell执行line-width tracking和quote/comment detection(《Visualizing and understanding recurrent networks》)。对我们的工作更有启发的是《Generating wikipedia by summarizing long sequences》的观察,一个被训练用于生成维基百科文章的模型也学会了翻译语言之间的name。先前的工作已经探索了过滤和构建大型网页文本语料库的替代方法,如

iWeb Corpus(《The 14 billion word iweb corpus》)。关于语言任务的预训练方法,已经有了大量的工作。

- 除了

Introduction中提到的那些之外,GloVe将word vector representation learning扩展到所有的Common Crawl。 - 关于文本

deep representation learning的一个有影响力的早期工作是Skip-thought Vectors。 《Learned in translation: Contextualized word vectors》探索了使用来自机器翻译模型的representation。《Universal language model fine-tuning for text classification》改进了《Semi-supervised sequence learning》基于RNN的微调方法。《Supervised learning of universal sentence representations from natural language inference data》研究了由自然语言推理模型natural language inference model学到的representation的迁移性能。《Learning general purpose distributed sentence representations via large-scale multi-task learning》探索了大规模多任务训练。

- 除了

《Unsupervised pretraining for sequence to sequence learning》证明了seq2seq模型得益于用预训练的语言模型作为编码器和解码器的初始化。最近的工作表明,语言模型预训练在微调困难的生成任务(如闲聊对话和基于对话的问答系统)时也有帮助(《Transfertransfo: A transfer learning approach for neural network based conversational agents》、《Wizard of wikipedia: Knowledge-powered conversational agents》)。

5.1 模型

我们方法的核心是语言建模

language modeling。语言建模通常是指从样本集合distribution estimation,每个样本都由可变长度的符号symbol序列natural sequential ordering,通常将符号的联合概率分解为条件概率的乘积:这种方法允许对

Transformer这样的自注意力架构。GPT-2和GPT-1一样都是自回归模型。单个任务的学习可以在概率框架中表示为估计一个条件分布

multi-task和元学习meta-learning的环境中已经被不同程度地公式化了。任务调节

task conditioning通常在架构层面上实现,如《One model to learn them all》中的特定任务编码器和解码器;或者在算法层面上实现,如MAML的内循环和外循环优化框架(《Model-agnostic meta-learning for fast adaptation of deep networks》)。但是,正如

《The natural language decathlon: Multitask learning as question answering》所举的例子,语言提供了一种灵活的方式来指定task, input, output都是符号的一个序列。例如,一个翻译任务的训练样本可以写成序列(translate to french, english text, french text)。同样地,一个阅读理解的训练样本可以写成(answer the question, document, question, answer)。《The natural language decathlon: Multitask learning as question answering》证明有可能训练单个模型,即MQAN,来推断和执行具有这种类型格式样本的许多不同任务。语言建模原则上也能够学习

《The natural language decathlon: Multitask learning as question answering》的任务,而无需明确监督哪些符号是要预测的输出。监督目标与无监督目标相同,但是监督目标只需要对序列的一个子集进行评估,无监督目标的全局最小值也是监督目标的全局最小值。在这个略微玩具性质的setting中,《Towards principled unsupervised learning》中讨论的对密度估计作为原则性训练目标的担忧被忽略了。现在的问题是,我们是否能够在实践中优化无监督目标以达到收敛。初步实验证实,足够大的语言模型能够在这种玩具性的setup中进行多任务学习,但学习速度比显式的监督方法慢得多。因为将监督学习任务改写成

(task, input, output)格式的符号序列之后,监督目标就变成了无监督目标。但是,在所有的序列中,仅有从监督任务改写而来的序列才可以构成验证集(或测试集)。虽然从上面描述的精心设计的

setup到混乱的"language in the wild"是一大步,但是《Dialog-based language learning》认为,在dialog的上下文中,有必要开发能够直接从自然语言中学习的系统,并展示了一个概念证明a proof of concept:在没有奖励信号reward signal的情况下,通过使用对teacher的输出的前向预测forward prediction来学习QA任务。虽然dialog是一种有吸引力的方法,但我们担心它过于严格。互联网包含了大量的信息,这些信息是被动可用的而无需交互式通信。我们的推测是:具有足够能力的语言模型将开始学习推断和执行自然语言序列中阐述的任务,以便更好地预测它们,而无论它们的获取方法如何。如果一个语言模型能够做到这一点,那么它实际上是在进行无监督的多任务学习。我们通过分析语言模型在各种任务上的

zero-shot setting的表现,来测试情况是否如此。

5.1.1 训练集

大多数先前的工作是在单个领域的文本上训练语言模型,如新闻文章、维基百科、或小说书

fiction book。我们的方法鼓励我们建立一个尽可能大和多样化的数据集,从而收集尽可能多的领域和上下文的自然语言演示natural language demonstration任务。一个有前景的多样化的、几乎无限的文本源是网络爬虫

web scrape,如Common Crawl。虽然这些文档比目前的语言建模数据集大很多个数量级,但是它们有重大的数据质量问题。《A simple method for common-sense reasoning》在他们关于常识推理的工作中使用了Common Crawl,但是注意到大量的文件 “其内容几乎是不可理解的”。我们在使用Common Crawl的初步实验中观察到了类似的数据问题。《A simple method for common-sense reasoning》的最佳结果是使用Common Crawl的一个小的子集来实现的,该子集仅包含与他们的target dataset(Winograd Schema Challenge)最相似的文件。虽然这是一个务实的方法从而提高特定任务的性能,但是我们希望避免提前对将要执行的任务做出假设。相反,我们创建了一个新的、强调文档质量的网络爬虫。为了做到这一点,我们仅爬取那些已经被人类精心管理/过滤的网页。人工过滤一个完整的网络爬虫将非常昂贵,因此作为一个开始,我们从

Reddit(一个社交媒体平台)爬取了所有的外链outbound link,这些外链至少收到了3个karma(类似于点赞数或评论数的一种计数机制)。这可以被认为是一个启发式指标,表明其它用户是否认为该链接有趣、有教育意义。由此产生的数据集

WebText,包含了这4500万个链接的文本子集。为了从HTML response中提取文本,我们使用了Dragnet和Newspaper内容提取器的组合。本文介绍的所有结果都使用了WebText的初步版本preliminary version,该版本不包括2017年12月之后创建的链接,并且在去重和一些基于启发式的清理之后包含了略微超过800万个文档,共计40GB的文本。我们从

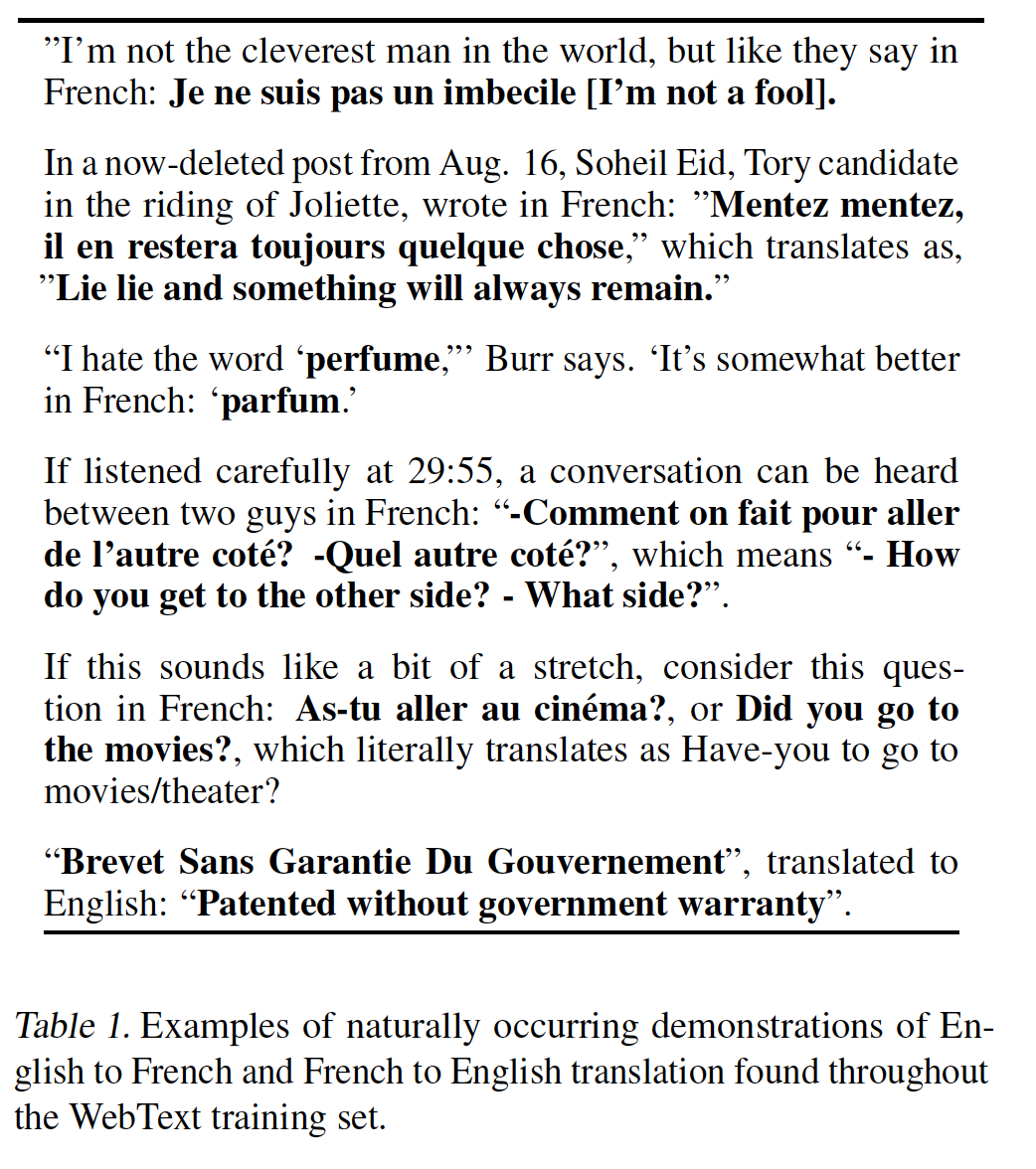

WebText中删除了所有的维基百科文档,因为它是其它数据集的一个常见数据源,并且由于训练数据与测试评估任务的重叠overlapping,可能会使分析变得复杂。下表所示为

WebText训练集中发现的自然发生的English to French和French to English的例子:

5.1.2 Input Representation

一个通用的语言模型应该能够计算出任何字符串的概率(当然也能生成任何字符串)。目前的大型语言模型包括预处理步骤,如

lowercasing、tokenization、out-of-vocabulary tokens,这些预处理步骤限制了可建模字符串的空间。虽然将

Unicode字符串处理为UTF-8 bytes序列可以优雅地满足这一要求(如《Multilingual language processing from bytes》),但是目前的byte-level语言模型在大型数据集(如One Billion Word Benchmark)上与word-level语言模型相比没有竞争力。在我们自己尝试在WebText上训练标准的byte-level语言模型时,我们也观察到了类似的性能差距。Byte Pair Encoding: BPE(《Neural machine translation of rare words with subword units》)是character-level和word-level语言建模之间的一个实用的中间地带middle ground,它有效地在word-level input和character-level input之间进行插值。尽管它的名字叫BPE,但是参考的BPE实现通常是在Unicode code point而不是字节序列上操作。这些实现需要包括Unicode symbol的全部空间,以便为所有Unicode字符串建模。这将导致在添加任何multi-symbol token之前,base vocabulary超过了130k。与BPE经常使用的32k到64k个token的vocabulary相比,这个规模太大了。相比之下,BPE的byte-level版本只需要256大小的base vocabulary。然而,直接将

BPE应用于字节序列会导致次优的merge,这是因为BPE使用贪心的frequency-based启发式方法来构建token vocabulary。我们观察到BPE包括了许多像dog这样的常见词的变体,如dog.、dog!、dog?。这导致了对有限的vocabulary slot和模型容量的次优分配。为了避免这种情况,我们防止BPE对任何字节序列进行跨character category的合并。我们为空格space增加了一个例外,这极大地提高了压缩效率,同时在多个vocabulary token中仅添加最小的单词碎片word fragmentation。这种

input representation使我们能够将word-level语言模型的经验优势与byte-level方法的通用性相结合。由于我们的方法可以给任何Unicode字符串分配一个概率,这使得我们可以在任何数据集上评估我们的语言模型,而无需考虑预处理、tokenization、或vocabulary size。

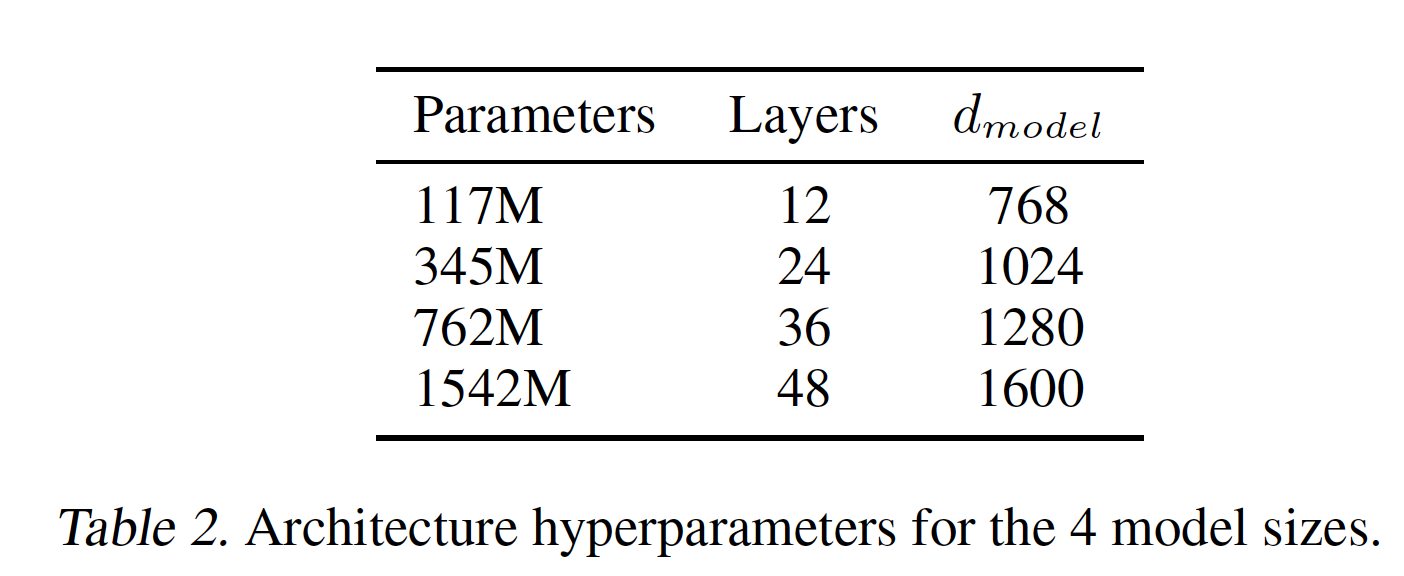

5.1.3 模型

我们的语言模型使用

Transformer-based架构。该模型大体上遵循OpenAI GPT模型的细节,并作了一些修改:layer normalization被移到每个子块的input,类似于一个pre-activation residual network。并且在final self-attention block之后增加了一个额外的layer normalization。即:

使用了修改过的初始化,它考虑了随着模型深度的增加时残差路径

residual path上的累积accumulation。我们在初始化时将残差层的权重按照vocabulary扩大到50257个。我们还将上下文窗口大小从

512增加到1024,并使用更大的batch size = 512。

5.2 实验

我们训练和评测了四个语言模型,它们具有大约对数均匀

log-uniformly间隔的大小。下表中总结了这些架构。最小的模型相当于原始的GPT,次小的模型相当于BERT的最大模型。我们最大的模型,称之为GPT-2,其参数规模比GPT大一个数量级。每个模型的学习率都是手动调优的,以便在

WebText的5%的held-out样本上获得最佳困惑度 。所有的模型对WebText仍然欠拟合under-fit,并且如果给定更多的训练时间那么held-out数据上的困惑度将会进一步改善。

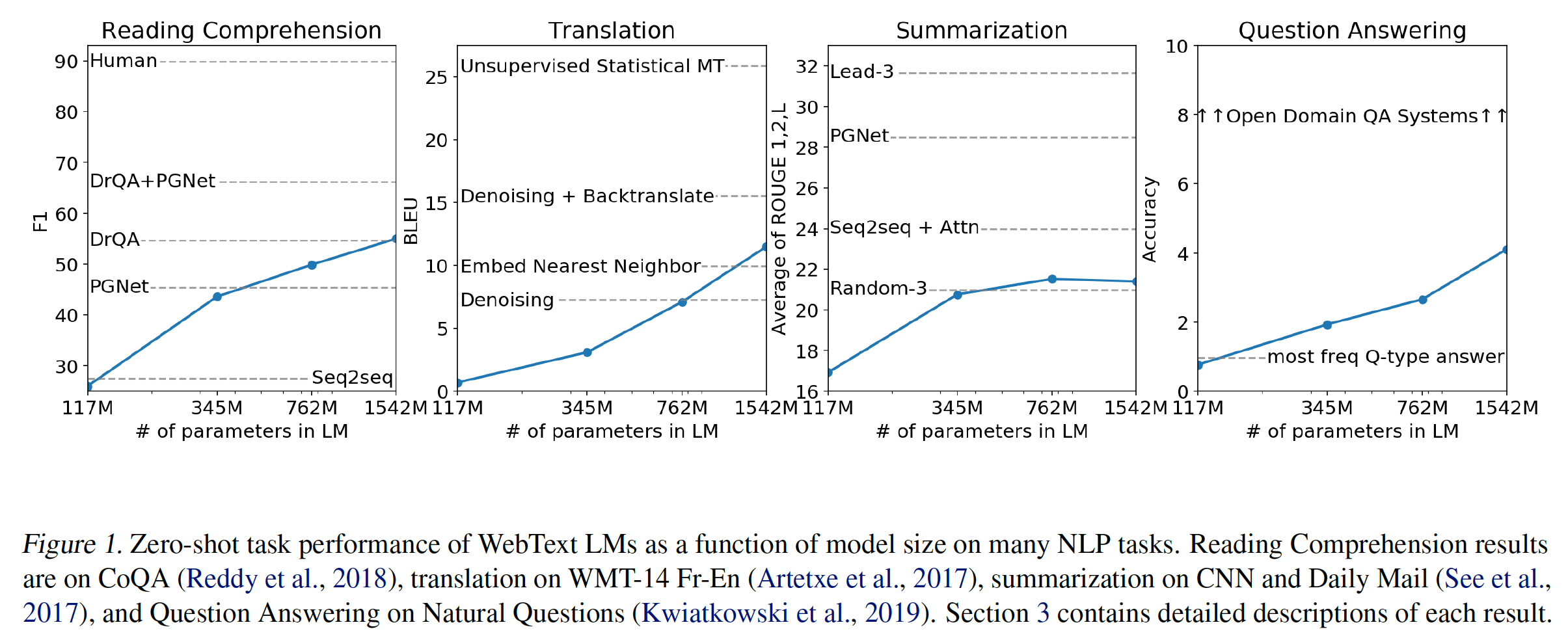

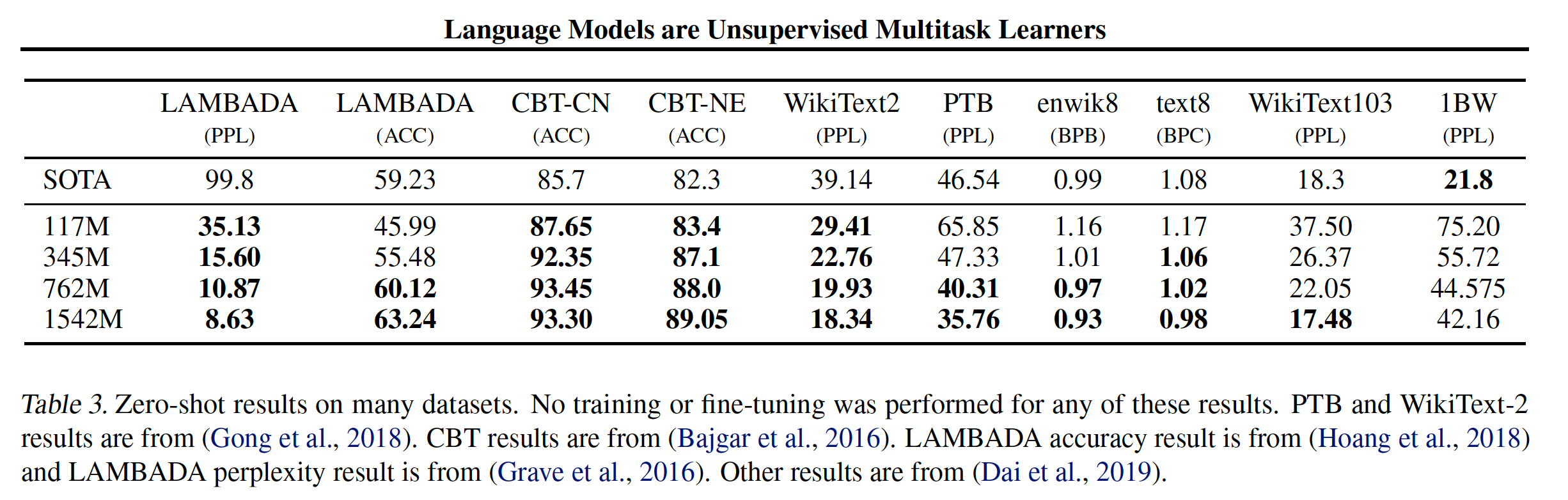

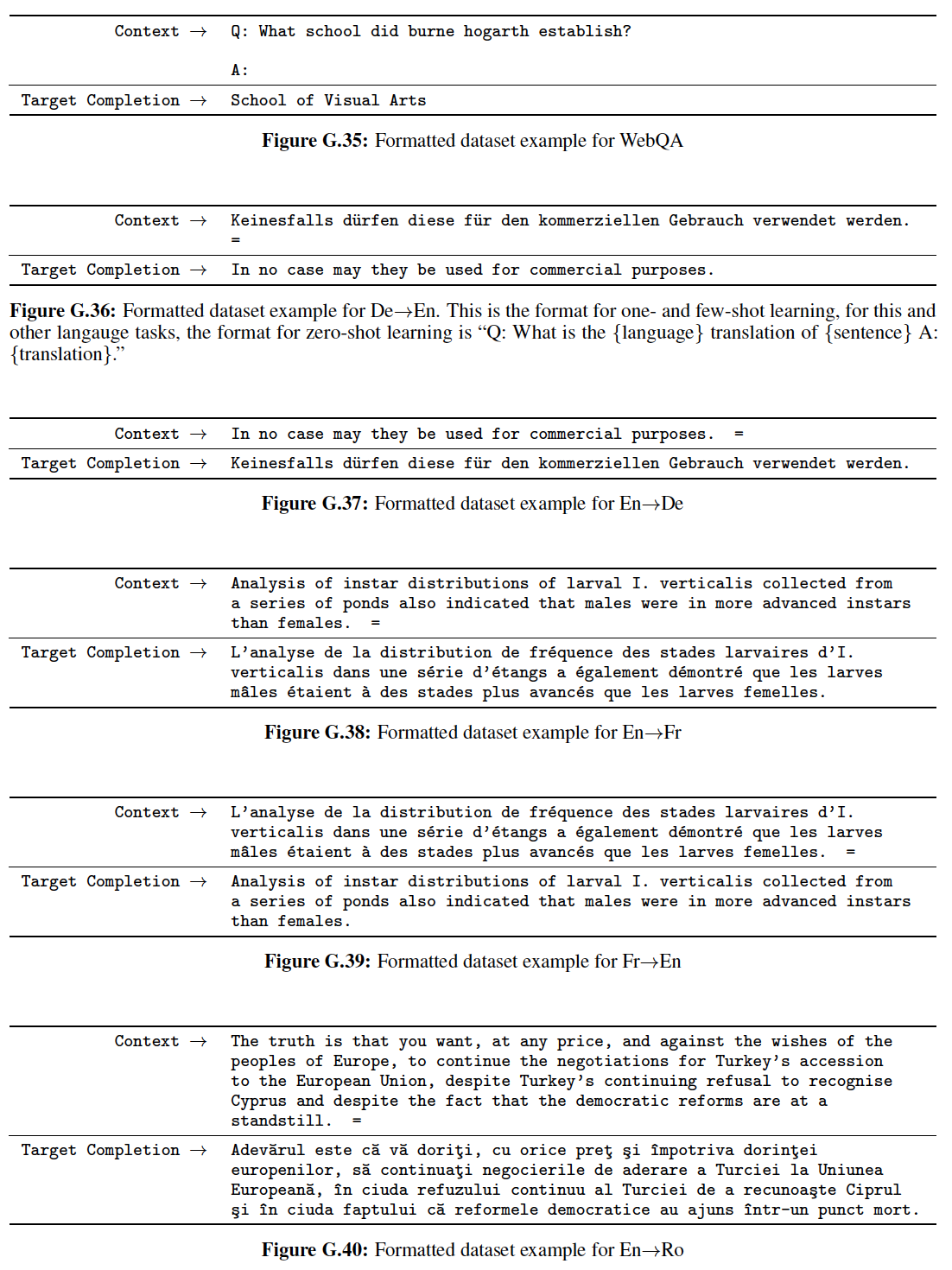

这些模型在不同任务上的表现如下图所示:

5.2.1 语言建模

作为实现

zero-shot的task transfer的第一步,我们有兴趣了解WebText语言模型在它们被训练的主要任务(即,语言建模language modeling)上的表现。由于我们的模型是在byte-level上运行的,不需要有损的预处理或tokenization,我们可以在任何语言模型benchmark上评估它。WebText语言模型在大多数的数据集上的测试大大超出了分布范围out-of-distribution,如必须预测极端标准化的文本aggressively standardized text、标记化的人造物tokenization artifact(如断开的标点符号和缩略语、混洗的句子)、甚至是WebText中极其罕见的字符串<UNK>(该字符串在400亿的字节中仅出现26次)。我们使用了可逆的

de-tokenizer从而尽可能多地移除这些tokenization/pre-processing的人造物artifact。由于这些de-tokenizer是可逆的,我们仍然可以计算出数据集的对数概率,它们可以被认为是一种简单的领域适配domain adaptation形式。我们观察到,使用这些de-tokenizer,GPT-2的困惑度提高了2.5到5。WebText语言模型在不同领域和数据集之间有很好的迁移,在zero-shot的setting下,在8个数据集中的7个上提高了state-of-the-art。- 我们观察到在小的数据集上有很大的改进,如

Penn Treebank: PTB和WikiText-2(它们只有1百万到2百万个训练token)。在为衡量长期依赖关系而创建的数据集上也有很大的改进,如LAMBADA和Children’s Book Test: CBT。 - 在

One Billion Word Benchmark: 1BW上,我们的模型仍然比先前的工作要差很多。这可能是因为它既是最大的数据集,又有一些最具破坏性的预处理:1BW的sentence-level混洗移除了所有的长程结构long-range structure。

- 我们观察到在小的数据集上有很大的改进,如

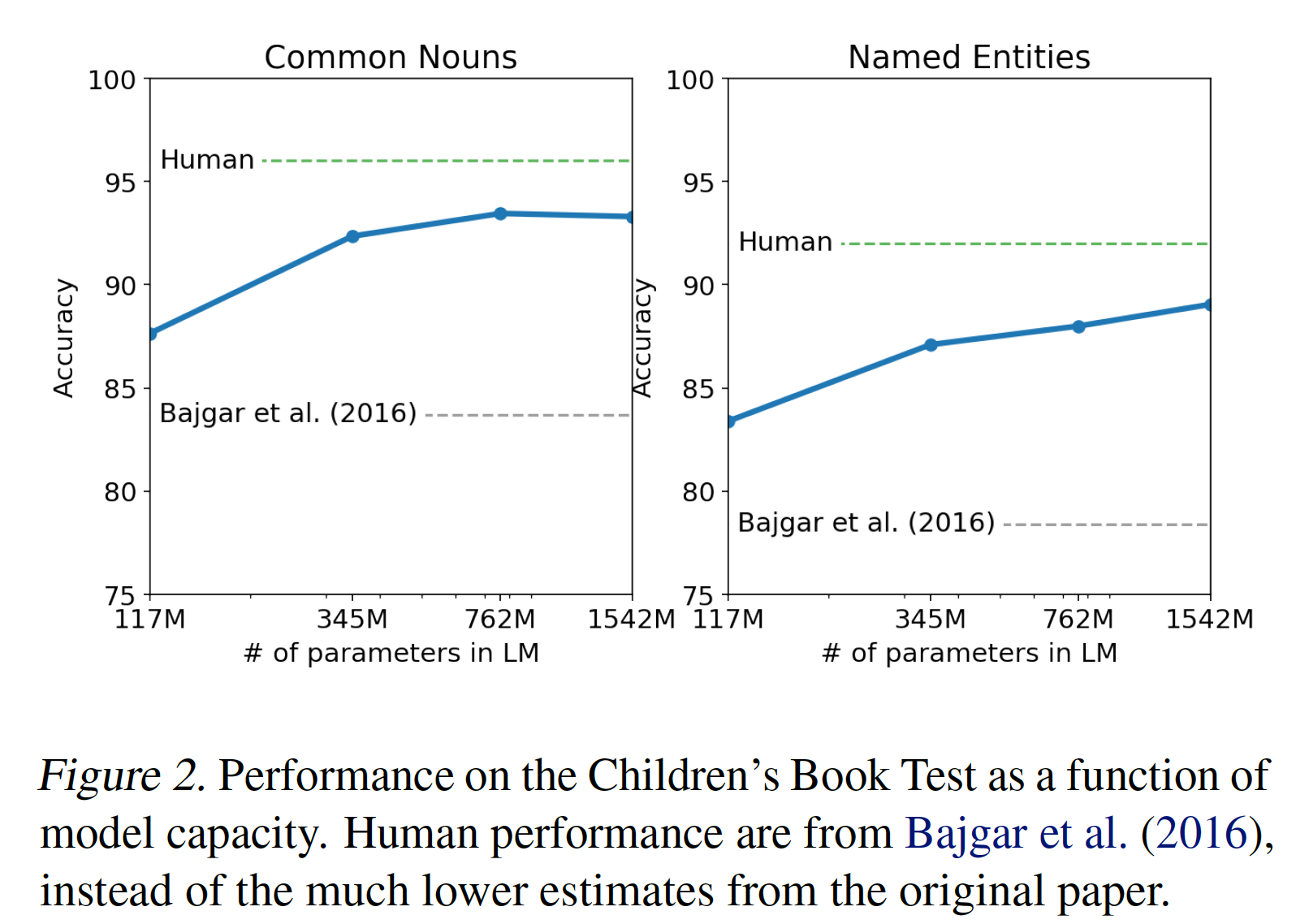

5.2.2 Children’s Book Test

Children’s Book Test: CBT是为了考察语言模型在不同类别的单词上的表现:命名实体named entity、名词noun、动词verb、介词preposition。CBT没有将困惑度作为评估指标,而是报告了自动构建的完形填空测试cloze test的准确率,其中的任务是:预测一个被省略的单词的10个可能的候选中,哪一个候选是正确的。按照原始论文中介绍的语言模型方法,我们根据语言模型计算每个候选的概率,和以该候选为条件的句子剩余部分的概率,并选择联合概率最高的那个选项。此外,我们应用一个de-tokenizer从而移除CBT中的PTB style的tokenization artifact。PTB style指的是Penn Treebank style的tokenization,它是一种常用的tokenization标准。如下图所示,随着模型大小的增加,模型性能稳步提高,并在该测试中缩小了与人类的差距的大部分。

数据重叠分析

data overlap analysis表明:CBT测试集中的一本书(即Rudyard Kipling的《Jungle Book》)在WebText中,所以我们报告了没有重大重叠的验证集的结果:GPT-2在普通名词上获得了93.3%的new state-of-the-art结果(即上表中的CTB-CN),在命名实体上获得了89.1%的new state-of-the-art结果(即上表中的CBT-NE)。

5.2.3 LAMBADA

LAMBADA数据集测试了系统对文本中长距离依赖long-range dependency的建模能力。任务是预测句子的最后一个单词。对于人类而言,该任务需要至少50个token的上下文才能成功预测。GPT-2将state-of-the-art从99.8的困惑度提高到8.6,并将语言模型在该测试中的准确率从19%提高到52.66%。其中,我们使用一个没有预处理的数据集版本。研究

GPT-2的错误表明:大多数预测是句子的有效延续continuation,但不是有效的最终词final word。这表明:语言模型没有使用额外的有用的约束条件,即该词必须是句子的最后一个。在此基础上增加一个stop-word filter作为近似approximation,可以使准确率进一步提高到63.24%,使该任务的整体state-of-the-art提高了4%。先前的

state-of-the-art使用了一个不同的约束性的预测settting,其中模型的输出被限制为仅出现在上下文中的单词。对于GPT-2,这种约束是有害而无益的。因为19%的答案不在上下文中。

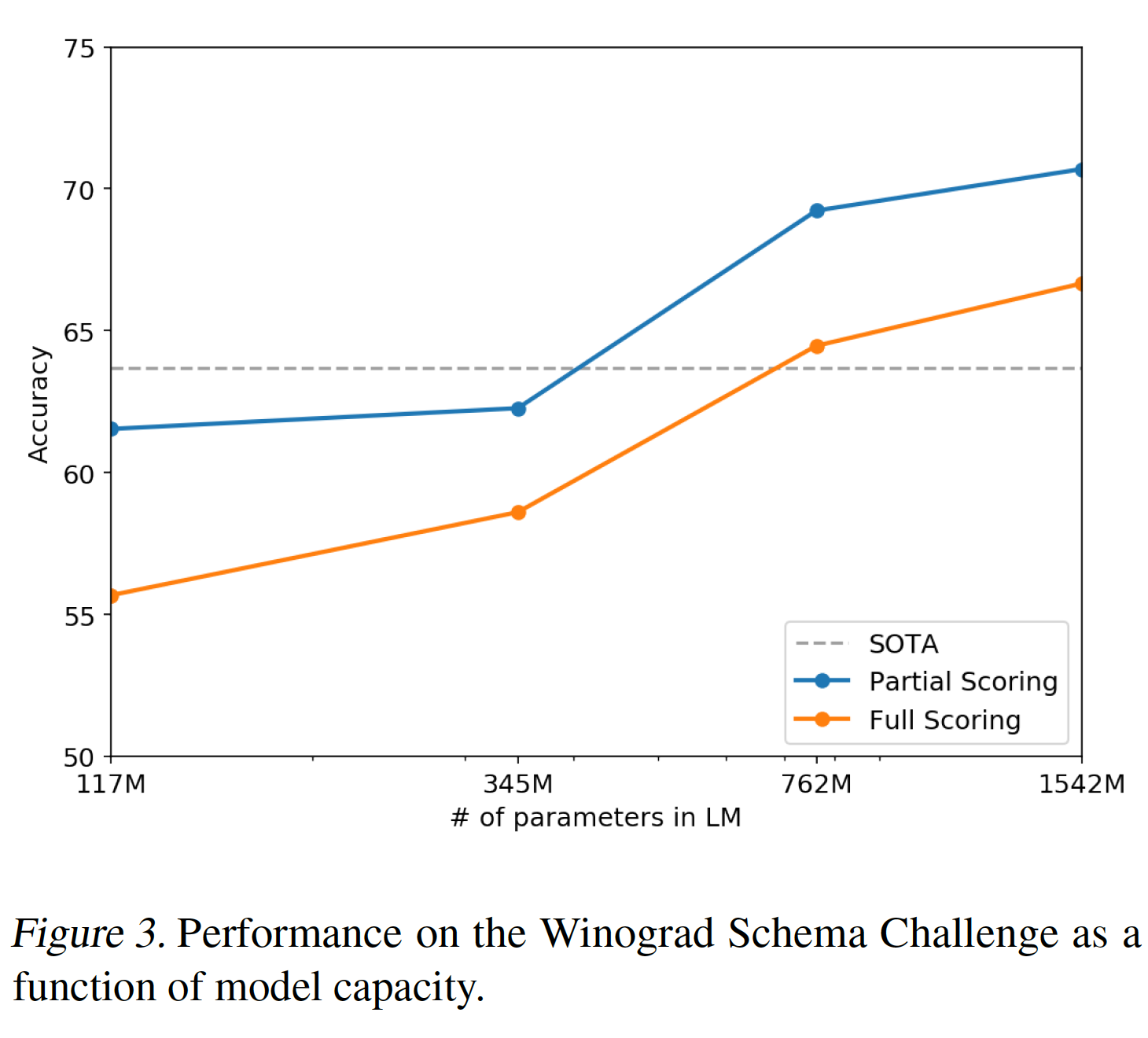

5.2.4 Winograd Schema Challenge

Winograd Schema challenge的目标是:通过衡量系统解决文本中的歧义ambiguity的能力,来衡量系统进行常识推理common-sense reasoning的能力。该数据集相当小,只有273个样本,所以我们建议阅读《On the evaluation of common-sense reasoning in natural language understanding》,从而帮助理解这一结果的背景。Winograd Schema challenge任务要求机器识别出一个歧义的代词的祖先,如:xxxxxxxxxxThe fish ate the worm. It is hungry.问题:

It指代fish还是worm?最近,

《A simple method for commonsense reasoning》通过预测更高概率的歧义的解决方案,证明了使用语言模型在这个Challenge上的重大进展。我们遵从了他们的问题表述,并在下图中直观地展示了我们的模型在完全评分技术full scoring technique和部分评分技术partial scoring technique下的表现。GPT-2将state-of-the-art准确率提高了7%,达到了70.70%(部分评分技术的准确率)。假设文本序列为

- 完全评分技术:将

- 部分评分技术:将

然后选择评分最高的候选词作为预测结果。

- 完全评分技术:将

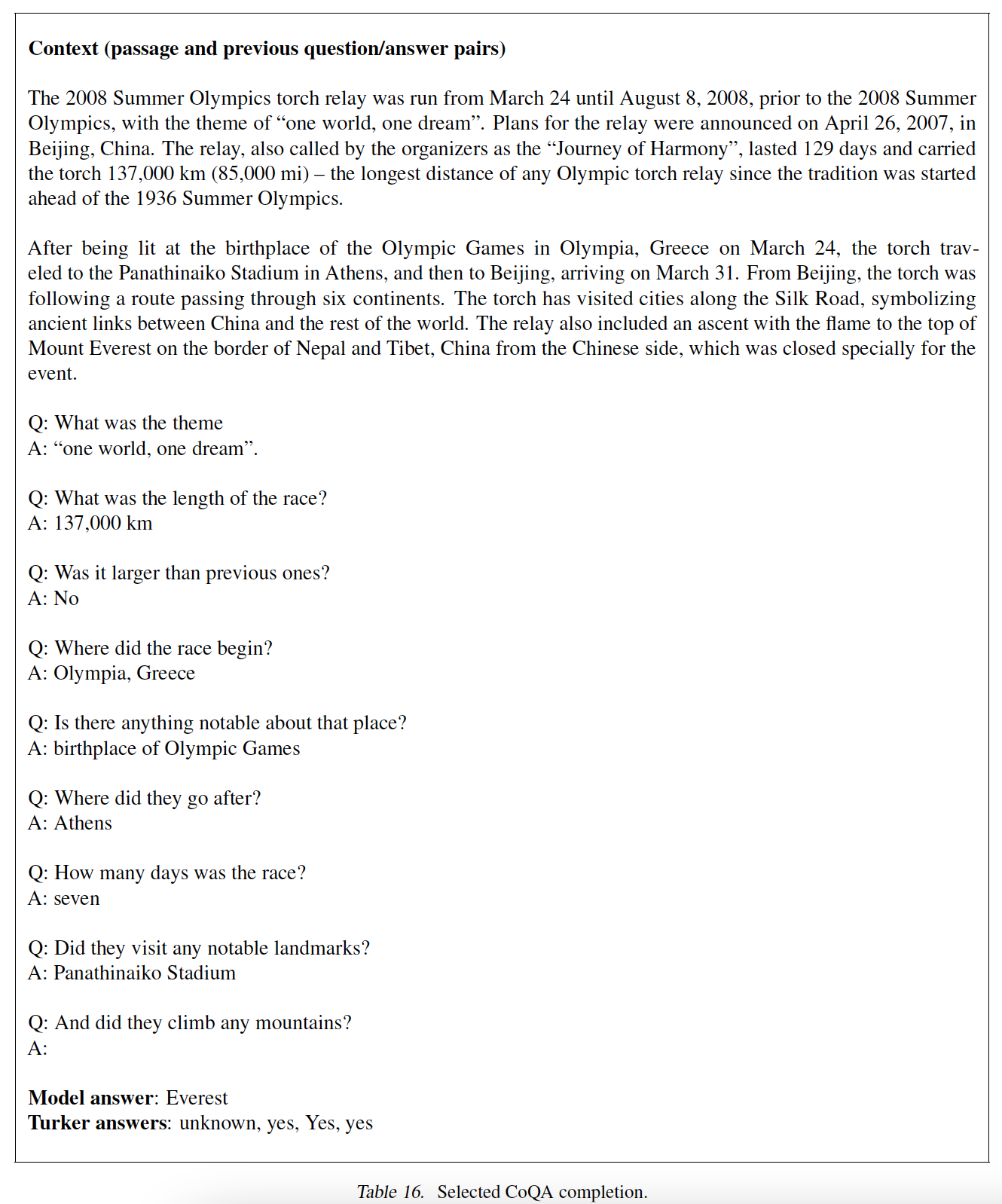

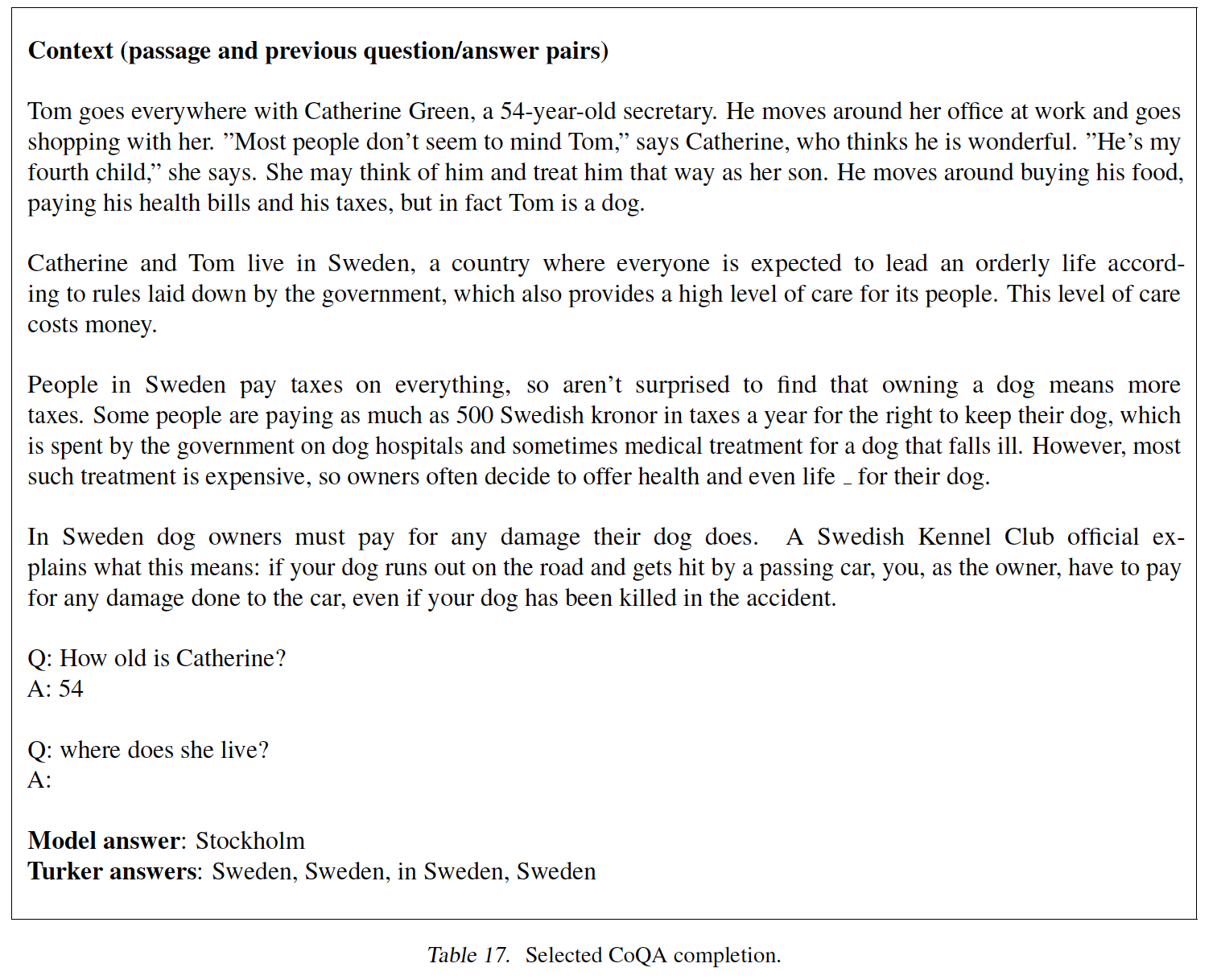

5.2.5 Reading Comprehension

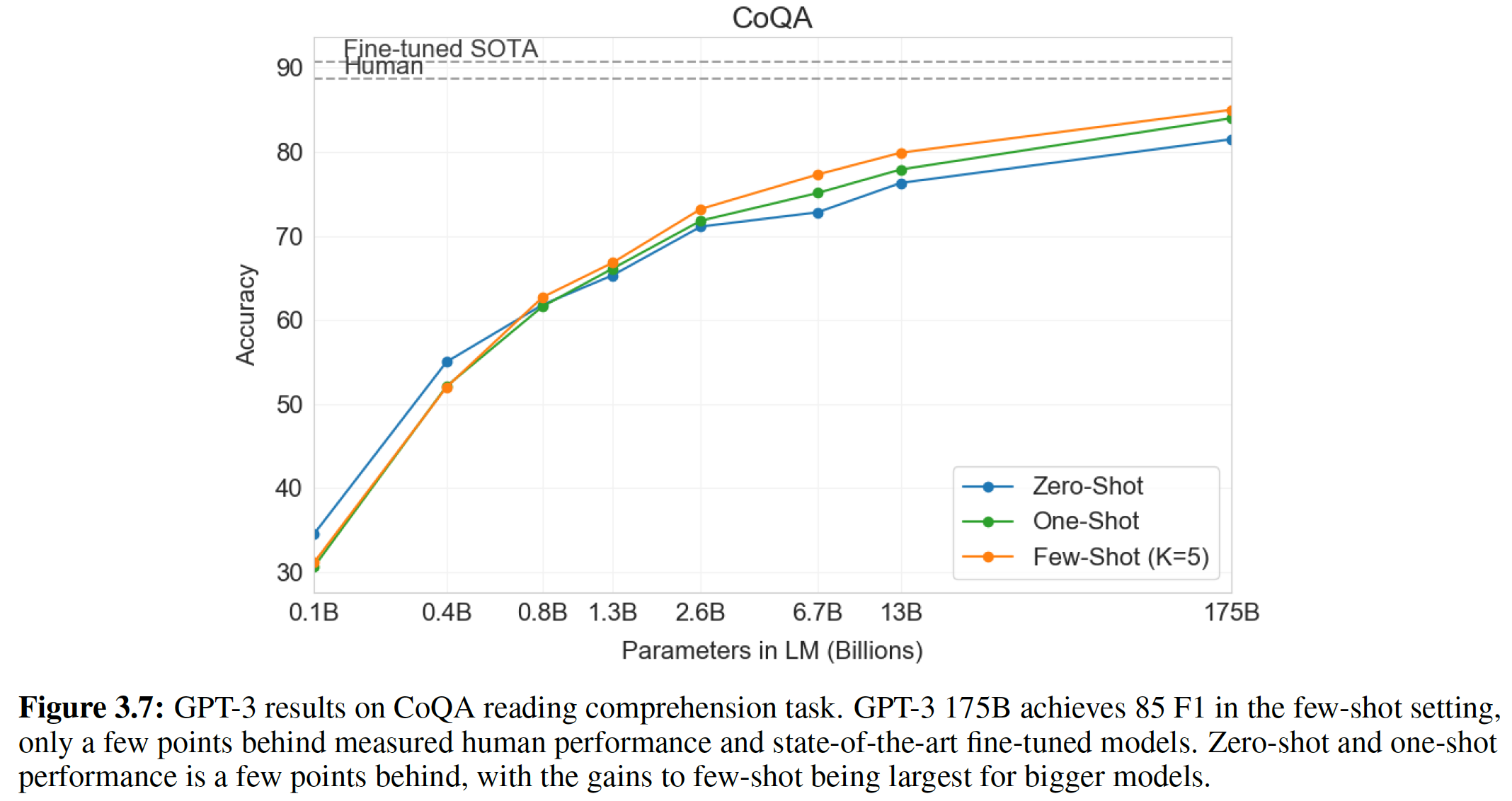

《A conversational question answering challenge》的Conversation Question Answering: CoQA数据集包含来自7个不同领域的文档,每个文档都是关于:问题提出者和问题回答者之间的自然语言对话的pair对。CoQA测试阅读理解能力,也测试模型回答那些依赖于对话历史的问题的能力(如why?)。当以文档、相关对话历史、

final token(即A:)为条件时,来自GPT-2的贪心解码greedy decoding在验证集上达到了55 F1。在没有使用127k个人工收集的question-answer pair的情况下,我们的方法达到了与4个baseline system中的3个相当甚至更好的效果,而这些baseline system是在这127k个人工收集的question-answer pair上训练的。监督的

state-of-the-art是一个基于BERT的系统,它接近人类的89 F1的性能。虽然GPT-2的性能对于一个没有任何监督训练的系统而言是令人振奋的,但是对GPT-2的答案和错误的一些检查表明:GPT-2经常使用简单的基于检索retrieval based的启发式方法,例如在回答who的问题时采用文档中的一个名字来回答。

5.2.6 Summarization

我们在

CNN和Daily Mail数据集上测试GPT-2执行文本摘要的能力。为了诱发摘要行为induce summarization behavior,我们在文章后面添加了文本TL;DR:,并使用Top-k随机采样(《Hierarchical neural story generation》)来生成100个token,这可以减少重复并鼓励比贪心解码更abstractive的摘要(类似于beam search)。我们使用这100个token中所生成的句子的前面三句话作为摘要。TL;DR:是一个缩写,可以是Too long; Didn't read(太长,所以没看)、也可以是Too long; Don't read(太长,不要看)。它通常作为一篇很长的文章的摘要的标题。

虽然从质量上讲,这些生成结果类似于摘要,如下表所示,但是它们通常关注文章中的最近的内容,或者混淆具体细节(如车祸中涉及多少辆车,或帽子/衬衫上是否有

logo)。在通常报告的

ROUGE 1,2,L指标上,生成的摘要仅开始接近经典的neural baseline的性能,并且勉强超过了从文章中随机选择的3个句子。ROUGE-N(其中N可以为1/2/...)为N-gram召回率:ROUGE-L为最长公共子序列的重合率:其中:

lcs()为最长公共子串函数,当任务提示被删除时(即没有

TL;DR:提示),GPT-2的性能在综合指标上下降了6.4分,这表明了用自然语言在语言模型中调用特定任务行为的能力。

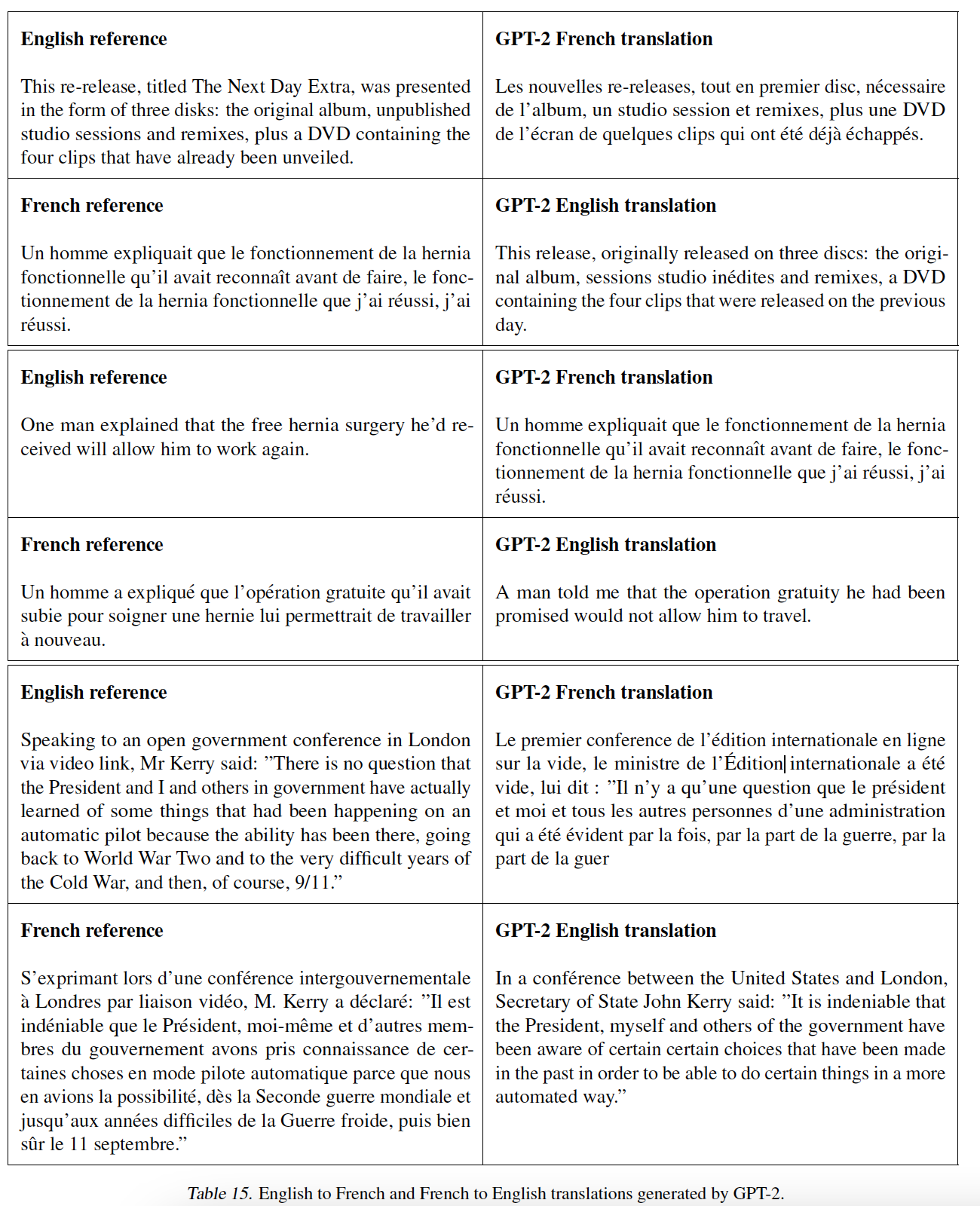

5.2.7 翻译

我们测试

GPT-2是否已经开始学习如何从一种语言翻译到了另一种语言。为了帮助它推断出这是目标任务,我们将语言模型置于english sentence = french sentence格式的样本pair对的上下文中,然后在一个final prompt(即english sentence =)之后,我们使用贪心解码从模型中采样,并使用第一个生成的句子作为翻译。- 在

WMT-14 English-French测试集上,GPT-2达到了5 BLUE,这比先前的无监督单词翻译工作(《Word translation without parallel data》)略差,该方法通过推断出的双语词库bilingual lexicon进行逐字替换。 - 在

WMT-14 French-English测试集上,GPT-2能够利用其非常强大的英语语言模型,表现明显更好,达到11.5 BLUE。这超过了《Unsupervised neural machine translation》和《Unsupervised machine translation using monolingual corpora only》的几个无监督机器翻译baseline,但是仍然比目前最好的无监督机器翻译方法的33.5 BLUE差很多(《An effective approach to unsupervised machine translation》)。

这项任务的表现让我们感到惊讶,因为我们故意从

WebText中删除非英文网页作为过滤步骤。为了证实这一点,我们在WebText上运行了一个byte-level的语言检测器,该检测器仅检测到10MB的法语数据,这比之前无监督机器翻译研究中常见的单语言法语语料库小了约500倍。

- 在

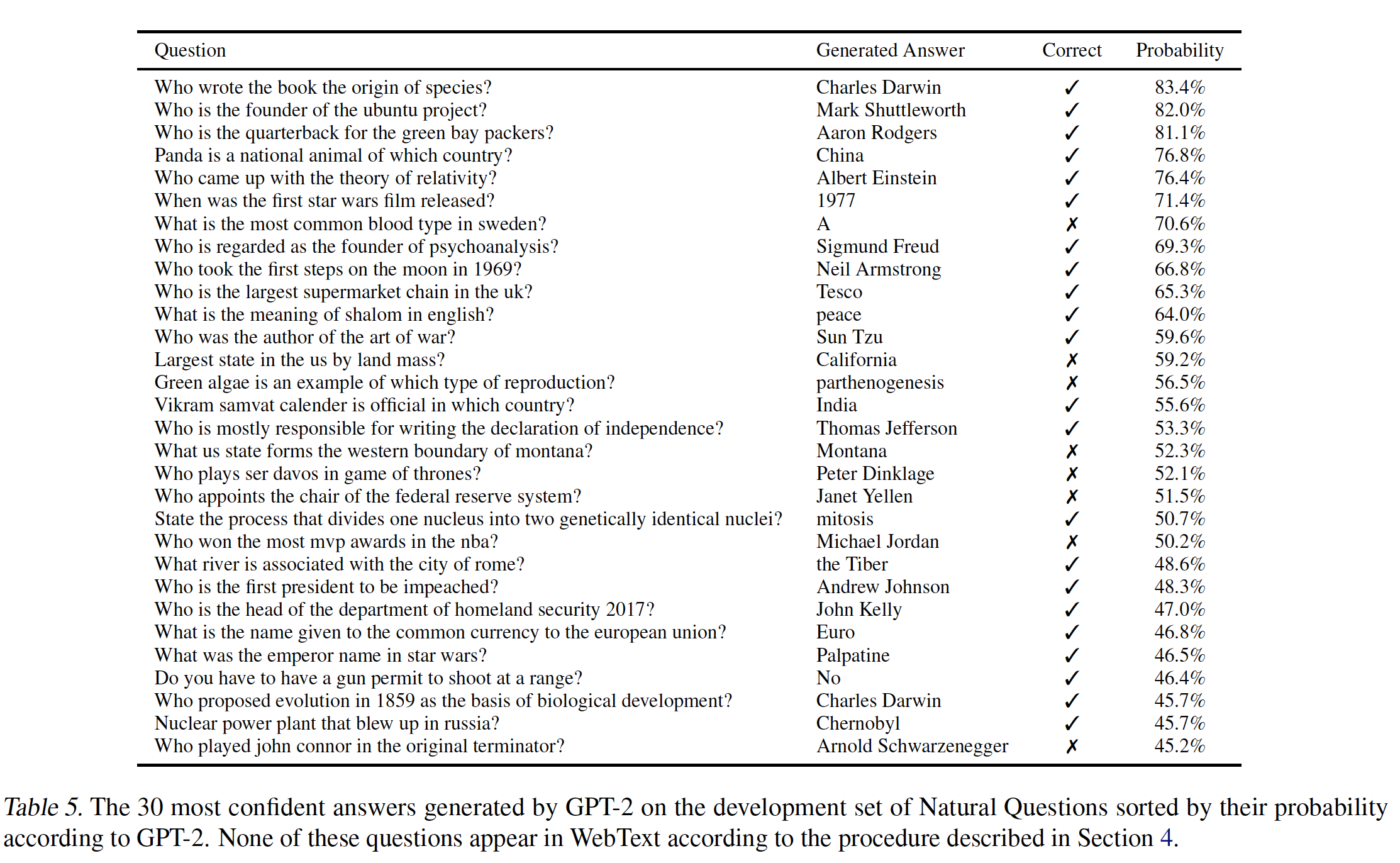

5.2.8 问答

测试语言模型中包含哪些信息的一个潜在方法是:评估语言模型对虚构风格

factoid-style问题产生正确答案的频率。由于缺乏高质量的评估数据集,先前对神经系统中这种行为的showcasing报告了定性的结果(《A Neural Conversational Model》)。最近引入的

Natural Questions数据集是一个有希望的资源,可以更定量地测试。与翻译类似,语言模型的上下文是以question answer pair作为样本的,这有助于模型推断出数据集的简短答案风格short answer style。当使用SQUAD等阅读理解数据集上常用的精确匹配指标exact match metric来评估时,GPT-2能够正确回答4.1%的问题。GPT-2在所生成的答案上分配的概率是经过良好校准well calibrated的,并且GPT-2在它最有把握的1%问题上的准确率为63.1%。但是,

GPT-2的最少参数的版本未能超越一个难以置信的、仅有1.0%准确率的简单baseline,该baseline返回每个问题类型(who, what, where等等)的最常见答案。GPT-2最大参数的版本回答了5.3倍正确的问题(相比较于最少参数的版本),这表明到目前为止,模型容量一直是神经系统在该任务上表现不佳的主要因素。下表展示了

GPT-2在验证集问题上生成的30个最有信心的答案。GPT-3的性能仍然比混合了信息检索和抽取式文档问答的开方域问答系统open domain question answering system的30% ~ 50%区间差很多很多。

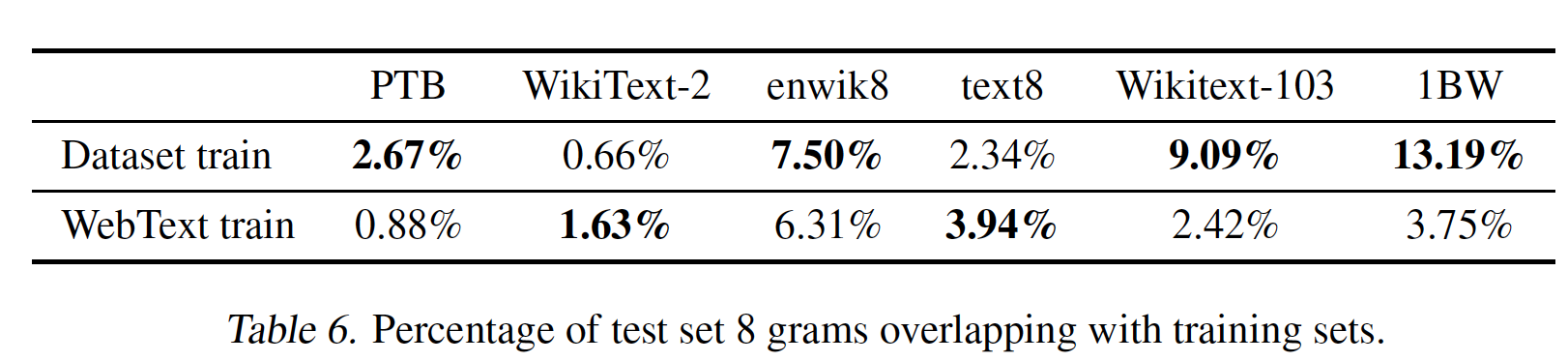

5.3 Generalization vs Memorization

最近在计算机视觉方面的工作表明:常见的图像数据集包含了不可忽略

non-trivial amount的近乎重复的图像。例如,CIFAR-10在训练集和测试集之间有3.3%的重叠(《Do we train on test data? purging cifar of near-duplicates》)。这导致了对机器学习系统的泛化性能的过度报告over-reporting。随着数据集规模的增加,训练集和验证集重叠的问题变得越来越可能,而类似的现象可能也发生在WebText上。因此,分析有多少测试数据也出现在训练集中是很重要的。为了研究这个问题,我们创建了

Bloom Filter,其中包含了8-gram的WebText训练集的token。为了提高召回率,字符串被规范化为仅包含小写字母的alpha-numeric单词并以空格作为分隔符。Bloom Filter的构造使得false positive rate的上限为100万个字符串进一步验证了低false positive rate,其中Bloom Filter没有命中这100万个字符串的任何一个。注意:这里评估的是

8-gram的重复率,而不是整篇文档的重复率。每篇文档包含多个8-gram。有可能存在这样的情况:两篇文档不重复,但是它们包含相同的8-gram。通过

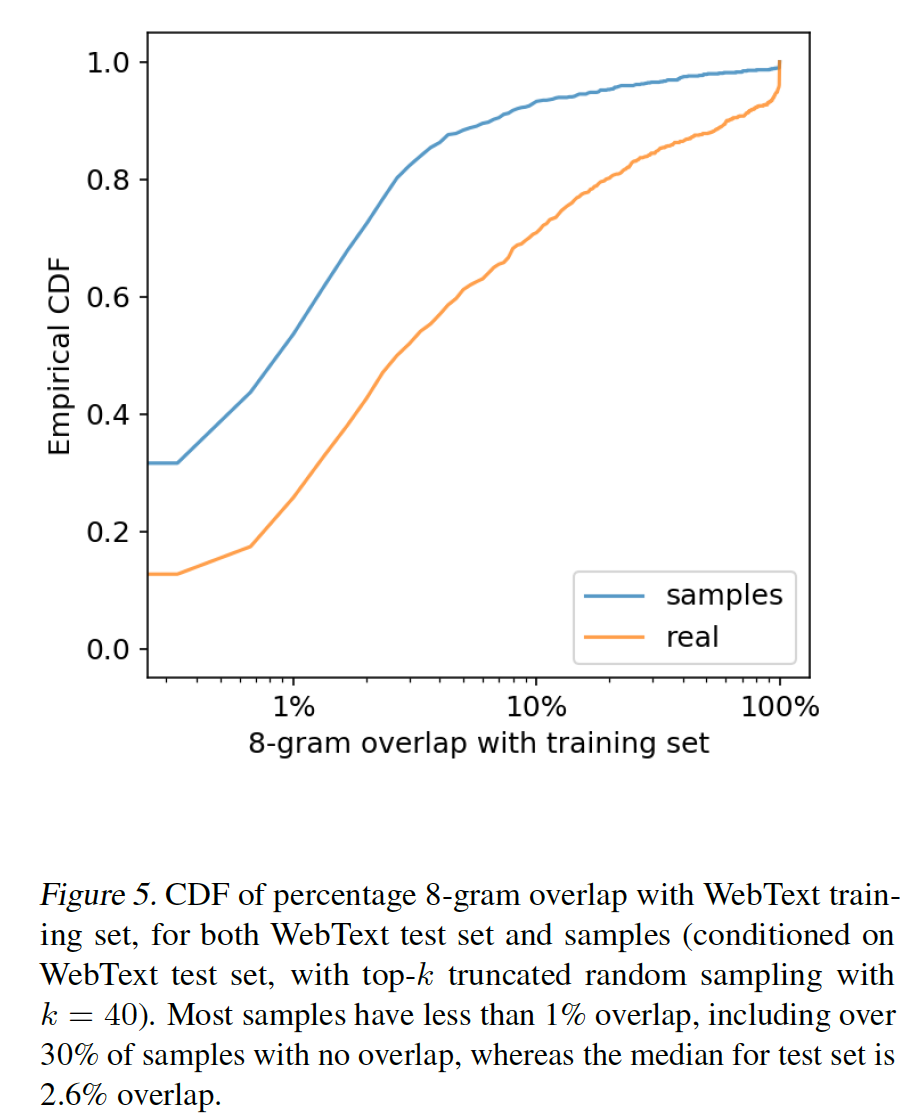

Bloom Filter我们计算得到:给定一个数据集,该数据集中的8-gram在WebText训练集中出现的比例。下表展示了常见的语言模型benchmark的这种overlap分析。常见的语言模型数据集的测试集与WebText训练集有1% ~ 6%的重叠overlap,平均重叠为3.2%。令人惊讶的是,在许多数据集内部,它们的测试集与自己的训练集有较大的重叠,平均有5.9%的重叠。

我们观察到

GPT-2在数据集中的那些较长且重复多次的字符串上的一些记忆行为,如名言或演讲。例如,当以Gettysburg Address(该演说在整个WebText中出现了40次)的第一句半为条件时,GPT-2的argmax解码可以恢复该演说。甚至当使用无截断的采样时,我们发现模型在漂移drifting之前会复制一段时间的演讲。模型通常在100-200个token内漂移,并且一旦漂移就会展示出很大的多样性。为了量化

exact memorization在样本中出现的频率,我们从GPT-2中生成了以WebText测试集文章为条件的样本,并将GPT-2的generation的重叠率与ground-truth completion的重叠率进行比较。比较结果如下所示,结果表明:GPT-2重复训练集中的文本的频率低于held-out文章(baseline)的重叠率。这里的重叠率指的是:给定一段文本,在训练集中重复出现的

8-gram数量占它总8-gram数量的比例。下图中曲线上的点表示:重叠率低于指定值的文本数量占比。

我们的方法针对召回率进行优化。虽然对重叠部分的人工检查显示了许多常见的短语,但是有许多更长的匹配

longer match是由于重复的数据造成的。这并不是WebText所独有的。例如:- 我们发现

WikiText-103的测试集有一篇文章也在训练集中。由于测试集仅有60篇文章,因此这导致至少有1.6%的重叠。 - 可能更令人担忧的是,根据我们的程序计算到:

1BW与它自己的训练集有大约13.2%的重叠。 - 对于

Winograd Schema Challenge,我们发现只有10个schemata与WebText训练集有8-gram overlap。其中,有2个是虚假的匹配,而剩下的8个中只有1个泄露了答案。 - 对于

CoQA而言,新闻领域中大约15%的文档已经出现在WebText中,该模型在这些数据集上提高了3 F1的性能。CoQA的验证集指标报告了5个不同领域的平均性能,由于不同领域上的overlap现象(与WebText训练集的重叠),我们测得约0.5 ~ 1.0 F1的增益。然而,由于CoQA是WebText的链接截止日期之后发布的,所以WebText中没有实际的训练问题或答案。 - 在

LAMBADA上,平均重叠为1.2%。在重叠大于15%的case上,GPT-2的表现提高了大约2 perplexity。在排除了所有任何overlap样本时,重新计算指标后,结果从8.6 perplexity变为8.7 perplexity,并将准确率从63.2%降低到62.9%。总体结果的变化较小,可能是因为200个样本中只有1个样本有明显的重叠。

总体而言,我们的分析表明:

WebText训练数据和特定的评估数据集之间的数据重叠为报告的结果提供了一个小的但是一致的好处。然而,对于大多数数据集而言,我们并没有发现比原始训练集和测试集之间已经存在的重叠而明显更大的重叠,正如上表所强调的。- 我们发现

了解和量化高度相似的文本如何影响性能是一个重要的研究问题。更好的去重技术(如,可扩展的模糊匹配)也可以帮助更好地回答这些问题。目前,我们建议使用基于

n-gram重叠的去重,作为新的NLP数据集创建train-test split时的一个重要验证步骤和理性检查。确定

WebText语言模型的性能是否归因于memory的另一个潜在方法是:检查它们在自己的held-out上的性能。如下图所示,WebText的训练集和测试集上的性能是相似的,并且随着模型规模的增加而共同提高。这表明,即使是GPT-2,它仍然在WebText上是欠拟合的。

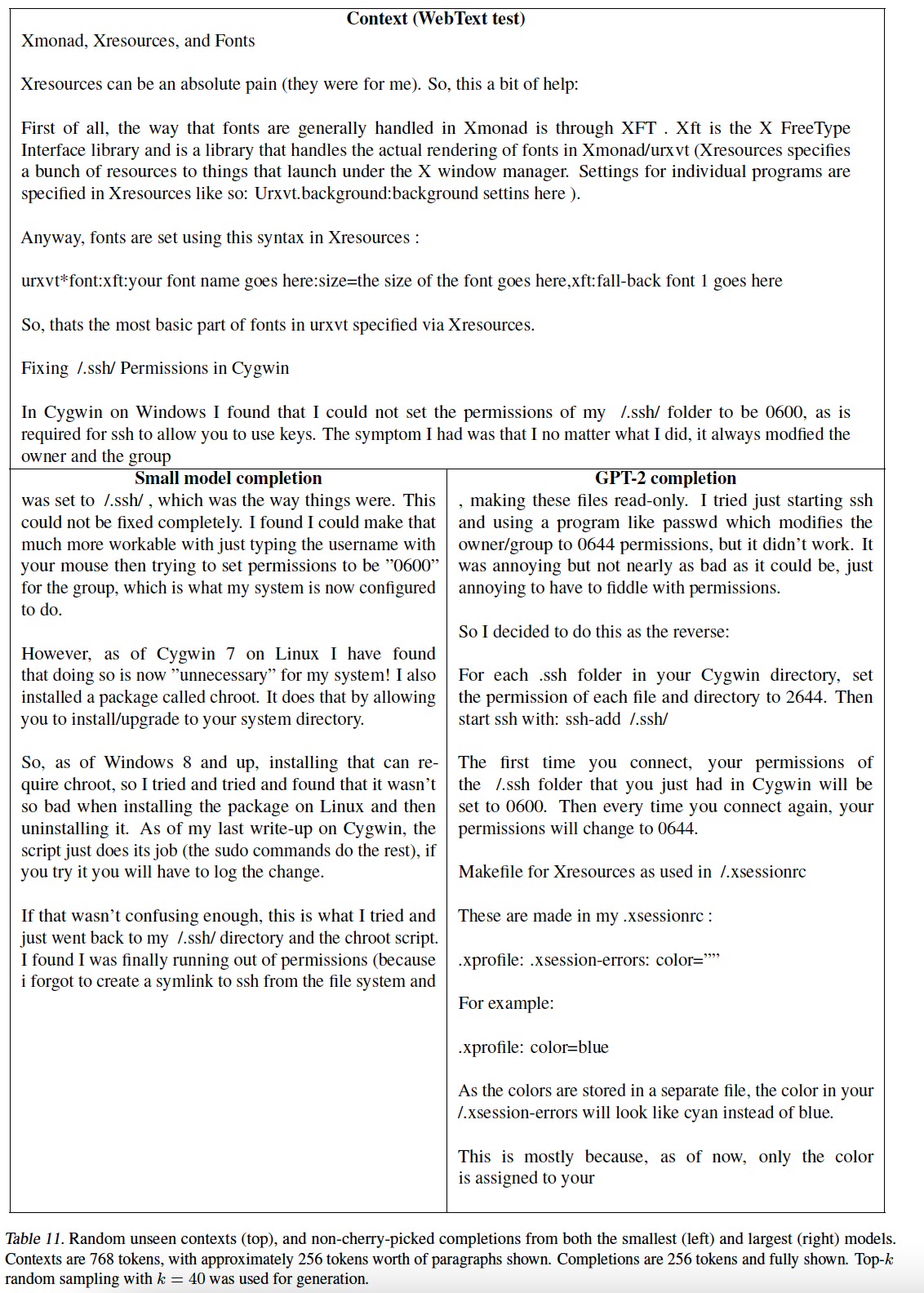

下表给出了最小的

WebText语言模型(GPT-2的最小版本)和GPT-2在随机未见的WebText测试集文章上的side-by-side completion:

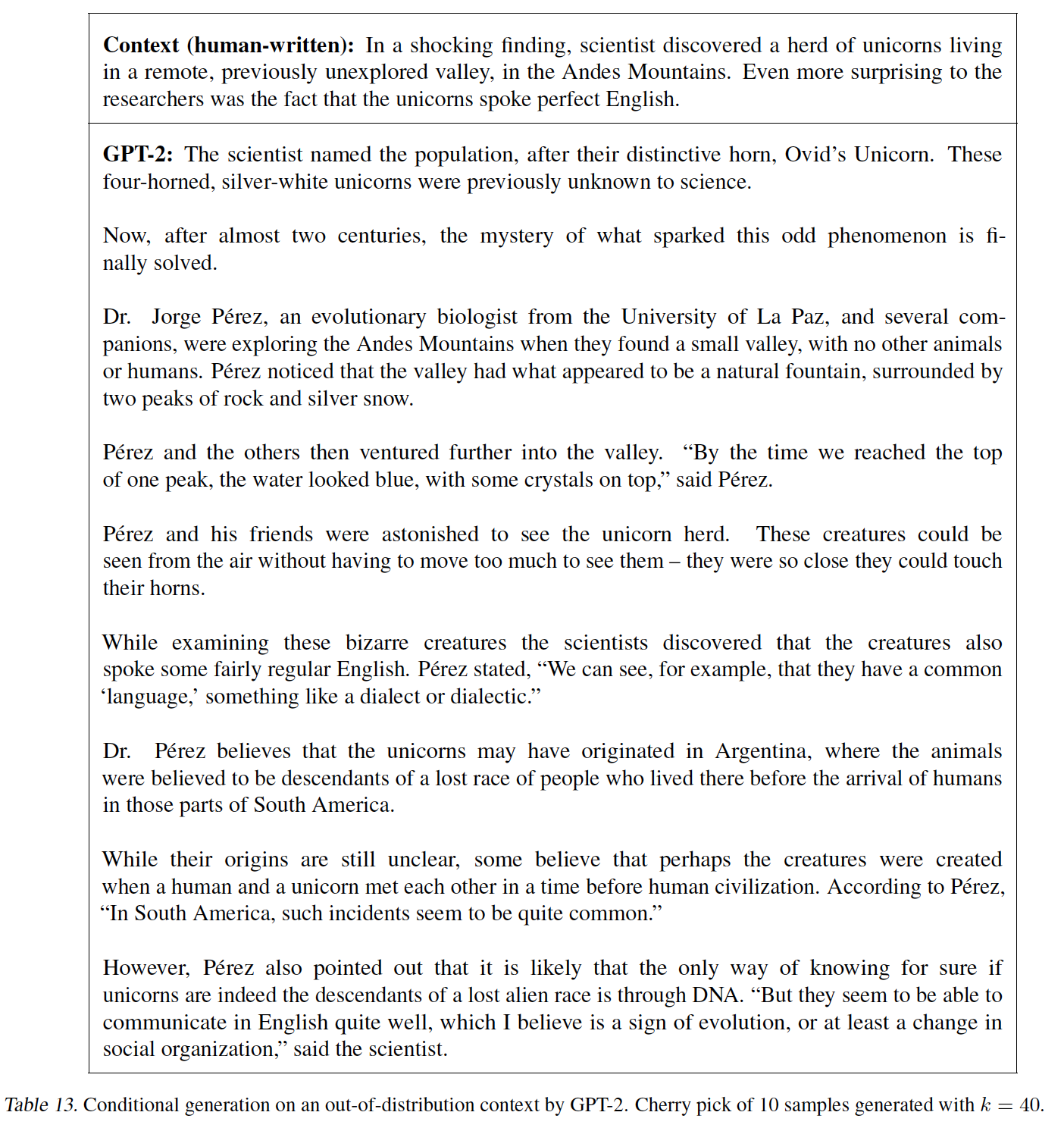

GPT-2也能写出关于发现会说话的独角兽的新闻文章。下表提出了一个例子。

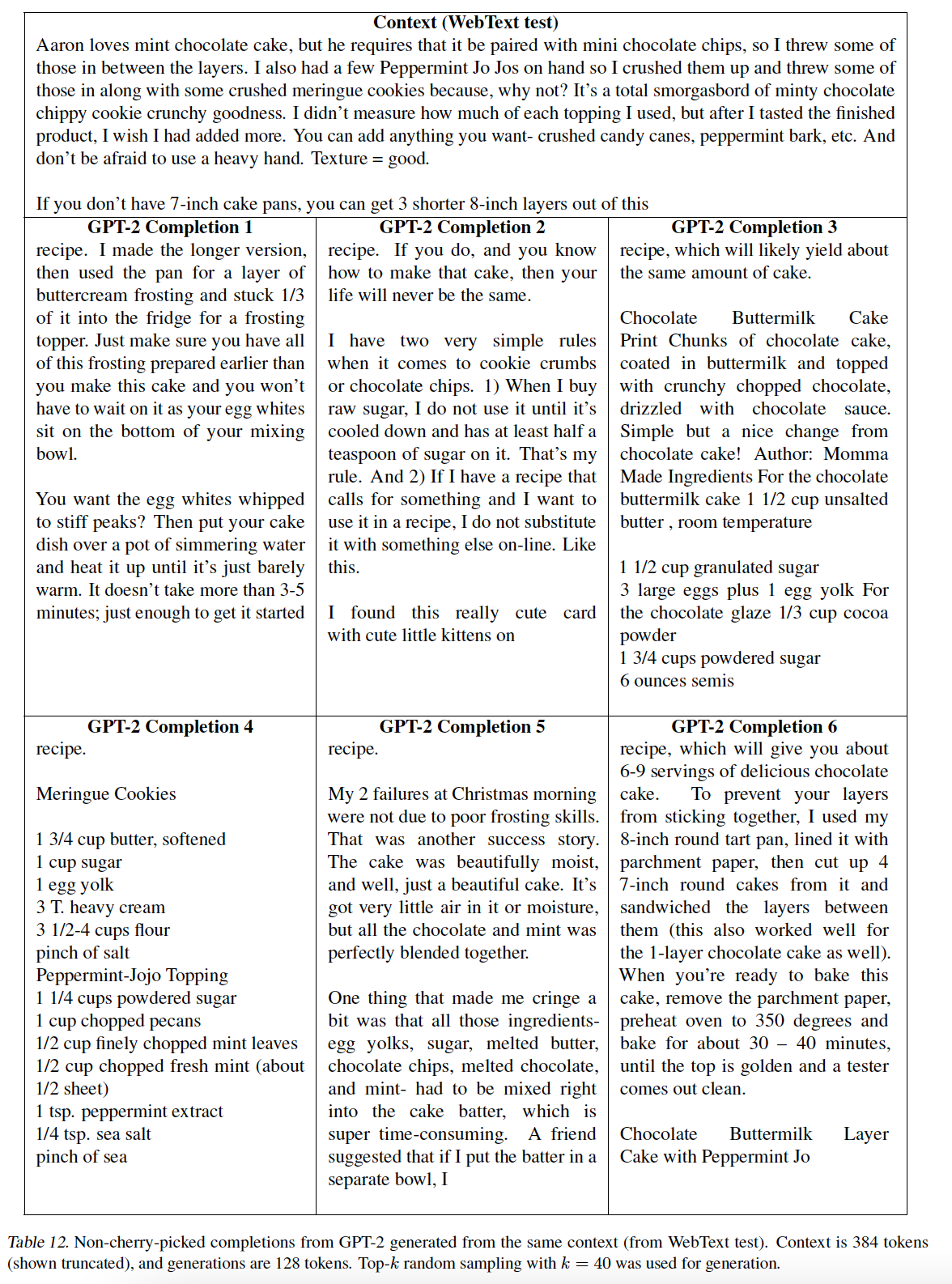

下表展示了同一个随机

WebText测试集上下文的多个completion,这显示了标准采样setting下,completion的多样性:

5.4 讨论

许多研究致力于学习

learning、理解understanding、批判性地评估evaluating有监督和无监督预训练方法的representation。我们的结果表明:无监督的任务学习是另一个有前途的、有待探索的研究领域。这些发现可能有助于解释预训练技术在下游NLP任务中的广泛成功。因为我们表明,在极限情况下,某些预训练技术开始直接学习执行任务,而不需要监督的适配或修改。在阅读理解方面,

GPT-2在zero-shot setting下的性能与监督的baseline是可比的。然而,在其它任务上(如summarization),虽然GPT-2执行了任务,但是根据定量指标,其性能仍然只是入门级的。作为一项研究成果而言,GPT-2是有启发意义的。而就实际应用而言,GPT-2的zero-shot性能还远未达到可使用的程度。我们已经研究了

WebText语言模型在许多典型NLP任务上的zero-shot性能,但还有许多其它任务可以评估。毫无疑问,在许多实际任务中,GPT-2的性能仍然不比随机的好。即使在我们评估的常见任务上(如问答和翻译),语言模型只有在足够的模型容量时才开始超越最平凡的baseline。虽然

zero-shot性能为GPT-2在许多任务上的潜在性能建立了一个baseline,但是并不清楚微调的上限在哪里。在某些任务上,GPT-2的fully abstractive output与基于extractive pointer network的输出有很大不同,后者是目前许多问答和阅读理解数据集上的state-of-the-art。鉴于之前微调GPT的成功,我们计划在decaNLP和GLUE等benchmark上研究微调,尤其是目前还不清楚GPT-2的额外训练数据和容量是否足以克服BERT所展示的单向representation的低效率问题。

六、GPT3[2020]

近年来,在

NLP系统中出现了预训练语言representation的趋势,并以越来越灵活的、与任务无关task-agnostic的方式应用于下游任务。- 首先出现的是通过词向量学到的

single-layer representation,然后馈入到特定的任务架构。 - 然后出现的是具有多层

representation和上下文状态的RNN,从而形成更强大的representation。 - 最近出现的是预训练的

RNN或transformer语言模型,它们被直接微调从而消除了对特定任务task-specific架构的需求。

最后一种范式在许多具有挑战性的

NLP任务上取得了实质性的进展,并在新的架构和算法的基础上继续推进。然而,这种方法的一个主要局限性是,虽然它的架构是任务无关的,但是仍然需要特定任务的微调fine-tunning:要在目标任务上获得强大的性能,通常需要在特定于该任务的、具有数千到数十万个样本的数据集上进行微调。人们希望消除这个局限性,原因如下:- 首先,从实用性角度来看,每一项新任务都需要一个大型的标记数据集,这限制了语言模型的适用性。对很多任务而言,收集一个大型的监督训练数据集就很困难,特别是需要为每个新的任务重复这个收集过程。

- 其次,过拟合从根本上说是随着模型的表达能力以及训练分布的窄化

narrowness的增加而增加。这可能会给预训练加微调的模式带来问题,在这种模式下,模型被设计得很大以便在预训练期间吸取信息,但是随后在很窄的任务分布中进行微调。有证据表明,这种范式下实现的泛化能力可能很差,因为模型过度具体于specific to训练分布,没有很好地泛化到训练分布之外(这里的训练分布指的是微调数据集)。因此,微调模型在特定benchmark上的性能,即使名义上是人类水平,也可能夸大了微调任务上的实际性能。 - 第三,人类不需要大量的监督数据集来学习大多数语言任务,简短的语言指令、或极少的示范

demonstration就足以使人类执行一项新任务。这种适应性除了解决上述NLP技术的局限性之外,还允许人类在许多任务和技能之间无缝切换,如在冗长的对话任务中进行加法任务。为了发挥更广泛的作用,我们希望有一天我们的NLP系统也能有这样的流畅性和通用性。

解决这些问题的一个潜在途径是

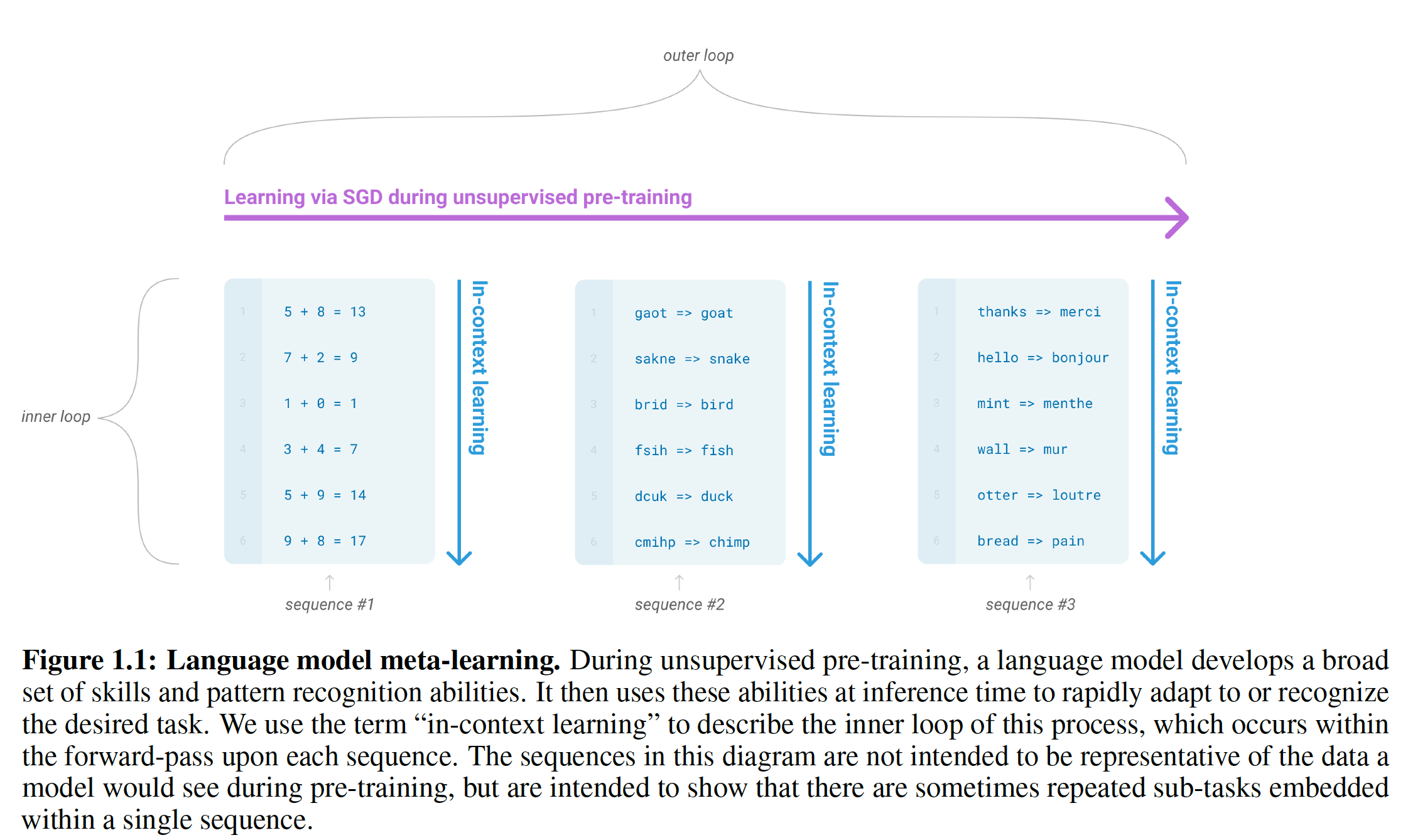

meta-learning:在语言模型的背景下,这意味着模型在训练时发展出一组广泛的技能以及模式识别能力,然后在推理时使用这些能力来快速适应或识别目标任务(如下图所示)。最近的工作GPT-2试图通过我们所说的in-context learning来做到这一点,它使用预训练的语言模型的文本输入作为一种任务规范task specification形式:GPT-2以自然语言指令和/或任务的几个示范demonstration为条件,然后预期模型通过预测接下来的内容来完成任务。虽然GPT-2已经显示出一些初步的希望,但是它所取得的结果仍然远远不如微调。meta-learning显然需要大量的改进,以便作为解决语言任务的实用方法。【作者注:在下图中,我们使用术语

in-context learning来描述这个过程的内循环,其中内循环发生在每个序列的前向传播中,下面每个子图代表一个序列(注意,并不是一行一个序列,而是多行代表一个序列)。该图中的序列并不是代表模型在预训练期间所看到的数据,只是表明有时在一个序列中会有重复的子任务。】

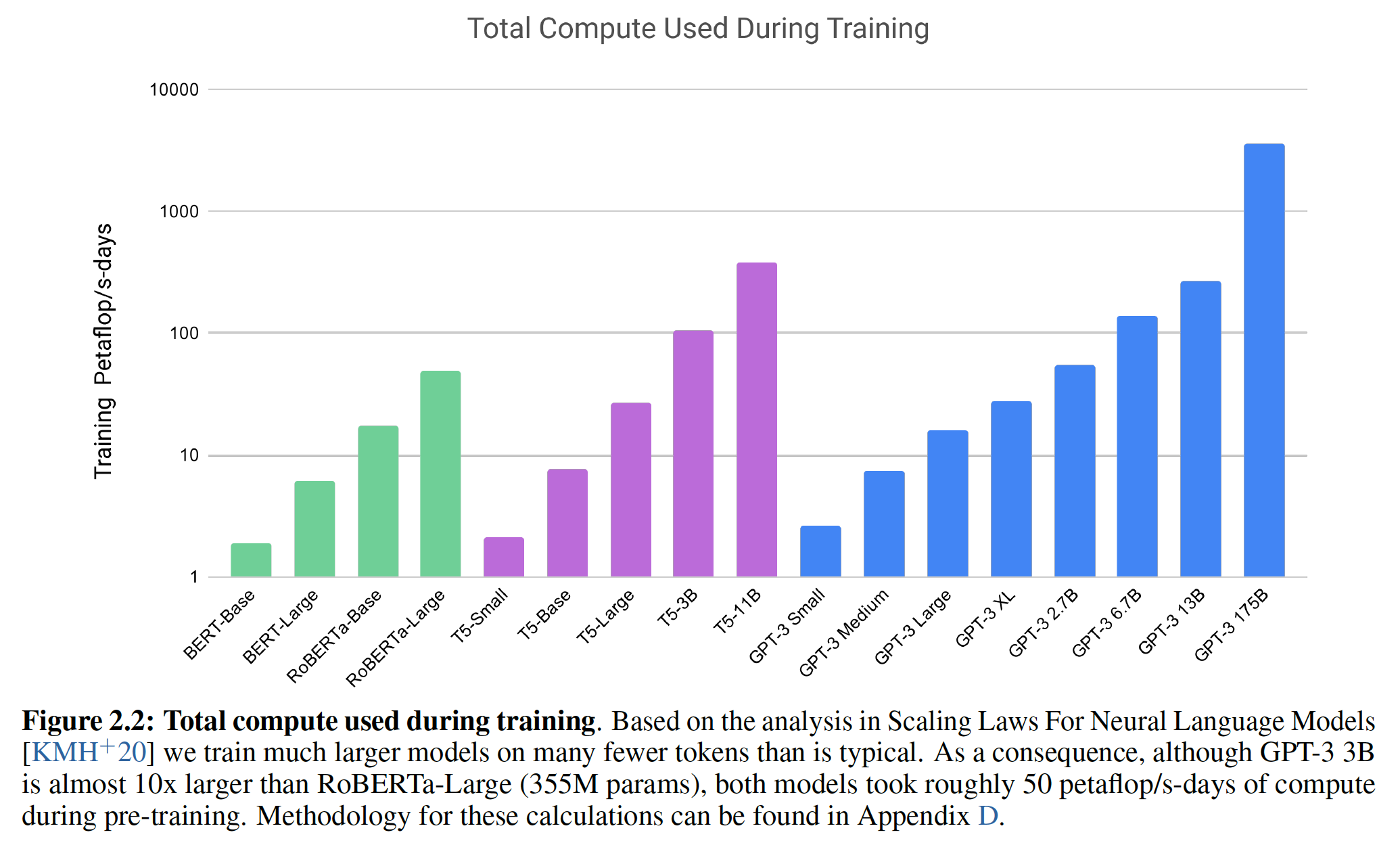

语言建模的另一个最新趋势可能提供了一条前进的道路。近年来,

transformer语言模型的容量大幅增加,从1亿个参数的GPT-1,到3亿个参数的BERT,到15亿个参数的GPT-2,到80亿个参数的Megatron,到110亿个参数的T5,最后到170亿个参数的Turing。每一次规模增加都带来了文本合成text synthesis和/或下游NLP任务的改进。而且有证据表明,log loss(它与许多下游任务关联性较好) 随着模型规模的增加而有平滑的改进趋势(《Scaling laws for neural language models》)。由于in-context learning涉及到在模型的参数中吸取许多技能和任务,因此,in-context learning能力可能会随着模型规模的扩大而表现出相似的强大收益,这是合理的。一言以蔽之,这个方向就是:模型规模要超级大。

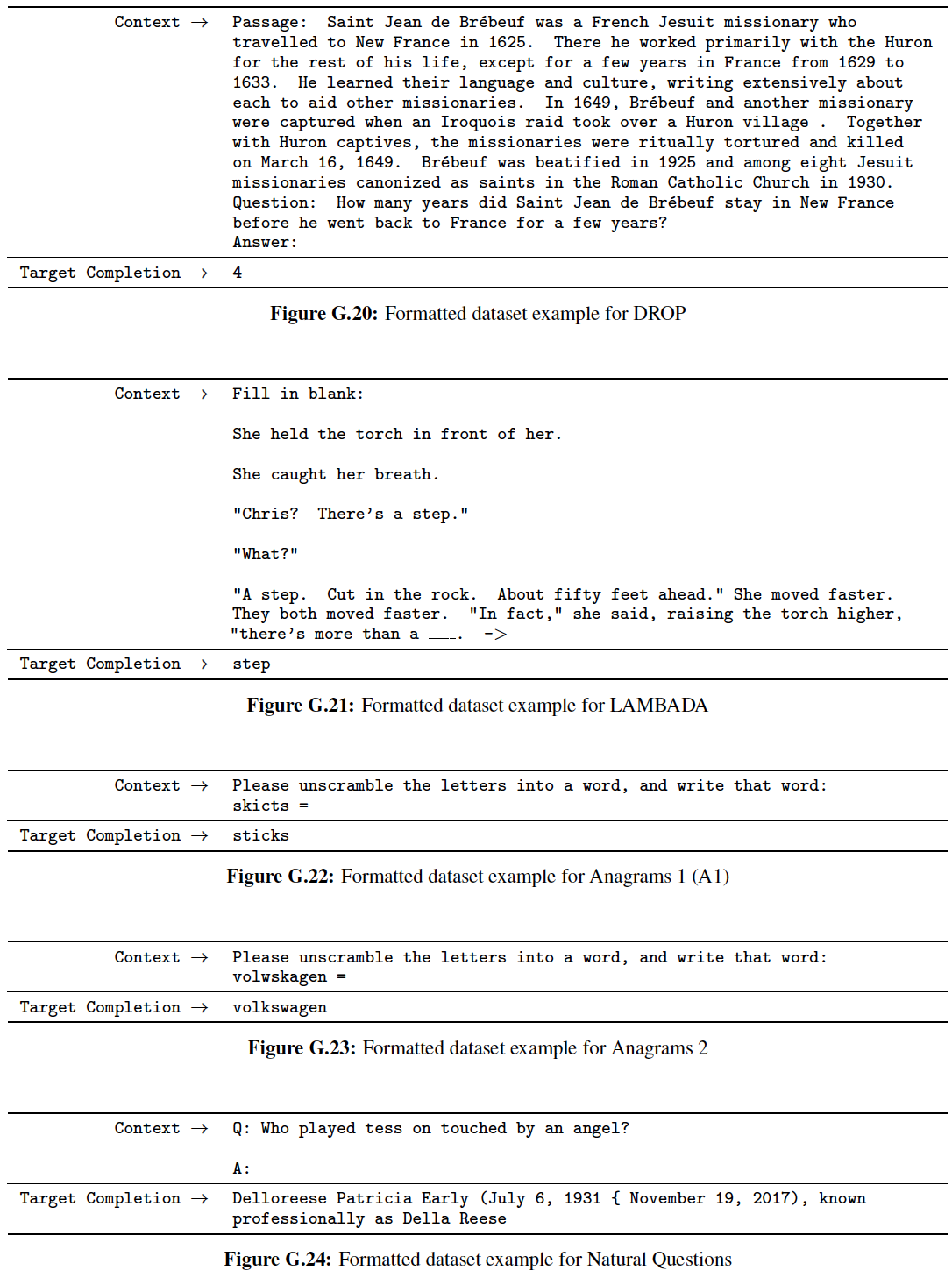

在论文

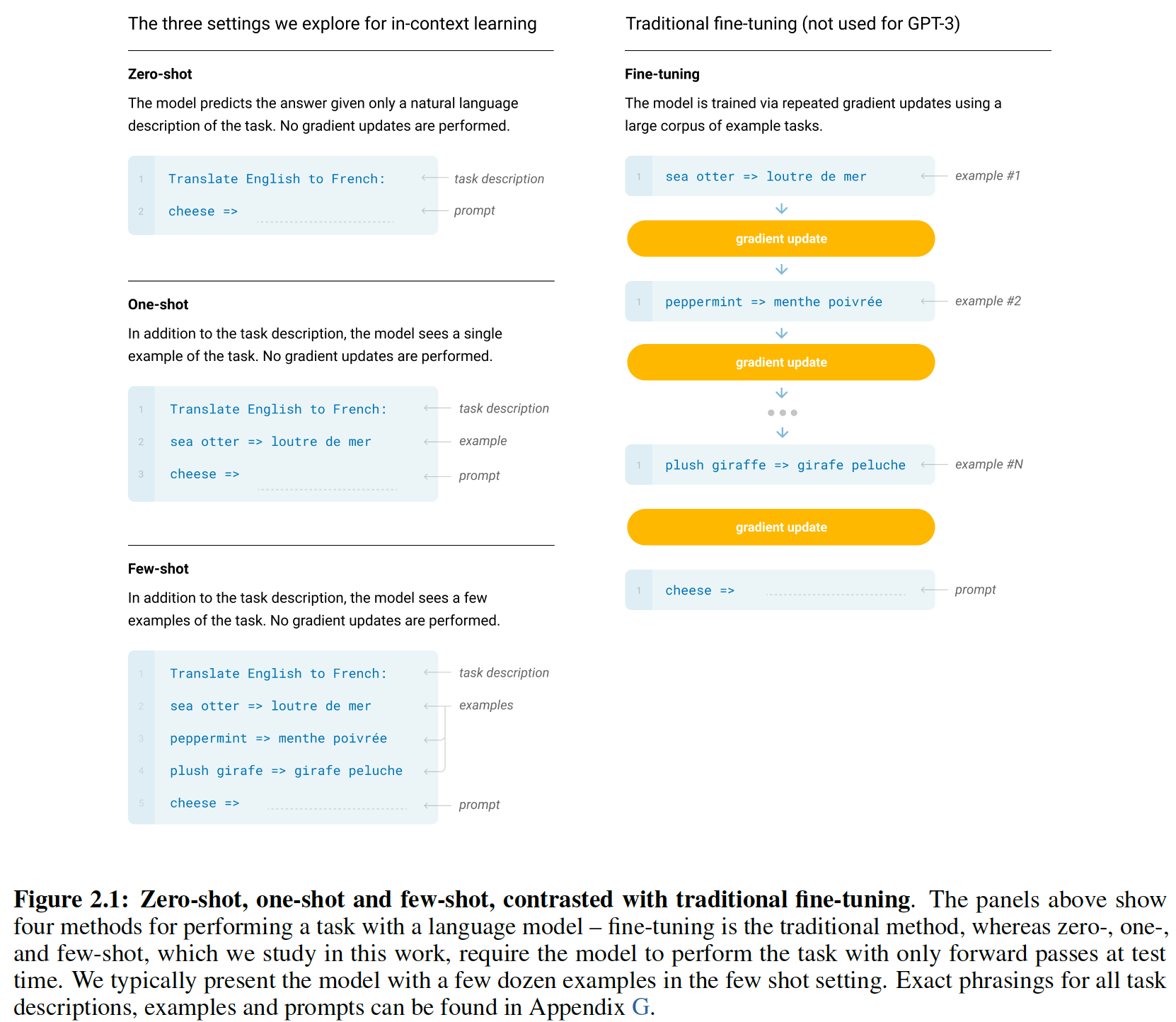

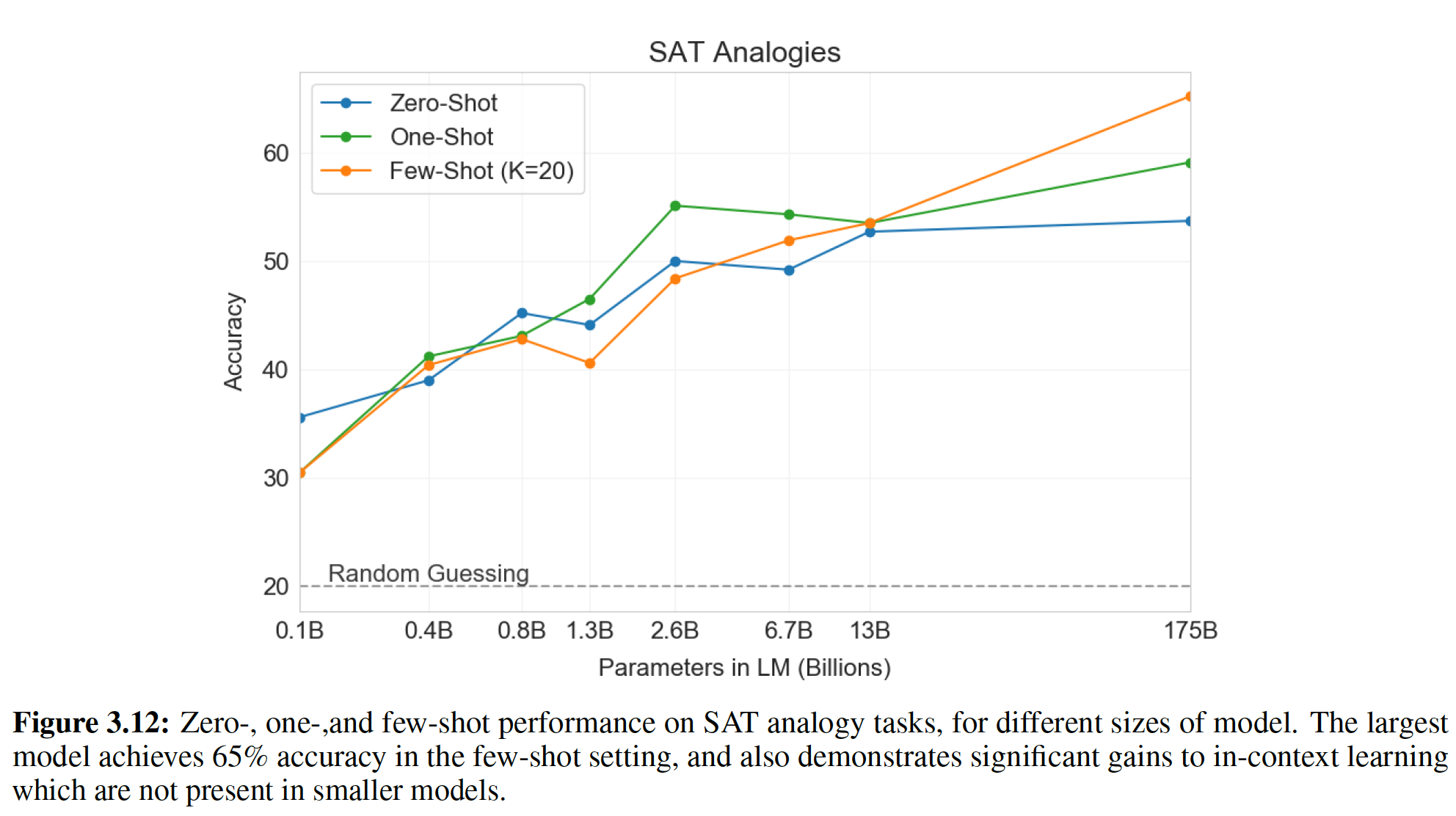

《Language Models are Few-Shot Learners》,我们通过训练一个1750亿参数的自回归语言模型autoregressive language model(我们称之为GPT-3),并测量其in-context learning能力来测试这个假设。具体而言,我们在二十多个NLP数据集以及几个新颖的任务上评估GPT-3。对于每个任务,我们三种setting下评估GPT-3:few-shot learning(或in-context learning):我们允许尽可能多的示范,从而适应模型的上下文窗口context window(通常是10到100)。one-shot learning:我们只允许一个示范。zero-shot learning:没有任何示范,只给模型提供一条自然语言的指令。

理论上讲,

GPT-3也可以在传统的微调setting中进行评估,但是我们将此留给未来的工作。下图说明了我们的研究条件,并展示了对一个简单任务的

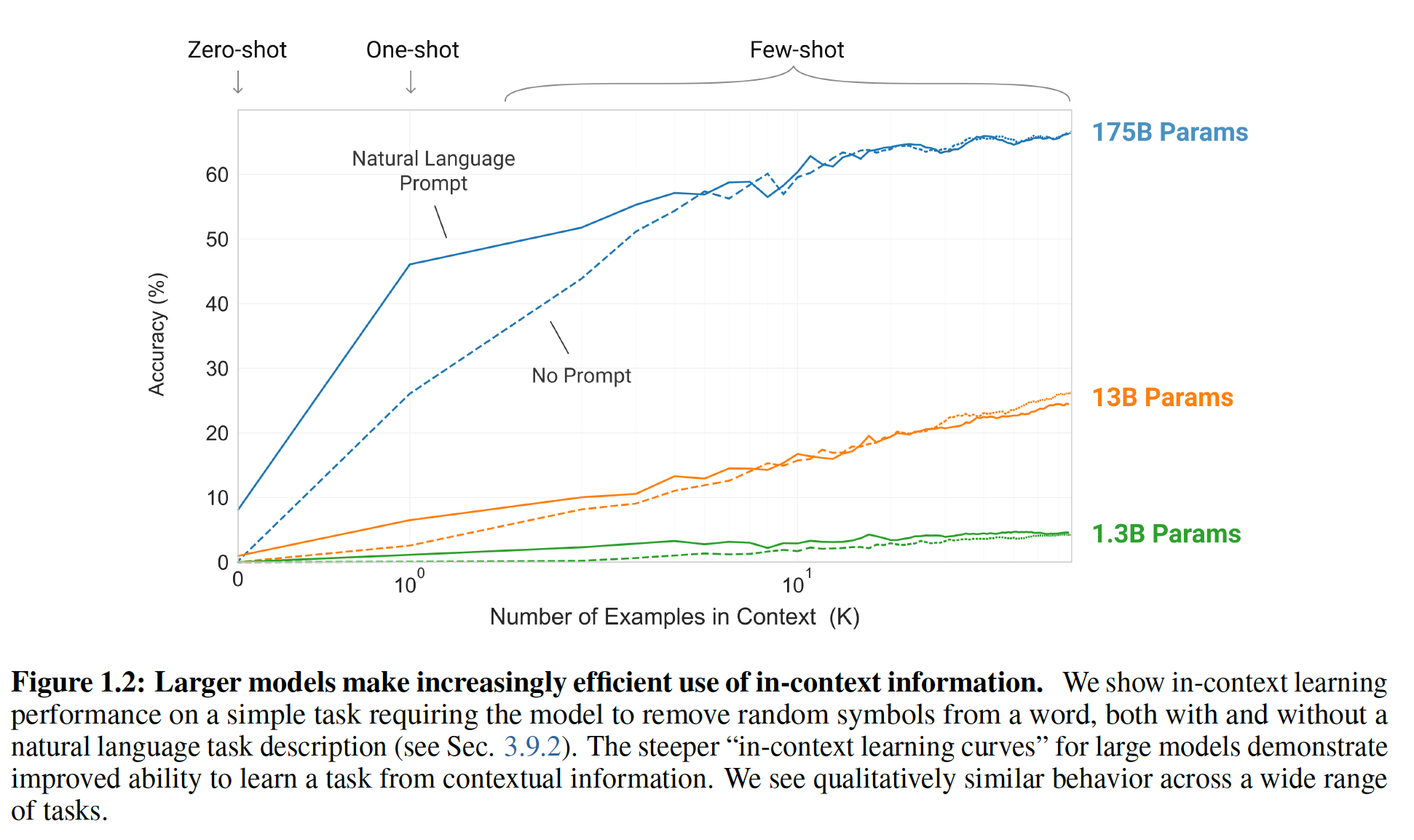

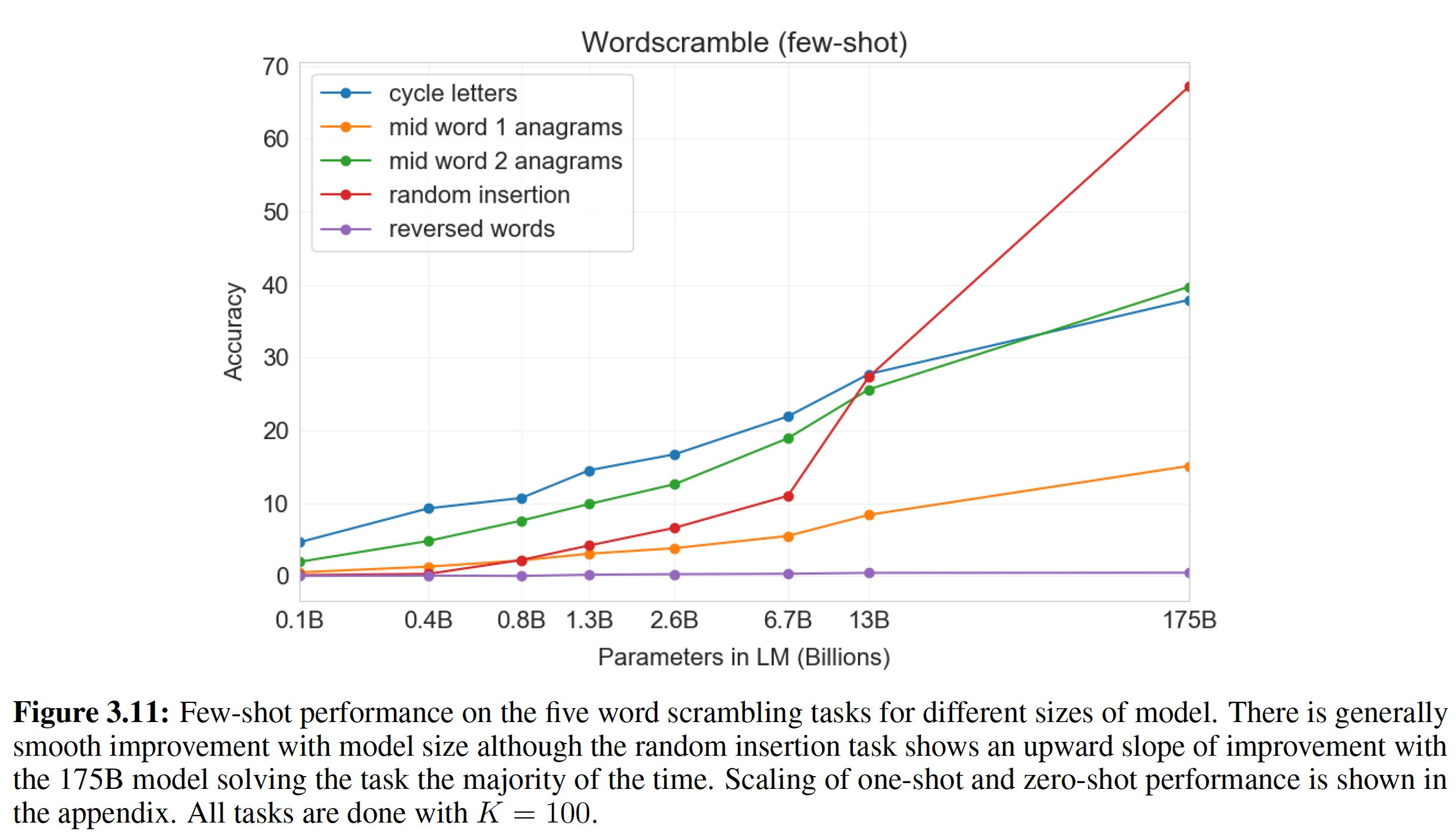

few-shot learning,该任务要求模型从一个单词中移除不相干的symbol。- 模型的性能随着自然语言任务的

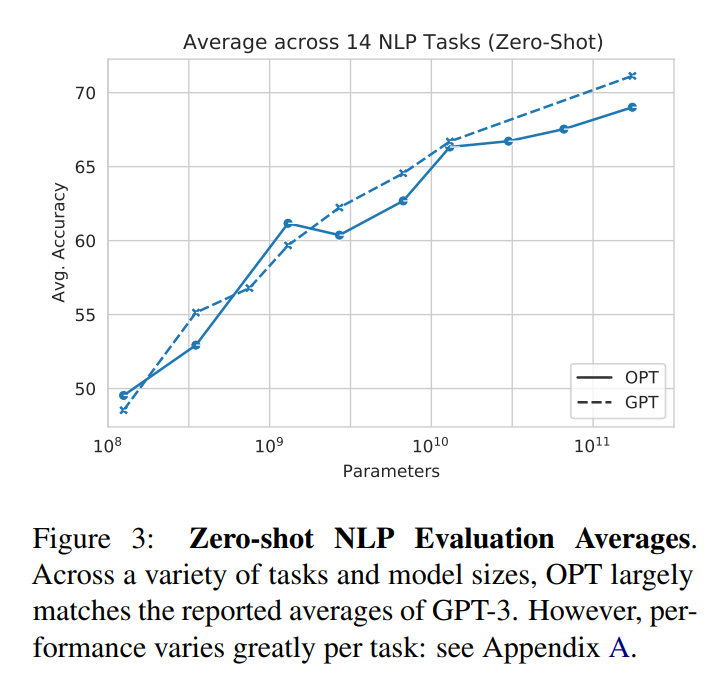

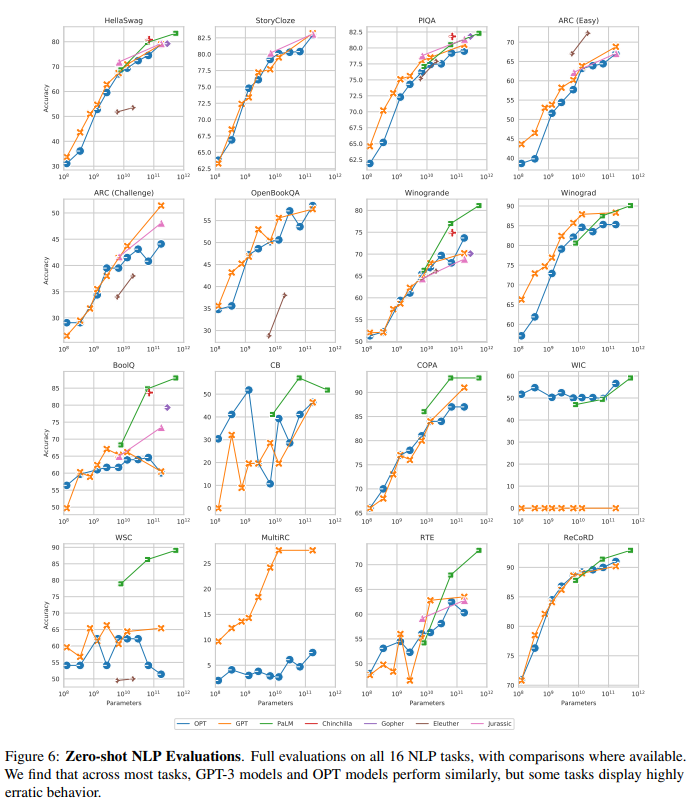

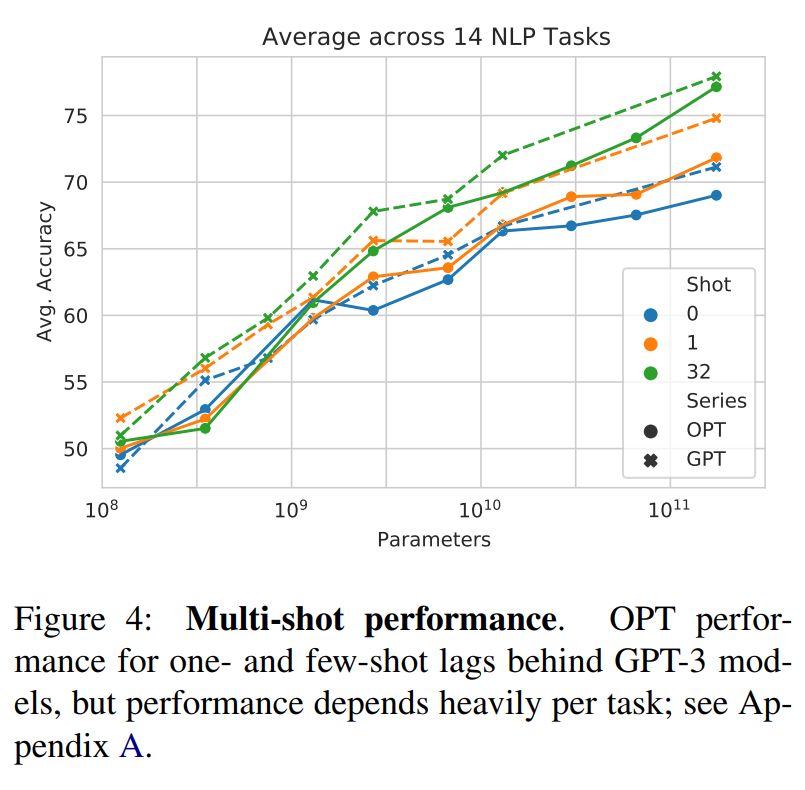

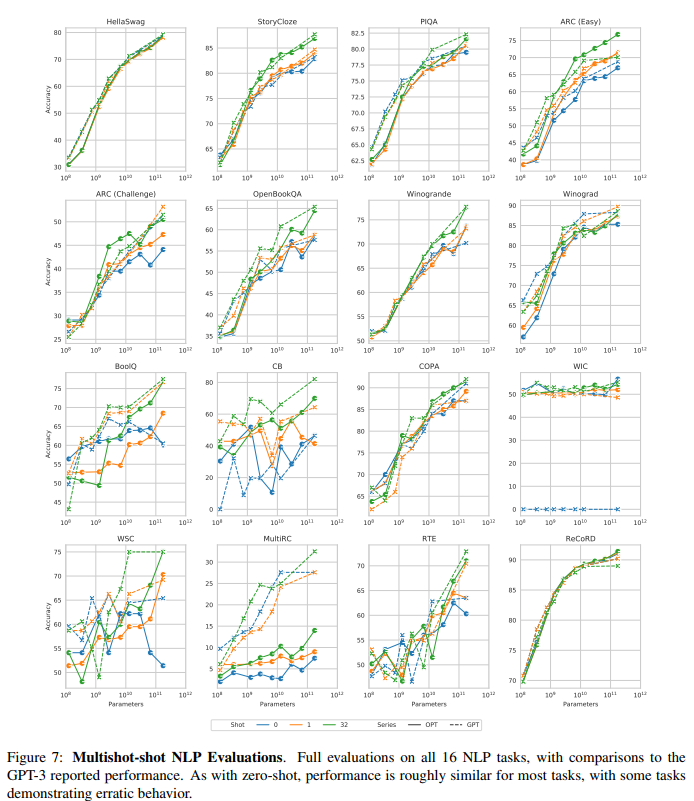

description的增加而增加(即有prompt的效果优于没有prompt)。下图实线表示有prompt,虚线表示没有prompt。 - 模型的性能也随着模型上下文中的样本数量(即

zero-shot,one-shot,few-shot。 few-shot learning性能也随着模型规模的增加而显著提高。

虽然这种情况下的结果特别引人注目,但是模型规模和上下文中的样本数量的一般趋势在我们研究的大多数任务中都适用。我们强调,这些

learning curve不涉及梯度更新或微调,只是增加了作为条件的示范的数量。【作者注:较大的模型对上下文信息的利用越来越有效。大型模型的

in-context learning curves越陡峭,则表明从contextual information中学习一个任务的能力越好。】

大体上,在

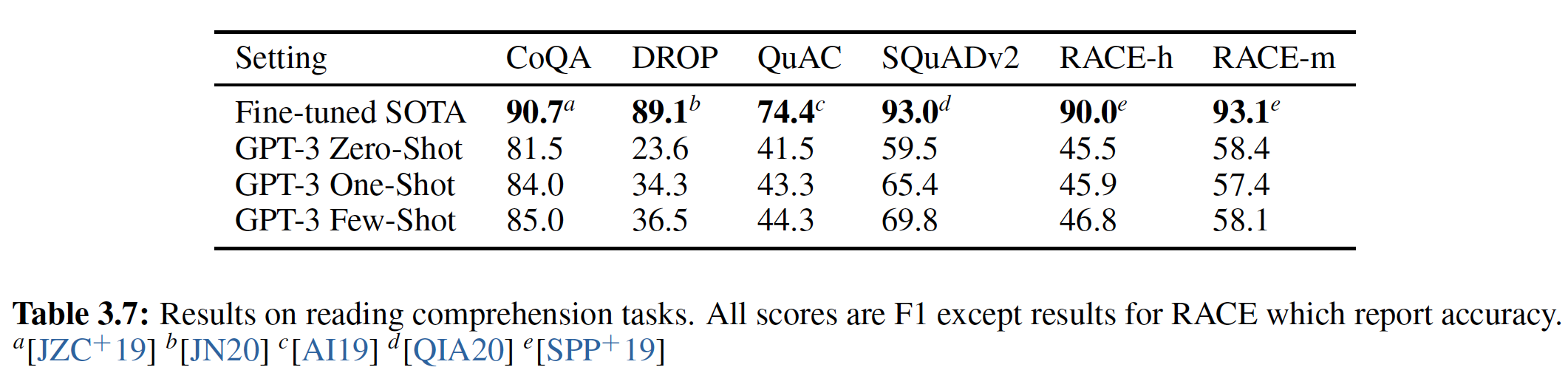

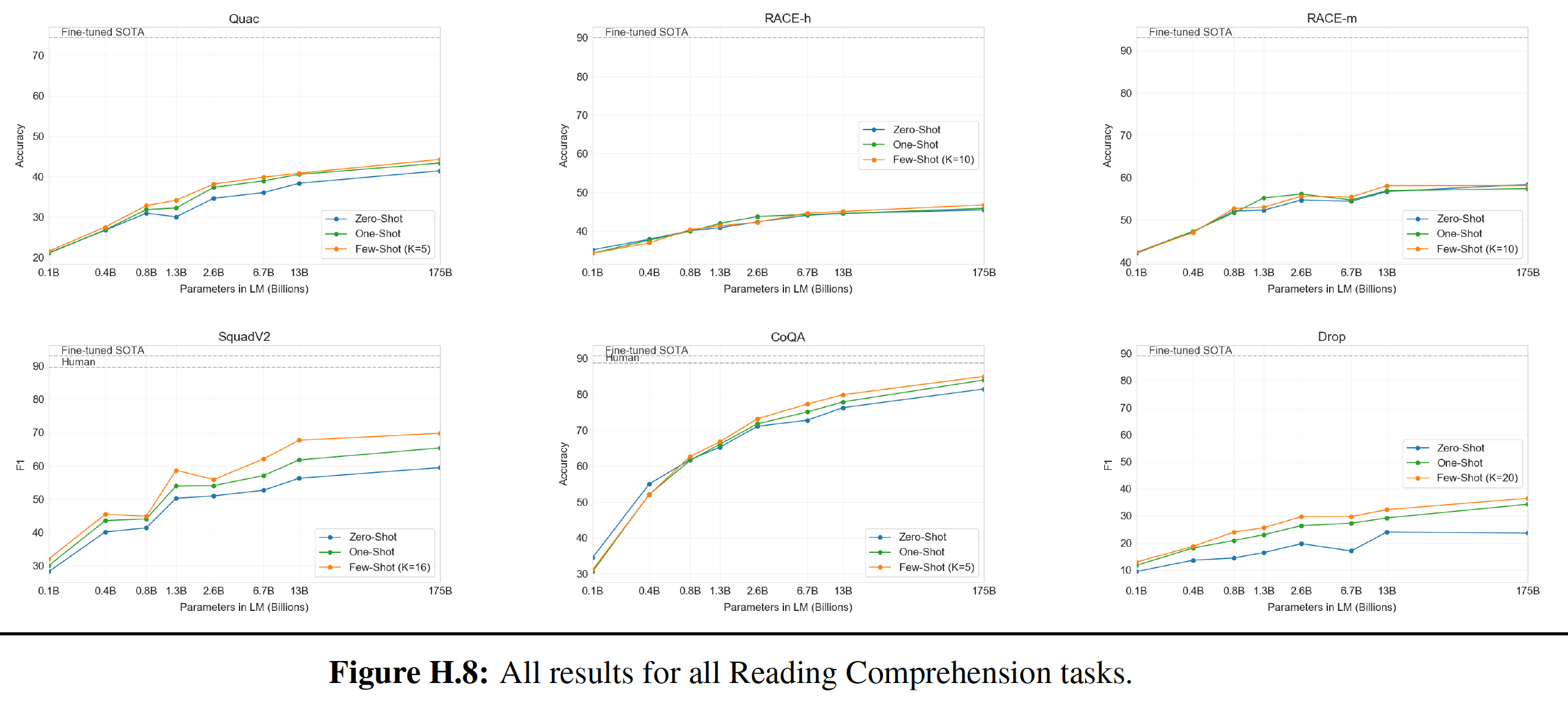

NLP任务中,GPT-3在zero-shot/one-shot setting中取得了有希望的结果;而在few-shot的setting中有时具有与SOTA相同的竞争力,甚至偶尔超越了SOTA(SOTA是由微调模型获得的)。例如:- 在

CoQA数据集上,GPT-3在zero-shot/one-shot/few-shot setting中实现了81.5/84.0/85.0 F1。 - 类似地,在

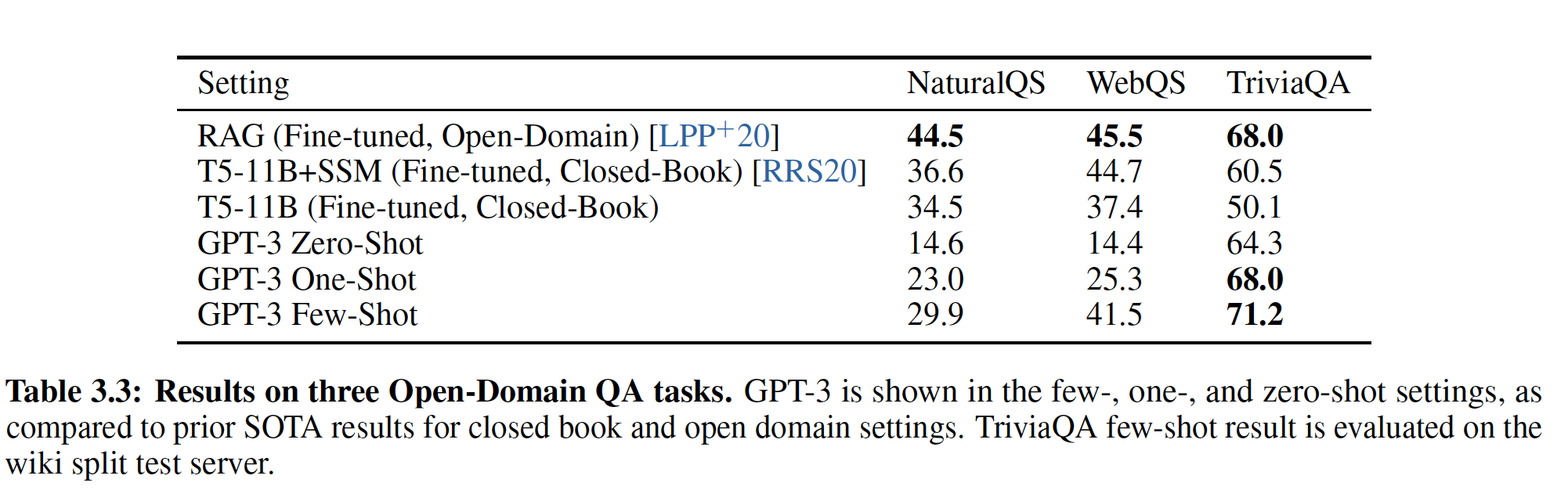

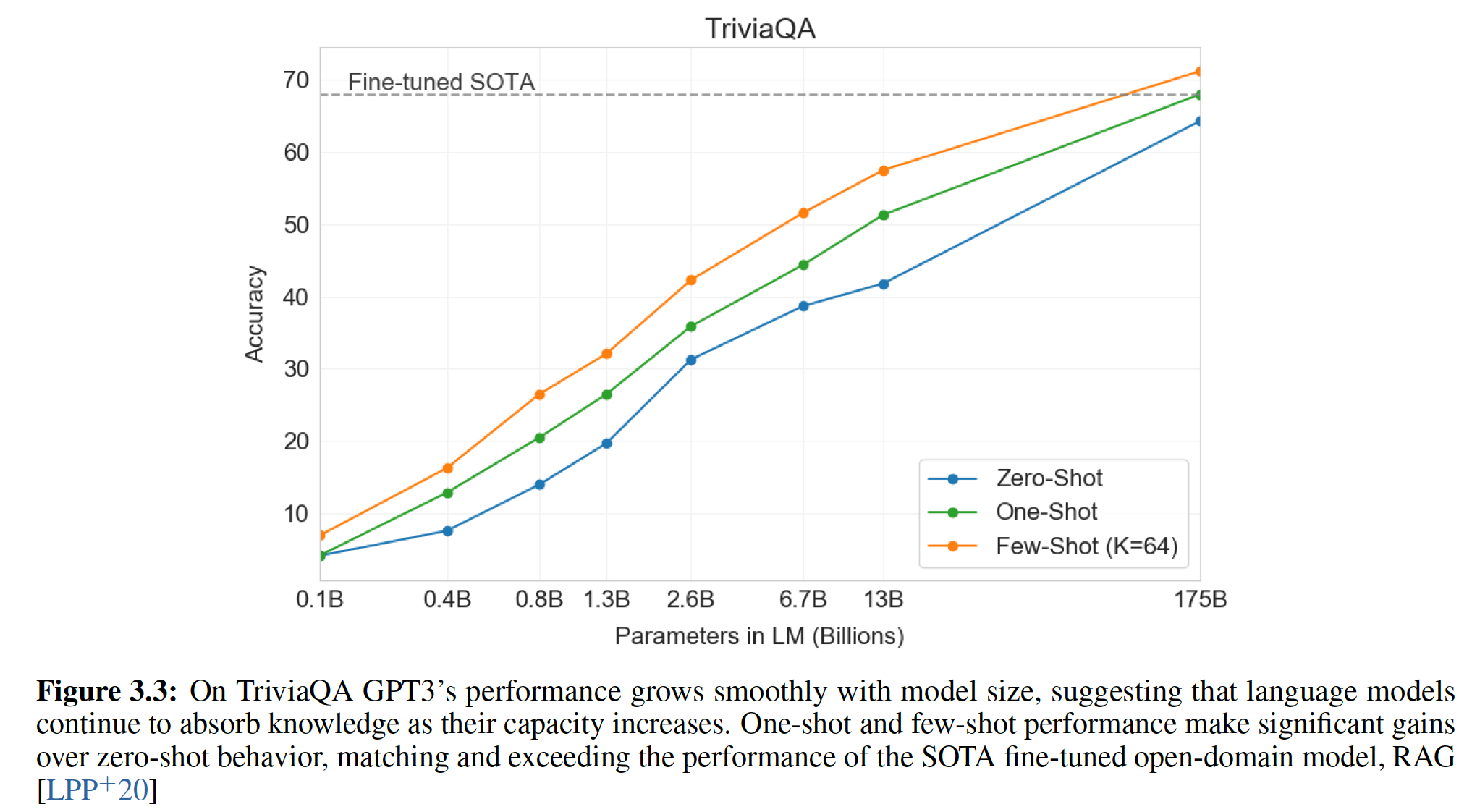

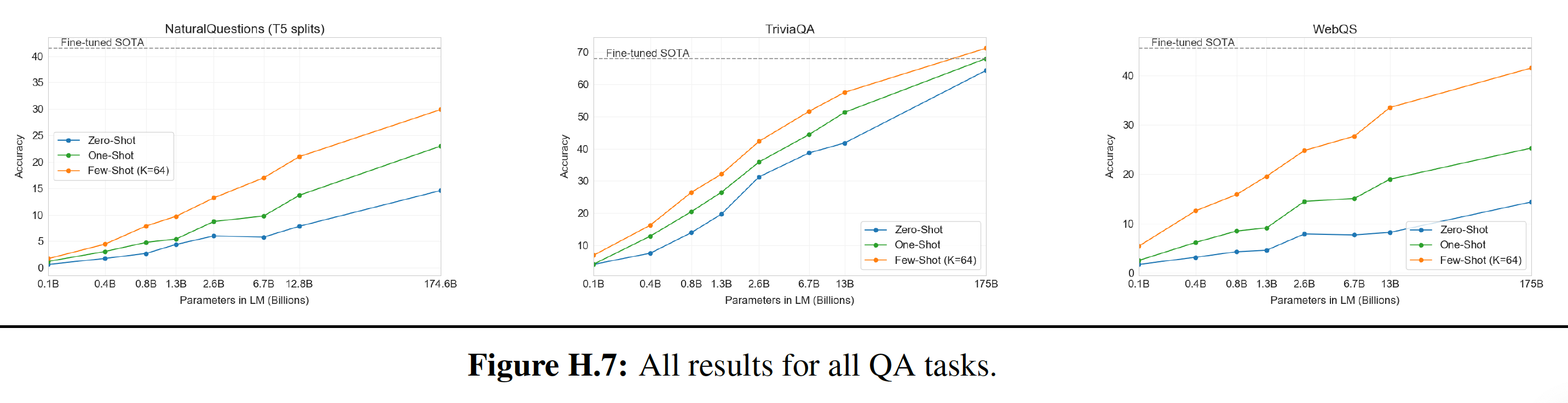

TriviaQA数据集上,GPT-3在zero-shot/one-shot/fiew-shot setting中实现了64.3%/68.0%/71.2%的准确率。其中few-shot的结果超越了在相同的closed-book setting下的微调模型,达到了SOTA。

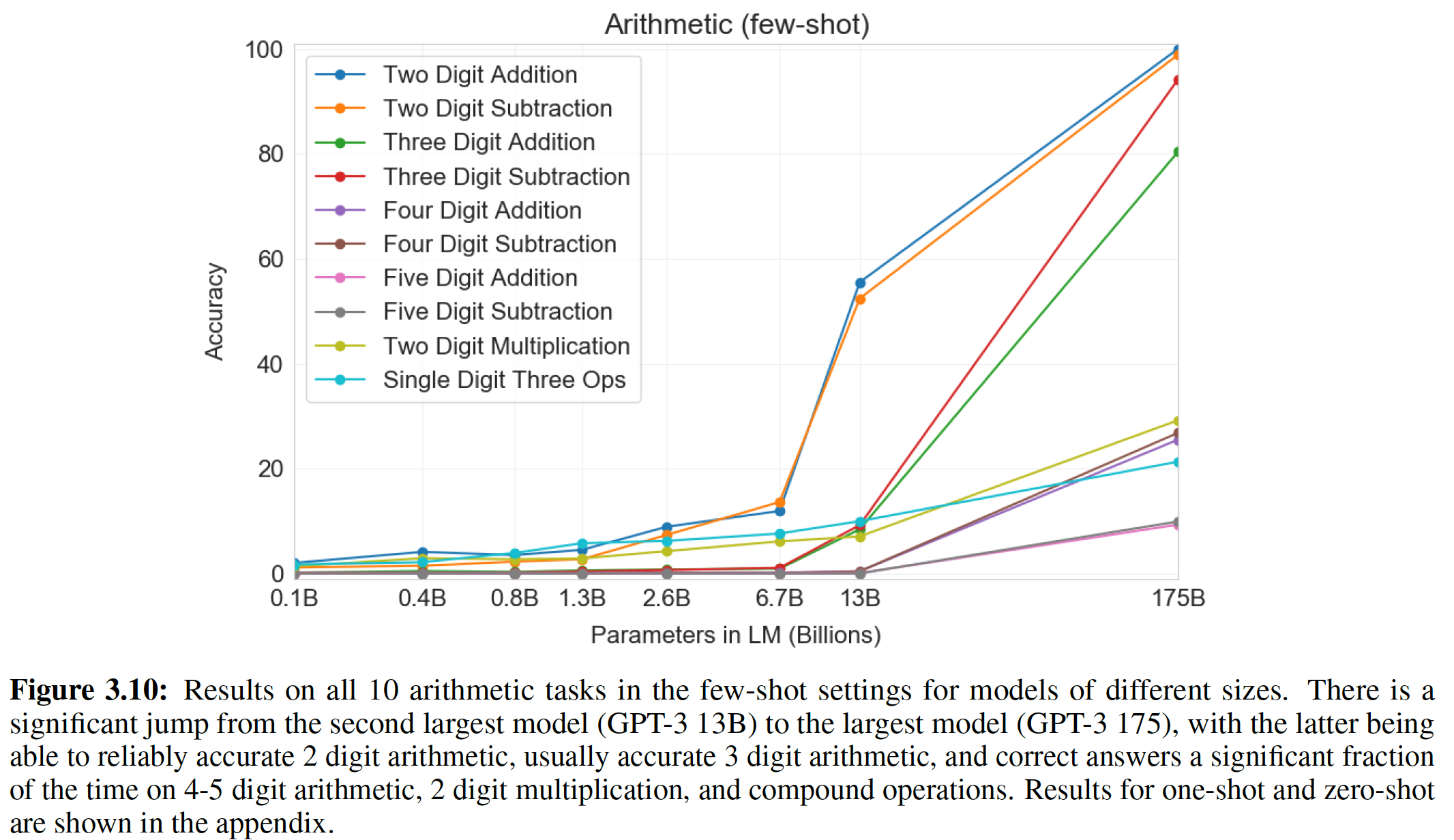

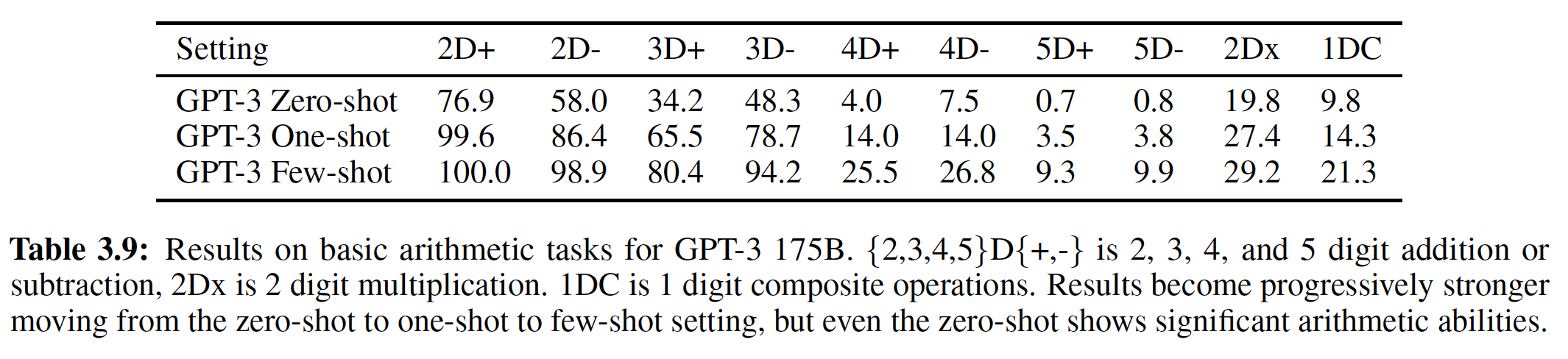

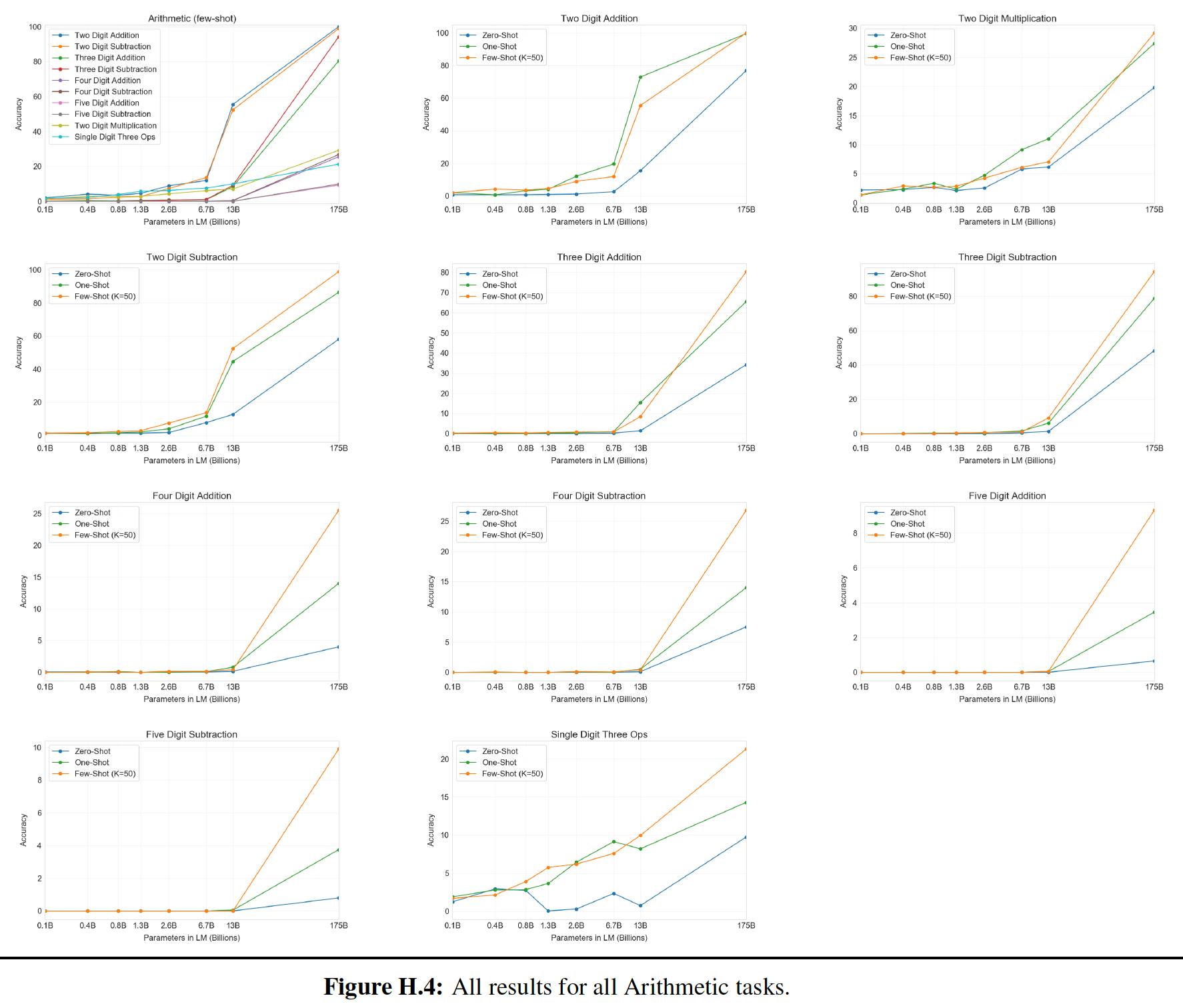

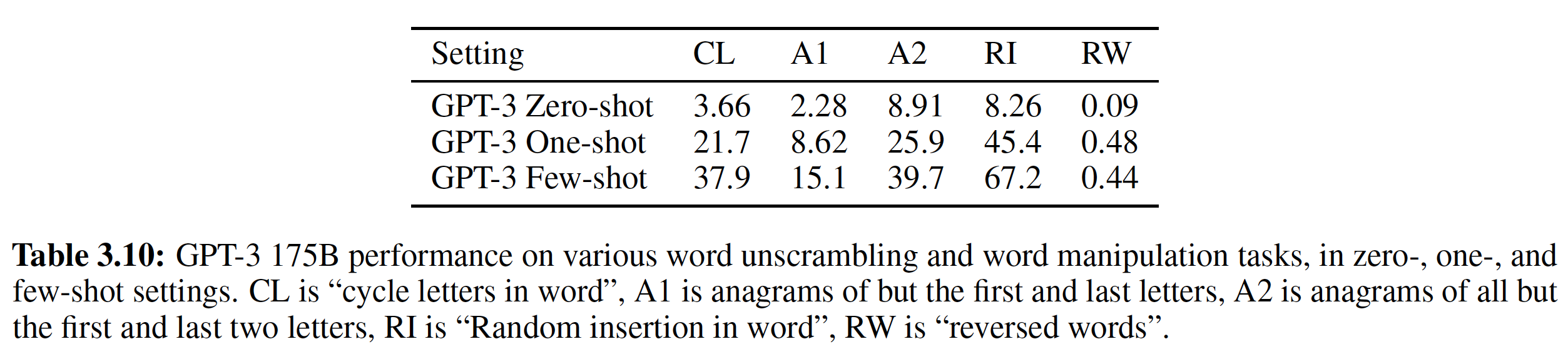

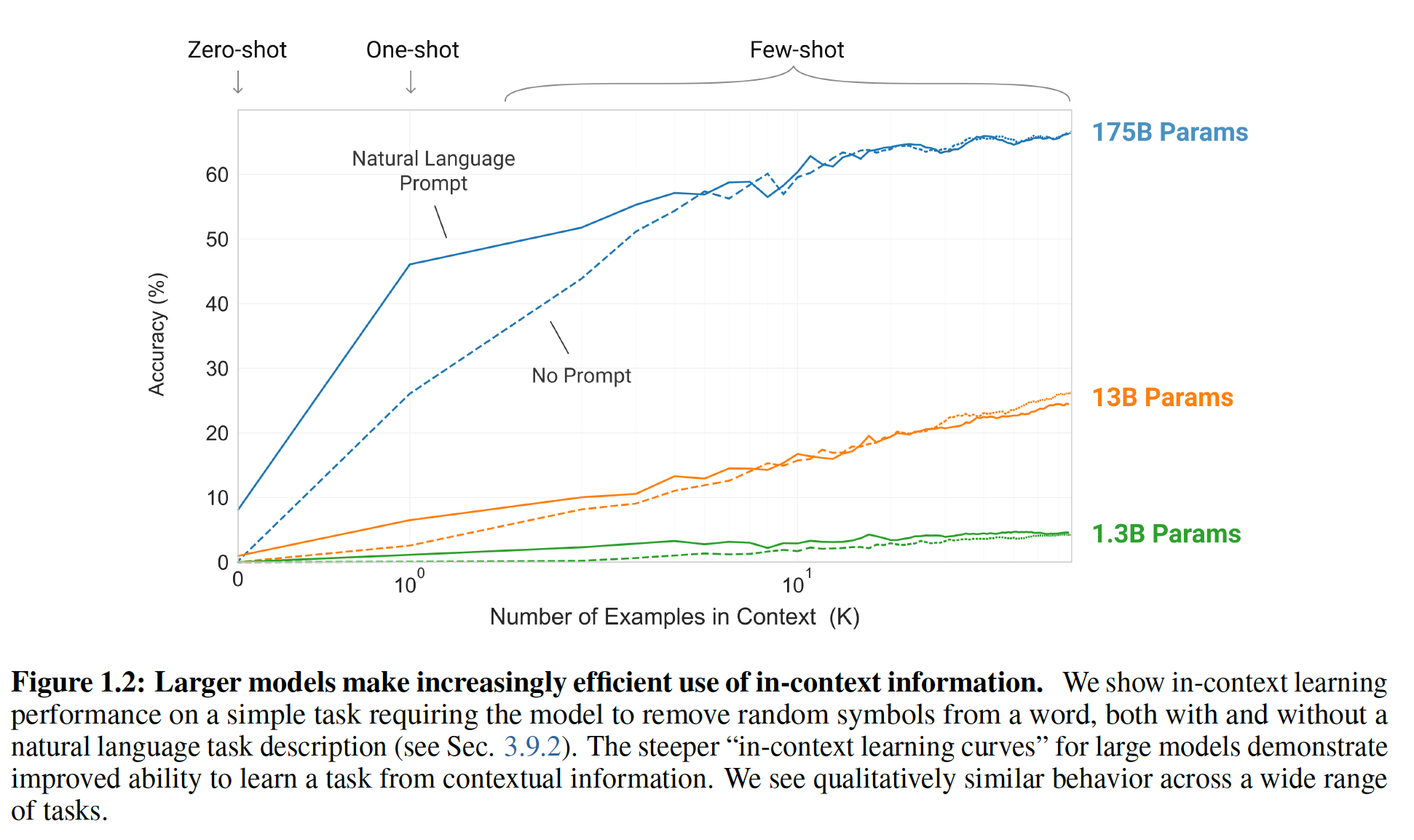

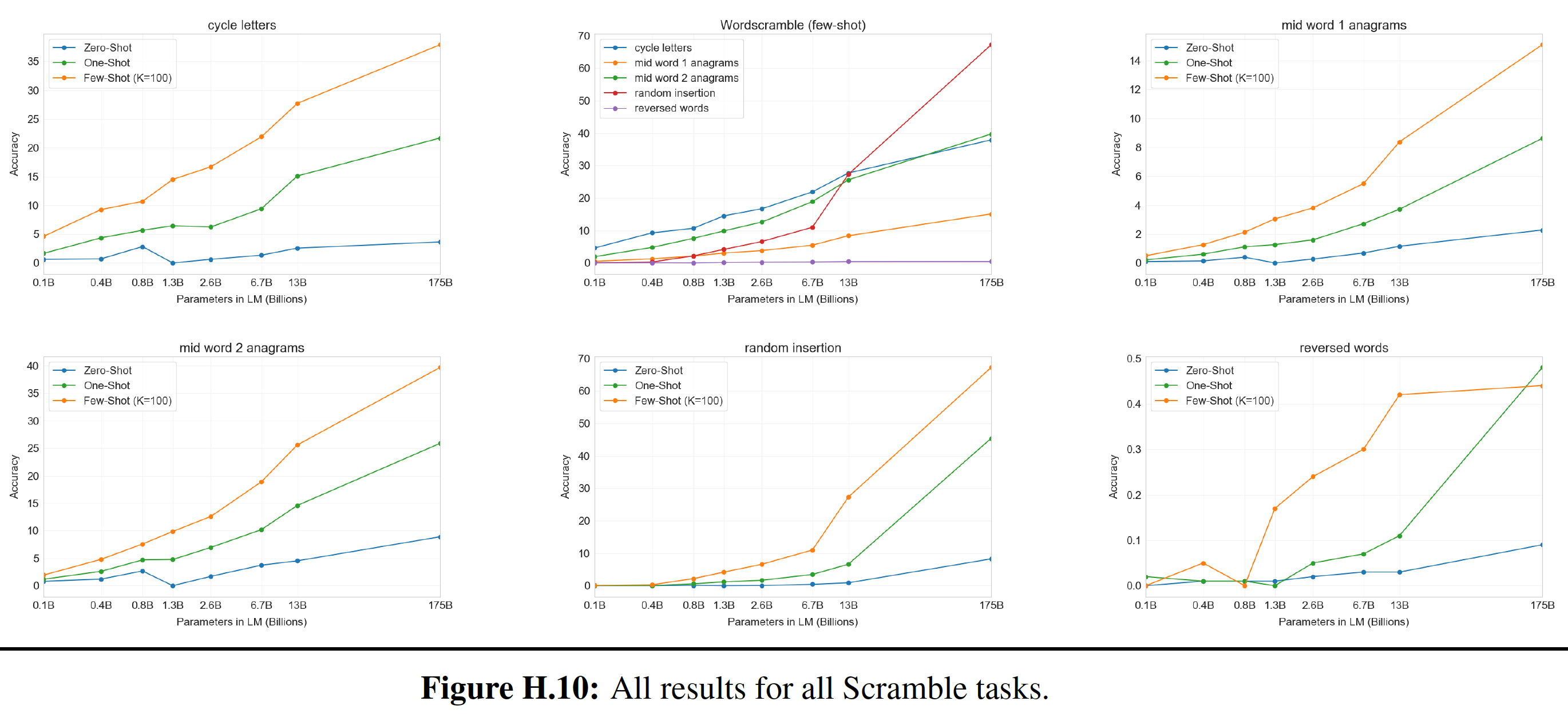

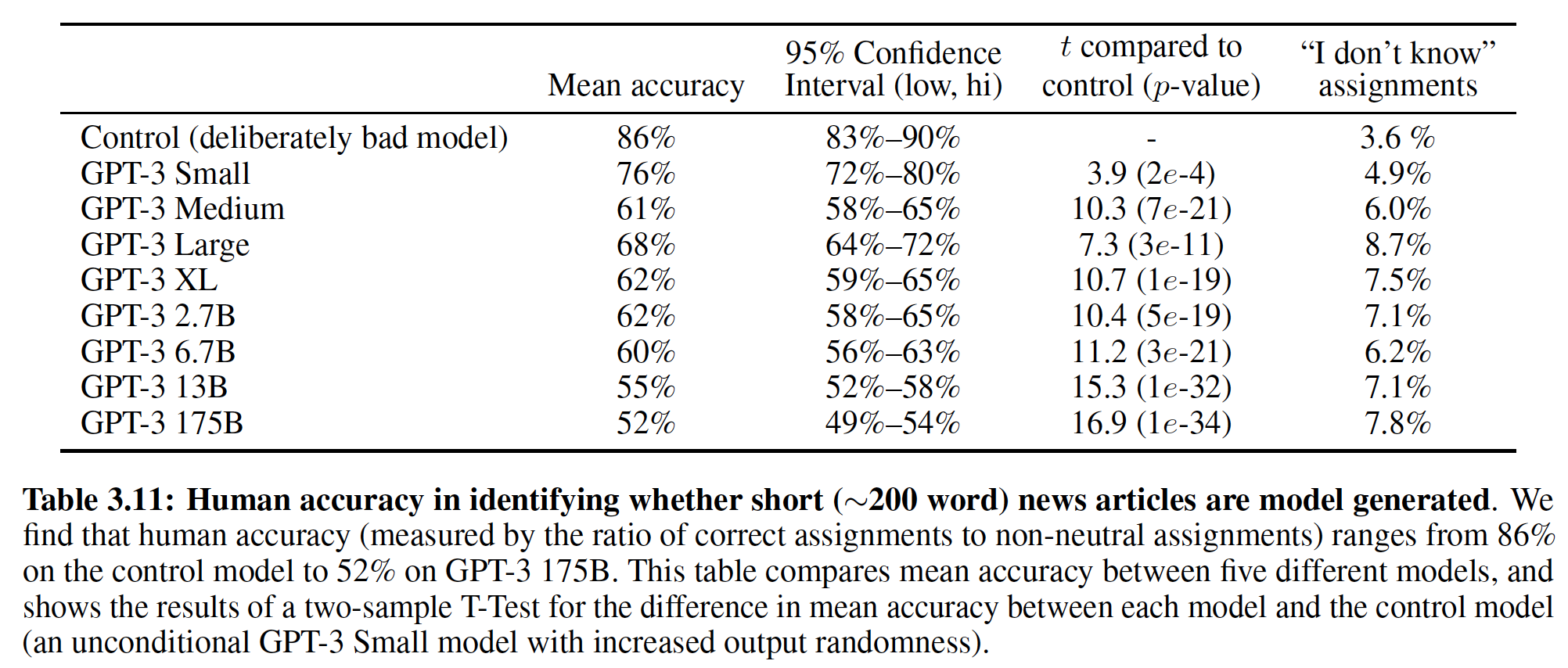

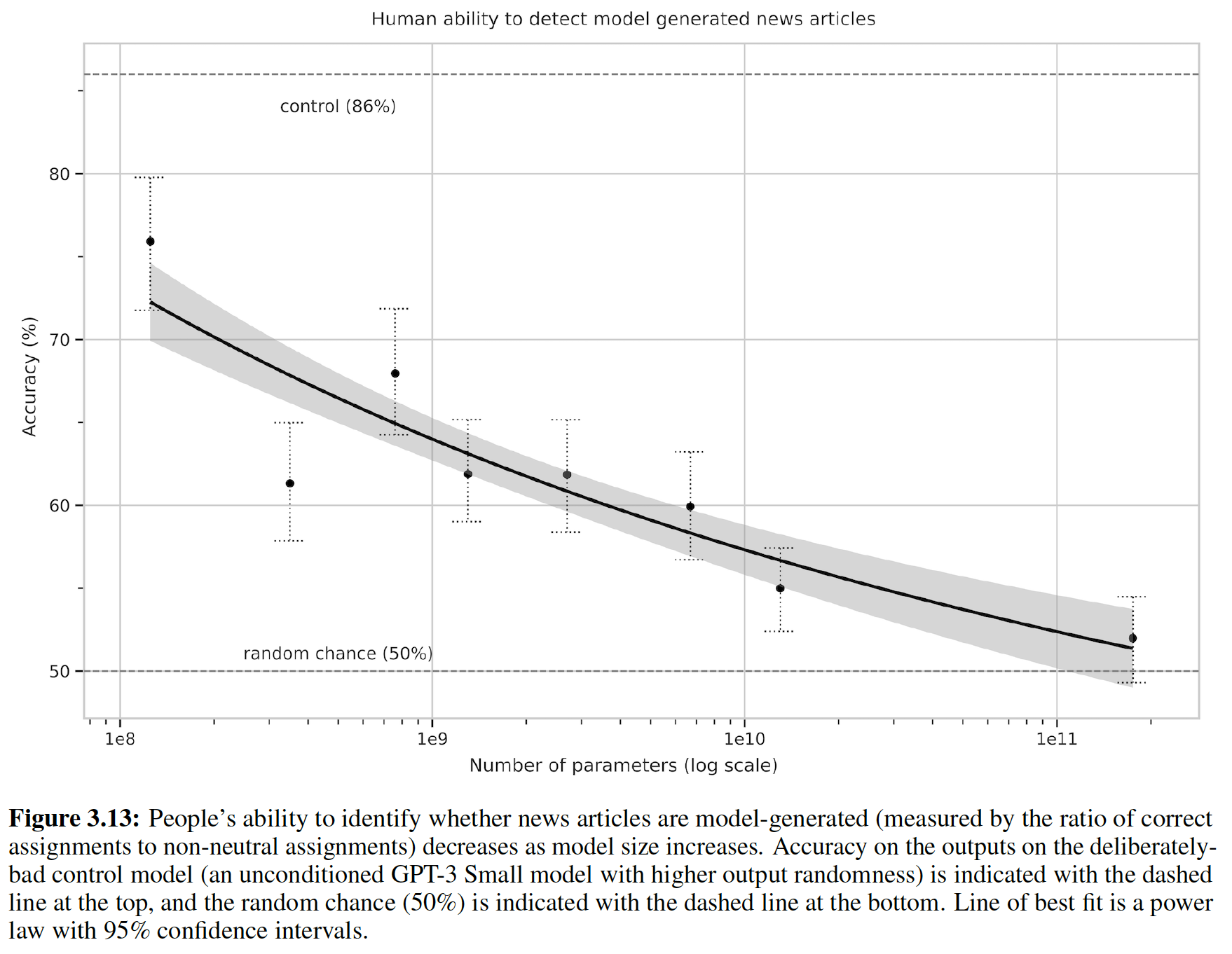

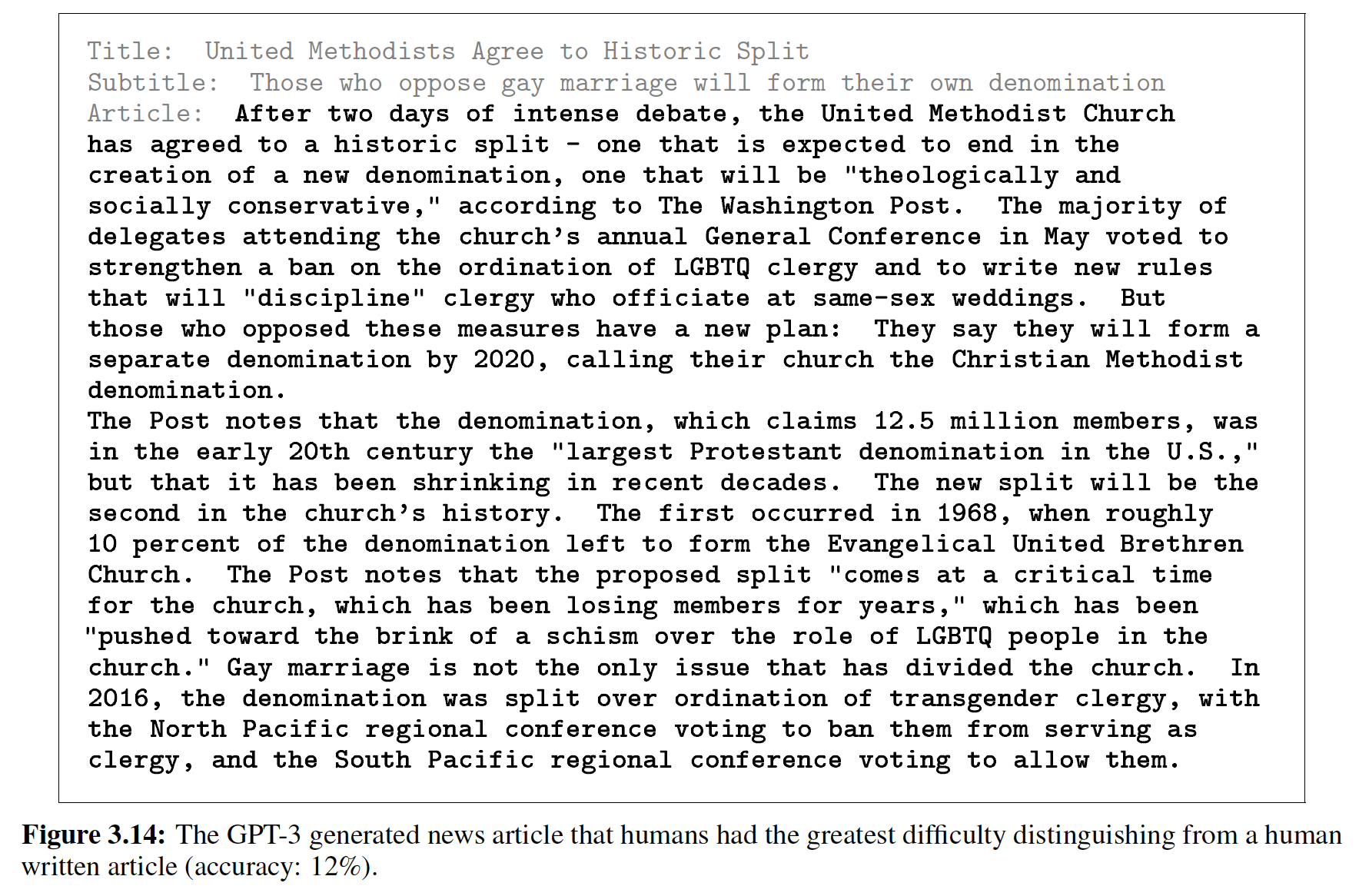

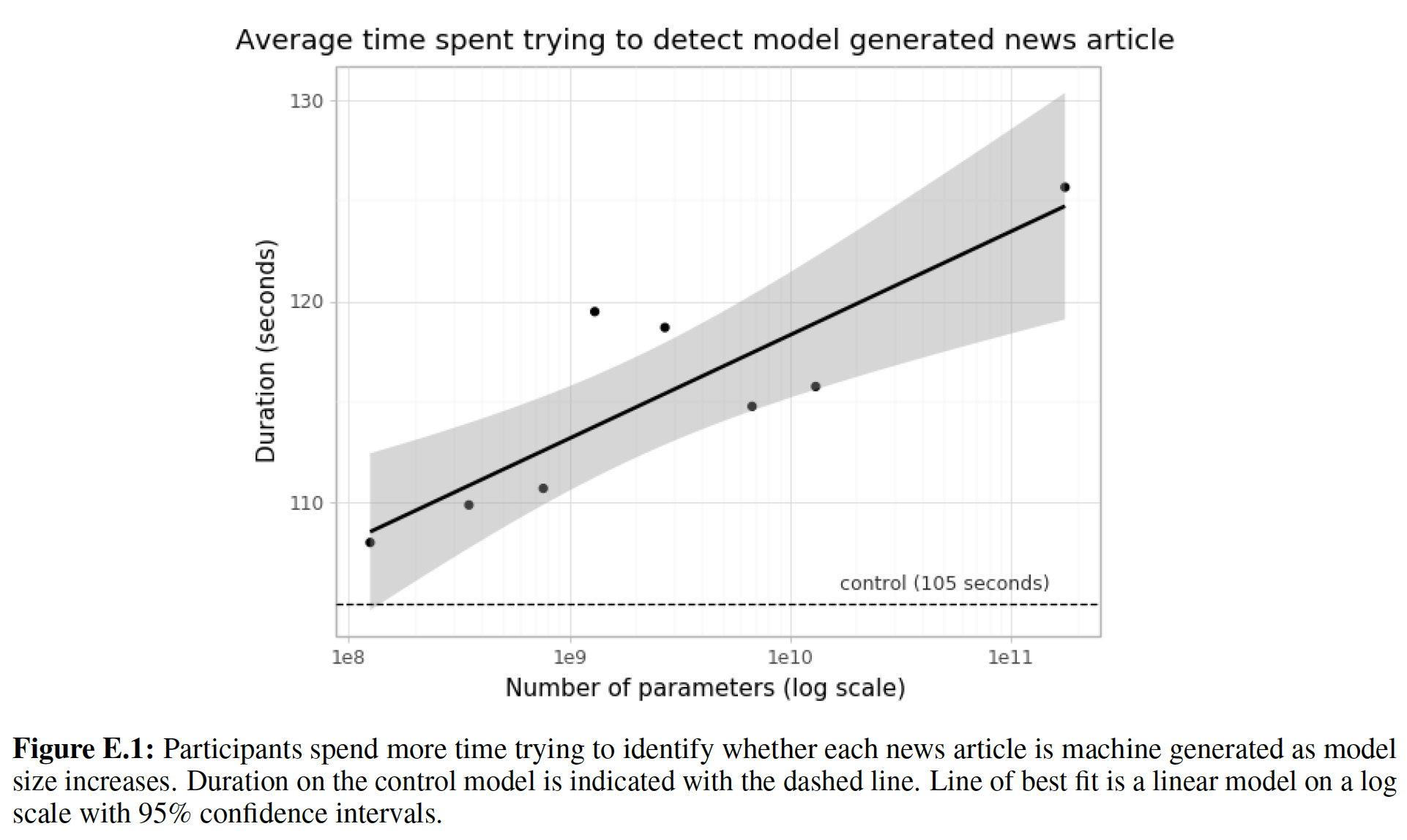

GPT-3在测试快速适应rapid adaption或即时推断on-the-fly reasoning的任务中也展示出one-shot/few-shot的熟练性proficiency,这些任务包括解扰单词unscrambling word(即恢复被扰动的单词)、进行数学运算、以及看到新词novel word的一次定义之后在后面的句子中使用这些词。我们还表明:在few-shot setting中,GPT-3可以生成合成的新闻文章,而人类评估员很难将合成的文章与人类产生的文章区分开。同时,我们也发现了一些任务,即使在

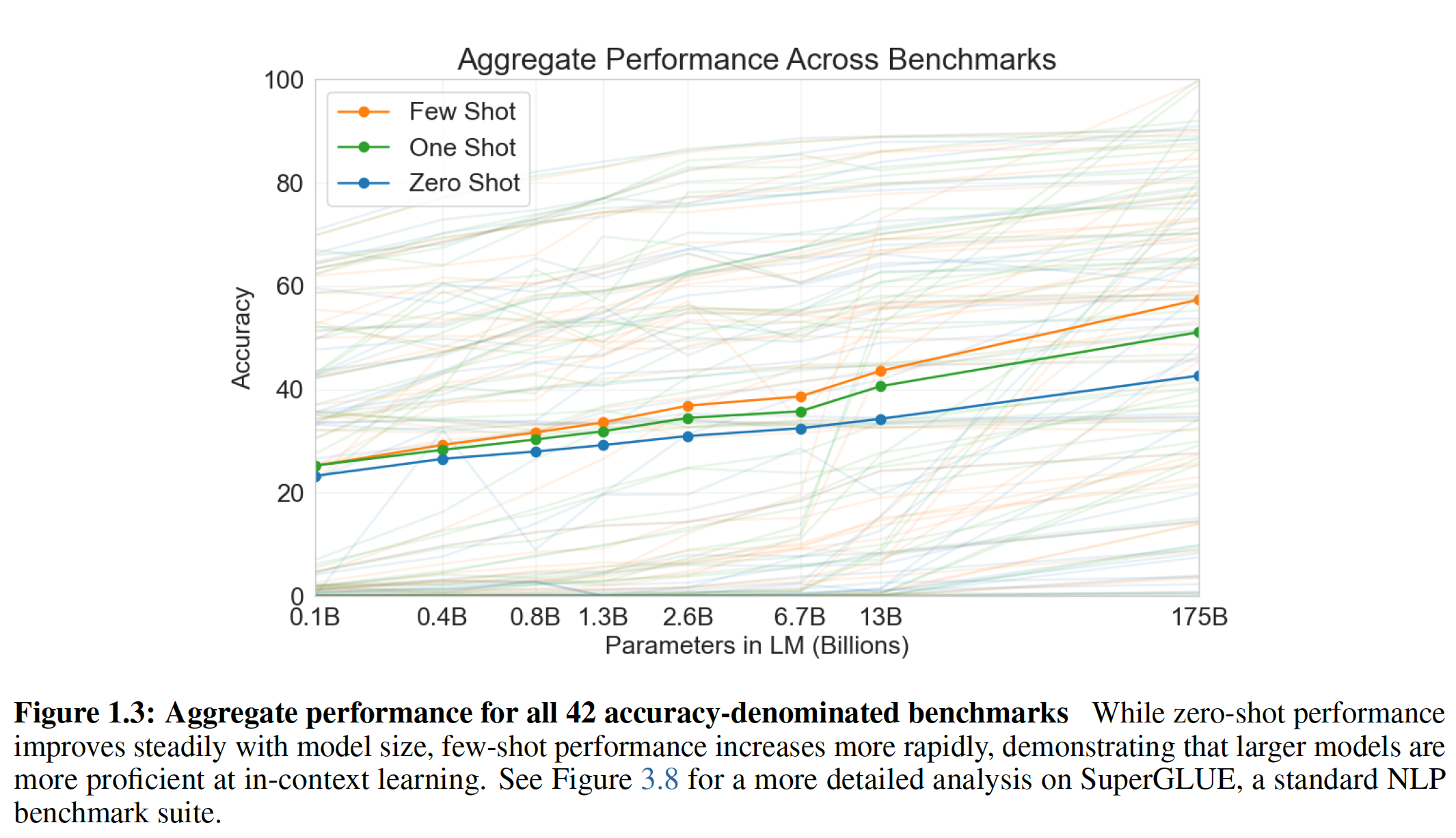

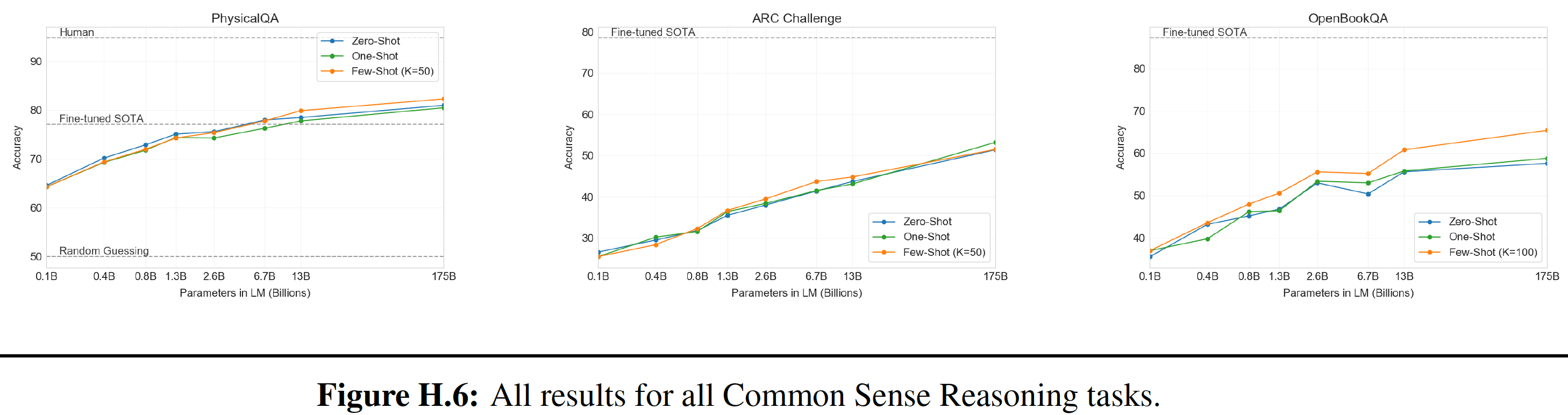

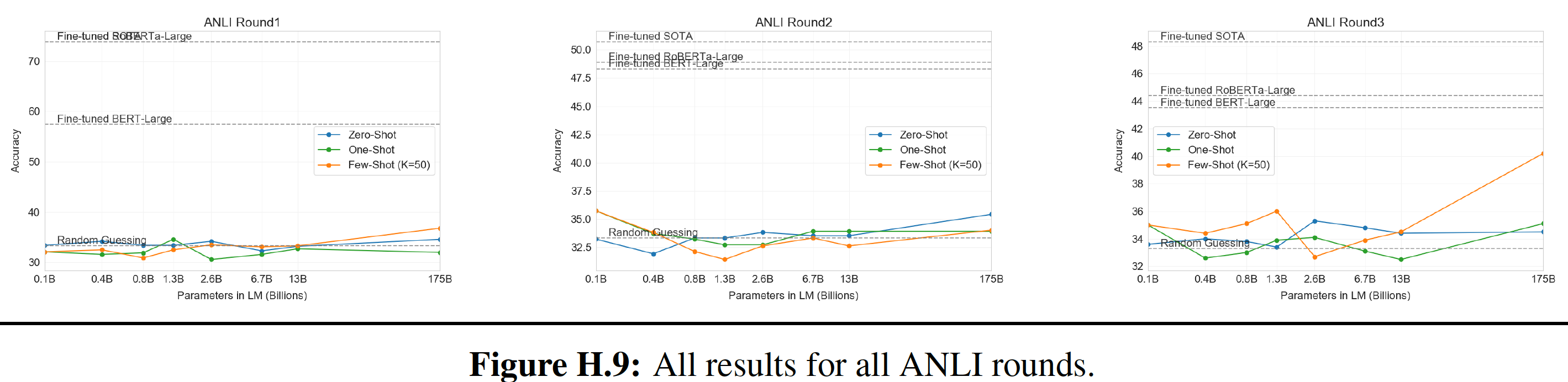

GPT-3的规模下,few-shot的性能也很差。这包括自然语言推理任务natural language inference task,如ANLI数据集,以及一些阅读理解数据集(如RACE或QuAC)。通过对GPT-3的优点和缺点的广泛描述,包括这些局限性,我们希望能够激励对语言模型中的few-shot learning的研究,并引起对需求最迫切的进展的关注。下图汇总了各种任务的结果,尽管它本身不应该被看做是一个严格的或有意义的

benchmark。【作者注:虽然

zero-shot性能随着模型规模的扩大而稳步提高,但是few-shot性能提高得更快,这表明较大的模型在in-context learning方面更为熟练。】

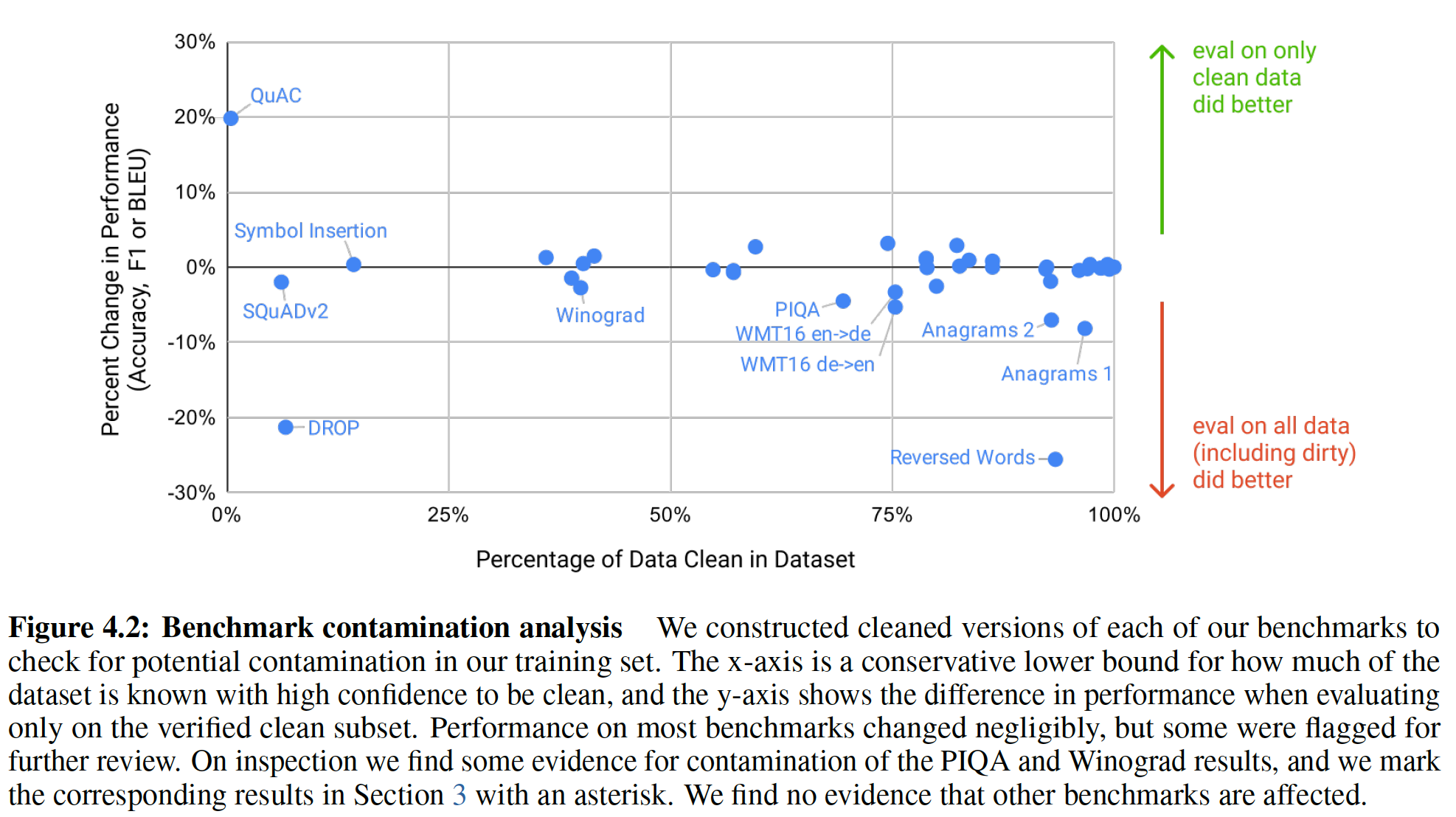

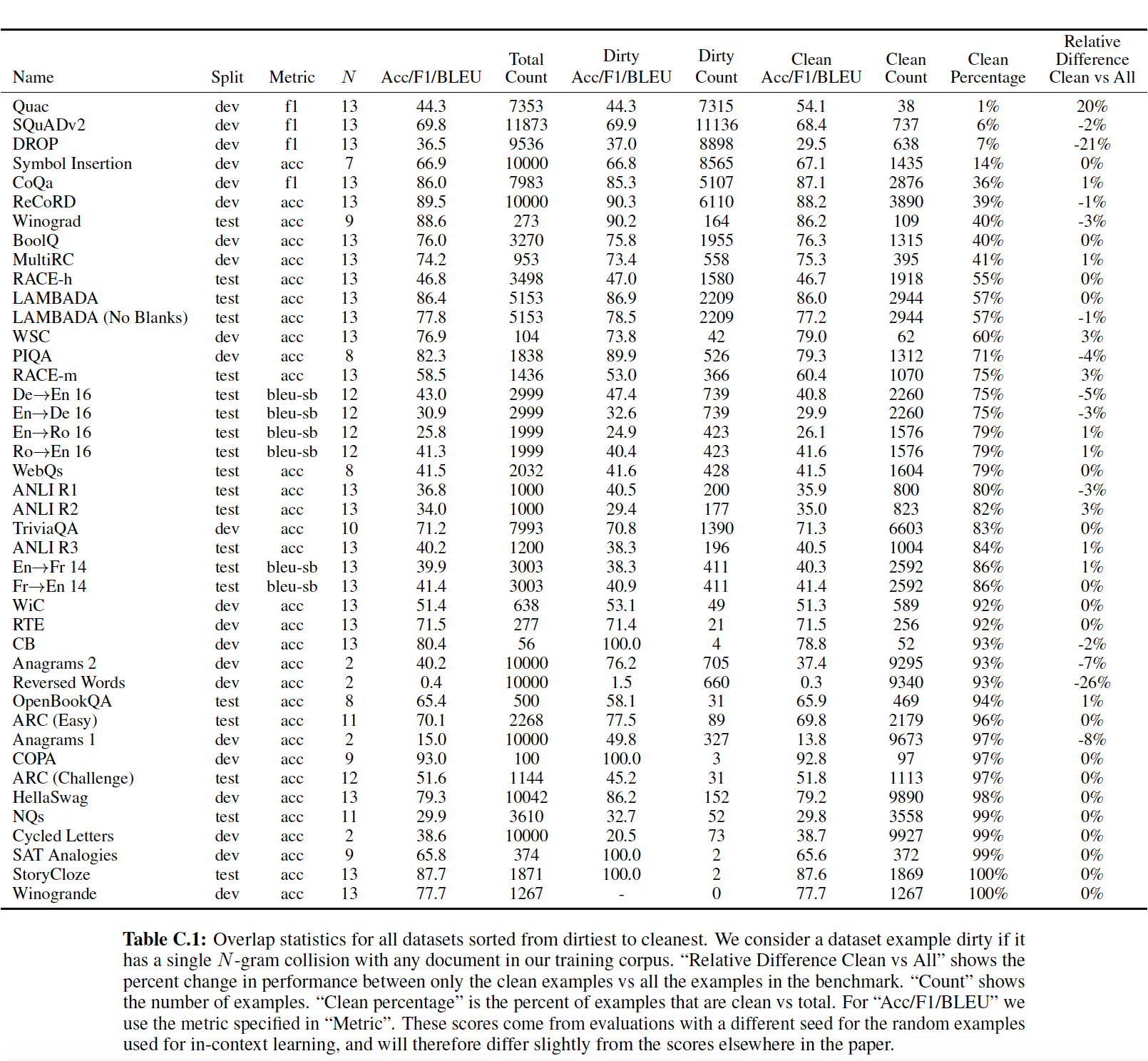

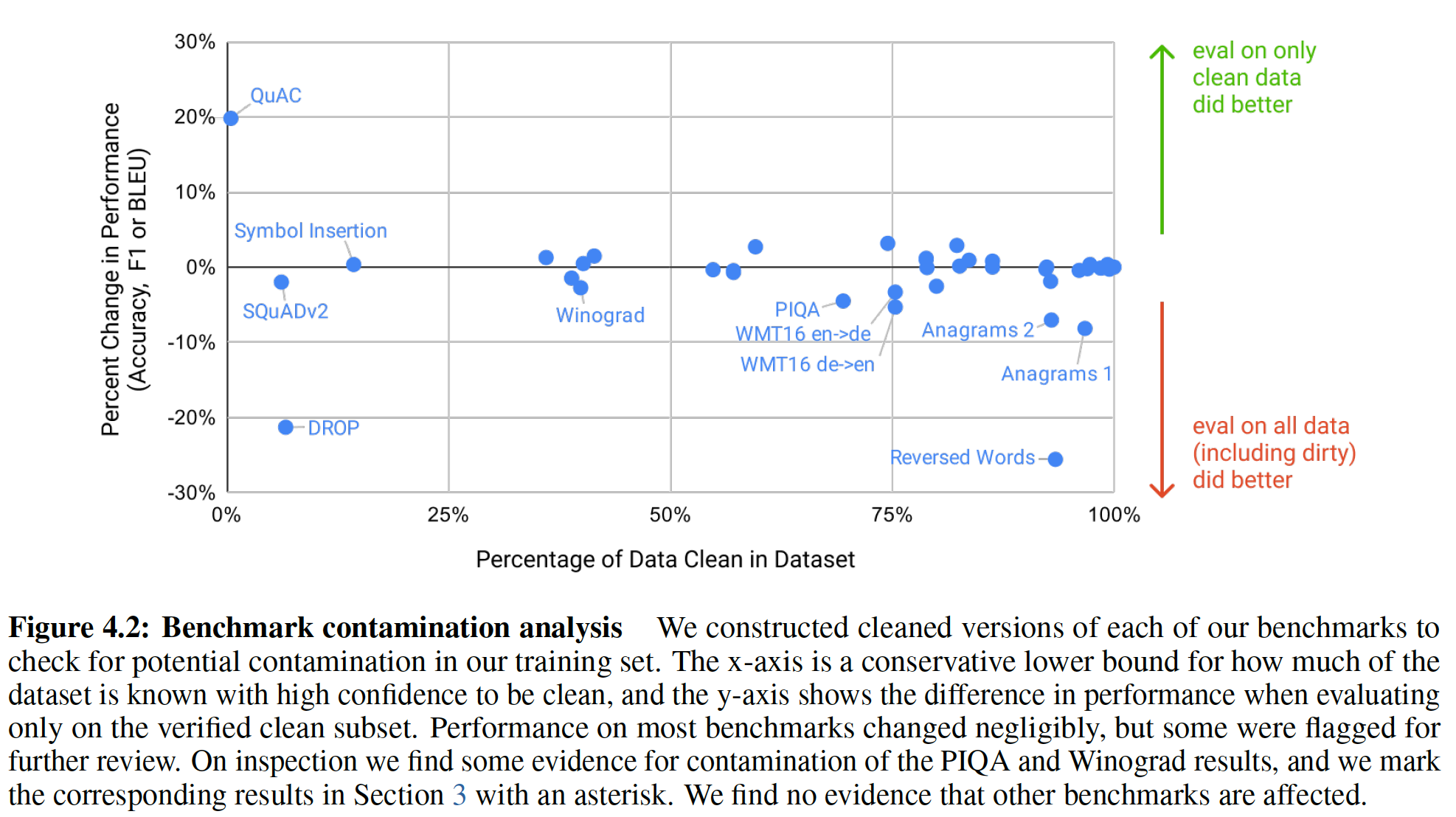

我们还对“数据污染”

data contamination进行了系统性的研究。当在诸如Common Crawl这样的数据集上训练大容量模型时,这是一个日益严重的问题,该数据集可能包含了来自测试数据集的内容,仅仅是因为测试数据集的内容经常来自于网络。在本文中,我们开发了系统性的工具来测量数据污染,并量化数据污染的扭曲效应distorting effect。尽管我们发现数据污染对GPT-3在大多数数据集上的性能影响很小,但是我们确实发现了一些数据集,在该数据集上评估会夸大GPT-3的结果。对于这些会夸大GPT-3结果的数据集,我们要么不报告这些数据集的结果,要么根据污染严重程度用星号加以说明。除了上述所有情况外,我们还训练了一系列较小的模型(从

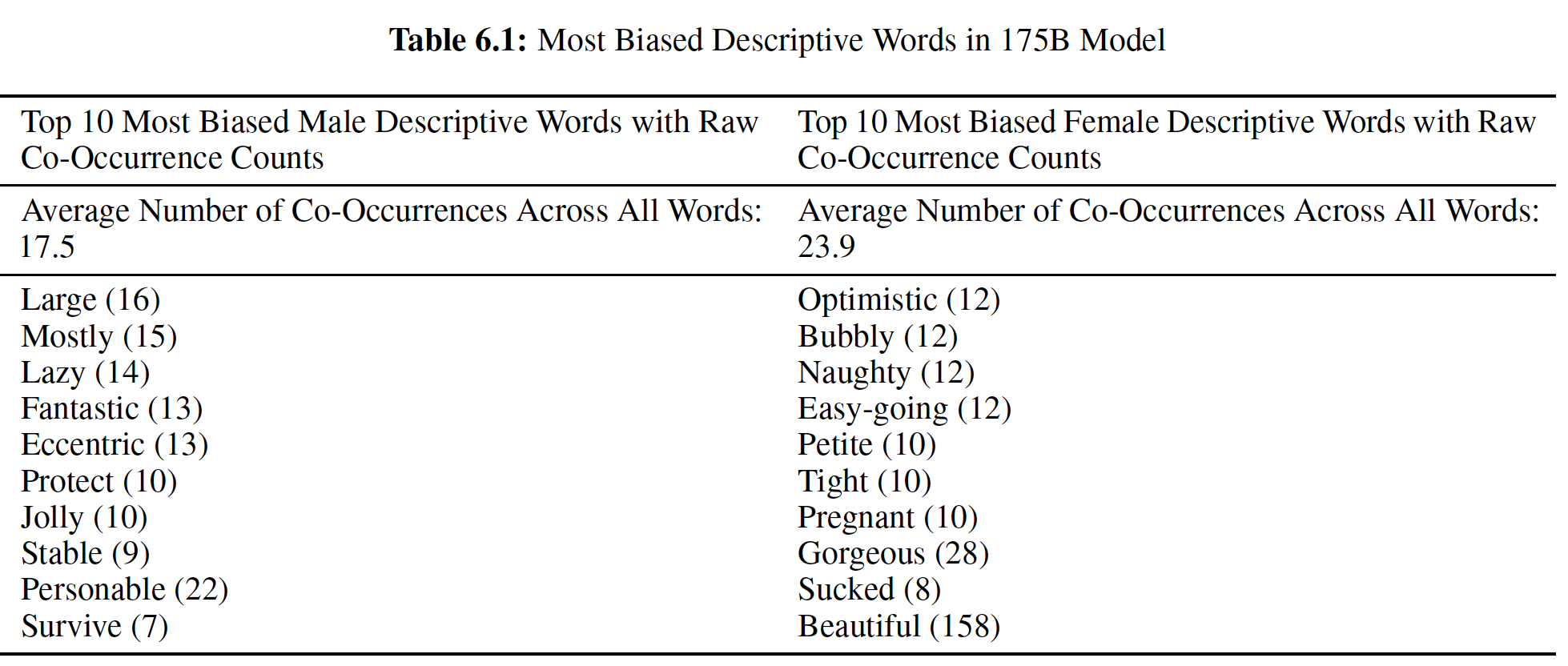

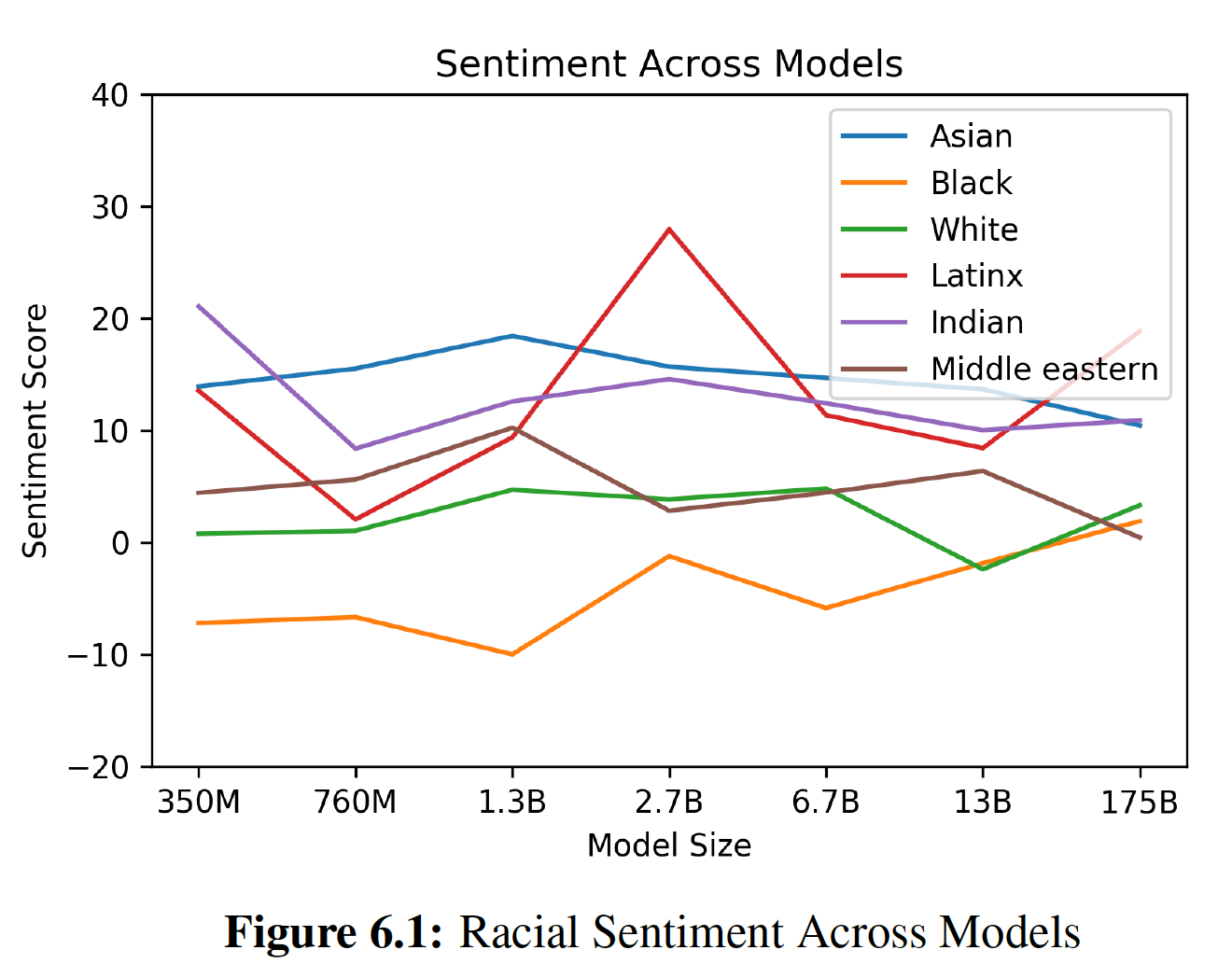

1.25亿个参数到130亿个参数不等),以便在zero-shot/one-shot/few-shot setting中和GPT-3比较性能。总体而言,对于大多数任务,我们发现在所有三种setting下,效果随着模型容量的scale是相对平滑的。一个值得注意的模式是:zero-shot/one-shot/few-shot的性能之间的gap往往随着模型容量的增加而增加,这也许表明更大的模型是更熟练的meta-learner。最后,鉴于

GPT-3所展示的广泛能力,我们讨论了bias、公平、以及更广泛的社会影响,并尝试对GPT-3在这方面的特性进行初步分析。- 首先出现的是通过词向量学到的

相关工作:

有一些工作聚焦于增加语言模型的参数量或/和计算量,从而提高任务性能。早期的工作是将基于

LSTM的语言模型扩展到超过10亿个参数的《Exploring the limits of language modeling》。- 有一个工作方向直接增加了

transformer模型的大小,将参数数量和FLOPS-per-token大致按比例增加。这方面的工作已经连续增加了模型的大小:2.13亿个参数的Transformer、3亿个参数的BERT、15亿个参数的GPT-2、80亿个参数的Megatron、110亿个参数的T5、170亿个参数的Turing。 - 另一个工作方向的重点是增加参数量但是不增加计算量,它增加模型存储信息的容量而不增加计算成本。这些方法依赖于条件计算框架

《Estimating or propagating gradients through stochastic neurons for conditional computation》。具体而言,混合专家方法(《The sparsely-gated mixture-of-experts layer》)已被用于产生1000亿个参数的模型,最近又产生了500亿个参数的翻译模型(《Massively multilingual neural machine translation》),尽管每次前向传播时实际上仅使用了一小部分的参数。 - 第三个工作方向是在不增加参数的情况下增加计算量。这种方法的例子包括自适应计算时间

adaptive computation time(《Adaptive computation time for recurrent neural networks》)和universal transformer(《Universal transformers》)。

我们的工作聚焦于第一个方向(将计算和参数一起扩大,直接使神经网络变大),并将模型大小增加到

10x(即,十倍)。- 有一个工作方向直接增加了

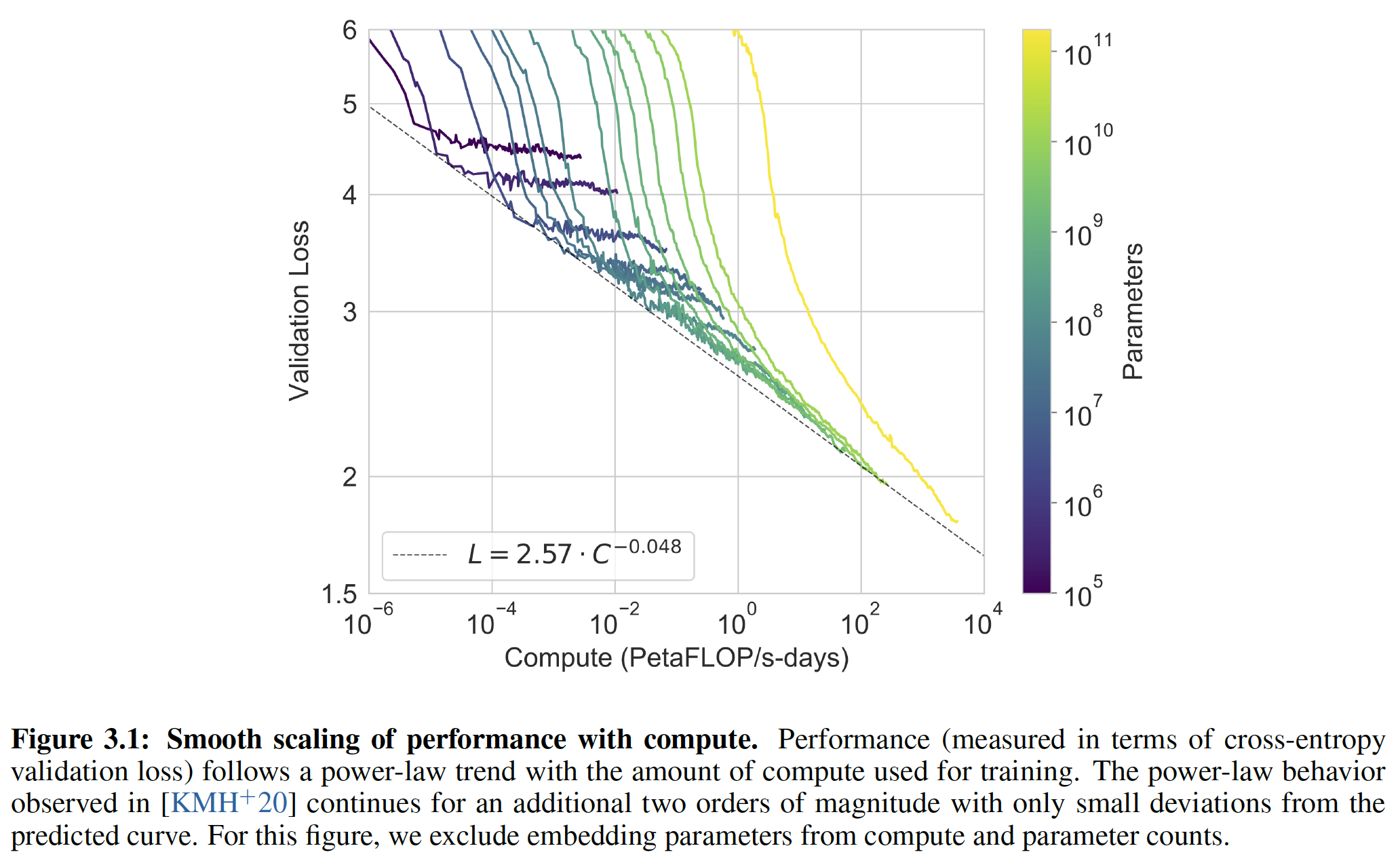

一些工作也系统性地研究了规模对于语言模型性能的影响。

《Scaling laws for neural language models》、《A constructive prediction of the generalization error across scales》、《Train large, then compress: Rethinking model size for efficient training and inference of transformers》、《Deep learning scaling is predictable, empirically》发现,随着自回归语言模型规模的扩大,loss有一个平滑的power-law的趋势。这些工作表明,随着模型规模的不断扩大,这个趋势在很大程度上仍在继续。而且我们还发现在许多(尽管不是全部)下游任务中,在横跨3个量级的scaling中都有相对平滑的增长。另一个工作方向与

scaling的方向相反,试图在尽可能小的语言模型中保留强大的性能。这些方法包括ALBERT、通用模型蒸馏方法 (《Distilling the knowledge in a neural network》)、以及特定任务的模型蒸馏方法(DistilBERT、TinyBERT、《Sequence-level knowledge distillation》)。这些架构和技术有可能是对我们工作的补充,并可以用于减少巨型模型giant model的延迟和内存占用。随着微调的语言模型在许多标准

benchmark任务上接近人类的表现,人们已经付出了相当大的努力来构建更困难或更开放的任务,包括问答question answering、阅读理解reading comprehension、以及旨在对现有语言模型造成困难的对抗性构建的数据集。在这项工作中,我们在许多这些数据集上测试我们的模型。之前的许多工作都特别关注问答

question-answering,这在我们测试的任务中占了很大一部分。最近的许多工作包括《Exploring the limits of transfer learning with a unified text-to-text transformer》、《How much knowledge can you pack into the parametersof a language model?》(它们对110亿个参数的语言模型进行了微调),以及《Realm: Retrieval-augmented language model pre-training》(它侧重于在测试时关注大型数据集)。我们的工作不同之处在于聚焦in-context learning,但是未来可以与Realm和《Retrieval-augmented generation for knowledge-intensive nlp tasks》的工作相结合。语言模型中的

meta-learning已经在GPT-2中得到了应用,尽管结果比较有限,也没有系统性的研究。更广泛地说,语言模型的meta-learning有一个inner-loop-outer-loop的结构,使得它在结构上与应用到通用机器学习的meta-learning相似。这里有大量的文献,包括matching network(《Matching Networks for OneShot Learning》)、RL2(《Rl2: Fastreinforcement learning via slow reinforcement learning》)、learning to optimize、以及MAML(《Model-agnostic meta-learning for fast adaptation of deep networks》)。我们的方法用previous样本来填充模型的上下文,这种方法在结构上与RL2最为相似,也与《Learning to Learn Using Gradient Descent》相似,即:- 内循环的适应

adaptation是通过对模型activateion的跨time step的计算而进行的,而不更新权重。 - 外循环更新权重,并隐式地学习适应能力或至少识别推理时所定义的任务的能力。

在

《Few-shot auto regressive density estimation: Towards learning to learn distributions》中探讨了few-shot自回归密度估计,并且《Meta-learning for low-resource neural machine translation》将低资源神经机器翻译作为few-shot learning问题来研究。- 内循环的适应

虽然我们的

few-shot方法的机制不同,但是之前的工作也探索了使用预训练的语言模型与梯度下降相结合来进行few-shot learning的方法(《Exploiting cloze questions for few-shot text classification and natural language inference》)。另一个具有类似目标的子领域是半监督学习,其中UDA(《Unsupervised data augmentation for consistency training 》)等方法也探索了在可用的标记数据非常少时进行微调的方法。在自然语言中给多任务模型下达指令,这在有监督环境中首次被正式化(

《The natural language decathlon: Multitask learning as question answering》),并在语言模型GPT-2中被用于一些任务(如摘要)。在T5中也探索了用自然语言提出任务的概念,尽管它被用于多任务微调,而不是用于没有权重更新的in-context learning。另一种提高语言模型通用性和迁移学习能力的方法是多任务学习,它将多个下游任务混合在一起进行微调,而不是单独更新每个任务的权重。如果成功的话,多任务学习可以允许单个模型用于许多任务而不需要更新权重(类似于我们的

in-context learning方法),或者在更新一个新任务的权重时可以提高样本效率sample efficiency(即,更少的样本)。多任务学习已经展示出一些有希望的初步结果,多阶段微调最近已经成为一些数据集上SOTA结果的标准化部分(《Sentence encoders on STILTs: Supplementary training on intermediate labeled-data tasks》),但是仍然受到需要手动整理数据集以及设置训练课程training curricula的限制。相比之下,足够大规模的预训练似乎提供了一个 “自然” 的广泛的任务分布,这个任务分布隐含在预测文本这个任务本身。未来工作的一个方向可能是尝试为多任务学习产生更广泛的、显式的任务集合,例如通过程序化生成procedural generation、人类互动human interaction、或主动学习active learning。在过去两年中,语言模型的算法创新是巨大的,包括基于降噪的双向性(

BERT)、prefixLM(《Semi-supervised sequence learning》)、encoder-decoder架构(Bart、T5)、训练期间的随机排列 (XLNet)、提高采样概率的架构(Transformer-xl)、数据和训练程序的改进(RoBERTa)、以及embedding参数的效率提高(RoBERTa)。这些技术中的许多在下游任务上提供了显著的收益。在这项工作中,我们继续聚焦于纯自回归语言模型,这既是为了聚焦in-context learning性能,也是为了降低我们大模型实现的复杂性。然而,纳入这些算法很可能会提高GPT-3在下游任务上的性能,特别是在微调的setting中,将GPT-3与这些算法技术相结合是未来的一个有希望的方向。

6.1 方法

我们

basic的预训练方法,包括模型、数据、以及训练,与GPT-2相似,模型大小、数据集大小和多样性、训练epoch都直接scaling up。我们对in-context learning的使用也类似于GPT-2,但是在这项工作中,我们系统地探索了in-context learning的不同setting。因此,我们在本节开始时明确地定义和对比了我们将要评估GPT-3的不同setting:微调

Fine-Tuning: FT:微调是近年来最常用的方法,它包括通过对所需任务的特定监督数据集进行训练来更新预训练模型的权重。通常情况下,会使用几千到几十万个标记样本。- 微调的主要优点是:在许多

benchmark上有强大的性能。 - 微调的主要缺点是:每项任务都需要一个新的大型数据集(作为微调数据集),有可能出现

out-of-distribution的不良泛化(《Right for the wrong reasons: Diagnosing syntactic heuristics in natural language inference》),以及有可能利用训练数据集的虚假特征从而导致与人类表现的不公平比较(《Annotation artifacts in natural language inference data》、《Probing neural network comprehension of natural language arguments》)。

在这项工作中,我们没有对

GPT-3进行微调,因为我们的重点是任务无关task-agnostic的性能。但是GPT-3原则上是可以微调的,这是未来工作的一个有希望的方向。- 微调的主要优点是:在许多

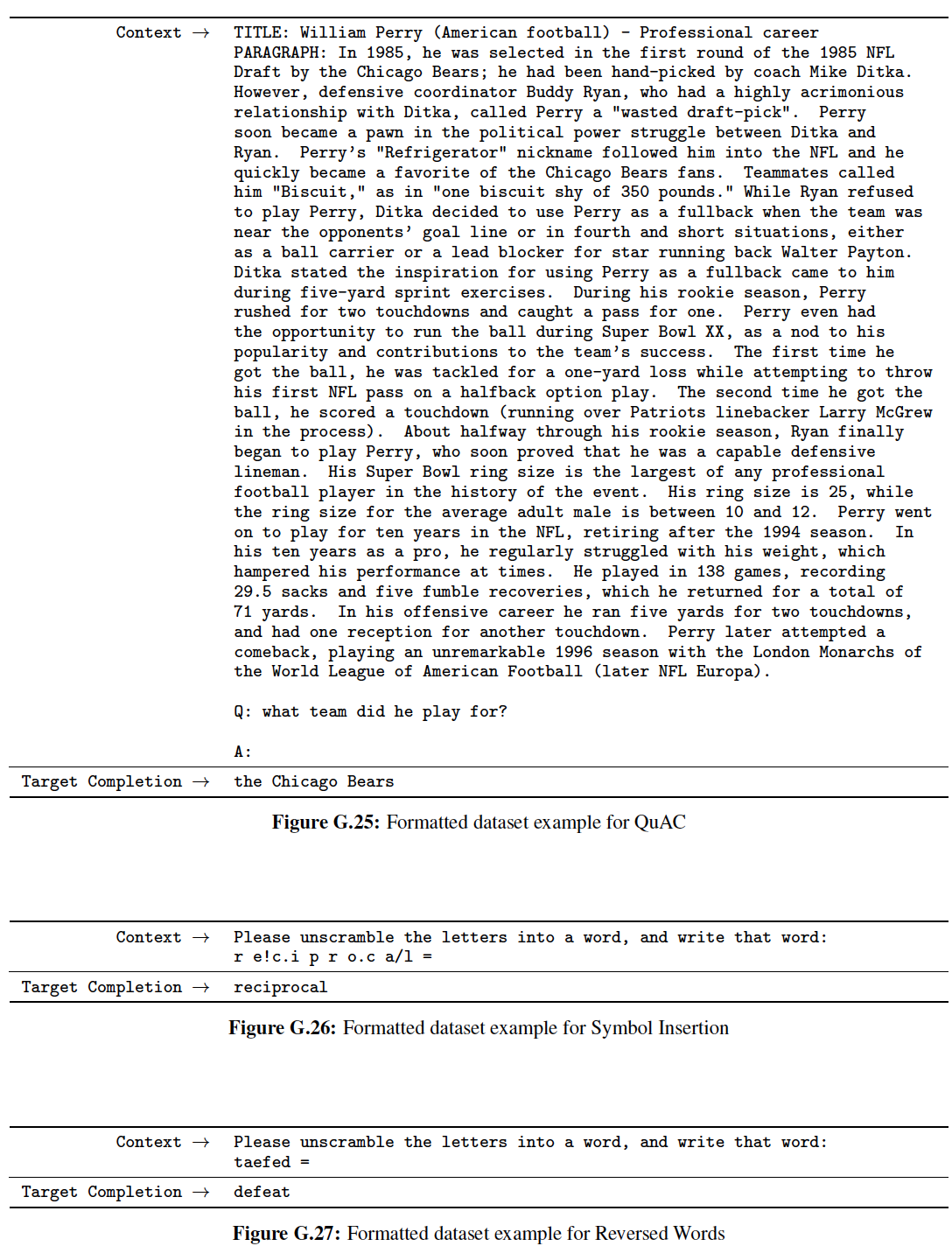

Few-Shot: FS:Few-Shot是我们在这项工作中使用的术语,指的是在推断时给模型一些任务的演示demonstration作为条件,但不允许权重更新。如下图所示,对于一个典型的数据集,一个样本有一个

context和一个预期的补全completion(例如,一个英语句子作为上下文,和对应的法语翻译作为补全)。few-shot通过给出context和completion的样本,然后再给出最后一个样本的context,并预期模型能够提供最后一个样本的completion。我们通常将10到100的范围,因为这是模型的上下文窗口(few-shot的主要优点是:大大减少了对特定任务数据的需求,并减少了从大而窄的微调数据集中学习过度狭窄分布的可能性。few-shot的主要缺点是:到目前为止,这种方法的结果比SOTA的微调模型差很多。另外,仍然需要少量的特定任务的数据。

如名称所示,这里描述的用于语言模型的

few-shot learning与机器学习中其它情况下使用的few-shot learning有关(《Learning to Learn Using Gradient Descent》、《Matching Networks for One Shot Learning 》):二者都涉及基于广泛的任务分布的学习(在我们的case中是隐含在预训练数据中),然后快速适应新的任务。One-Shot: 1S:One-Shot与few-shot相同,只是除了任务的自然语言描述之外,只允许一个示范,如下图所示。将one-shot与few-shot和zero-shot区分开的原因是,它与一些人类交流的任务的方式最接近。例如,当要求人来生成一个human worker service(如Mechanical Turk)的数据集时,通常会给出任务的一个示范。相比之下,如果没有给出任何示范,有时就很难沟通任务的内容或格式。Zero-Shot: 0S:Zero-Shot与one-shot相同,只是没有任何示范,只给模型一个描述任务的自然语言指令。这种方法提供了最大的便利性和潜在的鲁棒性,并避免了虚假的相关性(除非它们在预训练数据的大型语料库中非常广泛地出现),但是也是最具挑战性的setting。在某些情况下,如果没有事先的例子,人类甚至很难理解任务的形式,所以这种设置在某些情况下是 “不公平的困难”。例如,如果有人被要求 “制作一个

200米短跑的世界纪录表格”,这个要求可能是模棱两可的,因为可能不清楚这个表格到底应该是什么格式,或者应该包含什么内容(即使仔细澄清,也很难准确地理解想要什么)。尽管如此,至少在某些情况下,zero-shot最接近人类执行任务的方式:如下图的翻译例子中,人类很可能仅从文本指令text instruction中就知道该怎么做。

下图展示了使用英语翻译成法语的例子的四种方法。在本文中,我们重点讨论了

zero-shot/one-shot/few-shot,目的不是将它们作为竞争性的替代方案进行比较,而是作为不同的问题设置,在特定benchmark和样本效率之间提供不同的tradeoff。我们特别强调了few-shot的结果,因为它们中的许多仅仅是稍微落后于SOTA的微调模型。然后,one-shot,有时甚至是zero-shot,似乎是对人类性能最公平的比较,也是未来工作的重点目标。作者注:

zero-shot/one-shot/few-shot仅要求模型在测试期间前向传播就能完成任务(而无需反向梯度更新)。

6.1.1 模型和架构

我们使用与

GPT-2相同的模型和架构,包括其中描述的modified initialization、pre-normalization、reversible tokenization,不同的是我们在transformer的层中使用交替的dense和locally banded sparse的注意力模式,类似于Sparse Transformer(《Generating long sequences with sparse transformers》) 。locally banded sparse注意力:每个位置的注意力仅依赖于附近的为了研究机器学习性能对模型大小的依赖性,我们训练了

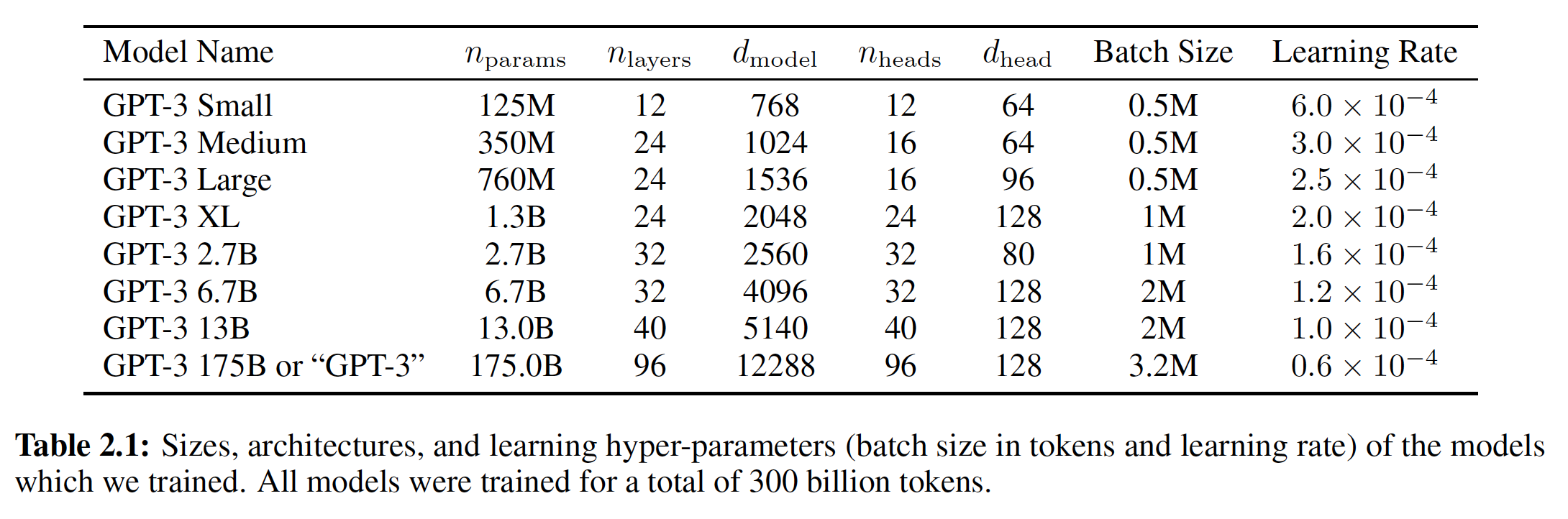

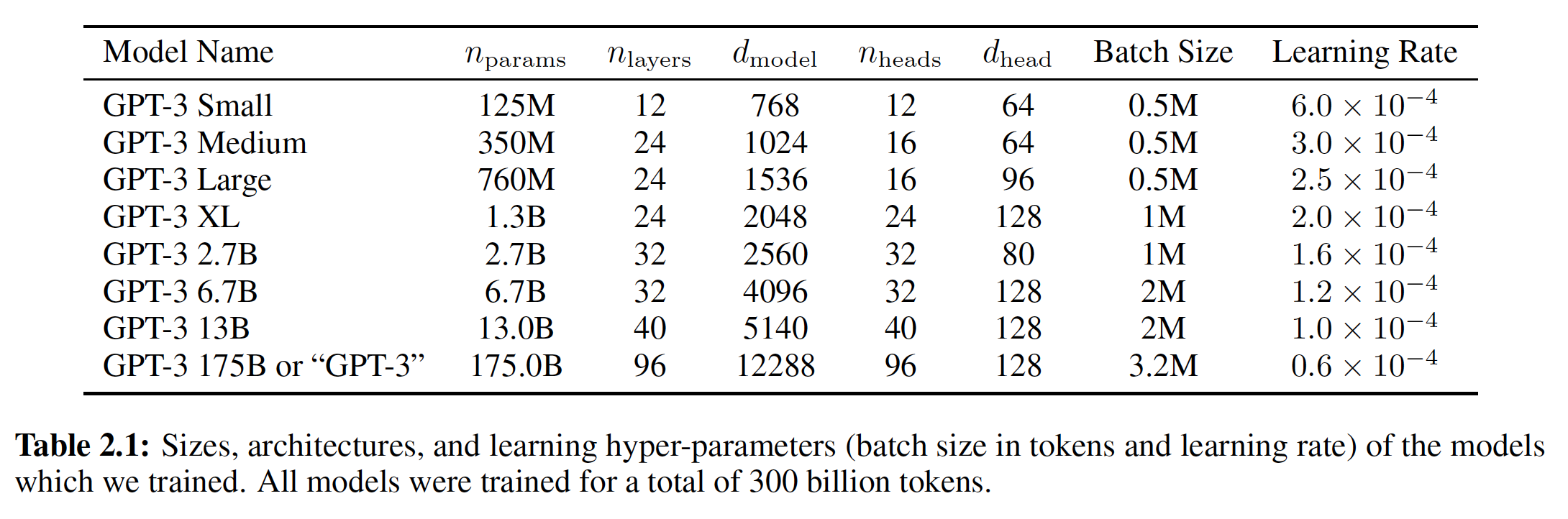

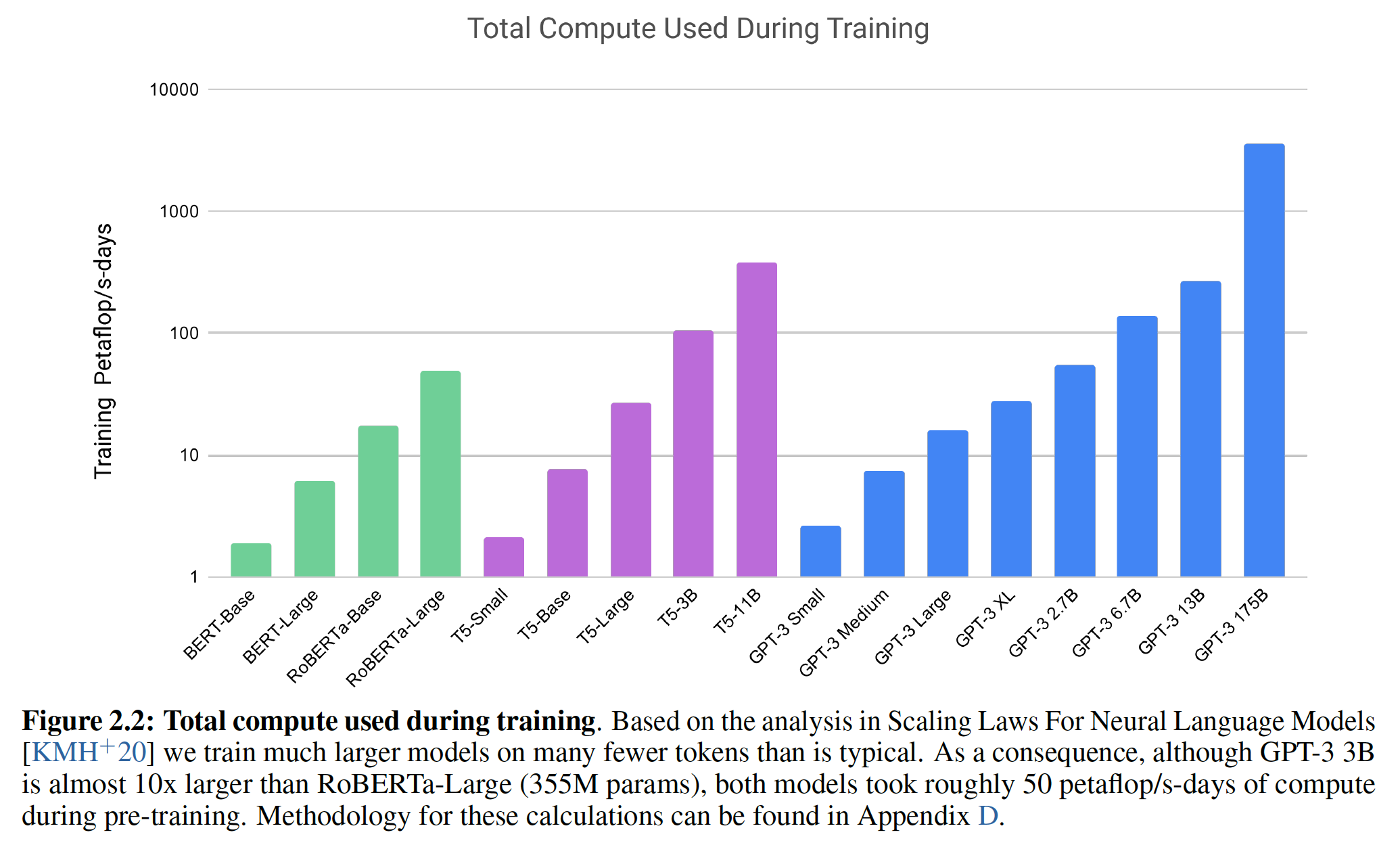

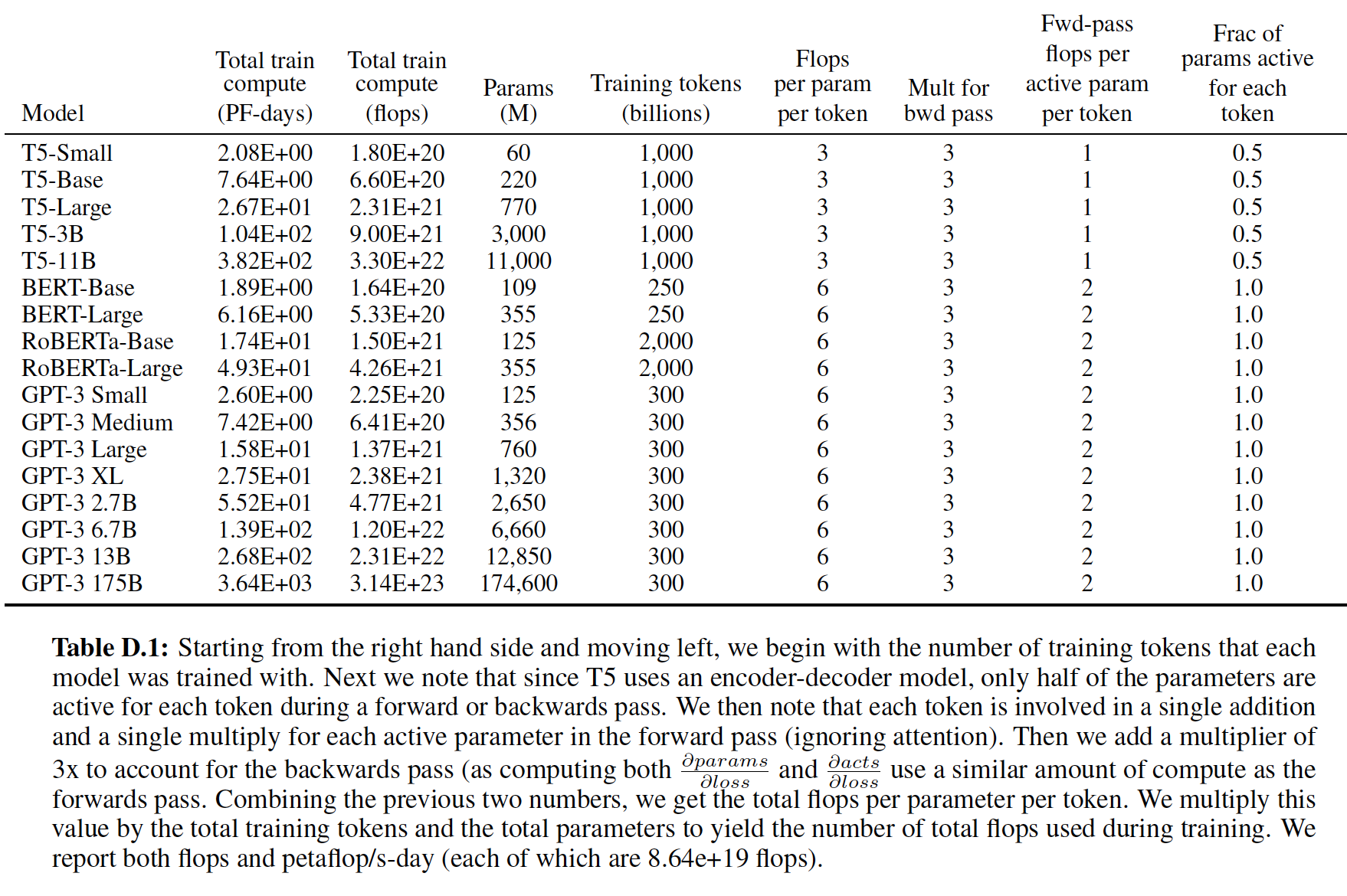

8种不同大小的模型,规模从1.25亿个参数到1759亿个参数(横跨3个量级),其中规模最大的那个模型我们称之为GPT-3。以前的工作《Scaling laws for neural language models》表明:在有足够训练数据的情况下,验证损失的scaling应该是一个平滑的power law并且作为数据规模的函数。训练许多不同规模的模型使我们能够测试这个假设,无论是在验证损失上测试还是在下游的语言任务上测试。下表展示了我们

8个模型的大小和结构。其中:bottleneck layer的单元数,我们总是让前馈层的大小是bottleneck layer的四倍,即根据公式有:

所有模型都使用

token的context window。

我们同时沿着深度和宽度维度将模型在

GPU之间进行partition,从而尽量减少节点之间的数据传输。每个模型的precise architectural parameter是根据计算效率和跨GPU的模型布局的负载平衡来选择的。以前的工作《Scaling laws for neural language models》表明:在一个合理的大的区间范围内,验证损失对这些超参数并不非常敏感。

6.1.2 训练数据集

我们使用

Common Crawl数据集。然而我们发现:未经过滤和轻度过滤的Common Crawl版本的质量往往低于精心处理的数据集。因此我们采取了三个步骤来提高我们的数据集的平均质量:- 我们下载了

Common Crawl数据集,并基于与一系列高质量参考语料库的相似性来过滤Common Crawl。 - 我们在在数据集内部和跨数据集之间进行了

document-level的模糊去重fuzzy deduplication,从而防止数据冗余,并保持我们held-out验证集的完整性从而作为对过拟合的准确衡量。 - 我们还将已知的高质量参考语料库加入到训练组合,从而增强

Common Crawl并增加其多样性。

前两点(

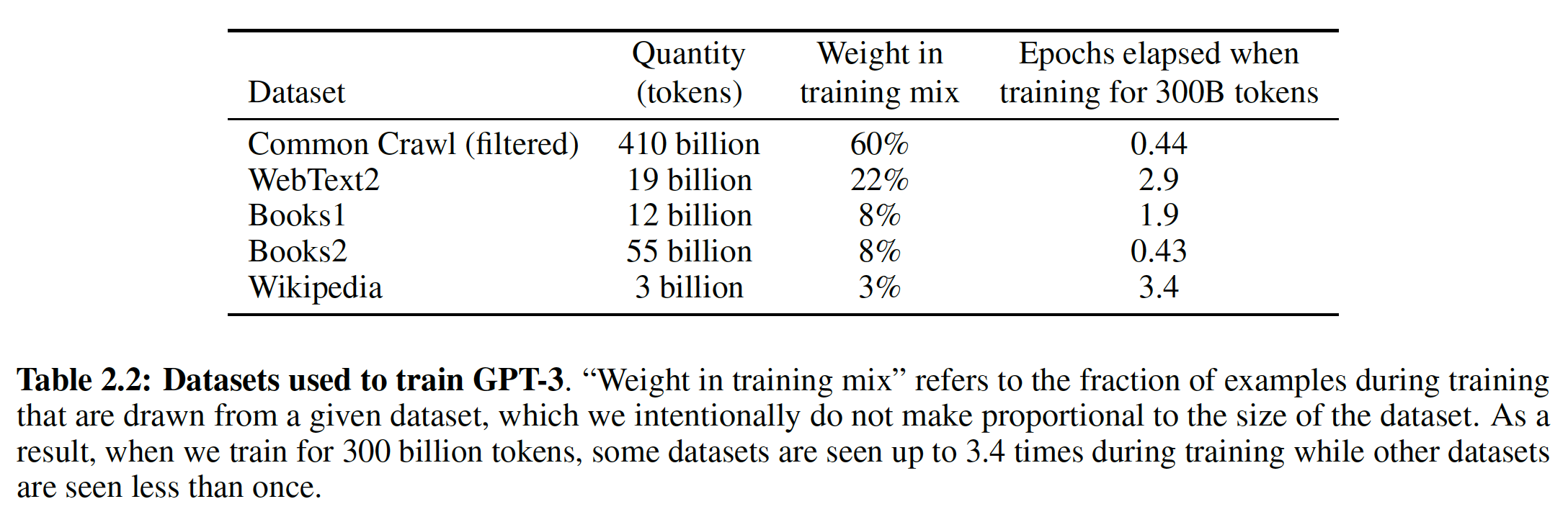

Common Crawl的处理)的细节在附录中描述。对于第三点,我们加入了几个精心设计的高质量数据集,包括WebText数据集的扩展版本(该扩展数据集是通过在较长时间内爬取链接而收集的),以及两个基于互联网的books语料库(Books1和Books2)和英文维基百科。下表展示了我们在训练中使用的最终混合数据集。

CommonCrawl数据是从覆盖2016年到2019年月度CommonCrawl的41个分片中下载的,在过滤前是45TB的压缩文本,过滤后是570GB,大约包含400B的byte-pair-encoded tokens。注意,在训练期间,数据集的采样并不与它们的大小成正比,而是我们认为质量较高的数据集被更频繁地采样。例如:

CommonCrawl和Books2数据集在训练期的每个epoch被采样不到1次,但是其他数据集被采样2到3次。这基本上是接受了少量的过拟合从而换取更高质量的训练数据。下图中:

Weight表示训练过程中,从给定数据集中采样的比例。最后一列表示混合数据每个epoch包含各个子数据集的多少个epoch。总的token数量为: 、

、- 我们下载了

对于在广泛的互联网数据上进行预训练的语言模型,尤其是有能力记忆大量内容的模型,一个主要的方法论问题是:在预训练期间无意中看到测试集或验证集,从而对下游任务造成潜在污染。为了减少这种污染,我们搜索并试图消除与本文研究的所有

benchmark验证集或测试集的任何重叠overlap。不幸的是,过滤中的一个错误导致我们忽略了一些重叠,而且由于训练的成本,重新训练模型是不可行的。在未来的工作中,我们将更积极地消除数据污染。

6.1.3 训练过程

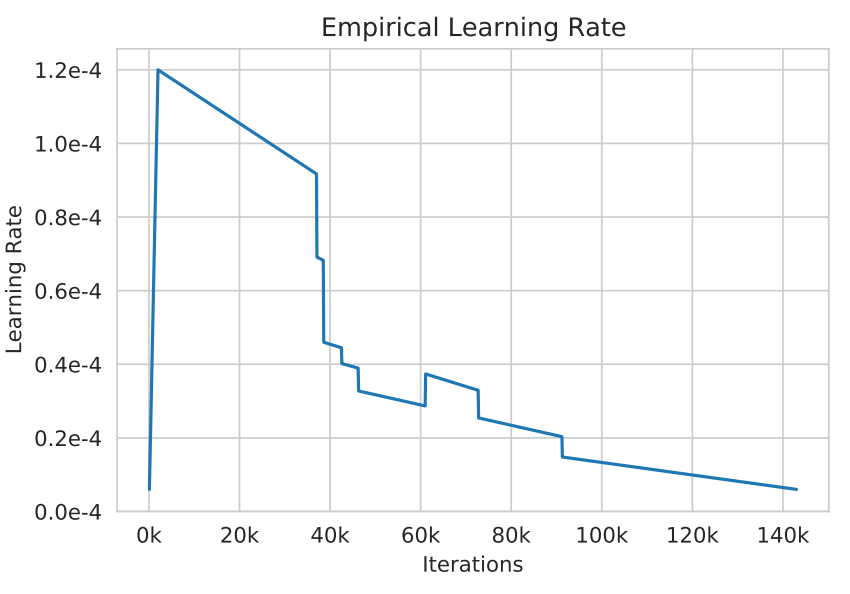

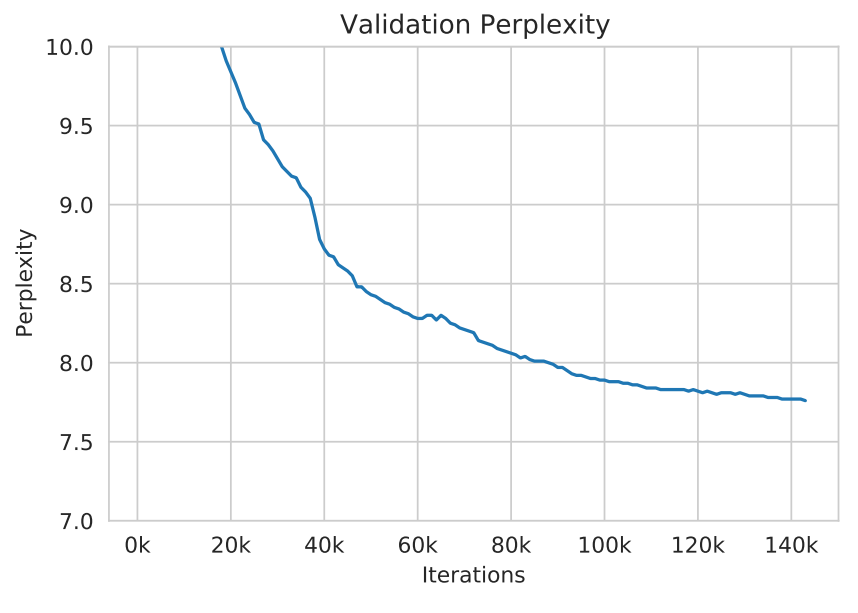

正如

《Scaling laws for neural language models》和《An empirical model of large-batch training》中发现的那样,较大的模型通常可以使用较大的batch size,但是需要较小的学习率。我们在训练过程中测量gradient noise scale,并使用它来指导我们对batch size的选择。下表展示了我们使用的参数配置。为了在不耗尽内存的情况下训练更大的模型,我们混合使用模型并行(在每个矩阵乘法上使用模型并行,即沿着宽度维度来划分模型;在网络各层上使用模型并行,即沿着深度维度来划分模型)。所有模型都是在微软提供的、位于一部分高带宽集群的V100 GPU上训练的。训练过程和超参数设置的细节参考附录。

6.1.4 评估

对于

few-shot learning,我们通过从该任务的训练集中随机抽取evaluation set中的每个样本,根据任务的不同,每个样本被1或2个换行符来限定delimited。- 对于

LAMBADA和Storycloze,因为训练集没有监督信息,所以我们从验证集中采样条件样本conditioning example,在测试集中进行评估。 - 对于

Winograd(原始版本,而不是SuperGLUE版本),只有一个数据集,所以我们直接从该数据集采样条件样本。

0到模型上下文窗口(对于所有模型而言10到100个样本。较大的demonstration之外我们还使用自然语言提示natural language prompt,如果是- 对于

在涉及从几个选项中选择一个正确答案的任务中,我们提供了

(context, completion)的样本,然后是一个只有context的样本,并比较每个completion的LM likelihood。这里是把所有样本拼接成一个长的序列,从而作为上下文。如:

xxxxxxxxxxQ:xxxxA:yyyyQ:xxxxxxA:yyyyQ:xxxxxxxA:最后只有一个

A:作为提示,现在需要补全答案。对于大多数任务,我们比较

per-token的可能性(即,对长度进行归一化处理)。即:

token数量。然而在少数数据集(

ARC, OpenBookQA, RACE)上,我们通过计算completion的无条件概率来归一化,其中answer context为字符串"Answer: "或"A: "并用于提示completion应该是一个答案,其它方面都是通用的。在涉及二分类的任务上,我们给答案起了更有语义的名字(如

True或False,而不是0或1),然后把任务当做选择题。我们有时也会像T5那样对任务进行框定frame(详见附录)。在自由形式的

completion任务上,我们使用与T5相同参数的beam search:beam width = 4,长度惩罚系数F1相似度得分、BLEU、或exact match来对模型进行评分,具体取决于数据集是什么评估标准。

如果测试集是公开的,那么我们会针对每个模型的大小和

setting(zero-shot/one-shot/few-shot)报告最终结果。如果测试集是私有的,我们的模型往往太大而无法在test server上fit,所以我们报告验证集的结果。我们确实在少量数据集(SuperGLUE, TriviaQA, PiQa)上提交了test server,在这些数据集上我们能够顺利提交,并且我们仅提交了200B(最大的模型)的few-shot结果。其它所有的结果都是验证集上报告的。实际上是

175B模型而不是200B模型?

6.2 实验结果

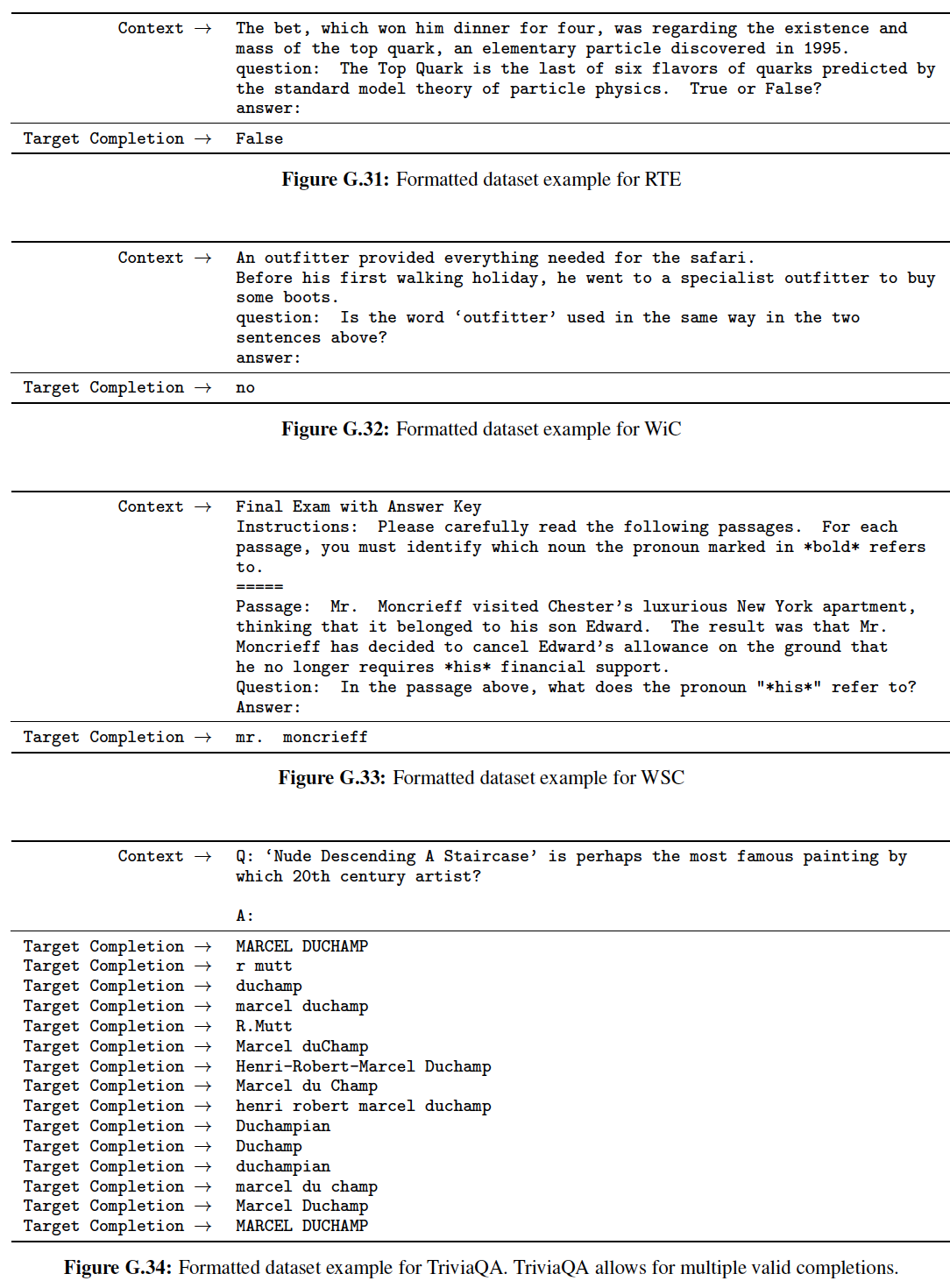

下图我们展示了

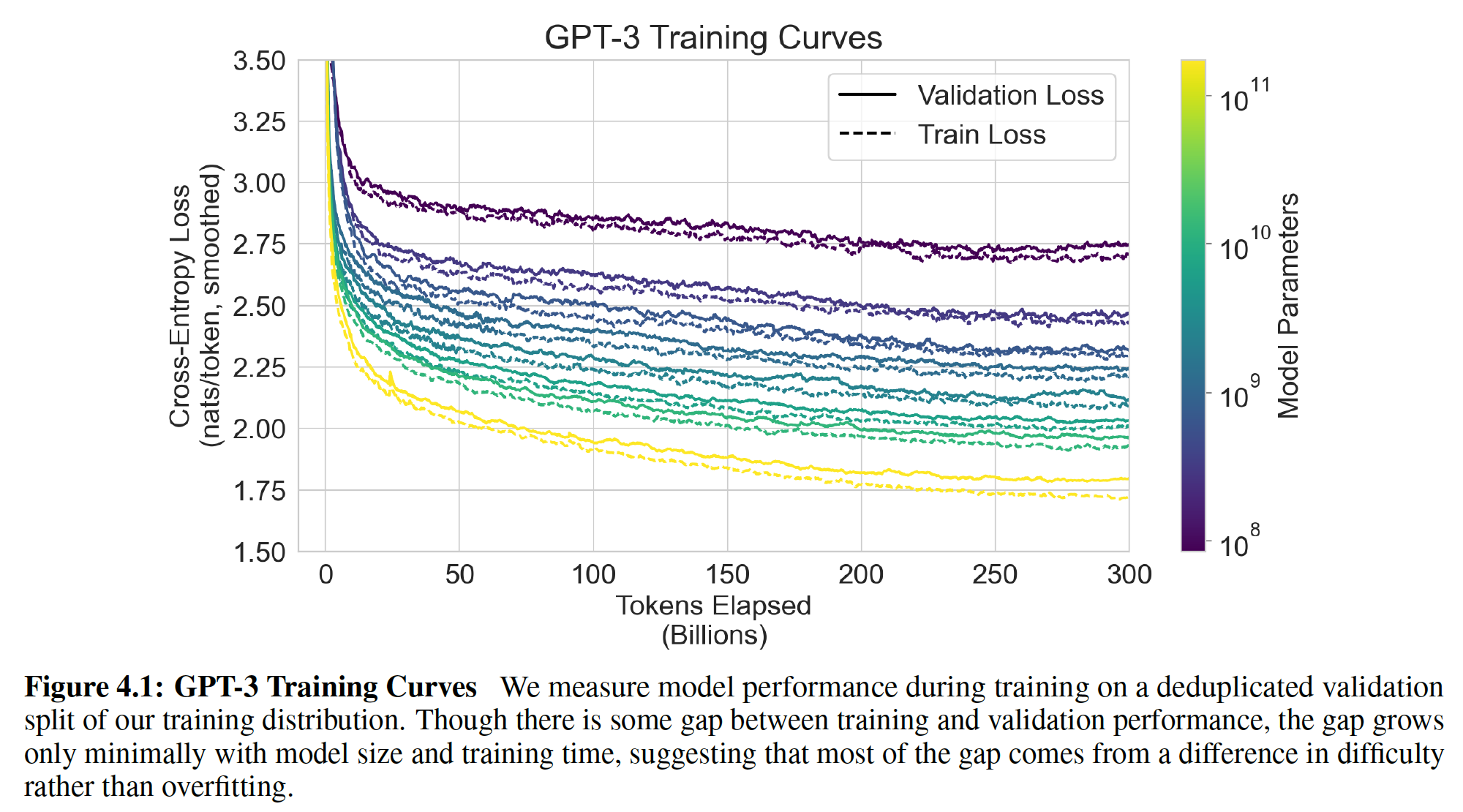

8个模型的训练曲线。在这张图中,我们还包括了6个额外的小模型,它们的参数只有10万个(一共十四条曲线)。正如在《Scaling laws for neural language models》中观察到的,当有效利用training compute时,语言建模的性能遵循一个power-law。在将这个趋势再scale两个数量级之后,我们观察到的是对power-law的轻微偏离(如果有的话)。人们可能会担心:交叉熵损失的这些提升仅仅来自于对我们训练语料库的虚假细节spurious details的建模(从而导致泛化能力较差)。然而,我们将在后续的章节看到,交叉熵损失的改善在广泛的自然语言任务中导致了一致的性能提升。作者注:在下图中,我们把

emebdding parameters从统计中剔除了。

下面,我们对这

8个模型(1750亿参数的GPT-3和7个较小的模型)在广泛的数据集上进行评估。我们将这些数据集分为9个类别,代表大致相似的任务。- 在

3.1节(原始论文的章节,下同)中,我们对传统的语言建模任务和语言建模类似的任务进行评估,如Cloze任务和sentence/paragraph completion任务。 - 在

3.2节中,我们的对closed book问答任务进行评估,这些任务需要使用存储在模型参数中的信息来回答通用的知识问题。 - 在

3.3节中,我们评估了该模型在不同语言之间的翻译能力(尤其是one-shot/few-shot)。 - 在

3.4节中,我们评估该模型在类似Winograd Schema任务上的表现。 - 在

3.5节中,我们对涉及尝试推理或问答的数据集进行评估。 - 在

3.6节中,我们对阅读理解任务进行了评估。 - 在

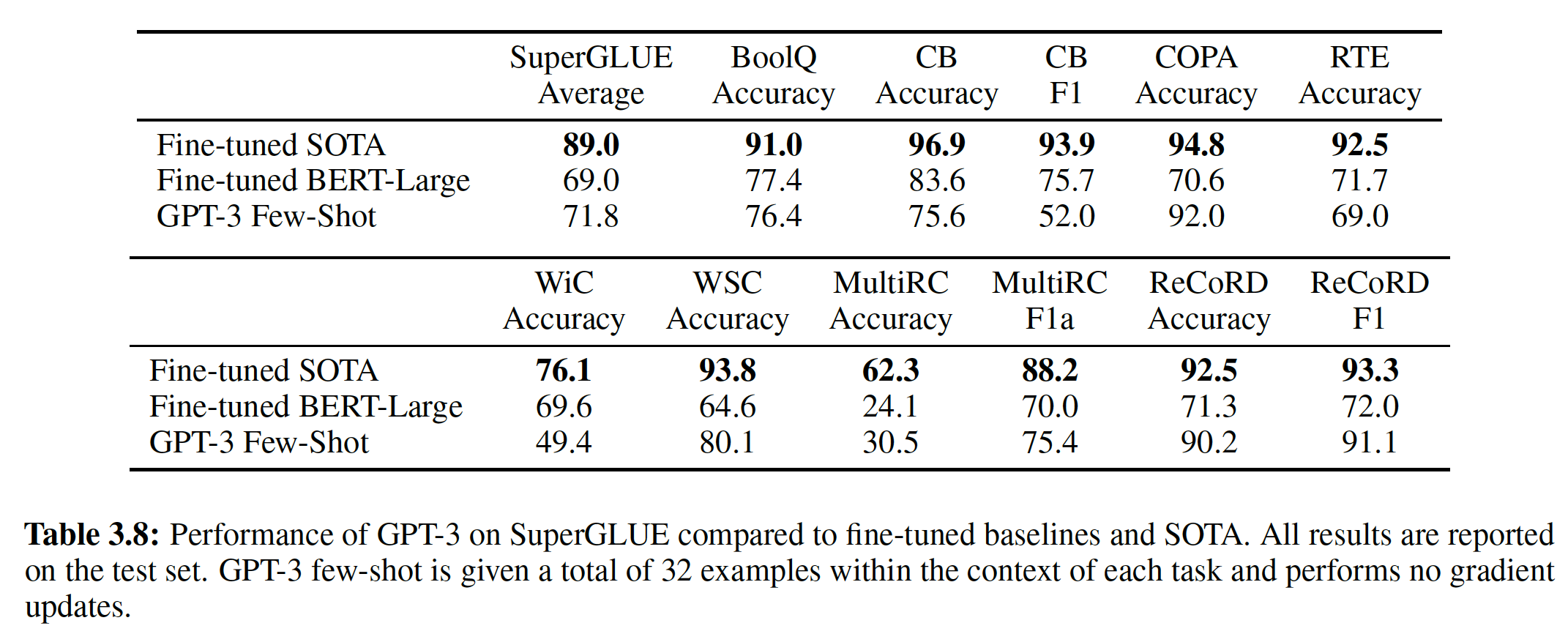

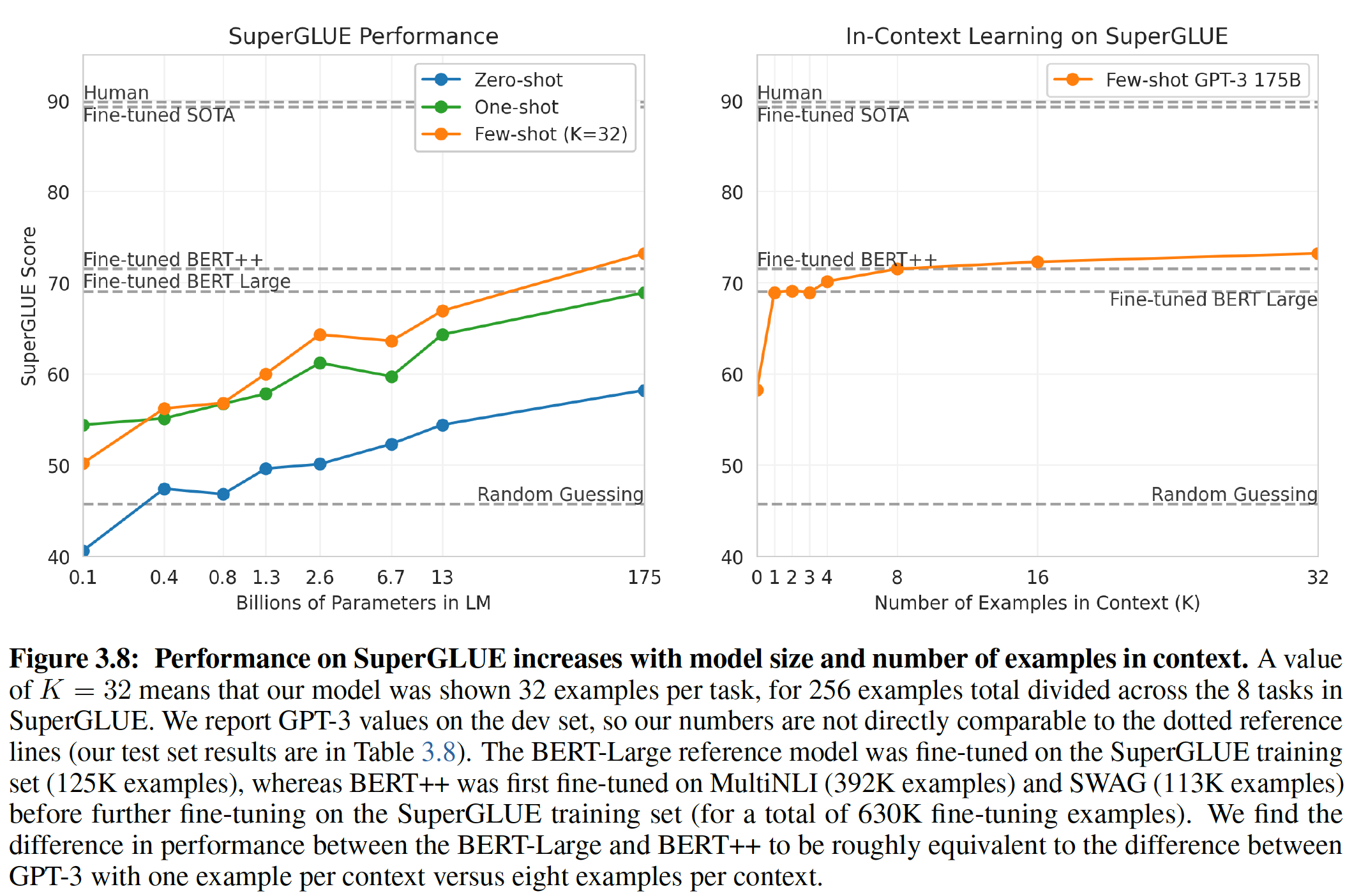

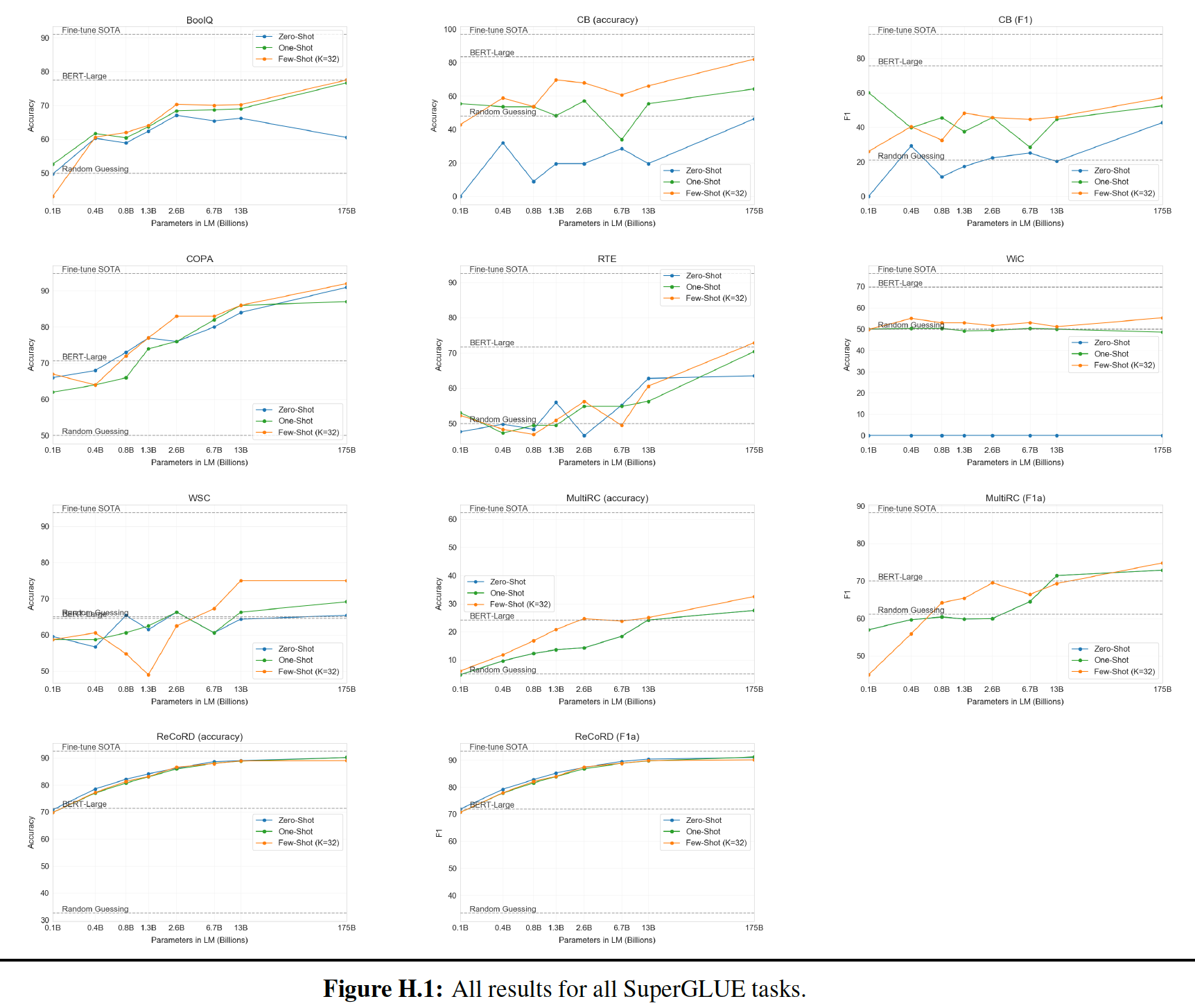

3.7节中,我们对SuperGLUE benchmark suite进行了评估。 - 在

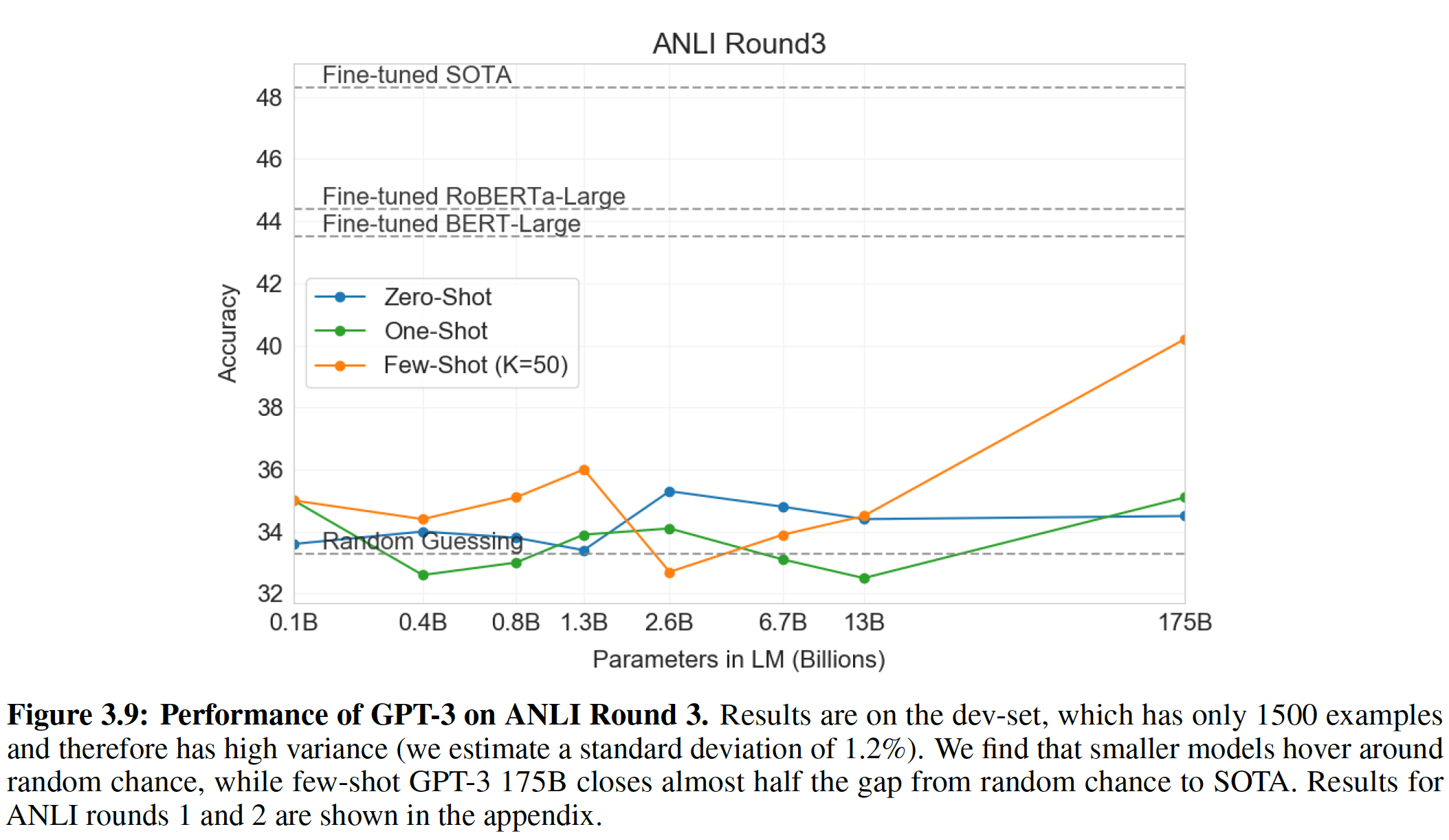

3.8节中,我们简要地讨论了NNLI。 - 在

3.9节中,我们开发了一些额外的任务,专门用来探测in-context learning能力。这些任务聚焦于即时推理on-the-fly reasoning、适应技能adaption skill、开放式文本合成open-ended text synthesis。

我们对所有任务都在

few-shot/one-shot/zero-shot setting下进行了评估。- 在

6.2.1 语言建模、完形填空、Completion 任务

a. 语言建模

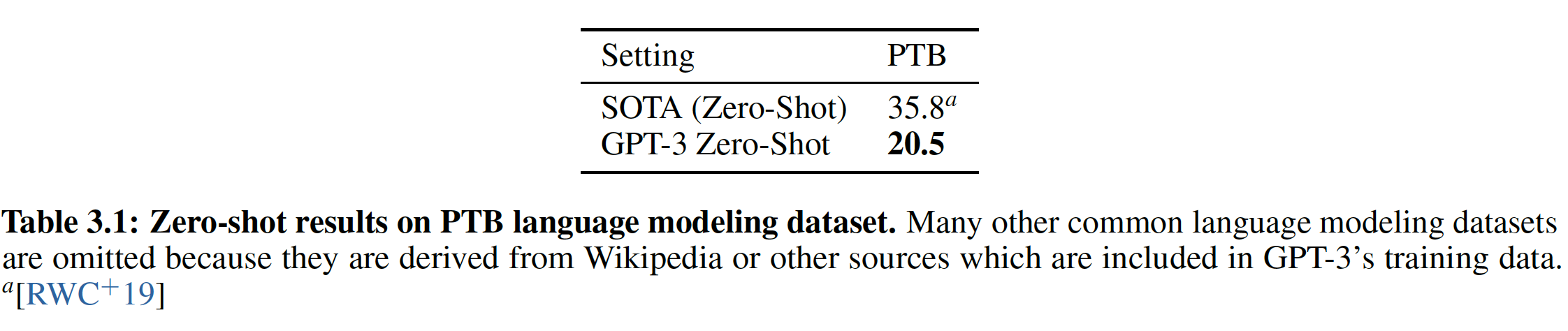

我们在

GPT-2中测量的Penn Tree Bank: PTB数据集上计算了zero-shot困惑度。我们最大的模型在PTB上达到了一个新的SOTA,有15个点的飞跃,达到了20.50的困惑度。注意,由于PTB是一个传统的语言建模数据集,它没有明确的分隔separation的样本来定义one-shot或zero-shot,所以我们仅测量zero-shot的。这里省略了许多常见的语言建模数据集,因为这些数据集来自于维基百科或其它数据源,而这些数据源都已经包含在

GPT-3的训练数据中。

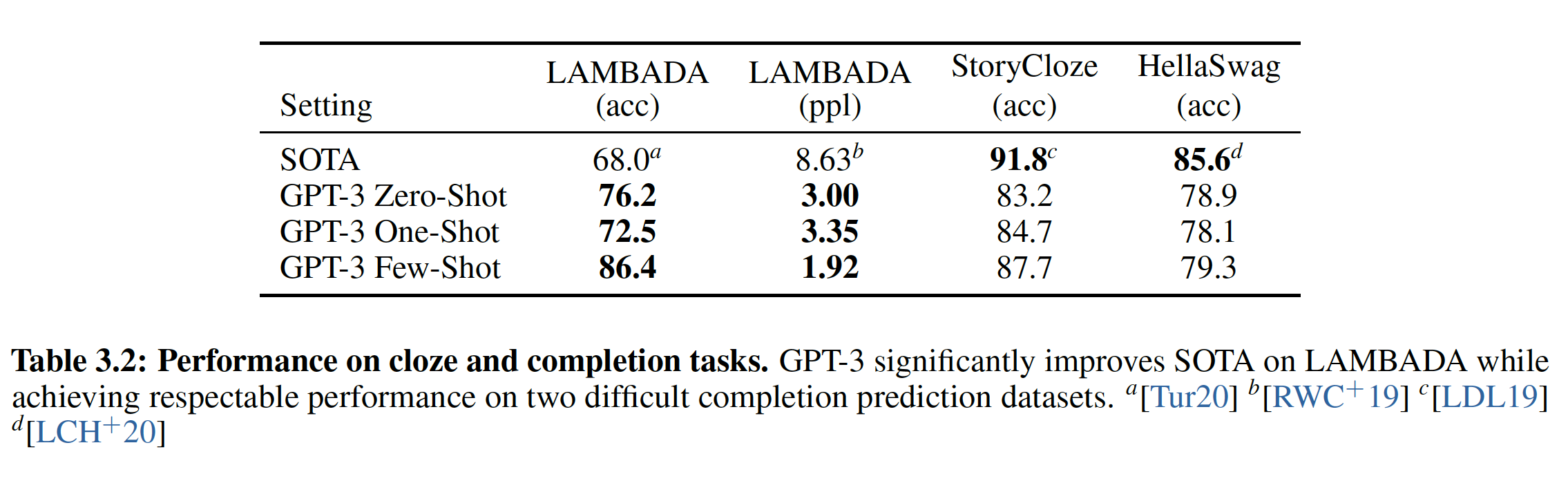

b. LAMBADA

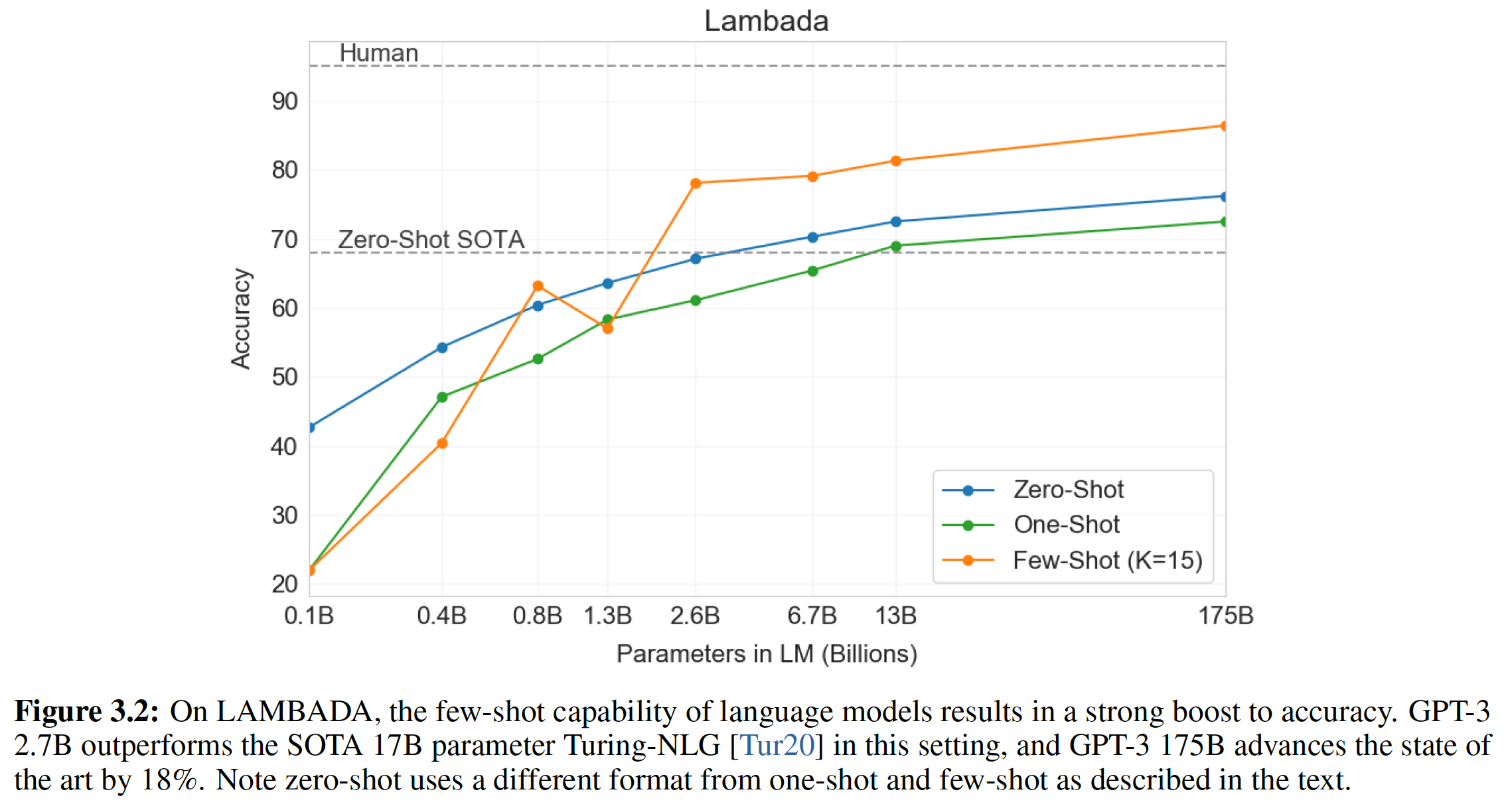

LAMBADA数据集测试了文本中长距离依赖关系的建模:模型被要求预测句子的最后一个单词,这要求模型阅读一个段落(作为上下文)。在zero-shot的情况下,GPT-3在LAMBADA上达到了76%,比以前的技术水平提高了8%。

LAMBADA也是few-shot learning灵活性的证明,因为它提供了一种方法来解决这个数据集上出现的一个经典问题:尽管LAMBADA中的completion总是句子中的最后一个单词,但是标准的语言模型却无法得知这个细节。因此,语言模型不仅为正确的结尾分配概率,也为该段落的其它有效continuation分配概率。这个问题在过去已经通过停用词过滤(这禁止了continuation词)得到了部分解决。few-shot setting反而使我们能够将任务 “框定” 为一个cloze-test,并允许语言模型从样本中推断出恰好需要一个单词的completion。我们使用以下的fill-in-the-blank格式:xxxxxxxxxxAlice was friends with Bob. Alice went to visit her friend ____. -> BobGeorge bought some baseball equipment, a ball, a glove, and a ___. ->当以这种方式呈现样本时,

GPT-3在few-shot setting下达到了86.4%的准确率,比之前的SOTA提高了18%。我们观察到,few-shot的性能随着模型的大小而得到强烈的改善:对于最小的模型则性能只有接近20%,而对于GPT-3则性能达到86%。最后,

fill-in-blank在one-shot setting中效果不佳,它的表现总是比zero-shot setting更差。也许这是因为所有模型仍然需要几个样本来识别模式。作者注:对于

few-shot learning,GPT-3 2.7B已经超越了SOTA的17B参数的Turing-NLG,并且GPT-3 175B超越了SOTA高达18%。

需要注意的是,对测试集污染的分析发现,

LAMBADA数据集中的相当一部分似乎存在于我们的训练数据中。然而 ”衡量和防止对benchmark的记忆“这部分章节的分析表明:这对性能的影响可以忽略不计。

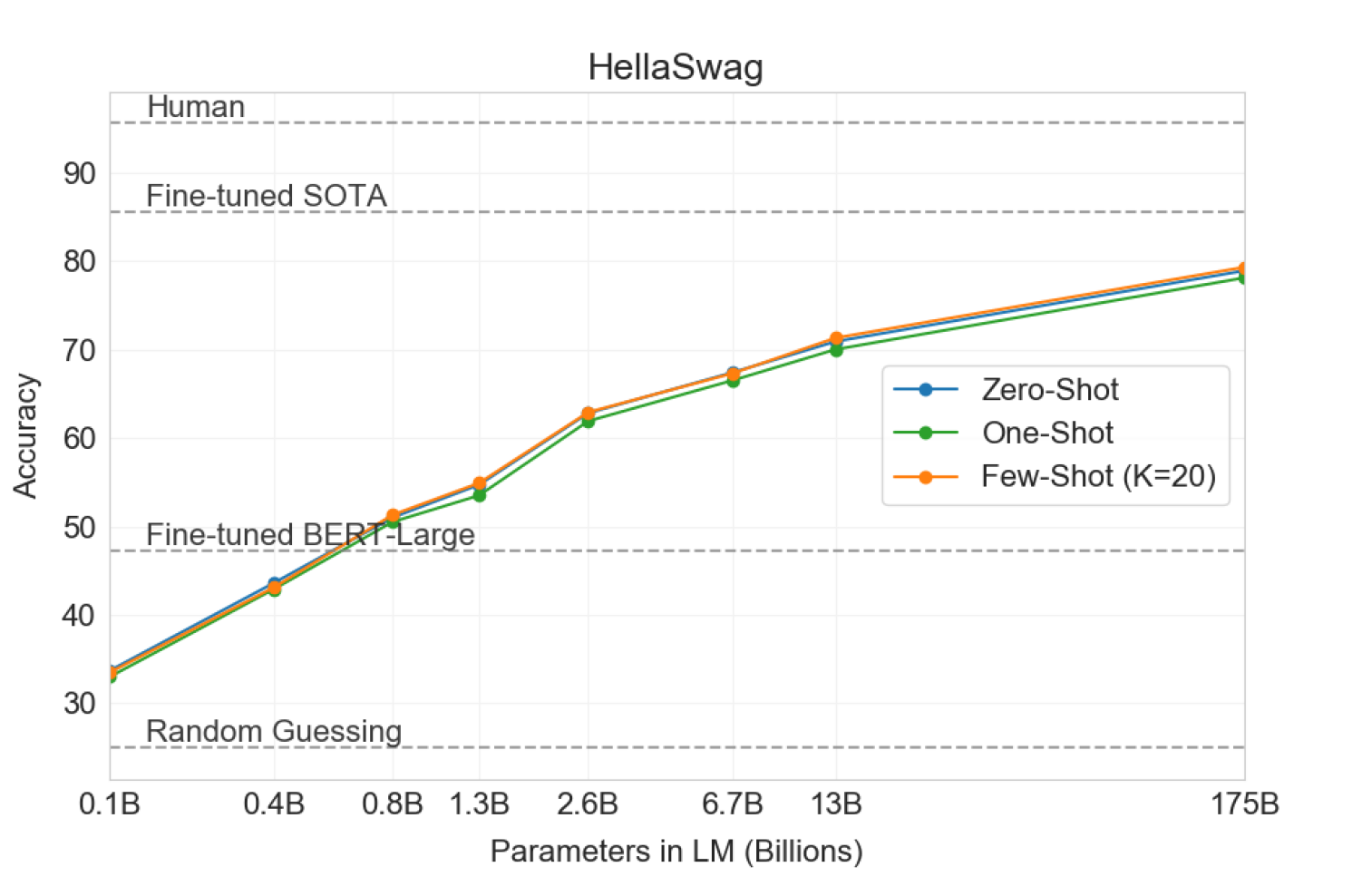

c. HellaSwag

HellaSwag数据集涉及为一个故事或一组指令挑选最佳的ending。这些例子被对抗性地挖掘出来,对语言模型而言很难,而对于人类而言确很容易(人类达到95.6%的准确率)。GPT-3在one-shot/few-shot setting中取得了78.1%/79.3%的准确率,超越了微调的1.5B参数模型Grover的75.4%的准确率,但是仍然比微调的多任务模型ALUM取得的85.6%的SOTA低了不少。

d. StoryCloze

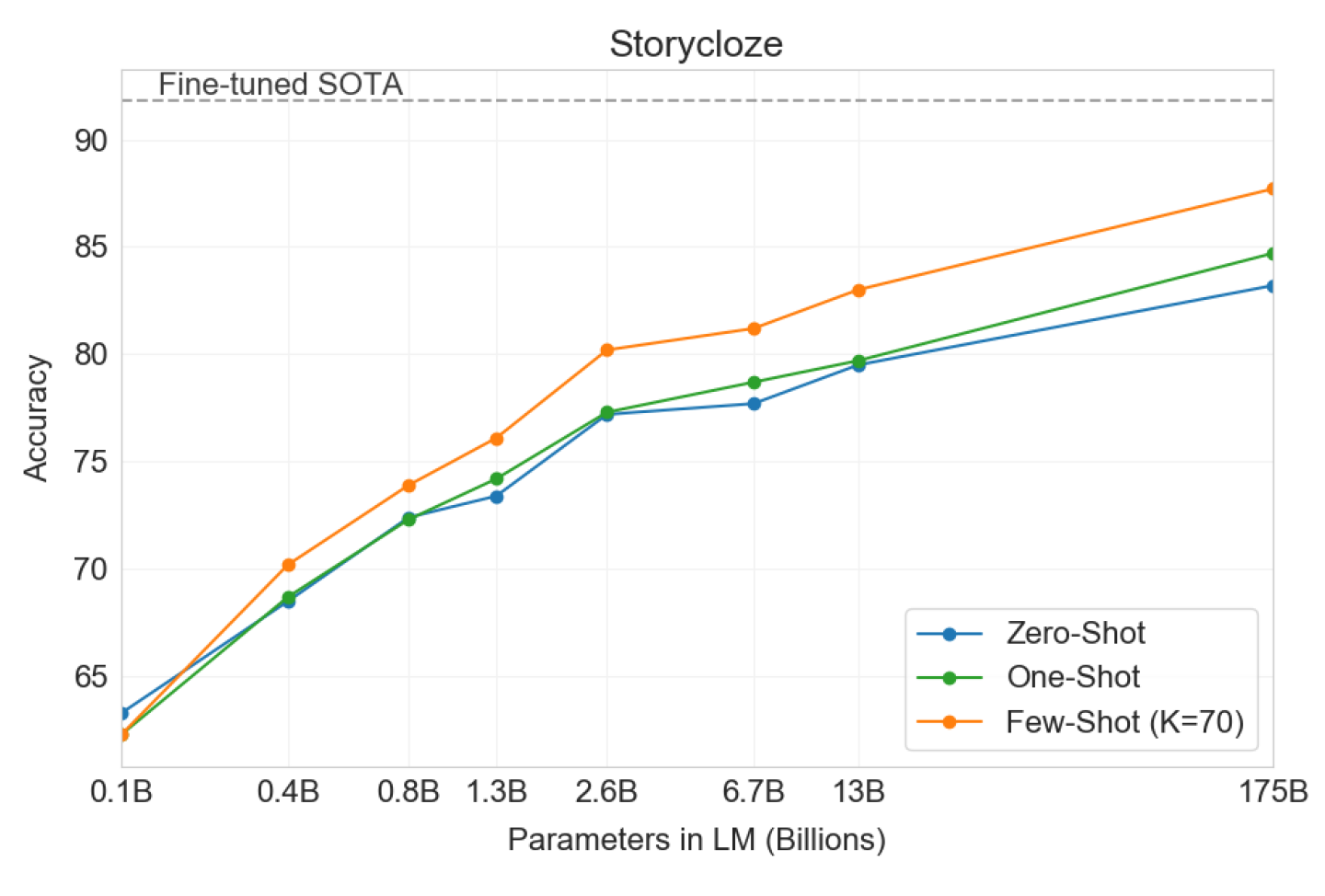

StoryCloze 2016数据集涉及为五句话长度的故事选择正确的ending sentence。这里,GPT-3在zero-shot/few-shot setting中取得了83.2%/87.7%的成绩,其中few-shot的BERT模型的微调SOTA低4.1%,但是比以前的zero-shot结果提高了大约10%。

6.2.2 Closed Book 问答

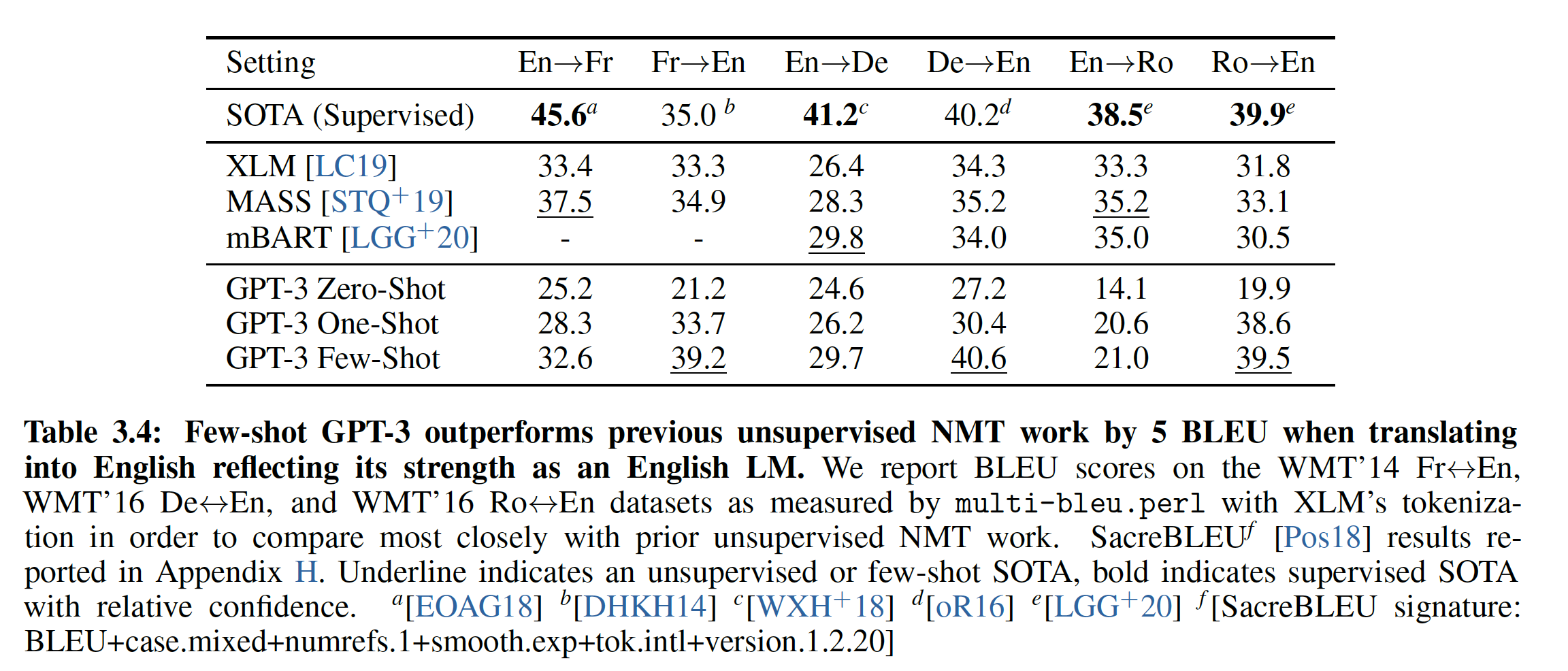

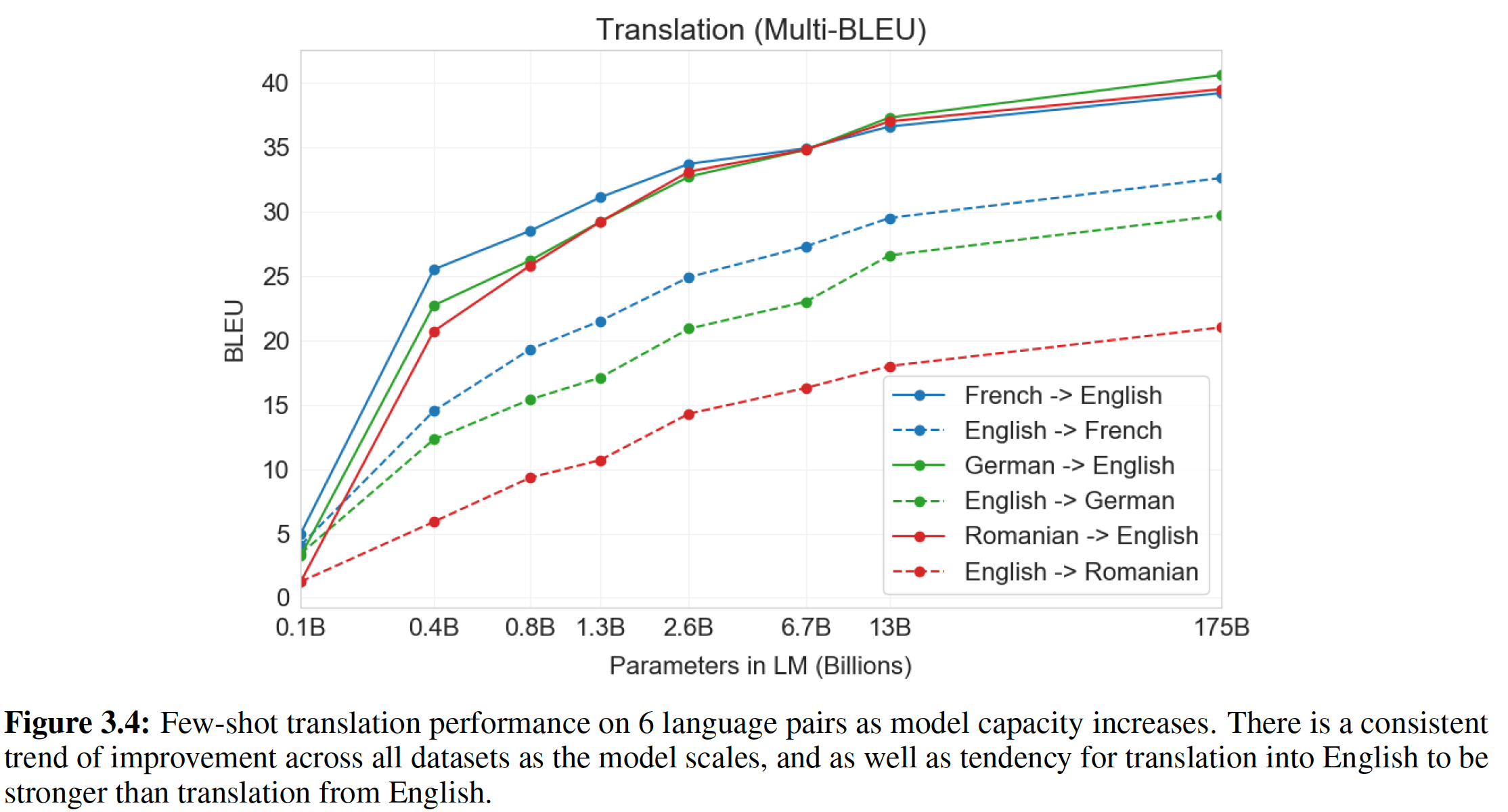

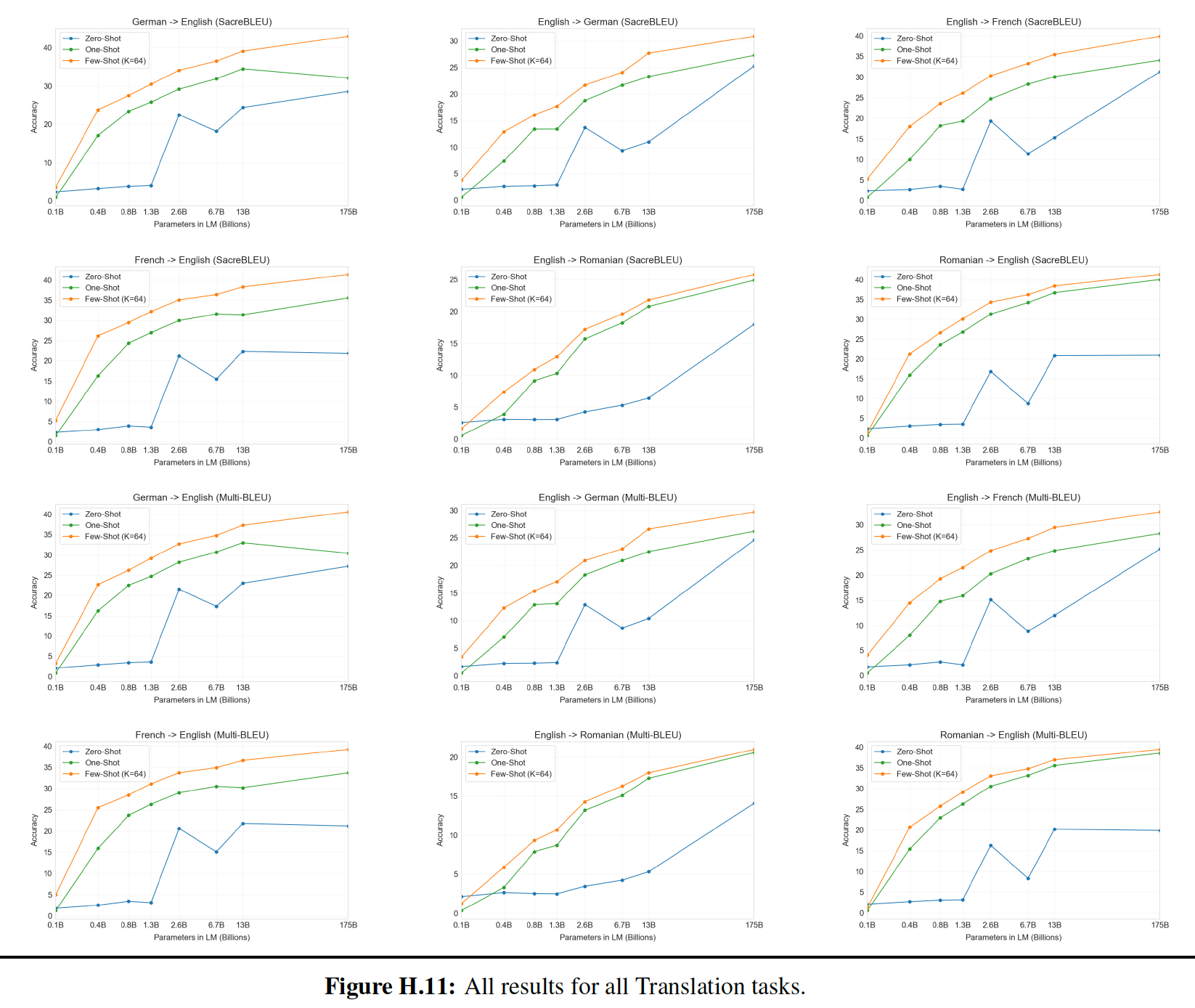

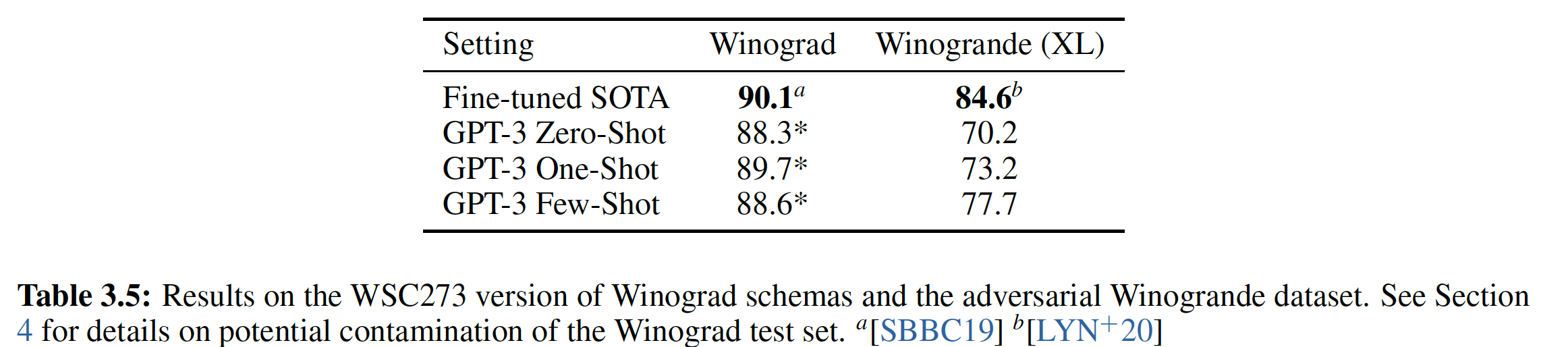

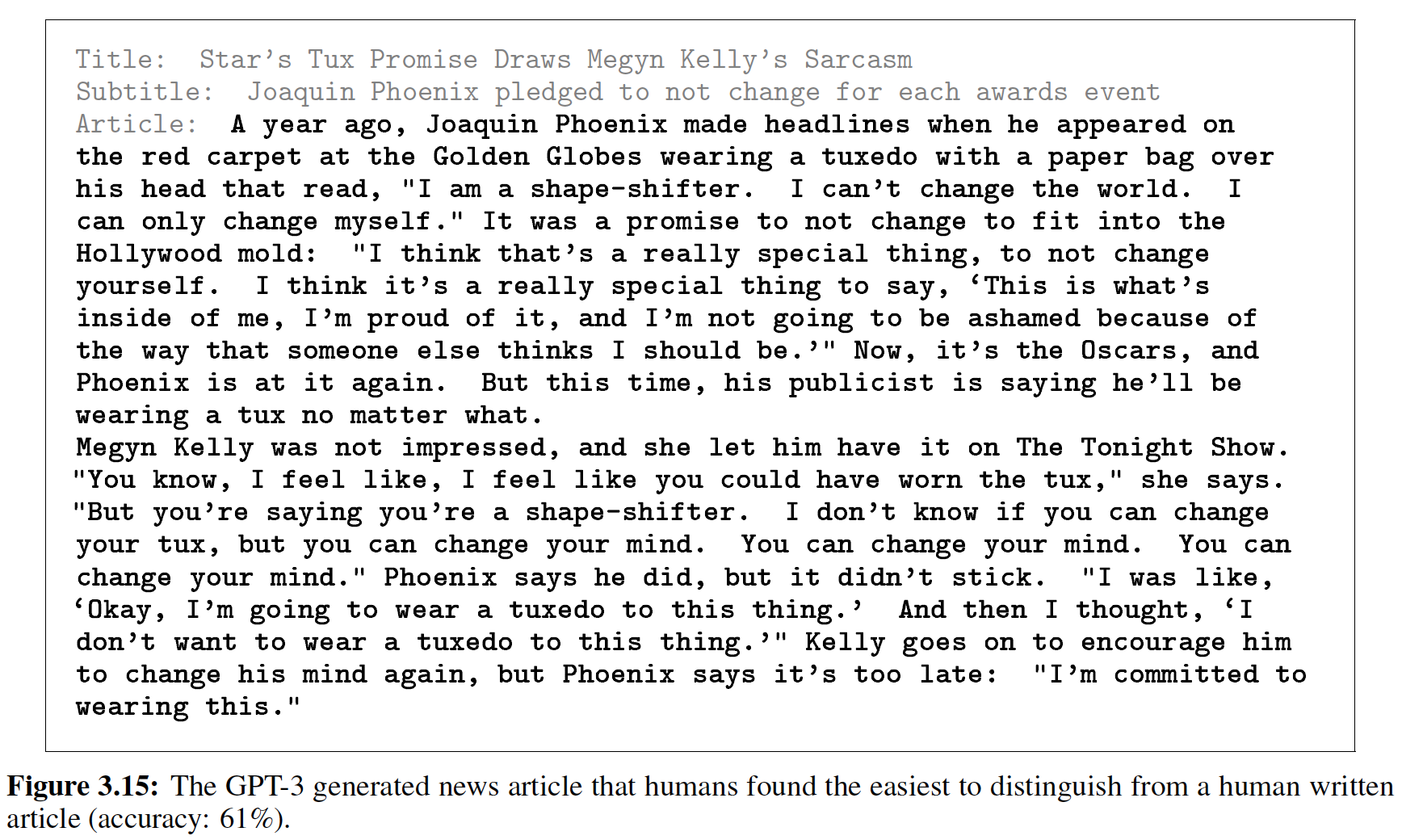

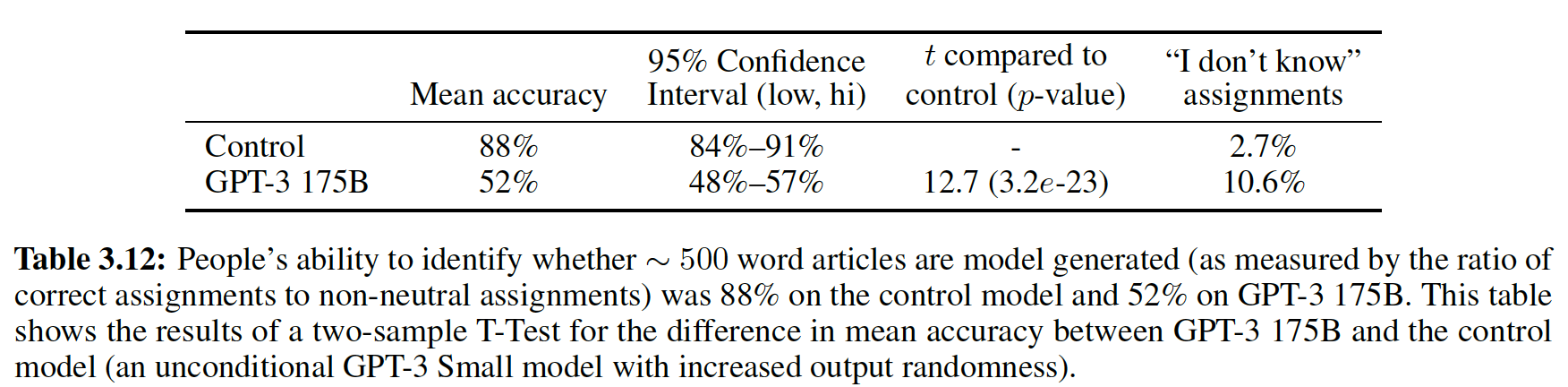

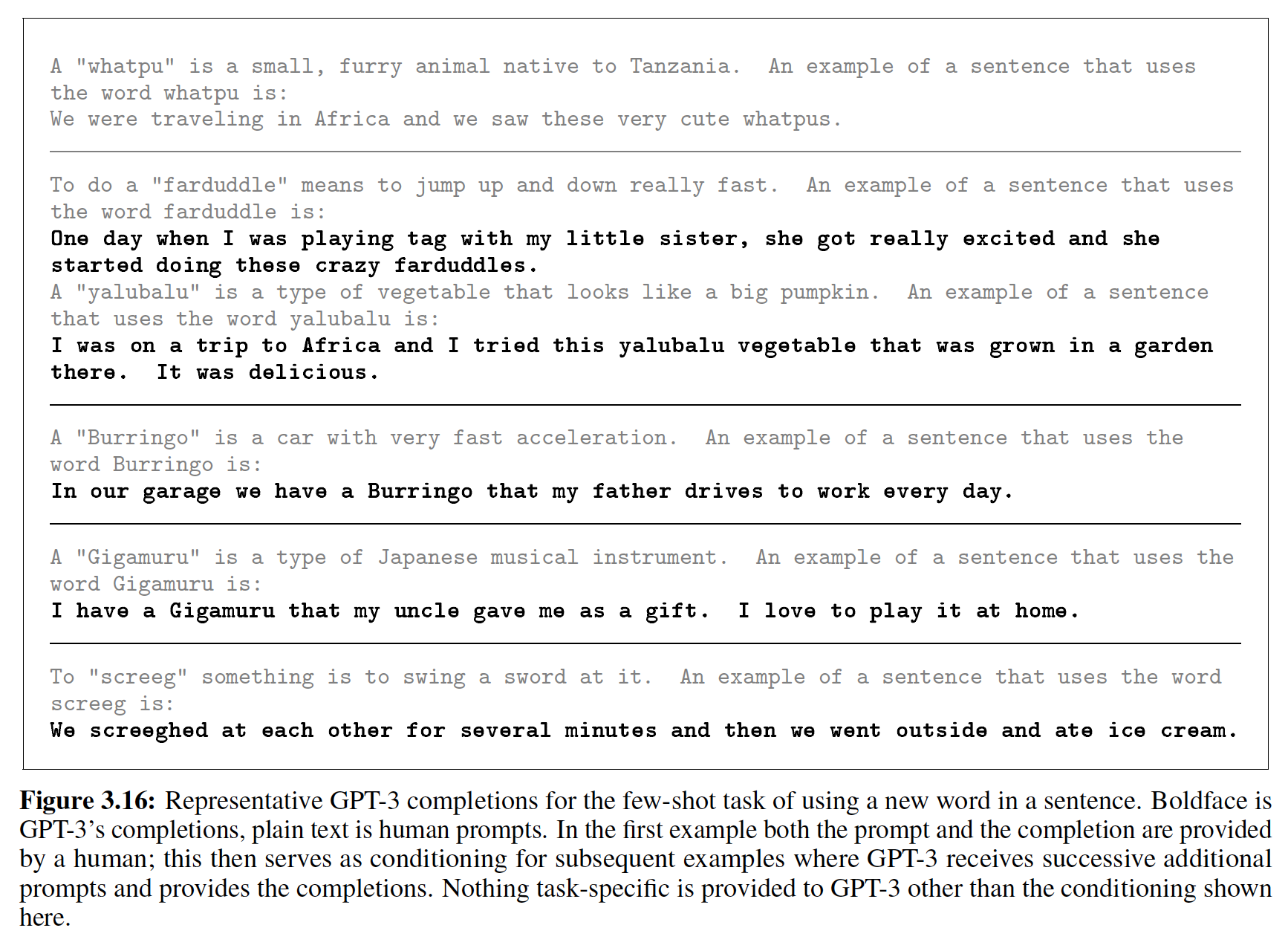

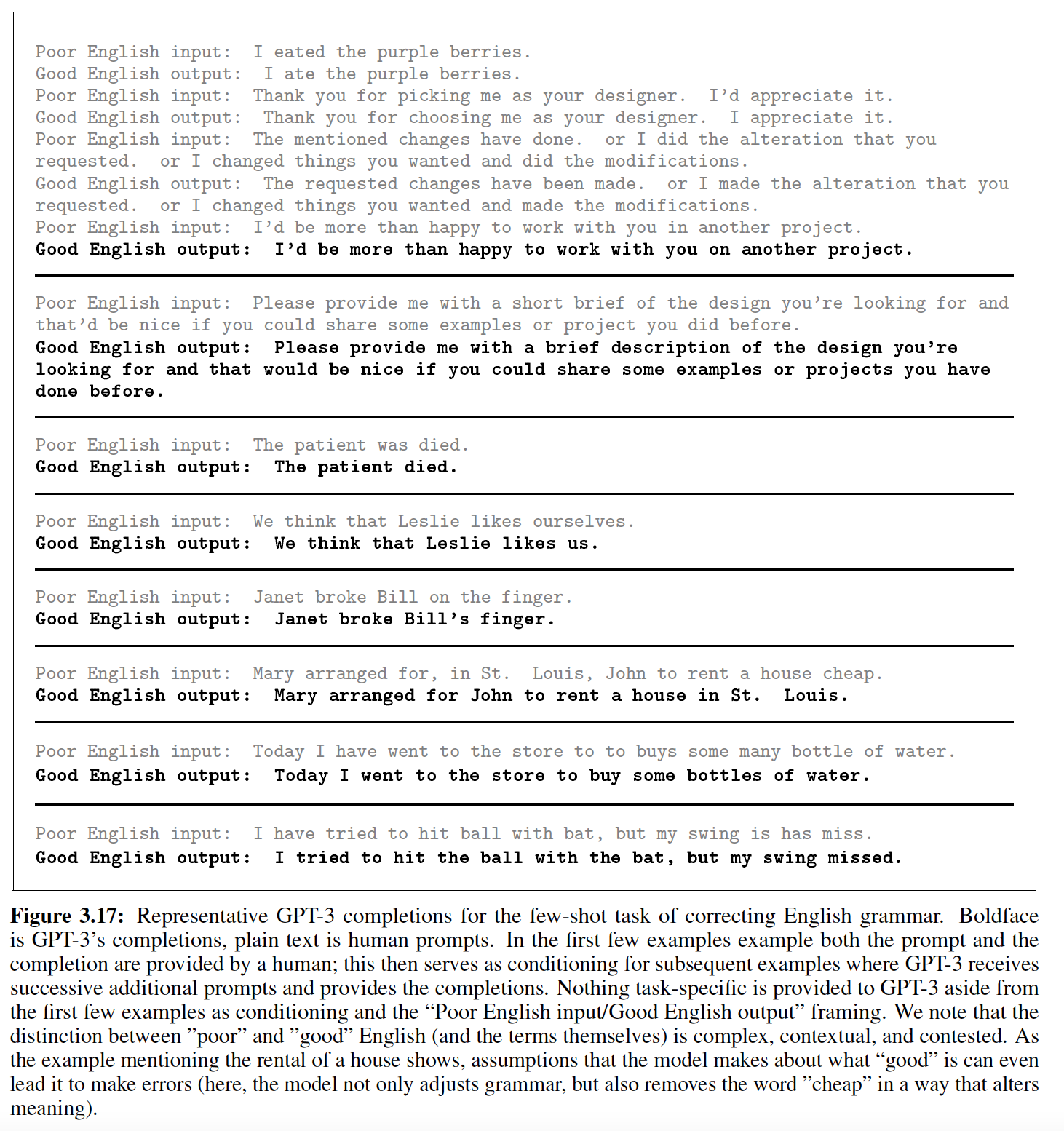

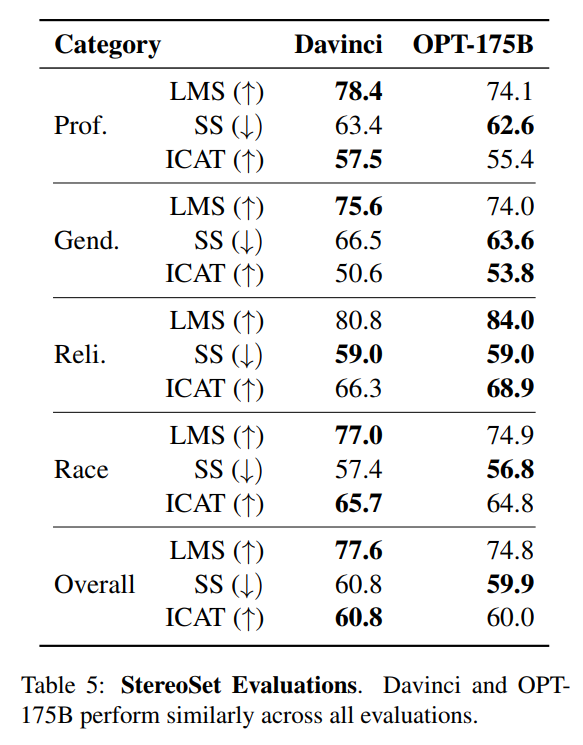

这里我们衡量