一、GIN [2019]

《How powerful are graph neural networks?》

对图结构数据的学习需要有效地对图结构进行表示。最近,对图表示学习(

graph representation learning)的图神经网络(Graph Neural Network: GNN)引起了人们的广泛兴趣。GNN遵循递归邻域聚合方案,其中每个节点聚合其邻居的representation向量从而计算节点的新的representation。已经有很多

GNN的变体,它们采用不同的邻域聚合方法、graph-level池化方法。从实验上看,这些GNN变体在很多任务(如节点分类、链接预测、图分类)中都达到了SOTA性能。但是,新的GNN的设计主要基于经验直觉(empirical intuition)、启发式(heuristics)、以及实验性(experimental)的反复试验。人们对

GNN的性质和局限性的理论了解很少,对GNN的表达容量(representational capacity)的理论分析也很有限。论文《How powerful are graph neural networks?》提出了一个用于分析GNN表达能力(representational power)的理论框架。作者正式刻画了不同GNN变体在学习表达(represent)和区分(distinguish)不同图结构上的表达能力(expressive)。论文的灵感主要来自于

GNN和Weisfeiler-Lehman:WL图同构检验(graph isomorphism test)之间的紧密联系。WL-test是一种强大的、用于区分同构图的检验。类似于GNN,WL-test通过聚合其网络邻域的特征向量来迭代更新给定节点的特征向量。WL-test如此强大的原因在于它的单射聚合更新(injective aggregation update),这可以将不同的节点邻域映射到不同的特征向量。单射函数:假设

论文的主要洞察是:如果

GNN的聚合方案具有很高的表达能力(expressive)并且建模单射函数(injective function),那么GNN可以具有与WL-test一样强大的判别力(discriminative power)。为了从数学上形式化该洞察,论文的框架首先将给定节点的邻居的特征向量集合表示为

multiset,即可能包含重复元素的集合。可以将GNN中的邻域聚合视为multiset上的聚合函数(aggregation function over the multiset)。因此,为了具有强大的表征能力 ,GNN必须能够将不同的multiset聚合为不同的representation。论文严格研究了multiset函数的几种变体,并从理论上刻画了它们的判别能力,即不同的聚合函数如何区分不同的multiset。multiset函数的判别力越强,则底层GNN的表征能力就越强。然后论文设计出一种简单的架构Graph Isomorphism Network: GIN,该架构被证明是GNN中最具表达能力的,并且和WL-test一样强大。论文在图分类数据集上进行实验来验证该理论,其中

GNN的表达能力对于捕获图结构至关重要。具体而言,作者比较了使用各种聚合函数的GNN的性能。实验结果证明了最强大的GNN(即作者提出的GIN)在实验中也具有很高的表征能力,因为它几乎完美拟合训练数据。而能力更弱的GNN变体通常对于训练数据严重欠拟合(underfit)。此外,GIN在测试集上的准确率也超过了其它GNN变体,并在图分类benchmark上达到了SOTA性能。论文的主要贡献:

证明

GNN在区分图结构方面最多和WL-test一样强大。给出邻域聚合函数和图

readout函数在什么条件下所得的GNN和WL-test一样强大。识别那些无法被主流的

GNN变体(如GCN,GraphSAGE)判别的图结构,然后刻画这些GNN-based模型能够捕获的图结构。设计了一个简单的神经网络架构,即

Graph Isomorphism Network: GIN,并证明了其判别能力/表征能力等于WL-test。

相关工作:尽管

GNN在经验上取得成功,但是在数学上研究GNN特性的工作很少。《Computational capabilities of graph neural networks》表明:早期的GNN模型在概率上逼近测度函数。《Deriving neural architectures fromsequence and graph kernels》表明:该论文提出的架构位于graph kernel的PKHS中,但没有明确研究该架构可以区分哪些图。

这些工作中的每一个都专注于特定的体系结构,并且不容易推广到多种体系结构。相反,我们的研究为分析和刻画一系列

GNN模型的表征能力提供了一个通用框架。另外,近期提出了一些基于

GNN的体系结构大多数没有理论推导。与此相比,我们的GIN是有理论推导的,而且简单、强大。

1.1 GNN 模型

我们首先总结一些常见的

GNN模型。令图

每个节点

通常我们关心图上的两类任务:

节点分类任务:每个节点

representation向量图分类任务:给定一组图

representation向量

GNN利用图结构和节点特征representation向量representation向量现代

GNN使用邻域聚合策略,在该策略中我们通过聚合邻域的representation来迭代更新节点的representation。在经过representation将捕获其k-hop邻域内的结构信息。以数学公式来讲,

GNN的第其中:

representation。另外

在

GraphSAGE的最大池化变体中,聚合函数为:其中:

relu非线性激活函数。

而

GraphSAGE中的拼接函数为简单的向量拼接:其中

[,]表示向量拼接,在

Graph Convolutional Networks: GCN中,聚合函数采用逐元素的均值池化。此时聚合函数、拼接函数整合在一起:其中

MEAN(.)为逐元素的均值池化,

对于节点分类任务,节点

representationrepresentation。对于图分类任务,

READOUT函数聚合所有节点最后一层的representation从而得到整个图的representationREADOUT函数可以是简单的排列不变函数(permutation invariant function),例如求和函数;也可以是更复杂的graph-level池化函数。

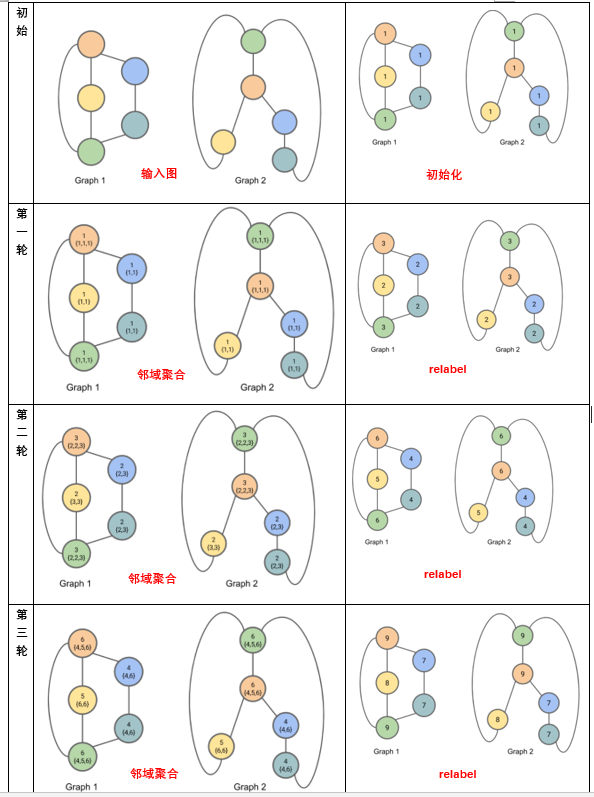

1.2 WL-test

图同构问题 (

graph isomorphism problem)是判断两个图在拓扑结构上是否相同。这是一个具有挑战性的问题,尚不知道多项式时间(polynomial-time)的算法。除了某些极端情况之外,图同构的

Weisfeiler-Lehman(WL) test是一种有效且计算效率高的算法,可用于各种类型的图。它的一维形式是naïve vertex refinement,它类似于GNN中的邻域聚合。在

WL-test过程中,每个节点都分配一个label。注意:这里的label和分类任务中的label不同,这里的label更多的表示“属性”, 而不是“监督信息”。WL-test对节点邻域进行反复迭代,最终根据两个图之间的节点label是否完全相同,从而判断两个图是否同构的。WL-test迭代过程如下:聚合节点及其邻域的

label。将聚合后的

label经过哈希函数得到不同的、新的label,即relabel。

如下图所示:

首先将图中每个节点初始化为

label = 1。然后经过三轮迭代,最终:

图

1具有1个label = 8、2个label = 7、2个label = 9。图

2具有1个label = 8、2个label = 7、2个label = 9。

因此我们不排除图

1和图2同构的可能性。

下图的哈希函数为:

{1,1} --> 2{1,1,1} --> 3{2,3} --> 4{3,3} --> 5{2,2,3} --> 6{4,6} --> 7{6,6} --> 8{4,5,6} --> 9注意:这里的

label集合需要根据label大小排序,并且每次哈希之后都需要分配一个新的label。

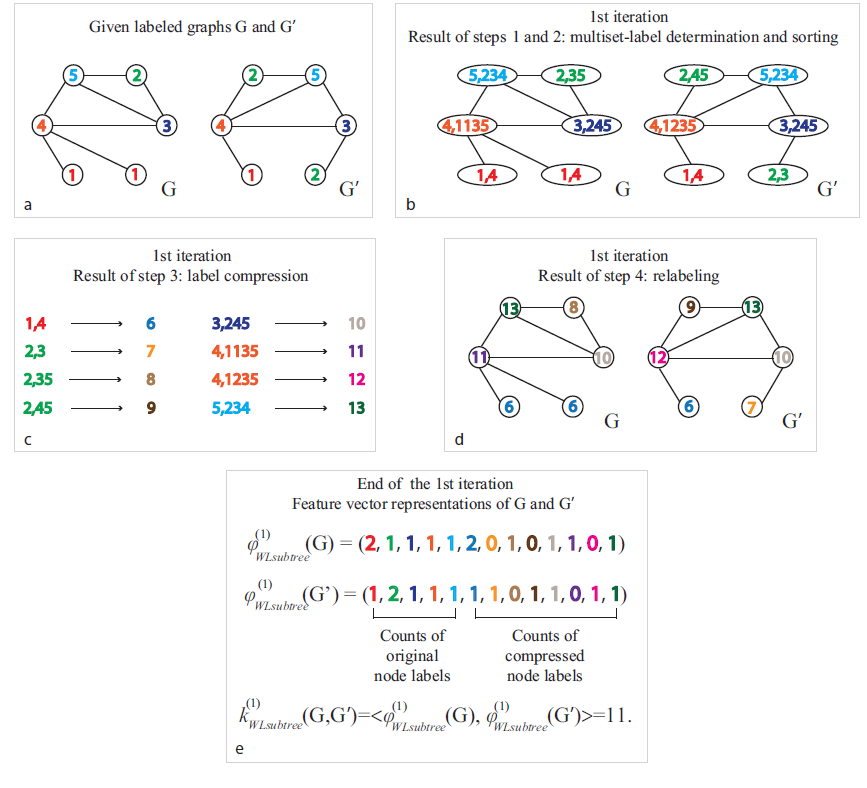

《Weisfeiler-lehman graph kernels》根据WL-test提出了WL subtree kernel来衡量两个图的相似性。核函数利用WL tet的不同迭代中使用的节点label数作为图的特征向量。直观地讲,

WL test第label代表了以该节点为根的、高度为WL subtree kernel考虑的图特征本质上是不同根子树的计数。如下图所示为一棵高度

WL subtree。 这里label = 8的节点代表一棵高度为1的subtree模式,其中subtree根节点的label为2、包含label=3和label=5的邻居节点。

1.3 模型

我们首先概述我们的框架,下图说明了我们的思想:

GNN递归更新每个节点的representation向量,从而捕获网络结构和邻域节点的representation,即它的rooted subtree结构。在整篇论文中,我们假设:

节点输入特征来自于可数的范围(

countable universe)。模型的任何

layer的representation也是来自可数的范围。

通常浮点数是不可数的,而整数是可数的。我们可以将浮点数离散化为整数,从而使得数值可数。

为便于说明,我们为每个

representation vector(输入特征向量是第0层的representation vector)分配唯一的label,label范围在label然后节点的邻域节点

representation vector就构成一个multiset:由于不同的节点可以具有相同的representation向量,因此同一个label可以在multiset中出现多次。下图中:

左图:一个图结构的数据。

中图:

rooted subtree结构,用于在WL test中区分不同的图。右图:如果

GNN聚合函数捕获节点邻域的full multiset,则GNN能够以递归的方式捕获rooted subtree结构,从而和WL test一样强大。

multiset定义:multiset是set概念的推广,它允许包含相同的多个元素。正式地讲,,multiset是一个2-tupleset,它包含唯一(distinct)的元素。multiplicity)。

为研究

GNN的表征能力,我们分析GNN何时将两个节点映射到embedding空间中的相同位置。直观地看,能力强大的

GNN仅在两个节点具有相同subtree结构、且subtree上相应节点具有相同特征的情况下才将两个节点映射到相同的位置。由于

subtree结构是通过节点邻域递归定义的,因此我们可以将分析简化为:GNN是否将两个邻域(即两个multiset)映射到相同的embedding或representation。能力强大的

GNN绝对不会将两个不同的邻域(即representation向量的multiset)映射到相同的representation。这意味着聚合函数必须是单射函数。因此我们将GNN的聚合函数抽象为神经网络可以表示的、multiset上的函数,并分析它们能否表示multiset上的单射函数。接下来我们使用这种思路来设计能力最强的

GIN。最后我们研究了主流的GNN变体,发现它们的聚合函数本质上不是单射的因此能力较弱,但是它们能够捕获图的其它有趣的特性。

1.3.1 定理

我们首先刻画

GNN-based通用模型的最大表征能力。理想情况下,能力最强大的

GNN可以通过将不同的图结构映射到embedding空间中不同的representation来区分它们。这种将任意两个不同的图映射到不同embedding的能力意味着解决具有挑战性的图同构问题。即,我们希望将同构图映射到相同的representation,将非同构图映射到不同的representation。在我们的分析中,我们通过一个稍弱的准则来刻画

GNN的表征能力:一种强大(powerful)的、启发式(heuristic)的、称作Weisfeiler-Lehman(WL)的图同构测试(graph isomorphism test)。WL-test通常工作良好,但是也有一些例外,如正规图(regular graph)。正规图是图中每个节点的degree都相同。如:立方体包含四个节点,每个节点的degree为3,记作4k3。

引理

2:令non-isomorphic graph)。如果一个图神经网络embedding,则WL-test也会判定证明:这里采用反证法。

假设经过

WL-test无法区分WL-test中从迭代0到迭代label collection都相同。具体而言,

label multisetlabel集合WL-test第label。否则WL-test在第label collection从而区分出现在我们证明:如果

当

WL-test和GNN都使用节点的特征向量来初始化。如前所述,对于任意label假设对于第

考虑第

根据第

由于两个图

AGGREGATE函数和COMBINE函数。因此相同的输入(如邻域特征)产生相同的输出。因此有:因此第

因此如果

WL-test节点label满足representation集合graph-level readout函数对于节点representation集合是排列不变的(permutation invariant),因此有根据引理

2,任何基于聚合的GNN在区分不同图结构方面最多和WL-test一样强大。一个自然的问题是:是否存在和

WL-test一样强大的GNN?在定理3中,我们将证明:如果邻域聚合函数和graph-level readout函数是单射的,则得到的GNN和WL-test一样强大。定理

3:令GNN。在具有足够数量GNN层的条件下,如果满足以下条件,则WL-test判定为非同构的两个图embedding:representation:其中

multiset上。graph-level readout函数是单射函数。其中readout函数作用在节点embedding multiset

证明:令

WL-test在我们假设

representation为:其中

假设

WL-test应用一个预定义的单射函数label:其中

接下来我们通过数学归纳法证明:对于任意迭代轮次

当

WL-test和GNN都使用节点的特征向量来初始化。如前所述,对于任意label假设对于

现在考虑第

由于单射函数的复合函数也是单射函数,因此存在某个单射函数

则有:

因此复合函数

因此对于任意迭代轮次

经过

WL-test判定label multisetinjectivity),embedding集合对于可数集,单射性(

injectiveness)很好地描述了一个函数是否保持输入的唯一性(distinctness)。节点输入特征是连续的不可数集则需要进一步考虑。此外,刻画学到的

representation在embedding空间中的邻近程度(如果两个embedding不相等的话)也很有意义。我们将这些问题留待以后的工作,本文重点放在输入节点特征来自可数集的情况,并仅考虑输出representation相等/不等的情况。引理

4:假设输入特征空间GNN第size有界的multisetrepresentation证明:证明之前我们先给出一个众所周知的结论,然后将其简化:对于任意

现在回到我们的的引理证明。如果我们可以证明在可数集上的、

size有限的multiset上定义的任何函数range)也是可数的,则对于任意现在我们的目标是证明

首先,因为

layer定义良好(well-defined)的函数,因此很明显multiset由于两个可数集的并集也是可数的,因此

dummy元素且不在正如

multiset的集合映射到由于

我们对于

由于

multisetsize有界,则存在其中最后

dummy element

显然

size有界的multiset这里还值得讨论

GNN在图结构判别能力上的一个重要优点,即:捕获图结构的相似性。WL-test中的节点特征向量本质上是one-hot编码,因此无法捕获subtree之间的相似性。相反,满足定理

3条件的GNN将subtree嵌入到低维空间来推广WL-test。这使得GNN不仅可以区分不同的结构,还可以学习将相似的图结构映射到相似的embedding从而捕获不同图结构之间的依赖关系。捕获

node label的结构相似性有助于泛化(generalization),尤其是当subtree的共现(co-occurrence)很稀疏时、或者存在边噪音和/或节点特征噪音时。

1.3.2 GIN

在研究出能力最强的

GNN的条件之后,我们接下来将设计一种简单的架构,即图同构网络 (Graph Isomorphism Network: GIN)。可以证明GIN满足定理3中的条件。GIN将WL-test推广从而实现了GNN的最大判别力。为建模用于邻居聚合的

multiset单射函数,我们研究了一种deep multiset理论,即:使用神经网络对multiset函数进行参数化。我们的下一个引理指出:

sum聚合实际上可以表示为multiset上的通用单射函数。引理

5:假设输入特征空间size的multisetunique)。进一步地,任何multiset函数证明:我们首先证明存在一个映射

size的multiset由于

multisetcardinality)是有界的,则存在自然数one-hot向量或N-digit数字的压缩表示。因此multiset的单射函数。permutation invariant),因此它是定义良好的 (well-defined)的multiset函数。对于任意multiset函数引理

5将《Deep sets》中的结论从set扩展到multiset。deep multiset和deep set之间的重要区别是:某些流行的set单射函数 (如均值聚合)不再是multiset单射函数。通过将引理

5中的通用multiset函数建模机制作为构建块 (building block),我们可以设想一个聚合方案,该方案可以表示单个节点及其邻域的multiset上的通用函数,因此满足定理3中的第一个条件。我们的下一个推论是在所有这些聚合方案中选择一个简单而具体的形式。

推论

6:假设pair对unique),其中size的multisetpair上的函数证明:接着推论

5的证明过程,我们考虑5。令

我们用反证法证明。

对于任意

此时

根据推论

5该等式不成立,因为我们重写

因为

对于定义在

注意:这样的

well-defined),因为由于通用逼近定理(

universal approximation theorem),我们可以使用多层感知机 (multi-layer perceptrons:MLPs)来建模和学习推论6中的函数实际上我们使用一个

MLP来建模MLPs可以表示组合函数。在第一轮迭代中,如果输入特征是

one-hot编码,则在求和之前不需要MLP,因为它们的求和本身就是单射的。即:

我们将

GIN的节点representation更新方程为:

通常而言,可能存在很多其它强大的

GNN。GIN是这些能力强大的GNN中的一个简单的例子。GIN学到的节点embedding可以直接用于诸如节点分类、链接预测之类的任务。对于图分类任务,我们提出以下readout函数,该函数可以在给定每个节点embedding的情况下生成整个图的embedding。关于

graph-level readout函数的一个重要方面是:对应于subtree结构的node embedding随着迭代次数的增加而越来越精细化(refine)和全局化(global)。足够数量的迭代是获得良好判别力的关键,但是早期迭代的representation可能会泛化能力更好。为了考虑所有结构信息,我们使用来自模型所有深度的信息。我们通过类似于

Jumping Knowledge Networks的架构来实现这一点。在该架构体系中,我们将GIN所有层的representation拼接在一起:通过定理

3和推论6,如果GIN使用求和函数(求和针对相同迭代轮次中所有节点的representation进行)替代了上式中的READOUT(因为求和本身就是单射函数,因此在求和之前不必添加额外的MLP),它就可证明地(provably)推广了WL-test和WL subtree kernel。

1.4 Less Powerfull GNN

现在我们研究不满足定理

3中条件的GNN,包括GCN、GraphSAGE。另外,我们对GIN的聚合器的两个方面进行消融研究:单层感知机代替多层感知机

MLP。均值池化或最大池化代替求和。

我们将看到:这些

GNN变体无法区分很简单的图,并且比WL-test能力更差。尽管如此,具有均值聚合的模型(如GCN)在节点分类任务中仍然表现良好。为了更好地理解这一点,我们精确地刻画了哪些GNN变体可以捕获或无法捕获图结构,并讨论了图学习的意义。

1.4.1 单层感知机

引理

5中的函数multiset映射到唯一的embedding。MLP可以通过通用逼近定理对GNN改为使用单层感知机relu)。这种单层映射是广义线性模型(Generalized Linear Models)的示例。因此,我们有兴趣了解单层感知机是否足以进行图学习。引理

7表明:确实存在使用单层感知机的图模型永远无法区分的网络邻域(multiset)。引理

7:存在有限size的multiset证明:考虑示例

multiset,但是它们的sum结果相同。我们将使用ReLU的同质性(homogeneity)。令

如果

如果

如果

因此得到:

引理

7的证明的主要思想是:单层感知机的行为和线性映射非常相似。因此GNN层退化为简单地对邻域特征进行求和。我们的证明基于以下事实:线性映射中缺少偏置项。使用偏置项和足够大的输出维度,单层感知机可能区分不同的multiset。尽管如此,和使用

MLP的模型不同,单层感知机(即使带有偏置项)也不是multiset函数的通用逼近器。因此,即使具有单层感知机的GNN可以在不同程度上将不同的图嵌入到不同的位置,此类embedding也可能无法充分捕获结构相似性,并且可能难以拟合简单的分类器(如线性分类器)。在实验中,我们观察到带单层感知机的

GNN应用于图分类时,有时对于训练数据严重欠拟合(underfit)。并且在测试集准确率方面要比带MLP的GNN更差。

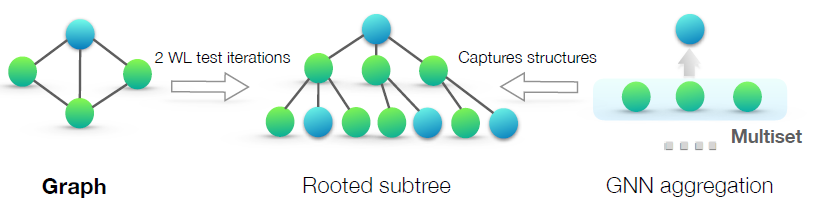

1.4.2 均值池化和最大池化

如果我们把

GCN、GraphSAGE中的那样,结果会如何?均值池化和最大池化仍然是

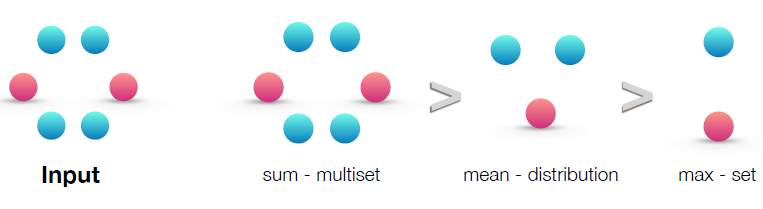

multiset上定义良好的函数,因为它们是排列不变的(permutation invariant)。但是,它们不是单射函数。下图按照表征能力对这三种聚合器(

sum/mean/max聚合器)进行排名(rank)。左图给出了输入的multiset,即待聚合的网络邻域。后面的三幅图说明了给定的聚合器能够捕获multiset的哪个方面:sum捕获了完整的multiset。mean捕获了给定类型的元素的比例/分布。max忽略了多重性(multiplicity),将multiset简化为简单的set。

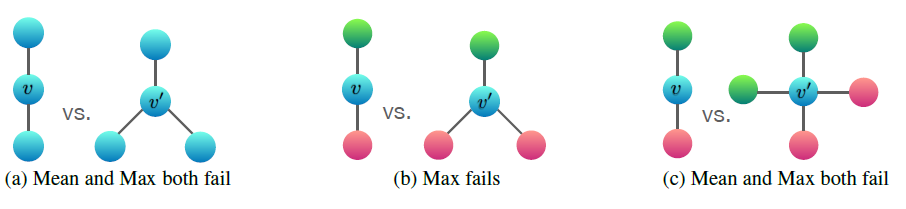

下图说明了

mean池化和max池化无法区分的一对图结构。这里节点颜色表示不同的节点特征,我们假设GNN首先将邻域聚合在一起,然后再将它们与标记为combine)在一起。在两个图之间,节点

embedding,即使它们的图结构是不同的。如前所述:sum捕获了完整的multiset;mean捕获了给定类型的元素的比例/分布;max忽略了多重性 (multiplicity),将multiset简化为简单的set。图

(a)给出均值池化和最大池化都无法区分的图。这表明:均值池化和最大池化无法区分所有节点特征都相同的图。图

(b)给出最大池化无法区分的图。令r表示红色、g表示绿色) 为max池化:collapse)到相同的representation(即使对应的图结构不同)。因此最大池化也无法区分它们。相反,均值池化是有效的,因为

图

(c)给出均值池化和最大池化都无法区分的图。这表明:均值池化和最大池化无法区分节点特征分布相同的图。因为:

a. 均值池化

为了刻画均值聚合器能够区分的

multiset类型,考虑两个multiset:distinct)的元素,但是embedding,因为均值聚合器只是对各元素特征取均值。因此,均值聚合器捕获的是

multiset中元素的分布(比例),而不是捕获确切的multiset本身。推论

8:假设1的整数。证明:假设

multiset1的正整数。即set,并且multiplicity为因此有:

现在我们证明存在一个函数

distributionally equivalent)的unique的。由于multisetcardinality是有界的,因此存在一个数如果某个任务中,图的统计信息和分布信息比确切结构更重要,则对于该任务使用均值聚合器可能会表现良好。

此外,当节点特征多种多样(

diverse),且很少重复时,均值聚合器的能力几乎和sum聚合器一样强大。这可以解释为什么尽管存在限制(只能捕获multiset中元素的分布、而不是捕获确切的multiset本身),但是具有均值聚合器的GNN对于节点特征丰富的节点分类任务(如文章主题分类和社区检测)有效,因为邻域特征分布足以为任务提供强有力的信号。

b. 最大池化

最大池化将多个具有相同特征的节点视为仅一个节点(即,将

multiset视为一个简单的set)。最大池化无法捕获确切的结构或分布。但是,它可能适合于需要识别代表性元素或者骨架(

skeleton),而不适合需要区分确切结构或分布的任务。实验表明:最大池化聚合器学会了识别

3D点云的骨架,并对噪声和离群点具有鲁棒性。为了完整起见,下一个推论表明最大池化聚合器捕获了multiset底层的set。推论

9:假设set有证明:假设

multisetset现在我们证明存在一个映射

set的unique的。由于其中

multiset映射到它的one-hot embedding。

1.4.3 其它聚合器

我们还没有覆盖到其它非标准的邻域聚合方案,如通过

attention加权平均的聚合器、LSTM池化聚合器。我们强调,我们的理论框架足以通用从而刻画任何基于聚合的GNN的表征能力。未来我们会研究应用我们的框架来分析和理解其它聚合方案。

1.5 实验

我们评估和对比了

GIN以及能力较弱的GNN变体的训练和测试性能。训练集上的性能比较让我们能够对比不同

GNN模型的表征能力。测试集上的性能比较让我们能够对比不同

GNN模型的泛化能力。

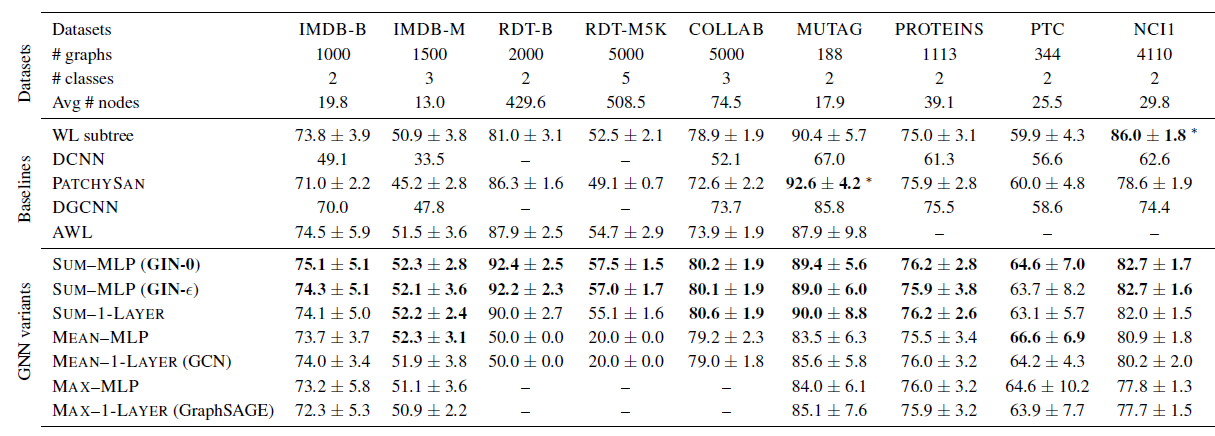

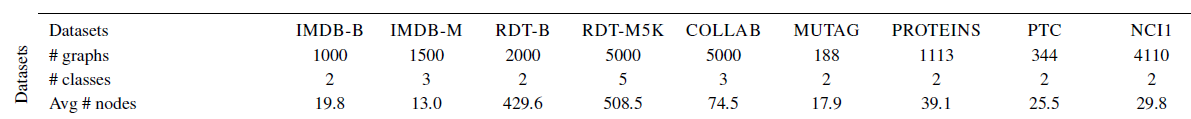

数据集:我们使用

9种图分类benchmark数据集,包括4个生物信息学数据集(MUTAG, PTC, NCI1, PROTEINS)、5个社交网络数据集(COLLAB, IMDB-BINARY, IMDB-MULTI, REDDITBINARY and REDDIT-MULTI5K) 。社交网络数据集:

IMDB-BINARY和IMDB-MULTI是电影协作(collaboration)数据集。每个图对应于演员的协作图,节点代表演员。如果两个演员出现在同一部电影中,则节点之间存在边。

每个图都来自于预先指定的电影流派(

genre),任务的目标是对图的流派进行分类。REDDIT-BINARY和REDDIT-MULTI5K是平衡的数据集。每个图对应于一个在线讨论话题(

thread),节点对应于用户。如果一个用户评论了另一个用户的帖子,则两个节点之间存在一条边。任务的目标是将每个图分类到对应的社区。

COLLAB是一个科学协作(collaboration)数据集,它来自3个公共协作数据集,即High Energy Physics, Condensed Matter Physics, Astro Physics。每个图对应于来自每个领域的不同研究人员的协作网络。任务的目标是将每个图分类到所属的领域。

生物学数据集:

MUTAG是包含188个诱变(mutagenic)的芳香族(aromatic)和异芳香族(heteroaromatic)硝基化合物(nitro compound)的数据集,具有7个类别。PROTEINS数据集中,节点是二级结构元素 (secondary structure elements:SSEs),如果两个节点在氨基酸序列或3D空间中是邻居,则两个节点之间存在边。它具有3个类别,分别代表螺旋(helix)、片(sheet)、弯(turn)。PTC是包含344种化合物的数据集,给出了针对雄性和雌性老鼠的致癌性,具有19个类别。NCL1是美国国家癌症研究所公开的数据集,是化学化合物平衡数据集的子集(balanced datasets of chemical compounds)。这些化合物经过筛选具有抑制一组人类癌细胞系生长的能力,具有37个类别。

重要的是,我们的目标不是让模型依赖于节点的特征,而是主要从网络结构中学习。因此:在生物信息图中,节点具有离散 (

categorical)的输入特征;而在社交网络中,节点没有特征。对于社交网络,我们按照如下方式创建节点特征:对于

REDDIT数据集,我们将所有节点特征向量设置为相同。因此这里特征向量不带任何有效信息。对于其它社交网络,我们使用节点

degree的one-hot编码作为节点特征向量。因此这里的特征向量仅包含结构信息。

下表给出了数据集的统计信息。

baseline方法:WL sbuntree kernel,其中使用C-SVM来作为分类器。SVM的超参数C以及WL迭代次数通过超参数调优得到,其中迭代次数从{1,2,3,4,5,6}之中选择。STOA深度学习架构,如Diffusionconvolutional neural networks: DCNN、PATCHY-SAN、Deep Graph CNN: DGCNN。Anonymous Walk Embeddings: AWL。

对于深度学习方法和

AWL,我们报告其原始论文中的准确率。实验配置:我们评估

GIN和能力较弱的GNN变体。在

GIN框架下,我们考虑两种变体:一种是通过梯度下降来学习

另一种是固定

GIN-0。GIN的邻域聚合就是sum池化(不包含当前节点自身)。

正如我们将看到的,

GIN-0将表现出强大的实验性能:GIN-0不仅与对于能力较弱的

GNN变体,我们考虑使用均值池化或最大池化替代GIN-0中的sum聚合,或者使用单层感知机来代替GIN-0中的多层感知机。这些变体根据使用的聚合器、感知器来命名。如

mean-1-layer对应于GCN、max-1-layer对应于GraphSAGE,尽管有一些小的体系架构修改。

对于

GIN和所有的GNN变体,我们使用相同的graph-level readout函数。具体而言,由于更好的测试性能,生物信息学数据集的readout采用sum函数,而社交网络数据集的readout采用mean函数。我们使用

LIB-SVM执行10-fold交叉验证,并报告10-fold交叉验证中验证集准确率的均值和标准差。对于所有配置(

configurations):我们使用

5层GNN layer(包含输入层),并且MLP都有2层(它不算在5层GNN内)。我们对于每个

hidden layer应用batch normalization。我们使用初始学习率为

0.01的Adam学习器,并且每50个epoch进行学习率衰减0.5。

超参数是针对每个数据集进行调优的:

对于生物学数据集,隐层维度为

16或32;对于社交网络数据集,隐层维度为64。batch size为32或128。dropout在dense层后,dropout比例为0或0.5。epoch数量通过10-fold交叉验证来确定。

注意:由于数据集规模较小,因此使用验证集进行超参数选择极其不稳定。例如对于

MUTAG,验证集仅包含18个数据点。因此上述有很多超参数是我们人工调优的。我们也报告了不同

GNN的训练准确率。其中所有的超参数在所有数据集上都是固定的(调优之后):5层GNN layer(包括输入层)、hidden维度为64、batch size = 128、dropout比例为0.5。为进行比较,我们也报告了

WL subtree kernel的准确率,其中迭代数量为4。这和5 GNN layer相当。

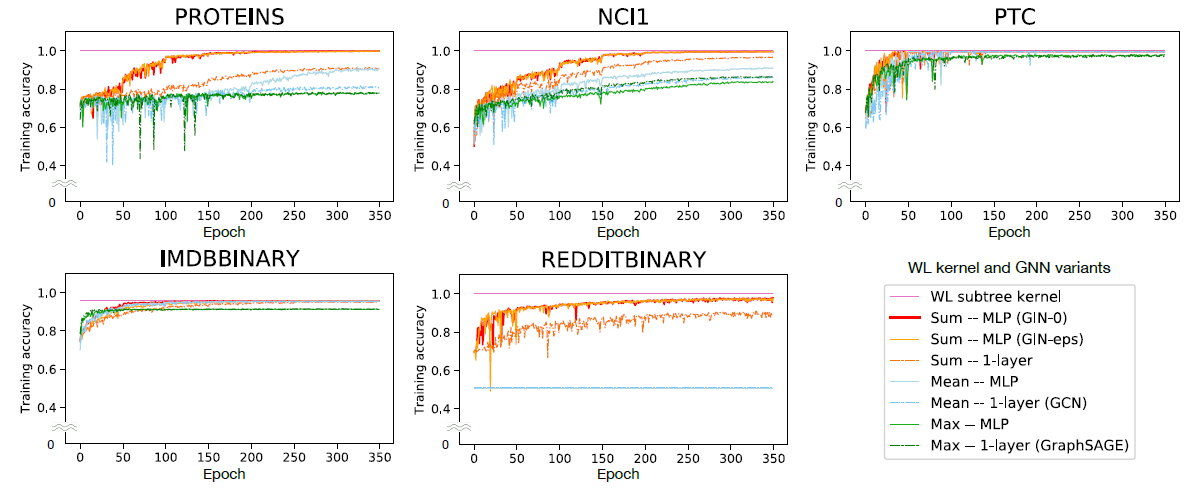

1.5.1 训练准确率

通过比较

GNN的训练准确率,我们验证了我们关于表征能力的理论分析。具有较高表达能力的模型应该具有较高的训练准确率。下图给出了具有相同超参数设置的GIN和能力较弱的GNN变体的训练曲线。首先,

GNN,它们都可以几乎完美地拟合训练集。在我们的实验中,在拟合训练数据集这个方面 ,显式学习

0的相比之下,使用均值/最大值池化聚合、或者单层感知机的

GNN变体在很多数据集中严重欠拟合。具体而言,训练准确率模式和我们通过模型表征能力的排名相符:

采用

MLP的GNN变体要比采用单层感知机的GNN变体拟合训练集效果更好。采用

sum聚合器的GNN变体要比采用均值/最大值池化聚合的GNN变体拟合训练集效果更好。

在我们的数据集上,

GNN训练准确率永远不会超过WL subtree kernel。这是可以预期的,因为

GNN的判别力通常比WL-test更低。例如在IMDB-BINARY数据集上,没有一个模型能够完美拟合训练集,而GNN最多可达到与WL kernel相同的训练准确率。这种模式和我们的结果一致,即

WL-test为基于聚合的GNN的表征能力提供了上限。但是,WL kernel无法学习如何组合节点特征,这对于给定的预测任务非常有用。我们接下来会看到。

1.5.2 测试准确率

接下来我们比较测试准确率。尽管我们的理论分析并未直接提及

GIN的泛化能力,但是可以合理地预期具有强大表达能力的GNN可以准确地捕获感兴趣的图结构,从而更好地泛化。下表给出了

GIN(Sum-MLP) 、其它GNN变体、以及SOTA baseline的测试准确率。表现最好的GNN以黑色突出显示。在有些数据集上GIN的准确率在所有GNN变体之间并非最高,但是和最佳GNN相比GIN仍然具有可比的性能,因此GIN也已黑色突出显示。如果baseline的性能明显高于所有GNN,则我们用黑体和星号同时突出显示。结论:

首先,

GIN,尤其是GIN-0,在所有9个数据集上均超越了(或者达到可比的)能力较弱的GNN变体,达到了SOTA性能。其次,在包含大量训练数据的社交网络数据集中,

GIN效果非常好。对于

Reddit数据集,所有节点都使用相同的特征,因此模型仅能捕获图结构信息。GIN以及sum聚合的GNN准确地捕获到图结构,并且显著优于其它模型。均值聚合

GNN无法捕获图的任何结构,并且其测试准确率和随机猜测差不多。

对于其它社交网络数据集,虽然提供了节点

degree作为输入特征,但是基于均值聚合的GNN也要比基于sum聚合的GNN差得多。对于

GIN-0和GIN-0稍微、但是一致地超越了GIN-0相比