一、NCF [2017]

《Neural Collaborative Filtering》

在信息爆炸的时代,推荐系统在缓解信息过载(

information overload)方面发挥着举足轻重的作用,并且已经被许多在线服务广泛采用,包括电商、在线新闻、社交媒体网站。个性化推荐系统的关键在于根据用户历史交互(例如评分、点击)对user-item的偏好进行建模,这就是所谓的协同过滤(collaborative filtering)。在各种协同过滤技术中,矩阵分解(

matrix factorization: MF)是最流行的一种,它将用户和item投影到共享的潜在空间(latent space)中,使用潜在特征向量来表示用户和item。此后,用户对item的交互被建模为它们潜在向量(latent vector)的内积。通过Netflix Prize的推广,MF已经成为基于潜在因子模型(latent factor model-based)的推荐的事实上的方法。许多研究工作致力于增强

MF,例如将其与基于邻域的模型(neighbor-based model)相结合、将其与item内容的主题模型(topic model)相结合、将其扩展到分解机(factorization machine)从而进行特征的通用建模。尽管

MF对于协同过滤很有效,但是众所周知,它的性能可能会受到简单选择“内积” 作为交互函数的阻碍。例如,对于基于显式反馈的评分预测任务,众所周知,可以通过将user bias项和item bias项添加到交互函数中从而提高MF模型的性能。虽然这对于内积算子而言似乎只是一个微不足道的调整,但是它指出了设计一个更好的、专用的交互函数来建模用户和item之间潜在特征交互的积极效果。内积算子,它仅仅简单地线性组合多个潜在特征(latent feature)的乘法,可能不足以捕获用户交互数据的复杂结构。在论文

《Neural Collaborative Filtering》中,作者探讨了使用深度神经网络从数据中学习交互函数,而不是像以前许多工作那样人工设计交互函数。神经网络已经被证明能够逼近任何连续函数,而且最近发现神经网络(deep neural networks: DNNs)在多个领域都有效 ,从计算机视觉、语音识别到文本处理。然而,与大量关于MF方法的文献相比,使用DNN进行推荐的工作相对较少。尽管最近的一些进展已经将DNN应用于推荐任务并显示出有希望的结果,但是它们主要使用DNN来建模辅助信息(auxiliary information),例如item的文本描述、音乐的音频特征、图像的视觉特征。在建模关键的协同过滤效果方面,他们仍然采用MF,使用内积来结合用户潜在特征和item潜在特征。论文通过形式化(formalize)用于协同过滤的神经网络建模方法来解决上述研究问题(利用神经网络来建模交互函数)。通过采用可以从数据中学习任意函数的神经网络架构代替内积,论文提出了一个名为Neural Network-based Collaborative Filtering: NCF的通用框架。论文聚焦于隐式反馈(

implicit feedback),隐式反馈通过视频观看、商品购买、item点击等行为间接反映了用户的偏好。和显式反馈(explicit feedback)(即显式评分rating和评论review)相比,隐式反馈可以自动跟踪,因此更容易被内容提供商(content provider)所收集。然而,隐式反馈的使用更具有挑战性,因为无法观察到用户满意度(user satisfaction),并且负反馈(negative feedback)天然的稀疏性。在本文中,作者探讨了如何利用DNN对包含噪音的隐式反馈信号进行建模。论文的主要贡献:

论文提出了一个神经网络架构来对用户和

item的潜在特征进行建模,并设计了一个基于神经网络的协同过滤通用框架NCF。论文表明:

MF可以被解释为NCF的特殊情况,并利用多层感知机赋予NCF模型高度的非线性。论文在两个真实数据集上进行了大量的实验,从而证明

NCF方法的有效性,以及深度学习在协同过滤方面的前景。

相关工作:

隐式反馈:虽然关于推荐的早期文献主要集中在显式反馈,但最近人们越来越关注隐式数据。具有隐式反馈的协同过滤(

collaborative filtering: CF)任务通常被形式化为item推荐问题,其目的是向用户推荐一个简短的item列表。和显式反馈工作广泛解决的评分预测相比,解决item推荐问题更实用但更具有挑战性。一个关键的洞察(insight)是对缺失数据进行建模,而这些缺失数据总是被显式反馈的工作所忽略。为了使用隐式反馈为

item推荐定制(tailor)潜在因子模型,早期工作应用了两种均匀加权策略:将所有缺失数据视为负样本,或者从缺失数据中均匀采样负样本。最近,《Fast matrix factorization for online recommendation with implicit feedback》和《Modeling user exposure in recommendation》提出了专门的模型来对缺失数据进行加权。《A generic coordinate descent framework for learning from implicit feedback》为基于特征的分解模型开发了一种隐式坐标下降(implicit coordinate descent: iCD)解决方案,实现了SOTA的item推荐性能。基于神经网络的推荐:早期先驱工作

《Restricted boltzmann machines for collaborative filtering》提出了一种两层受限玻尔兹曼机(Restricted Boltzmann Machine: RBM)来建模用户对item的显式评分。《Ordinal boltzmann machines for collaborative filtering》扩展了该工作从而对评分的保序性质(ordinal nature)进行建模。最近,自编码器已经成为构建推荐系统的流行选择。

《Autorec: Autoencoders meet collaborative filtering》提出了基于用户的AutoRec,其思想是学习隐藏的结构(hidden structure),这些结构可以根据用户的历史评分作为输入从而重构用户的评分。在用户个性化方面,该方法与item-item模型(将用户表示为他/她的历史评分item)具有相似的精神。为了避免自编码器学习恒等函数(

identity function)从而无法泛化到未见(unseen)的数据,降噪自编码器(denoising autoencoder: DAE)应用于从故意损坏的输入中学习。最近

《A neural autoregressive approach to collaborative filtering》提出了一种用于CF的神经自回归方法。虽然这些工作为神经网络解决

CF的有效性提供了支持,但是其中大多数都专注于显式评分,并仅对观察到的数据进行建模。结果,对于从只有正样本的隐式数据中学习的任务,它们很容易失败。神经网络用于隐式反馈的推荐:最近的一些工作探索了基于隐式反馈的深度学习模型来进行推荐,但是他们主要使用

DNN对辅助信息进行建模,例如item的文本描述、音乐的声学特征、用户的跨域行为、以及知识库中的丰富信息。然后,将DNN学到的特征与用于协同过滤的MF集成。与我们的工作最相关的工作是

《Collaborative denoising auto-encoders for top-n recommender systems》,它为CF提供了一个带有隐式反馈的协同降噪自编码器(collaborative denoising autoencoder: CDAE)。 和DAE-based CF相比,CDAE额外地将一个用户节点插入到自编码器的输入中从而重建用户的评分。如作者所示,当应用恒等映射作为CDAE的隐层激活函数时,CDAE等效于SVD++模型。这意味着虽然CDAE是一种用于CF的神经网络建模方法,但是它仍然应用线性核(linear kernel)(即内积)来对user-item交互进行建模。这可以部分解释为什么CDAE使用更深的层不会提高性能。与

CDAE不同,我们的NCF采用双路架构,使用多层前馈神经网络对user-item交互进行建模。这允许NCF从数据中学习任意函数,比固定的内积函数更强大、更具表达能力。其它工作:沿着类似的路线,在知识图谱文献中已经深入研究了学习两个实体之间的关系。已有很多关系型机器学习(

relational machine learning method)方法被提出。与我们的方法最相似的一个是神经张量网(Neural Tensor Network: NTN),它使用神经网络来学习两个实体的交互并展示层强大的性能。在这里,我们关注协同过滤的不同problem setting。虽然将MF和MLP相结合的NeuMF的思想部分受到NTN的启发,但是在允许MF和MLP学习不同的embedding集合方面,我们的NeuMF比NTN更灵活、更通用。最近,谷歌公布了他们用于

App推荐的Wide & Deep方法。Deep组件同样在特征embedding之上使用MLP,据报道它具有很强的泛化能力。虽然他们的工作重点是结合用户和item的各种特征,但是我们的目标是探索纯协同过滤系统的DNN。我们表明,DNN是对user-item交互建模的一个很有前景的选择。据我们所知,以前从未有工作对此进行研究过。

1.1 模型

1.1.1 基本概念

我们首先将问题形式化并讨论现有的带隐式反馈的协同过滤解决方案。然后我们简短地概括了广泛使用的

MF模型,并强调其内积造成的局限性。从隐式数据中学习(

Learning from Implicit Data):令item数量。定义从用户隐式反馈(implicit feedback)得到的user-item交互矩阵注意:

itemitemitemitemitem

这给从隐式数据中学习带来了挑战,因为隐式数据仅提供了关于用户偏好(

users' preference)的带噪音的信号(noisy signals)。虽然观察到的item至少反映了用户对item的兴趣,但是未观察到的item可能只是缺失的数据(missing data),并且天然(natural)缺乏负反馈(negative feedback)。带隐式反馈的推荐问题被表述为估计

item的得分(score)的问题,其中这些score用于对item进行排序。model-based方法假设数据可以由底层模型生成(或描述)。形式上, 模型可以抽象为学习:其中:

predicted score。interaction function)。

为了估计参数

point-wise loss和pair-wise loss。作为显式反馈(

explicit feedback)大量工作的自然延伸,point-wise loss通常定义为最小化negative data的缺失,他们要么将所有未观察到的item视为负样本、要么从未观察到的item中采样负样本。pair-wise loss的思想是:观察到的item应该比未观察到的item的排名更高。因此,它不是最小化pair-wise learning最大化观察到的itemitemmargin)。

更进一步地,我们的

NCF框架使用神经网络参数化交互函数NCF自然支持point-wise learning和pair-wise learning。矩阵分解(

Matrix Factorization: MF):MF将每个用户、每个item都和潜在特征向量(latent feature vector)相关联。令MF估计(estimate)交互其中

latent space)的维度。正如我们所看到的,

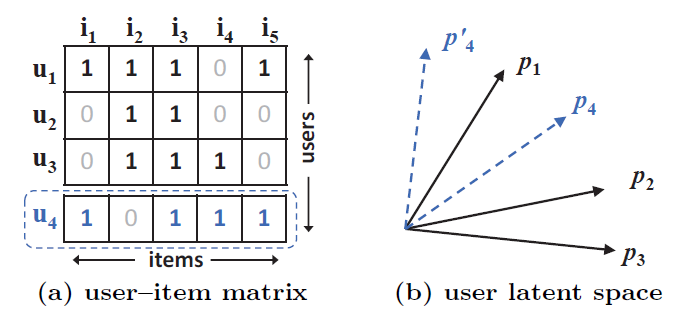

MF对用户潜在因子(latent factor)和item潜在因子的双向交互(two-way interaction)进行建模,假设潜在空间的每个维度彼此独立,并以相同的权重线性组合它们。因此,MF可以视为潜在因子的线性模型。下图说明了内积函数如何限制

MF的表达能力。为了更好地理解示例,有两个设置(settings)需要事先说明。首先,因为

MF将用户和item都映射到相同的潜在空间,所以两个用户之间的相似性也可以用内积来衡量(或者它们潜在向量之间的余弦相似度来衡量)。其次,不失一般性,我们使用

Jaccard系数(用户A观察到的item集合与用户B观察到的item集合之间的Jaccard系数)作为MF需要恢复的、两个用户之间的真实相似度(ground-truth similarity)。

我们首先关注图

(a)中的前三行(用户)。很容易有(b)所示绘制。现在,让我们考虑一个新的用户

(a)中的虚线所示。所以我们有MF模型将(b)中用虚线显示的两个选择),则会导致ranking loss)。这个例子显示了

MF使用简单的、且固定的内积来估计低维潜在空间中复杂的user-item交互的限制。在这个例子中,我们注意到解决该问题的一种方法是使用更大的潜在因子数量

在本文中,我们通过从数据中使用

DNN学习交互函数来解决MF的这个限制。我们首先介绍了通用的

NCF框架,详细说明了如何学习NCF的概率模型,该模型强调了隐式数据的二元属性(binary property)。然后我们证明了

MF可以在NCF下表达和推广。为了探索用于协同过滤的

DNN,我们接着提出NCF的实例化,使用多层感知机(multi-layer perceptron: MLP)来学习user-item交互函数。最后,我们提出了一个新的神经矩阵分解模型,它在

NCF框架下集成了MF和MLP,从而统一了MF的线性和MLP的优势来建模user-item潜在结构(latent structures)。

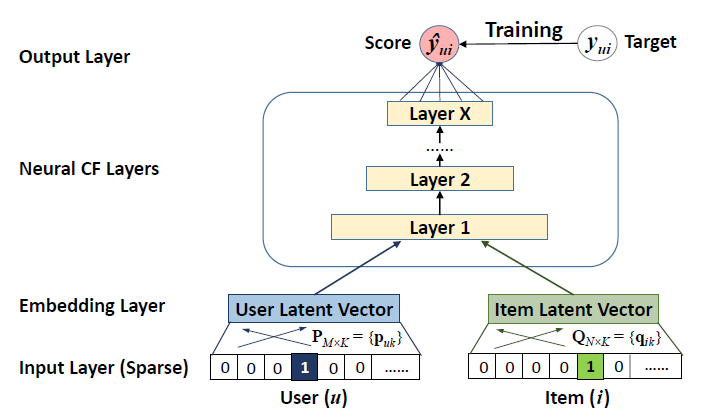

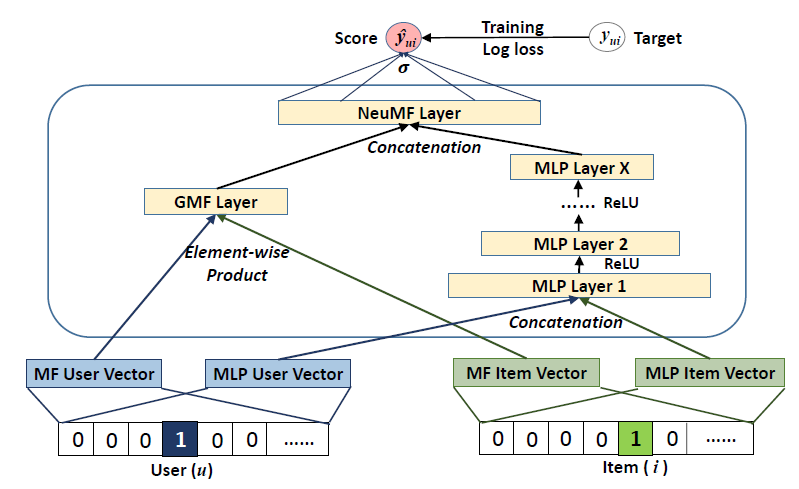

1.1.2 NCF 通用框架

为了允许全(

full)神经网络来处理协同过滤, 我们采用multi-layer representation来建模user-item交互底部输入层由两个特征向量

item输入特征向量可以自定义(

customized)从而支持广泛的用户建模和item建模,例如上下文感知(context-aware)建模、content-based建模、neighbor-based建模。由于这项工作聚焦于纯粹(pure)的协同过滤设置(setting),我们仅采用user id和item id作为输入特征,并将其转换为稀疏的one-hot向量。基于输入的这种通用特征表示(

generic feature representation),我们的方法可以通过使用内容特征来表示用户和item,从而轻松地解决冷启动问题(cold-start problem)。输入层之上是

embedding层,它是一个全连接层,将稀疏表示(sparse representation)投影到稠密向量(dense vector)。得到的user embedding(item embedding)可以视为潜在因子模型背景下的用户潜在向量(item潜在向量)。然后,用户

embedding和item embedding被馈入多层神经架构,我们称之为神经协同过滤层(neural collaborative filtering layers),从而将潜在向量映射为预估分。神经

CF层的每一层都可以自定义,从而发现user-item交互的某些潜在结构。最后一个隐层X的维度决定了模型的能力。最终的输出层是预估分

point-wise loss来进行训练。我们注意到训练模型的另一种方法是执行

pair-wise learning,例如使用Bayesian Personalized Ranking和margin-based loss。由于本文的重点是神经网络建模部分,我们将扩展NCF的pair-wise learning作为未来的工作。

我们形式化

NCF预测模型为:其中:

item的潜在因子矩阵(latent factor matrix)。

由于交互函数

其中

为了学习模型参数,现有的

point-wise方法主要使用平方损失进行回归:其中:

user-item权重高于未观察到交互的user-item。这里

虽然平方损失可以通过假设观测值(

observations)由高斯分布产生来解释,但是我们指出这可能与隐式数据不符。这是因为对于隐式数据,目标值1或者0,表示用户itempoint-wise NCF的概率方法,该方法特别关注隐式数据的二元属性(binary property)。考虑到隐式反馈的

one-class特性,我们可以将label:1表示item0表示itemitemNCF这样的概率解释,我们需要将输出[0.0, 1.0]之间。这可以通过使用概率函数(例如Logistic或Probit函数)作为输出层setting,我们将似然函数定义为:使用负的对数似然,我们得到:

这是

NCF方法需要最小化的目标函数,其优化可以通过执行随机梯度下降(stochastic gradient descent: SGD)来完成。细心的读者可能已经意识到它与二元交叉熵损失(binary cross-entropy loss)(也称作对数损失log loss)相同。通过对

NCF进行概率处理,我们将带有隐式反馈的推荐作为二元分类问题来解决。由于分类感知(classification-aware)的log loss在推荐文献中很少被研究,我们在这项工作中对其进行了探索,并在实验中证明了其有效性。对于负样本集合

sampling ratio)(这个比例是相对于观察到的交互数量)。虽然非均匀采样策略(例如,item popularity-biased)可能会进一步提高性能,但是我们将这个探索留作未来的工作。

1.1.3 广义矩阵分解 GMF

我们现在展示如何把

MF解释为我们NCF框架的一个特例。由于MF是最流行的推荐模型,并在文献中进行了广泛的研究,因此能够复原MF使得NCF可以模拟一大族因子分解模型。由于

NCF输入层的user ID(或者item ID)是one-hot编码,因此得到的embedding向量可以视为user(或者item)的隐向量。令用户item其中

然后我们将结果向量投影到输出层:

其中

直观地讲,如果我们选择

1的向量,那么我们就可以准确地复原MF模型。在

NCF框架下,MF可以很容易地推广和扩展。例如:如果我们允许

MF的一个变体,这个变体允许MF模型学习各潜在维度的不同重要性。如果我们对

MF的一个变体,这个变体是一个非线性模型,并且可能比线性MF模型更具有表达能力。在这项工作中,我们在

NCF框架下实现了一个广义版本的MF,它使用sigmoid函数作为我们称这个模型为广义矩阵分解(

Generalized Matrix Factorization: GMF)。

1.1.4 多层感知机

由于

NCF使用两路分别对用户和item进行建模,因此通过将这两路特征拼接起来从而组合它们的特征是很直观的。这种设计已经在多模态(multimodal)深度学习工作中广泛采用。 然而,简单的向量拼接并没有考虑用户潜在特征和item潜在特征之间的任何交互,这不足以建模协同过滤效果。为了解决这个问题,我们提出在拼接向量上添加隐层,使用标准MLP来学习用户潜在特征和item潜在特征之间的交互。从这个意义上讲,我们可以赋予模型很大程度的灵活性和非线性从而学习GMF那样只使用一个固定的逐元素乘积。具体而言,我们的

NCF框架下的MLP模型定义为:其中

对于

MLP层的激活函数,可以自由选择sigmoid、tanh、ReLU等。sigmoid函数将每个神经元限制在(0.0,1.0)之间,这可能会限制模型的性能。众所周知,sigmoid受到饱和(saturation)的影响:当神经元的输出接近0或1时,神经元就会停止学习。尽管

tanh是更好的选择并且已经被广泛采用,但是它只能一定程度上缓解sigmoid的问题。因为tanh可以视作sigmoid的rescale版本:最终我们选择

ReLU,它在生物学上更合理,并且被证明是非饱和(non-saturated)的。此外,它鼓励稀疏激活(sparse activations)(即大多数神经元是非激活的) ,非常适合稀疏数据并使得模型不太可能过拟合。我们的实验结果表明:ReLU的性能略优于tanh,而tanh又明显优于sigmoid。

对于网络结构的设计,最常见的解决方案是采用塔式模式(

tower pattern),其中底层最宽、接下来每一层的神经元数量依次减少。基本假设是:对更高层使用更少的隐单元,使得更高层能够学习数据的更抽象的特征。我们根据经验实现了塔式结果,将每个连续层的神经元数量减半。

1.1.5 融合 GMF 和 MLP

到目前为止,我们已经开发了

NCF的两个实例:GMF应用一个linear kernel来建模潜在特征交互。MLP使用一个non-linear kernel来从数据中学习非线性交互。

那么接下来的问题是:我们如何在

NCF框架下融合GMF和MLP,以便它们可以相互加强从而更好地建模复杂的user-item交互?一个简单的解决方案是:让

GMF和MLP共享相同的embedding层,然后组合(combine)它们交互函数的输出。这种方式与著名的神经张量网络(Neural Tensor Network: NTN)有着相似的精神。具体而言,将

GMF和one-layer MLP相结合的模型可以表述为:然而,共享

GMF和MLP的embedding可能会限制模型的性能。这意味着GMF和MLP使用相同大小的embedding。对于两个子模型最佳embedding大小差异很大的数据集,该解决方案可能无法获得最佳的集成(ensemble)。为了给融合模型(

fused model)提供更大的灵活性,我们允许GMF和MLP学习单独的embedding,并通过拼接它们最后一个隐层来组合这两个模型。下图给出了我们的方案,其公式如下:其中:

GMF和MLP部分的user embedding。GMF和MLP部分的item embedding。如前所述,我们使用

ReLU作为MLP layer的激活函数。

该模型结合了

MF的线性和DNN的非线性,从而对user-item潜在结构进行建模。我们将该模型称作神经矩阵分解(Neural Matrix Factorization: NeuMF)。模型相对于每个参数的导数可以用标准的反向传播来计算,由于空间限制这里省略了标准反向传播的描述。

NeuMF类似于DeepFM,它们相同点在于:都使用线性部分来直接捕获特征交互;都使用非线性DNN来捕获非线性交互;都通过拼接两部分来同时捕获线性和非线性交互。区别在于:

NeuMF的线性部分仅捕获user和item之间的二阶交互,而DeepFM捕获所有特征之间的二阶交互。但是这里NeuMF只有user id和item id特征,因此它们之间的二阶交互也意味着所有特征的二阶交互。NeuMF的两个组件独立使用embedding,而DeepFM使用共享的embedding。

预训练:由于

NeuMF目标函数的非凸性(non-convexity),基于梯度的优化方法只能找到局部最优解。据报道,初始化对深度学习模型的收敛和性能起着重要作用。由于NeuMF是GMF和MLP的集成(ensemble),我们提出使用GMF和MLP的预训练模型初始化NeuMF。我们首先使用随机初始化来训练

GMF和MLP,直到收敛。然后我们使用

GMF和MLP模型的参数作为NeuMF相应参数部分的初始化。唯一的调整是在输出层,我们将两个模型的权重拼接起来作为初始化:其中:

GMF模型和MLP模型的tradeoff的超参数。

为了从头开始训练

GMF和MLP,我们采用Adaptive Moment Estimation: Adam优化器,它通过对频繁参数(frequent parameters)执行较小的更新、对不频繁参数(infrequent parameters)执行较大的更新,从而调整每个参数的学习率。和普通SGD相比,Adam方法为两种模型都产生了更快的收敛速度,并缓解了调整学习率的痛苦。在将预训练参数输入

NeuMF之后,我们使用普通SGD而不是Adam进行优化。这是因为Adam需要保存动量信息(momentum information)以正确更新参数。由于我们仅使用预训练模型的参数来初始化NeuMF并放弃保存动量信息,因此不适合使用基于动量的方法进一步优化NeuMF。

1.2 实验

我们进行实验以回答以下三个问题:

RQ1:我们提出的NCF方法是否优于SOTA的隐式协同过滤方法?RQ2:我们提出的优化框架(带负采样的log loss)如何用于推荐任务?RQ3:更深层的网络是否有助于从user-item交互数据中学习?

接下来,我们首先介绍实验配置,然后回答上述三个问题。

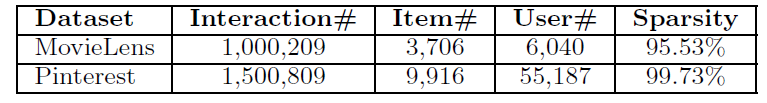

数据集:我们在两个公共数据集上进行实验。

MovieLens:一个电影评分数据集,该数据集已经被广泛用于评估协同过滤算法。我们使用包含100万个评分的版本,其中每个用户至少有20个评分。虽然它是一个显式反馈数据集,但是我们有意选择它来研究从显式反馈的隐式信号中学习的性能。为此,我们将其转换为隐式数据,其中每一项被标记为

0或1,表明用户是否对该item进行了评分。Pinterest:一个基于内容的图像推荐数据集。原始数据非常大,但是非常稀疏。例如超过20%的用户只有一个pin,这使得评估协同过滤算法变得困难。因此,我们以与MovieLens数据相同的方式过滤数据集,仅保留至少有20次交互的用户。结果我们得到一个包含55,187个用户、1,500,809个互动的子集。每个互动都表示用户是否将图片钉到用户的board上。

这些数据集的统计信息如下表所示。

Sparsity表示未观测到互动的user-item pair占比。

评估方式:为了评估

item推荐的性能,我们采用了广泛使用的leave-one-out评估。对于每个用户,我们将hold-out其最近的交互作为测试集,并使用剩余的数据进行训练。由于在评估过程中,每个用户对所有的

item进行排序太耗时,因此我们遵循了常见的策略:随机抽取100个用户未交互的item,然后在100个item中对测试item进行排序。ranked list的性能由Hit Ratio: HR和Normalized Discounted Cumulative Gain: NDCG来判断。在没有特别说明的情况下,我们将这两个指标的ranked list长度截断为10。因此:HR直观地衡量测试item是否出现在列表的top-10中。NDCG通过为排名靠前的hit分配更高的分数来说明hit的position。

我们为每个测试用户计算这两个指标并报告了平均得分。

baseline方法:我们将NCF方法(GMF/MLP/NeuMF)和以下方法进行比较:ItemPop:根据互动数量来判断item的流行度popularity从而对item进行排序。这是一种对推荐性能进行基准测试benchmark的非个性化方法。ItemKNN:这是标准的基于item的协同过滤方法。我们遵循《Collaborative filtering for implicit feedback datasets》的设置从而使其适应隐式数据。BRP:该方法使用pairwise ranking loss来优化MF模型,使得模型适合从隐式反馈中学习。这是一个极具竞争力的item推荐baseline。我们使用固定的学习率并报告最佳性能。eALS:这是item推荐的state-of-the-art MF方法。它优化了平方损失,将所有未观察到的交互视为负样本,并通过item流行度对它们进行非均匀加权。由于eALS显示出优于均匀加权方法WMF的性能,因此我们不会进一步报告WMF的性能。

由于我们提出的方法旨在对用户和

item之间的关系进行建模,因此我们主要与user-item模型进行比较。我们省略了与item-item模型的比较,如SLIM, CDAE,因为性能差异可能是由于使用个性化的用户模型引起的(因为SLIM, CDAE这些模型是item-item模型)。实验配置:

我们基于

Keras实现了我们的方法。为了确定

NCF方法的超参数,我们为每个用户随机抽取了一个交互作为验证集,并在其上调优了超参数。我们测试了

batch size为[128, 256, 512, 1024]、learning rate为[0.0001, 0.0005, 0.001, 0.005]。所有

NCF模型都是通过优化log loss来学习的,其中我们为每个正样本采样了四个负样本。对于从头开始训练的

NCF模型,我们使用高斯分布(均值为0、标准差为0.01)来随机初始化模型参数,并使用mini-batch的Adam优化器来优化模型。由于

NCF的最后一个隐层决定了模型的能力(因为NCF的隐层维度采用逐层减半的策略),我们将其称为预测因子(predictive factors),并评估了维度为[8, 16, 32, 64]。值得注意的是,维度较高的预测因子可能会导致过拟合并降低性能。

如果没有特别说明,那么我们为

MLP使用三层的隐层。例如,如果预测因子维度为8,那么神经CF层的架构为32 -> 16 -> 8,embedding size为16。对于预训练的

NeuMF,GMF和MLP对NeuMF的初始化做出同等的贡献。

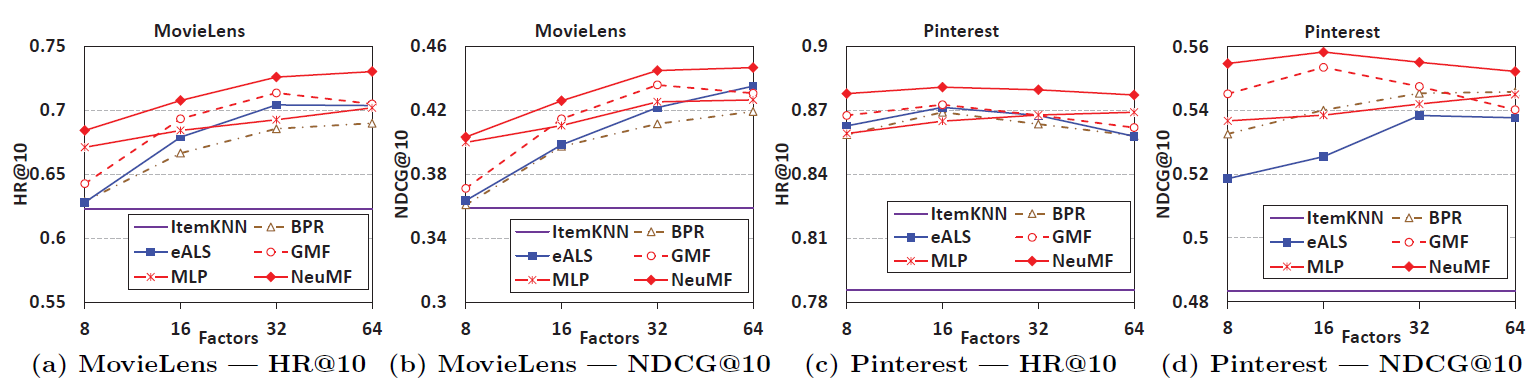

1.2.1 RQ1 性能比较

下图显示了

HR@10和NDCG@10在不同预测因子维度方面的性能。对于

MF方法BPR和eALS,预测因子的维度等于潜在因子的维度。对于ItemKNN,我们测试了不同邻域大小并报告了最佳性能。由于ItemPop性能较弱,因此下图中省略了ItemPop从而更好地突出个性化方法的性能差异。首先,我们可以看到

NeuMF在两个数据集上都实现了最佳性能,明显优于state-of-the-art的eALS和BPR(平均而言,相对于eALS和BPR的提升为4.5%和4.9%)。对于

Pinterest数据集,NeuMF使用8维预测因子也大大超越了64维预测因子的eALS和BPR。这表明NeuMF通过融合线性MF和非线性MLP模型从而具有高的表达能力。其次,另外两种

NCF方法(GMF和MLP)也表现出相当强劲的性能。在它们之间,MLP的表现略差于GMF。注意,可以通过添加更多隐层来进一步提升MLP的性能(参考下面的实验),这里我们仅展示三层隐层的MLP性能。对于小的预测因子维度,

GMF在两个数据集上均优于eALS。尽管GMF在大的预测因子为维度上过拟合,但是它的最佳性能优于eALS或者与eALS相当。GMF使用自动学习的加权权重,而eALS根据item流行度来加权。最后,

GMF显示出对BPR的持续改进,表明分类感知(classification-aware)的log loss对推荐任务的有效性。因为GMF和BPR是学习相同的MF模型、但是具有不同的目标函数。

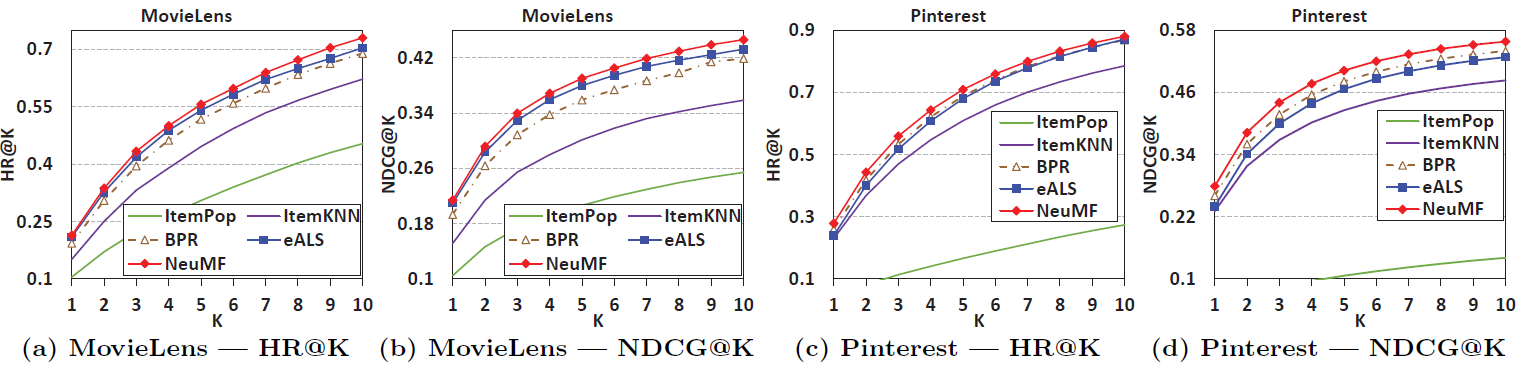

下图显示了

Top-K推荐列表的性能,其中排序位置K的范围从1 ~ 10。为了使图更加清晰,我们展示了NeuMF的性能,而不是所有三种NCF方法。可以看到:和其它方法相比,

NeuMF在不同位置上表现出一致的提升。我们进一步进行了one-sample paired的t检验,验证所有提升对于在所有的

baseline方法中,eALS在MovieLens上的性能优于BPR(相对提升约5.1%),而在Pinterest方面的性能低于BPR。这与《Fast matrix factorization for online recommendation with implicit feedback》的发现一致,即BPR由于其pairwise ranking-aware learner而可以成为强大的排序器。基于邻域的

ItemKNN表现不如基于模型的方法。Item Pop表现最差,说明有必要对用户的个性化偏好进行建模,而不是仅仅向用户推荐热门item。

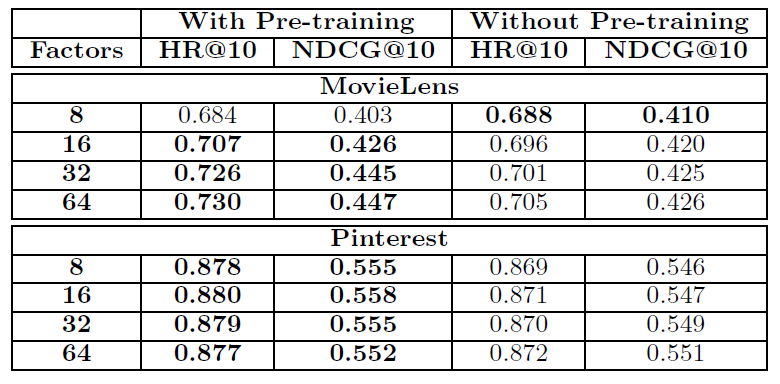

预训练的效用(

utility):为了证明预训练对NeuMF的效用,我们比较了两个版本的NeuMF的性能--有预训练、没有预训练。对于没有预训练的NeuMF,我们使用Adam通过随机初始化来学习。结果如下表所示。可以看到:

经过预训练的

NeuMF在大多数情况下取得了更好的性能,仅在预测因子维度为8的MovieLens时预训练方法的性能稍差。在

MovieLens和Pinterest数据集上,使用预训练的NeuMF的相对提升分别为2.2%和1.1%。这一结果证明了我们预训练方法对初始化NeuMF的有效性。

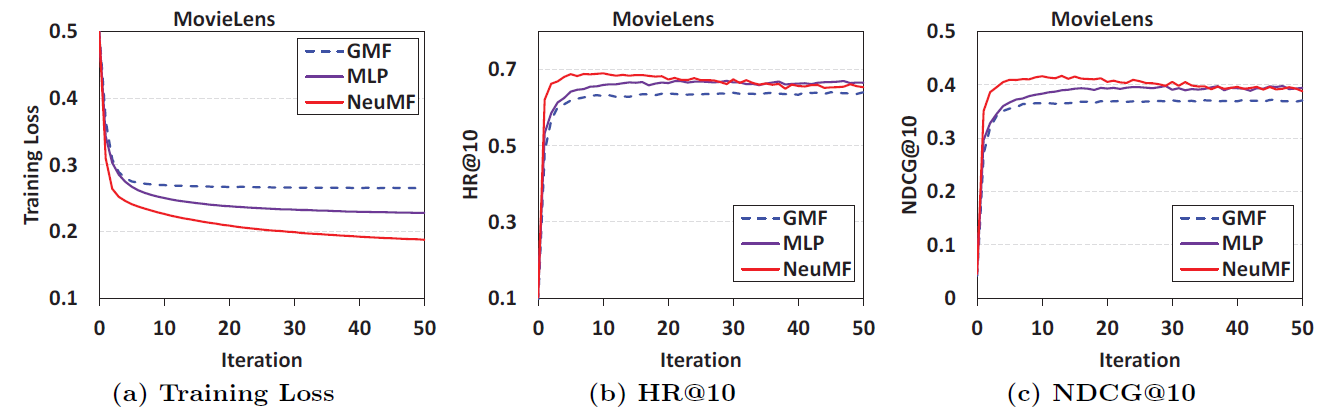

1.2.2 RQ2 负采样的 Log Loss

为了处理隐式反馈的

one-class性质,我们将推荐转换为二元分类任务。通过将NCF视为概率模型,我们使用log loss对其进行了优化。下图显示了在

MovieLens上NCF方法每次迭代的训练损失(所有训练样本的均值)和推荐性能,其中预测因子维度为8。Pinterest上的结果也显示了相同的趋势,由于篇幅所限,这里没有给出Pinterest上的结果。首先,可以看到随着迭代次数的增加,

NCF模型的训练损失逐渐减少,推荐性能得到提升。最有效的更新发生在前

10次迭代中,更多的迭代可能会使模型发生过拟合(例如,尽管NeuMF的训练损失在10次迭代之后不断减少,但是推荐性能实际上会下降)。其次,在三种

NCF方法中,NeuMF的训练损失最低、其次是MLP、最次是GMF。推荐性能也呈现同样的趋势,即NeuMF > MLP > GMF。

上述发现为优化

log loss以从隐式数据中学习的合理性(rationality)和有效性(effectiveness)提供了经验证据。

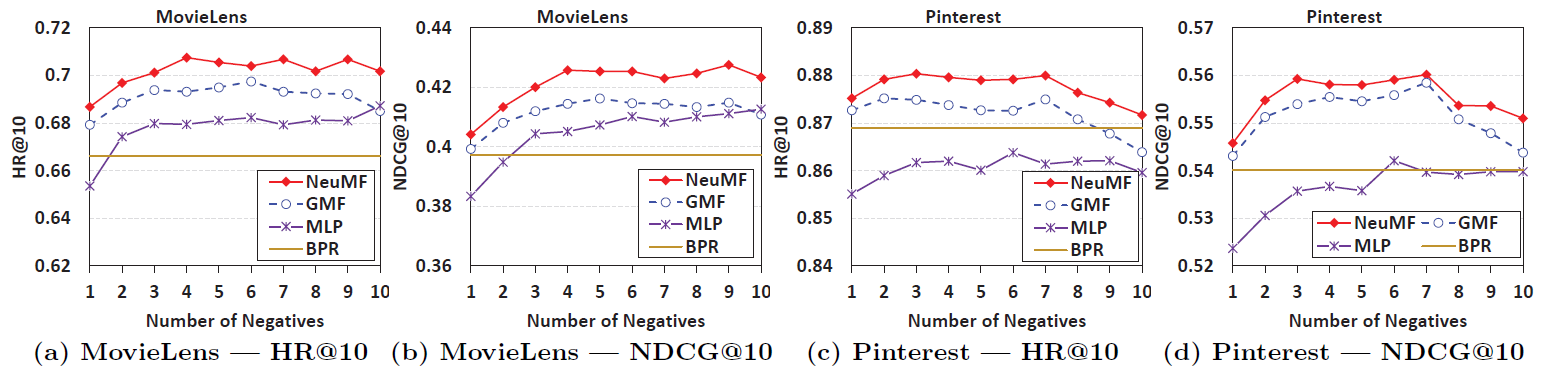

pointwise log loss相对于pairwise目标函数的一个优势是负样本的灵活采样比例。虽然pairwise目标函数只能将一个采样的负样本和一个正样本配对,但是在pointwise log loss中我们可以灵活控制采样比例。为了说明负采样比例对

NCF方法的影响,我们在下图中展示了NCF方法在不同负采样比例下的性能。其中预测因子维度为16。注意:BPR对于每个正样本采样一个负样本从而构成pair对,因此它的表现是一条直线。可以看到:

在

NCF中,每个正样本仅一个负样本不足以实现最佳性能,采样更多的负样本是有利的。将

GMF和BPR进行比较,我们可以看到:采样比例为1的GMF的性能与BPR相当,而较大采样比例的GMF的性能明显优于BPR。这显示了pointwise log loss相对于pairwise BPR loss的优势。在这两个数据集上,最佳采样比例约为

3 ~ 6。在Pinterest数据集上,我们发现采样比例大于7时,NCF方法的性能开始下降。这表明:过于激进地设置采样比例可能会对性能产生不利影响。

1.2.3 RQ3 网络深度

由于用神经网络学习

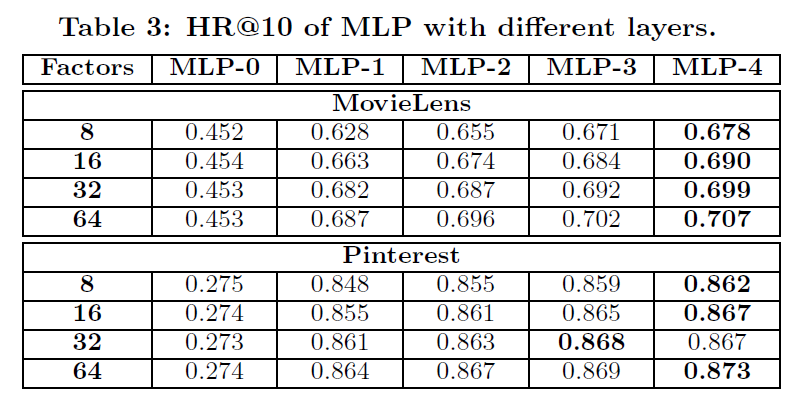

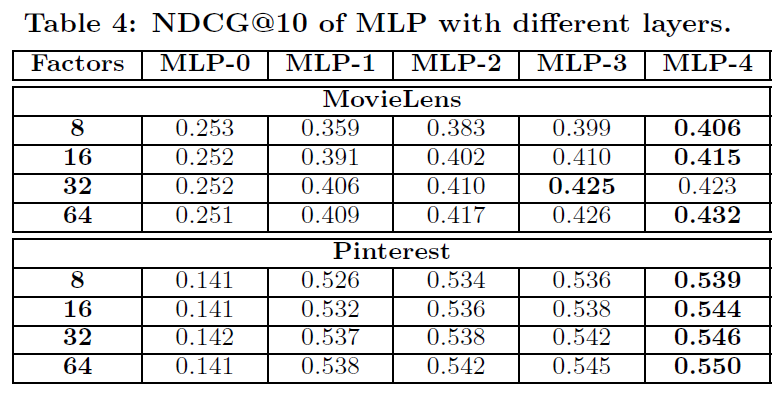

user-item交互函数的工作很少,所以很好奇使用深层的网络结构是否有利于推荐任务。为此,我们进一步研究了具有不同隐层数量的MLP,结果总结在下表中。MLP-3表示具有三层隐层(除了embedding层和输出层)的MLP方法,其它符号类似。可以看到:即使对于具有相同能力的模型,堆叠更多的层也有利于性能。这一结果非常令人振奋,表明使用深层模型进行协同推荐的有效性。

我们将性能提升归因于堆叠更多非线性层带来的高度非线性。为了验证这一点,我们进一步尝试堆叠线性层,使用恒等映射作为激活函数,结果其性能比使用

ReLU非线性激活函数差得多。对于没有隐层的

MLP-0(即embedding层直接投影到预测),性能非常弱,并不比非个性化的Item-Pop好。这验证了我们前面的论点:即简单地拼接用户潜在向量和item潜在向量,不足以对特征交互进行建模,因此需要用隐层来进行转换。