一、SR-GNN [2019]

《Session-Based Recommendation with Graph Neural Networks》

随着互联网上信息数量的快速增长,在许多互联网应用中(如搜索、电商、流媒体网站),推荐系统成为帮助用户缓解信息过载问题并选择有趣信息的基础。大多数现有的推荐系统都假设

user profile和历史行为都被持续地记录。然而,在许多服务中,user id可能是未知的,并且只有正在进行的session期间的用户行为历史可用。因此,建模在一个session中有限的行为并生成推荐是非常重要的。相反,在这种情况下,依赖于充足的user-item交互的传统推荐方法无法实现很好的推荐。这里的

user profile指的是用户历史行为记录,而不是指的是年龄性别等用户画像。由于具备很高的实用价值,人们对这个问题的研究兴趣越来越大,并且已经开发了多种

session-based的推荐方法。基于马尔科夫链,一些工作根据前一个行为来预测用户的next action。在强独立性假设下,历史行为的独立组合(independent combination)限制了预测准确性。近年来,大多数研究将

Recurrent Neural Network: RNN应用于session-based的推荐系统,并获得了有前景的结果。《Session-based recommendations with recurrent neural networks》首先提出了一种RNN方法,然后通过数据增强和考虑用户行为的时间漂移(temporal shift)来增强模型。最近,

NARM设计了一个全局RNN和局部RNN推荐器,来同时捕获用户的序列行为(sequential behavior)和主要意图(main purpose)。类似于

NARM,STAMP也通过使用简单的MLP网络和注意力网络来捕获用户的通用兴趣(general interest)和当前兴趣(current interest)。

尽管上述方法取得了令人满意的结果并成为

SOTA的技术,但是它们仍然存在一些局限性。首先,如果在一个

session中没有足够的用户行为,那么这些方法难以估计user representation。通常,这些

RNN方法的hidden vector被视为user representation,然后可以基于这些representation来生成推荐,例如,NARM的全局推荐器。然而,在session-based的推荐系统中,session大多是匿名的而且数量非常多,并且session点击中涉及的用户行为通常是有限的。因此很难从每个session中准确估计每个用户的representation。其次,之前的工作表明(

NARM和STAMP),item transition的模式很重要,可以用作session-based推荐中的局部因子,但是这些方法总是建模连续item之间的单向转移(singleway transition),而忽略了上下文之间的转移,即session中的其它item。因此,这些方法经常忽略远距离item之间的复杂转移。RNN网络仅建模单向转移,而attention机制建模全局相关性而忽略了item之间的关系。

为了克服上述限制,论文

《Session-Based Recommendation with Graph Neural Networks》提出了一种新的Session-based Recommendation with Graph Neural Network: SR-GNN方法,从而探索item之间的丰富转移并生成准确的item潜在向量。Graph Neural Network: GNN被设计用于生成图的representation。最近,

GNN被广泛用于为natural language processing: NLP和computer vision: CV的应用构建图结构依赖关系,如脚本事件(script event)预测、情景识别(situation recognition)、图像分类。对于

session-based推荐,论文首先从历史session序列构建有向图。基于session graph,GNN能够捕获item的转移并相应地生成准确的item embedding向量,这是传统的序列方法(如MC-based方法和RNN-based方法)所难以揭示的。基于准确的item embedding向量,SR-GNN构造了可靠的session representation,并可以推断出next-click item。SR-GNN的核心在于item embedding的生成。传统的session-based推荐方法中,item embedding是自由变量并随机初始化。在SR-GNN推荐方法中,item embedding是根据GNN计算得到的,因此包含了item之间的转移关系。能否仅仅依赖于

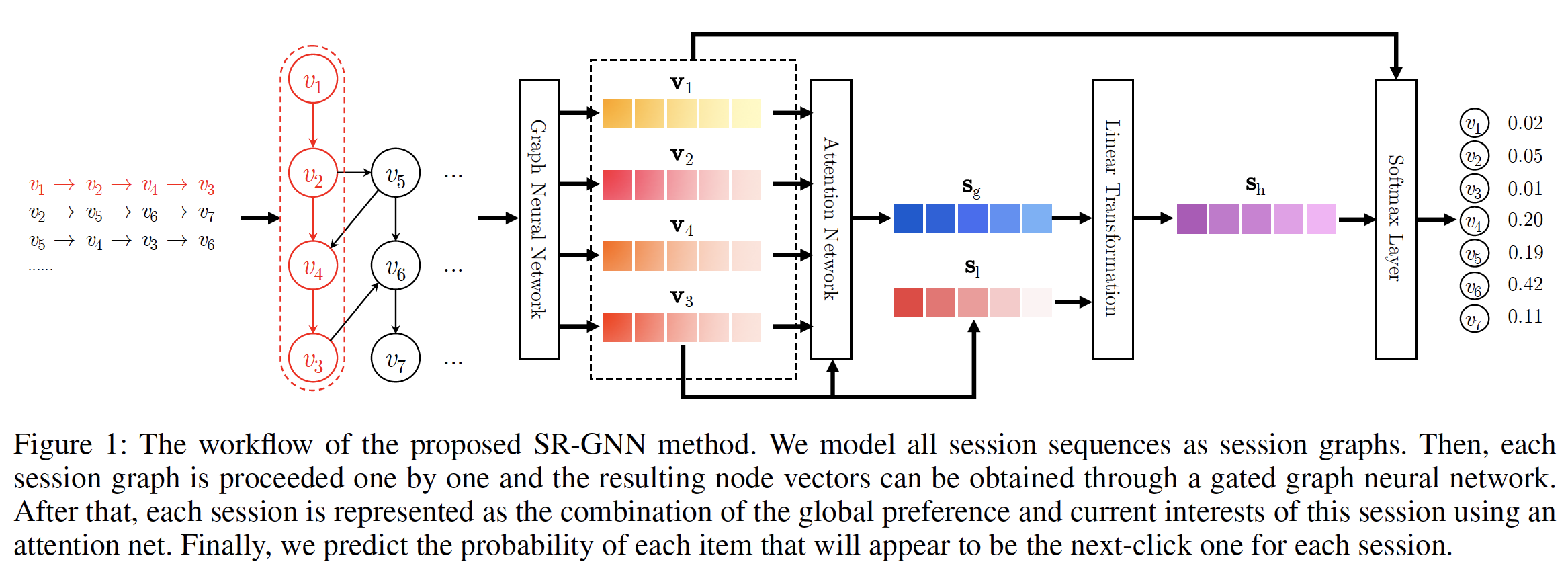

GNN来建模session-based推荐?读者认为是不可行的。因为GNN无法建模序列信息,而序列信息(尤其是last click item)对于session-based推荐至关重要。下图说明了所提出的

SR-GNN方法的工作流程。首先,所有

session序列都被建模为有向的session graph,其中每个session序列都可以视为一个子图。也可以将所有

session序列建模为一张大的图,而不是每个session一个session graph。但是论文在实验部分对比了这两种方式的效果,实验表明:每个session一个session graph的效果更好。因为前者(建模为一张大图)会显著影响当前session的完整性。然后,每个

session graph依次被处理,并且可以通过gated graph neural network: GGNN来获得每个子图中涉及的所有节点的潜在向量。之后,我们将每个

session表达为该session中该用户的全局偏好(global preference)和当前兴趣 (current interest)的组合,其中这些全局session embedding向量和局部session embedding向量都由节点的潜在向量组成。session embedding的计算方式类似于STAMP,其中全局session embedding向量通过注意力机制计算得到,局部session embedding向量就是last click item的embedding向量。最后,对于每个

session,我们预测每个item成为next click的概率。

论文在真实世界的代表性数据集上进行了大量实验,实验结果证明了所提出方法的有效性并达到了

SOTA。论文主要贡献总结如下:

论文将独立的

session序列建模为图结构化数据,并使用GNN来捕获复杂的item transistion。据作者所知,该方法提出了在session-based推荐场景中建模的新视角。为了生成

session-based推荐,论文不依赖于user representation而是使用session representation,它可以仅基于每个单一session中涉及的item的潜在向量来获得。在真实世界数据集上进行的大量实验表明,

SR-GNN显著优于SOTA的方法。

相关工作:这里我们回顾了

session-based推荐系统的一些相关工作,包括:传统方法、基于马尔科夫链的序列方法、RNN-based方法。然后我们介绍了图上的神经网络。传统的推荐方法:

矩阵分解是推荐系统的一种通用方法。矩阵分解的基本目标是将

user-item评分矩阵分解为两个低秩矩阵,每个矩阵代表用户潜在因子或item潜在因子。它不太适合session-based推荐,因为用户偏好仅由一些positive点击来提供。item-based邻域方法是一种自然的解决方案,其中item相似性是根据同一session中的item co-occurrence来计算的。这些方法难以考虑item的顺序,并且仅基于the last click来生成预测。然后人们提出了基于马尔科夫链的序列推荐方法,该方法根据用户的前一个行为来预测

next action。《An mdp-based recommender system》将推荐生成视为序列优化问题,并采用马尔科夫决策过程(Markov decision process: MDP)来解决该问题。通过对用户的个性化概率转移矩阵进行分解,

FPMC对每两次相邻点击之间的序列行为进行建模,并为每个序列提供更准确的预测。

然而,基于马尔科夫链的模型的主要缺点是:它们独立地组合了历史行为(

combine past components independently)。这种独立性假设太强,从而限制了预测的准确性。

基于深度学习的方法:最近,一些基于神经网络的预测模型,尤其是

language model被人们提出。在众多language model中,recurrent neural network: RNN在句子建模方面是最成功的模型,并且已被广泛应用于各种自然语言处理任务,例如机器翻译、对话机器人(conversation machine)、图像字幕生成(image caption)。RNN也成功应用于许多application,例如序列点击预测、位置预测(location prediction)、以及next basket推荐。对于

session-based推荐,《Session-based recommendations with recurrent neural networks》提出了RNN的方法,然后《Parallel recurrent neural network architectures for feature-rich session-based recommendations》扩展到具有并行RNN的架构,该架构可以根据被点击的item及其特征来建模session。此后,人们基于这些RNN方法提出了一些工作。《Improved recurrent neural networks for session-based recommendations》通过使用适当的数据增强技术并考虑用户行为的时间漂移(temporal shift)来提高RNN模型的性能。《When recurrent neural networks meet the neighborhood for session-based recommendation》将RNN方法和neighborhood-based方法结合起来,从而混合序列模式和共现信号(co-occurrence signal)。《3d convolutional networks for session-based recommendation with content features》将session点击与item描述和item类别等内容特征相结合,通过使用三维卷积神经网络生成推荐。此外,

《Session-aware information embedding for e-commerce product recommendation》通过list-wise的深度神经网络来建模每个session内的有限用户行为,并使用一个list-wise的ranking model来为每个session生成推荐。此外,具有一个

encoder-decoder架构的神经注意力推荐机(neural attentive recommendation machine: NARM) 采用RNN上的注意力机制来捕获用户的序列行为特征和主要意图。然后,

《Stamp:Short-term attention/memory priority model for session-based recommendation》提出了一种使用简单MLP网络和注意力网络的short-term attention priority model,即STAMP,从而有效地捕获用户的通用兴趣和当前兴趣。

图上的神经网络:如今,神经网络已被用于生成图结构化数据(如社交网络、知识图谱)的

representation。扩展自

word2vec的无监督算法DeepWalk旨在基于随机游走来学习图节点的representation。继DeepWalk之后,无监督网络嵌入算法LINE和node2vec是最具代表性的方法。另一方面,经典的神经网络

CNN和RNN也部署在图结构数据上。《Convolutional networks on graphs for learning molecular fingerprints》引入了一个卷积神经网络,它直接对任意大小和形状的图进行操作。《Semi-supervised classification with graph convolutional networks》是一种可扩展的方法,通过谱图卷积的局部近似来选择卷积架构。它是一种有效的变体,也可以直接对图进行操作。

但是,这些方法仅能在无向图上实现。

先前,人们提出了

《The graph neural network model》来操作有向图。作为GNN的修改,《Gatedgraph sequence neural networks》提出了gated GNN来使用GRU并采用back-propagation through time: BPTT来计算梯度。最近,

GNN被广泛应用于不同的任务,例如脚本事件预测、情景识别、图像分类。

1.1 模型

在这里我们介绍了所提出的

SR-GNN,它将图神经网络应用于session-based的推荐。我们首先形式化问题,然后解释如何从session构建图,最后描述SR-GNN方法。形式化问题:

session-based推荐旨在预测用户接下来会点击哪个item,仅仅基于用户当前的序列session数据,而无需访问用户的长期历史行为数据。这里我们给出该问题的形式化(formulation)如下。在

session-based的推荐中,令session中涉及的所有unique item组成的集合。一个匿名session序列sessionitem。session-based推荐的目标是预测next click,即针对sessionsequence label在

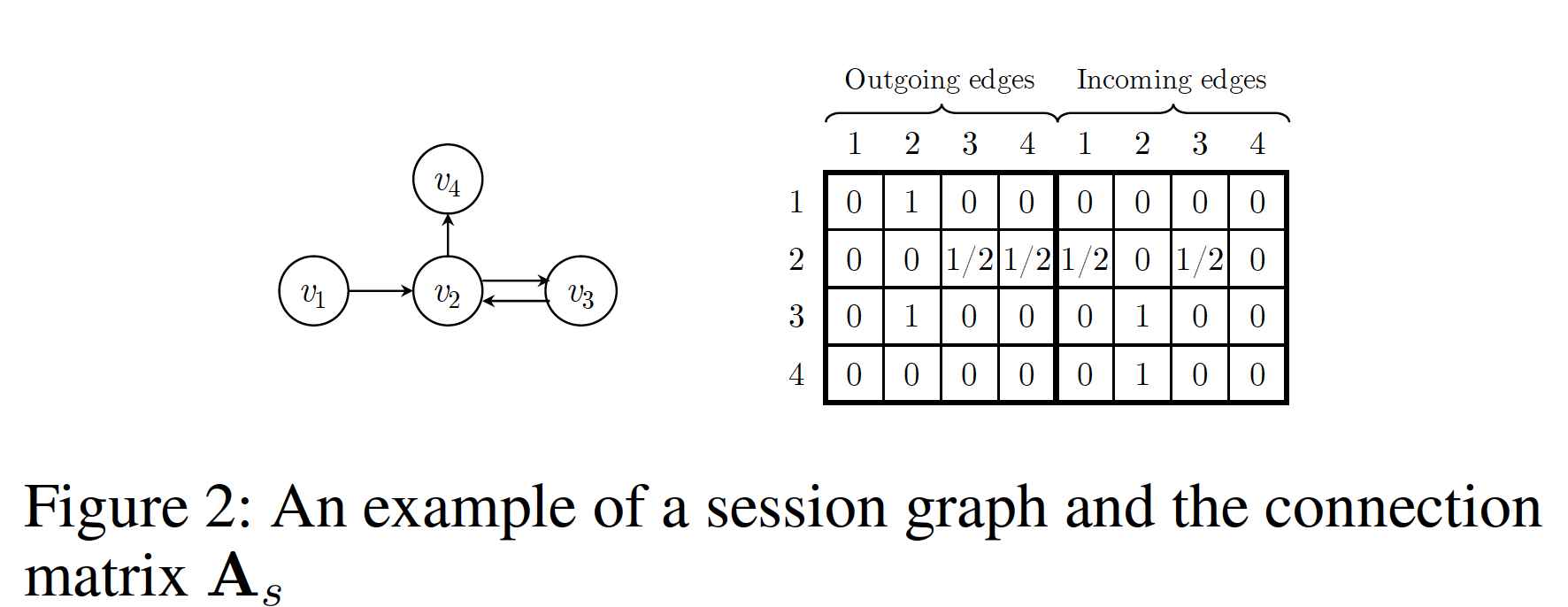

session-based的推荐模型下,对于sessionitem的概率item的推荐分。top-K取值的item就是被推荐的候选item。构建

session graph:每个session序列session graph中,每个节点代表一个itemsessionitemitem由于序列中可能重复出现多个

item,我们为每条边分配一个归一化的权重,权重的计算方法是:边的出现次数除以该边的起始节点的出度(out degree)。我们将每个

itemembedding空间中,节点向量GNN学到的itemsessionembedding向量

1.1.1 学习 Item Embedding

然后我们介绍了如何通过

GNN获得节点的潜在向量。普通的GNN由《The graph neural network model》提出,它扩展了神经网络方法从而用于处理图结构数据。《Gated graph sequence neural networks》进一步引入门控循环单元(gated recurrent unit)并提出gated GNN。GNN非常适合session-based的推荐,因为它可以在考虑丰富的节点链接的情况下自动抽取session graph的特征。我们首先演示

session graph中节点向量的学习过程。形式上,对于图其中:

sessionnode vector。session graph的connection matrix,它决定了graph中节点之间如何相互通信。reset gate),update gate),sigmoid函数,

这里

session graph中出边(outgoing edge)的邻接矩阵和入边 (incoming edge)的邻接矩阵。例如,考虑一个session对于矩阵

注意,

SR-GNN可以为各种类型的session graph支持不同的connection matrixsession graph的构建策略,那么connection matrixcategorical)信息时,该方法可以进一步推广。具体而言,我们可以将节点的内容特征和节点向量拼接起来从而处理这些内容特征信息。对于每个

session graphGGNN同时处理所有节点。首先,它抽取邻域的潜在向量并将它们作为

input馈入到GNN中。然后,更新门和复位门分别决定保留哪些信息、丢弃哪些信息。

之后,我们通过前一个状态、当前状态、复位门来构造候选状态。

最后,在更新门的控制下,

final state是前一个隐状态和当前候选状态的组合。

在更新

session graph中的所有节点直到收敛之后,我们可以获得final的节点向量。这里需要迭代

session graph直到达到不动点fixed point。然而,可以采用GraphSage, Semi-GCN等方法,这些方法无需达到不动点,只需要迭代

1.1.2 生成 Session Embedding

之前的

session-based的推荐方法总是假设每个session存在用户的distinct latent representation。相反,SR-GNN方法不对该向量做任何假设。在SR-GNN中,session直接由该session中涉及的节点来表达。为了更好地预测用户的next click,SR-GNN将session的长期偏好和当前兴趣相结合,并将这种组合的embedding作为session embedding。引入

user embedding需要直到user id。而在session-based推荐场景之下,通常是不知道user id的,即匿名session。在将所有

session graph输入GGNN之后,我们获得了所有节点的向量。然后,为了将每个session表达为一个embedding向量我们首先考虑

sessionembeddingsessionembedding可以简单地定义为last-clicked item的embedding,即:然后,我们通过聚合所有节点向量来考虑

session graphembeddingembedding中的信息可能具有不同level的优先级,我们进一步采用soft-attention机制来更好地表达全局session偏(global session preference):其中:

attention的参数向量。

这里将局部

embeddingquery向量。最后,我们通过对局部

embedding向量和全局embedding向量拼接之后的线性变换来计算混合embedding向量其中:

这里对局部

embedding向量和全局embedding向量进行线性组合,组合权重由模型自动学到。

1.1.3 生成推荐以及模型训练

在获得每个

session的embedding之后,对于每个候选itemembeddignsession representationitem然后我们应用一个

softmax函数来得到模型的输出向量其中:

item的推荐分,item作为sessionnext click的概率。对于每个

session graph,损失函数定义为预测值和ground truth的交叉熵。即:其中:

ground truth,最后,我们使用时间反向传播

Back-Propagation Through Time: BPTT算法来训练所提出的SR-GNN模型。注意。在session-based的推荐场景中,大多数session的长度相对较短。因此,建议选择相对较少的训练step从而防止过拟合。

1.2 实验

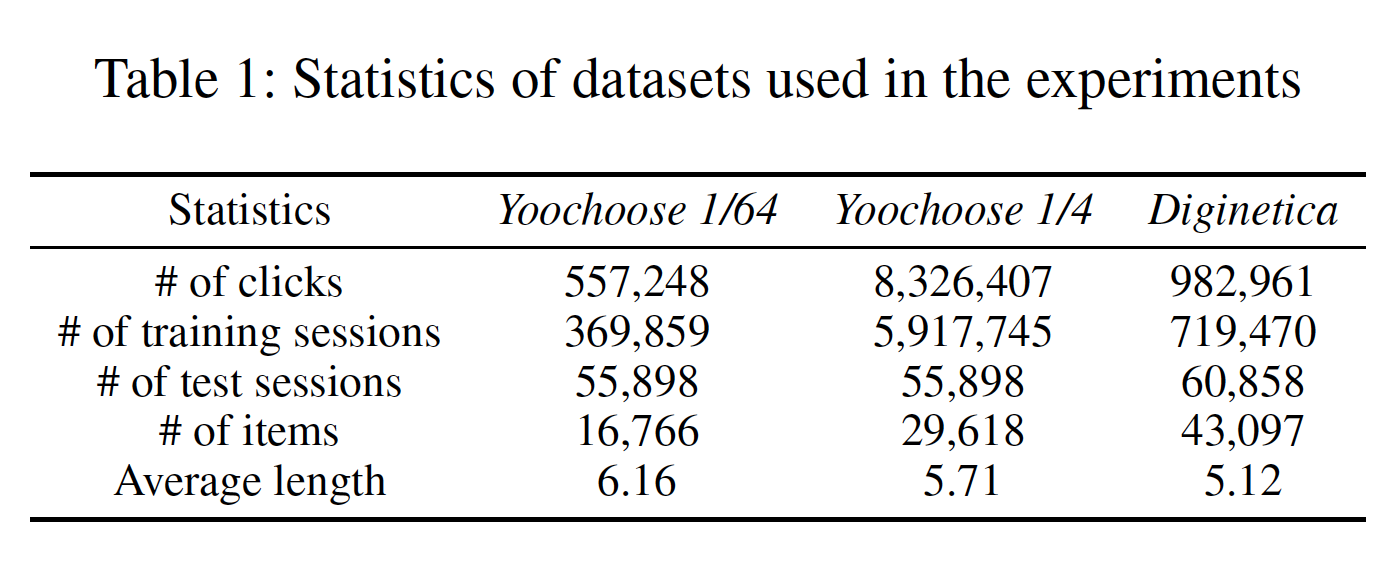

数据集:

Yoochoose:来自RecSys Challenge 2015,包含一个电商网站6个月内的用户点击流(stream of user clicks)。Diginetica:来自于CIKM Cup 2016,这里仅使用交易数据。

为了公平比较,遵从

NARM和STAMP,我们过滤掉所有长度为1的session以及出现频次少于5次的item。Yoochoose数据集剩下7981580个session和37483个item,而Diginetica数据集剩下204771个session和43097个item。对于

Yoochoose我们将最后几天的session设为测试集,对于Diginetiva我们将最后几周的session设为测试集。遵从NARM和STAMP,我们还使用了Yoochoose训练序列的最近1/64和1/4。此外,类似于

《Improved recurrent neural networks for session-based recommendations》,我们通过拆分input序列来生成序列和对应的label。具体而言,对于session序列input和相应的label为:数据集的统计数据如下表所示。

baseline方法:POP和S-POP:分别推荐训练集和当前session中的top-N流行的item。Item-KNN:推荐与session中先前点击的item相似的item,其中相似性定义为session向量之间的余弦相似度。session向量:一个session数量。如果item在第session中出现,那么该向量的第1,否则为0。BPR-MF:通过随机梯度下降优化pairwise的排序目标函数。FPMC:一种基于马尔科夫链的序列预测方法。GRU4REC:使用RNN为session-based推荐来建模用户序列。NARM:采用带注意力机制的RNN来捕获用户的主要意图和序列行为。STAMP:捕获用户对当前session的通用兴趣(general interest)、以及last click的当前兴趣(current interest)。

评估指标:

P@20(Precision)):一个广泛应用的准确性指标,它代表了top 20个item中,正确推荐item的比例。MRR@20(Mean Reciprocal Rank):是正确推荐的item的排名倒数(reciprocal rank)的均值。当排名差于20时,排名倒数置为零。MRR指标考虑推荐的order,其中MRR值大则表示正确的推荐排在ranking list的头部。

实验配置:

遵从之前的方法(

NARM和STAMP),我们将两个数据集上的潜在向量维度设置为此外,我们在验证集上选择其它超参数,其中验证集是训练集的随机

10%子集。所有参数均使用均值为零、标准差为

0.1的高斯分布进行初始化。我们使用

mini-batch的Adam优化器,其中学习率设置为0.001,每3个epoch之后将衰减0.1。此外,

mini-batch size设为100,L2正则化系数设为

和

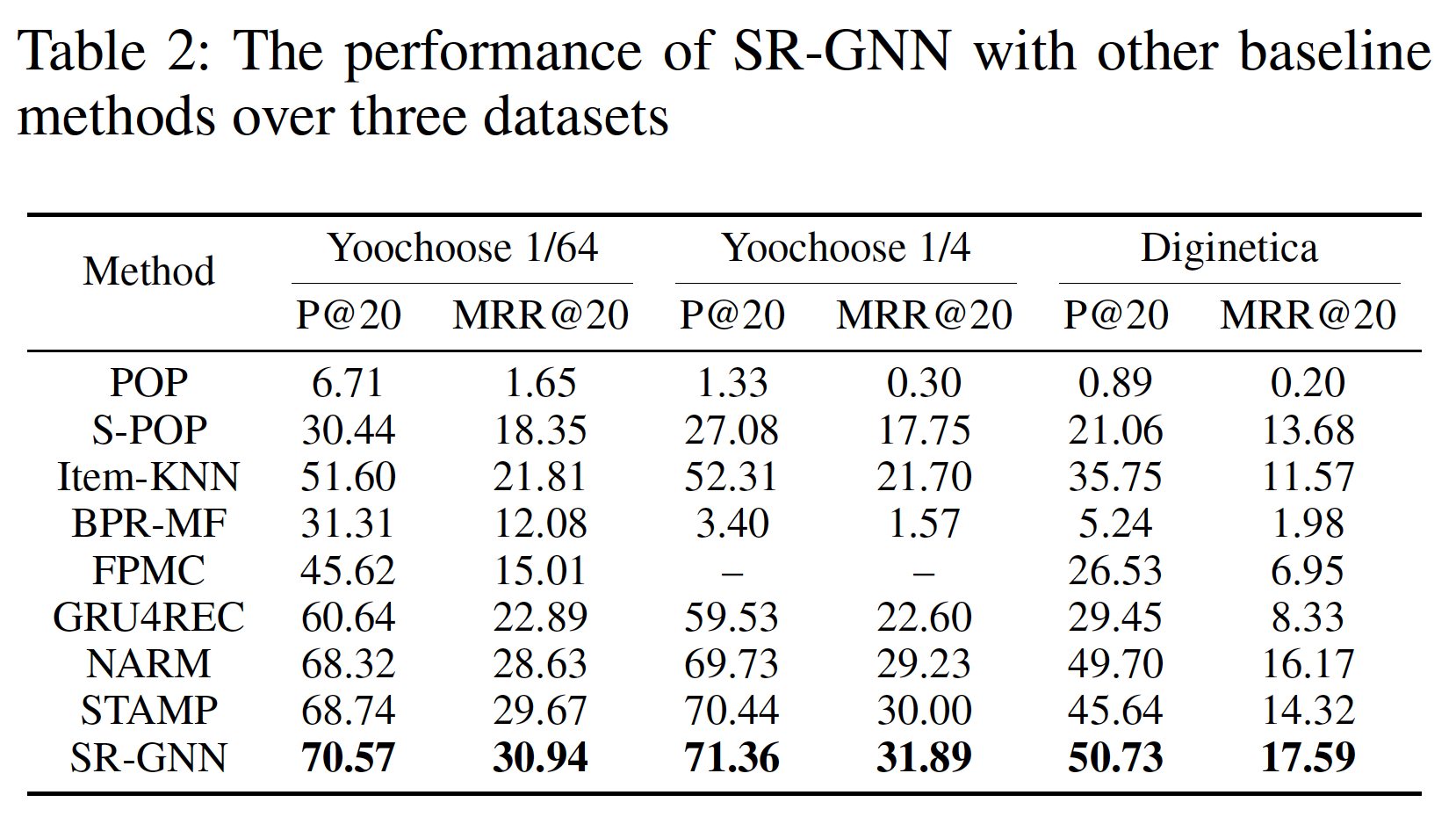

baseline的比较:为了展示所提出模型的整体性能,我们将SR-GNN与其它SOTA的session-based的推荐方法进行比较,比较结果如下表所示,其中最佳结果以粗体突出显示。注意,与《Neural attentive session-based recommendation》一样,由于初始化FPMC的内存不足,这里没有报告Yoochoose 1/4上的性能。SR-GNN将分离(separated)的session序列聚合为图结构数据。在这个模型中,我们共同考虑全局session偏好以及局部兴趣。根据实验,很明显,所提出的SR-GNN方法在P@20和MRR@20指标上在所有三个数据集上都实现了最佳性能。这验证了SR-GNN的有效性。POP, S-POP等传统算法的性能相对较差。这种简单的模型仅基于重复的共现item、或者连续item进行推荐,这在session-based推荐场景中是有问题的。即便如此,

S-POP的表现仍然优于POP, BPR-MF, FPMC等竞争对手,这证明了session上下文信息(session contextual information)的重要性。Item-KNN比基于马尔科夫链的FPMC取得了更好的结果。注意,Item-KNN仅利用item之间的相似性,而不考虑序列信息。这表明传统的基于马尔科夫链的方法主要依赖的假设是不现实的,这个假设是:successive items的独立性。基于神经网络的方法(如

NARM和STAMP)优于传统方法,这展示了在推荐领域应用深度学习的能力。短期/长期记忆模型,如GRU4REC和NARM,使用循环单元来捕获用户的通用兴趣(general interest),而STAMP通过利用last-click item来改善短期记忆(short-term memory)。这些方法显式地建模用户的全局行为偏好,并考虑用户的previous actions和next click之间的转移(transition),从而获得优于传统方法的性能。但是,它们的性能仍然不如

SR-GNN。与NARM和STAMP等SOTA方法相比,SR-GNN进一步考虑了session中item之间的转移,从而将每个session建模为一个graph,这个graph可以捕获用户点击之间更复杂、更隐式的链接。而在NARM和GRU4REC中,它们显式地建模每个用户,并通过separated的session序列来获得user representation,忽略了item之间可能的交互关系。因此,SR-GNN对session行为的建模能力更强大。RNN网络显式建模单向转移,而attention机制显式建模全局相关性而忽略了item之间的关系。相比之下,SR-GNN建模了item之间更复杂、更隐式的关系(如一阶邻近性、高阶邻近性)。此外,

SR-GNN采用soft-attention机制生成session representation,这可以自动选择最重要的item转移,并忽略当前session中噪音(noisy)的、无效的用户action。相反,STAMP仅使用last click item和previous actions之间的转移,这可能还不够。SR-GNN在soft-attention机制中,也使用last click item和previous actions之间的关系。但是在SR-GNN中,每个item embedding考虑了session graph中更复杂的、更隐式的转移。其它

RNN模型,如GRU4REC和NARM,在传播过程中也无法选择有影响力的信息。它们使用所有previous items来获得代表用户通用兴趣的向量。当用户的行为是漫无目的、或者用户的兴趣在当前session中快速漂移时,传统模型无法有效地处理噪音的session。NARM在通过局部编码器计算当前session的主要意图时,也使用注意力机制来自适应地关注更重要的item。因此作者这里表述有误。

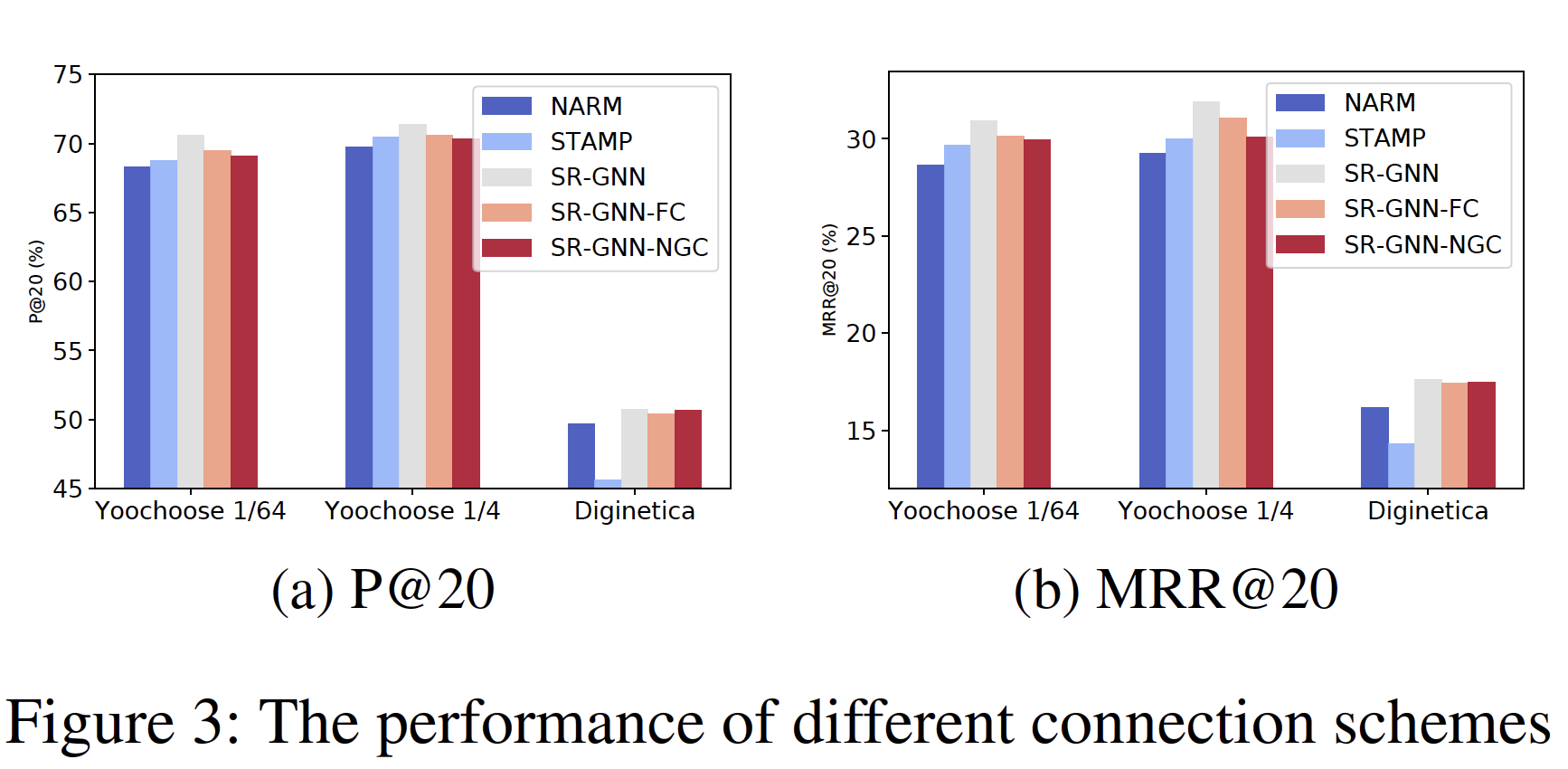

各种链接方案的比较:所提出的

SR-GNN方法可以灵活地构建graph中item之间的链接关系。我们展示了另外两个链接变体,从而评估每个session graph中item之间的不同方式的关系。变体一:我们将所有

session graph聚合在一起,并将它们建模为一个有向的、整体的item graph,称之为global graph。在global graph中,每个节点表示一个unique item,每条边表示从一个item到另一个item的有向转移。我们使用从

global graph中提取的边权重代替connection matrix,称之为:具有归一化的全局链接(normalized global connection)的SR-GNN(SR-GNNNGC)。变体二:我们将一个

session中item之间的所有高阶关系显式建模为直接链接。我们使用布尔权重表示所有高阶关系,并将其对应的connection matrix附加到SR-GNN的connection matrix,称之为:具有全连接的SR-GNN(SR-GNN-FC)。

不同链接方案的结果如下图所示,可以看到:

所有三种链接方案都实现了与

SOTA的STAMP和NARM方法更好或几乎相同的性能,证明了将session建模为graph的有用性。与

SR-GNN相比,对于每个session,SR-GNNNGC除了考虑当前session中的item之外,还考虑了其它session的影响,从而减少了当前session graph中high degree节点对应的边的影响。这种融合方法会显著影响当前session的完整性,尤其是当graph中边的权重差异较大时,从而导致模型性能下降。此外,

SR-GNNGC需要构建一张大的global graph,当节点数量非常多(如数十亿),此时对内存也是一个挑战。而session graph小得多,也更容易处理。此外,即使

session graph之间相互独立,但是item embedding是共享的,因此每个item可以从所有的session graph中学习各种转移模式。对于

SR-GNN和SR-GNN-FC,前者仅对连续item之间的确切关系进行建模,后者进一步显式地将所有高阶关系视为直接链接。结果表明,SR-GNN-FC的性能要比SR-GNN更差,尽管两种方法的实验结果差别不大。如此小的结果差异表明,在大多数推荐场景中,并非每个高阶转移都可以直接转换为直接链接,高阶

item之间的intermediate stage仍然是必需的。例如,考虑到用户在浏览一个网站时浏览了以下网页:A -> B -> C,不适合直接在A之后推荐网页C而没有中间网页B,因为A和C之间没有直接的联系。

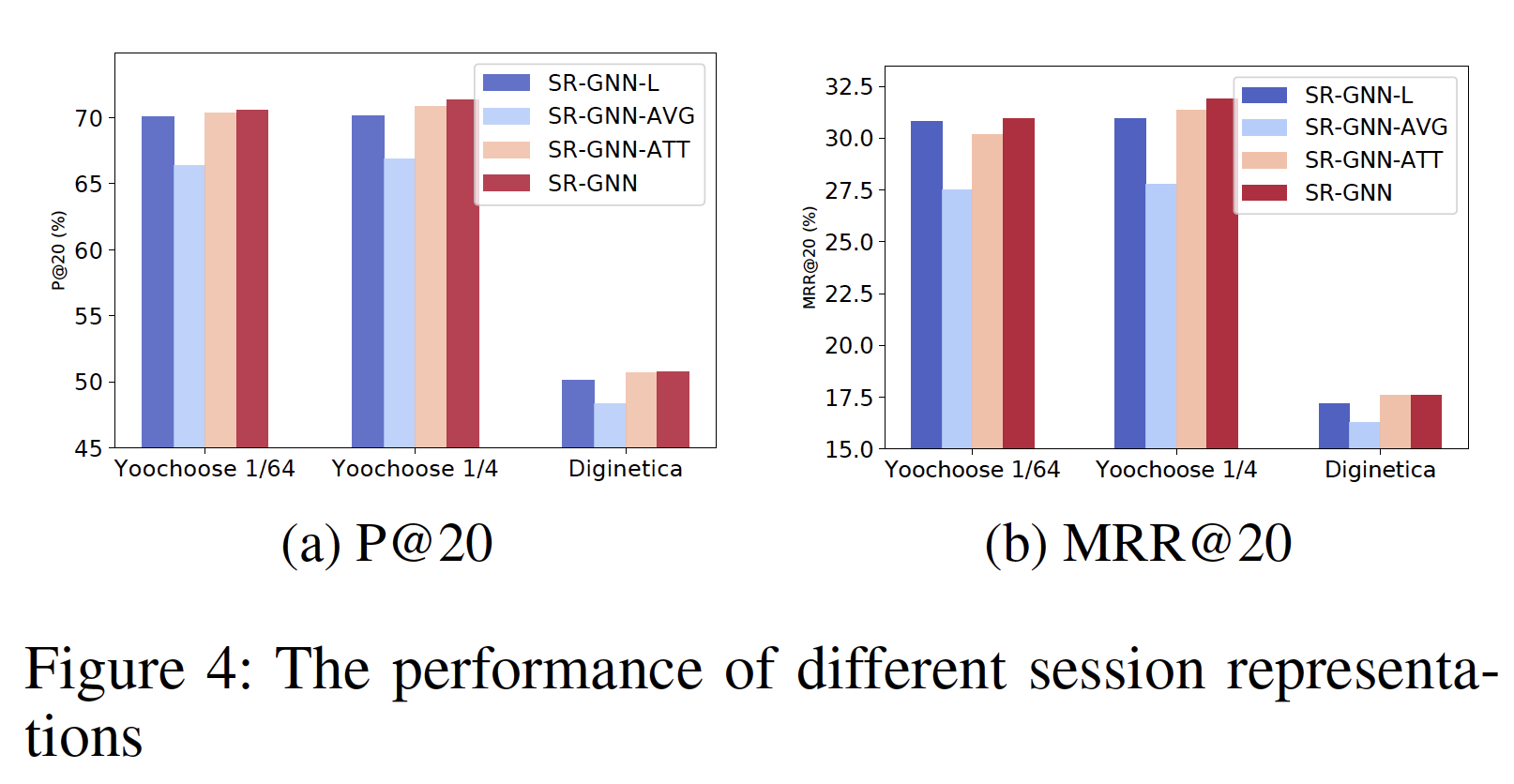

不同

Session Embedding的比较:我们将SR-GNN的session embedding生成策略与以下三种方法进行比较:仅

local embedding(SR-GNNL):即,仅考虑last-clicked item的embedding。仅具有均值池化的

global embedding(SR-GNNAVG):即,仅考虑global embedding并且仅具有注意力机制的

global embedding(SR-GNN-ATT) :即,仅考虑global embedding。

下图给出了三种不同

embedding策略的方法的结果。可以看到:原始的

SR-GNN在所有三个数据集上都取得了最佳结果,这验证了显式结合当前session兴趣和长期偏好的重要性。此外,

SR-GNN-ATT在三个数据集上的 性能优于SR-GNN-AVG。这表明session可能包含一些噪音的行为。此外,结果表明,注意力机制有助于从session数据中抽取重要行为从而构建长期偏好。注意,

SR-GNN的降级版本SR-GNN-L仍然优于SR-GNN-AVG,并达到与SR-GNN-ATT几乎相同的性能,这表明:当前session兴趣和长期偏好对于session-based推荐都是至关重要的。仅使用

last-clicked item的embedding效果就很好,那么是否可以丢弃所有previous行为而仅保留last-clicked item?如果可以的话,那么会极大地简化推荐算法。读者认为是不可以的,因为还依赖于

session graph来生成last-clicked item的embedding。

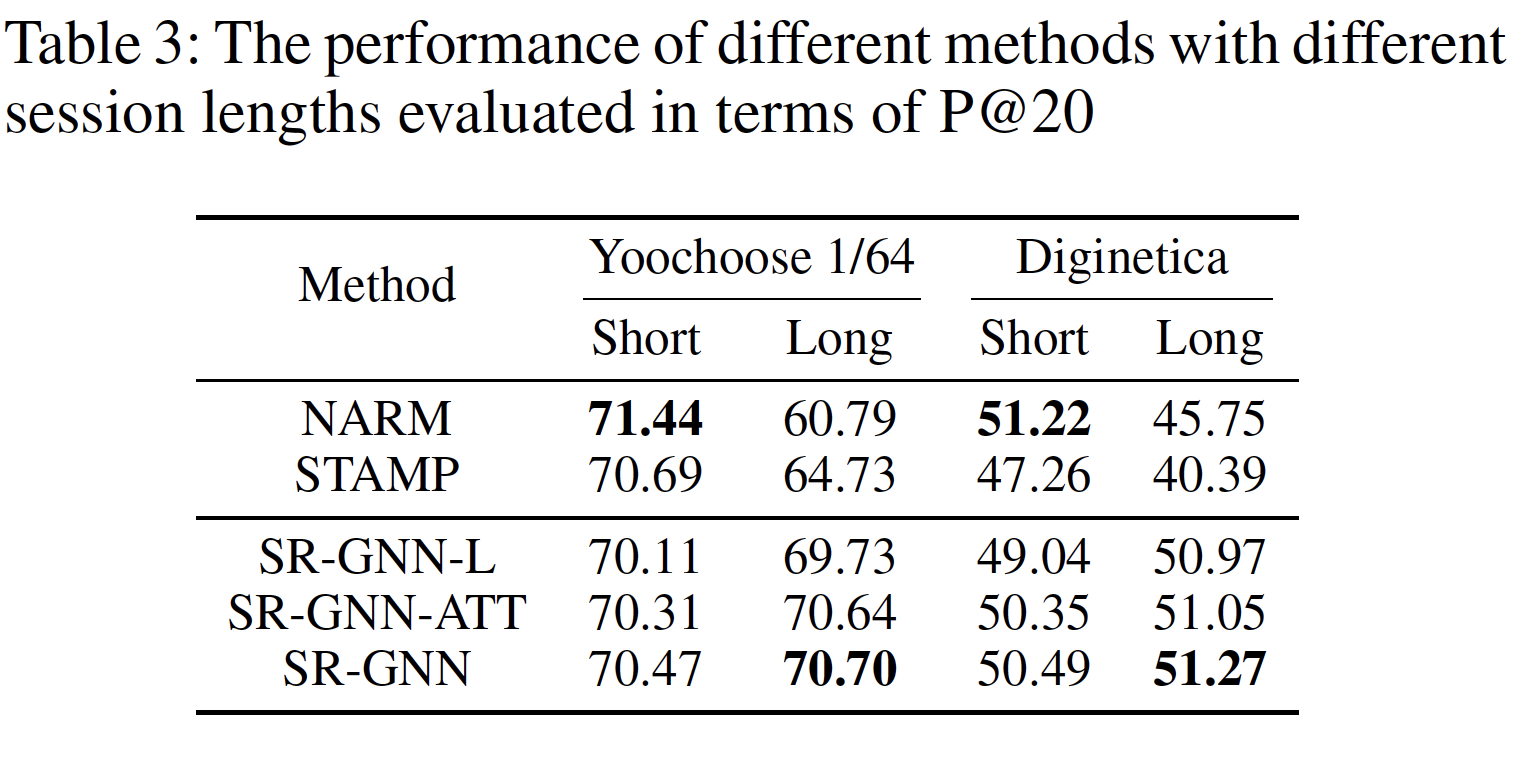

session序列长度分析:我们进一步分析了不同模型处理不同长度session的能力。为了比较,我们将Yoochoose 1/64和Diginetica分为两组,其中:Short组表示session的长度小于或等于5个,Long组表示session的长度超过5个。之所以选择数字5,是因为所有数据集中session的平均长度最接近整数5。Yoochoose数据集上的session中,属于Short组和Long组的比例分别为0.701和0.299,而Diginetica数据集则为0.764和0.236。对于每种方法,我们在下表中报告了P@20的指标。可以看到我们的

SR-GNN及其变体在两个数据集上具有不同session长度时表现稳定。这证明了SR-GNN的优越性能、以及GNN在session-based推荐中的适应性(adaptability)。相反,

NARM和STAMP的性能在Short组和Long组的性能变化很大。STAMP解释这样的差异归因于重复的动作(replicated actions):这可能是因为重复点击可能会强调不重要item的一些无效信息,并使其难以捕获到next action相关的用户兴趣。与

STAMP类似,NARM在Short组上获得了良好的性能,但是随着session长度的增加,性能迅速下降。部分原因是RNN模型难以处理长的序列。

然后我们分析了

SR-GNN-L, SR-GNN-ATT, SR-GNN在不同session长度下的性能:与

STAMP和NARM相比,这三种方法取得了有前景的结果。这可能是因为基于GNN的学习框架,我们的方法可以获得更准确的节点向量。这种node embedding不仅可以捕获节点的潜在特征,还可以全局地建模节点链接。此外,

SR-GNN的性能是最稳定的,而SR-GNN-L, SR-GNN-ATT的性能在Short组和Long组上波动很大。结论不成立,

SR-GNN-ATT的波动与SR-GNN一样都很小。此外,

SR-GNN-L也可以取得良好的结果,尽管该变体仅使用local session embedding vector。这可能是因为建模local session embedding vector时还隐式地考虑了session graph中一阶节点和高阶节点的属性。